Google hat heute einen

RFC-Entwurf des Robots Exclusion Protocol (REP) -Standards angekündigt und gleichzeitig den Parser der Datei robots.txt unter der Apache License 2.0 verfügbar gemacht. Bis heute gab es keinen offiziellen Standard für Robots Exclusion Protocol (REP) und robots.txt (dies war der nächstgelegene), der es Entwicklern und Benutzern ermöglichte, ihn auf ihre eigene Weise zu interpretieren. Die Initiative des Unternehmens zielt darauf ab, Unterschiede zwischen den Implementierungen zu verringern.

Ein Entwurf des neuen Standards kann

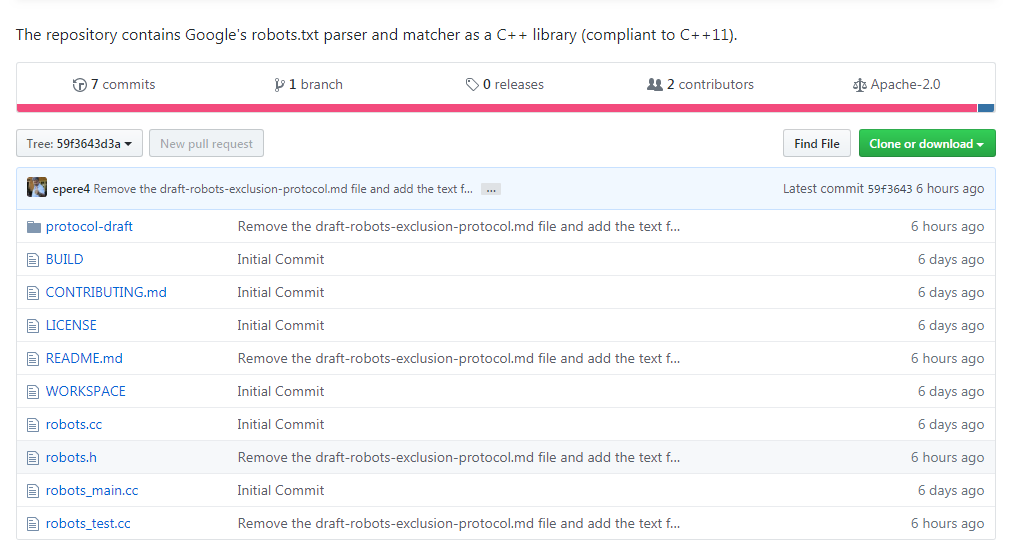

auf der IETF-Website eingesehen werden. Das Repository ist auf Github unter

https://github.com/google/robotstxt verfügbar.

Der Parser ist der Quellcode, den Google als Teil seiner Produktionssysteme verwendet (mit Ausnahme kleinerer Änderungen - wie entfernter Header-Dateien, die nur innerhalb des Unternehmens verwendet werden). Die robots.txt-Dateien werden genau wie Googlebot (einschließlich) analysiert wie er Unicode-Zeichen in Mustern behandelt). Der Parser ist in C ++ geschrieben und besteht im Wesentlichen aus zwei Dateien - Sie benötigen einen mit C ++ 11 kompatiblen Compiler, obwohl der Bibliothekscode aus den 90er Jahren stammt und Sie darin rohe Zeiger und

Strbrk finden . Für die Montage wird die Verwendung von

Bazel empfohlen (CMake-Unterstützung ist in naher Zukunft geplant).

Die Idee zu robots.txt und dem Standard gehört Martine Coster, die ihn 1994 erstellt hat. Der

Legende nach war der Grund die Suchspinne Charles Strauss, die den Bonfire-Server mithilfe eines DoS-Angriffs „fallen ließ“. Seine Idee wurde von anderen aufgegriffen und schnell zum De-facto-Standard für diejenigen, die an der Entwicklung von Suchmaschinen beteiligt waren. Diejenigen, die das Parsen durchführen wollten, mussten manchmal Googlebot zurückentwickeln, einschließlich Blekko, der einen

eigenen Parser für Perl für seine Suchmaschine schrieb.

Der Parser war nicht ohne lustige Momente: Sehen Sie sich zum Beispiel an,

wie viel Arbeit in die unzulässige Verarbeitung gesteckt wurde .