Im

ersten Teil dieses Textes haben wir Tiefenkameras untersucht, die auf Messungen des strukturellen Lichts und der Umlauflichtverzögerung basieren und hauptsächlich Infrarotbeleuchtung verwenden. Sie eignen sich hervorragend für Innenräume in Entfernungen von 10 bis 10 Metern und sind vor allem sehr billig. Daher die massive Welle ihrer aktuellen Verwendung in Smartphones. Aber ... Sobald wir nach draußen gehen, beleuchtet die Sonne sogar durch die Wolken das Infrarotlicht und ihre Arbeit verschlechtert sich stark.

Wie Steve Blank (

aus einem anderen Grund ) sagt: "Wenn Sie Erfolg haben wollen, verlassen Sie das Gebäude." Im Folgenden werden wir über Tiefenkameras sprechen, die im Freien arbeiten. Heute wird dieses Thema stark von autonomen Autos bestimmt, aber, wie wir sehen werden, nicht nur.

Quelle: Innoviz sieht massenproduzierte selbstfahrende Autos mit Festkörper-LiDAR vor

Quelle: Innoviz sieht massenproduzierte selbstfahrende Autos mit Festkörper-LiDAR vorSo können Tiefenkameras, d.h. Geräte, die Videos aufnehmen, in deren Pixel der Abstand zum Szenenobjekt im Sonnenlicht liegt!

Wen kümmert es - willkommen bei kat!

Beginnen wir mit den zeitlosen Klassikern ...

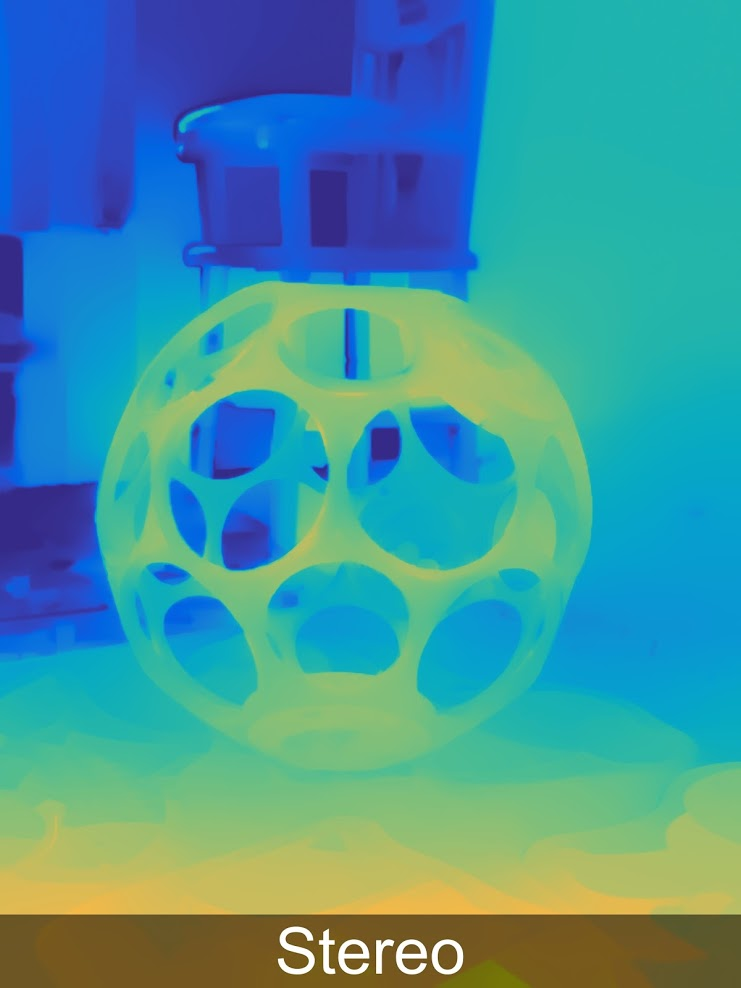

Methode 3: Tiefe von der Stereokamera +

Das Erstellen einer Tiefenkarte aus Stereo ist bekannt und wird seit

über 40 Jahren verwendet . Im Folgenden finden Sie ein Beispiel für eine Kompaktkamera für 450 US-Dollar, mit der Gesten zusammen mit professioneller Fotografie oder VR-Helmen gesteuert werden können:

Quelle

QuelleDer Hauptvorteil solcher Kameras besteht darin, dass Sonnenlicht sie nicht nur nicht stört, sondern umgekehrt auch ihre Ergebnisse verbessert. Daher ist die aktive Verwendung solcher Kameras für alle Arten von Straßenkoffern beispielsweise ein hervorragendes Beispiel dafür, wie ein dreidimensionales Modell einer alten Festung in wenigen Minuten aufgenommen werden kann:

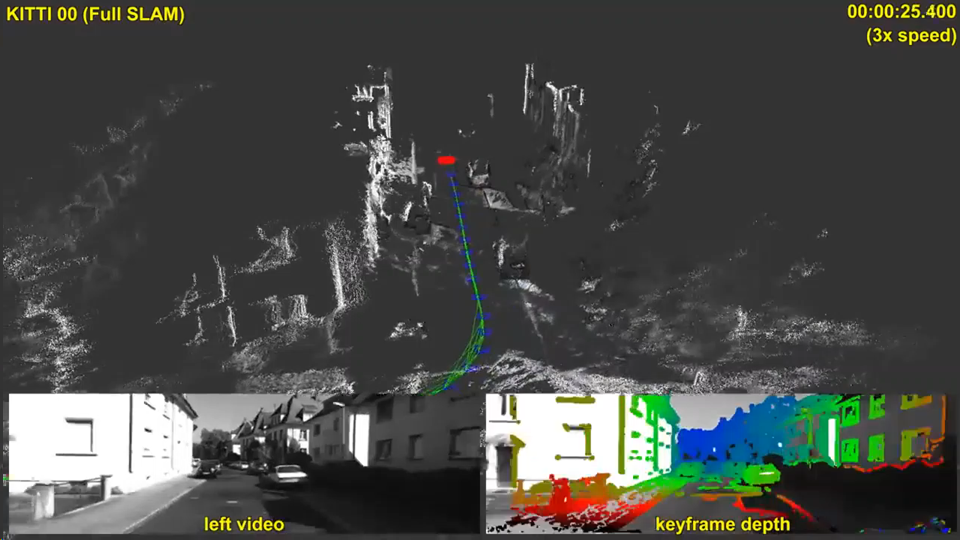

Ein Beispiel für den Straßengebrauch der ZED-KameraDas spürbare Geld für die Übersetzung der Tiefenkonstruktion von Stereo auf ein neues Niveau wurde natürlich vom Thema autonome Autos beeinflusst. Von den 5 in Betracht gezogenen Methoden zum Erstellen eines Tiefenvideos stören nur zwei - diese und die nächste (Stereo und Plenoptik) - nicht die Sonne und nicht benachbarte Autos. Gleichzeitig ist die Plenoptik über große Entfernungen um ein Vielfaches teurer und ungenauer. Auf jeden Fall können Dinge passieren, es ist schwierig, Prognosen zu erstellen, aber in diesem Fall lohnt es sich, Elon Mask zuzustimmen - Stereo von allen 5 Methoden hat die besten Aussichten. Und die aktuellen Ergebnisse sind sehr ermutigend:

Quelle: Direct SLAM in großem Maßstab mit Stereokameras

Quelle: Direct SLAM in großem Maßstab mit StereokamerasEs ist jedoch interessant, dass nicht unbemannte Fahrzeuge (von denen bisher nur wenige hergestellt werden), sondern viel massivere Geräte, auf denen derzeit eine Stereotiefenkarte erstellt wird, einen noch stärkeren Einfluss auf die Entwicklung der Bautiefe aus Stereo haben werden, nämlich ... Richtig! Smartphones!

Vor drei Jahren gab es einfach den Boom der „zweiäugigen“ Smartphones, bei denen buchstäblich alle Marken bekannt waren, weil sich die Qualität der mit einer Kamera aufgenommenen Fotos und die Qualität der mit zwei Kameras aufgenommenen Fotos dramatisch unterschieden. Unter dem Gesichtspunkt der Preiserhöhung für ein Smartphone war dies jedoch nicht so bedeutend:

Darüber hinaus ging der Prozess im vergangenen Jahr noch aktiv weiter: „Haben Sie 2 Kameras in Ihrem Smartphone? Scheiße! Ich habe

drei vier !!! ”:

Quelle: Samsung Galaxy A8 & A9

Quelle: Samsung Galaxy A8 & A9Sechsäugige Zukunft Sony wurde im ersten Teil erwähnt. Im Allgemeinen werden mehräugige Smartphones bei Herstellern immer beliebter.

Die grundlegenden Ursachen dieses Phänomens sind einfach:

- Die Auflösung von Kamerahandys wächst und die Größe des Objektivs ist gering. Infolgedessen steigt trotz zahlreicher Tricks der Geräuschpegel und die Qualität nimmt ab, insbesondere bei Aufnahmen im Dunkeln.

- Darüber hinaus können wir bei der zweiten Kamera das sogenannte Bayer-Filter aus der Matrix entfernen, d.h. Eine Kamera ist schwarzweiß und die zweite Farbe. Dies erhöht die Schwarzweißempfindlichkeit um etwa das Dreifache. Das heißt, Die Empfindlichkeit von 2 Kameras wächst bedingt nicht um das 2-fache, sondern um das 4-fache (!). Es gibt zahlreiche Nuancen, aber eine solche Erhöhung der Empfindlichkeit ist für das Auge wirklich deutlich sichtbar.

- Wenn ein Stereopaar erscheint, haben wir unter anderem die Möglichkeit, die Schärfentiefe programmgesteuert zu ändern, d. H. Verwischen Sie den Hintergrund, von dem viele Fotos erheblich profitieren (darüber haben wir in der zweiten Hälfte hier geschrieben ). Diese Option neuer Smartphone-Modelle wurde schnell sehr beliebt.

- Mit zunehmender Anzahl von Kameras ist es auch möglich, andere Objektive zu verwenden - Weitwinkel (Kurzfokus) und umgekehrt Langfokus, was die Qualität beim "Annähern" von Objekten erheblich verbessern kann.

- Interessanterweise bringt uns eine Zunahme der Anzahl der Kameras näher an das Thema eines verdünnten Lichtfeldes heran, das viele seiner Merkmale und Vorteile aufweist. Dies ist jedoch eine andere Geschichte.

- Wir stellen außerdem fest, dass Sie durch Erhöhen der Anzahl der Kameras die Auflösung durch Auflösungswiederherstellungsmethoden erhöhen können.

Im Allgemeinen gibt es so viele Pluspunkte, dass sich die Leute, wenn sie sich ihrer bewusst sind, fragen, warum mindestens zwei Kameras schon lange nicht mehr eingestellt wurden.

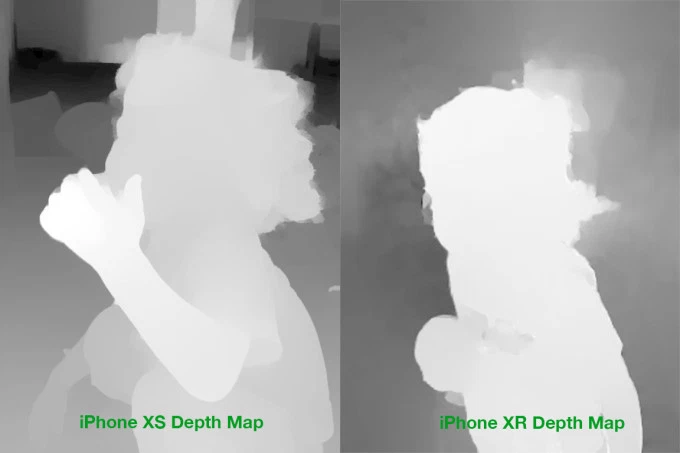

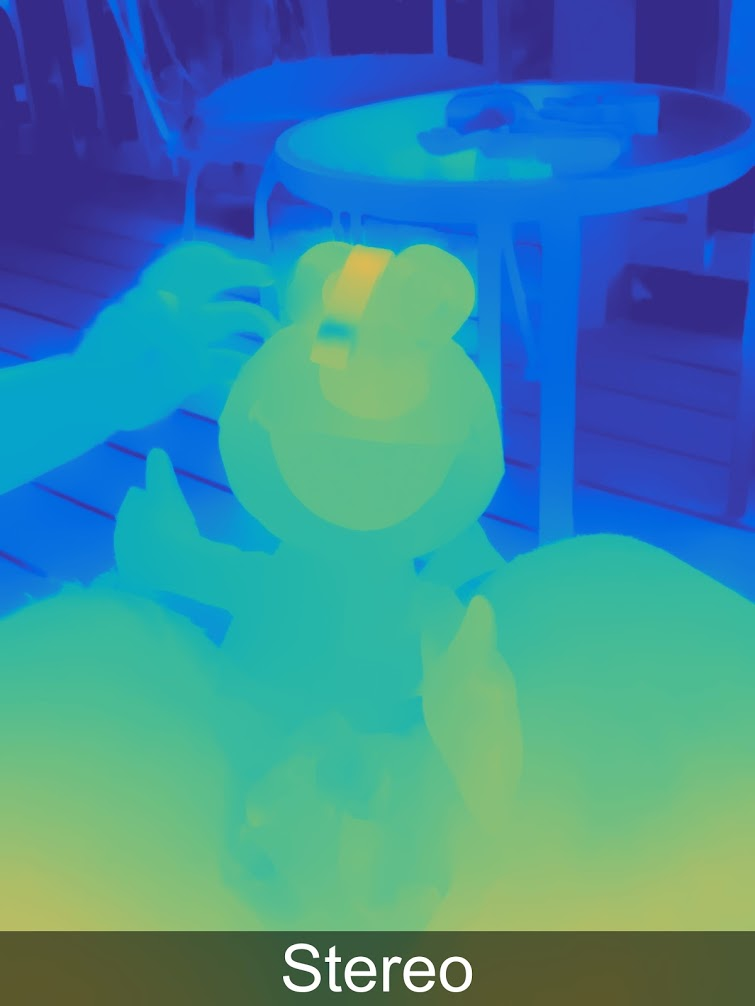

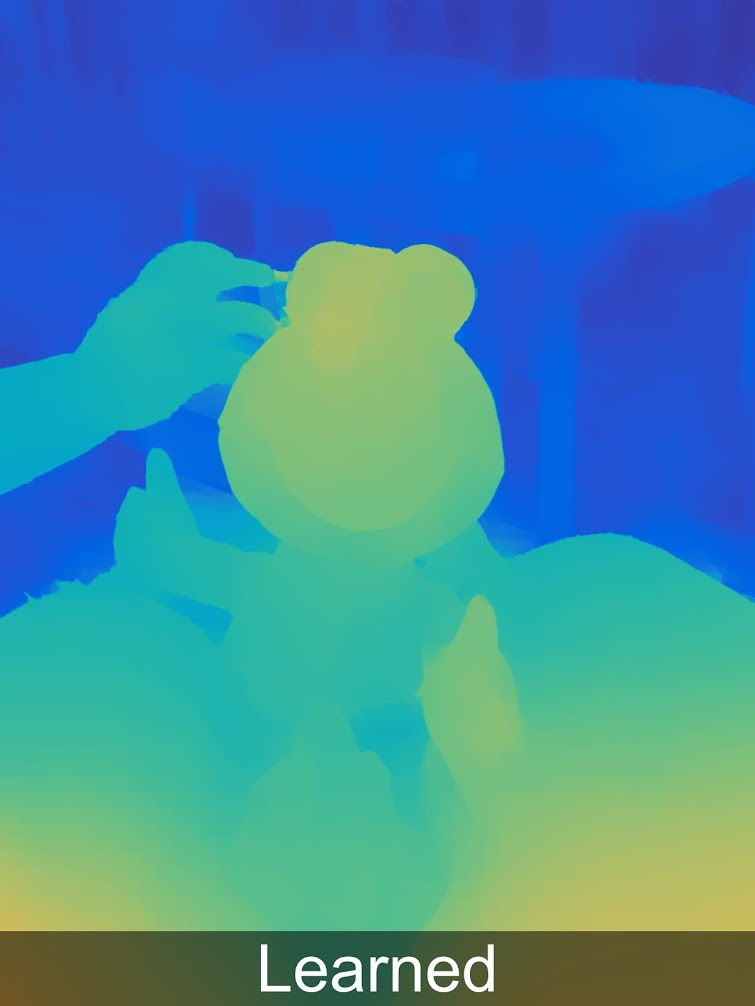

Und dann stellt sich heraus, dass nicht alles so einfach ist. Um zusätzliche Kameras sinnvoll einzusetzen, um das Bild zu verbessern (und nicht nur zu einer Kamera mit einem anderen Objektiv zu wechseln), müssen wir eine sogenannte Disparitätskarte erstellen, die direkt in eine Tiefenkarte umgewandelt wird. Und dies ist eine nicht triviale Aufgabe, zu deren Lösung gerade die Leistung von Smartphones gekommen ist. Und selbst jetzt sind Tiefenkarten oft von eher zweifelhafter Qualität. Das heißt, bevor die genaue Übereinstimmung "Pixel auf dem rechten Bild mit dem Pixel auf der linken Seite" noch überleben muss. Hier sind zum Beispiel echte Beispiele für Tiefenkarten für das iPhone:

Quelle: iPhone XS & XR Tiefenkartenvergleich

Quelle: iPhone XS & XR TiefenkartenvergleichSelbst mit dem Auge sind Massenprobleme im Hintergrund deutlich sichtbar, an den Rändern schweige ich über

durchscheinendes Haar. Daher gibt es zahlreiche Probleme, die sowohl beim Übertragen von Farbe von einer Schwarzweißkamera auf eine Farbkamera als auch während der weiteren Verarbeitung auftreten.

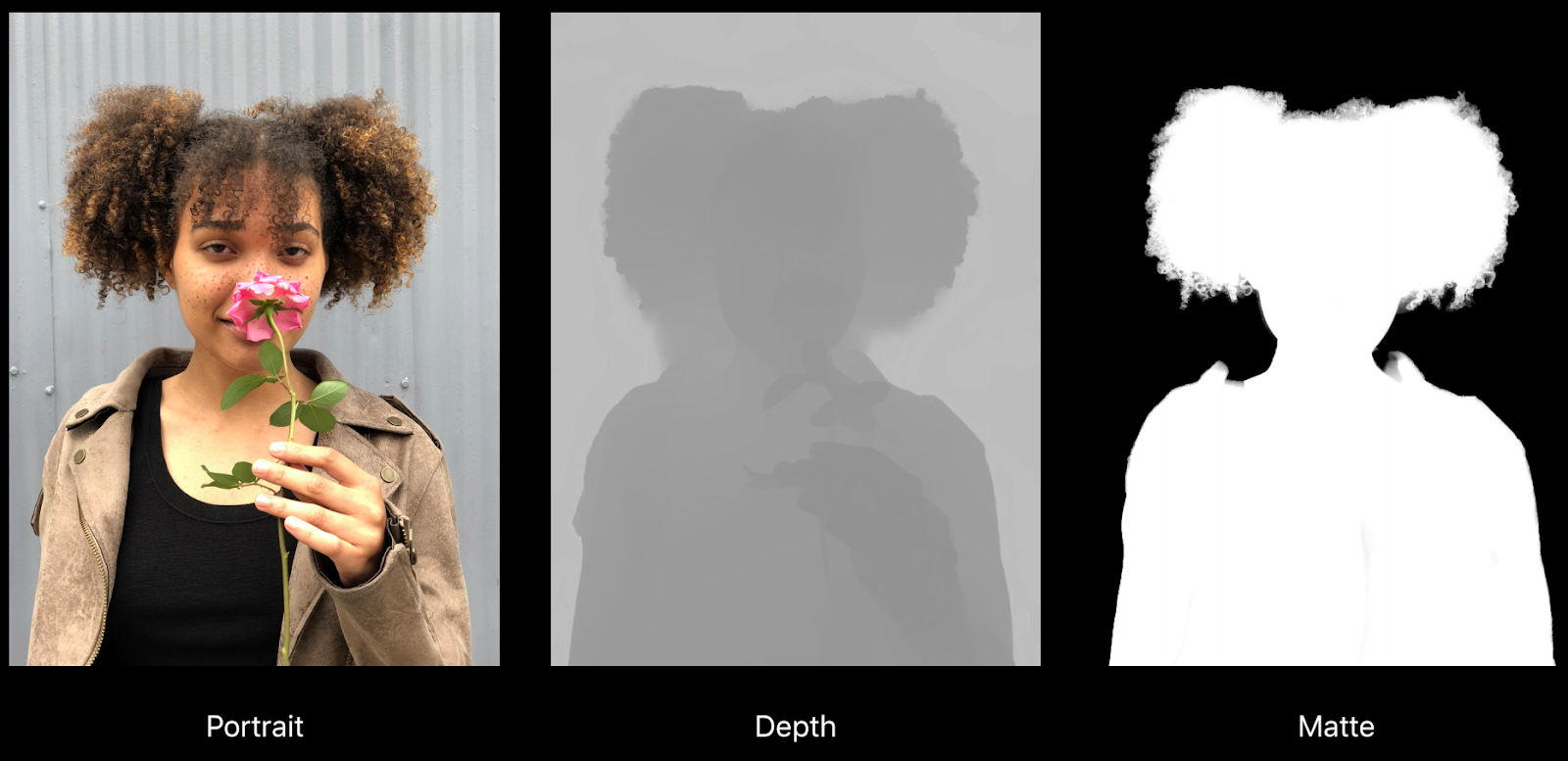

Hier ist zum Beispiel ein ziemlich gutes Beispiel aus einem Bericht von Apple zum Thema „Erstellen von Foto- und Videoeffekten mit Tiefe“:

Quelle: Erstellen von Foto- und Videoeffekten • Verwenden von Depth, Apple, WWDC18

Quelle: Erstellen von Foto- und Videoeffekten • Verwenden von Depth, Apple, WWDC18Sie können deutlich sehen, wie fehlerhaft die Tiefe unter den Haaren ist, und zwar vor einem mehr oder weniger gleichmäßigen Hintergrund, aber was noch wichtiger ist, auf der rechten Mattierungskarte ist der Kragen in den Hintergrund getreten (d. H. Er wird unscharf). Ein weiteres Problem ist die tatsächliche Auflösung der Tiefe und die Mattierungskarte ist erheblich niedriger als die Bildauflösung, was sich auch auf die Qualität während der Verarbeitung auswirkt:

All dies ist jedoch ein Wachstumsproblem. Wenn vor 4 Jahren keine ernsthaften Auswirkungen auf das Video in Frage kamen, hat das Telefon sie einfach nicht "gezogen", aber heute wird sich die Videoverarbeitung mit Tiefe auf seriellen Top-Telefonen gezeigt (in derselben Präsentation von Apple):

Quelle: Erstellen von Foto- und Videoeffekten • Verwenden von Depth, Apple, WWDC18

Quelle: Erstellen von Foto- und Videoeffekten • Verwenden von Depth, Apple, WWDC18Im Allgemeinen erobert das Thema Multi-Multi-Handys und damit das Thema Tiefenschärfe von Stereo auf Mobiltelefonen die Massen kampflos:

Quelle: "auf diesen von Ihrem Internet gefunden"

Quelle: "auf diesen von Ihrem Internet gefunden"Wichtigste Ergebnisse:

- Die Tiefe von Stereo - gemessen an den Ausrüstungskosten - ist der billigste Weg, um Tiefe zu erhalten, da Kameras jetzt kostengünstig sind und immer schneller billiger werden. Die Schwierigkeit besteht darin, dass die Weiterverarbeitung viel ressourcenintensiver ist als bei anderen Methoden.

- Bei Mobiltelefonen können Sie den Durchmesser des Objektivs nicht vergrößern, während die Auflösung schnell zunimmt. Infolgedessen kann die Verwendung von zwei oder mehr Kameras die Qualität des Fotos erheblich verbessern, das Rauschen bei schlechten Lichtverhältnissen reduzieren und die Auflösung erhöhen. Da heutzutage häufig ein Mobiltelefon für die Qualität der Kamera ausgewählt wird, ist dies ein äußerst greifbares Plus. Das Erstellen einer Tiefenkarte ist ein unauffälliger Nebenbonus.

- Die Hauptnachteile der Gebäudetiefe von Stereo:

- Sobald die Textur verschwindet oder einfach weniger kontrastreich wird, nimmt das Rauschen in der Tiefe stark zu, so dass selbst bei einfachen Objekten die Tiefe häufig schlecht genutzt wird (schwerwiegende Fehler sind möglich).

- Außerdem ist die Tiefe bei dünnen und kleinen Objekten ("abgeschnittenen" Fingern oder sogar Händen, versenkten Säulen usw.) schlecht bestimmt.

- Sobald Sie mit der Leistung von Eisen eine Tiefenkarte für Videos erstellen können, wird die Tiefe auf Smartphones einen starken Impuls für die Entwicklung von AR geben (irgendwann, völlig unerwartet für die Öffentlichkeit, wird die Qualität von AR-Anwendungen auf allen neuen Telefonmodellen, einschließlich der Budget-Modelle, plötzlich merklich höher und eine neue Welle wird losgehen) . Völlig unerwartet!

Die nächste Methode ist weniger trivial und berühmt, aber sehr cool. Triff mich!

Methode 4: Lichtfeldtiefenkameras

Das Thema Plenoptik (vom lateinischen Plenus - voll und optikos - visuell) oder Lichtfelder ist der Masse noch relativ wenig bekannt, obwohl Fachleute damit begannen, sich sehr dicht damit zu befassen. Auf vielen Top-Konferenzen wurden separate Abschnitte für Artikel zum Thema Lichtfeld zugewiesen (der Autor war einmal beeindruckt von der Anzahl der asiatischen Forscher auf der IEEE International Conference on Multimedia and Expo, die sich intensiv mit diesem Thema befassen).

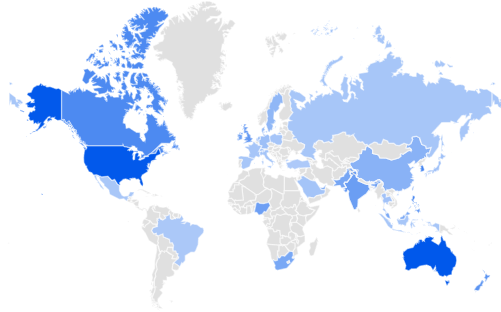

Laut Google Trends sind die USA und Australien an Light Field interessiert, gefolgt von Singapur und Korea. Großbritannien Russland liegt auf Platz 32 ... Wir werden den Rückstand aus Indien und Südafrika korrigieren:

Quelle: Google Trends

Quelle: Google TrendsIhr bescheidener Diener hat vor einiger Zeit einen

ausführlichen Artikel über Habré verfasst, in dem ausführlich beschrieben wird, wie es funktioniert und was es gibt. Lassen Sie uns kurz darauf eingehen.

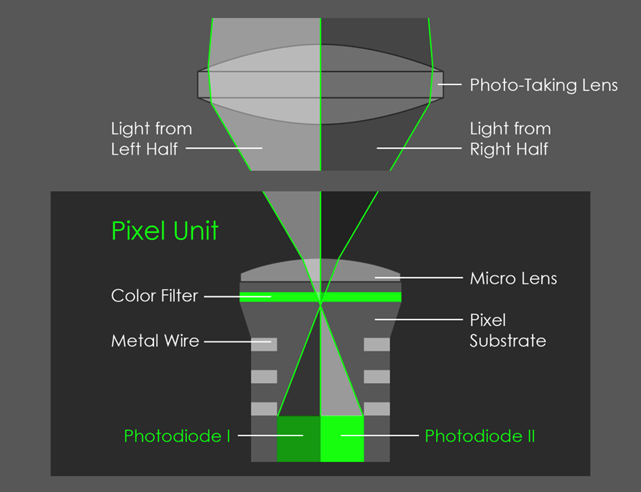

Die Hauptidee besteht darin, an jedem Punkt nicht nur Licht, sondern eine zweidimensionale Anordnung von Lichtstrahlen zu fixieren, wodurch jeder Rahmen vierdimensional wird. In der Praxis erfolgt dies mit einer Reihe von Mikrolinsen:

Quelle: plenoptic.inf (empfohlen zum Klicken und Anzeigen in voller Auflösung)

Quelle: plenoptic.inf (empfohlen zum Klicken und Anzeigen in voller Auflösung)Infolgedessen haben wir

viele neue Möglichkeiten , aber die Auflösung fällt ernsthaft. Nachdem sie viele komplizierte technische Probleme gelöst hatten, erhöhten sie die Auflösung bei

Lytro (von Google gekauft) radikal, wo im Lytro Cinema die Auflösung des Kamerasensors auf 755 Megapixel RAW-Daten erhöht wurde und wie die ersten Kameras sperrig aussah:

Quelle: NAB: Neue Lytro-Lichtfeldkamera, die große Änderungen an der Arbeit mit visuellen Effekten bewirken könnte, wird vorgestellt

Quelle: NAB: Neue Lytro-Lichtfeldkamera, die große Änderungen an der Arbeit mit visuellen Effekten bewirken könnte, wird vorgestelltEs ist interessant, dass selbst Profis den Auflösungsabfall von plenoptischen Kameras regelmäßig falsch einschätzen, weil sie unterschätzen, wie gut sie mit

Super Resolution- Algorithmen arbeiten können, die viele Details der Bild-Mikroverschiebungen im Lichtfeld wirklich perfekt wiederherstellen (achten Sie auf verschwommene Stricknadeln und sich bewegende Schaukeln im Hintergrund). ::

Quelle: Naive, intelligente und hochauflösende plenoptische Rahmenwiederherstellung aus dem technischen Bericht von Adobe „Superauflösung mit plenoptischer Kamera 2.0“

Quelle: Naive, intelligente und hochauflösende plenoptische Rahmenwiederherstellung aus dem technischen Bericht von Adobe „Superauflösung mit plenoptischer Kamera 2.0“All dies wäre von relativ theoretischem Interesse, wenn Google keine Plenoptik in Pixel 2 implementiert hätte, indem

2 Pixel mit einer Linse abgedeckt wurden :

Quelle: AI Google Blog

Quelle: AI Google BlogAls Ergebnis wurde ein Mikrostereopaar gebildet, das es ermöglichte, die Tiefe zu messen, bis zu der Google, getreu neuen Traditionen, neuronale Netze hinzufügte, und es stellte sich im Allgemeinen als wunderbar heraus:

Weitere Beispiele für Tiefe in voller Auflösung

in einer speziellen Galerie .

Interessanterweise wird die Tiefe von Google (wie Huawei und anderen) im Bild selbst gespeichert, sodass Sie sie von dort extrahieren und sehen können:

Quelle: Drei geheime Funktionen der neuen Kamera-App von Google, die Sie umhauen werden

Quelle: Drei geheime Funktionen der neuen Kamera-App von Google, die Sie umhauen werdenUnd dann können Sie das Foto dreidimensional machen:

Quelle: Drei geheime Funktionen der neuen Kamera-App von Google, die Sie umhauen werden

Quelle: Drei geheime Funktionen der neuen Kamera-App von Google, die Sie umhauen werdenSie können auf der Website

http://depthy.me , auf der Sie Ihr Foto hochladen können, unabhängig damit experimentieren. Interessanterweise ist die Site

in der Quelle verfügbar , d. H. Die Tiefenverarbeitung kann verbessert werden, dafür gibt es viele Möglichkeiten, jetzt werden dort die einfachsten Verarbeitungsalgorithmen angewendet.

Wichtige Punkte:

- Auf einer der Google-Konferenzen wurde angekündigt, dass möglicherweise 4 Pixel mit einem Objektiv abgedeckt werden. Dies verringert die direkte Auflösung des Sensors, verbessert jedoch die Tiefenkarte erheblich. Erstens aufgrund des Auftretens von Stereopaaren in zwei senkrechten Richtungen und zweitens aufgrund der Tatsache, dass sich die Stereobasis bedingt um das 1,4-fache erhöht (zwei Diagonalen). Dies bedeutet auch eine deutliche Verbesserung der Tiefengenauigkeit in der Ferne.

- Plenoptics selbst (es ist auch ein kalkuliertes Foto) ermöglicht Folgendes:

- Das „ehrliche“ Ändern von Fokus und Schärfentiefe nach dem Aufnehmen ist die bekannteste Fähigkeit von plenoptischen Sensoren.

- Blendenform berechnen.

- Berechnen Sie die Szenenbeleuchtung.

- Verschieben Sie den Aufnahmepunkt etwas, einschließlich des Empfangs von Stereo (oder Multi-Angle-Frame) mit einem Objektiv.

- Berechnen Sie die Auflösung, da Sie mit der hohen Rechenkomplexität der Super Resolution-Algorithmen den Frame tatsächlich wiederherstellen können.

- Berechnen Sie eine Transparenzkarte für durchscheinende Ränder.

- Und schließlich erstellen Sie eine Tiefenkarte, die heute wichtig ist.

- Wenn die Hauptkamera des Telefons parallel zur Aufnahme in Echtzeit eine hochwertige Tiefenkarte erstellen kann, wird dies möglicherweise eine Revolution auslösen . Dies hängt weitgehend von der Rechenleistung an Bord ab (dies hindert uns daran, heute in Echtzeit bessere Tiefenkarten mit höherer Auflösung zu erstellen). Dies ist natürlich für AR am interessantesten, aber es gibt viele Möglichkeiten, Fotos zu ändern.

Und schließlich fahren wir mit der letzten Methode zur Überprüfung der Tiefe fort.

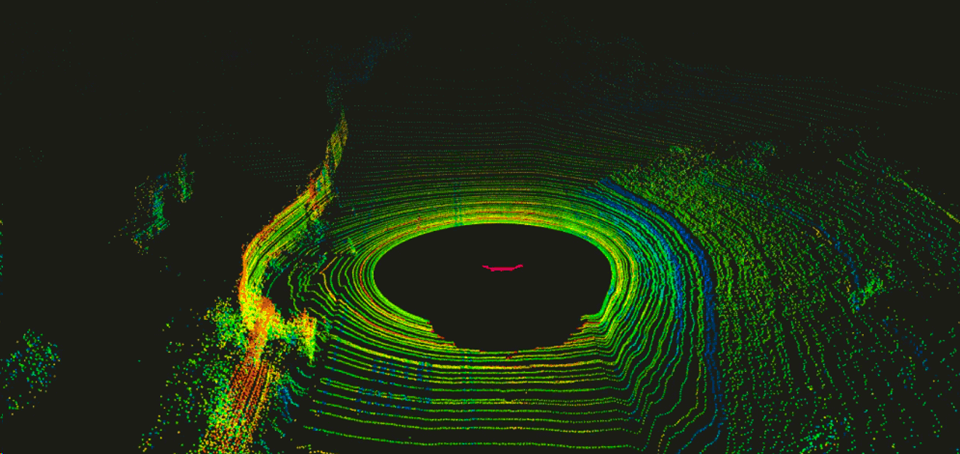

Methode 5: Kameras auf Lidar-Technologien

Im Allgemeinen sind

Laser-Entfernungsmesser fest in unserem Leben verankert, kostengünstig und bieten eine hohe Genauigkeit. Die ersten Lidars (von LIDaR -

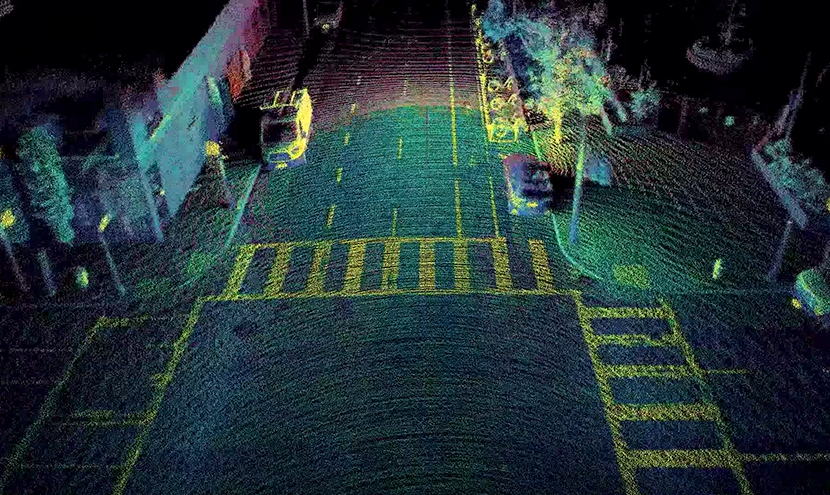

Light Identification Detection and Ranging ), die als Bündel ähnlicher Geräte gebaut wurden, die sich um eine horizontale Achse drehen, wurden zuerst vom Militär verwendet und dann in Autopiloten von Autos getestet. Sie erwiesen sich dort als recht gut, was zu einem starken Anstieg der Investitionen in der Region führte. Anfangs drehten sich die Lidare und ergaben mehrmals pro Sekunde ein ähnliches Bild:

Quelle: Eine Einführung in LIDAR: Der wichtigste selbstfahrende Autosensor

Quelle: Eine Einführung in LIDAR: Der wichtigste selbstfahrende AutosensorEs war unangenehm, aufgrund der beweglichen Teile unzuverlässig und ziemlich teuer.

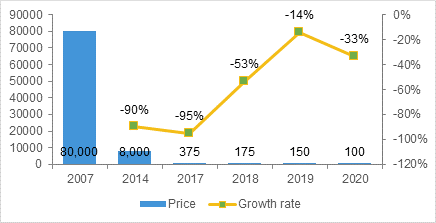

Tony Ceba liefert in seinen Vorlesungen interessante Daten zur Senkung der Lidarkosten. Wenn Lidars für die ersten autonomen Google-Computer 70.000 US-Dollar kosten (zum Beispiel kostet der auf den ersten Computern verwendete spezialisierte

HDL-64E 75.000 US-Dollar):

Quelle: Dies und Weiter Vom Parken zu Parks - Bellevue & die Störung des Transports

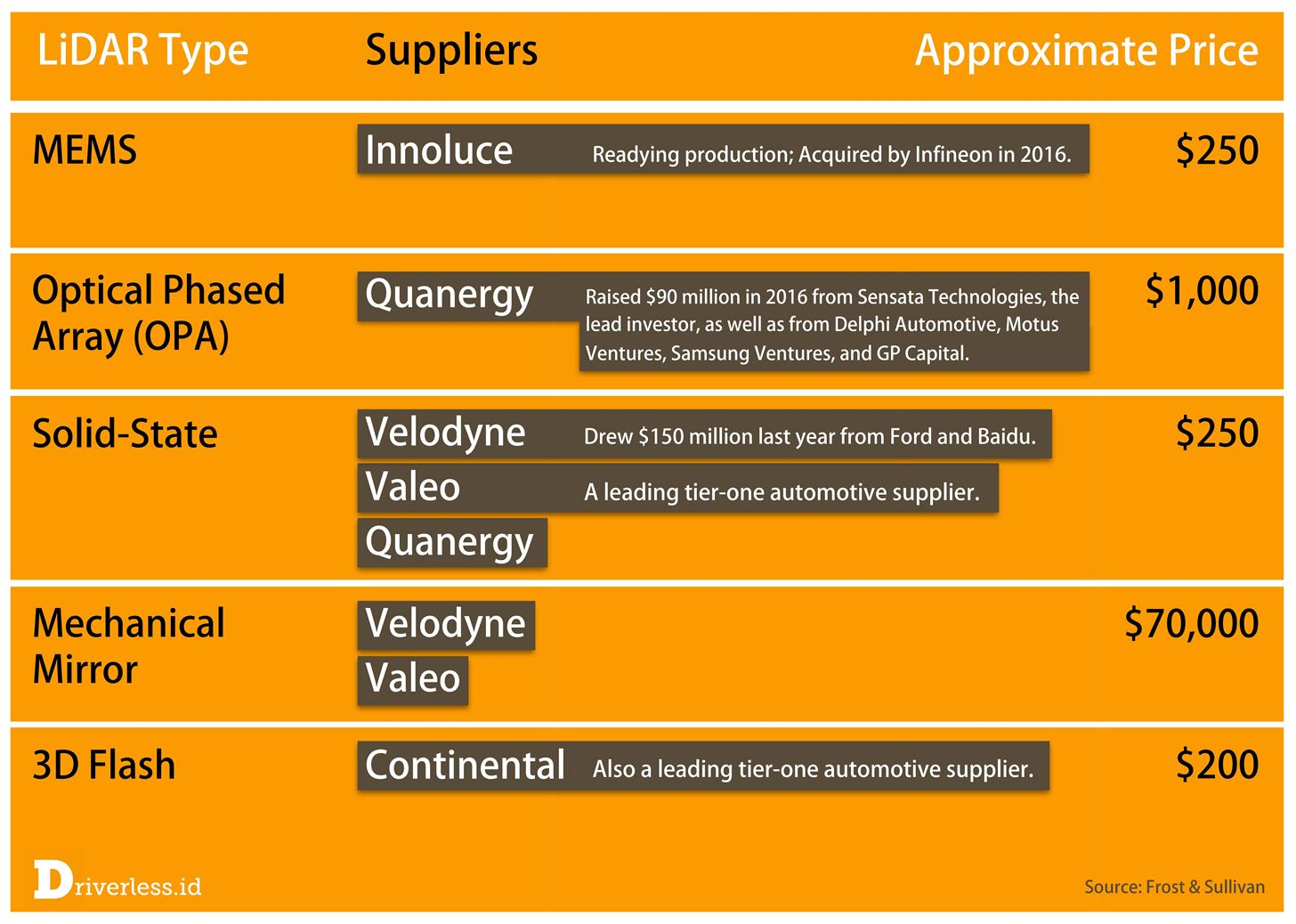

Quelle: Dies und Weiter Vom Parken zu Parks - Bellevue & die Störung des TransportsIn der Massenproduktion drohen dann neue Modelle der nächsten Generationen, den Preis deutlich unter 1000 US-Dollar zu senken:

Man kann über das Beispiel von Tony streiten (das Versprechen eines Startups sind nicht die endgültigen Kosten), aber dass es in diesem Bereich einen Boom in der Forschung gibt, die rasche Zunahme der Produktionsläufe, das Erscheinen völlig neuer Produkte und ein allgemeiner Preisverfall unbestritten sind. Wenig später im Jahr 2017 lautete die Prognose für einen Preisverfall wie folgt (und der Moment der Wahrheit wird kommen, wenn sie massiv in Autos eingebaut werden):

Quelle: LiDAR schließt Sensing Triumvirate ab

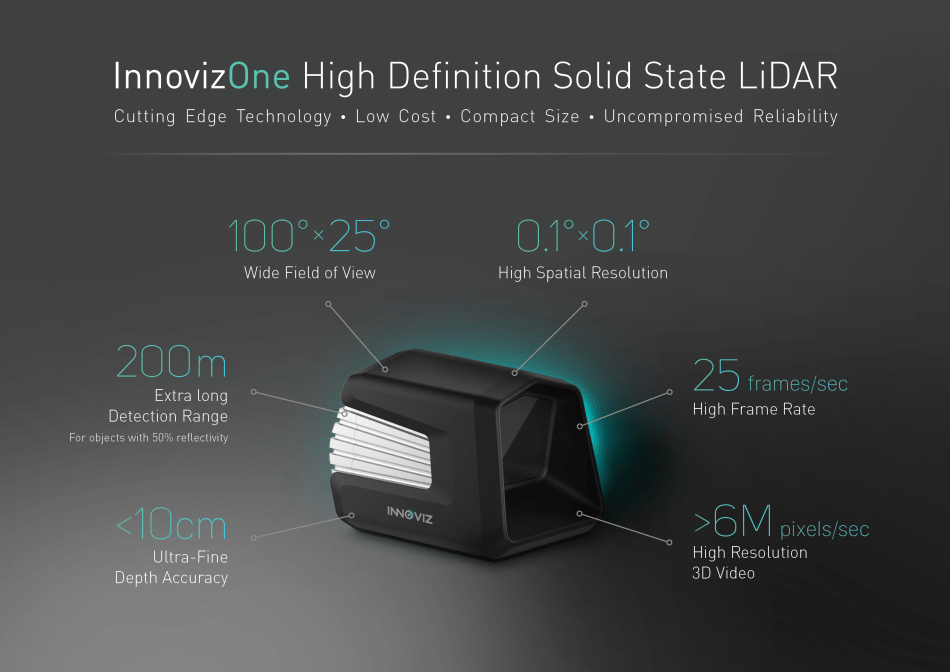

Quelle: LiDAR schließt Sensing Triumvirate abInsbesondere haben vor relativ kurzer Zeit mehrere Hersteller sofort den sogenannten

Solid State Lidar auf den

Markt gebracht , der im Grunde keine beweglichen Teile aufweist, die eine radikal höhere Zuverlässigkeit aufweisen, insbesondere beim Schütteln, bei

geringeren Kosten usw. Ich empfehle, dieses Video anzuschauen, in dem das Gerät in 84 Sekunden sehr deutlich erklärt wird:

Quelle: Festkörper-LidarsensorFür uns ist wichtig, dass Solid State Lidar ein rechteckiges Bild liefert, d.h. Tatsächlich funktioniert es wie eine „normale“ Tiefenkamera:

Quelle: Innoviz sieht massenproduzierte selbstfahrende Autos mit Festkörper-LiDAR vor

Quelle: Innoviz sieht massenproduzierte selbstfahrende Autos mit Festkörper-LiDAR vorDas obige Beispiel zeigt ein Video mit ungefähr 1024 x 256, 25 FPS und 12 Bit pro Komponente. Solche Lidars werden unter dem Haubengrill montiert (wenn sich das Gerät gut erwärmt):

Quelle: Festkörper-LiDAR-Magna-Elektronik

Quelle: Festkörper-LiDAR-Magna-ElektronikWie üblich leuchten die Chinesen, die bei der Herstellung von Elektrofahrzeugen weltweit an erster Stelle stehen und bei autonomen Autos eindeutig den ersten Platz in der Welt anstreben:

Quelle: Alibaba, RoboSense startet unbemanntes Fahrzeug mit Festkörper-LIDAR

Quelle: Alibaba, RoboSense startet unbemanntes Fahrzeug mit Festkörper-LIDARInsbesondere ihre Experimente mit einem nicht quadratischen „Pixel“ der Tiefe sind interessant. Wenn Sie eine gemeinsame Verarbeitung mit einer RGB-Kamera durchführen, können Sie die Auflösung erhöhen, und dies ist ein ziemlich interessanter Kompromiss (das „Quadrat“ der Pixel ist in der Tat nur für eine Person wichtig):

Quelle: MEMS Lidar für fahrerlose Fahrzeuge macht einen weiteren großen Schritt

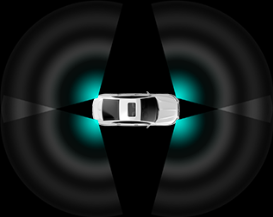

Quelle: MEMS Lidar für fahrerlose Fahrzeuge macht einen weiteren großen SchrittLidare werden in unterschiedlichen Schemata montiert, abhängig von den Kosten des Kits und der Leistung des Bordsystems, das alle diese Daten verarbeiten muss. Dementsprechend ändern sich auch die allgemeinen Eigenschaften des Autopiloten. Infolgedessen sind teurere Autos besser auf staubigen Straßen und können Autos, die an Kreuzungen an der Seite in Autos einfahren, leichter „ausweichen“. Billige Autos tragen nur dazu bei, die Anzahl der (zahlreichen) dummen Staus zu verringern:

Quelle: Beschreibung RoboSense RS-LiDAR-M1

Quelle: Beschreibung RoboSense RS-LiDAR-M1Beachten Sie, dass niedrige Preise neben Festkörpern ein paar weitere Bereiche versprechen, in denen sich Lidars entwickeln. Hier etwas vorherzusagen ist eine undankbare Aufgabe, da zu viel nicht von den möglichen technischen Eigenschaften der Technologie abhängt, sondern beispielsweise von Patenten. Es ist nur so, dass sich bereits mehrere Unternehmen mit Solid-State beschäftigen, daher sieht das Thema am vielversprechendsten aus. Aber nichts über den Rest zu sagen, wäre unfair:

Quelle: Dieser LiDAR-Engpass 2017 verursacht einen modernen Goldrausch

Quelle: Dieser LiDAR-Engpass 2017 verursacht einen modernen GoldrauschWenn wir von Lidars als Kameras sprechen, ist es erwähnenswert, ein weiteres wichtiges Merkmal zu erwähnen, das bei der Verwendung von Festkörper-Lidars von Bedeutung ist. Sie arbeiten von Natur aus wie Kameras mit einem bereits vergessenen beweglichen

Verschluss , der beim Aufnehmen bewegter Objekte zu merklichen Verzerrungen führt:

Quelle: Was ist der Unterschied zwischen einem globalen (globalen) Verschluss und einem rollenden Verschluss ?

Quelle: Was ist der Unterschied zwischen einem globalen (globalen) Verschluss und einem rollenden Verschluss ?Angesichts der Tatsache, dass sich auf der Straße, insbesondere auf der Autobahn mit einer Geschwindigkeit von 150 km / h, alles recht schnell ändert, verzerrt diese Funktion von Lidars Objekte erheblich, einschließlich solcher, die schnell auf uns zufliegen ... Einschließlich der Tiefe ... Beachten Sie, dass die beiden vorherigen Methoden Tiefe zu bekommen ist kein solches Problem.

Quelle: Schöne Wikipedia-Animation mit Auto-VerzerrungDieses Merkmal erfordert in Verbindung mit niedrigen FPS die Anpassung von Verarbeitungsalgorithmen, aber aufgrund der hohen Genauigkeit, auch bei großen Entfernungen, haben Lidars auf keinen Fall besondere Konkurrenten.Interessanterweise funktionieren Lidars von Natur aus sehr gut in ebenen Bereichen und schlechter an Grenzen, und Stereosensoren sind in geraden Bereichen schlecht und an Grenzen relativ gut. Außerdem ergeben Lidars eine relativ kleine FPS, und die Kameras sind viel größer. Infolgedessen ergänzen sie sich im Wesentlichen, was auch bei Lytro Cinema-Kameras verwendet wurde (auf dem Foto in der Nähe der Kamera befindet sich eine beleuchtete plenoptische Linse mit bis zu 300 FPS und das schwarze Quadrat von

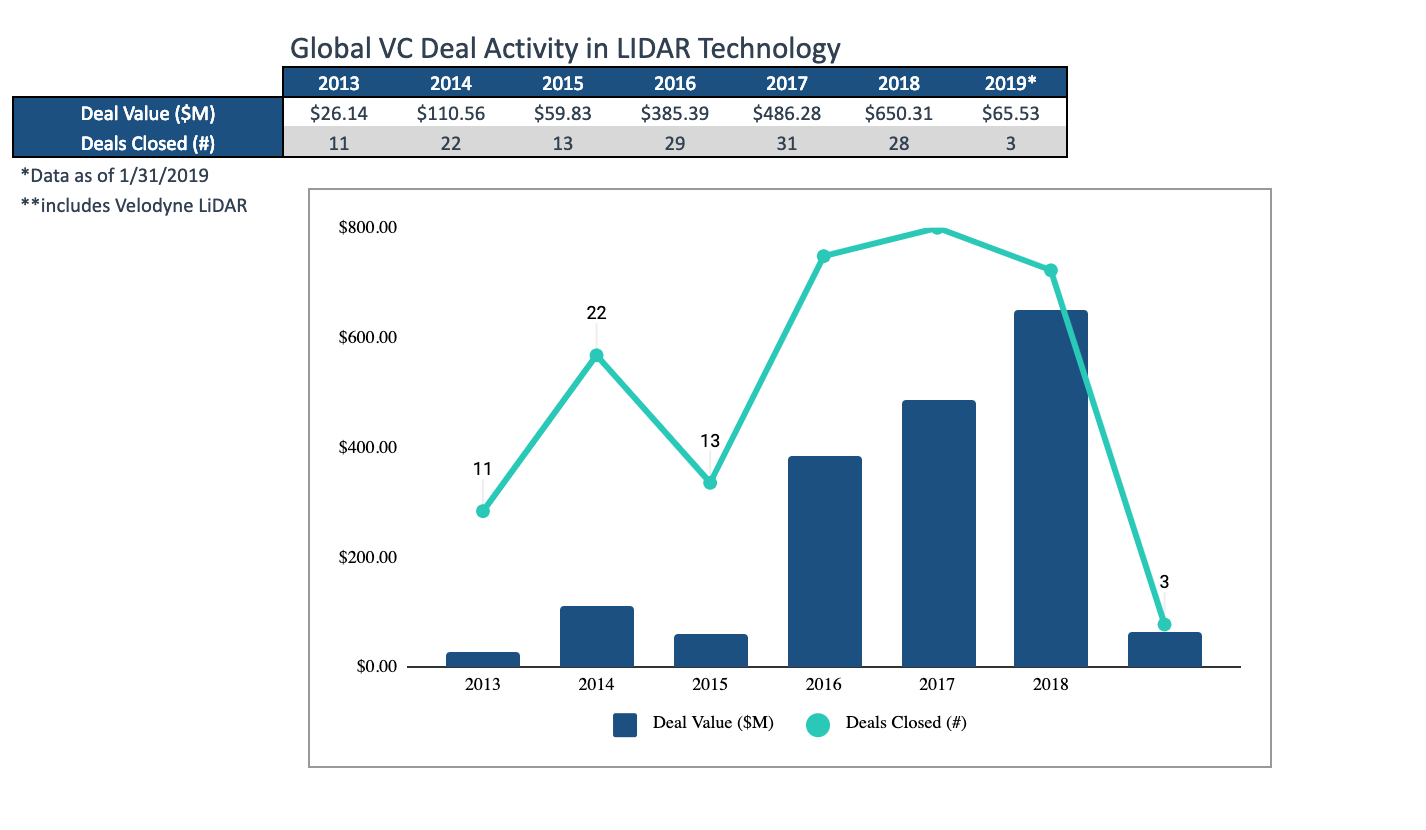

Quelle: Schöne Wikipedia-Animation mit Auto-VerzerrungDieses Merkmal erfordert in Verbindung mit niedrigen FPS die Anpassung von Verarbeitungsalgorithmen, aber aufgrund der hohen Genauigkeit, auch bei großen Entfernungen, haben Lidars auf keinen Fall besondere Konkurrenten.Interessanterweise funktionieren Lidars von Natur aus sehr gut in ebenen Bereichen und schlechter an Grenzen, und Stereosensoren sind in geraden Bereichen schlecht und an Grenzen relativ gut. Außerdem ergeben Lidars eine relativ kleine FPS, und die Kameras sind viel größer. Infolgedessen ergänzen sie sich im Wesentlichen, was auch bei Lytro Cinema-Kameras verwendet wurde (auf dem Foto in der Nähe der Kamera befindet sich eine beleuchtete plenoptische Linse mit bis zu 300 FPS und das schwarze Quadrat von Malevich Lidar darunter ): Quelle: Lytro ist bereit, das Filmemachen für immer zu verändern : debütiert auf der NAB mit dem Prototyp und dem Kurzfilm des KinosWenn zwei Tiefensensoren in einer Filmkamera kombiniert wurden, kann bei anderen Geräten (von Smartphones bis zu Autos) erwartet werden, dass die Massenverteilung von Hybridsensoren maximale Qualität gewährleistet.In gewisser Weise handelt es sich bei Lidars immer noch um Investitionen, die sich in den letzten drei Jahren auf etwa 1,5 Milliarden US-Dollar beliefen (glücklicherweise wird dieser Markt in 6 Jahren auf 10 Milliarden US-Dollar geschätzt, und die folgende Grafik zeigt, wie die durchschnittliche Transaktionsgröße gewachsen ist):

Quelle: Lytro ist bereit, das Filmemachen für immer zu verändern : debütiert auf der NAB mit dem Prototyp und dem Kurzfilm des KinosWenn zwei Tiefensensoren in einer Filmkamera kombiniert wurden, kann bei anderen Geräten (von Smartphones bis zu Autos) erwartet werden, dass die Massenverteilung von Hybridsensoren maximale Qualität gewährleistet.In gewisser Weise handelt es sich bei Lidars immer noch um Investitionen, die sich in den letzten drei Jahren auf etwa 1,5 Milliarden US-Dollar beliefen (glücklicherweise wird dieser Markt in 6 Jahren auf 10 Milliarden US-Dollar geschätzt, und die folgende Grafik zeigt, wie die durchschnittliche Transaktionsgröße gewachsen ist): Quelle: Interessant März Rückblick auf die Trends auf dem Lidar-Markt durch TechcrunchDer Entwicklungszyklus eines innovativen Produkts selbst in hart umkämpften Märkten beträgt 1,5 bis 2 Jahre, sodass wir bald äußerst interessante Produkte sehen werden. Sie existieren bereits als Prototypen.Wichtige Punkte:

Quelle: Interessant März Rückblick auf die Trends auf dem Lidar-Markt durch TechcrunchDer Entwicklungszyklus eines innovativen Produkts selbst in hart umkämpften Märkten beträgt 1,5 bis 2 Jahre, sodass wir bald äußerst interessante Produkte sehen werden. Sie existieren bereits als Prototypen.Wichtige Punkte:- Pluspunkte von Lidars:

- die höchste Genauigkeit, einschließlich der besten unter allen Methoden auf große Entfernungen,

- Arbeiten Sie am besten auf ebenen Flächen, auf denen die Stereoanlage nicht mehr funktioniert.

- fast nicht mit der Sonne scheinen,

- Nachteile von Lidars:

- hoher Stromverbrauch

- relativ niedrige Bildrate

- den laufenden Verschluss und die Notwendigkeit, ihn während der Verarbeitung zu kompensieren,

- In der Nähe befindliche Lidare stören sich gegenseitig, was nicht so einfach zu kompensieren ist.

- Trotzdem beobachten wir, wie buchstäblich in 2 Jahren im Wesentlichen eine neue Art von Tiefenkameras mit hervorragenden Aussichten und einem riesigen potenziellen Markt entstanden ist. In den kommenden Jahren können wir mit einer erheblichen Preissenkung rechnen, einschließlich des Auftretens kleiner universeller Lidars für Industrieroboter.

Videoverarbeitung mit Tiefe

Überlegen Sie kurz, warum die Tiefe nicht so einfach zu handhaben ist.

Im Folgenden finden Sie ein Beispiel für eingehende Rohdaten einer sehr guten Reihe von

Intel RealSense-Kameras . An den Fingern in diesem Video können Sie den Betrieb der Kamera und die Verarbeitungsalgorithmen relativ einfach „mit dem Auge“ bewerten:

Quelle: im Folgenden - die Materialien des Autors

Quelle: im Folgenden - die Materialien des AutorsTypische Probleme von Tiefenkameras sind deutlich sichtbar:

- Daten sind im Wert instabil, Pixel in der Tiefe „Rauschen“.

- Entlang der Grenzen über eine ziemlich große Breite sind die Daten auch sehr verrauscht (aus diesem Grund maskieren sich die Tiefenwerte entlang der Grenzen oft einfach, um die Arbeit nicht zu beeinträchtigen).

- Um den Kopf herum sieht man viele "gehende" Pixel (anscheinend beginnt die Nähe zur Wand im Rücken + Haar zu beeinflussen).

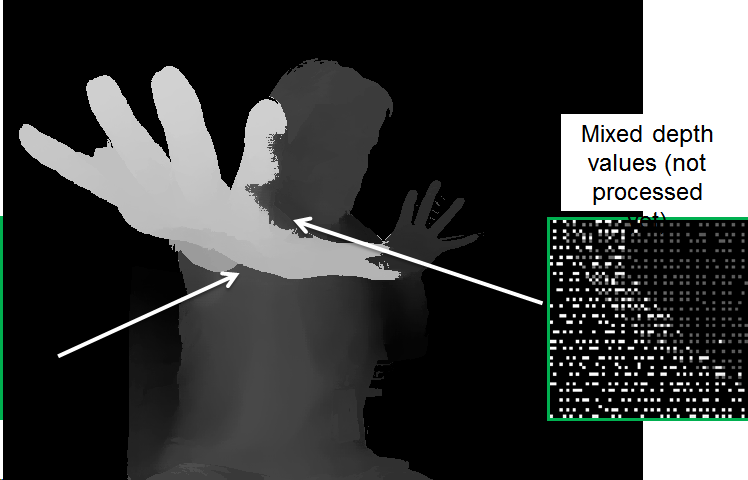

Das ist aber noch nicht alles. Wenn wir uns die Daten genauer ansehen, ist klar, dass an einigen Stellen die tieferen Daten die näheren „durchscheinen“:

Dies liegt daran, dass das Bild zur Vereinfachung der Verarbeitung von der RGB-Kamera auf das Bild reduziert wird. Da die Grenzen nicht genau bestimmt werden, müssen solche „Überlappungen“ speziell verarbeitet werden, da sonst Probleme auftreten, wie z. B. solche „Löcher“ in der Tiefe des Arms:

Bei der Verarbeitung treten viele Probleme auf, zum Beispiel:

- "Leckage" der Tiefe von einem Objekt zum anderen.

- Instabilität der Tiefe im Laufe der Zeit.

- Aliasing (Bildung einer "Leiter"), wenn die Unterdrückung von Tiefenrauschen zur Diskretisierung von Tiefenwerten führt:

Es ist jedoch klar, dass sich das Bild stark verbessert hat. Beachten Sie, dass langsamere Algorithmen die Qualität immer noch erheblich verbessern können.

Im Allgemeinen ist die

Tiefenvideoverarbeitung ein eigenständiges großes Thema, das sich bisher nicht mit so vielen Menschen befasst, aber rasch an Popularität gewinnt. Der bisherige Markt, den sie komplett verändert hat, ist die Konvertierung von Filmen von 2D nach 3D. Das Ergebnis der manuellen Erstellung von Stereo aus 2D-Videos verbesserte sich so schnell, zeigte ein viel vorhersehbareres Ergebnis, verursachte so weniger Kopfschmerzen und weniger Kosten, dass sie im 3D-Kino nach fast 100 Jahren Dreharbeiten (!) Ziemlich schnell fast vollständig aufhörten und nur mit der Konvertierung begannen . Es gab sogar eine eigene Spezialität -

Tiefenkünstler , und die

Stereographen der alten Schule standen unter Schock („ka-ak-a-ak?“). Die Schlüsselrolle bei dieser Revolution spielte die rasche Verbesserung der Videoverarbeitungsalgorithmen. Vielleicht werde ich eines Tages Zeit finden, eine separate Artikelserie darüber zu schreiben, weil mein Material in großen Mengen vorhanden ist.

Etwa das Gleiche ist in naher Zukunft für Tiefenkameras von Robotern, Smartphones und autonomen Autos zu erwarten.

Wach auf! Die Revolution kommt!Anstelle einer Schlussfolgerung

Vor ein paar Jahren brachte Ihr bescheidener Diener einen Vergleich verschiedener Ansätze, um Video mit Tiefe auf eine einzige Platte zu bringen. Im Allgemeinen hat sich die Situation in dieser Zeit nicht geändert. Die Trennung ist hier eher willkürlich, da sich die Hersteller der Nachteile von Technologien bewusst sind und versuchen, diese auszugleichen (manchmal äußerst erfolgreich). Im Allgemeinen können jedoch verschiedene Ansätze verglichen werden:

Quelle: Materialien des Autors

Quelle: Materialien des AutorsGehen wir über den Tisch:

- Bei der Auflösung liegt die Tiefe von Stereo im Vordergrund, aber alles hängt sehr stark von der Szene ab (wenn es monophon ist, ist das Ding eine Pfeife).

- In Bezug auf die Genauigkeit sind Lidars unübertroffen, die Situation mit der Plenoptik ist übrigens die schlechteste.

- Aufgrund der Komplexität der Verarbeitung erhalten nur ToF und Lidars die „Tiefe“ direkt. Um die Tiefe von Stereo und Plenoptik zu erhalten, sind viele sehr nicht triviale Berechnungen erforderlich.

- Laut FPS sind ToF-Kameras strukturell gut und werden in naher Zukunft, wenn das Bügeleisen hochgezogen wird, von Stereokameras eingeholt (die bis zu 300 fps liefern können). Lidaram träumt bisher nur davon.

- Entsprechend den Ergebnissen bei schlechten Lichtverhältnissen wird erwartet , dass Stereo und Plenoptik verlieren.

- Bei Arbeiten im Freien - ToF- und strukturierte Lichtkameras funktionieren nicht gut.

Gleichzeitig ist es wichtig, die Situation in bestimmten Märkten gut zu verstehen. Zum Beispiel scheint der plenoptische Ansatz deutlich hinterherzuhinken. Wenn sich jedoch herausstellt, dass es das Beste für AR ist (und dies wird in den nächsten drei bis vier Jahren deutlich werden), wird es seinen rechtmäßigen Platz in

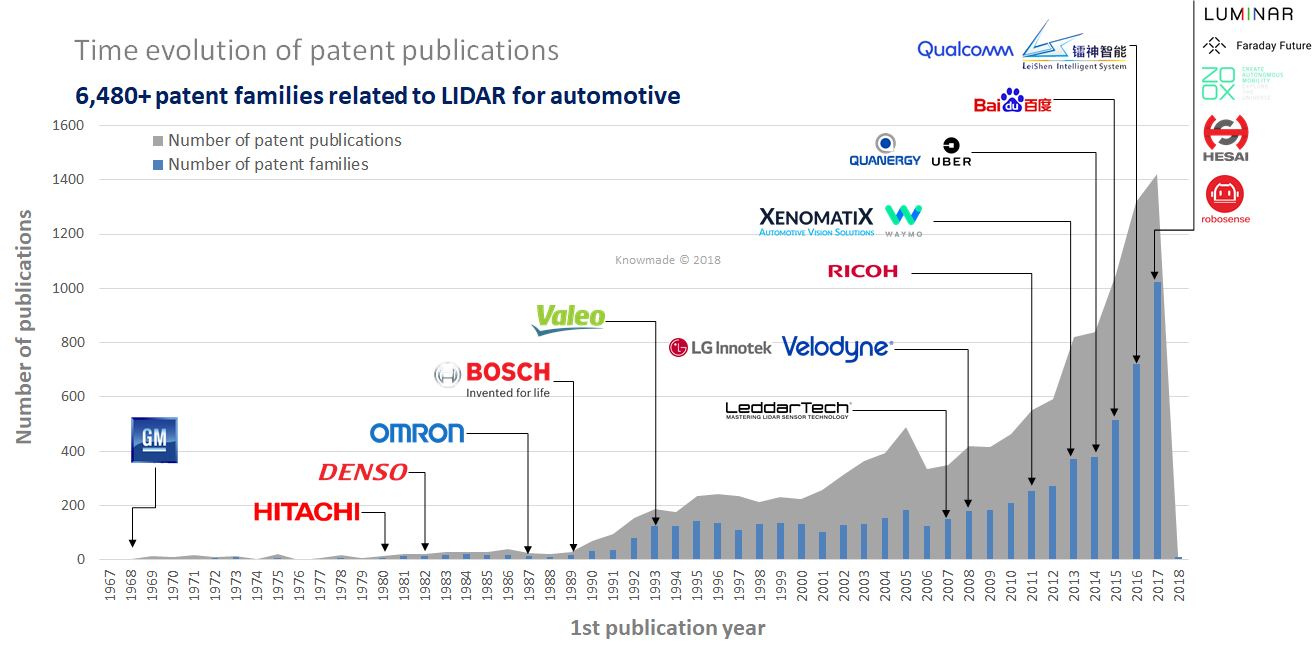

jedem Telefon und Tablet einnehmen. Es zeigt sich auch, dass Festkörper-Lidars am besten aussehen (die „grünsten“), aber dies ist die jüngste Technologie, und dies sind ihre eigenen Risiken, insbesondere die patentierten (auf dem Gebiet gibt es viele neue Patente, die nicht bald ablaufen werden):

Quelle: LiDAR: Ein Überblick über die Patentlandschaft

Quelle: LiDAR: Ein Überblick über die PatentlandschaftWir vergessen jedoch nicht, dass der Markt für Tiefensensoren für Smartphones für das nächste Jahr auf

6 Milliarden US-Dollar geplant

ist und nicht weniger als 4

US-Dollar betragen darf, da er im vergangenen Jahr mehr als 3 Milliarden US-Dollar betrug. Dies ist eine enorme Geldsumme, die nicht nur zur Kapitalrendite (für die erfolgreichsten Investoren), sondern auch zur Entwicklung neuer Sensorgenerationen verwendet wird. Es gibt noch kein ähnliches Wachstum bei Lidars, aber nach allen Anzeichen wird es in den nächsten 3 Jahren buchstäblich gehen. Und dann ist dies ein gewöhnlicher Lawinen-ähnlicher Exponentialprozess, der bereits mehr als einmal stattgefunden hat.

Die nahe Zukunft der Tiefenkameras sieht äußerst interessant aus!

Karthago muss kaputt sein ... Das ganze Video wird bis Ende des Jahrhunderts dreidimensional sein!Bleib dran!

Wer hat nicht gelesen - der

erste Teil des Textes !

DanksagungIch möchte mich herzlich bedanken bei:

- Labor für Computergrafik VMK Moscow State University MV Lomonosov für seinen Beitrag zur Entwicklung der Computergrafik in Russland und nicht nur

- Google, Apple und Intel für großartige kompakte Lösungen und alle Lidar-Hersteller für schnelle Fortschritte.

- persönlich Konstantin Kozhemyakov, der viel getan hat, um diesen Artikel besser und visueller zu machen,

- und schließlich vielen Dank an Roman Kazantsev, Eugene Lyapustin und Yegor Sklyarov für eine große Anzahl vernünftiger Kommentare und Korrekturen, die diesen Text viel besser gemacht haben!