Vor nicht allzu langer Zeit stand ich vor der Aufgabe, auf ein neues BI-System für unser Unternehmen umzusteigen. Da ich mich ziemlich tief und gründlich mit diesem Thema befassen musste, beschloss ich, meine Gedanken dazu mit der seriösen Community zu teilen.

Im Internet gibt es viele Artikel zu diesem Thema, aber zu meiner großen Überraschung beantworteten sie nicht viele meiner Fragen zur Auswahl des richtigen Tools und waren etwas oberflächlich. Innerhalb von 3 Wochen nach dem Testen haben wir 4 Tools getestet:

Tableau, Looker, Periscope / Sisense, Modusanalyse . Diese Tools werden hauptsächlich in diesem Artikel behandelt. Ich muss sofort sagen, dass der vorgeschlagene Artikel die persönliche Meinung des Autors ist und die Bedürfnisse eines kleinen, aber sehr schnell wachsenden IT-Unternehmens widerspiegelt :)

Ein paar Worte zum Markt

Jetzt finden auf dem BI-Markt interessante Änderungen statt, die Konsolidierung ist im Gange, große Cloud-Technologie-Player versuchen, ihre Position durch vertikale Integration aller Aspekte der Arbeit mit Daten (Datenspeicherung, -verarbeitung, -visualisierung) zu stärken. In den letzten Monaten gab es 5 größere Übernahmen: Google kaufte Looker, Salesforce kaufte Tableau, Sisense kaufte Periscope Data, Logi Analytics kaufte Zoomdata, Alteryx kaufte ClearStory Data. Wir werden nicht weiter in die Unternehmenswelt der Fusionen und Übernahmen eintauchen. Es ist erwähnenswert, dass

weitere Änderungen sowohl in der Preisgestaltung als auch in den protektionistischen Richtlinien der neuen Eigentümer von BI-Tools zu erwarten sind (wie uns das Alooma-Tool kürzlich kurz nach dem Kauf durch Google gefiel) alle Datenquellen außer Google BigQuery werden nicht mehr unterstützt :)).

Ein bisschen Theorie

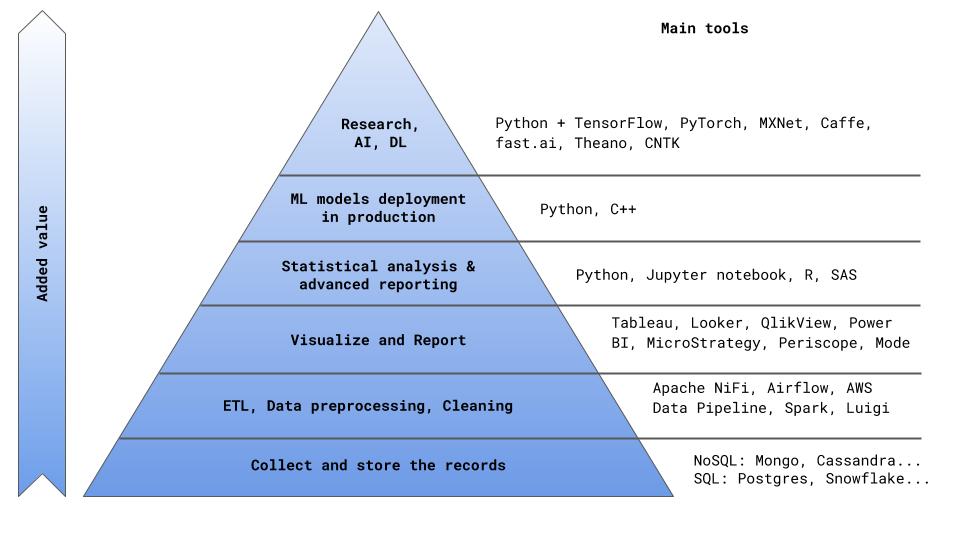

Also wollte ich mit einem kleinen theoretischen Teil beginnen, denn jetzt wo ohne Theorie. Laut Gartner ist ein BI-System ein Begriff, der Softwareprodukte, Tools, Infrastruktur und Best Practices kombiniert, um Entscheidungen zu verbessern und zu optimieren [1]. Diese Definition umfasst auch Datenspeicherung und ETL. In diesem Artikel schlage ich vor, mich auf ein engeres Segment zu konzentrieren, nämlich Softwareprodukte für die Datenvisualisierung und -analyse.

In der Pyramide der Wertschöpfung für das Unternehmen (ich hatte den Mut, eine weitere Darstellung dieser offensichtlichen Struktur in Abb. 0 vorzuschlagen) befinden sich die BI-Tools hinter den Blöcken zum Speichern von Datensätzen und zur vorläufigen Datenverarbeitung (ETL).

Dies ist wichtig zu verstehen - die

beste Vorgehensweise in diesem Fall ist die Trennung von ETL- und BI-Aufgaben . Neben einem transparenteren Prozess der Arbeit mit Daten sind Sie auch nicht an eine Softwarelösung gebunden und können für jede ETL- und BI-Aufgabe das am besten geeignete Tool auswählen. Mit einem gut strukturierten ETL-Prozess und einer optimalen Architektur von Datentabellen können Sie im Allgemeinen 80% aller dringenden geschäftlichen Probleme ohne Verwendung spezieller Software schließen. Dies erfordert natürlich eine erhebliche Beteiligung von Analysten und DS. Daher kommen wir zur Hauptfrage: Was brauchen wir eigentlich zuerst von einem BI-Softwareprodukt?

Abb. 0

Schlüsselkriterien für die Auswahl eines BI-Softwareprodukts

Wie wir bereits verstanden haben, können alle wichtigen Metriken und Leistungsindikatoren des gesamten Unternehmens direkt aus den Analysetabellen in der Datenbank entnommen werden, die zuvor im Rahmen des ETL-Prozesses erstellt wurden (ich werde Ihnen im nächsten Artikel erläutern, wie Sie einen ETL-Prozess optimal erstellen können In der Zwischenzeit werde ich einen Vorgeschmack geben, warum dies so wichtig ist: Laut einer Kaggle-Umfrage besteht die Hauptschwierigkeit, mit der die Hälfte der DS konfrontiert ist, in schmutzigen Daten [2]. Das Hauptproblem in diesem Fall wird natürlich die Komplexität und Ineffizienz der Nutzung der Analystenzeit sein. Anstatt ein vollwertiges Produkt zu erstellen, erstellen Analysten / DS ständig Indikatoren, zählen Metriken, überprüfen Diskrepanzen in Zahlen, suchen nach Fehlern im SQL-Code und führen andere nicht hilfreiche Aktivitäten aus. Hier bin ich davon überzeugt, dass Analysten / DS vor allem ein Produkt schaffen sollten, das dem Unternehmen auf lange Sicht einen Mehrwert bringt. Dies kann entweder ein Abrechnungs- / Vorhersagedienst sein, dessen Ergebnis Teil des Hauptprodukts des Unternehmens ist (z. B. ein Algorithmus zur Berechnung der Kosten / Zeit einer Reise), oder beispielsweise ein Algorithmus zur Verteilung von Bestellungen unter Kunden oder ein vollständiger Analysebericht, in dem die Gründe für den Abfluss von Benutzern und eine Verringerung der MAU ermittelt werden .

Daher sollte das Hauptkriterium für die Auswahl eines Analysesystems die

Fähigkeit sein, Analysten so weit wie möglich von Ad-hoc-Problemen und Fluidität zu entlasten. Wie kann dies erreicht werden? Tatsächlich gibt es zwei Möglichkeiten: a) automatisieren, b) delegieren. Mit dem zweiten Absatz meine ich den mittlerweile beliebten Ausdruck

Self Service - um Unternehmen die Möglichkeit zu geben, sich mit den Daten selbst zu befassen.

Das heißt, Analysten richten ein Softwareprodukt einmal ein: Erstellen Sie Datenwürfel, richten Sie die automatische Aktualisierung von Cubes ein (z. B. jede Nacht), senden Sie automatisch Berichte, bereiten Sie mehrere Dashboard-Assistenten vor und bringen Sie den Benutzern die Verwendung des Produkts bei. Darüber hinaus stellt das Unternehmen seine zusätzlichen Anforderungen unabhängig bereit, indem es die erforderlichen Indikatoren in verschiedenen Datenaggregationen und -filtern mithilfe der einfachen und verständlichen

Drag & Drop- Option berechnet.

Neben der Einfachheit des Berichtsprozesses

ist auch die Geschwindigkeit der Abfrageausführung wichtig . Niemand wird 15 Minuten auf den Vormonat warten, um Daten oder Metriken für eine andere Stadt zu laden. Um dieses Problem anzugehen, gibt es mehrere allgemein akzeptierte Ansätze. Eine davon ist die Erstellung von

OLAP-Datenwürfeln (Online Analytical Processing). In OLAP-Cubes werden Datentypen in Dimensionen (Dimensionen) unterteilt. Dies sind Felder, mit denen Aggregationen durchgeführt werden können (z. B. Stadt, Land, Produkt, Zeitintervalle, Zahlungsart ...), und Kennzahlen sind berechnete Metriken für Messungen (z. B. Anzahl der Reisen, Einnahmen, Anzahl der neuen Benutzer, durchschnittlicher Scheck, ...). Data Cubes ist ein ziemlich leistungsfähiges Tool, mit dem Sie mit voraggregierten Daten und berechneten Metriken sehr schnell Ergebnisse erzielen können. Die Kehrseite von OLAP-Cubes ist die Tatsache, dass alle Daten vorab erfasst werden und sich erst beim nächsten Cube-Build ändern. Wenn Sie eine Datenaggregation oder eine Metrik benötigen, die ursprünglich nicht berechnet wurde, oder wenn Sie neuere Daten benötigen, müssen Sie

den Datenwürfel

neu erstellen.

Eine weitere Lösung zur Erhöhung der Geschwindigkeit beim Arbeiten mit Daten sind

In-Memory-Lösungen . In Memory Database (IMDB) bietet maximale Leistung, wenn genügend RAM zum Speichern von Daten vorhanden ist. Während relationale Datenbanken so konzipiert sind, dass sie maximale Leistung bieten, wenn Daten nicht vollständig im RAM abgelegt sind und langsame Festplatten-E / A in Echtzeit ausgeführt werden sollten. Viele moderne Tools kombinieren beide Lösungen (z. B. Sisense, Tableau, IBM Cognos, MicroStrategy usw.).

Zuvor haben wir über die Einfachheit und Bequemlichkeit der Verwendung von BI-Tools für Geschäftsanwender gesprochen. Es ist wichtig, einen

praktischen Dashboard-Entwicklungs- und Freigabeprozess für Analysten / DS einzurichten. Hier ist die Situation ähnlich wie bei jedem anderen IT-Produkt - Sie benötigen einen schnellen und bequemen Bereitstellungsprozess (

schnelle Bereitstellungszeit ) sowie einen durchdachten Entwicklungsprozess, Tests, Codeüberprüfung, Freigabe, Versionskontrolle und Teamzusammenarbeit. All dies wird durch das Konzept des Workflows kombiniert.

Damit kommen wir zu den

wichtigsten Anforderungen für das BI-Softwareprodukt . Dieselben Anforderungen bildeten die Grundlage für die Speed-Map, auf deren Grundlage wir schließlich einen Produktlieferanten auswählten.

Tabelle 1. Auswahlkriterien für BI-Tools.

Die endgültige Tabelle der Abstimmungsergebnisse in unserem Team lautet wie folgt:

Tabelle 2. Abstimmungsergebnisse für die Auswahl eines BI-Tools.

Seitens der Geschäftsanwender (sie nahmen auch an der Auswahl des Produkts teil) wurden die Stimmen ungefähr zu gleichen Teilen zwischen Tableau und Looker aufgeteilt. Infolgedessen wurde die Wahl zugunsten von Looker getroffen. Warum Looker und was sind die grundlegenden Unterschiede zwischen den Tools, werden wir jetzt diskutieren.

Detaillierte Werkzeugbeschreibung

Beginnen wir also mit der Beschreibung der BI-Tools.

Tableau

(Hier sprechen wir über ein erweitertes Servicepaket: Tableau Online)

- UX + Drag & Drop.

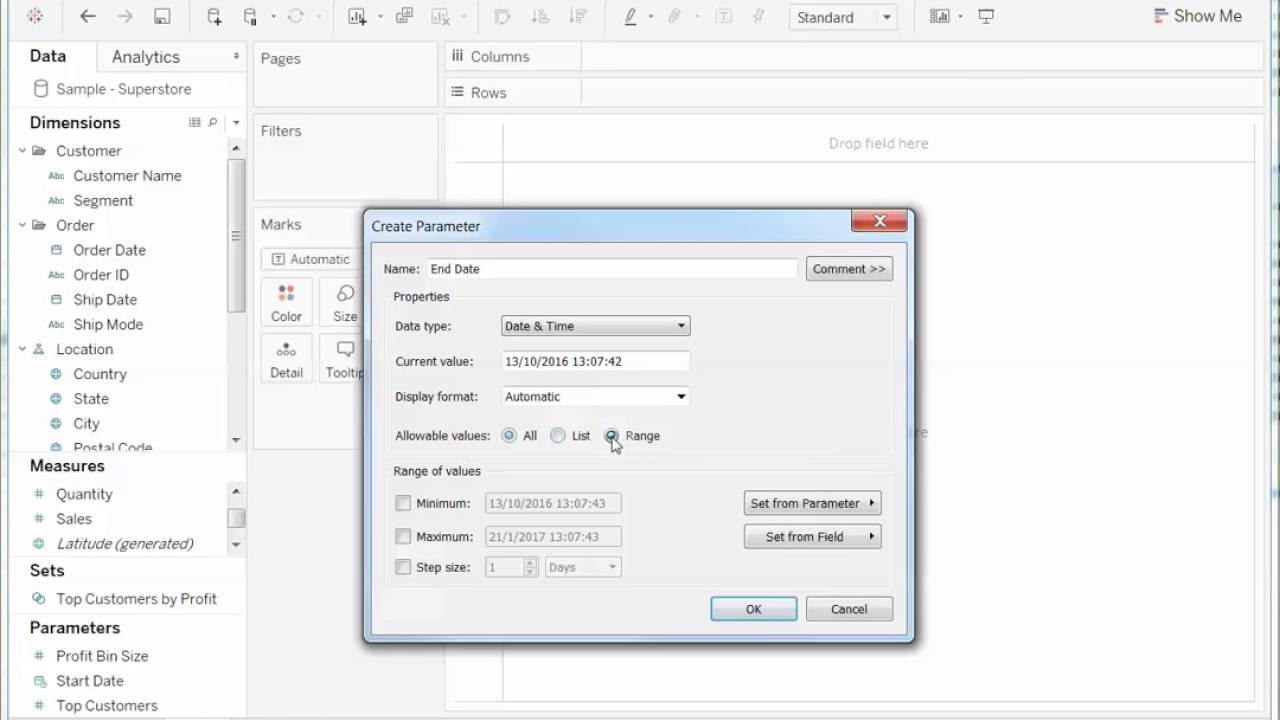

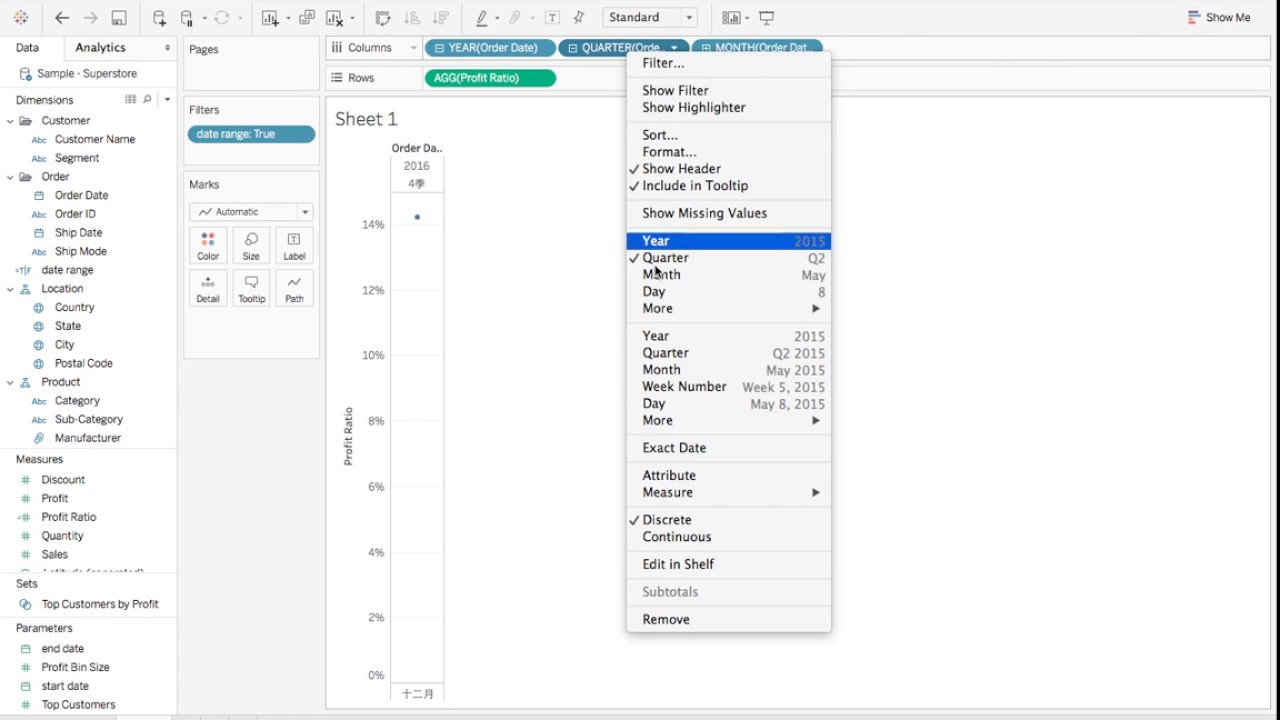

Tableau ist seit 2003 ein ziemlich altes Tool auf dem Markt, und es besteht das Gefühl, dass sich die Benutzeroberfläche seitdem nicht wesentlich geändert hat. Möglicherweise haben Sie Angst vor Popups und Dropdown-Optionen im Stil von Windows XP (Abb. 1, Abb. 2). Aber ziemlich schnell können Sie sich an die Grundfunktionen des Tools gewöhnen und diese beherrschen. Tableau erinnert viele an die erweiterte Version von Excel. Es verfügt über Registerkarten (Arbeitsblätter) und Dashboards (Dashboards) - eine Kombination von Visualisierungen, die auf Arbeitsblättern erhalten wurden. Die Drag & Drop-Option ist recht einfach zu verwenden, Filter in den Diagrammen können einfach konfiguriert und geändert werden (Abb. 3, Abb. 4). Tableau verfügt über zwei Versionen des Dienstes: Desktop und Desktop + Online. Desktop ist eher altmodisch - es ist in der Tat fortgeschrittenes Excel. Die Online-Version für den Testzeitraum war oft nachdenklich und endete manchmal mit der Aktualisierung der Seite, ohne Ihre Arbeit zu speichern.

Abb. 1

Abb. 2

Abb. 3

Abb. 4

- Datenverarbeitung.

Tableau verarbeitet Daten sehr schnell. Das Ändern des Zeitfilters oder der Aggregation erfolgt selbst bei großen Datenmengen (mehr als 20 Millionen Datensätze) in Sekundenschnelle. Wie bereits erwähnt, verwendet Tableau hierfür sowohl OLAP-Datenwürfel als auch In-Memory-Datenmodule. Tableau behauptet, dass sich die Ausführungsgeschwindigkeit von Abfragen dank der internen In-Memory-Lösung Hyper verfünffacht hat.

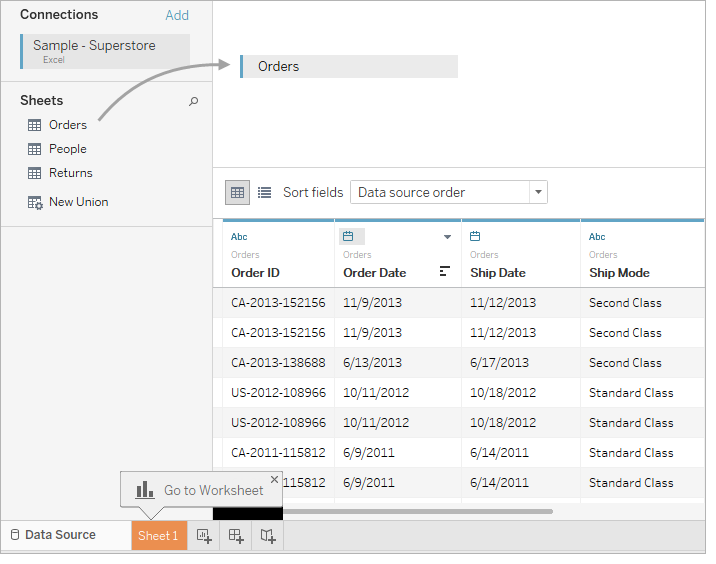

Datenwürfel können in der lokalen Version von Tableau Desktop konfiguriert und auf einem Netzwerkserver heruntergeladen oder aktualisiert werden. In diesem Fall werden alle Dashboards, die auf der vorherigen Version der Cube-Assembly basieren, automatisch aktualisiert. Update-Cubes können beispielsweise nachts automatisch konfiguriert werden. Alle Maße und Maße (Maße und Maße) werden beim Zusammenbau des Würfels im Voraus festgelegt und ändern sich erst in der nächsten Version des Zusammenbaus. Zusammen mit der Verwendung von Datenwürfeln in Tableau ist es möglich, direkt auf die Datenbank zuzugreifen. Dies wird als Live-Verbindung bezeichnet. In diesem Fall ist die Geschwindigkeit viel geringer, die Daten sind jedoch relevanter. Das Zusammenstellen eines Datenwürfels ist recht einfach. Die Hauptsache besteht darin, die richtigen Felder für das Zusammenstellen mehrerer Tabellen (Verknüpfungen) auszuwählen (Abb. 5).

Abb. 5

- Workflow

Aus diesem Grund haben wir uns in Zukunft nicht für Tableau entschieden. Nach diesem Parameter blieb Tableau deutlich hinter der Branche zurück und konnte keine Tools anbieten, um die Entwicklung und Freigabe von Dashboards zu vereinfachen. Tableau bietet weder Versionskontrolle, Codeüberprüfung, Teamzusammenarbeit noch eine durchdachte Entwicklungs- und Testumgebung. Genau aus diesem Grund geben Unternehmen Tableau häufig zugunsten fortschrittlicherer Tools auf. Bereits bei einigen Mitarbeitern, die an der Erstellung von Datenwürfeln und Dashboards beteiligt sind, kann es zu Verwirrung kommen - wo die neueste Version der Daten zu finden ist, welche Metriken verwendet werden können und welche nicht. Es besteht ein Mangel an Datenintegrität, was zu einem Misstrauen gegenüber dem Unternehmen in Bezug auf die im System angezeigten Metriken führt.

- Visualisierung

In Bezug auf die Datenvisualisierung ist Tableau ein sehr leistungsfähiges Werkzeug. Sie finden Diagramme und Grafiken für jeden Geschmack und jede Farbe (Abb. 6). Datenvisualisierung - Seite, wie in Excel, können Sie zwischen Registerkarten wechseln.

Abb. 6

- Unterstützung.

Aus Sicht des Tableau-Supports schien es mir nicht sehr kundenorientiert zu sein , ich musste die Antwort für die meisten Fragen selbst finden. Glücklicherweise hat Tableau eine ziemlich große Community, in der Sie Antworten auf die meisten Fragen finden können.

- Statistik

Tableau kann in Python integriert werden. Weitere Details finden Sie hier.

- Preis

Die Preise sind ziemlich normal für den Markt, können auf der offiziellen Website gefunden werden. Der Preis hängt von der Benutzerebene ab (Entwickler, Explorer, Viewer). Die Beschreibung finden Sie dort . Bei der Berechnung von 10 Entwicklern, 25 Forschern und 100 Zuschauern werden pro Jahr 39.000 US-Dollar pro Jahr ausgegeben.

Guck mal

- UX + Drag & Drop.

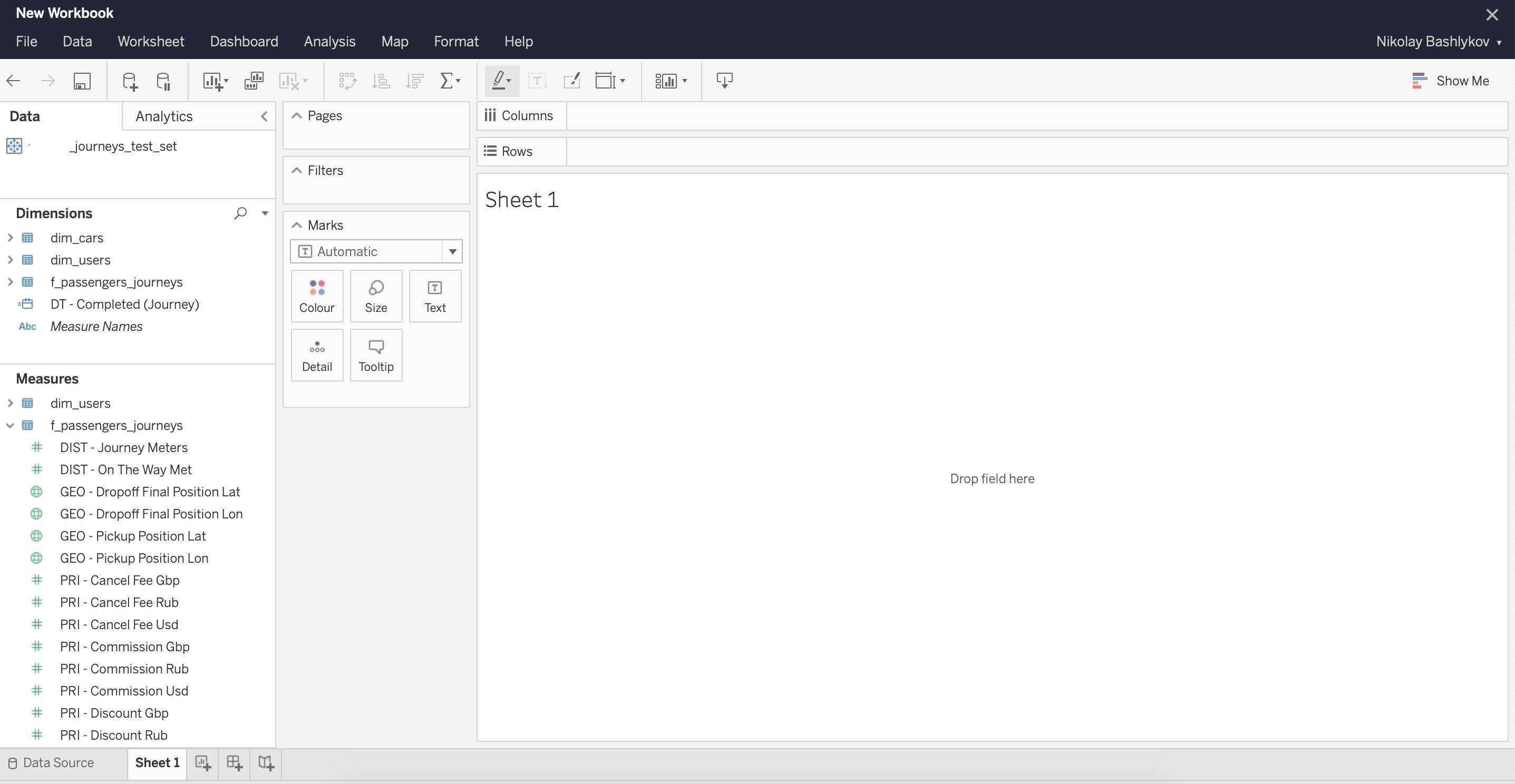

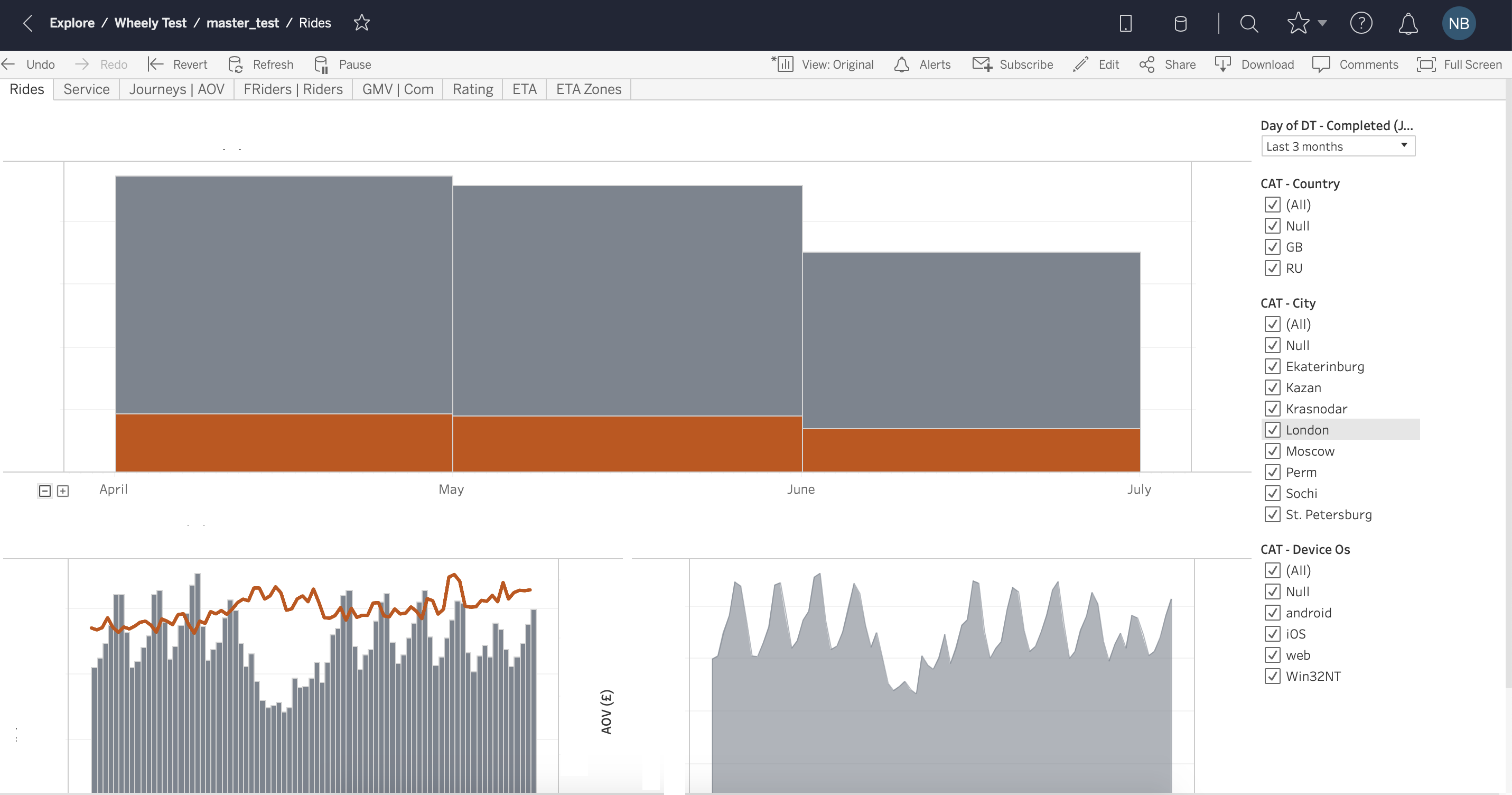

Looker ist ein relativ junges Unternehmen, das 2012 gegründet wurde. UX ist für den Benutzer von Natur aus klar und einfach, Drag & Drop ist bequem implementiert (Abb. 7).

Abb. 7

- Datenverarbeitung.

Die Arbeit mit Daten in Looker ist deutlich langsamer als in Tableau . Der Hauptgrund ist, dass Looker Abfragen direkt an die Datenbank sendet, ohne OLAP-Cubes zu erstellen. Wie wir bereits besprochen haben, hat dieser Ansatz seine Vorteile - die Tatsache, dass die Daten immer aktuell sind und jede Datenaggregation durchgeführt werden kann. Looker bietet auch ein Tool zum Beschleunigen komplexer Abfragen - zwischengespeicherte Abfragen , dh die Möglichkeit, Abfragen zwischenzuspeichern.

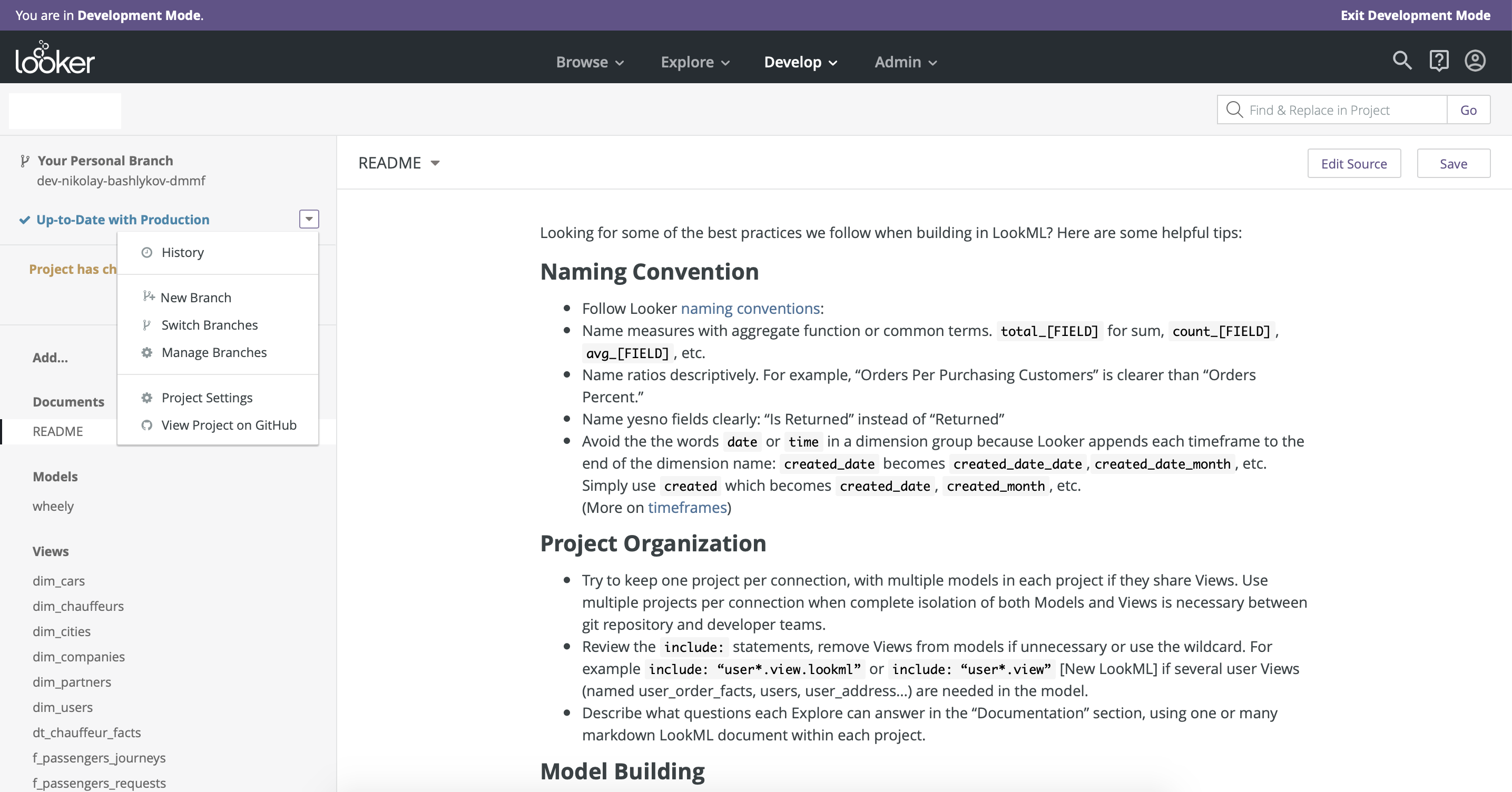

- Workflow

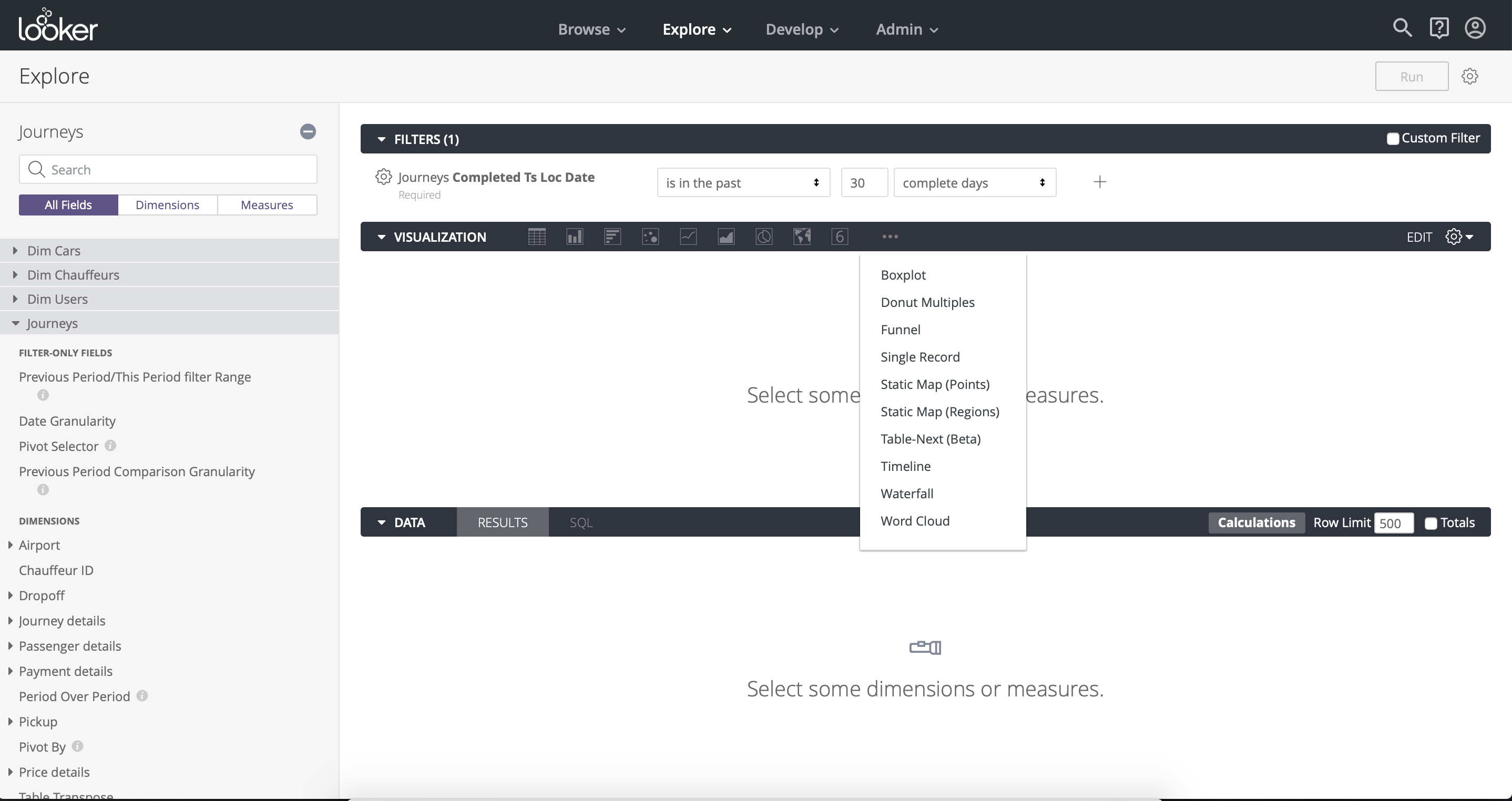

Der Hauptvorteil von Looker im Vergleich zu allen von uns getesteten BI-Tools ist der durchdachte Dashboard-Entwicklungs- und Release-Prozess . Looker integriert die Versionskontrolle mit Github . Die Entwicklungsumgebung (Produktionsmodus) und die Produktionsumgebung (Abb. 8) sind ebenfalls gut voneinander getrennt. Ein weiterer Vorteil von Looker besteht darin, dass der Zugriff auf die Datenmodellierung in denselben Händen bleibt - es gibt nur eine Master-Version des Datenmodells, die die Integrität gewährleistet.

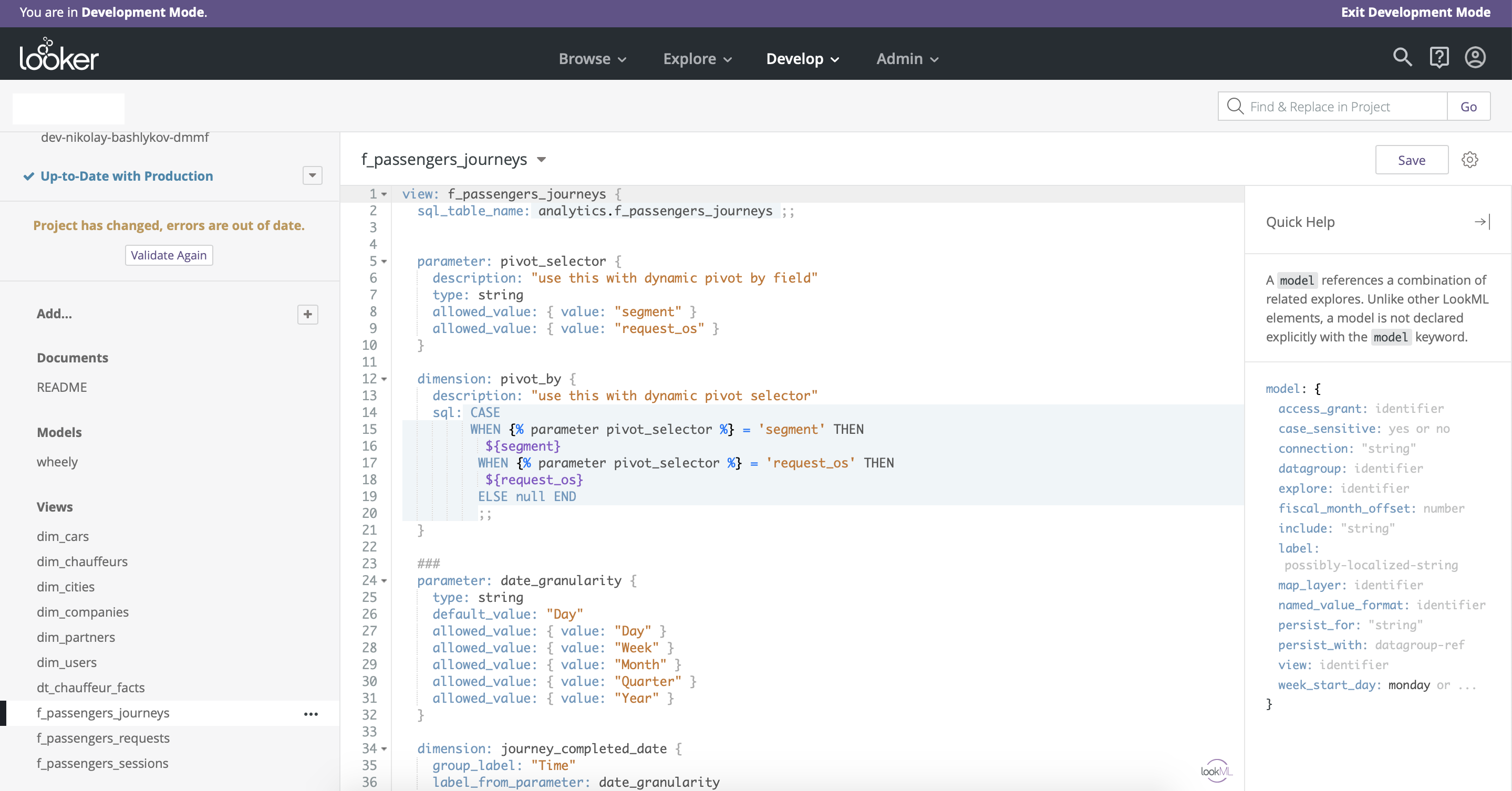

Es ist hier sinnvoll zu erwähnen, dass Looker ein eigenes Analogon zur SQL-Sprache mit zusätzlichen Funktionen für die Datenmodellierung hat - LookML. Dies ist ein ziemlich einfaches und flexibles Tool, mit dem Sie die Drag & Drop-Funktionalität anpassen und viele neue Optionen hinzufügen können (Abb. 9).

Abb. 8

Abb. 9

- Visualisierung

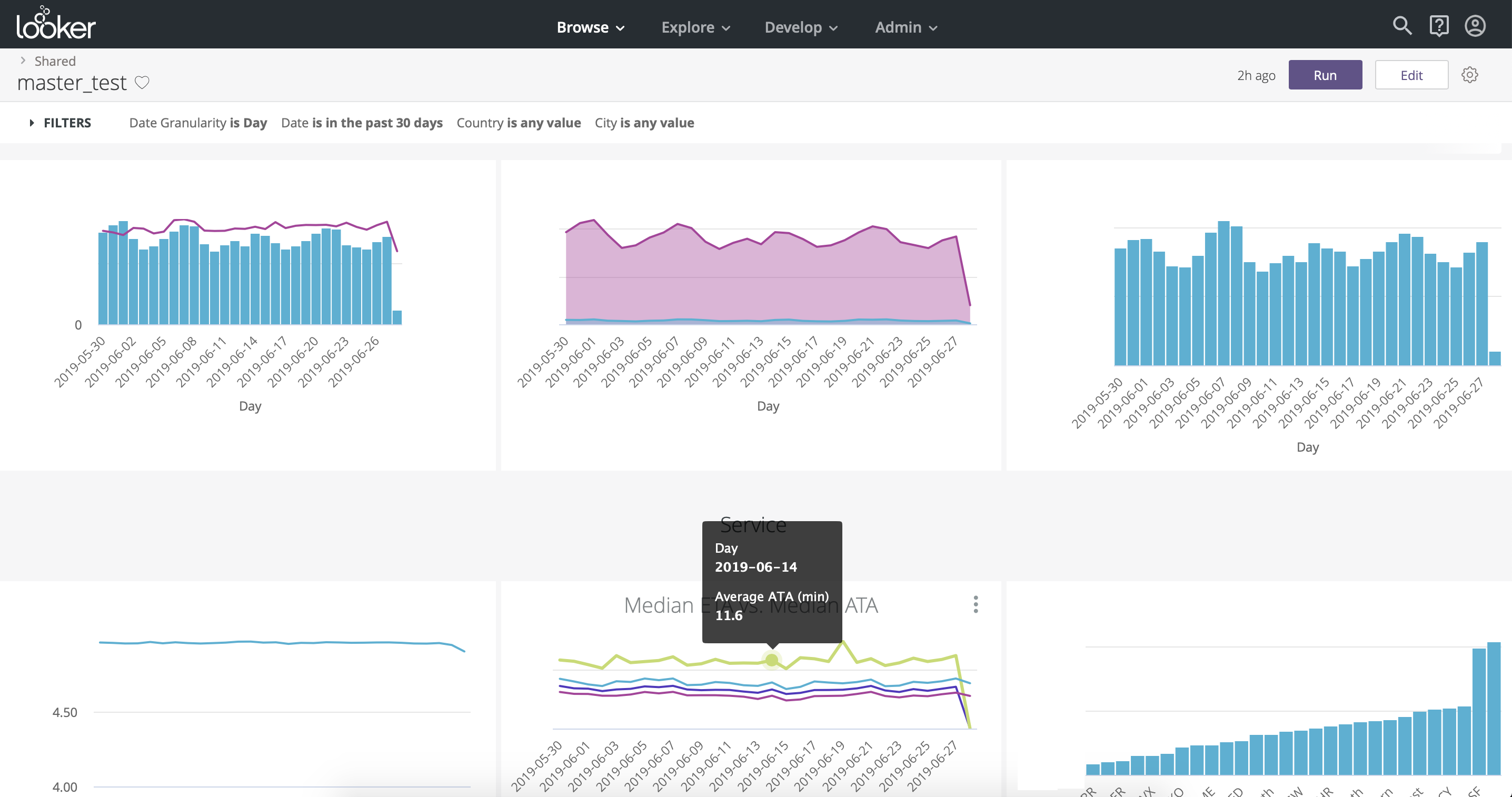

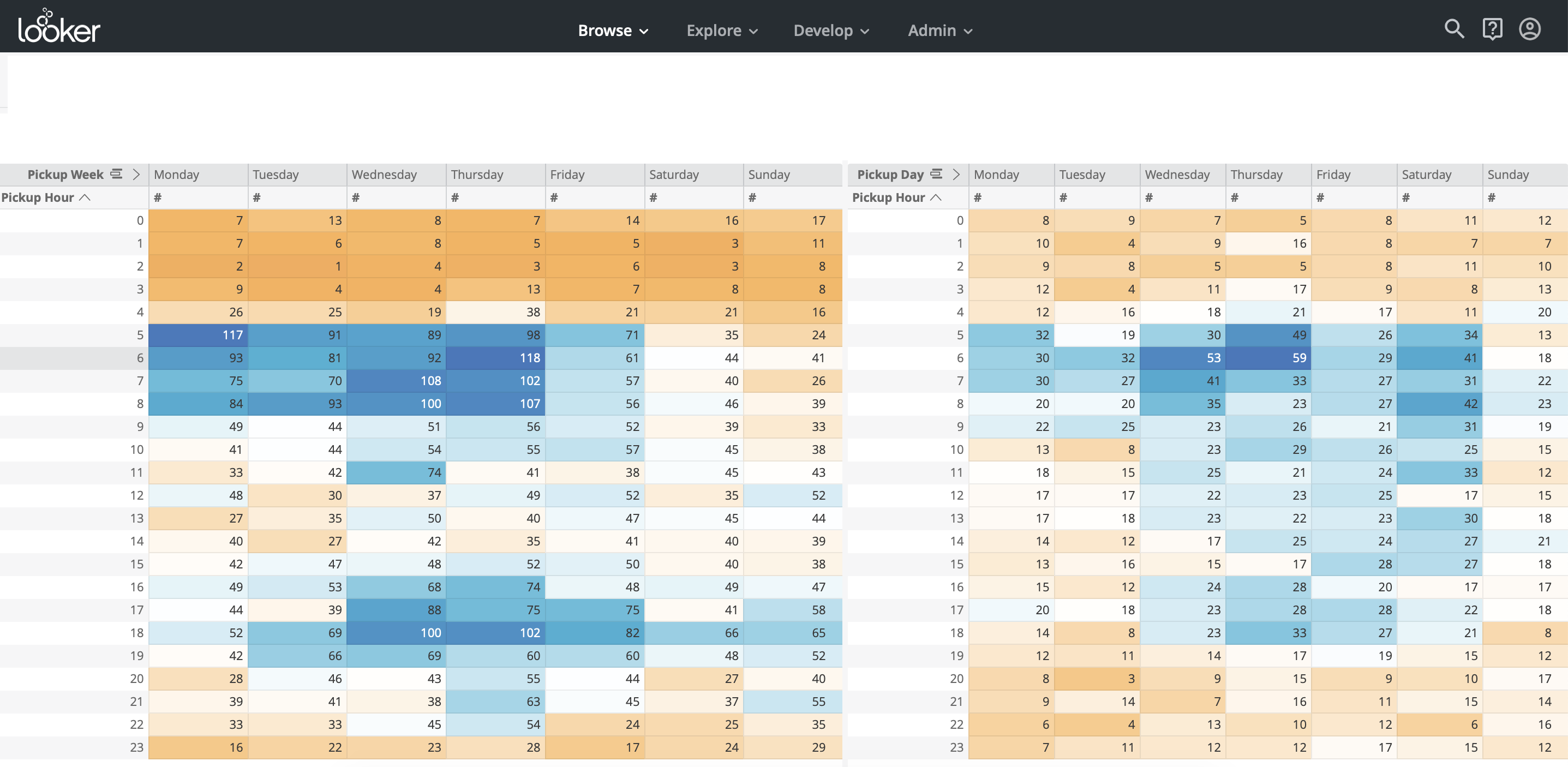

Unter dem Gesichtspunkt der Visualisierung ist Looker Tableau nicht viel unterlegen. Darin finden Sie Diagramme und Diagramme nach Ihrem Geschmack. Die Organisation der Diagramme ist vertikal, im Gegensatz zu Tableau, wo die Organisation paginiert ist (Abb. 10, Abb. 11). Eine nützliche Funktion für Geschäftsbenutzer ist ein Drilldown - die Möglichkeit, ausgewählte Daten in vordefinierten Dimensionen zu segmentieren.

Abb. 10

Abb. 11

- Unterstützung.

Ich muss sagen, die Unterstützung durch Unternehmensberater und technische Experten bei Looker war überraschend: Wir konnten in jeder halben Stunde einen Videoanruf zu jedem Thema planen und eine vollständige Antwort erhalten. Es scheint, dass Looker ihre Kunden wirklich schätzt und versucht, ihr Leben zu vereinfachen.

- Statistik

Looker verfügt über eine API - Look API und SDK für Python. Mit ihrer Hilfe können Sie von Python aus eine Verbindung zu Looker herstellen und die erforderlichen Informationen herunterladen. Führen Sie dann die erforderlichen Transformationen und statistischen Analysen in Python durch und laden Sie die Ergebnisse mit anschließender Ausgabe an die Looker in den Dashboards zurück in die Datenbank.

- Preis

Looker kostet deutlich mehr als Tableau . Für eine ähnliche Gruppe von Benutzern war Looker fast doppelt so teuer wie Tableau - etwa 60.000 US-Dollar pro Jahr.

Periskop

- UX + Drag & Drop.

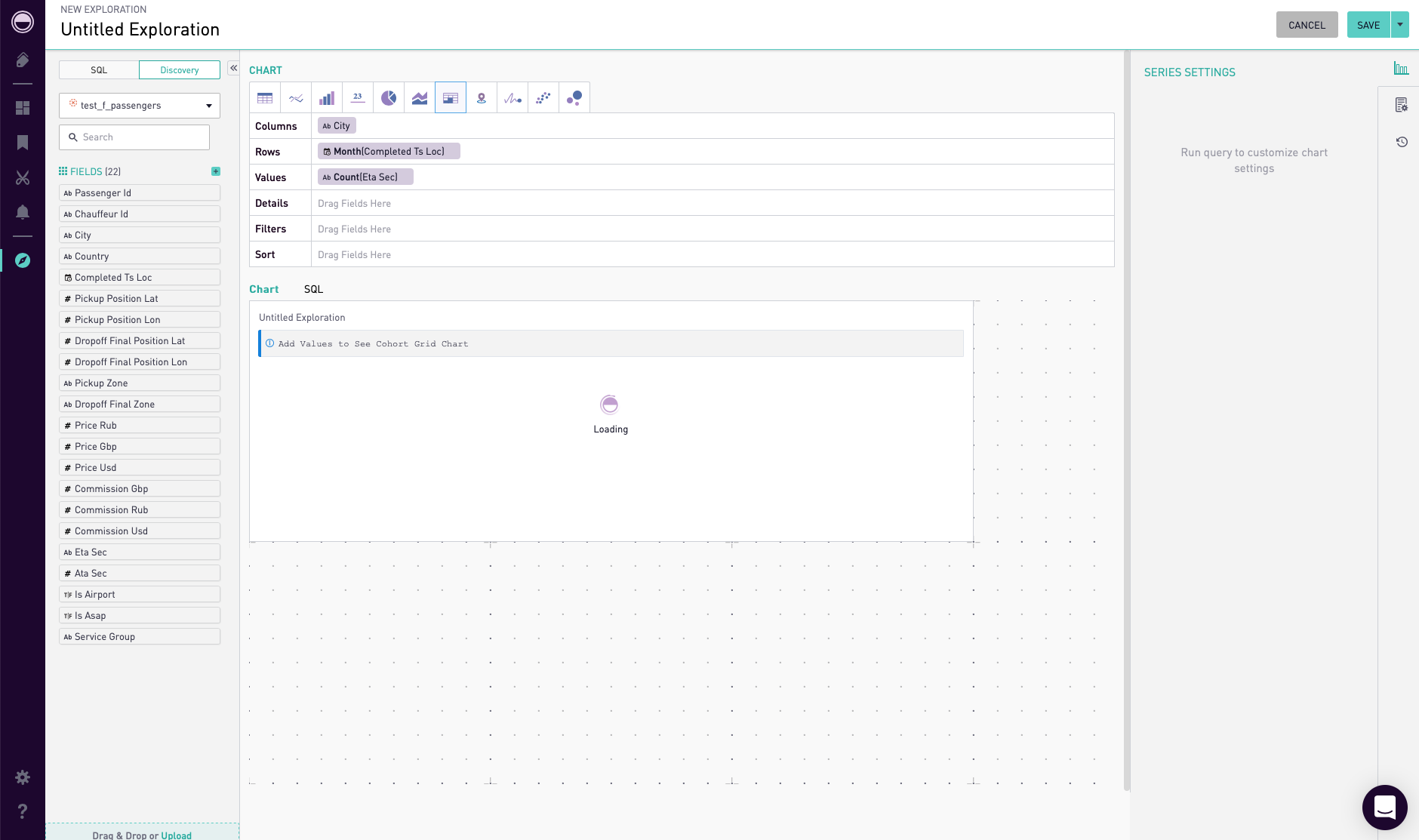

Periscope ist ein recht einfach zu bedienendes Tool mit eingeschränkter Funktionalität . Es gibt auch eine Drag & Drop-Funktion, aber Filter für verschiedene Diagramme müssen separat erstellt werden, was unpraktisch ist (Abb. 12). Sie können nicht auf SQL verzichten, um etwas komplexere Abfragen zu erstellen.

Abb. 12

- Datenverarbeitung.

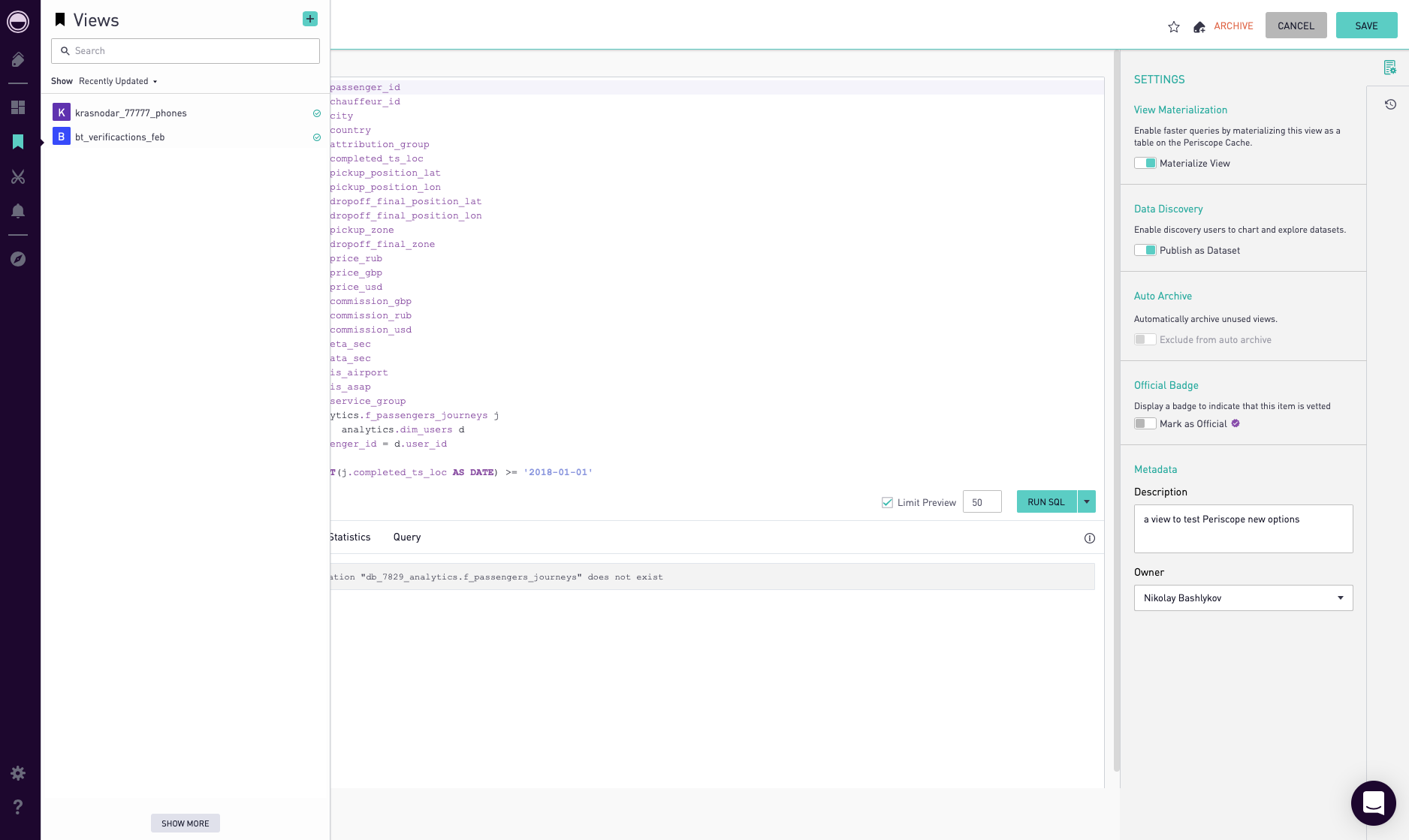

Periscope hat eine Kreuzung zwischen OLAP-Cubes und Abfrage-Caching. Darin können Sie Ansichten erstellen und zwischenspeichern. Ansicht ist eine beliebige SQL-Abfrage. Für das Caching muss in den Einstellungen dieser Ansicht auf die Schaltfläche "Materialisieren" geklickt werden (Abb. 13). Sie können auch eine Veröffentlichungsansicht veröffentlichen, damit Sie sie per Drag & Drop verwenden können.

Abb. 13

- Workflow

Periscope Pro integriert die Versionskontrolle mit git. Es ist auch möglich, den Verlauf eines Dashboards anzuzeigen und auf die vorherige Version zurückzusetzen.

- Visualisierung

Die Anzahl der Diagramme und Diagramme ist sehr begrenzt. Sie können die Vielfalt hier nicht wie in Tableau oder Looker finden.

- Unterstützung.

Der Support ist ziemlich betriebsbereit, wenn Sie die Änderung vornehmen, dass das Support-Center zur Pacific Standard Time betrieben wird. Innerhalb von 24 Stunden erhalten Sie definitiv eine Antwort.

- Statistik

Periscope ist in Python integriert. Weitere Details finden Sie hier .

- Preis

Periscope Pro kostet ungefähr wie Tableau: 35.000 US-Dollar.

Modusanalyse

- UX + Drag & Drop.

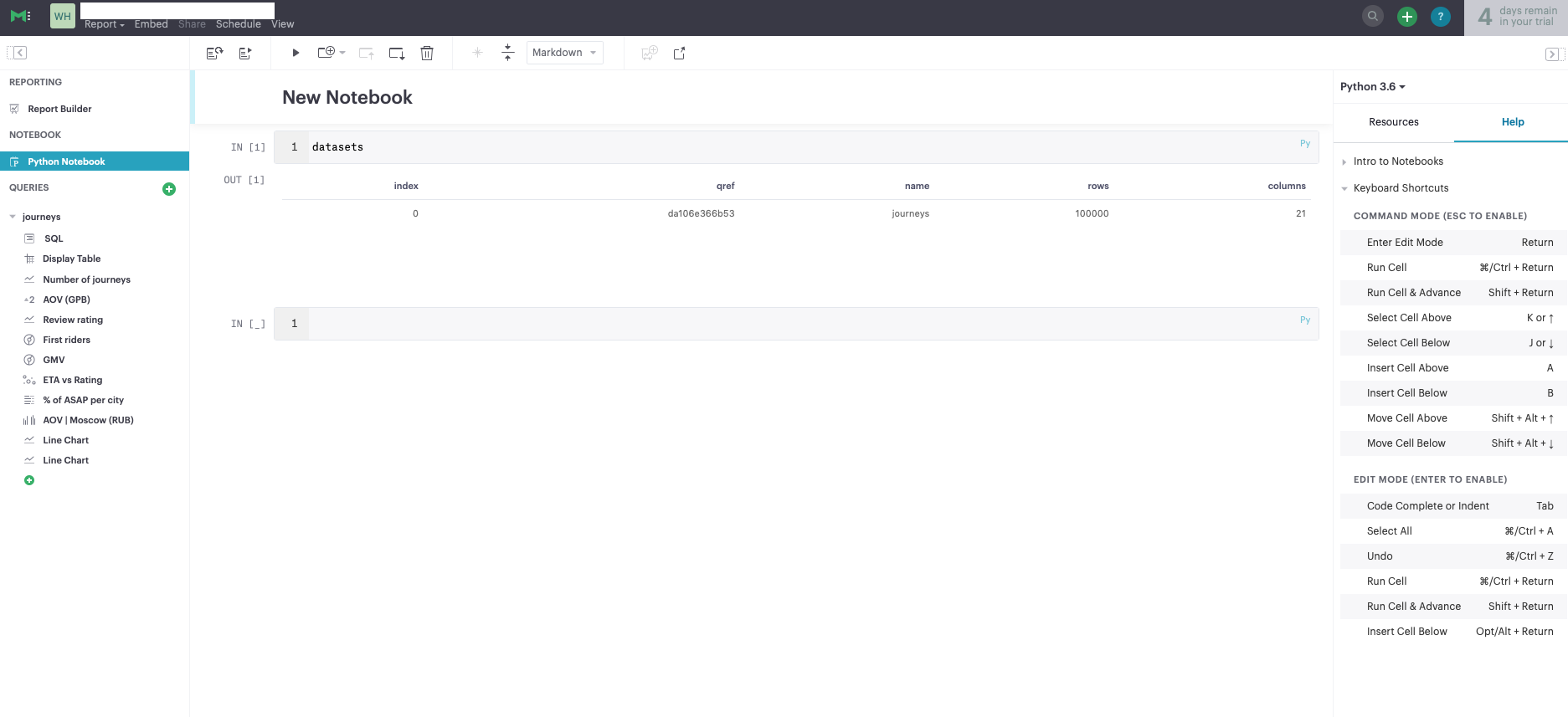

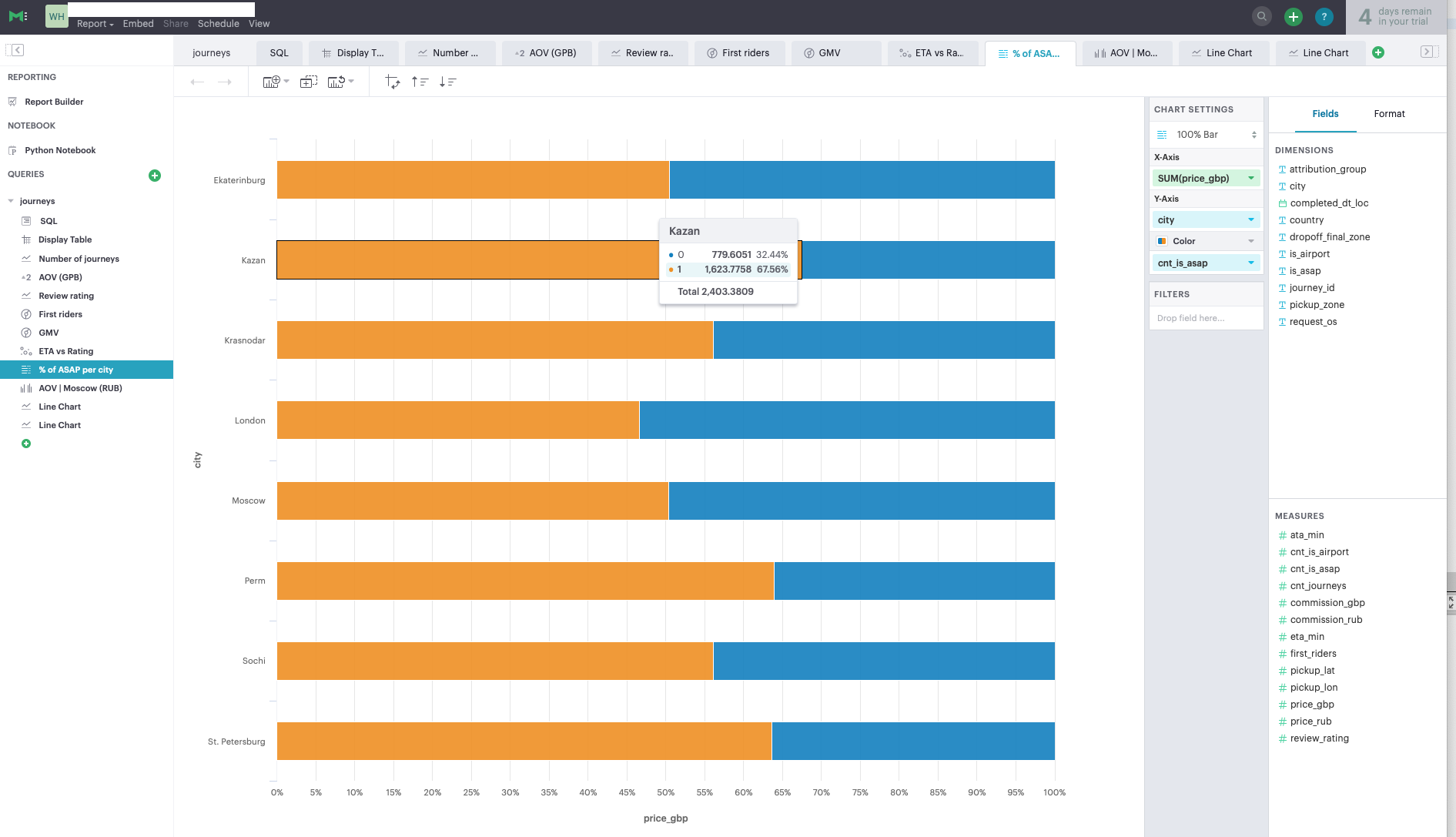

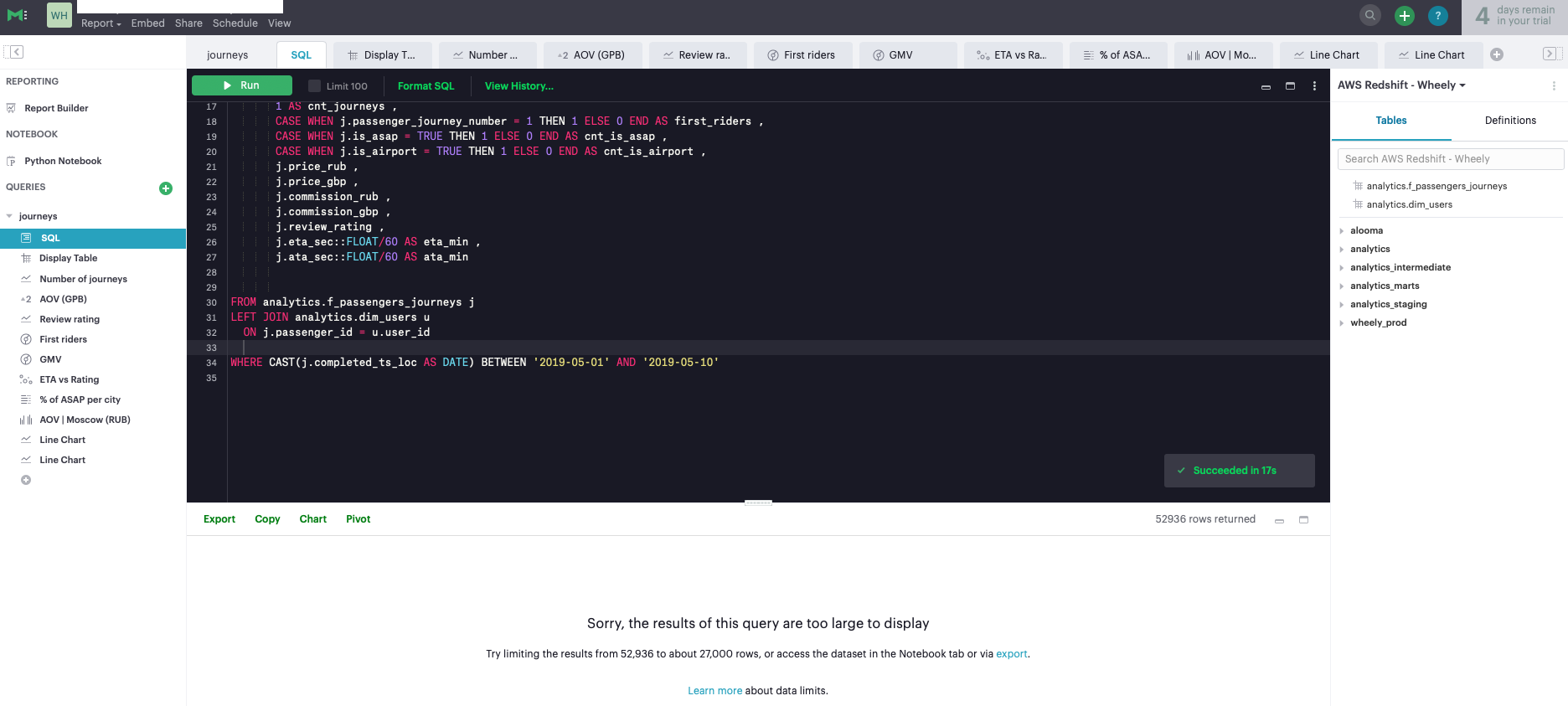

Der Modus ist das einfachste dieser Tools. Der Hauptunterschied liegt in der Integration in Python und der Möglichkeit, Analyseberichte basierend auf dem Jupyter Notebook zu erstellen (Abb. 14). Wenn Sie den Prozess der Erstellung von Analyseberichten mit dem Jupyter-Notizbuch nicht aufgebaut haben, kann dieses Tool für Sie hilfreich sein. Der Modus ist eher eine Ergänzung zu einem vollwertigen BI-System. Seine Funktionalität ist sehr eingeschränkt. Zum Erstellen von Dashboards können Sie Tabellen mit nicht mehr als 27.000 Zeilen verwenden, was die Funktionen des Tools erheblich einschränkt (Abb. 15). Andernfalls müssen Sie für jedes Diagramm separate SQL-Abfragen schreiben, um die Daten zu aggregieren und eine kleinere Dimensionstabelle zur Visualisierung zu erhalten (Abb. 16).

Abb. 14

Abb. 15

Abb. 16

- Datenverarbeitung.

Im Modus als solcher fehlt die Datenverarbeitung. Alle Abfragen werden direkt an die Datenbank gesendet. Es gibt keine Möglichkeit, die Haupttabellen zwischenzuspeichern.

- Workflow

Der Modus ist in Github integriert. Weitere Details finden Sie hier .

- Visualisierung

Der Satz von Datenvisualisierungen ist sehr begrenzt, es gibt 6-7 Arten von Diagrammen.

- Unterstützung.

Während des Testzeitraums war der Support recht betriebsbereit.

- Statistik

Wie bereits erwähnt, ist Mode gut in Python integriert, sodass Sie mit dem Jupyter Notebook benutzerfreundliche Analyseberichte erstellen können.

- Preis

Seltsamerweise ist der Modus für seine Funktionen ziemlich teuer - ungefähr 50.000 US-Dollar pro Jahr.

Schlussfolgerungen

Die Auswahl eines BI-Tool-Anbieters sollte mit Unterstützung der Geschäftsbenutzer und Festlegung der Hauptkriterien für die Auswahl eines Tools (vorzugsweise in Form einer Geschwindigkeitskarte) gründlich angegangen werden. Die in diesem Artikel vorgestellten Kriterien zielen in erster Linie darauf ab, die Effizienz der Arbeit mit Daten zu verbessern, den Prozess des Extrahierens von Informationen zu vereinfachen, die Qualität der Datenvisualisierung zu verbessern und die Belastung der Analysten zu verringern.Quellen

- Gartner, Business Intelligence - BI - Gartner IT-Glossar

- Kaggle

- Tableau - Hyper

- ZDNet - Salesforce-Tableau, andere BI-Deals fließen

- Tableau-Website

- Looker-Website

- Periscope-Website

- Mode Analytics-Website