Unsere türkischen Kunden haben uns gebeten, das Backup für das Rechenzentrum korrekt zu konfigurieren. Wir machen ähnliche Projekte in Russland, aber hier ging es mehr darum zu erforschen, wie es am besten geht.

Gegeben: Es gibt einen lokalen S3-Speicher, Veritas NetBackup, das neue erweiterte Funktionen zum Verschieben von Daten in Objektspeicher mit Deduplizierungsunterstützung erworben hat, und es gibt ein Problem mit dem freien Speicherplatz in diesem lokalen Speicher.

Ziel: alles so zu gestalten, dass der Backup-Speicherprozess schnell und kostengünstig ist.

Zuvor waren in S3 alles nur Dateien, und dies waren vollständige Besetzungen kritischer Rechenzentrumsmaschinen. Das ist nicht so, dass es sehr optimiert ist, aber am Anfang hat alles funktioniert. Jetzt ist es Zeit, es herauszufinden und es richtig zu machen.

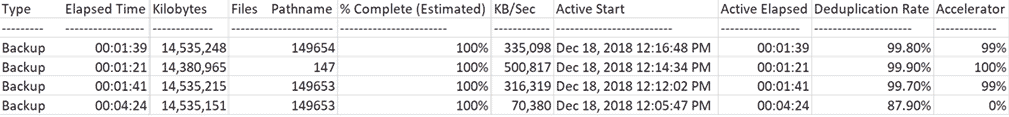

Auf dem Bild, worauf wir gekommen sind:

Wie Sie sehen können, wurde die erste Sicherung langsam durchgeführt (70 Mbit / s), und nachfolgende Sicherungen derselben Systeme waren viel schneller.

Eigentlich noch ein bisschen mehr Details darüber, welche Features da sind.

Sicherungsprotokolle für diejenigen, die bereit sind, eine halbe Seite des Speicherauszugs zu lesenVoll mit Rescan

18. Dezember 2018 12:09:43 - Info bpbkar (pid = 4452) Accelerator hat 14883996160 Bytes von 14883994624 Bytes an den Server gesendet, Optimierung 0,0%

18. Dezember 2018 12:10:07 - Info NBCC (pid = 23002) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Report = PDDO-Statistik (Multithread-Stream verwendet) für (NBCC): gescannt: 14570817 KB, CR gesendet: 1760761 KB, CR über FC gesendet: 0 KB, Dedup: 87,9%, Cache deaktiviert

Voll

18. Dezember 2018 12:13:18 - Info bpbkar (pid = 2864) Accelerator hat 181675008 Bytes von 14884060160 Bytes an den Server gesendet, Optimierung 98,8%

18. Dezember 2018 12:13:40 - Info NBCC (pid = 23527) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Report = PDDO Stats for (NBCC): gescannt: 14569706 KB, CR gesendet: 45145 KB, CR über FC gesendet: 0 KB, Dedup: 99,7%, Cache deaktiviert

Inkrementell

18. Dezember 2018 12:15:32 - Info bpbkar (pid = 792) Accelerator hat 9970688 Bytes von 14726108160 Bytes an den Server gesendet, Optimierung 99,9%

18. Dezember 2018 12:15:53 - Info NBCC (pid = 23656) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Bericht = PDDO-Statistiken für (NBCC): gescannt: 14383788 KB, CR gesendet: 15700 KB, CR über FC gesendet: 0 KB, Dedup: 99,9%, Cache deaktiviert

Voll

18. Dezember 2018 12:18:02 - Info bpbkar (pid = 3496) Accelerator hat 171746816 Bytes von 14884093952 Bytes an den Server gesendet, Optimierung 98,8%

18. Dezember 2018 12:18:24 - Info NBCC (pid = 23878) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Report = PDDO Stats for (NBCC): gescannt: 14569739 KB, CR gesendet: 34120 KB, CR über FC gesendet: 0 KB, Dedup: 99,8%, Cache deaktiviert

Was ist das Problem

Kunden möchten so oft wie möglich sichern und so billig wie möglich speichern. Es ist billig, sie am besten im Objektspeicher vom Typ S3 zu speichern, da sie zum Preis der Wartung pro Megabyte am günstigsten sind, von wo aus Sie sie in angemessener Zeit zurücksetzen können. Wenn es viele Backups gibt, wird es nicht sehr billig, da der größte Teil des Speichers von Kopien derselben Daten belegt wird. Bei HaaS türkischer Kollegen kann die Lagerung um ca. 80-90% verdichtet werden. Es ist klar, dass dies speziell für ihre Besonderheiten gilt, aber ich würde definitiv mit mindestens 50% des Dedups rechnen.

Um das Problem zu lösen, haben die Hauptanbieter lange Zeit Gateways für Amazon S3 erstellt. Alle ihre Methoden sind mit lokalem S3 kompatibel, wenn sie die Amazon-API unterstützen. Im türkischen Rechenzentrum erfolgt die Sicherung sowohl in unserem S3 als auch im T-III „Compressor“ in Russland, da sich ein solches Arbeitsschema bei uns als gut erwiesen hat.

Und

unser S3 ist voll kompatibel mit Sicherungsmethoden in Amazon S3. Das heißt, mit allen Sicherungswerkzeugen, die diese Methoden unterstützen, können Sie alles sofort in einen solchen Speicher kopieren.

Veritas NetBackup hat eine CloudCatalyst-Funktion erstellt:

Das heißt, zwischen den Computern, die gesichert werden müssen, und dem Gateway befindet sich ein Linux-Zwischenserver, über den der Sicherungsverkehr von den CPC-Agenten geleitet wird und die Deduplizierung im laufenden Betrieb erfolgt, bevor sie an S3 übertragen werden. Wenn es früher 30 Backups mit jeweils 20 GB und Komprimierung gab, sind sie jetzt (aufgrund der Ähnlichkeit der Maschinen) um 90% kleiner geworden. Die Deduplizierungs-Engine wird genauso verwendet wie bei der Speicherung auf normalen Festplatten mit Netbackup.

Folgendes passiert vor dem Staging-Server:

Wir haben getestet und sind zu dem Schluss gekommen, dass dies bei der Implementierung in unseren Rechenzentren Platz in S3-Speichern für uns und für Kunden spart. Als Eigentümer von kommerziellen Rechenzentren berechnen wir natürlich das belegte Volumen, aber es ist auch für uns sehr profitabel - weil wir anfangen, an skalierbareren Stellen in der Software zu verdienen und nicht an der Vermietung von Eisen. Nun, das ist eine Reduzierung der internen Kosten.

Protokolle228 Jobs (0 in der Warteschlange 0 aktiv 0 auf Wiederholung warten 0 ausgesetzt 0 unvollständig 228 fertig - 13 ausgewählt)

(Filter angewendet [13])

Job-ID-Typ Status Status Details Status Jobrichtlinie Job-Zeitplan Client Media Server Startzeit Verstrichene Zeit Endzeit Speichereinheit Versuch Operation Kilobyte-Dateien Pfadname% Vollständig (Geschätzt) Job-PID-Eigentümer Kopie Übergeordnete Job-ID KB / Sek. Aktiver Start Aktiv Abgelaufener Roboter-Tresor-Profil Sitzung ID-Medien zum Auswerfen der Datenverschiebung Off-Host-Typ Master-Priorität Deduplizierungsrate Transportbeschleuniger-Optimierungsinstanz oder Datenbankfreigabe-Host

- 1358 Snapshot Done 0 VMware - NGNCloudADC NBCC 18. Dezember 2018 12:16:19 00:02:18 18. Dezember 2018 12:18:37 STU_DP_S3 _ **** backup 1 100% root 1358 18. Dezember 2018 12 : 16: 27 PM 00:02:10 Instant Recovery Disk Standard WIN - *********** 0

1360 Backup Done 0 VMware Full NGNCloudADC NBCC 18. Dezember 2018 12:16:48 00:01:39 18. Dezember 2018 12:18:27 STU_DP_S3 _ **** Backup 1 14.535.248 149654 100% 23858 root 1358 335.098 18. Dezember , 2018 12:16:48 PM 00:01:39 Instant Recovery Disk Standard WIN - *********** 0 99,8% 99%

1352 Snapshot Done 0 VMware - NGNCloudADC NBCC 18. Dezember 2018 12:14:04 00:02:01 18. Dezember 2018 12:16:05 STU_DP_S3 _ **** backup 1 100% root 1352 18. Dezember 2018 12: 14:14 00:01:51 Instant Recovery Disk Standard WIN - *********** 0

1354 Sicherung abgeschlossen 0 VMware Incremental NGNCloudADC NBCC 18. Dezember 2018 12:14:34 00:01:21 18. Dezember 2018 12:15:55 STU_DP_S3 _ **** Sicherung 1 14.380.965 147 100% 23617 root 1352 500.817 18. Dezember , 2018 12:14:34 PM 00:01:21 Instant Recovery Disk Standard WIN - *********** 0 99,9% 100%

1347 Snapshot Done 0 VMware - NGNCloudADC NBCC 18. Dezember 2018 12:11:45 00:02:08 18. Dezember 2018 12:13:53 STU_DP_S3 _ **** backup 1 100% root 1347 18. Dezember 2018 12: 23:45 00:02:08 Instant Recovery Disk Standard WIN - *********** 0

1349 Sicherung abgeschlossen 0 VMware Full NGNCloudADC NBCC 18. Dezember 2018 12:12:02 00:01:41 18. Dezember 2018 12:13:43 STU_DP_S3 _ **** Sicherung 1 14.535.215 149653 100% 23508 root 1347 316.319 18. Dezember , 2018 12:12:02 PM 00:01:41 Instant Recovery Disk Standard WIN - *********** 0 99,7% 99%

1341 Snapshot Done 0 VMware - NGNCloudADC NBCC 18. Dezember 2018 12:05:28 00:04:53 18. Dezember 2018 12:10:21 STU_DP_S3 _ **** backup 1 100% root 1341 18. Dezember 2018 12: 17:28 00:04:53 Instant Recovery Disk Standard WIN - *********** 0

1342 Sicherung abgeschlossen 0 VMware Full_Rescan NGNCloudADC NBCC 18. Dezember 2018 12:05:47 00:04:24 18. Dezember 2018 12:10:11 STU_DP_S3 _ **** Sicherung 1 14.535.151 149653 100% 22999 root 1341 70.380 18. Dezember , 2018 12:05:47 PM 00:04:24 Instant Recovery Disk Standard WIN - *********** 0 87,9% 0%

1339 Snapshot Done 150 VMware - NGNCloudADC NBCC 18. Dezember 2018 11:05:46 00:00:53 18. Dezember 2018 11:06:39 STU_DP_S3 _ **** backup 1 100% root 1339 18. Dezember 2018 11: 05:46 00:00:53 Instant Recovery Disk Standard WIN - *********** 0

1327 Snapshot Done 0 VMware - *******. ********. Cloud NBCC 17. Dezember 2018 12:54:42 05:51:38 17. Dezember 2018 18:46:20 STU_DP_S3 _ **** backup 1 100% root 1327 17. Dezember 2018 12:54:42 PM 05:51:38 Instant Recovery Disk Standard WIN - *********** 0

1328 Backup Done 0 VMware Full *******. ********. Cloud NBCC 17. Dezember 2018 12:55:10 05:29:21 17. Dezember 2018 18:24:31 STU_DP_S3 _ **** backup 1 222,602,719 258932 100% 12856 root 1327 11,326 17. Dezember 2018 12:55:10 05:29:21 Instant Recovery Disk Standard WIN - *********** 0 87,9% 0%

1136 Snapshot Done 0 VMware - *******. ********. Cloud NBCC 14. Dezember 2018 16:48:22 16:05:16 14. Dezember 2018 20:53:38 STU_DP_S3 _ **** backup 1 100% root 1136 14. Dezember 2018 16:48:22 04:05:16 Instant Recovery Disk Standard WIN - *********** 0

1140 Backup Done 0 VMware Full_Scan *******. ********. Cloud NBCC 14. Dezember 2018 16:49:14 03:49:58 14. Dezember 2018 20:39:12 STU_DP_S3 _ **** backup 1 217,631,332 255465 100% 26438 root 1136 15,963 14. Dezember 2018 16:49:14 03:49:58 Instant Recovery Disk Standard WIN - *********** 0 45,2% 0%

Mit dem Beschleuniger können Sie den Datenverkehr von Agenten reduzieren, weil Es werden nur Datenänderungen übertragen, dh selbst vollständige Sicherungen werden nicht vollständig übertragen, da der Medienserver nachfolgende vollständige Sicherungen aus inkrementellen Sicherungen sammelt.

Der Zwischenserver verfügt über ein eigenes Repository, in das er einen "Cache" mit Daten schreibt und die Basis für die Deduplizierung enthält.

In voller Architektur sieht es so aus:

- Der Master-Server verwaltet die Konfiguration, Aktualisierungen und mehr und befindet sich in der Cloud.

- Der Medienserver (Intermediate * Nix-Computer) sollte sich in Bezug auf die Netzwerkverfügbarkeit am nächsten an den redundanten Systemen befinden. Hier werden Backups von allen redundanten Maschinen dedupliziert.

- Auf den redundanten Computern befinden sich Agenten, die im Allgemeinen nur das an den Medienserver senden, was sich nicht in seinem Speicher befindet.

Alles beginnt mit einem vollständigen Scan - dies ist ein vollwertiges vollständiges Backup. Zu diesem Zeitpunkt nimmt der Medienserver alles, dedupliziert es und überträgt es an S3. Die Geschwindigkeit zum Medienserver ist gering - höher. Die Hauptbeschränkung ist die Verarbeitungsleistung des Servers.

Die folgenden Sicherungen sind aus Sicht aller Systeme vollständig, in Wirklichkeit handelt es sich jedoch um synthetische vollständige Sicherungen. Das heißt, die eigentliche Übertragung und Aufzeichnung auf den Medienserver sind nur die Datenblöcke, die zuvor in VM-Sicherungen noch nicht gesehen wurden. Und die Übertragung und Aufzeichnung an S3 sind nur die Datenblöcke, deren Hash nicht in der Deduplizierungsdatenbank des Medienservers enthalten ist. Wenn in einfacheren Worten - dass es vorher keine VMs in einer Sicherung gab.

Beim Wiederherstellen fordert der Medienserver die erforderlichen deduplizierten Objekte von S3 an, rehydriert sie und leitet sie an die CPC-Agenten weiter, d. H. Es ist erforderlich, das Verkehrsaufkommen während der Wiederherstellung zu berücksichtigen, das dem tatsächlichen Datenvolumen entspricht, das wiederhergestellt wird.

So sieht es aus:

Und hier ist noch ein Stück Protokolle169 Jobs (0 in der Warteschlange 0 aktiv 0 auf Wiederholung warten 0 ausgesetzt 0 unvollständig 169 fertig - 1 ausgewählt)

Job-ID-Typ Status Status Details Status Jobrichtlinie Job-Zeitplan Client Media Server Startzeit Verstrichene Zeit Endzeit Speichereinheit Versuch Operation Kilobyte-Dateien Pfadname% Vollständig (Geschätzt) Job-PID-Eigentümer Kopie Übergeordnete Job-ID KB / Sek. Aktiver Start Aktiv Verstrichene Roboter-Tresorprofil-Sitzung ID-Medien zum Auswerfen der Datenverschiebung Off-Host-Typ Master-Prioritäts-Deduplizierungsrate Transport Accelerator-Optimierungsinstanz oder Datenbankfreigabe-Host

- 1372 Wiederherstellung abgeschlossen 0 nbpr01 NBCC 19. Dezember 2018 13:05:58 00:04:32 19. Dezember 2018 13:10:30 1 14,380,577 1 100% 8548 root 1372 70,567 19. Dezember 2018 1:06:00 PM 00:04:30 WIN - *********** 90.000

Die Integrität der Daten wird durch den Schutz von S3 selbst sichergestellt - es besteht eine gute Redundanz zum Schutz vor Hardwarefehlern wie einer toten Festplattenspindel.

Der Medienserver benötigt 4 Terabyte Cache - dies ist die Empfehlung von Veritas für die Mindestgröße. Besser mehr, aber genau das haben wir getan.

Zusammenfassung

Wenn ein Partner 20 GB in unseren S3 geworfen hat, haben wir 60 GB gespeichert, da wir eine dreimalige Georeservierung von Daten bereitstellen. Jetzt ist der Verkehr viel geringer, was sowohl für den Kanal als auch für das Laden des Speichers gut ist.

In diesem Fall werden die Routen über das "große Internet" hinaus geschlossen. Sie können jedoch den Datenverkehr über VPN L2 über das Internet leiten. Es ist jedoch besser, den Medienserver auf den Eingang des Anbieters einzustellen.

Wenn Sie sich für diese Funktionen in unseren russischen Rechenzentren interessieren oder Fragen zu Ihrer Implementierung haben, wenden Sie sich an die Kommentare oder an ekorotkikh@croc.ru.