Eines der Hauptereignisse im Bereich Computerlinguistik und maschinelles Lernen im Jahr 2018 war die

Veröffentlichung von BERT von Google AI, das laut der nordamerikanischen Zweigstelle der Association of Computer Linguistics (NACL) als bester Bericht des Jahres ausgezeichnet wurde. In diesem Artikel werden wir über dieses Sprachmodell und seine Funktionen sprechen.

Für diejenigen, die noch nichts gehört haben, ist BERT ein neuronales Netzwerk, das auf der Methode der vorläufigen Vorbereitung kontextbezogener Darstellungen von Wörtern basiert, dh ein bidirektionales Sprachmodell verwendet und es Ihnen ermöglicht, ganze Sätze zu analysieren. In diesem Fall werden auch die Wörter berücksichtigt, die nach dem Gegebenen und Durchkommen kommen. Diese Methode ermöglicht es, Ergebnisse mit einem breiten Spektrum an Stand der Technik in einer Vielzahl von NLP-Aufgaben (Natural Language Processing) zu erzielen, erfordert jedoch eine hohe Rechenleistung.

Von der formellen Rede zur Konversation

BERT wurde ursprünglich in 104 Wikipedia-Sprachen (mehrsprachig) unterrichtet. Zusätzlich zur mehrsprachigen Version hat Google BERT basierend auf englischer Wikipedia und BERT auf Chinesisch veröffentlicht.

Im Labor für neuronale Systeme und Deep Learning haben wir BERT verwendet, um die NLP-Komponenten von DeepPavlov zu verbessern, einer interaktiven Open-Source-Bibliothek zur Entwicklung eines virtuellen interaktiven Assistenten und einer Textanalyse auf der Basis von TensorFlow und Keras. Wir haben das BERT-Modell in der russischen Wikipedia - RuBERT - trainiert, um die Qualität der russischen Modelle erheblich zu verbessern. Außerdem haben sie BERT in Lösungen für drei beliebte NLP-Aufgaben integriert: Textklassifizierung, Sequenz-Tagging und Antworten auf Fragen. Weitere Informationen zu den BERT-Modellen von DeepPavlov finden Sie in den neuesten Veröffentlichungen unseres Blogs:

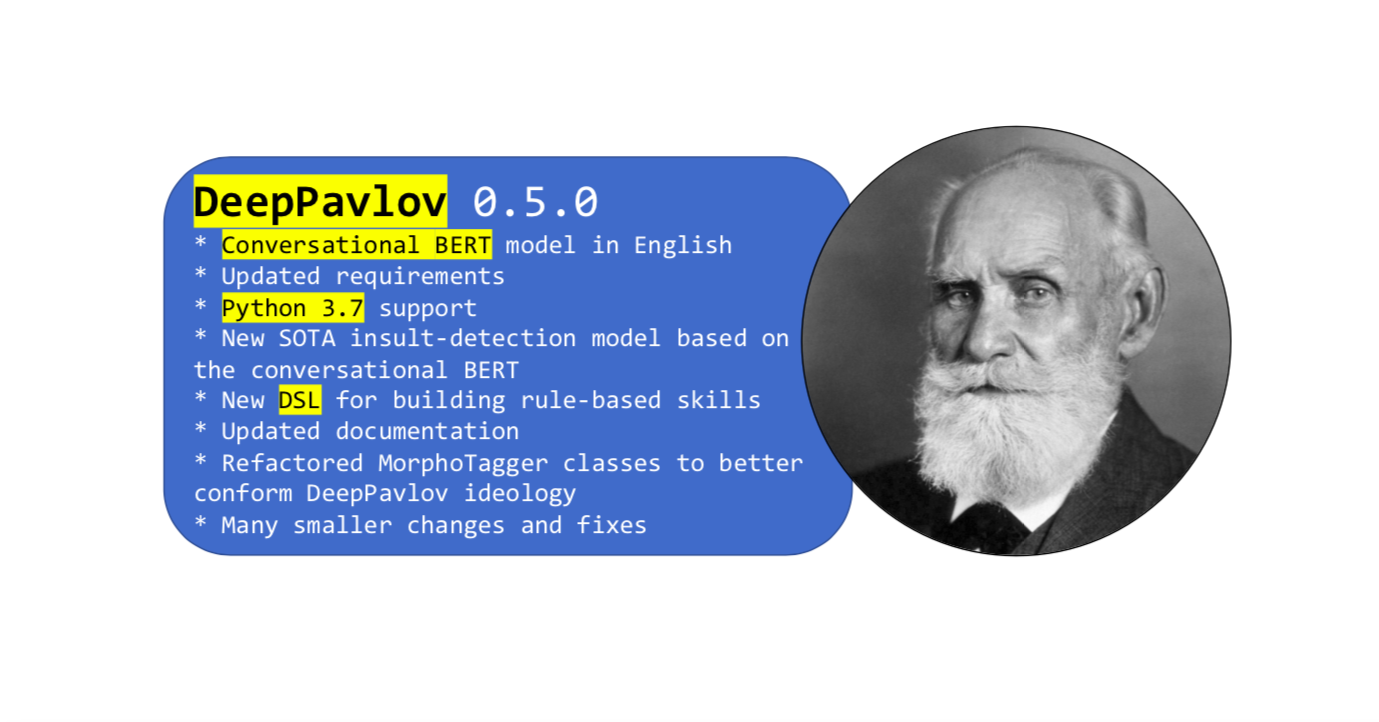

Zuletzt eine neue Version der Bibliothek

Das Hauptmerkmal dieses Updates war BERT, das im englischen Wortschatz sozialer Netzwerke geschult wurde. Die formale Sprache von Wikipedia unterscheidet sich von der gewöhnlichen Umgangssprache. Um einige Probleme zu lösen, benötigen Sie lediglich eine.

Conversational BERT wurde in Englisch unter Verwendung offener Daten von Twitter, Reddit, DailyDialogues, OpenSubtitles, Debatten, Blogs und Kommentaren zu Facebook-Nachrichten geschult. Diese Daten wurden verwendet, um das Vokabular der englischen Subtokens als Initialisierung für das englischsprachige BERT in die englische Version von BERT zu integrieren. Infolgedessen zeigte das gesprochene BERT bei Aufgaben mit sozialen Daten die neuesten Ergebnisse.

Verwendung von Conversational BERT in DeepPavlov

Sie können das neue

Beleidigungserkennungsmodell verwenden , das auf gesprochenem BERT in Englisch basiert. Oder ein anderes BERT-basiertes Modell, das eine

einfache Anleitung aus der Dokumentation verwendet.

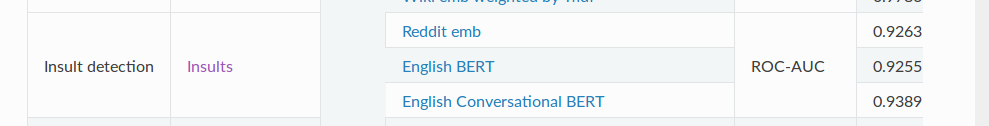

Das SOTA

Insult-Erkennungsmodell enthält eine binäre Klassifizierungsaufgabe zum Erkennen von Missbrauch. Für die ROC-AUC-Metrik (Leistungsmessung für die Klassifizierungsaufgabe bei verschiedenen Schwellenwerteinstellungen) zeigt dieses Modell einen Wert von 93,89 für die Daten im Vergleich zum üblichen BERT - 92,55.

Und schließlich

Das ist fast alles, was wir Ihnen über unser Gesprächs-BERT erzählen wollten. Und vergessen Sie nicht, dass DeepPavlov ein

Forum hat - stellen Sie Ihre Fragen bezüglich der Bibliothek und der Modelle. Seien Sie im Geschäft!