1998, als die MNIST-Datenbank erschien, dauerte es Wochen, um die fortschrittlichsten Computer zu trainieren, was viel schlechtere Ergebnisse erzielte als die heutigen Computer, die mit der GPU weniger als eine Stunde benötigen. Daher ist MNIST keine Aufgabe mehr, die die Grenzen der Technologie überschreitet. Die Geschwindigkeit des Trainings legt nahe, dass diese Aufgabe für das Studium dieser Technologie gut geeignet ist. In der Zwischenzeit geht die Forschung weiter und moderne Arbeiten untersuchen viel komplexere Probleme. In diesem Abschnitt werde ich kurz einige Beispiele für laufende Arbeiten im Zusammenhang mit der Bilderkennung mithilfe neuronaler Netze beschreiben.

Dieser Abschnitt unterscheidet sich vom Rest des Buches. In dem Buch konzentrierte ich mich auf vermutlich langlebige Ideen - Backpropagation, Regularisierung, Faltungsnetzwerke. Ich habe versucht, die Ergebnisse zu vermeiden, die zum Zeitpunkt des Schreibens als modisch galten und deren langfristiger Wert zweifelhaft schien. In der Wissenschaft erweisen sich solche Ergebnisse meist als kurzlebig, verschwinden schnell und haben keine langfristige Wirkung. Vor diesem Hintergrund würde der Skeptiker sagen: „Natürlich können die jüngsten Fortschritte bei der Bilderkennung als Beispiel für eine solche eintägige Reise angesehen werden. In zwei oder drei Jahren wird sich alles ändern. Sind diese Ergebnisse wahrscheinlich für eine kleine Anzahl von Fachleuten von Interesse, die im Vordergrund stehen? Warum überhaupt darüber diskutieren? "

Ein solcher Skeptiker wird insofern Recht haben, als die kleinen Details der jüngsten Arbeiten allmählich an wahrgenommener Bedeutung verlieren. In den letzten Jahren gab es jedoch unglaubliche Verbesserungen bei der Lösung besonders komplexer Probleme der Bilderkennung unter Verwendung von tiefen neuronalen Netzen (GNS). Stellen Sie sich einen Wissenschaftshistoriker vor, der 2100 Material über Computer Vision schreibt. Sie werden 2011-2015 (und wahrscheinlich einige Jahre danach) als eine Zeit bedeutender Durchbrüche definieren, die von Deep Convolution Networks (GSS) angetrieben werden. Dies bedeutet nicht, dass das GOS auch im Jahr 2100 verwendet wird, ganz zu schweigen von Details wie Ausnahme, ReLU und mehr. Dies bedeutet jedoch, dass es derzeit einen wichtigen Übergang in der Ideengeschichte gibt. Dies ähnelt der Beobachtung der Entdeckung des Atoms, der Erfindung von Antibiotika: der Erfindung und Entdeckung historischer Proportionen. Ohne auf Details einzugehen, lohnt es sich daher, sich ein Bild von den interessanten Entdeckungen zu machen, die heute gemacht werden.

Arbeit 2012 LRMD

Lassen Sie mich mit der

Arbeit von 2012 beginnen, die von einer Gruppe von Forschern aus Stanford und Google verfasst wurde. Ich werde sie LRMD nennen, mit den Anfangsbuchstaben der Namen der ersten vier Autoren. LRMD verwendete NS, um Bilder aus der ImageNet-Datenbank zu klassifizieren, was eine sehr schwierige Aufgabe der Mustererkennung ist. Die Daten, die sie aus dem ImageNet 2011 verwendeten, umfassten 16 Millionen Vollfarbbilder, die in 20.000 Kategorien unterteilt waren. Die Bilder wurden aus dem Internet heruntergeladen und von Amazon Mechanical Turk klassifiziert. Hier sind einige davon:

Sie gehören jeweils zu den Kategorien: Mumps, brauner Wurzelpilz, pasteurisierte Milch, Spulwürmer. Wenn Sie üben möchten, empfehle ich Ihnen, die Liste der Handwerkzeuge von ImagNet zu besuchen, in der Unterschiede zwischen Hügeln, Endhobeln, Hobeln zum Anfasen und Dutzenden anderer Arten von Hobeln gemacht werden, ganz zu schweigen von anderen Kategorien. Ich weiß nichts über Sie, aber ich kann all diese Tools nicht mit Sicherheit unterscheiden. Dies ist offensichtlich weitaus schwieriger als MNIST! Das LRMD-Netzwerk erzielte mit ImageNet ein anständiges Ergebnis bei einer Bilderkennungsgenauigkeit von 15,8%. Dies scheint kein so beeindruckendes Ergebnis zu sein, aber es war eine enorme Verbesserung gegenüber dem vorherigen Ergebnis von 9,3%. Ein solcher Sprung deutet darauf hin, dass NS einen effektiven Ansatz für sehr komplexe Bilderkennungsaufgaben wie ImageNet bieten können.

Arbeit 2012 KSH

Auf die Arbeit von LRMD im Jahr 2012 folgten die

Arbeiten von Krizhevsky, Sutskever und Hinton (KSH). KSH trainierte und testete GSS unter Verwendung einer begrenzten Teilmenge von ImagNet-Daten. Diese Untergruppe wird durch den beliebten Wettbewerb für maschinelles Lernen definiert - ImageNet Large-Scale Visual Recognition Challenge (ILSVRC). Die Verwendung dieser Untergruppe gab ihnen eine bequeme Möglichkeit, ihren Ansatz mit anderen führenden Techniken zu vergleichen. Das ILSVRC 2012-Set enthält ungefähr 1,2 Millionen Bilder aus 1000 Kategorien. Die Verifizierungs- und Bestätigungssätze enthalten 150.000 bzw. 50.000 Bilder aus denselben 1000 Kategorien.

Eine der Herausforderungen des ILSVRC-Wettbewerbs besteht darin, dass viele Bilder aus ImageNet mehrere Objekte enthalten. Im Bild läuft der Labrador Retriever beispielsweise einem Fußball nach. T.N. Die „korrekte“ Klassifizierung von ILSVRC entspricht möglicherweise dem Labrador Retriever-Label. Ist es notwendig, Punkte aus dem Algorithmus auszuwählen, wenn das Bild wie ein Fußball markiert wird? Aufgrund dieser Mehrdeutigkeit wurde der Algorithmus als korrekt angesehen, wenn die ImageNet-Klassifizierung zu den 5 wahrscheinlichsten Vermutungen des Algorithmus hinsichtlich des Bildinhalts gehörte. Nach diesem Kriterium erreichte das GSS von KSH unter den Top 5 eine Genauigkeit von 84,7%, viel besser als der vorherige Gegner, der eine Genauigkeit von 73,8% erreichte. Unter Verwendung einer strengeren Metrik erreichte die KSH-Genauigkeit 63,3%, wenn das Etikett genau der vorgeschriebenen entsprechen muss.

Es lohnt sich, das KSH-Netzwerk kurz zu beschreiben, da es so viele Werke inspirierte, die folgten. Wie wir sehen werden, ist es auch eng mit den Netzwerken verbunden, die wir in diesem Kapitel trainiert haben, obwohl es komplexer ist. KSH verwendete GSS, das auf zwei GPUs trainiert wurde. Sie verwendeten zwei GPUs, weil ihre spezielle Karte (NVIDIA GeForce GTX 580) nicht über genügend Speicher verfügte, um das gesamte Netzwerk zu speichern. Daher teilen sie das Netzwerk in zwei Teile.

Das KSH-Netzwerk besteht aus 7 Schichten versteckter Neuronen. Die ersten fünf verborgenen Schichten sind Faltungsschichten (einige verwenden maximales Pooling), und die nächsten zwei sind vollständig verbunden. Die ausgegebene Softmax-Schicht besteht aus 1000 Neuronen, die 1000 Bildklassen entsprechen. Hier ist eine Skizze des Netzwerks aus der Arbeit von KSH. Details werden unten beschrieben. Beachten Sie, dass viele Ebenen in zwei Teile unterteilt sind, die zwei GPUs entsprechen.

In der Eingabeebene befindet sich ein 3x224x224-Neuron, das die RGB-Werte für ein Bild mit einer Größe von 224x224 angibt. Denken Sie daran, dass ImageNet Bilder mit verschiedenen Auflösungen enthält. Dies stellt ein Problem dar, da die Eingangsnetzwerkschicht normalerweise eine feste Größe hat. KSH hat dies behoben, indem jedes Bild so skaliert wurde, dass seine kurze Seite eine Länge von 256 Pixel hatte. Dann schneiden sie einen Bereich von 256 x 256 Pixel aus der Mitte des verkleinerten Bildes aus. Schließlich ruft KSH zufällige Bildstücke (224 x 224) (und ihre horizontalen Reflexionen) aus 256 x 256 Bildern ab. Dieser zufällige Schnitt ist eine Möglichkeit, Trainingsdaten zu erweitern, um die Umschulung zu reduzieren. Dies hilft insbesondere dabei, ein so großes Netzwerk wie KSH zu trainieren. Und schließlich werden diese 224x224-Bilder als Eingabe in das Netzwerk verwendet. In den meisten Fällen enthält das zugeschnittene Bild das Hauptobjekt des Originalbilds.

Wir gelangen zu den verborgenen Schichten des KSH-Netzwerks. Die erste verborgene Schicht ist eine Faltungsschicht mit einem maximalen Zugschritt. Es werden lokale Empfangsfelder der Größe 11 x 11 und ein Schritt von 4 Pixeln verwendet. Insgesamt werden 96 Feature-Karten erhalten. Charakterkarten sind in zwei Gruppen zu je 48 Teilen unterteilt, wobei sich die ersten 48 Karten auf einer GPU und die zweite auf der anderen befinden. Das maximale Pooling in dieser und den nachfolgenden Ebenen wird von 3 × 3-Abschnitten ausgeführt, aber die Pooling-Abschnitte können sich überlappen und befinden sich in einem Abstand von nur 2 Pixeln voneinander.

Die zweite verborgene Schicht ist ebenfalls Faltungsschicht mit maximalem Pooling. Es verwendet lokale 5x5-Empfangsfelder und verfügt über 256 Funktionskarten, die für jede GPU in 128 Teile unterteilt sind. Feature-Maps verwenden nur 48 eingehende Kanäle und nicht wie üblich alle 96 Ausgänge der vorherigen Ebene. Dies liegt daran, dass jede Funktionskarte Eingaben von der GPU empfängt, auf der sie gespeichert ist. In diesem Sinne entfernt sich das Netzwerk von der Faltungsarchitektur, die wir weiter oben in diesem Kapitel beschrieben haben, obwohl die Grundidee offensichtlich dieselbe bleibt.

Die dritte, vierte und fünfte Schicht sind Faltungsschichten, jedoch ohne maximale Poolbildung. Ihre Parameter: (3) 384 Merkmalskarten, lokale Empfangsfelder 3x3, 256 eingehende Kanäle; (4) 384 Merkmalskarten, lokale Empfangsfelder 3 × 3, 192 eingehende Kanäle; (5) 256 Feature-Karten, lokale Empfangsfelder 3x3, 192 eingehende Kanäle. Auf der dritten Ebene werden Daten zwischen den GPUs ausgetauscht (wie in der Abbildung gezeigt), sodass die Feature-Maps alle 256 eingehenden Kanäle verwenden können.

Die sechste und siebte verborgene Schicht sind vollständig miteinander verbunden, jeweils 4096 Neuronen.

Die Ausgabeschicht ist Softmax und besteht aus 1000 Einheiten.

Das KSH-Netzwerk nutzt viele Techniken. Anstatt Sigmoid oder hyperbolische Tangente als Aktivierungsfunktion zu verwenden, werden ReLUs verwendet, die das Lernen erheblich beschleunigen. Das KSH-Netzwerk enthält etwa 60 Millionen Trainingsparameter und muss daher auch bei einem großen Satz von Trainingsdaten umgeschult werden. Um dies zu bewältigen, erweiterten die Autoren das Trainingsset durch zufälliges Zuschneiden von Bildern, wie oben beschrieben. Sie verwendeten dann die L2-Regularisierungsvariante und die Ausnahme. Das Netzwerk wurde unter Verwendung eines stochastischen Gradientenabfalls basierend auf dem Impuls und mit Minipaketen trainiert.

Dies ist ein kurzer Überblick über viele der wichtigsten Erkenntnisse von KSH. Ich habe einige Details weggelassen und sie selbst im Artikel gesucht. Sie können sich auch das Projekt von Alex Krizhevsky

cuda-convnet (und seinen Anhängern)

ansehen , das Code enthält, der viele der beschriebenen Ideen umsetzt.

Eine auf Theano basierende Version dieses Netzwerks

wurde ebenfalls

entwickelt . Sie können im Code Ideen erkennen, die denen ähneln, die wir in diesem Kapitel entwickelt haben, obwohl die Verwendung mehrerer GPUs die Sache kompliziert macht. Das Caffe-Framework verfügt über eine eigene Version des KSH-Netzwerks. Weitere Informationen finden Sie in den "

Zoomodellen ".

ILSVRC-Wettbewerb 2014

Seit 2012 sind recht schnelle Fortschritte zu verzeichnen. Nehmen Sie am ILSVRC-Wettbewerb 2014 teil. Wie im Jahr 2012 mussten die Teilnehmer Netzwerke für 1,2 Millionen Bilder aus 1000 Kategorien trainieren, und eine der 5 wahrscheinlichen Vorhersagen in der richtigen Kategorie war ein Qualitätskriterium.

Das Gewinnerteam , das hauptsächlich aus Google-Mitarbeitern bestand, verwendete das GSS mit 22 Schichten von Neuronen. Sie benannten ihr Netzwerk GoogLeNet nach LeNet-5. Nach dem Kriterium für das Erreichen der fünf besten Optionen erreichte GoogLeNet einen Indikator mit einer Genauigkeit von 93,33%, was die Ergebnisse des Gewinners von 2013 (Clarifai von 88,3%) und des Gewinners von 2012 (KSH von 84,7%) erheblich verbesserte.

Wie gut ist die Genauigkeit von GoogLeNet 93,33%? Im Jahr 2014 schrieb ein Forschungsteam eine

Überprüfung des ILSVRC-Wettbewerbs. Eines der angesprochenen Themen war, wie gut die Menschen mit der Aufgabe umgehen können. Für das Experiment haben sie ein System erstellt, mit dem Personen Bilder mit ILSVRC klassifizieren können. Wie einer der Autoren der Arbeit, Andrei Karpaty, in einem informativen Eintrag in seinem Blog erklärt, war es sehr schwierig, die Effektivität von Menschen auf GoogLeNet-Indikatoren zu bringen:

Die Aufgabe, Bilder mit fünf von 1000 möglichen Kategorien zu markieren, wurde selbst für diejenigen meiner Freunde im Labor, die seit einiger Zeit mit ILSVRC und seinen Kategorien arbeiten, sehr schwierig. Zunächst wollten wir die Aufgabe bei Amazon Mechanical Turk einreichen. Dann beschlossen wir, Studenten für Geld einzustellen. Deshalb habe ich unter Experten in meinem Labor eine Markierungsparty organisiert. Danach entwickelte ich eine modifizierte Schnittstelle, die GoogLeNet-Vorhersagen verwendete, um die Anzahl der Kategorien von 1000 auf 100 zu reduzieren. Trotzdem war die Aufgabe schwierig - die Leute übersprangen Kategorien und gaben Fehler in der Größenordnung von 13-15% an. Am Ende wurde mir klar, dass der effektivste Ansatz für mich darin besteht, mich hinzusetzen und einen unglaublich langen Lernprozess und den anschließenden Prozess des gründlichen Markups zu durchlaufen, um dem GoogLeNet-Ergebnis noch näher zu kommen. Die Markierung hatte zunächst eine Geschwindigkeit von etwa 1 Einheit pro Minute, wurde jedoch mit der Zeit beschleunigt. Einige Bilder waren leicht zu erkennen, während andere (z. B. bestimmte Hunderassen, Vogelarten oder Affen) mehrere Minuten Konzentration erforderten. Ich konnte sehr gut zwischen Hunderassen unterscheiden. Basierend auf meiner Bildprobe wurden die folgenden Ergebnisse erhalten: GoogLeNet war in 6,8% der Fälle falsch; Meine Fehlerquote betrug 5,1%, was ungefähr 1,7% besser war.

Mit anderen Worten, der Experte, der nur mit ernsthaften Anstrengungen sehr sorgfältig arbeitete, konnte dem STS leicht einen Schritt voraus sein. Karpaty berichtet, dass es dem zweiten Experten, der mit weniger Bildern geschult wurde, gelungen ist, den Fehler bei der Auswahl von bis zu 5 Etiketten pro Bild um nur 12% zu reduzieren, was viel weniger als bei GoogLeNet ist.

Tolle Ergebnisse. Und seit dem Aufkommen dieser Arbeit haben mehrere Teams über die Entwicklung von Systemen berichtet, deren Fehlerrate bei der Auswahl der 5 besten Tags sogar unter 5,1% lag. Manchmal wurden diese Errungenschaften in den Medien als die Entstehung von Systemen behandelt, die Bilder besser erkennen können als Menschen. Obwohl die Ergebnisse im Allgemeinen bemerkenswert sind, gibt es viele Nuancen, die nicht berücksichtigt werden können, dass Computer Vision auf diesen Systemen besser funktioniert als auf Menschen. In vielerlei Hinsicht ist der ILSVRC-Wettbewerb eine sehr begrenzte Aufgabe - die Ergebnisse einer Bildsuche in einem offenen Netzwerk entsprechen nicht unbedingt dem, was das Programm in einer praktischen Aufgabe erwartet. Und natürlich ist das Kriterium „eine der fünf besten Noten“ ziemlich künstlich. Wir haben noch einen langen Weg vor uns, um das Problem der Bilderkennung zu lösen, ganz zu schweigen von der allgemeineren Aufgabe des Computer Vision. Trotzdem ist es sehr cool zu sehen, wie viel Fortschritt bei der Lösung einer so schwierigen Aufgabe in nur wenigen Jahren erzielt wurde.

Andere Aufgaben

Ich habe mich auf ImageNet konzentriert, es gibt jedoch einige andere Projekte, die NS zur Bilderkennung verwenden. Lassen Sie mich kurz einige interessante Ergebnisse beschreiben, die kürzlich erzielt wurden, um sich ein Bild von der modernen Arbeit zu machen.

Eine inspirierende praktische

Reihe von Ergebnissen wurde von einem Team von Google erzielt, das GSS auf die Aufgabe der Adressschilderkennung in Google Street View anwendete. In ihrer Arbeit berichten sie, wie sie fast 100 Millionen Adressschilder mit einer Genauigkeit entdeckt und automatisch erkannt haben, die mit der menschlichen Arbeit vergleichbar ist. Und ihr System ist schnell: Es konnte Daten von allen Google Street View-Bildern in Frankreich in weniger als einer Stunde entschlüsseln! Sie schreiben: "Durch das Abrufen dieses neuen Datensatzes hat sich die Qualität der Geokodierung von Google Maps in mehreren Ländern erheblich verbessert, insbesondere dort, wo es keine anderen Geokodierungsquellen gab." Dann machen sie eine allgemeinere Aussage: „Wir glauben, dass wir dank dieses Modells das Problem der optischen Erkennung kurzer Sequenzen auf eine Weise gelöst haben, die in vielen praktischen Anwendungen anwendbar ist.“

Vielleicht habe ich den Eindruck einer Parade siegreicher und inspirierender Ergebnisse erweckt. Die interessantesten Berichte betreffen natürlich grundlegende Dinge, die uns noch nicht klar sind. Zum Beispiel wurde in der

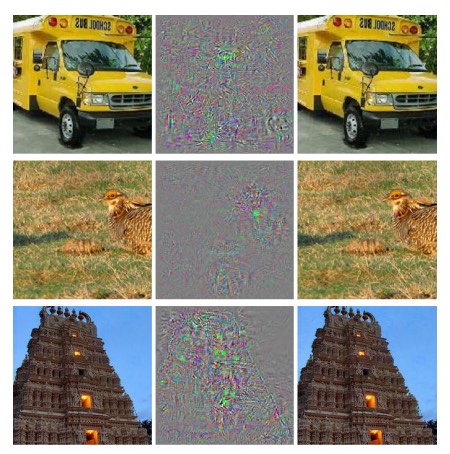

Arbeit von 2013 gezeigt, dass die Nationalversammlung tatsächlich blinde Flecken hat. Schauen Sie sich die Bilder unten an. Links ist das Bild aus ImageNet zu sehen, das das Forschernetzwerk korrekt klassifiziert hat. Auf der rechten Seite befindet sich ein leicht modifiziertes Bild (in der Mitte sind die Unterschiede dargestellt), das das Netzwerk nicht mehr richtig erkennen konnte. Und die Autoren fanden heraus, dass solche "kontroversen" Änderungen für jedes Bild aus der Datenbank ausgewählt werden können, und nicht nur für die Elite.

Unangenehmes Ergebnis. Wir haben ein Netzwerk verwendet, das auf demselben Code basiert wie das KSH-Netzwerk - das heißt, es ist ein solches Netzwerk, das immer häufiger verwendet wird. Und obwohl solche NS im Prinzip kontinuierliche Funktionen berechnen, legen ähnliche Ergebnisse nahe, dass sie wahrscheinlich fast diskrete Funktionen berechnen. Schlimmer noch, sie erweisen sich als diskret in einer Weise, die unsere intuitive Vorstellung von intelligentem Verhalten verletzt. Das ist ein Problem. Außerdem ist nicht sehr klar, was genau zu Diskretion führt, was ist das Problem: in der Verlustfunktion? Welche Aktivierungsfunktionen sind zu verwenden? In der Netzwerkarchitektur? In etwas anderem? Wir wissen es nicht.

Aber diese Ergebnisse sind nicht so schlecht, wie sie scheinen. Obwohl solche kontroversen Veränderungen recht häufig sind, ist es unwahrscheinlich, dass sie in der Praxis gefunden werden. Wie in der Arbeit angegeben:

Das Vorhandensein von kontroversen Negativen widerspricht der Fähigkeit des Netzwerks, eine hohe Generalisierbarkeit zu erreichen. Wenn das Netzwerk gut verallgemeinern könnte, wie könnte es dann durch solche kontroversen Negative getäuscht werden, die nicht von gewöhnlichen Beispielen zu unterscheiden sind? Die Erklärung ist, dass eine Reihe von Wettbewerbsnegativen eine extrem geringe Wahrscheinlichkeit hat und daher im Trainingsdatensatz nicht beobachtet (oder fast nicht beobachtet) wird, jedoch eine hohe Dichte aufweist (ungefähr wie rationale Zahlen) und daher für fast jeden Fall gefunden werden kann .

Trotzdem ist es unangenehm, dass wir die Arbeit der Nationalversammlung so schlecht verstehen, dass dieses Ergebnis kürzlich entdeckt wurde. Der Hauptvorteil solcher Ergebnisse wird natürlich sein, dass sie das Auftreten späterer Arbeiten zu diesem Thema stimulierten. Eine

kürzlich durchgeführte Arbeit aus dem Jahr 2014 hat gezeigt, dass es einem geschulten Netzwerk möglich ist, Bilder zu erstellen, die für eine Person wie weißes Rauschen aussehen, und das Netzwerk wird sie mit einem hohen Maß an Vertrauen in bekannte Kategorien einteilen.

Dies ist eine weitere Demonstration, die wir in der Arbeit der NS und in ihrer Verwendung für die Bilderkennung noch viel zu verstehen haben.Trotz ähnlicher Ergebnisse ist das Gesamtbild inspirierend. Wir sehen schnelle Fortschritte bei der Durchführung äußerst komplexer Tests wie ImageNet. Wir sehen auch schnelle Fortschritte bei der Lösung von Problemen aus der realen Welt, z. B. beim Erkennen von Adressschildern in StreetView. Trotz der Inspiration reicht es jedoch nicht aus, nur Verbesserungen bei der Leistung von Geschwindigkeitstests oder sogar realen Aufgaben zu beobachten. Es gibt grundlegende Phänomene, deren Wesen wir noch immer schlecht verstehen, zum Beispiel die Existenz von Wettbewerbsbildern. Und während sich solche grundlegenden Probleme immer noch öffnen (ganz zu schweigen von ihrer Lösung), wäre es verfrüht, über die Annäherung an die Lösung des Bilderkennungsproblems zu sprechen. Gleichzeitig sind solche Probleme hervorragende Anreize für die weitere Arbeit.Andere Ansätze für tiefe neuronale Netze

In diesem Buch haben wir uns auf eine Aufgabe konzentriert: die Klassifizierung von Zahlen MNIST. Eine hervorragende Aufgabe, die uns viele effektive Ideen verständlich machte: stochastischer Gradientenabstieg, Backpropagation, Faltungsnetzwerke, Regularisierung usw. Dies ist jedoch auch eine eher enge Aufgabe. Nachdem Sie die Literatur zu neuronalen Netzen gelesen haben, werden Sie auf viele Ideen stoßen, die wir nicht besprochen haben: wiederkehrende NS, Boltzmann-Maschinen, generative Modelle, Trainingstransfer, verstärktes Lernen und so weiter und so fort! Neuronale Netze sind ein weites Gebiet. Viele wichtige Ideen sind jedoch Variationen dieser Ideen, die wir bereits besprochen haben, und sie sind recht einfach zu verstehen. In diesem Abschnitt werde ich den Vorhang über diesen riesigen Weiten leicht öffnen. Ihre Diskussion wäre nicht detailliert und umfassend - dies würde das Buch extrem aufblasen. Es wird impressionistisch sein,ein Versuch, den konzeptuellen Reichtum dieses Bereichs aufzuzeigen und einige Konzepte mit denen zu verbinden, die wir bereits gesehen haben. Im Text werde ich einige Verweise auf andere Quellen sowie auf Materialien für die Weiterbildung geben. Natürlich werden viele von ihnen bald von anderen abgelöst, und Sie möchten vielleicht nach neuerer Literatur suchen. Trotzdem glaube ich, dass viele Grundideen noch lange interessant bleiben werden.Wiederkehrende neuronale Netze (RNS)

In den von uns verwendeten direkten Ausbreitungsnetzwerken gibt es einen Eingang, der die Aktivierung aller Neuronen in nachfolgenden Schichten vollständig bestimmt. Dies ist ein sehr statisches Bild: Alles im Netzwerk ist fest und hat einen gefrorenen, kristallinen Charakter. Angenommen, wir lassen zu, dass sich Netzwerkelemente dynamisch ändern. Zum Beispiel kann das Verhalten von versteckten Neuronen nicht nur durch Aktivierungen in vorherigen Schichten bestimmt werden, sondern auch durch Aktivierungen, die früher in der Zeit stattfanden. Die Aktivierung eines Neurons kann teilweise durch seine frühere Aktivierung bestimmt werden. In Netzwerken mit direkter Verteilung ist dies eindeutig nicht der Fall. Oder vielleicht wird die Aktivierung von versteckten und ausgegebenen Neuronen nicht nur durch die aktuelle Eingabe in das Netzwerk bestimmt, sondern auch durch vorherige.Neuronale Netze mit dieser Art von zeitlich variierendem Verhalten werden als wiederkehrende neuronale Netze oder RNS bezeichnet. Es gibt viele Möglichkeiten, die informelle Beschreibung des vorherigen Absatzes mathematisch zu formalisieren. Sie können sich ein Bild davon machen, indem Sie den Wikipedia-Artikel lesen . Zum Zeitpunkt des Schreibens sind in der englischen Version des Artikels mindestens 13 verschiedene Modelle beschrieben [zum Zeitpunkt der Übersetzung im Jahr 2019 bereits 18 / ca. übersetzt.].

Wenn wir jedoch die mathematischen Details beiseite lassen, ist die allgemeine Idee des RNS das Vorhandensein dynamischer Änderungen im Netzwerk, die im Laufe der Zeit auftreten. Und es überrascht nicht, dass sie besonders nützlich sind, um Daten oder Prozesse zu analysieren, die sich im Laufe der Zeit ändern. Solche Daten und Prozesse treten natürlich in Aufgaben wie der Sprachanalyse oder der natürlichen Sprache auf.Eine der aktuellen Möglichkeiten zur Verwendung von RNS besteht darin, neuronale Netze besser in traditionelle Methoden zur Darstellung von Algorithmen zu integrieren, mit Konzepten wie einer Turing-Maschine und gängigen Programmiersprachen. In Arbeit von 2014RNS wurde entwickelt, das in der Lage ist, eine buchstabenweise Beschreibung eines sehr einfachen Python-Programms zu akzeptieren und das Ergebnis seiner Arbeit vorherzusagen. Informell gesehen lernt das Netzwerk, bestimmte Python-Programme zu „verstehen“. In der zweiten Arbeit aus dem Jahr 2014 wurde das RNS als Ausgangspunkt für die Entwicklung der Turing-Neuromaschine (BDC) verwendet. Dies ist ein universeller Computer, dessen gesamte Struktur durch Gradientenabstieg trainiert werden kann. Sie trainierten ihren BDC, um Algorithmen für verschiedene einfache Aufgaben wie Sortieren oder Kopieren zu erstellen.Dies sind natürlich sehr einfache Spielzeugmodelle. Wenn Sie lernen, wie man ein Programm in Python wie print (398345 + 42598) ausführt, wird ein neuronales Netzwerk nicht zu einem vollwertigen Interpreter der Sprache! Es ist nicht klar, wie viel stärker diese Ideen sein werden. Trotzdem sind die Ergebnisse sehr interessant. In der Vergangenheit haben neuronale Netze Muster gut erkannt, die auf herkömmliche algorithmische Ansätze gestoßen sind. Umgekehrt lösen herkömmliche algorithmische Ansätze Probleme, die für NS komplex sind, gut. Heute versucht niemand mehr, einen Webserver oder eine Datenbank auf Basis von NS zu implementieren! Es wäre großartig, integrierte Modelle zu entwickeln, die die Stärken sowohl von NS als auch von traditionellen algorithmischen Ansätzen integrieren. RNS und von ihnen inspirierte Ideen können uns dabei helfen.In den letzten Jahren wurde RNS verwendet, um viele andere Probleme zu lösen. Sie waren besonders nützlich bei der Spracherkennung. RNS-basierte Ansätze stellen Rekorde für die Qualität der Phonemerkennung auf . Sie wurden auch verwendet, um verbesserte Modelle der von Menschen verwendeten Sprache zu entwickeln . Verbesserte Sprachmodelle helfen dabei, Mehrdeutigkeiten in der Sprache zu erkennen, die ähnlich klingen. Ein gutes Sprachmodell kann uns sagen, dass der Ausdruck „vorwärts ins Unendliche“ viel wahrscheinlicher ist als der Ausdruck „vorwärts ohne Gliedmaßen“, obwohl sie ähnlich klingen. RNS wurde verwendet, um Rekordleistungen in bestimmten Sprachtests zu erzielen.Diese Arbeit ist Teil der breiteren Verwendung von NS aller Art, nicht nur von RNS, zur Lösung des Problems der Spracherkennung. Beispielsweise hat ein GNS-basierter Ansatz hervorragende Ergebnisse bei der Erkennung kontinuierlicher Sprache mit einem großen Wortschatz gezeigt. Ein weiteres GNS-basiertes System ist im Android-Betriebssystem von Google implementiert .Ich habe ein wenig darüber gesprochen, wozu die RNCs in der Lage sind, aber nicht erklärt, wie sie funktionieren. Sie werden nicht überrascht sein zu erfahren, dass viele der Ideen aus der Welt der direkten Vertriebsnetze auch in RNS verwendet werden können. Insbesondere können wir den RNS trainieren, indem wir den Gradientenabstieg und die Rückenausbreitung in der Stirn modifizieren. Viele andere Ideen, die in direkten Verteilungsnetzen verwendet werden, von Regularisierungstechniken über Faltungs- und Aktivierungs- bis hin zu Kostenfunktionen, werden ebenfalls nützlich sein. Viele der Ideen, die wir im Rahmen des Buches entwickelt haben, können auch für die Verwendung im RNS angepasst werden.DCT-Module (Long Term Short Term Memory)

Eines der Probleme von RNS ist, dass frühe Modelle sehr schwer zu trainieren waren, komplizierter als selbst GNS. Der Grund waren die Probleme des instabilen Gradienten, die wir in Kapitel 5 besprochen haben. Wir erinnern daran, dass die übliche Manifestation dieses Problems darin bestand, dass der Gradient ständig abnimmt, wenn er sich in entgegengesetzter Richtung durch die Schichten ausbreitet. Dies verlangsamt das Lernen der frühen Schichten extrem. In RNS wird dieses Problem noch schlimmer, da sich die Gradienten nicht nur in der entgegengesetzten Richtung entlang der Schichten, sondern auch zeitlich in der entgegengesetzten Richtung ausbreiten. Wenn das Netzwerk ziemlich lange funktioniert, kann der Gradient extrem instabil werden und auf seiner Basis sehr schwer zu erlernen sein. Glücklicherweise kann eine Idee, die als DCT- Module ( Long Term Short Term Memory ) bekannt ist, in das RNS aufgenommen werden . Zum ersten Mal wurden die Module vorgestelltHochreiter und Schmidguber im Jahr 1997 , speziell um das Problem eines instabilen Gradienten zu lösen. DCTs erleichtern das Erzielen guter Ergebnisse beim Erlernen von RNS, und viele neuere Arbeiten (einschließlich der Arbeiten, auf die ich bereits verwiesen habe) verwenden DCT oder ähnliche Ideen.Deep Trust-Netzwerke, generative Modelle und Boltzmann-Maschinen

Heutzutage hat das Interesse an Deep Learning 2006 nach der Veröffentlichung von Werken ( 1 , 2 ), in denen erklärt wird, wie eine spezielle Art von NS, das so genannte Deep Trust Network (GDS), unterrichtet wird, einen zweiten Wind bekommen . GDS beeinflusste mehrere Jahre lang das Forschungsfeld, aber dann begann ihre Popularität abzunehmen, und direkte Vertriebsnetze und wiederkehrende NS wurden in Mode. Trotzdem machen einige der Eigenschaften von GDS sie sehr interessant.Erstens sind GDS ein Beispiel für ein generatives Modell. In einem direkten Verteilungsnetzwerk spezifizieren wir Eingabeaktivierungen und sie bestimmen die Aktivierung von Merkmalsneuronen weiter unten im Netzwerk. Das generative Modell kann auf ähnliche Weise verwendet werden, aber Sie können die Werte der darin enthaltenen Neuronen festlegen und dann das Netzwerk „in die entgegengesetzte Richtung“ ausführen, um die Werte der Eingabeaktivierungen zu generieren. Insbesondere kann ein GDS, der auf handgeschriebenen Ziffernbildern trainiert ist, selbst Bilder erzeugen, die handgeschriebenen Ziffern ähnlich sind (möglicherweise und nach bestimmten Aktionen). Mit anderen Worten, GDM kann gewissermaßen schreiben lernen. In diesem Sinne ähneln generative Modelle dem menschlichen Gehirn: Sie können Zahlen nicht nur lesen, sondern auch schreiben. Jeffrey Hintons berühmtes Sprichwort gibt an, dass Sie für die Mustererkennung zunächst lernen müssen, wie Bilder generiert werden.Zweitens können sie ohne Lehrer und fast ohne Lehrer lernen . Wenn Sie beispielsweise Bilder trainieren, können GDS Zeichen lernen, die zum Verständnis anderer Bilder nützlich sind, selbst wenn die Trainingsbilder keine Markierungen aufweisen. Die Fähigkeit, ohne Lehrer zu lernen, ist sowohl aus grundlegender wissenschaftlicher als auch aus praktischer Sicht äußerst interessant - wenn sie gut genug funktioniert.Warum ging ihre Popularität angesichts all dieser attraktiven Punkte der GDS als Modelle für tiefes Lernen zurück? Teilweise aufgrund der Tatsache, dass andere Modelle wie Direktverteilung und wiederkehrende Netzwerke erstaunliche Ergebnisse erzielt haben, insbesondere Durchbrüche in den Bereichen Bilderkennung und Sprache. Es ist nicht überraschend, dass diese Modelle solche Aufmerksamkeit erhalten haben und sehr verdient sind. Daraus folgt jedoch eine unangenehme Schlussfolgerung. Der Markt der Ideen funktioniert oft nach dem Schema „Gewinner bekommt alles“, und fast die gesamte Aufmerksamkeit gilt dem, was derzeit in diesem Bereich am angesagtesten ist. Es kann für Menschen äußerst schwierig sein, an derzeit unpopulären Ideen zu arbeiten, auch wenn es offensichtlich ist, dass sie von langfristigem Interesse sind. Meine persönliche Meinung ist, dass die GDS und andere generative Modelle mehr Aufmerksamkeit verdienen als sie bekommen.Ich bin nicht überrascht, wenn das GDM oder ein ähnliches Modell jemals die heutigen populären Modelle übertrifft. Lesen SieDieser Artikel dient der Einführung in den Bereich GDM. Dieser Artikel kann auch nützlich sein . Es geht nicht nur um GDM, aber es gibt viele nützliche Dinge über limitierte Boltzmann-Maschinen, eine Schlüsselkomponente von GDM.Andere Ideen

Was passiert sonst noch im Bereich der Nationalversammlung und des Zivilschutzes? Eine Menge interessanter Arbeiten. Zu den aktiven Forschungsgebieten gehört die Verwendung von NS zur

Verarbeitung natürlicher

Sprache ,

maschineller Übersetzung und unerwarteterer Anwendungen, beispielsweise der

Musikinformatik . Es gibt viele andere Bereiche. In vielen Fällen können Sie nach dem Lesen dieses Buches die neuesten Arbeiten verstehen, obwohl Sie natürlich möglicherweise einige Wissenslücken schließen müssen.

Ich werde diesen Abschnitt mit der Erwähnung einer besonders interessanten Arbeit beenden. Sie kombiniert tiefe Faltungsnetzwerke mit einer Technik namens Verstärkungslernen,

um zu

lernen, wie man Videospiele spielt (und

einem weiteren Artikel darüber). Die Idee ist, ein Faltungsnetzwerk zu verwenden, um Pixeldaten vom Spielbildschirm aus zu vereinfachen und sie in einen einfacheren Satz von Attributen umzuwandeln, die dann verwendet werden können, um Entscheidungen über weitere Aktionen zu treffen: "nach links gehen", "nach rechts gehen", "schießen" und usw. Besonders interessant ist, dass ein Netzwerk ziemlich gut gelernt hat, sieben verschiedene klassische Videospiele zu spielen, vor Experten in drei von ihnen. Dies sieht natürlich nach einem Trick aus, und die Arbeit wurde aktiv unter der Überschrift „Atari-Spiele mit Reinforcement Learning spielen“ beworben. Hinter einem oberflächlichen Glanz ist jedoch die Tatsache zu berücksichtigen, dass das System Rohpixeldaten verwendet - es kennt nicht einmal die Spielregeln - und auf ihrer Grundlage darauf trainiert ist, qualitativ hochwertige Entscheidungen in mehreren sehr unterschiedlichen und sehr wettbewerbsorientierten Situationen zu treffen, von denen jede ihre eigenen komplexen Regeln hat. Ziemlich gut.

Die Zukunft neuronaler Netze

User Intent Interfaces

In einem alten Witz sagt ein ungeduldiger Professor zu einem verwirrten Studenten: "Höre nicht auf meine Worte, hör auf das, was ich meine." In der Vergangenheit haben Computer wie ein verwirrter Schüler oft nicht verstanden, was ein Benutzer bedeutet. Die Situation ändert sich jedoch. Ich erinnere mich noch an das erste Mal, als ich überrascht war, als ich fälschlicherweise eine Anfrage an Google schrieb und die Suchmaschine zu mir sagte: "Meinten Sie [richtige Anfrage]?" Google Director Larry Page hat

einmal die perfekte Suchmaschine als ein System beschrieben, das genau versteht, was Ihre Abfragen bedeuten, und Ihnen genau das gibt, was Sie wollen.

Dies ist die Idee einer Schnittstelle, die auf der Absicht des Benutzers basiert. Anstatt auf wörtliche Benutzeranfragen zu antworten, verwendet die Suchmaschine das MO, um eine vage Benutzeranfrage entgegenzunehmen, genau zu verstehen, was dies bedeutet, und auf dieser Basis zu handeln.

Die Idee einer Schnittstelle, die auf der Absicht des Benutzers basiert, kann breiter angewendet werden als nur bei der Suche. In den nächsten Jahrzehnten werden Tausende von Unternehmen Produkte entwickeln, in denen MO für Benutzeroberflächen verwendet wird, wobei sie sich ruhig auf ungenaue Benutzeraktionen beziehen und ihre wahren Absichten erraten. Wir sehen bereits frühe Beispiele für solche absichtsbasierten Schnittstellen: Apple Siri; Wolfram Alpha; IBM Watson Systeme, die Fotos und Videos automatisch markieren und vieles mehr.

Die meisten von ihnen werden scheitern. Die Entwicklung von Schnittstellen ist eine komplizierte Sache, und ich vermute, dass viele Unternehmen, anstatt Schnittstellen zu inspirieren, leblose Schnittstellen auf der Basis von MO erstellen werden. Das beste MO der Welt hilft Ihnen nicht, wenn Ihre Schnittstelle nicht funktioniert. Einige Produkte werden jedoch erfolgreich sein. Dies wird im Laufe der Zeit zu einer ernsthaften Änderung unserer Beziehung zu Computern führen. Vor nicht allzu langer Zeit, zum Beispiel im Jahr 2005, hielten Benutzer es für selbstverständlich, dass die Interaktion mit Computern eine hohe Genauigkeit erfordert. Die wörtliche Natur des Computers diente dazu, die Idee zu verbreiten, dass Computer sehr wörtlich sind; Das einzige vergessene Semikolon könnte die Art der Interaktion mit dem Computer vollständig verändern. Ich glaube jedoch, dass wir in den nächsten Jahrzehnten mehrere erfolgreiche Schnittstellen entwickeln werden, die auf der Absicht der Benutzer basieren, und dies wird unsere Erwartungen bei der Arbeit mit Computern radikal verändern.

Maschinelles Lernen, Datenwissenschaft und der makellose Innovationskreis

Natürlich wird MO nicht nur zum Erstellen von Schnittstellen verwendet, die auf der Absicht des Benutzers basieren. Eine weitere interessante Anwendung von MO ist die Datenwissenschaft, bei der nach „bekannten Unbekannten“ gesucht wird, die in den erhaltenen Daten verborgen sind. Dies ist bereits ein modisches Thema, über das viele Artikel geschrieben wurden, daher werde ich nicht lange darauf eingehen. Ich möchte eine Konsequenz dieser Mode erwähnen, die nicht oft erwähnt wird: Auf lange Sicht ist es möglich, dass der größte Durchbruch in der Region Moskau nicht nur ein konzeptioneller Durchbruch sein wird. Der größte Durchbruch wird darin bestehen, dass die Forschung auf dem Gebiet der MO durch die Verwendung von Daten in der Wissenschaft und in anderen Bereichen rentabel wird. Wenn ein Unternehmen einen Dollar in MO-Forschung investieren und ziemlich schnell einen Dollar und zehn Cent Umsatz erzielen kann, wird viel Geld in die MO-Region fließen. Mit anderen Worten, MO ist der Motor, der uns zur Entstehung mehrerer großer Märkte und Bereiche des Technologiewachstums treibt. Infolgedessen werden große Teams von Experten auf diesem Gebiet erscheinen, die Zugang zu unglaublichen Ressourcen haben. Dies wird das MO noch weiter bewegen und noch mehr Märkte und Möglichkeiten schaffen, die den makellosen Innovationskreis bilden werden.

Die Rolle neuronaler Netze und tiefes Lernen

Ich habe MO allgemein als einen Weg beschrieben, neue Möglichkeiten für die Technologieentwicklung zu schaffen. Welche spezifische Rolle wird die Nationalversammlung und die Zivilgesellschaft dabei spielen?

Um die Frage zu beantworten, ist es nützlich, sich der Geschichte zuzuwenden. In den 1980er Jahren gab es eine aktive freudige Wiederbelebung und Optimismus in Verbindung mit neuronalen Netzen, insbesondere nach der Popularisierung der Rückausbreitung. Die Erholung ließ jedoch nach, und in den neunziger Jahren wurde der MO-Stab auf andere Technologien übertragen, beispielsweise auf die Support-Vektor-Methode. Heute ist die Nationalversammlung wieder auf dem Pferd, stellt alle möglichen Rekorde auf und überholt viele Gegner in verschiedenen Problemen. Aber wer garantiert, dass morgen kein neuer Ansatz entwickelt wird, der die NA erneut überschattet? Oder werden die Fortschritte auf dem Gebiet der Nationalversammlung vielleicht ins Stocken geraten und nichts wird sie ersetzen?

Daher ist es viel einfacher, über die Zukunft des gesamten Verteidigungsministeriums nachzudenken, als speziell über die Nationalversammlung. Ein Teil des Problems ist, dass wir die Nationalversammlung sehr schlecht verstehen. Warum kann NS so gut Informationen zusammenstellen? Wie vermeiden sie eine so gute Umschulung angesichts der Vielzahl von Optionen? Warum funktioniert der stochastische Gradientenabstieg so gut? Wie gut funktioniert NS beim Skalieren von Datensätzen? Wenn wir beispielsweise die ImageNet-Basis zehnmal erweitern, wird sich die Leistung des NS mehr oder weniger verbessern als die Effektivität anderer MO-Technologien? All dies sind einfache, grundlegende Fragen. Und bis jetzt haben wir ein sehr schlechtes Verständnis für die Antworten auf diese Fragen. In dieser Hinsicht ist es schwierig zu sagen, welche Rolle die Nationalversammlung in der Zukunft der Region Moskau spielen wird.

Ich werde eine Vorhersage machen: Ich denke, dass GO nirgendwo hingehen wird. Die Fähigkeit, Hierarchien von Konzepten zu studieren und verschiedene Abstraktionsebenen aufzubauen, ist offensichtlich von grundlegender Bedeutung für das Wissen der Welt. Dies bedeutet nicht, dass sich die GO-Netzwerke von morgen nicht radikal von denen von heute unterscheiden werden. Wir können auf große Änderungen in ihren Bestandteilen, Architekturen oder Lernalgorithmen stoßen. Diese Änderungen können sich als dramatisch genug herausstellen, damit wir die resultierenden Systeme nicht mehr als neuronale Netze betrachten. Sie werden sich jedoch weiterhin im Zivilschutz engagieren.

Werden NS und GO bald zum Auftreten künstlicher Intelligenz führen?

In diesem Buch haben wir uns auf die Verwendung von NS bei der Lösung spezifischer Probleme konzentriert, z. B. der Bildklassifizierung. Lassen Sie uns unsere Fragen erweitern: Was ist mit universell denkenden Computern? Können uns die Nationalversammlung und die Zivilgesellschaft helfen, das Problem der Schaffung einer Allzweck-KI zu lösen? Und wenn ja, werden wir angesichts der hohen Fortschritte im Bereich des Zivilschutzes in naher Zukunft die Entstehung von KI sehen?

Eine detaillierte Antwort auf eine solche Frage würde ein separates Buch erfordern. Lassen Sie mich stattdessen eine Beobachtung anbieten, die auf

dem Gesetz von

Conway basiert :

Organisationen, die Systeme entwerfen, sind auf ein Design beschränkt, das die Kommunikationsstruktur dieser Organisation kopiert.

Das heißt, das Gesetz von Conway besagt beispielsweise, dass das Layout des Boeing 747-Flugzeugs die erweiterte Struktur von Boeing und seinen Auftragnehmern zum Zeitpunkt der Entwicklung des 747-Modells widerspiegelt. Oder ein anderes einfaches und konkretes Beispiel: Betrachten Sie ein Unternehmen, das komplexe Software entwickelt. Wenn das Software-Control-Panel mit dem MO-Algorithmus verbunden werden soll, sollte der Panel-Designer mit dem MO-Experten des Unternehmens kommunizieren. Conways Gesetz formalisiert diese Beobachtung einfach.

Zum ersten Mal, als sie Conways Gesetz hörten, sagten viele Leute entweder: "Ist das kein alltäglicher Beweis?" Oder "Ist es so?" Ich werde mit einer Bemerkung über seine Untreue beginnen. Denken wir mal: Wie spiegelt sich die Boeing-Buchhaltung im Modell 747 wider? Was ist mit der Reinigungsabteilung? Ein Fütterungspersonal? Die Antwort ist, dass diese Teile der Organisation höchstwahrscheinlich nirgendwo anders in Schema 747 explizit erscheinen. Daher müssen Sie verstehen, dass das Gesetz von Conway nur für diejenigen Teile der Organisation gilt, die direkt mit Design und Engineering befasst sind.

Was ist mit der Bemerkung über Banalität und Beweise? Vielleicht ist das so, aber ich denke nicht, weil Organisationen oft daran arbeiten, das Gesetz von Conway abzulehnen. Teams, die neue Produkte entwickeln, sind häufig aufgrund der übermäßigen Anzahl von Mitarbeitern aufgeblasen, oder umgekehrt fehlt ihnen eine Person mit kritischem Wissen. Denken Sie an alle Produkte mit nutzlosen und komplizierten Funktionen. Oder denken Sie an Produkte mit offensichtlichen Mängeln - zum Beispiel mit einer schrecklichen Benutzeroberfläche. In beiden Programmklassen treten häufig Probleme auf, weil das Team, das für die Veröffentlichung eines guten Produkts erforderlich ist, nicht mit dem Team übereinstimmt, das sich wirklich versammelt hat. Das Gesetz von Conway mag offensichtlich sein, aber das bedeutet nicht, dass die Leute es nicht regelmäßig ignorieren können.

Das Gesetz von Conway gilt für den Entwurf und die Erstellung von Systemen in Fällen, in denen wir uns von Anfang an vorstellen, aus welchen Bestandteilen das Produkt bestehen wird und wie sie hergestellt werden sollen. Es kann nicht direkt auf die Entwicklung der KI angewendet werden, da die KI (noch) keine solche Aufgabe ist: Wir wissen nicht, aus welchen Teilen sie besteht. Wir sind uns nicht einmal sicher, welche grundlegenden Fragen Sie stellen können. Mit anderen Worten, im Moment ist KI eher ein Problem der Wissenschaft als der Ingenieure. Stellen Sie sich vor, Sie müssen mit der Entwicklung des 747 beginnen, ohne etwas über Düsentriebwerke oder die Prinzipien der Aerodynamik zu wissen. Sie wissen nicht, welche Experten Sie in Ihrer Organisation einstellen sollen. Wie Werner von Braun schrieb: "Grundlagenforschung ist das, was ich mache, wenn ich nicht weiß, was ich mache." Gibt es eine Version des Conway-Gesetzes, die für Aufgaben gilt, die mehr mit der Wissenschaft als mit Ingenieuren zu tun haben?

Um die Antwort auf diese Frage zu finden, erinnern wir uns an die Geschichte der Medizin. In den frühen Tagen war die Medizin die Domäne von Praktizierenden wie

Galen oder

Hippokrates , die den gesamten menschlichen Körper untersuchten. Aber mit der Zunahme unseres Wissensvolumens musste ich mich spezialisieren. Wir haben viele tiefe Ideen entdeckt - erinnern Sie sich an die mikrobielle Theorie von Krankheiten oder an das Verständnis des Wirkungsprinzips von Antikörpern oder an die Tatsache, dass Herz, Lunge, Venen und Arterien das Herz-Kreislauf-System bilden. Solche tiefen Ideen bildeten die Grundlage für engere Disziplinen wie Epidemiologie, Immunologie und die Anhäufung überlappender Bereiche im Zusammenhang mit dem Herz-Kreislauf-System. So bildete die Struktur unseres Wissens die soziale Struktur der Medizin. Dies macht sich insbesondere in der Immunologie bemerkbar: Die Vorstellung, dass ein Immunsystem existiert, das einer gesonderten Studie würdig ist, war sehr trivial. Wir haben also ein ganzes Gebiet der Medizin - mit Spezialisten, Konferenzen, Auszeichnungen usw. -, das sich um etwas kümmert, das nicht nur unsichtbar, sondern vielleicht auch nicht getrennt ist.

Eine solche Entwicklung von Ereignissen wurde oft in vielen etablierten wissenschaftlichen Disziplinen wiederholt: nicht nur in der Medizin, sondern auch in Physik, Mathematik, Chemie und anderen. Regionen werden monolithisch geboren und haben nur wenige tiefgreifende Ideen auf Lager. Die ersten Experten können sie alle abdecken. Aber im Laufe der Zeit ändert sich die Solidität. Wir entdecken viele neue tiefe Ideen, und es gibt zu viele, als dass jemand sie alle wirklich beherrschen könnte. Infolgedessen wird die soziale Struktur der Region neu organisiert und geteilt, wobei diese Ideen im Mittelpunkt stehen. Anstelle eines Monolithen haben wir Felder, die durch Felder geteilt sind, die durch Felder getrennt sind - eine komplexe, rekursive soziale Struktur, die sich auf sich selbst bezieht und deren Organisation die Verbindungen zwischen den tiefgreifendsten Ideen widerspiegelt. So bildet die Struktur unseres Wissens die soziale Organisation der Wissenschaft. Diese soziale Form begrenzt jedoch wiederum und hilft zu bestimmen, was wir erkennen können. Dies ist das wissenschaftliche Analogon zu Conways Gesetz.

Aber was hat das alles mit Deep Learning oder KI zu tun?

Nun, seit den Anfängen der KI-Entwicklung

gab es Debatten darüber, dass alles entweder "nicht zu kompliziert, dank der Superwaffe, die wir haben" oder "Superwaffe wird nicht genug sein". Deep Learning ist das neueste Beispiel für eine Superwaffe, die in den Streitigkeiten verwendet wurde, die ich gesehen habe. In den frühen Versionen solcher Streitigkeiten wurde Logik oder Prolog oder Expertensysteme oder eine andere Technologie verwendet, die damals die mächtigste war. Das Problem bei solchen Streitigkeiten ist, dass sie Ihnen nicht die Möglichkeit geben, genau zu sagen, wie mächtig einer der Kandidaten für Superwaffen sein wird. Natürlich haben wir nur ein ganzes Kapitel damit verbracht, Beweise dafür zu prüfen, dass Zivilschutz äußerst komplexe Probleme lösen kann. Es sieht auf jeden Fall sehr interessant und vielversprechend aus. Dies war jedoch bei Systemen wie Prolog oder Eurisko oder bei Expertensystemen der Fall. Daher bedeutet nur die Tatsache, dass eine Reihe von Ideen vielversprechend aussieht, nichts Besonderes. Woher wissen wir, dass GO sich tatsächlich von diesen frühen Ideen unterscheidet? Gibt es eine Möglichkeit zu messen, wie mächtig und vielversprechend eine Reihe von Ideen ist? Aus Conways Gesetz folgt, dass wir die Komplexität der mit diesen Ideen verbundenen sozialen Struktur als grobe und heuristische Metrik verwenden können.

Daher haben wir zwei Fragen. Erstens, wie mächtig sind die zivilgesellschaftlichen Ideen gemäß dieser Metrik der sozialen Komplexität? Zweitens, wie mächtig ist eine Theorie, um eine Allzweck-KI zu erstellen?

Zur ersten Frage: Wenn wir uns heute den Zivilschutz ansehen, sieht dieses Feld interessant aus und entwickelt sich schnell, aber relativ monolithisch. Es hat mehrere tiefgreifende Ideen und es werden mehrere große Konferenzen abgehalten, von denen sich einige stark überschneiden. Bei der Arbeit werden dieselben Ideen verwendet: der stochastische Gradientenabstieg (oder dessen nahe Äquivalent), um die Kostenfunktion zu optimieren. Es ist großartig, dass diese Ideen so erfolgreich sind. Was wir bisher nicht beobachten, ist eine große Anzahl gut entwickelter kleinerer Gebiete, von denen jedes seine eigenen tiefgreifenden Ideen erforschen würde, die die Zivilgesellschaft in viele Richtungen bewegen würden. Entsprechend der Metrik der sozialen Komplexität tut Deep Learning dem Wortspiel leid, während es ein sehr flaches Forschungsgebiet bleibt. Eine Person ist immer noch in der Lage, die meisten tiefen Ideen aus diesem Bereich zu beherrschen.

Zur zweiten Frage: Wie viel komplexe und leistungsstarke Ideen werden benötigt, um KI zu schaffen? Die Antwort lautet natürlich: Niemand weiß es genau. Aber im Nachwort zum Buch habe ich einige der vorhandenen Beweise zu diesem Thema studiert. Ich kam zu dem Schluss, dass die Schaffung von KI selbst nach optimistischen Schätzungen viele, viele tiefgreifende Ideen erfordern wird. Nach dem Gesetz von Conway müssen, um diesen Punkt zu erreichen, viele miteinander verbundene Disziplinen mit einer komplexen und unerwarteten Struktur entstehen, die die Struktur unserer tiefsten Ideen widerspiegelt. Wir beobachten noch keine so komplexe soziale Struktur, wenn wir NS und Zivilschutz einsetzen. Daher glaube ich, dass wir zumindest einige Jahrzehnte davon entfernt sind, GO zur Entwicklung einer Allzweck-KI zu verwenden.

Ich habe mich sehr bemüht, ein spekulatives Argument zu entwickeln, das vielleicht ganz offensichtlich erscheint und nicht zu einer bestimmten Schlussfolgerung führt. Dies wird sicherlich sicherheitsliebende Menschen enttäuschen. Ich treffe viele Leute online, die öffentlich ihre sehr eindeutigen und selbstbewussten Meinungen über KI verkünden, oft basierend auf wackeligen Argumenten und nicht existierenden Beweisen. Ich kann ehrlich sagen: Ich denke, es ist zu früh, um es beurteilen zu können. Wie im alten Witz: Wenn Sie einen Wissenschaftler fragen, wie viel mehr wir auf eine Entdeckung warten müssen und er „10 Jahre“ (oder mehr) sagt, dann bedeutet er tatsächlich „Ich habe keine Ahnung“. Vor dem Aufkommen der KI, wie im Fall der kontrollierten Kernfusion und einiger anderer Technologien, sind „10 Jahre“ mehr als 60 Jahre geblieben. Auf der anderen Seite haben wir im Bereich des Zivilschutzes definitiv eine wirksame Technologie, deren Grenzen wir noch nicht entdeckt haben, und viele offene grundlegende Aufgaben. Und es eröffnet erstaunliche kreative Möglichkeiten.