UX- und UI-Designer stehen Sprachschnittstellen immer noch skeptisch gegenüber. Einer scheint ein Marketing-Hype zu sein, der bald zunichte gemacht wird. Andere verwenden keine Sprachassistenten und sind daher zuversichtlich, dass die Stimme unangenehm und unnatürlich ist. Aber während sie zweifelten, hat sich eine unabhängige berufliche Sphäre entwickelt - mit ihren Geheimnissen, Mustern und Mechaniken (und sogar dem Arbeitsmarkt). Gemeinsam mit der Just AI UX-Architektin Yekaterina Yulina finden wir heraus, wie man mit Sprachtechnologien umgeht und was der UX-Designer traditioneller Schnittstellen in seinem Denken ändern und die Stimme aufnehmen sollte.

Aber zuerst eine kleine Retrospektive. Auf dem Hof 1995. Microsoft veröffentlicht Windows 95 und eine Revolution findet in der Welt statt. Ich erinnere mich, wie Eltern und andere Erwachsene über die Vorteile und Gefahren von Computern sprachen. Und am Wochenende besuchte die ganze Familie unsere Freunde, um Kosinka und Minesweeper zu spielen.

Das Nokia 3310 wurde im Jahr 2000 veröffentlicht. Die Welt hat sich erneut verändert, diesmal dank Telefonen mit Drucktasten. Smartphones mit Stiften erschienen später. Ich hatte auch einen. Das Stochern mit einem Stift auf dem Bildschirm war sehr cool. Hebt sich sofort irgendwie vom Hintergrund von Menschen mit Drucktastentelefonen ab. Aber "der beste Stift ist Ihr eigener Finger", sagte Steve Jobs. Im Jahr 2007 begann Apple mit dem Verkauf des iPhone - und seitdem tippen und wischen die Leute, und das Stöbern mit einem Stift war lange Zeit dumm.

Und dann ging es los: 2011 - Apple präsentiert Siri, 2014 startet Amazon Alexa und Amazon Echo, 2016 erscheint Google Assistant, 2017 - „Alice“ von Yandex ... Türen vor Entwicklern und Unternehmen geöffnet Ökosystem der Assistenten, wie einmal - in mobilen App Stores. Und bald wird nur ein Fauler (und Kurzsichtiger!) Keine Fähigkeiten für Sprachassistenten entwickeln.

Situationen, in denen die Stimme wirklich bequem ist

Es ist nicht vorstellbar, dass eine Benutzererfahrung (UX, Benutzererfahrung) in einem Vakuum aufgebaut ist. Sprachkenntnisse entstehen in einer bestimmten Situation, in der sie nützlich und organisch sind. Es macht keinen Sinn, ein Sprachskript zu erstellen und dann darüber nachzudenken, wo es angewendet werden soll. Es ist wichtig, diese Situation zu entdecken und meisterhaft zu überwinden.

Sprache ist bequemer als Web- oder mobile Anwendungen, wenn wir eine bestimmte Funktion benötigen, um ein bestimmtes Problem zu lösen. Warum? Da Sie nicht warten müssen, bis die Site geladen ist, scrollen Sie durch die Seiten, durchsuchen Sie das Menü und drücken Sie die Tasten. Websites und Anwendungen sind multifunktional. Die Sprachkenntnisse sollten für einen einzelnen Fall unter "Hier und Jetzt" geschärft werden.

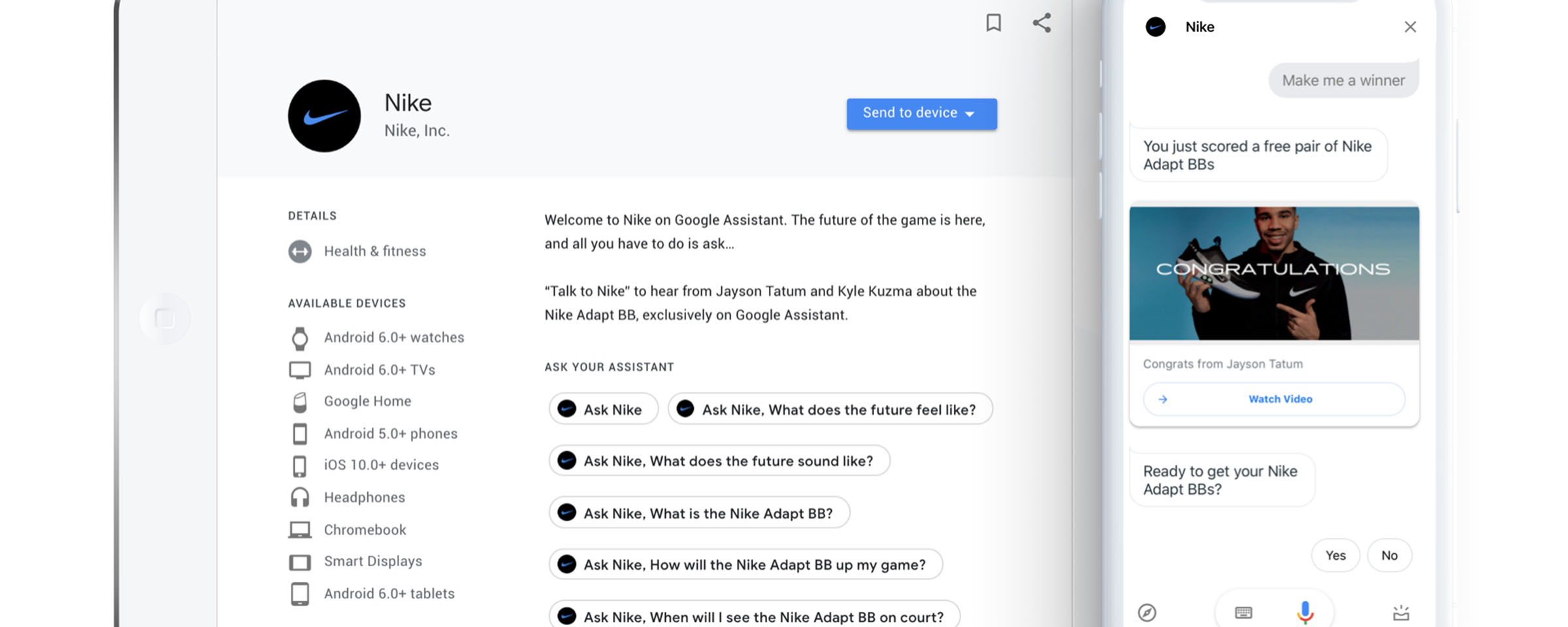

Im Februar 2019 sendete der amerikanische Sender TNT NBA-Spiele. Zwischen den Spielen Los Angeles Lakers und Boston Celtics gibt Kommentator Ernie Johnson bekannt, dass Nike Sneakers in limitierter Auflage verkauft werden und dass die Zuschauer Google Assistant möglicherweise bitten, ein Paar für 350 US-Dollar für sie zu buchen.

Sechs Minuten später verschwanden die Turnschuhe. Mehr als 15.000 Personen buchten sie mit Hilfe eines Sprachassistenten (die Anzahl der Bestellungen überstieg die Menge der verfügbaren Waren). Die ideale Situation für den Verkauf von Basketballschuhen war ein echtes Spiel.

Bereits 2017 hatte Starbucks herausgefunden, wie man mit einem Sprachassistenten die Wartezeit für eine Bestellung und den Weg des Kunden zur gewünschten Tasse Kaffee verkürzt. Sie können "Alexa, bestellen Sie meine Starbucks" ("Alexa, bestellen Sie meine Starbucks") sagen und Ihr Lieblingsgetränk in wenigen Minuten am nächsten Ort abholen. Sie müssen nicht in der Schlange stehen und darauf warten, dass der Barista Ihren Namen ruft. Sie müssen nicht in die Anwendung gehen, suchen Sie nach Ihrer üblichen Bestellung und bestätigen Sie die Auswahl. Dann schlug der gleiche Fall Ford: Alexa wurde in das SYNC3-Multimediasystem integriert, sodass die Fahrer die Möglichkeit hatten, ihre Starbucks direkt im Auto per Stimme zu bestellen und zu bezahlen, ohne von der Straße abgelenkt zu werden.

Aber Kollegen von Alan AI erzählten mir, wie sie einen angewandten User Case gefunden haben - nicht für Marketing, sondern für Unternehmensaufgaben. Das technische Personal, das die Aufzüge in den USA bedient, muss Tonnen von Dokumentationen lesen, eine Reihe von Formularen ausfüllen, Reparaturdaten eingeben, über die Erledigung von Aufgaben berichten - und dies alles in verschiedenen Buchhaltungssystemen. Das Schreiben nimmt viel Zeit in Anspruch, in der der Aufzug nicht funktioniert. Alan AI verwendete die Technologie der künstlichen Sprachintelligenz, damit Lifter-Benutzer während der Arbeit oder auf Reisen zur Einrichtung Formulare mit Sprache ausfüllen können.

Bei Voice UX geht es nicht um Bilder, sondern um den Kontext der Situation. Die Aufgabe des Designers ist es, den Kontext im Detail zu untersuchen und zu verstehen, was der Benutzer in einer bestimmten Situation will.

UX-Muster in der Stimme

Eine Funktion. Eine Fähigkeit ist also eine Funktion. Wenn der Fahrer Kaffee bestellt, löst er dieses spezielle Problem. Fertig mit Kaffee und will die Entfernung zum Mond wissen? Eine andere Sprachfähigkeit ist bereits dafür verantwortlich. Ein Schweizer Messer in einer Fertigkeit herzustellen ist eine schlechte Idee.

Scrollen. UX- und UI-Designer streiten sich ständig mit Marketingfachleuten darüber, wie viele Informationen auf dem ersten Bildschirm angezeigt werden sollen. Es gibt nichts Schlimmeres, als darauf zu warten, dass der Inhalt geladen wird, und endlos durch die Seite zu scrollen. Dialogoberflächen haben auch einen ersten Bildschirm und im Gegensatz zum Web gibt es keinen Bildlauf. Er wird nicht benötigt, da der Sprachassistent eine Reihe von Fähigkeiten besitzt. Der Benutzer aktiviert auf Befehl die Fertigkeit und startet eine einzelne Funktion.

Modale Fenster und Schaltflächen. Der zweite Name für modale Fenster ist Dialog. Was ist das Wesentliche an modalen Fenstern? Bestätigen oder verweigern Sie die Absicht, den Vorgang auszuführen. Im wirklichen Leben drücken die Leute Absichten aus, indem sie Ja oder Nein sagen, und dafür benötigen Sie keine Schaltflächen.

Multimodalität. Intelligente Lautsprecher und Bildschirme, Smartphones, sprechendes Spielzeug für Kinder, intelligente Häuser, Armaturenbrett im Auto - Geräte bestimmen den Nutzungskontext. Was es für den Benutzer bequem ist, zu Hause über einen „intelligenten“ Lautsprecher zu arbeiten, unterscheidet sich von der Verwendung eines Sprachassistenten in einem Auto. Der gleiche Assistent auf verschiedenen Plattformen verfügt über unterschiedliche Fähigkeiten.

Definieren Sie den Verwendungskontext und das Gerät. Überprüfen Sie, ob Sie Sprache mit einer anderen Art der Interaktion auf diesem Gerät kombinieren können.

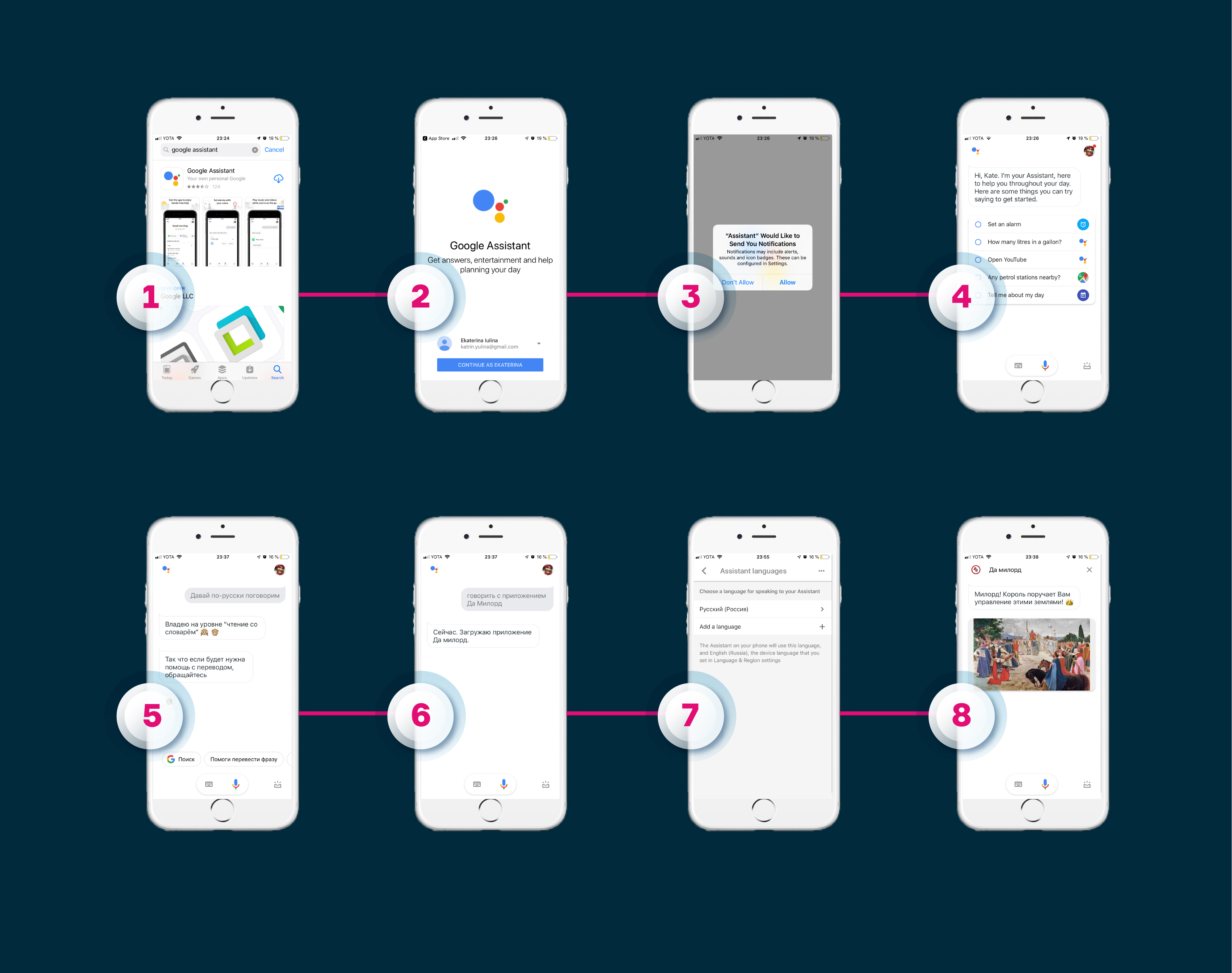

Plattformübergreifend . Ein weiterer Aspekt ist, wie man eine Fertigkeit für mehrere Assistenten macht. Mechanik und Logik können beibehalten werden, aber der Teufel wird in den Implementierungsdetails und dem Pfad des Benutzers zur Fertigkeit verborgen bleiben. Lassen Sie uns sehen, wie der Pfad zu den Fähigkeiten von Alice und den Aktionen von Google Assistant auf derselben Plattform aussieht.

Alice unter iOS . Alice-Benutzer müssen zuerst die Yandex.Browser-Anwendung herunterladen, ihm erlauben, den Standort und das Mikrofon zu verwenden, auf das Assistentensymbol klicken und die Aktivierungsphrase der Fertigkeit sagen. Zum Beispiel "Starten Sie die Fertigkeit" Ja, mein Herr. " Die zweite und nachfolgende Benutzererfahrung besteht aus drei Schritten: Öffnen Sie Yandex.Browser, klicken Sie auf die Schaltfläche für den Assistentenanruf und sagen Sie eine Aktivierungsphrase.

Google Assistant unter iOS

Google Assistant unter iOS . Der Nutzer lädt die Google Assistant-Anwendung herunter, meldet sich über sein Konto an, ermöglicht das Senden von Benachrichtigungen und erklärt sich mit dem Zugriff auf das Mikrofon einverstanden. Wenn die Standardsprache Englisch ist, müssen Sie in der Anwendungsoberfläche Russisch auswählen, den Assistenten bitten, die Sprache mit Ihrer Stimme zu ändern und die Aktivierungsphrase zu sagen, um die Aktion auszulösen. Hier ist sie anders - "Sprechen Sie mit der Anwendung" Ja, mein Herr. " Dann wird der Pfad verkürzt - das zweite Mal, wenn der Nutzer die Google Assistant-Anwendung öffnet und einfach den Befehl ausspricht.

Ohne Kenntnis der Aktivierungsphrase (und die Befehle zum Aufrufen derselben Fertigkeit in verschiedenen Ökosystemen unterscheiden sich), führen Sie die Fertigkeit nicht aus - und in Bezug auf UX ist dies eine der Schwächen von Sprachassistenten. Google, Yandex und andere Unternehmen arbeiten derzeit an der Aufgabe, bequeme Fähigkeiten zu entdecken (wie den Verbrauchern Informationen über neue Fähigkeiten korrekt vermittelt werden können), sodass es zu einem bestimmten Zeitpunkt einfacher sein wird, nützliche und relevante Fähigkeiten zu finden.

Übrigens bestehen VUI-Designer darauf, dass eine Fähigkeit mit derselben Mechanik für verschiedene Assistenten immer noch separate Projekte sind.

Entwerfen einer Schnittstelle in sieben Schritten

Ich habe VUI-Designer, Just AI-Kollegen und Benutzer des Aimylogic Skill Builder gefragt, mit denen sie im Allgemeinen mit der Arbeit am Skript beginnen. Jeder sagt "mit einer Idee". Sie können es in freier Form in einem Texteditor beschreiben.

Pavel Gvay, Gründer von tortu.io - einem Tool zum Entwerfen von Sprachanwendungen: „Der schnellste und kostengünstigste Weg, um zu verstehen, wie die Konversation zwischen dem Benutzer und Ihrer Anwendung aufgebaut wird, besteht darin, ein Beispiel für einen Dialog zu schreiben. Dies ist eine Textdatei, die den Betrieb eines Flusses beschreibt. Im Format ähneln die Dialogbeispiele dem Drehbuch für den Film, in dem alle Bemerkungen nach Rollen gemalt sind. “

Beispieldialog in NotionBenutzer begrüßen

Beispieldialog in NotionBenutzer begrüßenSagen Sie uns, was der Bot macht. Verwenden Sie geräumige Sätze mittlerer Länge. Beenden Sie den Satz mit einer geschlossenen Frage: Damit der Benutzer versteht, was er von ihm will.

Schlecht - „Hallo! Ich bin Aktivität. Ich kann keinen Tag ohne Sport leben. Er ist mein Alles, mein Leben, meine Inspiration! Ich habe auch viel Erfahrung als Trainer und Hunderte von Übungen in der Datenbank! Gerne teile ich meine Lieblingsübungen mit Ihnen! “

Gut - "Hallo! Ich bin Activity, ein Bot-Athlet. Ich empfehle Ihnen gerne eine Reihe von Übungen. Möchtest du etwas über Yoga erzählen? “

Benutzerpfade ausarbeitenIn der Sprache der Programmierer ist Absicht Absicht (englische Absicht). Die Analogie zu klassischen Schnittstellen ist eine formalisierte oder informelle Anfrage. Es ist einfacher, mit Formalisierten zu arbeiten, und das Informelle kann das Leben in einen Albtraum verwandeln.

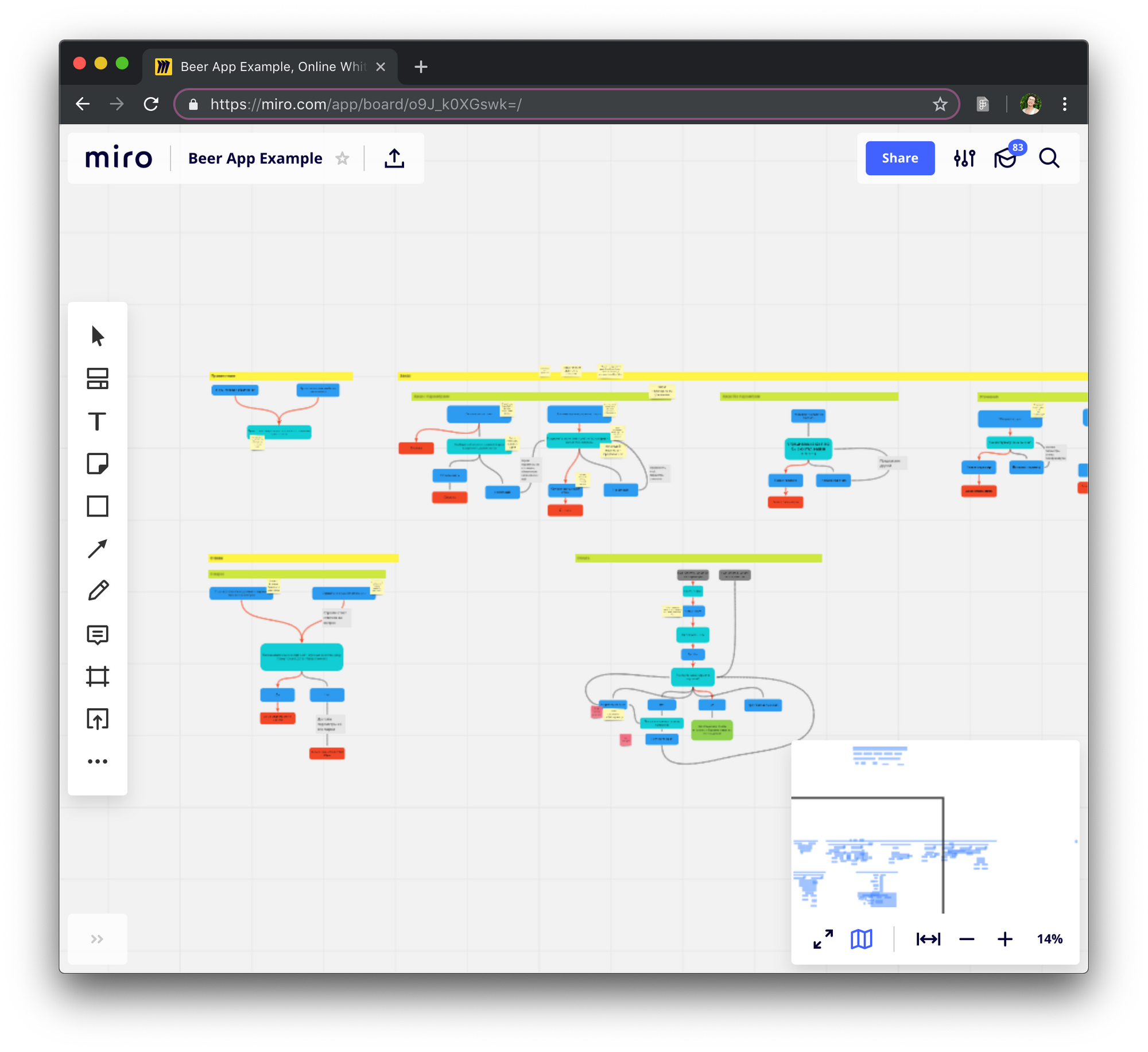

Designer verwenden ein Flussdiagramm, wenn sie mit Benutzerpfaden arbeiten. Ihre Aufgabe ist es, die Logik der Anwendung zu beschreiben. Das Flussdiagramm besteht aus Dialogschritten im Namen des Benutzers und des Systems, manchmal werden logische Elemente hinzugefügt - API-Aufrufe arbeiten mit dem Kontext.

Flussdiagramm in Miro

Flussdiagramm in MiroOft beschreibt das Flussdiagramm die wichtigsten Kreuzungen in der Sprachkompetenz. Einige Designer blockieren jedes Detail der Fertigkeit. Pavel Guy empfiehlt dies nicht, da es sehr schnell nicht mehr lesbar ist und Änderungen viel Zeit in Anspruch nehmen.

Der einfachste Weg, den Pfad des Benutzers zu ermitteln, besteht darin, von Anfang bis Ende mit ihm zu gehen und zu sehen, an welchen Punkten Bedingungen und Abweichungen vom Hauptszenario auftreten.

Navigation erstellenEgal in welchem Schritt sich der Benutzer befindet, er sollte immer die Möglichkeit haben, von vorne zu beginnen, zurück zu gehen, vorwärts zu gehen und variabel zu reagieren. Lassen Sie ihn keine Befehle auswendig lernen.

Ein Beispiel aus dem Leben. Die bereits erwähnte Fähigkeit "Ja, mein Herr" (das Publikum in "Alice" ist 650.000 Menschen, außerdem ist es eines der beliebtesten Spiele für Google Assistant nicht nur in Russland, sondern auch in der Welt) ist ein atmosphärisches Spiel mit Musik anständige Sprachsynthese, interessante Geschichten, Spielmechanik. Zu Beginn konnte er das Spiel nur mit Hilfe von „Ja“, „Nein“ und „Genug“ steuern. In der Geschichte gerät der Spieler - mein Herr, der Landbesitzer und die Bauern - in die Situation "Eure Gnade! In unseren fruchtbaren Ländern wurden große Kupfervorkommen gefunden! Bitte fang an, eine Mine zu bauen. “ Es wäre möglich, einfach mit Ja zu antworten, aber ich möchte mich an die Rolle gewöhnen und sprechen, wie es sich für eine hochkarätige Person gehört.

- Deine Gnade! In unseren fruchtbaren Ländern wurden große Kupfervorkommen gefunden! Bitte fangen Sie an, eine Mine zu bauen.

- Liebe!

Der VUI-Designer entdeckte diesen Punkt und trainierte die Fähigkeit, Benutzer besser zu verstehen, um ihnen mehr Freiheit bei der Beantwortung zu geben.

Schreiben Sie Beispiele für Dialoge und gestalten Sie die Antworten des Bots vielfältigerMeine Kollegen von Just AI schreiben Dialogbeispiele in Tabellen. Sie sind so viel bequemer, aber dies ist bei weitem nicht die bequemste Option - sowohl die Logik als auch mögliche Übergänge zu beschreiben. Jemand schreibt Skripte in Word. Es gibt kein einheitliches Format und keine einheitliche Regelung für die Beschreibung.

Benutzer sind sehr verärgert, wenn der Assistent beginnt, sich zu wiederholen. Die Hypothese wird von Nelly Kamaeva, Designerin Alan AI, bestätigt. Während eines Fähigkeitstests für Kinder sah sie, wie schnell die Jungs das Interesse verloren, wenn sie mit der gleichen Antwort konfrontiert wurden.

Es lohnt sich, mehrere Replikate in Betracht zu ziehen, die synonym sind und die der Benutzer hört, wenn er denselben Schritt im Skript erreicht. VUI-Designer empfehlen die Verwendung von drei bis zehn Variationen einer einzelnen Phrase.

Suchen Sie im Papierkorb nach nicht erkannten Absichten

"Papierkorb" oder Sammelbegriff in der Sprache der Programmierer ist der Ort, an dem Benutzerphrasen aus verschiedenen Gründen fallen.

"Mit wem spreche ich?" Bist du ein Roboter ?!

"Du hast mich durchgebracht." Möchten Sie weiter chatten?

Der Satz "Ich spreche überhaupt mit jemandem?" Bist du ein Roboter ?! " wird in den Sammelbegriff fallen (wenn Sie ihm kein Skript zur Verfügung gestellt haben). „Du hast mich durchgebracht. Möchten Sie die Kommunikation fortsetzen? “ - Standardreplik in solchen Situationen. Überlegen Sie sich im Voraus, wie Sie einem Benutzer helfen können, der beim Catch-All versagt.

Denken Sie an Stimme und CharakterErinnern Sie sich an die Gesprächspartner, die Sie gelangweilt haben. Es ist nicht interessant für sie, die Zurückhaltung, das Gespräch fortzusetzen, nennen wir sie langweilig. Das gleiche passiert im Umgang mit Fähigkeiten. Alice, Alexa und Google Assistant haben ein eigenes Speech Toolkit mit einer Vielzahl von Männer- und Frauenstimmen, Akzenten und Soundeffekten, um die Sprache des Bots wie Husten und Schnüffeln zu beleben.

Wenn Sie den Benutzer beeindrucken und in das Gespräch einbeziehen möchten, basteln Sie am Sprachstil und arbeiten Sie an der Synthese: Ordnen Sie Stress, Pausen und Intonationen an. Das ist mühsame Arbeit, aber glauben Sie mir, das Ergebnis ist es wert. In einem internen Workshop hat ein Kollege eine Fähigkeit für Alexa entwickelt - hören Sie sich das Fragment an:

- Hey, Mann. Schreckliches Wetter, ja? Willst du dich betrinken? Lassen Sie sich von Ihrem alten Freund Joe ein gutes irisches Getränk mixen. Ok

- Und jetzt, wenn du dich besser fühlst, nimm deinen effing Arsch und geh in die Kneipe von Joe. Dort wirst du niemals alleine trinken. Ich warte auf dich.

Eine andere Möglichkeit, mit Sprache zu arbeiten, besteht darin, Audio mit professionellen Schauspielern aufzunehmen. Für eine lange, teure, Flexibilität geht verloren, wenn Sie dem Skript etwas hinzufügen möchten, aber spektakulär. Die Fähigkeit kann mit den Stimmen von Prominenten, Politikern und Helden aus Filmen sprechen (nun, Sie konnten bereits unsere

Stimme für das Spiel Lovecraft World hören , aber Google Assistant spricht mit der Stimme des Grammy-Preisträgers John Legend -

tyk ).

Für einen der Business Cases haben wir auch Sprachaufnahmen von professionellen Schauspielern verwendet. Nur 0,5% der Kunden konnten vermuten (nicht einmal erraten, aber vermuten), dass der Bot mit ihnen sprach.

Verwenden Sie Sounds und Illustrationen, um eine Atmosphäre zu schaffen.

Sie können Sounds aus vorgefertigten Bibliotheken abrufen oder eigene erstellen (Alexa ist wählerisch in Bezug auf Dateierweiterungen, daher müssen Sie an der Konvertierung basteln). Im selben Spiel, "Ja, mein Herr", für "Alice", werden Geräusche verwendet, um eine Atmosphäre zu schaffen: Wiehern eines Pferdes, Murmeln einer Menge, ein bedrohliches Lachen, ein Dudelsack. Und kürzlich erschien in „Alice“ die Fertigkeit „Birds of Russia“, in der Sie in einem Gespräch hören können, wie eine Lerche, ein Spatz oder andere Vögel singen und zwitschern.

Das Design der Sprachschnittstelle ist nicht auf Flussdiagramme und trockenen Text beschränkt. Der Designer hat alles, um Fähigkeiten zu entwickeln, die den Benutzer in den Prozess einbeziehen.

Und noch mehr Tipps von VUI-Designern

Lehren Sie die Schnittstelle nicht. Sprache ist eine vertraute und intuitive Oberfläche. Keine Notwendigkeit, einer Person das Sprechen beizubringen. Er weiß wie.

Schlecht - "Um die Nachricht erneut anzuhören, sagen Sie" Nochmals anhören ". Um zur nächsten Nachricht zu gelangen, sagen Sie "Zur nächsten Nachricht gehen".

Gut - "Hören Sie die Nachricht noch einmal oder fahren Sie mit der nächsten fort?"

Stellen Sie geschlossene Fragen . Ich empfehle, offene Fragen und das offene Ende der Bot-Aussagen zu vermeiden. Der Benutzer sollte zum Handeln aufgefordert werden.

Schlecht - „Hallo! Ich bin Symphony, ein Musikliebhaber. Gerne empfehle ich Ihnen ein Album und erzähle Ihnen davon. "

Gut - "Hallo! Ich bin Symphony, ein Musikliebhaber. Ich werde Ihnen gerne ein Album empfehlen und Ihnen davon erzählen. Möchten Sie mehr über die Strecke des Tages erfahren? “

Vermeiden Sie Klerikalismus. Eine offensichtliche Empfehlung, der nur wenige Menschen folgen. Keiner von uns möchte einen komplexen und überladenen Text lesen, und das Hören ist umso unerträglicher.

Schlecht - "Es ist wichtig zu bedenken, dass die weiteren Alben dieses Künstlers mit Platin ausgezeichnet werden, was uns zu dem Schluss führt, dass dieses Debütalbum erfolgreich ist, um effektiv in die internationale Arena einzutreten."

Gut - „Das Debütalbum zog die Aufmerksamkeit der ganzen Welt auf den Künstler. Nicht ohne Grund wurden seine nächsten Platten zweimal mit Platin ausgezeichnet! “

Testen und Training

Testen Sie die Fähigkeit in Stille, auf der Straße, in einem lauten Raum, sprechen Sie mit unterschiedlichen Intonationen und mit unterschiedlichen Geschwindigkeiten. Selbst an der ruhigsten Stelle kann etwas schief gehen. Vielleicht wird der Testprozess einigen langweilig erscheinen, aber ich versichere Ihnen, dass dies nicht der Fall ist. Geschicklichkeit braucht einen echten Crashtest!

Aus persönlicher Erfahrung. In einem der Workshops entwarf ich eine Fitness-Fähigkeit: Nach der Idee gab Alexa zuerst Anweisungen, dann wurde die Musik eingeschaltet und die Person wiederholte die Übung. Ich habe alles mit Begeisterung an mir selbst getestet: Ich bin gesprungen und zur gehackten Musik gelaufen, habe die Länge der Tracks geändert, die Übungen viele Male wiederholt und letztendlich hat mich die UX-Fähigkeit zufrieden gestellt.

Provozieren und schwören

Benutzer sind Provokateure. Sie werden die Reaktion der Fertigkeit außerhalb des Themas überprüfen: Die Fertigkeit zum Bestellen von Pizza, und der Benutzer - es scheint sehr gerissen - wird nach Sushi fragen. Überlegen Sie sich eine anständige Antwort. Und verfluche dein Herz. Ich meine es ernst! Nur AI hat eine Checkliste für die beim Testen verwendete Matte.

Sprechen und hören

Sagen Sie alles, was Sie sich einfallen lassen. Hören Sie mit Ihren Ohren auf alles, was der Benutzer hören wird. Bitten Sie die Kollegen, das Drehbuch zu lesen und sogar abzuspielen. Sprache aufnehmen, zu Aufnahmen zurückkehren, experimentieren.

Fertigkeit trainieren

Aber das erste Mal sehen Sie nicht alles in der Fähigkeit voraus. Akzeptiere es und demütige dich. Ihre Fähigkeiten erfordern eine weitere Ausbildung. Dialoge lesen und Protokolle analysieren. Wie das mit Python in einer der Ausgaben von Alice's School geht, sagt Daria Serdyuk, NLP-Forschungsingenieurin Just AI.

Designer-Tools

Papier, Bleistift oder Markierungstafel - es wurde nichts Besseres erfunden, um mit der Arbeit zu beginnen oder einem Team oder Kunden schnell eine Idee zu vermitteln. Es gibt jedoch fortschrittlichere Tools, die das Berufsleben des Sprachschnittstellendesigners vereinfachen und zur Umsetzung der Idee beitragen.

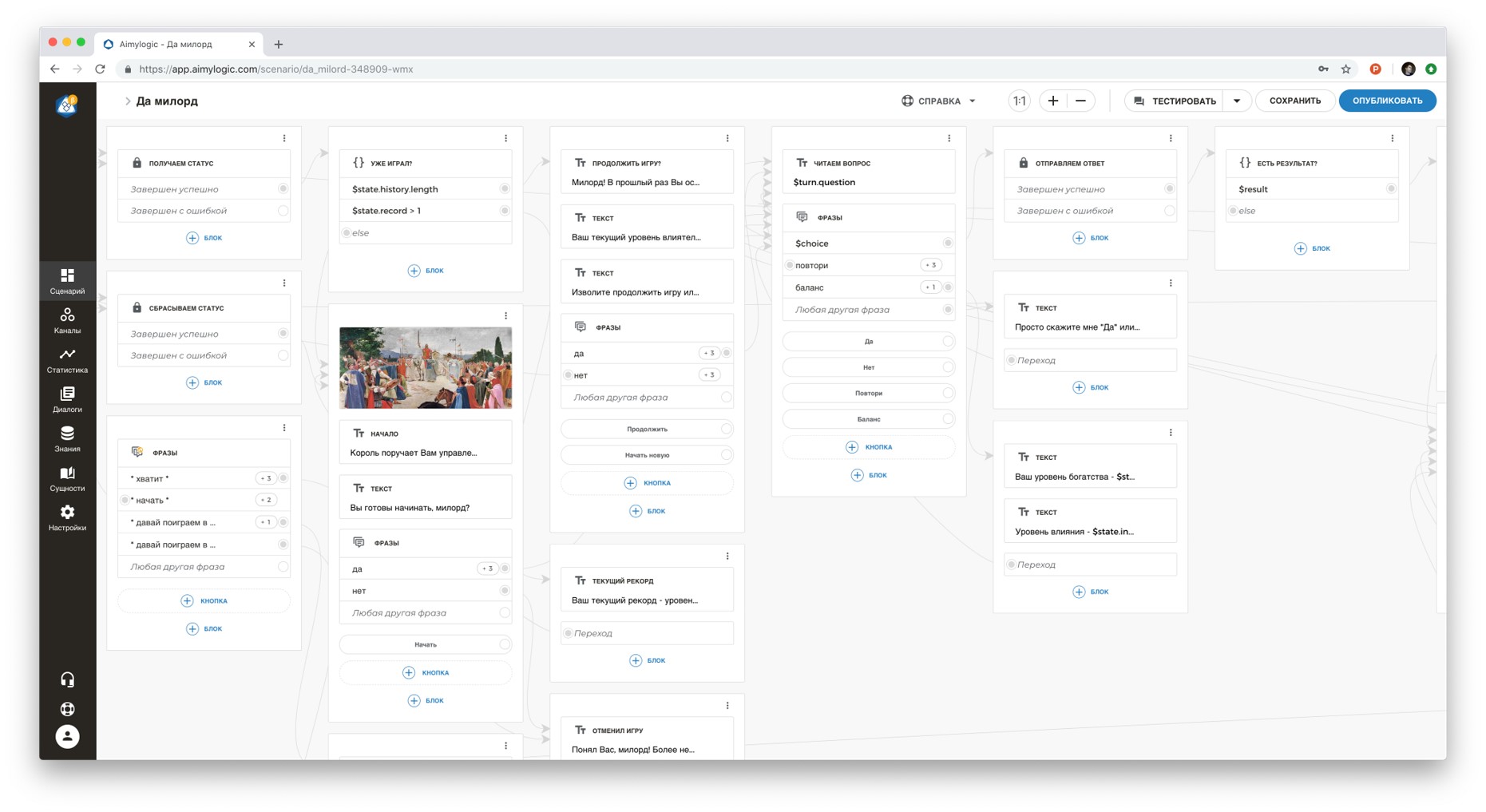

AimylogicKonstruktor mit einer NLU-Engine (Verständnis der natürlichen Sprache). Mehr als 10.000 Benutzer und mehr als 1100 Fähigkeiten für Sprachassistenten mit einem Gesamtpublikum von 1 Million Benutzern. Es gibt ein kostenloses Abonnement und eine kostenlose Demo-Frist für kostenpflichtige Abonnements.

Im Designer können Sie ein Skript erstellen, testen und mit mehr als zehn Kanälen verbinden (Alice, Google Assistant, Telegramm, VKontakte und andere). Es gibt technischen Support und eine Community in Telegram. Hier einige Beispiele für Sprachfähigkeiten:

Tortu.ioTool für Rapid Prototyping. Sie bauen buchstäblich in einem Blockdiagramm einen Dialog zwischen dem Benutzer und dem System auf und testen ihn dann anhand eines Prototyps. Geeignet für WoZ-Tests und schnelle Hypothesentests.

SprachflussGrafikdesignerin Alexa Skills. Ermöglicht das Erstellen von Alexa-Fähigkeiten ohne Programmierkenntnisse. Geeignet für UX-Tests.

Flow.aiGrafiktool zum Erstellen von Chatbots. Ermöglicht das Erstellen von Bots ohne Programmierkenntnisse. Auch für UX-Tests geeignet.

Materialien zum Pumpen

Die Psychologie und die tatsächlichen Erfahrungen der Benutzer von Sprachassistenten unterscheiden sich erheblich von denen, die wir im Web oder in der mobilen Umgebung gewohnt sind. Das Sprachdesign ist jedoch interessant, da es sich um ein neues und noch wenig erforschtes Gebiet handelt, in dem viele Entdeckungen und Durchbrüche erzielt werden können.Die im Artikel erwähnten Erfahrungen und Materialien der VUI-Designer wurden mit deren Zustimmung verwendet.

Danksagung:

Dmitry Chechetkin , Mitbegründer und Leiter strategischer Projekte, Just AI.Daria Serdyuk , NLP-Forschungsingenieurin, Just AI.Paul Gwai , Gründer von Tortu.io.Nelly Kamaeva , Produktdesignerin, Alan AI.