Ende letzten Jahres erhielten wir nach einem Vertrag mit Rostelecom eine Cloud-basierte SD-WAN / SDN-Plattform zur Bereitstellung von IB-Diensten für Kunden. Wir haben uns mit den Projektanbietern verbunden, die ihre Lösungen in virtualisierter Form bereitstellen, und wir haben einen riesigen Koloss erhalten, den wir als Unified Cybersecurity Services Platform (EPSC) bezeichnet haben. Das Hauptmerkmal ist die Bereitstellung von Sicherheitstechnologien aus der Cloud mit der Möglichkeit einer zentralen Verwaltung: Die Bereitstellung und Änderung einer einzelnen Netzwerkfunktion oder die globale Transformation in allen bedienten Büros dauert nur wenige Minuten. Heute werden wir Ihnen mehr über die Architektur und das „Füllen“ erzählen.

Aber bevor Sie unter die Haube kommen, noch ein paar Worte darüber, was der EPSC tatsächlich weiß. Die Plattform umfasst Dienste: E-Mail-Schutz (Secure Email Gateway, SEG) und Webanwendungen (Web Application Firewall, WAF), Verhinderung von Netzwerkeinbrüchen (Unified Threat Management, UTM) und Anti-DDoS. Alle von ihnen können gleichzeitig und getrennt verwendet werden - hier für jeden nach seinen Bedürfnissen.

Wickeln Sie mich bitte mit Verkehr ein. Arbeitsprinzipien

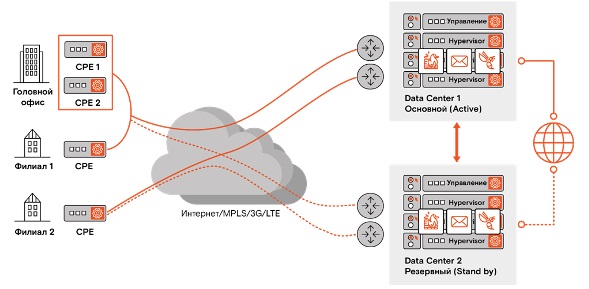

Im Allgemeinen: CPE-Routing-Geräte (Customer Premises Equipment) werden an allen Kundenstandorten installiert. CPE bietet einen sicheren Tunnel zu unseren Rechenzentren - zur EPSC-Plattform. Somit gelangt nur der Verkehr, der auf unserer Perimeter-Sicherheitsausrüstung gelöscht wurde, zum Kunden. Gleichzeitig hängt der Prozess der Bereitstellung von Datenverkehr auf unserer Plattform dank SD-WAN und Tunneling nicht vom Netzwerk des Anbieters ab, den der Kunde verwendet.

Plattformarchitektur

Die physische Infrastruktur des EPSC besteht aus normalen x86-Servern mit darauf bereitgestellten virtuellen Maschinen, Switches und Routern. Der Punkt ist, dass Sie diesen Reichtum flexibel und zentral verwalten können. Und hier helfen uns zwei magische Worte - VNF und MANO.

VNF (Virtualized Network Function) sind Netzwerkfunktionen, die Endbenutzern (UTM, SEG und WAF) zur Verfügung gestellt werden. MANO (Management and Orchestration) - eine Reihe von Tools zur Verwaltung des Lebenszyklus virtualisierter Funktionen. Diese Tools bieten nur diese Zentralisierung und flexible Orchestrierung, sodass Sie Änderungen mit einer grundlegend anderen Geschwindigkeit vornehmen können.

Und jetzt im Detail.

Am Rand jedes Rechenzentrums befindet sich ein Nokia 7750 SR-12-Router mit einem Durchsatz von 400 Gbit / s, der Routing am Umfang und in der Cloud ermöglicht. Auf einer niedrigeren Ebene befinden sich Juniper 5100 Spine Switches mit 40-Gbit / s-Ports, die alle Netzwerkkomponenten aus niedrigeren Schichten zusammenfassen.

Ein virtuelles Netzwerk umfasst zwei Segmente: SD-WAN, das die Cloud-Umgebung mit Kundenstandorten verbindet, und SDN DC, ein softwaredefiniertes Netzwerk in der Cloud selbst, über das Ports, IP-Adressen usw. konfiguriert werden. beim Erstellen einer Servicekette.

Der Serverteil besteht aus CloudBand-Cloud-Plattform-Verwaltungsservern, SDN-Verwaltungsservern, SD-WAN- (VSD, VSC) und NSG-BR-Verwaltungsservern (virtuelle Router, die IPsec über VXLAN-Kundentunnel beenden) oder VXLAN, je nachdem ob IPSec-Verschlüsselung.

Die weiße IP-Adressierung für den Kundenverkehr wird auf der Basis von 2 Subnetzen mit einer / 22-Maske (1018 Adressen in jedem Subnetz) implementiert: Eine davon wird an das Internet weitergeleitet, die andere an RSNet.

Fehlertoleranz

Die gesamte Cloud-Infrastruktur ist auf der Grundlage von zwei geografisch entfernten Rechenzentren in Moskau reserviert, die im Aktiv-Standby-Modus arbeiten. Darüber hinaus wird jede Servicekette (eine Reihe von Funktionen für einen bestimmten Client) in jedem von ihnen als Cluster bereitgestellt. Im Notfall gehen beim Wechsel von einem Knoten zu einem anderen nur etwa 10 Pakete verloren. Da dumme Leute sich TCP ausgedacht haben, wird der Verlust nicht spürbar sein.

In Zukunft planen wir eine geografische Expansion über den Ural hinaus, um die Verzögerungen bei der Datenübertragung für die Regionen zu verringern. Selbst für Chabarowsk beträgt die Verzögerung heute jedoch nur etwa 200 ms - Kunden spielen recht erfolgreich auf Steam und sehen sich Videos von YouTube an (aus einer echten Bewertung des Dienstes ).

In naher Zukunft wird es möglich sein, ein CPE mit zwei unabhängigen WANs zu verbinden. Der Kanal kann MPLS, Ethernet (Kupfer oder Optik, je nach verwendetem CPE), USB-LTE-Modem usw. sein. Zum Beispiel kann der Hauptkanal Glasfaser sein, und der Backup-Kanal kann drahtlos sein (weil niemand gegen den Bagger des Schicksals und beschädigter Drähte immun ist). Derzeit ist es möglich, zwei WANs zu verwenden, jedoch nur, wenn zwei CPEs in einem HA-Cluster verwendet werden.

Serviceketten

Der Kunde wählt die grundlegenden Parameter über den LC aus und beginnt mit der Bildung der Servicekette: Abhängig von der ausgewählten Bandbreite werden die Netzwerkschnittstellen automatisch angehoben, IP-Adressen zugewiesen und VNF-Bilder gepumpt. Wenn Sie beispielsweise FortiGate Firewall für 300 Mbit bestellt haben, werden Ihnen automatisch 4 Kerne, 8 GB RAM, eine bestimmte Menge an Speicherplatz zugewiesen und das Image wird automatisch in einer 0-Tage-Konfiguration bereitgestellt.

Die Leistung unserer Plattform ist jetzt für 160 Serviceketten mit jeweils 1 Gbit ausgelegt. Es ist geplant, bis zu 1000 Serviceketten mit jeweils 50 Mbit zu skalieren (da 1-Gbit-Ketten nach unserer Markteinschätzung weniger beliebt sein werden).

CPE - besser dünner, ja mehr?

Tatsächlich haben wir für unseren Service „dünne“ CPEs ausgewählt, die auf Nokia NSG-C und NSG-E200 basieren. Sie sind nur deshalb subtil, weil sie keine VNFs von Drittanbietern ausführen können. Andernfalls verfügen sie über alle Funktionen, die zum Aufbau der Kommunikation zwischen Standorten und zum Tunneln (IPSec und VPN) erforderlich sind. Für diese Aufgabe können jedoch Lösungen anderer Hersteller verwendet werden. Es gibt auch Zugriffssteuerungslisten (Access Control Lists, ACLs) zum Filtern: Ein Teil des Datenverkehrs kann lokal freigegeben und ein anderer Teil zur Feinbereinigung an das EPSC-Rechenzentrum gesendet werden, wo die virtuellen Funktionen WAF, UTM und SEG implementiert sind.

Das Gerät kann auch Application Aware Routing (AAR) ausführen, d. H. Priorisieren Sie die Bandbreite abhängig von der Art des Datenverkehrs mithilfe von DPI-Mechanismen (Deep Packet Inspection). Gleichzeitig können sowohl Festnetz- als auch Mobilfunknetze oder deren Kombination für unterschiedlichen Verkehr als Kommunikationskanäle verwendet werden.

Die CPE-Aktivierung basiert auf dem Prinzip der Zero-Touch-Bereitstellung. Das heißt, alles ist elementar: Wir verbinden das CPE mit dem Internet, wir verbinden einen Laptop über die interne Ethernet-Schnittstelle, klicken auf den Aktivierungslink und schalten dann unser LAN anstelle des Laptops ein und alles funktioniert. Darüber hinaus steigt in unserer Cloud der IPSec-Tunnel über VXLAN standardmäßig an (dh der Adressraum wird zuerst isoliert und dann getunnelt).

Im Allgemeinen erscheint uns die Option mit einem dünnen CPE bequemer. Mit diesem Ansatz wird der Kunde von einer möglichen Lieferantenverriegelung verschont und kann die Lösung jederzeit skalieren, ohne an die Dicke des CPE (50 Mbit / s) zu stoßen.

Bei einem Thick-CPE werden unter anderem auch die vom Client ausgewählten virtuellen Funktionen implementiert, und im EPCC-Rechenzentrum gibt es nur Service Chain Management. Der Vorteil dieses Ansatzes besteht darin, dass der gesamte Datenverkehr lokal verarbeitet wird. Gleichzeitig sind die Kosten für ein solches Gerät viel höher und Sie können nicht mehr als einen bestimmten Dienst darauf ausführen. Sie müssen zusätzliche CPEs erwerben. Ja, und Sie können Multi-Vendor vergessen.

Wenn der Kunde jedoch über eine ziemlich große Plattform (Büro, Zweigstelle) verfügt, die viel Verkehr durch sich selbst leitet (mehr als 200 Mbit / s) und alles lokal filtern möchte, ist es sinnvoll, auf die Nokia CPE NSG E300-Serie (und höher) zu achten. C. Bandbreite von 1 bis 10 Gbit / s, die Virtualisierung (VNF) unterstützt.

Standardmäßig bringt SD-WAN alle Standorte des Kunden in ein vollständiges Mesh-Netzwerk, dh, es verbindet sie ohne zusätzliche Filterung einzeln. Dies reduziert Verzögerungen im Innenumfang. Es ist jedoch möglich, komplexere Topologien (Stern, komplexer Stern, Gitter mit mehreren Rängen usw.) zu erstellen.

Bedienung

Alle VNFs, die sich in der Cloud befinden, sind derzeit in der klassischen MSSP-Doktrin verfügbar, dh sie unterliegen unserer Kontrolle. In Zukunft haben Kunden die Möglichkeit, diese Services unabhängig zu verwalten. Es ist jedoch wichtig, ihre Kompetenzen sinnvoll zu bewerten.

Einige einfache Funktionen sind jetzt teilweise automatisiert. In Secure Mail Gateway ist beispielsweise standardmäßig eine Richtlinie konfiguriert, in der der Benutzer einmal täglich eine Liste von Nachrichten erhält, die möglicherweise mit Spam zusammenhängen, und selbst über sein Schicksal entscheiden kann.

Einige globale Probleme und Schwachstellen, die von unserem JSOC überwacht werden, werden schnell geschlossen, auch für die Kunden des EPSC. Und hier ist die Möglichkeit einer zentralen Verwaltung von Richtlinien und Signaturen genau das, was wir brauchen - dies schützt Kunden vor Infektionen wie Petya, NotPetya und anderen.

Ehrliche Antworten auf unangenehme Fragen

Obwohl wir sehr an die Vorteile des Servicemodells glauben, ist es klar, dass das Konzept des E-Mail-Systems für viele zu ungewöhnlich ist. Was wir am häufigsten gefragt werden:

- FortiGate befindet sich in Ihrem Rechenzentrum. Sehen Sie also unseren Datenverkehr?- Nein, wir sehen keinen Verkehr. FortiGate empfängt es in verschlüsselter Form, entschlüsselt es mit dem Schlüssel des Kunden, überprüft und verarbeitet es mit einem Stream-Antivirus, verschlüsselt es mit demselben Schlüssel zurück und sendet es erst dann an Ihr Netzwerk. Wir haben keine Optionen, um uns in diesem Prozess zu verkeilen (es sei denn, wir führen ein Reverse Engineering von harten Infobase-Lösungen durch, aber es ist zu teuer ).

- Ist es möglich, unsere Netzwerksegmentierung beim Wechsel in die Cloud zu speichern?- Und hier gibt es eine Einschränkung. Netzwerksegmentierung ist keine trübe Geschichte. UTM ist eine Grenzfirewall des Kundennetzwerks, in der keine Segmentierung möglich ist, dh Ihre Daten werden in einem einzigen Kanal nach außen übertragen. In gewisser Weise können Sie das Netzwerk innerhalb der ACL auf dem CPE segmentieren, indem Sie unterschiedliche Einschränkungen für verschiedene Standorte festlegen. Wenn Sie jedoch Geschäftsanwendungen haben, die über die Firewall unterschiedlich miteinander interagieren müssen, müssen Sie für die interne Segmentierung weiterhin eine separate FW verwenden.

- Was passiert mit unseren IP-Adressen beim Wechsel in die Cloud?- In den meisten Fällen müssen Sie Ihre weißen IP-Adressen in unsere ändern. Eine Ausnahme ist möglich, wenn Ihnen ein vom Anbieter nicht unabhängiges autonomes System (PI AS) zugewiesen ist, das von uns erneut angekündigt werden kann.

Manchmal ist es logischer, eine komplexe Option zu wählen. Lassen Sie beispielsweise den Benutzerverkehr über UTM und geben Sie andere Netzwerksegmente direkt ins Internet frei.

- Und wenn Sie eine Site schützen müssen, die von einem externen Anbieter gehostet wird?- CPE nicht dort setzen. Sie können WAF verbinden, indem Sie den ADNS-Datensatz ändern: Ändern Sie die IP-Adresse der Site in die IP-Adresse der Servicekette. Anschließend wird der Datenverkehr ohne CPE durch unsere Cloud geleitet.

Wenn Sie weitere Fragen haben, schreiben Sie diese in die Kommentare, und wir werden versuchen, sie zu beantworten