Die Mission von Microsoft ist es, jeder Person und Organisation auf dem Planeten die Möglichkeit zu geben, mehr zu erreichen. Die Medienbranche ist ein hervorragendes Beispiel für die Umsetzung dieser Mission in die Realität. Wir leben in einer Zeit, in der immer mehr Inhalte erstellt und konsumiert werden, alles auf großartige Weise und auf mehr Geräten. Auf der IBC 2019 haben wir die neuesten Innovationen vorgestellt, an denen wir gerade arbeiten, und darüber gesprochen, wie sie zur Transformation Ihres Medienprozesses beitragen können.

Details unter dem Schnitt!

Diese Seite befindet sich auf

unserer Website.Video Indexer bietet Unterstützung für Animationen und mehrsprachige Inhalte

Letztes Jahr haben wir auf der IBC unseren preisgekrönten

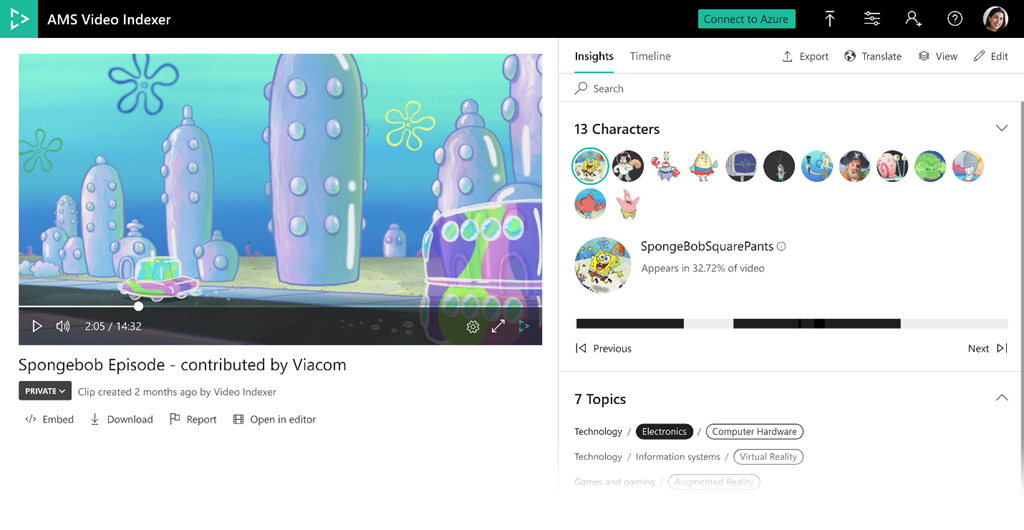

Azure Media Services-Videoindexer veröffentlicht , und dieses Jahr wurde er noch besser. Der Video-Indexer extrahiert automatisch Informationen und Metadaten aus Mediendateien wie gesprochenen Wörtern, Gesichtern, Emotionen, Themen und Marken, und Sie müssen kein Experte für maschinelles Lernen sein, um sie zu verwenden.

Unsere neuesten Angebote umfassen vorläufige Versionen von zwei sehr beliebten und differenzierten Funktionen - Erkennung von animierten Zeichen und Transkription mehrsprachiger Sprache sowie mehrere Ergänzungen zu bestehenden Modellen, die heute im Video Indexer verfügbar sind.

Erkennung von animierten Charakteren

Zeichentrickfilme sind eine der beliebtesten Arten von Inhalten, aber Standard-Bildverarbeitungsmodelle, die zum Erkennen menschlicher Gesichter erstellt wurden, funktionieren nicht sehr gut damit, insbesondere wenn der Inhalt Zeichen ohne menschliche Merkmale enthält. In der neuen Vorschau-Version ist Video Indexer in den Azure Custom Vision-Dienst von Microsoft integriert. Dadurch werden neue Modelle erstellt, die animierte Zeichen automatisch erkennen und gruppieren und das Kennzeichnen und Erkennen mithilfe integrierter benutzerdefinierter Bildverarbeitungsmodelle vereinfachen.

Die Modelle sind in einem einzigen Förderband integriert, sodass jeder diesen Service ohne Kenntnisse im Bereich des maschinellen Lernens nutzen kann. Die Ergebnisse sind über das Video Indexer-Portal verfügbar, für das kein Code erforderlich ist, oder über die REST-API für die schnelle Integration in Ihre eigenen Anwendungen.

Wir haben diese Modelle für die Arbeit mit animierten Charakteren zusammen mit einigen Verbrauchern erstellt, die echte animierte Inhalte für Schulungen und Tests bereitgestellt haben. Der Wert der neuen Funktionalität wurde von Andy Gutteridge, Senior Director für Studiotechnologie und Postproduktion von Viacom International Media Networks, der einer der Datenanbieter war, gut beschrieben: „Durch Hinzufügen einer robusten AI-basierten Funktion zur Erkennung animierter Inhalte können wir schnell und effizient Zeichenmetadaten aus unserer Bibliothek finden und katalogisieren Inhalt.

Vor allem wird es unseren Kreativteams die Möglichkeit geben, sofort die richtigen Inhalte zu finden, den Zeitaufwand für die Verwaltung der Medien zu minimieren und uns auf die Kreativität zu konzentrieren. “

Sie können die Erkennung animierter Zeichen auf der

Dokumentationsseite untersuchen .

Identifizierung und Transkription von Inhalten in mehreren Sprachen

Einige Medienressourcen wie Nachrichten, Ereignischroniken und Interviews enthalten Aufzeichnungen von Personen, die verschiedene Sprachen sprechen. Die meisten der vorhandenen Optionen zum Übersetzen von Sprache in Text erfordern eine vorläufige Angabe der Tonerkennungssprache, was das Transkribieren mehrsprachiger Videos erschwert.

Unsere neue Funktion zur automatischen Identifizierung einer gesprochenen Sprache für verschiedene Arten von Inhalten verwendet die Technologie des maschinellen Lernens, um Sprachen in Medienressourcen zu identifizieren. Nach der Erkennung durchläuft jedes Sprachsegment automatisch den Transkriptionsprozess in der entsprechenden Sprache. Anschließend werden alle Segmente zu einer einzigen Transkriptionsdatei zusammengefasst, die aus mehreren Sprachen besteht.

Die resultierende Entschlüsselung ist als Teil der Ausgabe des JSON Video Indexer und in Form von Dateien mit Untertiteln verfügbar. Die Ausgabeentschlüsselung ist auch in Azure Search integriert, sodass Sie sofort nach verschiedenen Sprachsegmenten in Videos suchen können. Darüber hinaus ist bei der Arbeit mit dem Video Indexer-Portal eine mehrsprachige Transkription verfügbar, sodass Sie das Transkript und die identifizierte Sprache nach Zeit anzeigen oder für jede Sprache zu bestimmten Stellen im Video gehen und während der Videowiedergabe eine mehrsprachige Transkription in Form von Signaturen anzeigen können. Sie können den resultierenden Text auch über das Portal und die API in eine der 54 verfügbaren Sprachen übersetzen.

Weitere Informationen zur neuen Funktion zur Erkennung mehrsprachiger Inhalte und ihrer Verwendung im Video-Indexer finden Sie

in der Dokumentation .

Zusätzliche aktualisierte und verbesserte Modelle

Wir fügen dem Video-Indexer auch neue Modelle hinzu und verbessern vorhandene, einschließlich der unten beschriebenen.

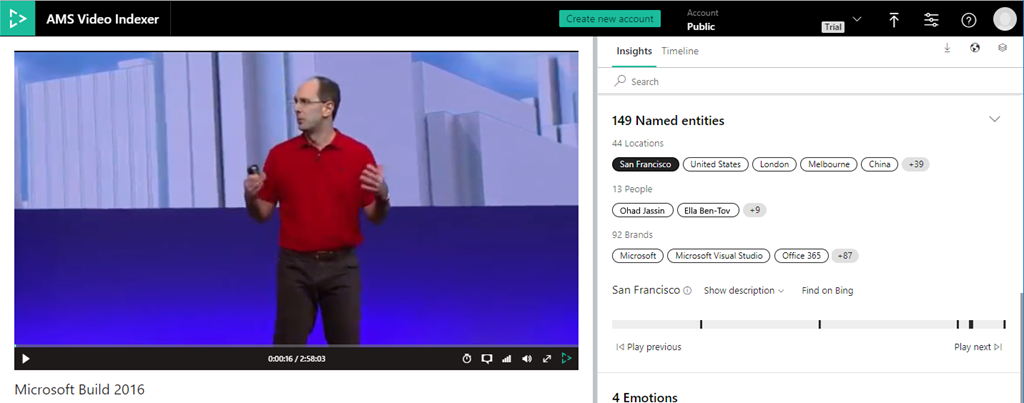

Abrufen von mit Personen und Orten verknüpften Entitäten

Wir haben unsere bestehenden Möglichkeiten zur Markenentdeckung um bekannte Namen und Standorte wie den Eiffelturm in Paris und den Big Ben in London erweitert. Wenn sie in der generierten Entschlüsselung oder mithilfe der optischen Zeichenerkennung (OCR) auf dem Bildschirm angezeigt werden, werden die entsprechenden Informationen hinzugefügt. Mit dieser neuen Funktion können Sie alle Personen, Orte und Marken durchsuchen, die im Video angezeigt werden, und Informationen zu diesen anzeigen, einschließlich Zeitintervallen, Beschreibungen und Links zur Bing-Suchmaschine, um weitere Informationen zu erhalten.

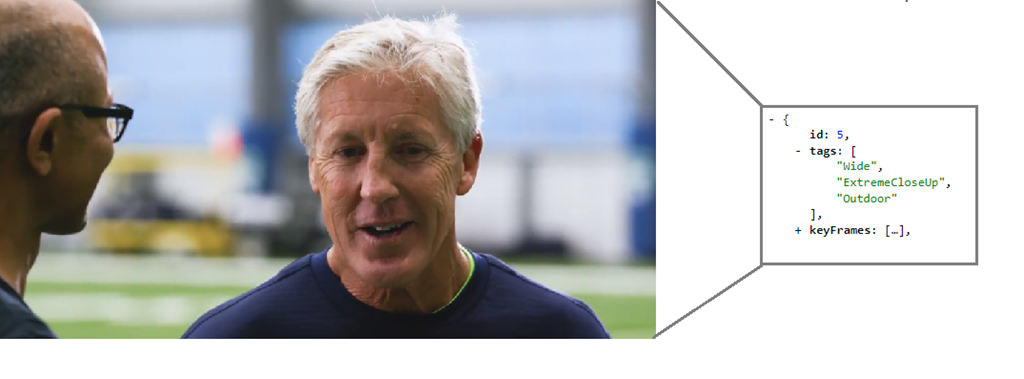

Editor-Erkennungsmodell

Diese neue Funktion fügt den Metadaten, die einzelnen Frames in den JSON-Details zugeordnet sind, eine Reihe von „Tags“ hinzu, um deren redaktionellen Typ darzustellen (z. B. Weitwinkel, mittlerer Frame, Nahaufnahme, sehr Nahaufnahme, zwei Aufnahmen, mehrere Personen, im Freien, drinnen usw.). Diese Rahmentypmerkmale sind nützlich, wenn Sie Videos für Clips und Trailer bearbeiten oder nach einem bestimmten Bildstil für künstlerische Zwecke suchen.

Weitere

Weitere Informationen

zur Frame-Typ-Erkennung finden Sie im Video-Indexer.

Erweiterte IPTC-Zuordnungsdetails

Unser Themenerkennungsmodell identifiziert ein Videothema basierend auf Transkription, optischer Zeichenerkennung (OCR) und entdeckten Prominenten, auch wenn das Thema nicht explizit angegeben ist. Wir ordnen diese entdeckten Themen vier Klassifizierungsbereichen zu: Wikipedia, Bing, IPTC und IAB. Diese Verbesserung ermöglicht es uns, eine IPTC-Klassifizierung der zweiten Ebene aufzunehmen.

Die Nutzung dieser Verbesserungen ist so einfach wie die Neuindizierung Ihrer aktuellen Video Indexer-Bibliothek.

Neue Live-Streaming-Funktionalität

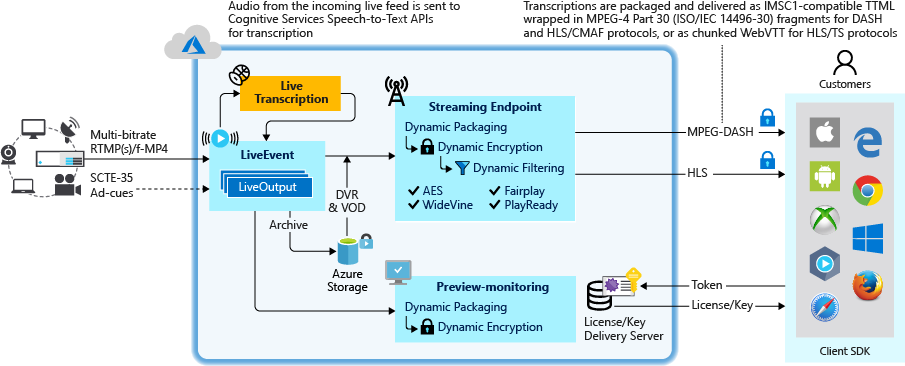

In der Vorschau-Version von Azure Media Services bieten wir außerdem zwei neue Funktionen für das Live-Streaming.

Die Echtzeit-Transkription von KI bringt Live-Übertragungen auf die nächste Stufe

Wenn Sie Azure Media Services für das Live-Streaming verwenden, können Sie jetzt einen Ausgabestream abrufen, der neben Audio- und Videoinhalten auch eine automatisch generierte Textspur enthält. Text wird durch Transkribieren von Echtzeit-Audio basierend auf künstlicher Intelligenz erstellt. Benutzerdefinierte Methoden werden vor und nach der Konvertierung von Sprache in Text angewendet, um die Ergebnisse zu verbessern. Die Textspur ist in IMSC1, TTML oder WebVTT gepackt, je nachdem, ob sie in DASH, HLS CMAF oder HLS TS vorliegt.

Lineare Echtzeitcodierung für 24/7-OTT-Kanäle

Mit unserer API v3 können Sie Kanäle mithilfe der OTT-Technologie (Over-the-Top) erstellen, Live-Übertragungen verwalten und verwalten sowie alle anderen Azure Media Services-Funktionen wie Live-Video-on-Demand (VOD) verwenden. Video on Demand), Verpackung und Digital Rights Management (DRM).

Eine Vorschau dieser Funktionen finden Sie auf

der Community- Seite von

Azure Media Services .

Neue Funktionen zur Paketgenerierung

Sound Track Beschreibung Unterstützung

Inhalte, die auf Sendekanälen ausgestrahlt werden, enthalten häufig eine Audiospur mit verbalen Erklärungen darüber, was zusätzlich zum normalen Audiosignal auf dem Bildschirm geschieht. Dies macht Programme für sehbehinderte Zuschauer zugänglicher, insbesondere wenn der Inhalt hauptsächlich visuell ist. Mit der neuen

Audiobeschreibungsfunktion können Sie eine der Audiospuren als Audiobeschreibungsspur (AD, Audiobeschreibung) mit Anmerkungen versehen, damit die Spieler die AD-Spur für die Zuschauer zugänglich machen können.

Fügen Sie ID3-Metadaten ein

Rundfunkunternehmen verwenden häufig im Video eingebettete zeitbasierte Metadaten, um ein Signal über das Einfügen von Werbung oder benutzergenerierten Metadatenereignissen auf den Player des Kunden zu übertragen. Zusätzlich zu den SCTE-35-Signalisierungsmodi unterstützen wir jetzt auch

ID3v2 und andere vom Anwendungsentwickler definierte

Benutzerschemata zur Verwendung durch die Clientanwendung.

Microsoft Azure-Partner präsentieren End-to-End-Lösungen

Bitmovin führt die Bitmovin-Videokodierung und den Bitmovin-Video-Player für Microsoft Azure ein. Kunden können diese Codierungs- und Wiedergabelösungen jetzt in Azure verwenden und erweiterte Funktionen wie dreistufige Codierung, Unterstützung für AV1 / VC-Codecs, mehrsprachige Untertitel und vorintegrierte Videoanalysen für QoS, Werbung und Video-Tracking verwenden.

Evergent präsentiert seine User Lifecycle Management Platform in Azure. Als führender Anbieter von Managementlösungen für Umsatz und Kundenlebenszyklus nutzt Evergent Azure AI, um Premium-Unterhaltungsanbietern dabei zu helfen, die Kundenbindung und -bindung zu verbessern, indem gezielte Servicepakete und Angebote zu kritischen Zeiten in ihrem Lebenszyklus erstellt werden.

Haivision wird seinen intelligenten Cloud-basierten Multimedia-Routing-Service SRT Hub

vorstellen , mit dem Kunden Workflows mithilfe von

Azure Data Box Edge von Anfang bis Ende transformieren und Workflows mithilfe von Hublets von Avid, Telestream, Wowza, Cinegy und Make.tv transformieren können.

SES hat die Azure-basierte Broadcast Class Media Services Suite für seine satellitenbasierten und verwalteten Mediendienstkunden entwickelt. SES zeigt Lösungen für vollständig verwaltete Wiedergabedienste, einschließlich Master-Wiedergabe, lokalisierter Wiedergabe, Anzeigenerkennung und -ersetzung sowie hochwertiger 24-Stunden-Echtzeit-Mehrkanalcodierung in Azure.

SyncWords stellt in Azure praktische Cloud-Tools und -Technologien zum Erstellen von Signaturen zur Verfügung. Diese Angebote erleichtern Medienunternehmen das automatische Hinzufügen von Untertiteln, auch in einer Fremdsprache, zu den Workflows der Videoverarbeitung in Echtzeit und offline in Azure.

Tata Elxsi , ein internationales Technologiedienstleistungsunternehmen, hat seine OTT SaaS TEPlay-Plattform in Azure Media Services integriert, um OTT-Inhalte aus der Cloud bereitzustellen. Tata Elxsi hat auch die QoE-Lösung von Falcon Eye, die Analyse- und Entscheidungsmetriken bereitstellt, auf Microsoft Azure migriert.

Verizon Media stellt seine Streaming-Plattform als Beta auf Azure zur Verfügung. Verizon Media Platform ist eine OTT-Lösung für Unternehmen, die DRM, Anzeigeneinfügung, personalisierte personalisierte Sitzungen, dynamischen Inhaltsaustausch und Videobereitstellung umfasst. Die Integration vereinfacht Workflows, globale Unterstützung und Skalierbarkeit und bietet Ihnen Zugriff auf eine Reihe einzigartiger Funktionen in Azure.