Unsere Mission bei Microsoft ist es, jeden Menschen und jede Organisation auf dem Planeten zu befähigen, mehr zu erreichen. Die Medienbranche veranschaulicht diese Mission. Wir leben in einer Zeit, in der mehr Inhalte auf mehr Arten und auf mehr Geräten als je zuvor erstellt und konsumiert werden. Auf der IBC 2019 haben wir uns sehr gefreut, Ihnen die neuesten Innovationen vorstellen zu können, an denen wir gearbeitet haben, und wie sie dazu beitragen können, Ihre Medienworkflows zu verändern. Lesen Sie weiter, um mehr zu erfahren.

Dieser Artikel

in unserem Blog .

Video Indexer bietet Unterstützung für Animationen und mehrsprachige Inhalte

Wir haben unseren preisgekrönten

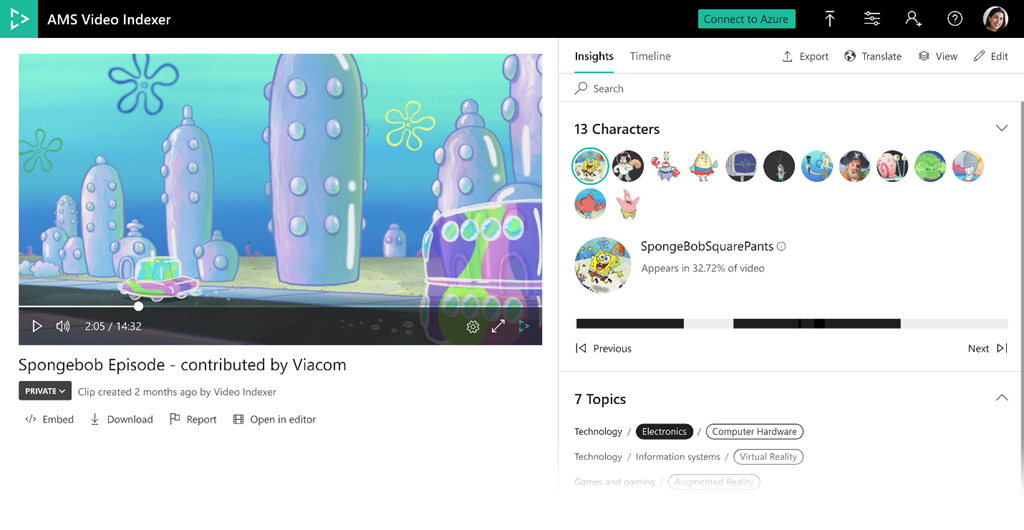

Azure Media Services-Videoindexer letztes Jahr allgemein auf der IBC verfügbar gemacht, und dieses Jahr wird er noch besser. Der Video Indexer extrahiert automatisch Erkenntnisse und Metadaten wie gesprochene Wörter, Gesichter, Emotionen, Themen und Marken aus Mediendateien, ohne dass Sie ein Experte für maschinelles Lernen sein müssen. Unsere neuesten Ankündigungen enthalten eine Vorschau auf zwei sehr gefragte und differenzierte Funktionen zur animierten Zeichenerkennung und mehrsprachigen Sprachtranskription sowie mehrere Ergänzungen zu bestehenden Modellen, die heute in Video Indexer verfügbar sind.

Animierte Zeichenerkennung

Animierte Inhalte oder Cartoons sind einer der beliebtesten Inhaltstypen, aber Standard-AI-Vision-Modelle für menschliche Gesichter funktionieren nicht gut mit ihnen, insbesondere wenn der Inhalt Zeichen ohne menschliche Merkmale enthält. In dieser neuen Vorschau-Lösung arbeitet Video Indexer mit dem Azure Custom Vision-Dienst von Microsoft zusammen, um eine neue Reihe von Modellen bereitzustellen, die animierte Zeichen automatisch erkennen und gruppieren und es Kunden ermöglichen, sie über integrierte benutzerdefinierte Vision-Modelle einfach zu kennzeichnen und zu erkennen. Diese Modelle sind in eine einzige Pipeline integriert, sodass jeder den Dienst ohne vorherige maschinelle Lernfähigkeiten nutzen kann. Die Ergebnisse sind über das No-Code-Video-Indexer-Portal oder die REST-API für die einfache Integration in Ihre eigenen Anwendungen verfügbar.

Wir haben diese animierten Charaktermodelle in Zusammenarbeit mit ausgewählten Kunden erstellt, die echte animierte Inhalte für Schulungen und Tests beigesteuert haben. Der Wert der neuen Funktionalität wird von Andy Gutteridge, Senior Director, Studio- und Postproduktionstechnologie bei Viacom International Media Networks, gut ausgedrückt. Er war einer der Datenverantwortlichen: "Die Hinzufügung einer zuverlässigen AI-basierten animierten Erkennung wird es uns ermöglichen Entdecken und katalogisieren Sie schnell und effizient Zeichenmetadaten aus unserer Inhaltsbibliothek. Am wichtigsten ist, dass unsere Kreativteams die Möglichkeit haben, die gewünschten Inhalte sofort zu finden, den Zeitaufwand für das Medienmanagement zu minimieren und sich auf das Creative zu konzentrieren. “

Um mit der Erkennung animierter Zeichen zu beginnen,

besuchen Sie bitte

unsere Dokumentationsseite .

Mehrsprachige Identifizierung und Transkription

Einige Medienelemente wie Nachrichten, aktuelle Angelegenheiten und Interviews enthalten Audio mit Sprechern in verschiedenen Sprachen. Für die meisten vorhandenen Sprach-Text-Funktionen muss die Audioerkennungssprache im Voraus festgelegt werden. Dies ist ein Hindernis für die Transkription mehrsprachiger Videos. Unsere neue automatische Identifizierung gesprochener Sprachen für mehrere Inhalte nutzt die Technologie des maschinellen Lernens, um die verschiedenen Sprachen zu identifizieren, die in einem Medienobjekt verwendet werden. Sobald jedes Sprachsegment erkannt wurde, wird es in der identifizierten Sprache automatisch transkribiert, und alle Segmente werden wieder zusammen in eine Transkriptionsdatei integriert, die aus mehreren Sprachen besteht.

Die resultierende Transkription ist sowohl als Teil der Video Indexer JSON-Ausgabe als auch als Untertiteldateien verfügbar. Das Ausgabetranskript ist auch in Azure Search integriert, sodass Sie sofort in Videos nach den verschiedenen Sprachsegmenten suchen können. Darüber hinaus ist die mehrsprachige Transkription als Teil des Video Indexer-Portals verfügbar, sodass Sie das Transkript und die identifizierte Sprache nach Zeit anzeigen oder zu den spezifischen Stellen im Video für jede Sprache springen und die mehrsprachige Transkription als Untertitel anzeigen können wie ein Video abgespielt wird. Sie können die Ausgabe auch über das Portal und die API in 54 verschiedene Sprachen übersetzen.

Weitere Informationen zur neuen mehrsprachigen Option und deren Verwendung in Video Indexer finden Sie

in unserer Dokumentation .

Zusätzliche aktualisierte und verbesserte Modelle

Wir fügen außerdem neue und verbesserte Modelle in Video Indexer hinzu, darunter:

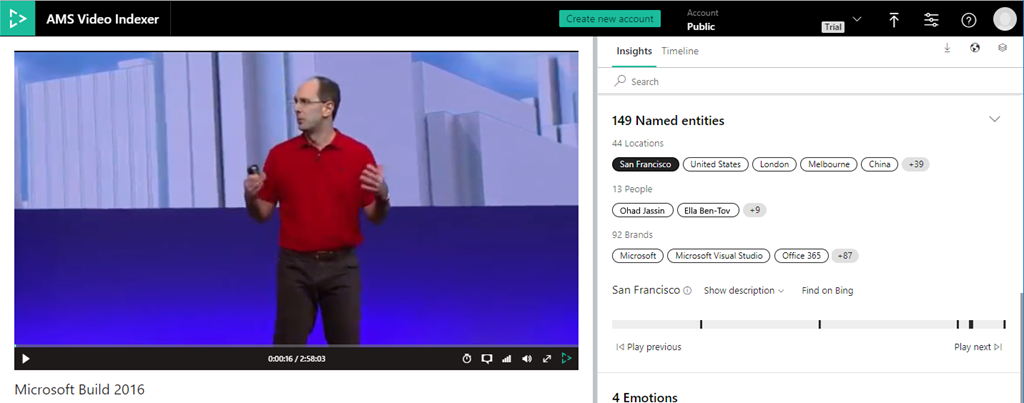

Extraktion von Personen und Standorten

Wir haben unsere aktuellen Funktionen zur Markenerkennung erweitert, um auch bekannte Namen und Standorte wie den Eiffelturm in Paris oder den Big Ben in London einzubeziehen. Wenn diese im generierten Transkript oder auf dem Bildschirm über die optische Zeichenerkennung (OCR) erscheinen, wird eine spezifische Einsicht erstellt. Mit dieser neuen Funktion können Sie alle Personen, Standorte und Marken, die im Video angezeigt werden, sowie deren Zeitrahmen, Beschreibung und einen Link zu unserer Bing-Suchmaschine überprüfen und nach weiteren Informationen suchen.

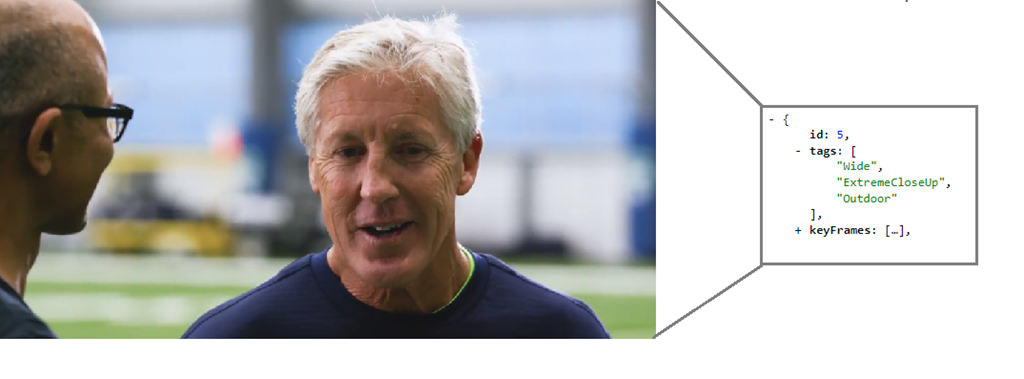

Editorial Shot Detection Modell

Diese neue Funktion fügt eine Reihe von "Tags" in die Metadaten ein, die einer einzelnen Aufnahme in Insights JSON zugeordnet sind, um deren redaktionellen Typ darzustellen (z. B. Weitwinkelaufnahme, mittlere Aufnahme, Nahaufnahme, extreme Nahaufnahme, zwei Aufnahmen, mehrere Personen, Außenaufnahmen) und drinnen usw.). Diese Eigenschaften des Aufnahmetyps sind nützlich, wenn Sie Videos in Clips und Trailern bearbeiten oder nach einem bestimmten Aufnahmestil für künstlerische Zwecke suchen.

Weitere

Weitere Informationen zur Erkennung redaktioneller Aufnahmetypen finden Sie in Video Indexer.

Erweiterte Granularität der IPTC-Zuordnung

Unser Themeninferenzmodell bestimmt das Thema von Videos basierend auf Transkription, optischer Zeichenerkennung (OCR) und erkannten Prominenten, auch wenn das Thema nicht explizit angegeben ist. Wir ordnen diese abgeleiteten Themen vier verschiedenen Taxonomien zu: Wikipedia, Bing, IPTC und IAB. Mit dieser Verbesserung schließen wir jetzt die IPTC-Taxonomie der Stufe 2 ein.

Der Tankvorteil dieser Verbesserungen ist so einfach wie das erneute Indizieren Ihrer aktuellen Video Indexer-Bibliothek.

Neue Live-Streaming-Funktionalität

Außerdem führen wir in der Vorschau von Azure Media Services zwei neue Live-Streaming-Funktionen ein.

Live-Transkription lädt Ihre Live-Events mit AI auf

Wenn Sie Azure Media Services zum Streamen eines Live-Ereignisses verwenden, können Sie jetzt einen Ausgabestream abrufen, der zusätzlich zu den Video- und Audioinhalten eine automatisch generierte Textspur enthält. Diese Textspur wird mithilfe einer AI-basierten Live-Transkription des Audios des Beitrags-Feeds erstellt. Vor und nach der Konvertierung von Sprache in Text werden benutzerdefinierte Methoden angewendet, um die Endbenutzererfahrung zu verbessern. Die Textspur wird in IMSC1, TTML oder WebVTT gepackt, je nachdem, ob Sie in DASH, HLS CMAF oder HLS TS liefern.

Lineare Live-Codierung für OTT-Kanäle (24/7 Over-the-Top)

Mit unseren v3-APIs können Sie Live-Kanäle für OTT-Dienste erstellen, verwalten und streamen und alle anderen Funktionen von Azure Media Services wie Live-to-Video-on-Demand (VOD), Verpackung und Digital Rights Management (DRM) nutzen.

Besuchen Sie die

Azure Media Services-Community- Seite, um diese Vorschaufunktionen auszuprobieren.

Neue Verpackungsmerkmale

Unterstützung für Audiobeschreibungsspuren

Broadcast-Inhalte enthalten häufig eine Audiospur, die zusätzlich zum normalen Programm-Audio verbale Erklärungen zu Bildschirmaktionen enthält. Dies macht das Programmieren für sehbehinderte Zuschauer zugänglicher, insbesondere wenn der Inhalt sehr visuell ist. Mit der neuen

Audiobeschreibungsfunktion kann ein Kunde eine der Audiospuren als Audiobeschreibungsspur (AD)

kennzeichnen , die wiederum von Spielern verwendet werden kann, um die AD-Spur für die Zuschauer erkennbar zu machen.

Einfügen von ID3-Metadaten

Um das Einfügen von Werbung oder benutzerdefinierten Metadatenereignissen auf einem Client-Player zu signalisieren, verwenden Rundfunkveranstalter häufig zeitgesteuerte Metadaten, die in das Video eingebettet sind. Zusätzlich zu den SCTE-35-Signalisierungsmodi unterstützen

wir jetzt auch ID3v2 oder andere benutzerdefinierte Schemas, die von einem Anwendungsentwickler zur Verwendung durch die Clientanwendung definiert wurden.

Microsoft Azure-Partner demonstrieren End-to-End-Lösungen

Bitmovin stellt seine Bitmovin-

Videokodierung und seinen Bitmovin-Videoplayer unter Microsoft Azure vor. Kunden können diese Codierungs- und Player-Lösungen jetzt in Azure verwenden und erweiterte Funktionen wie 3-Pass-Codierung, AV1 / VVC-Codec-Unterstützung, mehrsprachige Untertitel und vorintegrierte Videoanalyse für QoS, Anzeige und Video-Tracking nutzen.

Evergent zeigt seine User Lifecycle Management Platform in Azure. Als führender Anbieter von Managementlösungen für Umsatz und Kundenlebenszyklus nutzt Evergent Azure AI, um Premium-Unterhaltungsdienstleistern die Verbesserung der Kundenakquise und -bindung zu ermöglichen, indem gezielte Pakete und Angebote an kritischen Punkten im Kundenlebenszyklus generiert werden.

Haivision wird seinen intelligenten Cloud-Service für das

Medienrouting , SRT Hub,

vorstellen , mit dem Kunden End-to-End-Workflows beginnend mit der Aufnahme mithilfe von

Azure Data Box Edge und der Transformation von Medienworkflows mithilfe von Hublets von Avid, Telestream, Wowza und Cinegy sowie Make.tv transformieren können .

SES hat für seine Kunden mit Satellitenkonnektivität und verwalteten Mediendiensten eine Reihe von Mediendiensten in Broadcast-Qualität auf Azure entwickelt. SES zeigt Lösungen für vollständig verwaltete Playout-Dienste, einschließlich Master-Playout, lokalisiertes Playout sowie Erkennung und Ersetzung von Anzeigen und hochwertige Mehrkanal-Live-Codierung rund um die Uhr in Azure.

SyncWords stellt seine Technologie zur Untertitelautomatisierung und benutzerfreundlichen Cloud-basierten Tools in Azure zur Verfügung. Diese Angebote erleichtern Medienunternehmen das Hinzufügen automatisierter Untertitel- und Untertitelungsfunktionen für Fremdsprachen zu ihren Echtzeit- und Offline-Videoverarbeitungs-Workflows in Azure.

Das globale Design- und Technologiedienstleistungsunternehmen

Tata Elxsi hat TEPlay, seine OTT-Plattform SaaS, in Azure Media Services integriert, um OTT-Inhalte aus der Cloud bereitzustellen. Tata Elxsi hat auch FalconEye, seine QoE-Überwachungslösung (Quality of Experience), die sich auf umsetzbare Metriken und Analysen konzentriert, zu Microsoft Azure gebracht.

Verizon Media stellt seine Streaming-Plattform in der Beta-Version von Azure zur Verfügung. Verizon Media Platform ist eine verwaltete OTT-Lösung für Unternehmen, die DRM, Anzeigeneinfügung, personalisierte Eins-zu-Eins-Sitzungen, dynamischen Inhaltsaustausch und Videobereitstellung umfasst. Die Integration bietet vereinfachte Workflows, globale Unterstützung und Skalierbarkeit sowie Zugriff auf eine Reihe einzigartiger Funktionen, die in Azure verfügbar sind.