Die Idee der künstlichen Intelligenz hat die Menschheit lange Zeit beunruhigt. Automaten fanden in den Mythen des antiken Griechenland große Beachtung, und das berühmteste Beispiel ist die künstliche Frau Pandora, die von Zeus geschaffen wurde. Mystische Golems sind in der jüdischen Kultur zu finden. Und erstaunliche Karakuri-Puppen nehmen einen wichtigen Platz im japanischen Epos ein.

Im 17. Jahrhundert haben einige Philosophen über die Möglichkeit nachgedacht, den Geist in leblose Objekte zu stecken. Viele Theorien wurden aufgestellt. Zum Beispiel glaubte Rene Descartes an den Dualismus von Körper und Geist. Seine Ansichten lehnten die Möglichkeit der Mechanisierung der Intelligenz ab.

Leibniz hatte andere Ansichten. Er glaubte, dass alle menschlichen Gedanken mithilfe elementarer Symbole mathematisch dargestellt werden können. Dazu schlug er Characteristica Universalis vor, die Symbolik von Konzepten, die für die Beschreibung von Wissen notwendig sind.

Künstliche Intelligenz und Automaten sind seit jeher in der Fiktion enthalten. Ein Beispiel ist der "Frankenstein oder Modern Prometheus" von Mary Shelley und der "Rossum Universal Robots" von Karel Chapek. Dank ihnen erschien 1921 das Wort "Roboter" in der Literatur.

Dies waren die philosophischen Voraussetzungen für die Entstehung der KI. Lassen Sie uns nun über bestimmte Wissenschaftler und ihre Werke sprechen, dank derer künstliche Intelligenz aus der Fiktion Realität geworden ist. Eine relativ konkrete und sachliche Geschichte begann vor relativ kurzer Zeit. Der berühmte Turing-Test wurde erstmals 1950 durchgeführt, aber nur sechs Jahre später, 1956, begann sich die KI als eigenständige Disziplin zu bilden. Mal sehen, wie es war.

Erste Schritte

Die Zahl der wissenschaftlichen Arbeiten zur künstlichen Intelligenz nahm in den 1950er und 60er Jahren stark zu. Zuvor gab es jedoch Studien zu diesem Thema. Bertrand Russell und Alfred North Whitehead veröffentlichten 1913 The Principles of Mathematics . Etwa zur gleichen Zeit legte George Bull seine Denkgesetze vor . Damit war der Grundstein für die mathematische Logik gelegt.

Vielleicht begann alles in dem Moment, als ein unverständlicher 15-jähriger Junge in das Büro von Rudolf Karnap stürmte. Karnap wurde dann bereits ein einflussreicher Philosoph und lehrte an der Universität von Chicago. Er veröffentlichte die logische Syntax der Sprache. Der Junge kam ohne Erlaubnis und zeigte Fehler in dieser Arbeit an. Rudolph war geschockt. Der Besucher war ungewöhnlich. Außerdem stellte er sich nicht einmal vor und rannte sofort weg. Nach monatelanger Suche fand Rudolph schließlich seinen Besucher an einer örtlichen Universität. Es stellte sich heraus, dass es Walter Harry Pitts war .

Drei Jahre zuvor (ja, mit 12) schrieb Walter einen Brief an Bertrand Russell, in dem er auf die Probleme hinwies, die in den oben genannten Grundsätzen zu finden waren. Russell war so beeindruckt, dass er den Jungen zur Graduiertenschule an der Cambridge University in Großbritannien einlud. Obwohl Walter in einer dysfunktionalen Familie aufwuchs, wagte er es nicht, aus Detroit zu ziehen. Als Russell jedoch in Chicago ankam, um Vorträge zu halten, floh Pitts nach Hause, um bei ihm zu studieren. Er wurde kein Student an der Universität von Chicago, besuchte aber fleißig Vorlesungen. (Das Leben von Walter Pitts ist trotz seiner kurzen Dauer im Allgemeinen sehr hell und interessant. Ich empfehle, es selbst zu lesen - ca. Übersetzer ).

1942 traf Walter Pitts Warren McCallock . McCullock lud Pitts ein, in seinem Haus zu bleiben. Sie waren von der Richtigkeit der Leibniz-Theorie überzeugt, die die Möglichkeit einer "Mechanisierung" des menschlichen Denkens nahe legte. Und sie versuchten, ein Modell für die Neurobiologie des menschlichen Nervensystems zu erstellen. Sie veröffentlichten 1943 ihren Hauptartikel darüber und nannten ihn "Die logische Berechnung von Ideen im Zusammenhang mit nervöser Aktivität ". Dieses Dokument hat einen unschätzbaren Beitrag auf dem Gebiet der künstlichen Intelligenz geleistet. Wissenschaftler haben ein einfaches Modell vorgeschlagen, das als mathematisches McCullock-Pitts-Neuron bekannt ist . Sie studiert immer noch in maschinellen Lernkursen. Die von Wissenschaftlern vorgeschlagenen Ideen bilden die Grundlage für fast alle modernen KI.

Warren McCallock und Walter Pitts

Die Kybernetik von Norbert Weiner und die Informationstheorie von Claude Shannon wurden 1948 veröffentlicht. Kybernetik ist eine Studie über "Kontrolle und Kommunikation in einem lebenden Organismus und in einer Maschine". Informationstheorie ist die Messung der Informationsmenge, ihrer Speicherung und Übertragung. Beide Arbeiten hatten einen großen Einfluss auf die KI.

Die Kybernetik lieferte eine direkte Untersuchung der biologischen und mechanischen Intelligenz. Und die Informationstheorie hat die grundlegende Mathematik beeinflusst.

Nach ein paar Jahren führte Alan Turing den Turing- Test durch . Er beschrieb eine Methode, um festzustellen, ob eine Maschine intelligent ist. Der vereinfachte Test lautet wie folgt: Eine Person kommuniziert mit einem Computer und einer Person. Anhand ihrer Antworten auf Fragen muss er bestimmen, mit wem er spricht: mit einer Person oder einem Computerprogramm. Die Aufgabe eines Computerprogramms besteht darin, eine Person irrezuführen und sie zu zwingen, die falsche Wahl zu treffen. “

Obwohl der Turing-Test zu begrenzt ist, um moderne intelligente Systeme zu testen, war er zu dieser Zeit ein echter Durchbruch. Der Name von Alan Turing kam in die Presse und machte die Branche populärer.

Turing-Test

1956 fand in Dartmouth eine Konferenz zum Thema der Erforschung der Konzepte der "Mechanisierung" der Intelligenz statt. Später werden die Teilnehmer dieser Konferenz zu herausragenden Persönlichkeiten im Bereich der KI. Der berühmteste war Marvin Minsky , der 1951 die erste neuronale Netzwerkmaschine, SNARC, schuf. Er wird in den kommenden Jahrzehnten der bekannteste Name in der Welt der künstlichen Intelligenz sein.

Claude Shannon nahm ebenfalls an der Konferenz teil. Und der zukünftige Nobelpreisträger Herbert A. Simon und Allen Newell debütierten mit ihrem „ Logic-Theorist “. Anschließend wird er 38 der ersten 52 Sätze in Russells Prinzipien der Mathematik lösen.

John McCarthy - ebenfalls einer der Pioniere der künstlichen Intelligenz - prägte den Namen "Künstliche Intelligenz". Die Teilnehmer stimmten dieser Frist zu. Dies war die Geburt der KI.

Branchenentwicklung (1956–1974)

Semantisches Netzwerk

Dank dieser Konferenz ist das Interesse an KI gewachsen und es sind viele interessante Entwicklungen aufgetreten. 1959 schufen Newell und Simon den „Common Problem Solver“, der theoretisch jedes formalisierte Problem lösen konnte. Und James Slagle erstellte ein heuristisches Programm SAINT (Symbical Automatic INTegrator), das die Probleme der symbolischen Integration in die Analysis löste. Diese Programme waren beeindruckend.

Nach der Erstellung des Turing-Tests ist die Natürlichkeit der Sprache zu einem wichtigen Bereich der KI geworden. Daniel Bobrows STUDENT-Programm war in der Lage, Wortprobleme in der High School zu lösen. Wenig später erschien das Konzept des semantischen Netzwerks - eine Karte verschiedener Konzepte und der Beziehungen zwischen ihnen (wie in der Abbildung). In diesem Netzwerk wurden mehrere erfolgreiche Programme erstellt. 1966 gründete Joseph Weisenbaum ELIZA. Ein virtueller Gesprächspartner könnte realistische Gespräche mit Menschen führen.

Im Zusammenhang mit einer solch aktiven Entwicklung der KI-Industrie machten Wissenschaftler äußerst kühne Aussagen:

- Newell und Simon, 1958: "In 10 Jahren wird der digitale Computer zum Schachweltmeister." Und "innerhalb von 10 Jahren wird ein digitaler Computer einen wichtigen neuen mathematischen Satz entdecken und beweisen."

- Simon GA, 1965: „Maschinen können jede Arbeit ausführen, die eine Person 20 Jahre lang ausführen kann.“

- Marvin Minsky, 1967: "In einer Generation ... wird das Problem der Schaffung" künstlicher Intelligenz "im Wesentlichen gelöst sein."

- Marvin Minsky, 1970: "In drei bis acht Jahren werden wir eine Maschine mit der allgemeinen Intelligenz eines gewöhnlichen Menschen haben."

Auf die eine oder andere Weise kam Geld in die Branche. Das Office of Advanced Research Projects (ARPA, später in DARPA umbenannt) stellte dem MIT-Team 2,2 Millionen US-Dollar zur Verfügung. Der damalige Präsident der DARPA entschied, dass sie „Menschen finanzieren sollten, keine Projekte“, und schuf eine freie Forschungskultur. Dies ermöglichte es den Forschern, Projekte durchzuführen, die sie für richtig hielten.

Temporäre Kühlung (1974-1980)

1969 veröffentlichten Marvin Minsky und Seymour Papert ihr Buch Perceptrons . Darin zeigten sie die grundlegenden Einschränkungen von Perzeptronen und betonten die Unfähigkeit von Perzeptronen, das XOR-Elementarschema zu steuern. Dies führte zu einer Verlagerung des Interesses von Forschern der künstlichen Intelligenz auf den Bereich des symbolischen Rechnens, der den neuronalen Netzen entgegengesetzt ist.

Der alternative Ansatz der symbolischen KI gewann explosionsartig. Dieser Ansatz lieferte jedoch keine signifikanten Ergebnisse. In den 1970er Jahren wurde deutlich, dass KI-Forscher zu optimistisch in Bezug auf KI waren. Die versprochenen Ziele wurden noch nicht erreicht und ihre Erreichung schien eine Frage der fernen Zukunft zu sein.

Die Forscher stellten fest, dass sie an der Wand ruhen. KI wurde auf einfache Aufgaben angewendet. Die realen Szenarien waren für diese Systeme jedoch zu komplex. Die Anzahl der Möglichkeiten, die die Algorithmen erforschen mussten, erwies sich als astronomisch. Dies führte zu dem Problem einer kombinatorischen Explosion . Und dann stellte sich die klassische Frage, wie man einen Computer intelligent macht. Es war ein gesunder Menschenverstand .

All dies führte dazu, dass die Anleger von der Technologie enttäuscht waren. Die KI-Finanzierung ist damit verschwunden und die Forschung wurde eingestellt. Auch DARPA konnte eine Hacker-Forschungskultur aufgrund von Gesetzesänderungen nicht mehr unterstützen. Sponsoren haben die Mittel für die Forschung auf dem Gebiet der künstlichen Intelligenz eingefroren. Daher der Zeitraum 1974-1980. genannt " Winter AI ".

Wiedergeburt

1981 begann die japanische Regierung ernsthaft in die Forschung auf dem Gebiet der künstlichen Intelligenz zu investieren. Das Land stellte 850 Millionen US-Dollar für das Computerprojekt der fünften Generation bereit. Er zielte darauf ab, KI zu entwickeln. Die angeblichen Computer mussten kommunizieren, andere Sprachen übersetzen, Bilder erkennen. Es wurde erwartet, dass Computer die Grundlage für die Erstellung von Geräten bilden, die das Denken simulieren können.

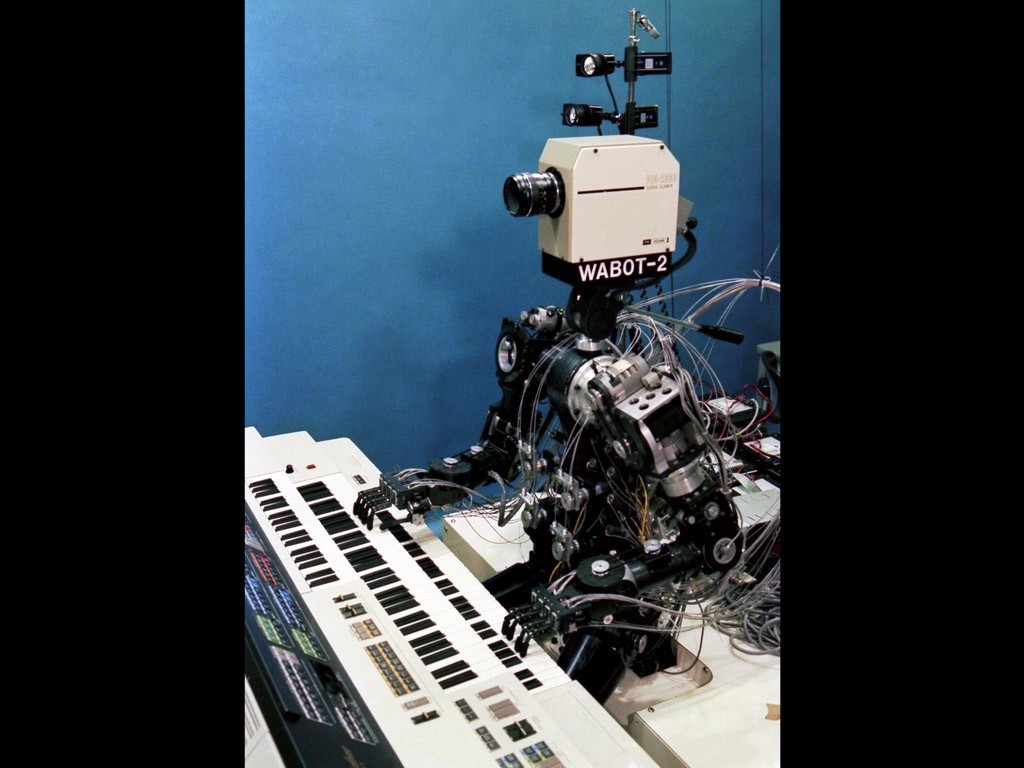

Wabot-2

Die Forschung in Japan schien vielversprechend. 1980 wurde der Wabot-2- Roboter an der Waseda University entwickelt. Er konnte mit Menschen kommunizieren, Partituren lesen und die elektronische Orgel spielen. Der Erfolg der Japaner hat andere Regierungen und Privatunternehmen gezwungen, ihren Blick wieder auf die KI zu richten.

An diesem Punkt stellte sich die Frage des Konnektionismus. 1982 schuf Hopfield eine neue Form eines neuronalen Netzwerks, das Informationen studieren und verarbeiten kann. Jeffrey Hinton und David Rumelhart popularisierten die umgekehrte Selbstunterscheidung. Diese Technologie war phänomenal und ist bis heute für das maschinelle Lernen von entscheidender Bedeutung.

KI erzielte kommerziellen Erfolg in Form von „Expertensystemen“. Diese Systeme hatten ein tiefes Wissen über ein bestimmtes Thema. Die Carnegie Mellon University (CMU) startete 1980 ein Expertensystem namens XCON. Es wurde bei der Digital Equipment Corporation eingesetzt. Bis 1986 sparte das Unternehmen jährlich 40 Millionen US-Dollar.

Zweiter Winter

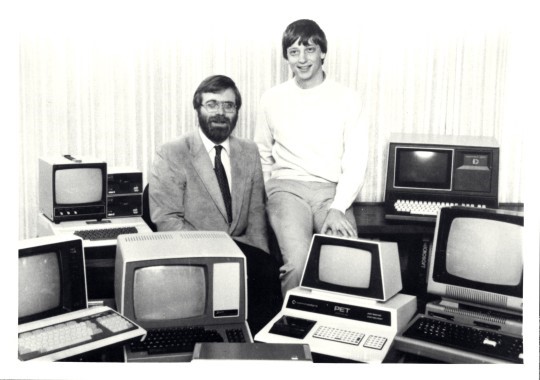

Die PC-Revolution hat den Verlauf der KI-Entwicklung verändert

In den späten 1980er Jahren wurde der Erfolg der KI-Industrie von der Computerrevolution überschattet. Apple und IBM produzierten gleichzeitig immer leistungsfähigere Computer. Desktop-Computer sind billiger und leistungsfähiger als Lisp-Maschinen mit künstlicher Intelligenz. Eine ganze Industrie im Wert von einer halben Milliarde Dollar wurde in einer Nacht zerstört. KI-Erfolge in Expertensystemen wie der XCON-Maschine haben sich als zu teuer erwiesen.

Es gibt Probleme mit Expertensystemen. Sie konnten nicht lernen. Sie waren „zerbrechlich“ (das heißt, sie könnten schwerwiegende Fehler machen, wenn sie ungewöhnliche Daten erhalten). Der praktische Umfang von Expertensystemen ist begrenzt. Die neue DARPA-Führung hat entschieden, dass KI nicht die „nächste Welle“ ist. Und umgeleitete Investitionen in Projekte, die aus ihrer Sicht sofortige Ergebnisse bringen sollten.

Bis 1991 waren die Ziele eines Computerprojekts in Japan nicht erreicht worden. Wissenschaftler unterschätzten die Schwierigkeiten, mit denen sie konfrontiert waren. Über 300 KI-Unternehmen wurden geschlossen, gingen in Konkurs oder wurden bis Ende 1993 gekauft. Es war tatsächlich das Ende der ersten Welle der kommerziellen Nutzung künstlicher Intelligenz.

Frischer Strom

Als die Echos der Computerrevolution nachließen, hatten die Menschen die Möglichkeit, große Rechenleistung zu nutzen. Mit der Allgegenwart von Computern hat die Anzahl der verschiedenen Datenbanken zugenommen. Es war alles sehr cool in Bezug auf die KI-Entwicklung.

Neue Technologien lösten Probleme und beseitigten Hindernisse, die Wissenschaftler störten. Mit zunehmender Rechenleistung haben die Forscher die Grenzen des Möglichen überschritten. Aus den Datenbanken, aus denen Big Data wurde, konnte immer mehr Wissen gewonnen werden. Die Möglichkeiten für den praktischen Einsatz von KI sind offensichtlicher geworden.

In den 1990er Jahren wurde ein neues Konzept namens „ Intelligent Agent “ eingeführt. Intelligent Agent (IA) ist ein System, das die vom Benutzer ausgegebene Aufgabe über einen längeren Zeitraum unabhängig ausführt. Es bestand die Hoffnung, dass wir eines Tages der IA beibringen können, miteinander zu interagieren. Dies würde zur Schaffung universeller und „intelligenterer“ Systeme führen.

In der KI-Community gab es unterschiedliche Meinungen über den Einsatz von Mathematik im Bereich der künstlichen Intelligenz. Einige dachten, die Intelligenz sei zu komplex, um mit mathematischen Symbolen beschrieben zu werden. Ihrer Meinung nach lassen sich Menschen bei Entscheidungen selten von Logik leiten. Ihre Gegner beanstandeten, dass logische Ketten der Weg nach vorne sind.

G. Kasparov spielt mit Deep Blue

Sehr bald, 1997, besiegte der IBM Deep Blue Supercomputer Garry Kasparov. In diesem Moment war Kasparov der Schachweltmeister. Was laut Newell und Simon bis 1968 geschehen sollte, geschah schließlich 1997.

Moderne Schachcomputer sind viel stärker als jeder Mensch. Die höchste Elo-Bewertung, die jemals von Menschen erreicht wurde, liegt bei 2.882. Bei Computern liegt die häufigste Zahl bei 3.000 Elo. Der höchste jemals gemessene Wert lag bei über 3.350.

Im Jahr 2005 entwickelte Stanford einen Roboter für autonomes Fahren. Er gewann die DARPA Grand Challenge, indem er 211 km auf einem unerforschten Wüstenweg fuhr.

Gefahr

Im Februar 2011 beschloss IBM, seinen IBM Watson im Jeopardy-Quiz zu testen. Der Computer konnte die beiden größten Champions of Jeopardy deutlich besiegen.

Mit der Lawinenentwicklung des Internets und der sozialen Netzwerke ist die Informationsmenge gewachsen. IT-Unternehmen mussten mit den erhaltenen Daten etwas anfangen. Und der Einsatz von KI ist zu einer Notwendigkeit geworden, nicht zur Unterhaltung.

Jetzt sortiert Google SERPs mithilfe von maschinellem Lernen. YouTube wählt empfohlene Videos mithilfe von ML-Algorithmen aus und empfiehlt Amazon-Produkte auf die gleiche Weise. Der Facebook-Newsfeed wird von einem intelligenten Computer generiert. Und selbst Tinder findet Leute, die ML-Algorithmen verwenden.

Dank der Computerrevolution ist die KI-Technologie zu unserem unverzichtbaren Werkzeug geworden. Und jetzt freut sich die Menschheit auf die Schaffung von Supermaschinen. Und obwohl die Auswirkungen künstlicher Intelligenz manchmal umstritten sind, ist eine Weiterentwicklung dieser Technologie unvermeidlich.

Was sonst noch nützlich ist, lesen Sie im Cloud4Y- Blog

→ Der Computer macht Sie lecker

→ KI hilft bei der Untersuchung von Tieren in Afrika

→ Der Sommer ist fast vorbei. Es sind fast keine Daten durchgesickert

→ 4 Möglichkeiten zum Speichern von Backups in der Cloud

→ IoT, Nebel und Wolken: Über Technologie sprechen?

Abonnieren Sie unseren Telegrammkanal , um keinen weiteren Artikel zu verpassen! Wir schreiben nicht mehr als zweimal pro Woche und nur geschäftlich.