Im Laufe seiner Geschichte, von Asimovs ersten Robotern bis hin zu AlphaGo, hatte AI Höhen und Tiefen. Tatsächlich fängt seine Geschichte aber gerade erst an.

Künstliche Intelligenz ist noch sehr jung. In diesem Bereich sind jedoch bereits viele bedeutende Ereignisse eingetreten. Einige von ihnen erregten die Aufmerksamkeit der Kultur, andere erzeugten eine Druckwelle, die nur von Wissenschaftlern wahrgenommen wurde. Hier sind einige wichtige Punkte, die den größten Einfluss auf die KI hatten.

Azimovs Geschichte "

Round Dance " markiert den ersten Auftritt in den Geschichten dieses berühmten Science-Fiction-Schriftstellers der "Drei Gesetze der Robotik":

- Ein Roboter kann einer Person keinen Schaden zufügen oder durch Untätigkeit zulassen, dass eine Person verletzt wird.

- Ein Roboter muss alle Anweisungen einer Person befolgen, außer in Fällen, in denen diese Anweisungen gegen das Erste Gesetz verstoßen.

- Der Roboter muss auf seine Sicherheit achten, soweit er nicht dem Ersten oder Zweiten Gesetz widerspricht.

In der Geschichte „Round Dance“ wird der Speedy-Roboter in eine Position gebracht, in der das dritte Gesetz im Widerspruch zu den ersten beiden steht. Azimovs Geschichten über Roboter ließen NF-Fans, einschließlich Wissenschaftler, über die Möglichkeit nachdenken, Maschinen zu denken. Bis heute üben die Menschen intellektuelle Übungen aus und wenden die Gesetze von Asimov auf die moderne KI an.

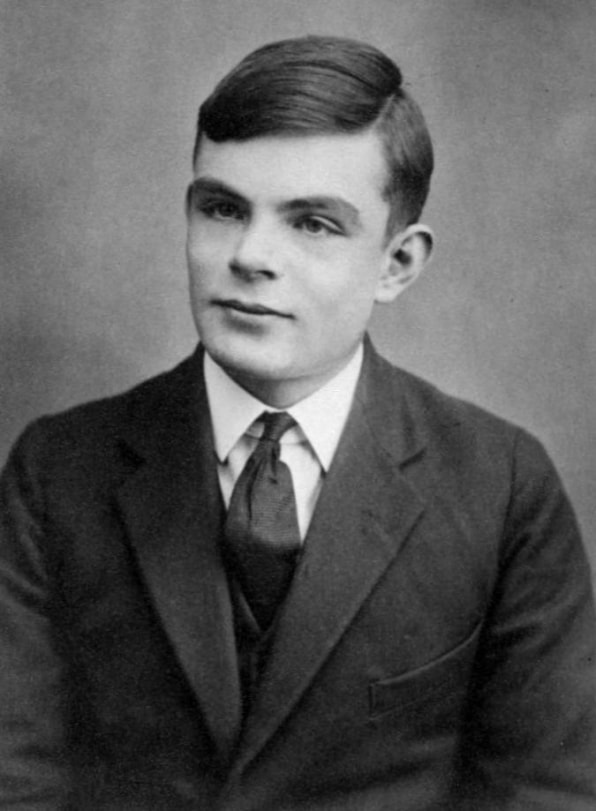

2. Alan Turing schlug sein "Game of Imitation" (1950) vor

Alan Turing beschrieb 1950 das erste Prinzip zur Messung des Rationalitätsgrades einer Maschine.

Alan Turing beschrieb 1950 das erste Prinzip zur Messung des Rationalitätsgrades einer Maschine.Ich schlage vor, die Frage "Können Autos denken?" So begann die einflussreiche Turing-Forschungsarbeit von 1950, die ein Glaubenssystem entwickelte, um über den Maschinenverstand nachzudenken. Er fragte, ob eine Maschine als intelligent angesehen werden könne, wenn sie menschliches Verhalten nachahmen könne.

Aus dieser theoretischen Frage entstand das berühmte „Simulationsspiel“ [es wird später als „

Turing-Test “ bezeichnet. transl.], eine Übung, bei der ein Forscher bestimmen muss, mit wem er korrespondiert - mit einem Computer oder einer Person. Zum Zeitpunkt von Turing gab es keine Maschinen, die diesen Test bestehen konnten, heute gibt es keine. Sein Test gab jedoch eine einfache Möglichkeit, um festzustellen, ob der Geist im Auto war. Er hat auch die Philosophie der KI mitgeprägt.

3. Dartmouth AI Conference (1956)

Bis 1955 hatten Wissenschaftler auf der ganzen Welt bereits Konzepte wie neuronale Netze und natürliche Sprache entwickelt, aber es gab immer noch keine einheitlichen Konzepte, die verschiedene Arten von Maschinenintelligenz umfassten. John McCarthy, Professor für Mathematik am Dartmouth College, prägte den Begriff „künstliche Intelligenz“, um sie alle zusammenzubringen.

McCarthy leitete die Gruppe, die 1956 ein Stipendium für die Organisation einer KI-Konferenz beantragte. Viele führende Forscher dieser Zeit wurden im Sommer 1956 nach Dartmouth Hall eingeladen. Die Wissenschaftler diskutierten verschiedene potenzielle Bereiche der KI-Studie, darunter Lernen und Suchen, Sehvermögen, logisches Denken, Sprache und Vernunft, Spiele (insbesondere Schach) und menschliche Interaktionen mit intelligenten Maschinen wie persönlichen Robotern.

Der allgemeine Konsens dieser Diskussionen war, dass KI ein enormes Potenzial zum Nutzen der Menschen hat. Das allgemeine Forschungsgebiet, dessen Entwicklung durch maschinelle Intelligenz beeinflusst werden kann, wurde umrissen. Die Konferenz organisierte und inspirierte die KI-Forschung über viele Jahre.

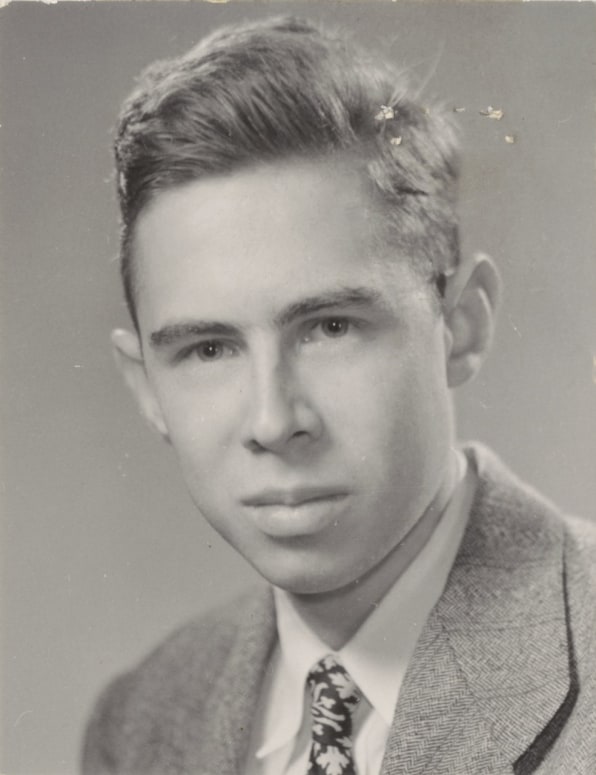

4. Frank Rosenblatt schafft das Perzeptron (1957)

Frank Rosenblatt schuf 1957 im Cornell Aeronautics Laboratory ein mechanisches neuronales Netzwerk

Frank Rosenblatt schuf 1957 im Cornell Aeronautics Laboratory ein mechanisches neuronales NetzwerkDie Grundkomponente des neuronalen Netzwerks wird als "

Perzeptron " bezeichnet [dies ist nur der

allererste und primitive Typ eines künstlichen Neurons / ca. übersetzt.]. Ein Satz von Eingabedaten fällt in den Knoten, der den Ausgabewert berechnet und eine Klassifizierung und ein Vertrauensniveau angibt. Zum Beispiel können die Eingabedaten verschiedene Aspekte des Bildes basierend auf den Eingabedaten analysieren und (mit einem gewissen Maß an Vertrauen) darüber abstimmen, ob ein Gesicht darauf ist. Dann zählt der Knoten alle „Stimmen“ und das Vertrauensniveau und gibt einen Konsens aus. In den heutigen neuronalen Netzen, die auf leistungsstarken Computern laufen, arbeiten Milliarden ähnlicher Strukturen zusammen.

Perzeptrone existierten jedoch schon vor dem Aufkommen leistungsfähiger Computer. In den späten 1950er Jahren schuf ein junger Psychologe, Frank Rosenblatt, ein elektromechanisches Modell des Perzeptrons namens Mark I Perceptron, das heute in der Smithsonian Institution gespeichert ist. Es war ein analoges neuronales Netzwerk, das aus einem Netzwerk lichtempfindlicher Elemente bestand, die durch Drähte mit Knotenbänken verbunden waren, die Elektromotoren und Drehwiderstände enthielten. Rosenblatt entwickelte den „Perzeptron-Algorithmus“, der das Netzwerk steuerte und die Stärke der Eingangssignale schrittweise so anpasste, dass die Objekte korrekt identifiziert wurden - tatsächlich wurde er trainiert.

Wissenschaftler diskutierten bis in die 1980er Jahre über die Bedeutung dieser Maschine. Es spielte eine wichtige Rolle bei der Schaffung der physischen Verkörperung des neuronalen Netzwerks, das bis dahin hauptsächlich in Form eines wissenschaftlichen Konzepts existierte.

5. AI steht vor seinem ersten Winter (1970er Jahre)

Für den größten Teil seiner Geschichte existierte KI nur in der Forschung. Während eines Großteils der 1960er Jahre investierten Regierungsbehörden, insbesondere DARPA, Geld in die Forschung und benötigten praktisch keinen Investitionsbericht. KI-Forscher haben das Potenzial ihrer Arbeit, weiterhin Mittel zu erhalten, oft übertrieben. In den späten 1960er und frühen 1970er Jahren änderte sich alles. Zwei Berichte - einer vom ALPAC-Beirat für die US-Regierung im Jahr 1966 und der zweite von Lighthill für die britische Regierung im Jahr 1973 - bewerteten pragmatisch die Fortschritte in der KI-Forschung und gaben eine sehr pessimistische Prognose über das Potenzial dieser Technologie ab. Beide Berichte stellten die Existenz konkreter Fortschritte in verschiedenen Bereichen der KI-Forschung in Frage. Lighthill argumentierte in seinem Bericht, dass es äußerst schwierig sei, KI für Spracherkennungsaufgaben auf Größen zu skalieren, die für die Regierung oder das Militär nützlich sein könnten.

Infolgedessen begannen die Regierungen der Vereinigten Staaten und Großbritanniens, die Mittel für die KI-Forschung an Universitäten zu kürzen. DARPA, das in den 1960er Jahren die KI-Forschung ohne Probleme finanzierte, forderte von den Projekten klare Zeitpläne und eine detaillierte Beschreibung der erwarteten Ergebnisse. Infolgedessen schien es, dass die KI die Erwartungen nicht erfüllte und niemals das Niveau menschlicher Fähigkeiten erreichen konnte. Der erste „Winter“ der KI dauerte alle 1970er und 80er Jahre.

6. Die Ankunft des zweiten Winters der KI (1987)

Die 1980er Jahre begannen mit der Entwicklung und den ersten Erfolgen von „

Expertensystemen “, die große Datenmengen speicherten und den Entscheidungsprozess von Menschen nachahmten. Die Technologie wurde ursprünglich an der Carnegie Mellon University für Digital Equipment Corporation entwickelt, und dann begannen andere Unternehmen, sie schnell zu implementieren. Expertensysteme erforderten jedoch teure Spezialgeräte, und dies wurde zu einem Problem, als ähnliche Stromversorgungs- und billigere Workstations von Sun Microsystems sowie PCs von Apple und IBM auftauchten. Der Markt für professionelle Computersysteme brach 1987 zusammen, als große Gerätehersteller ihn verließen.

Der Erfolg von Expertensystemen in den frühen 80er Jahren inspirierte DARPA, die Mittel für die KI-Forschung zu erhöhen, aber es änderte sich bald wieder und die Agentur reduzierte den größten Teil dieser Mittel, so dass nur wenige Programme übrig blieben. Auch hier ist der Begriff „künstliche Intelligenz“ in der Forschungsgemeinschaft fast verboten. Damit sie auf der Suche nach Finanzmitteln nicht als unpraktische Träumer wahrgenommen werden, verwendeten die Forscher andere Namen für Arbeiten im Zusammenhang mit SS - „Informatik“, „maschinelles Lernen“ und „Analytik“. Dieser zweite Winter der KI dauerte bis in die 2000er Jahre.

7. IBM Deep Blue besiegt Kasparov (1997)

IBM Deep Blue besiegte 1997 den weltbesten Schachspieler Garry Kasparov.

IBM Deep Blue besiegte 1997 den weltbesten Schachspieler Garry Kasparov.Das öffentliche Bewusstsein für KI verbesserte sich 1997, als der Deep Blue-Schachcomputer von IBM den damaligen Weltmeister Garry Kasparov besiegte. Von den sechs Spielen im Fernsehstudio gewann Deep Blue in zwei, Kasparov in einem und drei endeten unentschieden. Anfang des Jahres besiegte Kasparov die vorherige Version von Deep Blue.

Der Deep Blue-Computer verfügte über genügend Rechenleistung und verwendete die "Brute-Force-Methode" oder eine umfassende Suche, bei der 200 Millionen mögliche Bewegungen pro Sekunde ausgewertet und die beste ausgewählt wurden. Die Fähigkeiten der Menschen beschränken sich darauf, nach jedem Zug nur etwa 50 Züge zu bewerten. Die Arbeit von Deep Blue ähnelte der Arbeit von AI, aber der Computer dachte nicht über Strategien nach und lernte das Spiel nicht, wie es die darauf folgenden Systeme tun konnten.

Trotzdem brachte der Sieg von Deep Blue über Kasparov die KI eindrucksvoll in den Kreis der öffentlichen Aufmerksamkeit zurück. Einige Leute waren fasziniert. Anderen gefiel es nicht, dass die Maschine einen Schachexperten schlug. Die Anleger waren beeindruckt: Der Sieg von Deep Blue in Höhe von 10 US-Dollar erhöhte den Wert von IBM-Aktien und brachte sie auf das Maximum dieser Zeit.

8. Neuronales Netz sieht Katzen (2011)

Bis 2011 sprachen Wissenschaftler von Universitäten auf der ganzen Welt über neuronale Netze und schufen sie. Der Google-Programmierer

Jeff Dean traf in diesem Jahr den Stanford-IT-Professor

Andrew Eun . Gemeinsam konzipierten sie die Schaffung eines großen neuronalen Netzwerks, das durch die enorme Rechenleistung von Google-Servern bereitgestellt wird und eine große Anzahl von Bildern liefern kann.

Das von ihnen erstellte neuronale Netzwerk funktionierte auf 16.000 Serverprozessoren. Sie fütterten sie mit 10 Millionen zufälligen und unbeschrifteten Frames aus YouTube-Videos. Dean und Eun haben das neuronale Netzwerk nicht gebeten, bestimmte Informationen herauszugeben oder diese Bilder zu markieren. Wenn ein neuronales Netzwerk auf diese Weise funktioniert und ohne Lehrer lernt, versucht es natürlich, Muster in den Daten zu finden und Klassifikationen zu bilden.

Das neuronale Netzwerk verarbeitete die Bilder drei Tage lang. Dann produzierte sie drei verschwommene Bilder, die visuelle Bilder zeigten, die sie in den Trainingsdaten immer wieder traf - das Gesicht einer Person, den Körper einer Person und eine Katze. Diese Studie war ein wichtiger Durchbruch bei der Verwendung neuronaler Netze und beim Lernen von Nichtlehrern in der Bildverarbeitung. Es war auch der Start des Google Brain-Projekts.

9. Joffrey Hinton hat tiefe neuronale Netze freigesetzt (2012)

Joffrey Hintons Forschung hat das Interesse an tiefem Lernen wiederbelebt

Joffrey Hintons Forschung hat das Interesse an tiefem Lernen wiederbelebtEin Jahr nach dem Durchbruch schufen Dean und Un, Professor an der Universität von Toronto, Joffrey Hinton, und zwei seiner Studenten ein neuronales Netzwerk für Computer Vision, AlexNet, um am ImageNet-Bilderkennungswettbewerb teilzunehmen. Die Teilnehmer mussten ihre Systeme verwenden, um Millionen von Testbildern zu verarbeiten und sie mit der höchstmöglichen Genauigkeit zu identifizieren. AlexNet gewann den Wettbewerb mit einem Prozentsatz von Fehlern, der zweieinhalb Mal niedriger war als der des nächsten Konkurrenten. In fünf Versionen der Bildunterschrift des neuronalen Netzwerks gab es nur in 15,3% der Fälle keine korrekte Option. Der vorherige Datensatz war 26% der Fehler.

Dieser Sieg zeigte überzeugend, dass tiefe neuronale Netze auf GPUs laufen, wo Bilder besser als andere Systeme genau bestimmt und klassifiziert werden können. Dieses Ereignis beeinflusste vielleicht mehr als andere die Wiederbelebung des Interesses an tiefen neuronalen Netzen und brachte Hinton den Spitznamen "Pate des tiefen Lernens" ein. Zusammen mit anderen KI-Gurus, Yoshua Benjio und Jan Lekun, erhielt Hinton 2018 den lang erwarteten Turing Award.

10. AlphaGo besiegt den Weltmeister in go (2016)

2013 veröffentlichten Forscher des britischen Startups DeepMind einen Artikel, in dem beschrieben wurde, wie ein neuronales Netzwerk in 50 alten Atari-Spielen gelernt hat, zu spielen und zu gewinnen. Beeindruckt davon kaufte Google das Unternehmen - wie es heißt - für 400 Millionen US-Dollar. Der Hauptruhm von DeepMind lag jedoch noch vor uns.

Einige Jahre später wechselten Wissenschaftler von DeepMind, die sich jetzt im Google-Framework befinden, von Atari-Spielen zu einer der ältesten KI-Aufgaben - dem japanischen Brettspiel go. Sie entwickelten das neuronale AlphaGo-Netzwerk, das in der Lage ist, während des Spielens zu spielen und zu lernen. Das Programm hat Tausende von Spielen gegen andere Versionen von AlphaGo durchgeführt und dabei aus Verlusten und Gewinnen gelernt.

Und es hat funktioniert. AlphaGo besiegte den größten Go-Spieler der Welt,

Lee Sedola , im März 2016 mit 4: 1 in einer Reihe von Spielen. Der Prozess wurde für einen Dokumentarfilm gedreht. Beim Betrachten fällt es schwer, die Traurigkeit nicht zu bemerken, mit der Sedol den Verlust wahrnahm. Es schien, dass alle Menschen verloren haben und nicht nur eine Person.

Die jüngsten Fortschritte auf dem Gebiet der tiefen neuronalen Netze haben das Gebiet der KI so sehr verändert, dass ihre wahre Geschichte vielleicht erst am Anfang steht. Wir warten auf viele Hoffnungen, Hype und Ungeduld, aber jetzt ist klar, dass KI alle Aspekte des Lebens im 21. Jahrhundert beeinflussen wird - und vielleicht sogar mehr als das Internet auf einmal.