Entwickler der University of Edinburgh haben einen neuen Algorithmus zur Erstellung realistischer Charakterbewegungen in Spielen eingeführt. Das auf Motion Capture-Trajektorien trainierte neuronale Netzwerk versucht, die Bewegungen realer Personen zu kopieren, passt sie jedoch gleichzeitig an die Charaktere von Videospielen an.

Ein neuronales Netzwerk kann mehrere Aktionen im Spiel gleichzeitig verwalten. Türen öffnen, Gegenstände bewegen, Möbel benutzen. Gleichzeitig ändert sie dynamisch die Position der Beine und Arme, so dass die Figur Schubladen unterschiedlicher Größe realistisch halten, auf Stühlen unterschiedlicher Größe sitzen und auch in Passagen unterschiedlicher Höhe kriechen kann.

Unter der Kontrolle von Charakteren in Spielen mit KI bedeutet dies normalerweise die vollständige Kontrolle der Anstrengungen in den Gliedmaßen, basierend auf einer Art physischer Engine, die die Gesetze der Physik nachahmt. Dies ist die Domäne des maschinellen Lernens, die als Reinforcement Learning bezeichnet wird. Auf diese Weise

können leider

noch keine realistischen Bewegungen erzielt werden.

Auf der anderen Seite können Sie versuchen, das neuronale Netzwerk so zu trainieren, dass die Bewegungen realer Personen simuliert werden, die mit Motion Capture erfasst wurden. Auf diese Weise wurden vor etwa einem Jahr erhebliche Fortschritte bei der realistischen Animation von 3D-Zeichen erzielt.

Es gab mehrere aufeinanderfolgende wissenschaftliche Arbeiten zu diesem Thema, aber die vollständigste Beschreibung findet sich in

Towards a Virtual Stuntmans Arbeit über das neuronale DeepMimic-Netzwerk (

https://www.youtube.com/watch?v=vppFvq2quQ0 ).

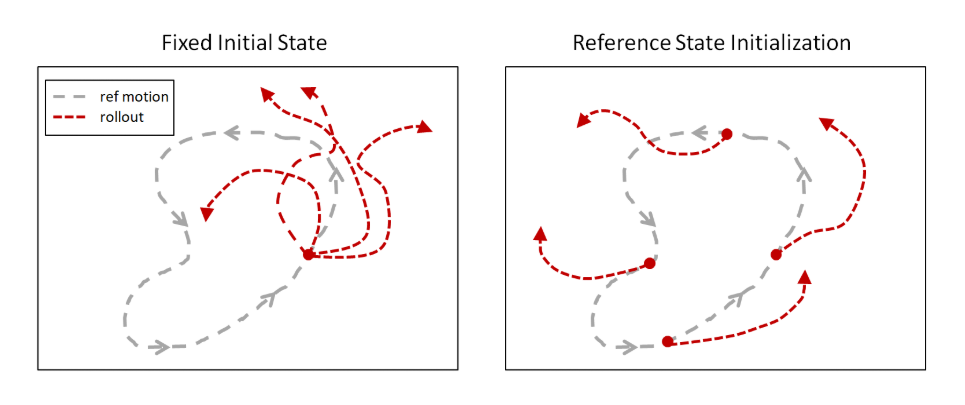

Die Hauptidee besteht darin, menschliche Bewegungen während des Trainings zu simulieren, um die Episode nicht wie zuvor am Anfang des Motion Capture-Tracks zu starten, sondern an zufälligen Punkten entlang des gesamten Pfades. Bestehende Algorithmen für das Verstärkungslernen untersuchen die Nachbarschaft des Startpunkts, sodass sie meistens nicht das Ende der Flugbahn erreichten. Wenn jedoch jede Episode entlang der gesamten Spur beginnt, steigt die Wahrscheinlichkeit, dass das neuronale Netzwerk lernt, die gesamte Flugbahn zu wiederholen.

Später wurde diese Idee in ganz anderen Bereichen aufgegriffen. Zum Beispiel brachte OpenAI dem neuronalen Netzwerk

bei, Montezumas Rache zu spielen , indem es den Menschen beibrachte, ein neuronales Netzwerk in Spielen zu spielen, und Episoden nicht von Anfang an, sondern von zufälligen Punkten aus (insbesondere in diesem Fall vom Ende bis zum Beginn) begann. Was bisher nicht den üblichen Reinforcement Learning-Algorithmen entsprach.

Ohne diesen Trick scheiterten Versuche, das neuronale Netzwerk zum Kopieren komplexer Bewegungen zu trainieren, weil das neuronale Netzwerk einen kürzeren Weg fand. Es gab zwar keine so große Belohnung wie für die gesamte Flugbahn, aber dennoch gab es eine Art Belohnung. Anstatt beispielsweise einen Salto zurück zu machen, prallte das neuronale Netzwerk einfach leicht ab und fiel auf den Rücken.

Mit diesem Ansatz untersucht das neuronale Netzwerk jedoch problemlos die Flugbahn nahezu jeder Komplexität.

Das Hauptproblem von DeepMimic, das eine direkte Anwendung auf Videospiele verhinderte, besteht darin, dass es nicht möglich war, das neuronale Netzwerk so zu trainieren, dass mehrere verschiedene Animationen gleichzeitig ausgeführt werden. Für jede Animation musste ein eigenes neuronales Netzwerk trainiert werden. Die Autoren versuchten, sie auf unterschiedliche Weise zu kombinieren, aber mehr als 3-4 Animationen konnten nicht kombiniert werden.

In der neuen Arbeit ist dieses Problem ebenfalls nicht vollständig gelöst, es wurden jedoch große Fortschritte auf dem Weg zu einem reibungslosen Übergang zwischen verschiedenen Animationen erzielt.

Es ist zu beachten, dass dieses Problem alle derzeit vorhandenen ähnlichen neuronalen Animationsnetzwerke betrifft. Zum Beispiel kann

dieses neuronale Netzwerk , das ebenfalls auf die Nachahmung von Motion Capture trainiert ist, eine große Anzahl von Muskeln (326!) Mit humanoidem Charakter auf einer physischen Engine ehrlich steuern. Anpassung an unterschiedliche Gewichte von angehobenen Gewichten und verschiedene Gelenkverletzungen. Gleichzeitig wird für jede Animation ein separat trainiertes neuronales Netzwerk benötigt.

Es versteht sich, dass das Ziel solcher neuronalen Netze nicht nur darin besteht, die menschliche Animation zu wiederholen. Und wiederholen Sie es auf der Physik-Engine. Gleichzeitig machen Reinforcement Learning-Algorithmen dieses Training zuverlässig und störungsresistent. Dann kann ein solches neuronales Netzwerk auf einen physischen Roboter übertragen werden, der sich in der Geometrie oder in der Masse von einer Person unterscheidet, aber dennoch die Bewegungen von Menschen realistisch wiederholt (wie bereits erwähnt, wurde dieser Effekt, wie bereits erwähnt, noch nicht erreicht). Oder wie in der obigen Arbeit können Sie virtuell untersuchen, wie sich eine Person mit Beinverletzungen bewegt, um bequemere Prothesen zu entwickeln.

Schon im ersten DeepMimic gab es die Anfänge einer solchen Anpassung. Es war möglich, den roten Ball zu bewegen, und der Charakter warf den Ball jedes Mal auf ihn. Ziel und Messung der Wurfkraft, um das Ziel genau zu treffen. Obwohl er auf der einzigen Motion Capture-Spur trainiert wurde, bietet dies keine solche Möglichkeit.

Daher kann dies als vollwertiges KI-Training angesehen werden, und die Nachahmung menschlicher Bewegungen ermöglicht es Ihnen einfach, das Lernen zu beschleunigen und Bewegungen visuell attraktiver zu machen, was uns vertraut ist (obwohl sie aus Sicht des neuronalen Netzwerks möglicherweise nicht gleichzeitig die optimalsten sind).

Neue Arbeiten sind noch weiter in diese Richtung gegangen.

Es gibt keine physische Engine, es ist ein reines Animationssystem für Videospiele. Der Schwerpunkt liegt jedoch auf dem realistischen Umschalten zwischen mehreren Animationen. Und um mit Spielgegenständen zu interagieren: Gegenstände bewegen, Möbel benutzen, Türen öffnen.

Die Architektur des neuronalen Netzes besteht aus zwei Teilen. Ein (Gating-Netzwerk) wählt basierend auf dem aktuellen Status des Status und dem aktuellen Ziel aus, welche Animation verwendet werden soll, und das andere (Bewegungsvorhersagenetzwerk) sagt die nächsten Frames der Animation voraus.

All dies wurde auf einer Reihe von Motion Capture-Spuren mithilfe von Simulation Reinforcement Learning trainiert.

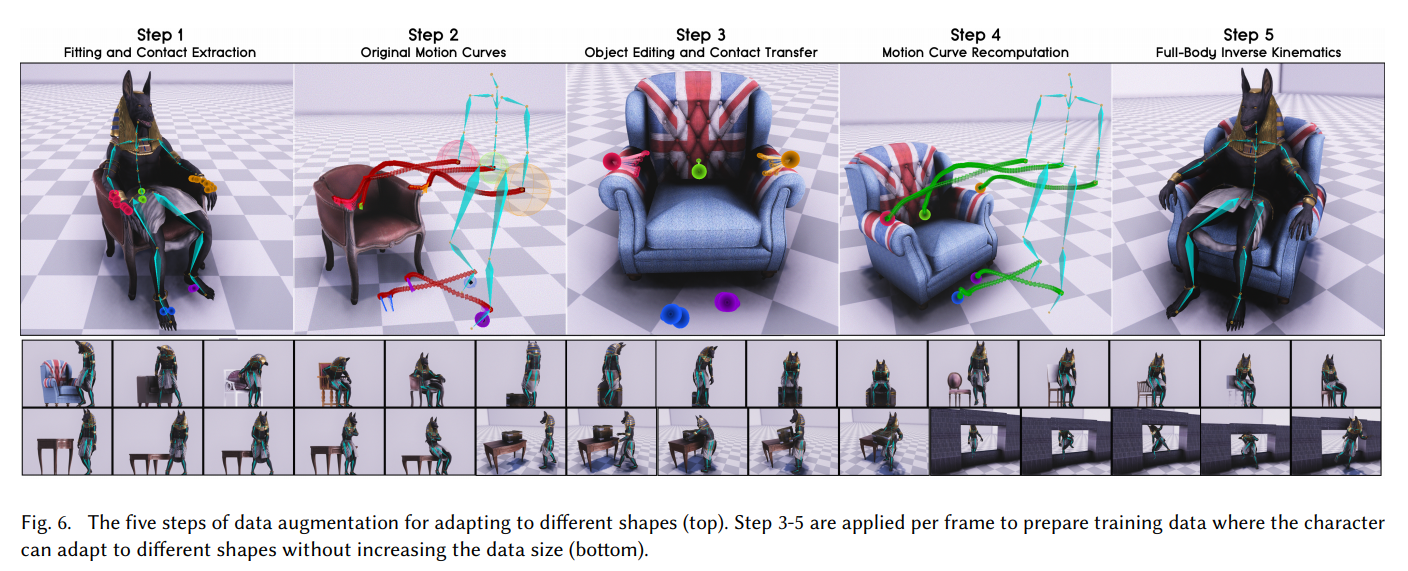

Die Hauptleistung dieser Arbeit ist jedoch anders. Wie die Entwickler dem neuronalen Netzwerk beigebracht haben, mit Objekten unterschiedlicher Größe zu arbeiten und sich in Passagen unterschiedlicher Breite oder Höhe zu quetschen. Damit die Positionen der Arme und Beine realistisch aussehen und der Größe des Objekts entsprechen, mit dem der Charakter im Spiel interagiert.

Das Geheimnis war einfach: Augmentation!

Zunächst bestimmten sie anhand der Motion Capture-Spur die Kontaktpunkte der Hände mit den Armlehnen des Stuhls. Dann ersetzten sie das Modell des Stuhls durch ein breiteres und berechneten die Motion Capture-Flugbahn neu, sodass die Hände die Armlehnen an denselben Stellen berührten, jedoch auf einem breiteren Stuhl. Und sie zwangen das neuronale Netzwerk, diese neue Flugbahn zu simulieren, die von Motion Capture generiert wurde. Ähnlich verhält es sich mit den Abmessungen der Kästen, der Höhe der Gänge usw.

Das neuronale Netzwerk hat dies viele Male mit verschiedenen 3D-Modellen der Umgebung wiederholt, mit denen der Spieler interagieren wird, und gelernt, mit Objekten unterschiedlicher Größe realistisch umzugehen.

Um mit der Umgebung im Spiel selbst zu interagieren, mussten die Objekte zusätzlich voxelisiert werden, damit sie als Sensoren am Eingang des neuronalen Netzwerks fungierten.

Das Ergebnis war eine sehr gute Animation für die Spielfiguren. Mit reibungslosen Übergängen zwischen Aktionen und der Fähigkeit, realistisch mit Objekten unterschiedlicher Größe zu interagieren.

Ich empfehle dringend, das Video anzuschauen, falls dies noch nicht geschehen ist. Es wird ausführlich beschrieben, wie sie dies erreicht haben.

Dieser Ansatz kann für Animationen verwendet werden, einschließlich vierbeiniger Tiere, um die unübertroffene Qualität und den Realismus der Bewegungen von Tieren und Monstern zu erzielen:

Referenzen

VideoProjektseite mit QuellePDF-Datei mit einer detaillierten Beschreibung der Arbeit:

SIGGRAPH_Asia_2019 / Paper.pdf