Dell

wird den leistungsstärksten

industriellen Supercomputer der Geschichte entwickeln. Eine neue Installation namens HPC5 wird eine Verarbeitungsleistung von 52 Pflops haben.

HPC4-Supercomputer im Green Eni-Rechenzentrum , Provinz Pavia, Italien

HPC4-Supercomputer im Green Eni-Rechenzentrum , Provinz Pavia, ItalienKunde ist Eni, ein Ölunternehmen, das bereits einen Dell 18 HPF4-Supercomputer besitzt. Das neue 52-Pflops-System wird vollständig mit dem Vorgängermodell kompatibel sein, sodass Eni einen Mini-Cluster aus zwei Supercomputern mit einer Gesamtrechenleistung von 70 Pflops erstellen wird. Dies ist die produktivste Installation

in der Geschichte der Industrie .

Der neue Supercomputer wird aus 1820 Serverknoten Dell EMC PowerEdge C4140 zusammengesetzt. An Bord werden jeweils zwei Intel Xeon Gold 6252-Prozessoren mit 24 Kernen sowie vier NVIDIA V100-Beschleuniger installiert. Es ist geplant, InfiniBand HDR als Verbindung zu verwenden. Ein Netzwerk mit einer nicht blockierenden Topologie wird auf Mellanox-Lösungen aufbauen, die mit einer Geschwindigkeit von bis zu 200 Gbit / s arbeiten. Das Speichersystem wird von einem Array von 15 Pbytes mit einer Gesamtlese- / Schreibgeschwindigkeit von 200 GB / s bedient.

Die Hauptaufgabe des neuen Systems ist die Arbeit mit Big Data. Der Supercomputer wird im eigenen Rechenzentrum von Green Eni installiert, in dem der vorhandene HPC4 bereits installiert ist.

HPC4-Supercomputer im Green Eni-Rechenzentrum , Provinz Pavia, Italien

HPC4-Supercomputer im Green Eni-Rechenzentrum , Provinz Pavia, ItalienLaut der Bewertung von

top500.org war im Juli 2019 der leistungsstärkste Supercomputer die Installation von IBM auf der Basis des

IBM Power System AC922 mit 148,6 Pflops . Sie wurde jedoch im Oak Ridge National Laboratory installiert und nicht für die Produktion, sondern für wissenschaftliche Berechnungen verwendet. Laut Open Source forscht das Labor seit 1942 in folgenden Bereichen: Materialwissenschaft, Neutronenphysik, Energie, Hochleistungsrechnen, Systembiologie.

IBM Supercomputer am Oak Ridge National Laboratory der Universität von Tennessee, USA

IBM Supercomputer am Oak Ridge National Laboratory der Universität von Tennessee, USADer derzeit leistungsstärkste Supercomputer gehört der US-Regierung und ist in der „wissenschaftlichen Arbeit“ tätig. Der Cluster aus HPC4 und HPC5 von Dell wird wiederum einer privaten Ölgesellschaft gehören und sich mit spezifischen Anwendungen aus der Branche befassen. Das Unternehmen selbst sagt, dass neue Kapazitäten darauf abzielen werden, das Problem der Lagerstätten zu lösen, die in dieser Phase der industriellen Entwicklung nicht zurückgewonnen werden können. Wir sprechen von Lagerstätten in geologisch instabilen oder für sichere Bohrzonen unmöglichen Lagerstätten.

Die Forderung nach Arbeit mit Big Data aus dem Ölgeschäft ist eine logische Entwicklung des gesamten Bereichs der Kohlenwasserstoffproduktion, sodass der Kauf der leistungsstärksten Recheneinheiten durchaus vorhersehbar ist. Alle großen Ölunternehmen auf der Welt müssen jetzt eine große Datenmenge analysieren, Prognosen für Bohrungen und Explorationen erstellen.

Fast alle führenden Ölunternehmen investieren jetzt aktiv in maschinelles Lernen und Big-Data-Verarbeitungssysteme: Der Fortschritt ermöglicht es, Telemetrie direkt aus dem Bohrloch zu entnehmen, ohne dass eine Kernextraktion in Form einer Steinsäule erforderlich ist.

Mit modernen maschinellen Lernsystemen können Sie das neuronale Netzwerk trainieren, um die aus dem Bohrloch gewonnenen Rohdaten zu analysieren und zu interpretieren. Dadurch werden Wissenschaftler entlastet und können mit einer relevanten Datenprobe arbeiten, anstatt Tausende von Diagrammen anzuzeigen. Es ist wahrscheinlich, dass der neue Cluster von HPC4 und HPC5 genau mit dem Training und Betrieb des neuronalen Netzwerks beschäftigt sein wird, das die erste Analyse der Telemetrie von Eni-Bohrgeräten übernehmen wird.

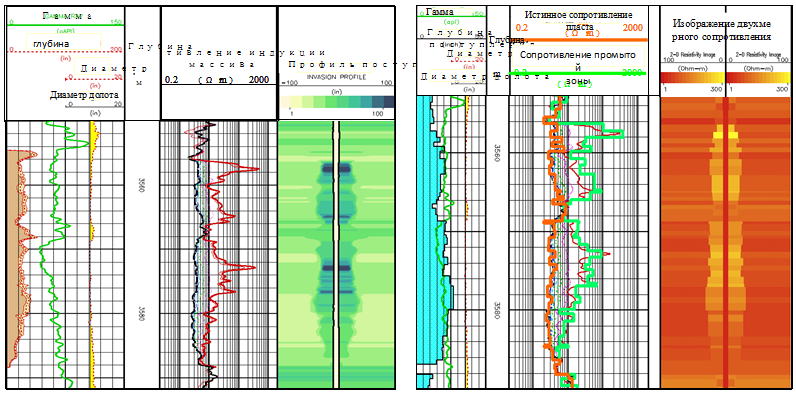

Ein Beispiel für die Protokollierung von Kurven für mehrere Parameter

Ein Beispiel für die Protokollierung von Kurven für mehrere ParameterNeuronale Netze analysieren auch die Parameter des Feldes in einer Vielzahl von Parametern, von der Tiefe bis zur Intensität der radioaktiven Strahlung. Bis vor kurzem wurde die Erstellung und Analyse von Protokollierungskurven jedoch manuell von Geologen durchgeführt. Neue industrielle Supercomputer und die Analyse von Big Data mithilfe neuronaler Netze werden den Wissenschaftlern diese monotone Belastung nehmen, sodass sie ihre Stärke und Energie in andere Richtungen nutzen können.