Der Übergang zu Kubernetes- und Linux-Infrastrukturen während der digitalen Transformation von Organisationen führt dazu, dass Anwendungen zunehmend auf der Basis von Microservice-Architekturen aufgebaut werden und daher häufig von komplexen Anforderungsrouting-Schemata zwischen Diensten umgeben sind.

Bei Red Hat OpenShift Service Mesh gehen wir über das herkömmliche Routing hinaus und bieten Komponenten zur Verfolgung und Visualisierung solcher Anforderungen an, um die Serviceinteraktion einfacher und zuverlässiger zu gestalten. Die Einführung einer speziellen logischen Verwaltungsebene, des sogenannten Service Mesh

Service Mesh , vereinfacht die Verbindung, Steuerung und Betriebsverwaltung auf der Ebene jeder einzelnen Anwendung, die auf Red Hat OpenShift, der führenden Kubernetes-Plattform der Enterprise-Klasse, bereitgestellt wird.

Red Hat OpenShift Service Mesh wird als spezieller Kubernetes-Operator angeboten, den Sie hier in Red Hat OpenShift 4 ausprobieren können.

Verbessertes Tracking, Routing und Optimieren der Kommunikation auf Anwendungs- und Serviceebene

Es ist sehr schwierig und manchmal unmöglich, die Kommunikation auf der Ebene „Service-to-Service“ kohärent und einheitlich zu verwalten und zu verwalten, wenn nur Hardware-Load-Balancer, spezielle Netzwerkgeräte und andere Lösungen eines ähnlichen Plans verwendet werden, die in modernen IT-Umgebungen zur Norm geworden sind zwischen Anwendungen und ihren Diensten. Mit der Einführung einer zusätzlichen Ebene des Service-Mesh-Managements können containerisierte Anwendungen ihre Kommunikation mit Kubernetes als Kern der Plattform besser überwachen, leiten und optimieren. Service Mesh vereinfacht das hybride Lastmanagement mit mehreren Standorten und ermöglicht eine genauere Kontrolle des Datenstandorts. Mit der Veröffentlichung des OpenShift Service Mesh hoffen wir, dass diese wichtige Komponente des Microservice-Technologiepakets die Fähigkeit des Unternehmens zur Implementierung von Multi-Cloud- und Hybrid-Strategien erweitert.

Das OpenShift Service Mesh basiert auf mehreren Open-Source-Projekten wie Istio, Kiali und Jaeger und ermöglicht die Programmierung der Kommunikationslogik im Rahmen der Microservice Application Architecture. Auf diese Weise können sich die Entwicklungsteams voll und ganz auf die Entwicklung von Anwendungen und Diensten konzentrieren, die geschäftliche Probleme lösen.

Entwicklern das Leben leichter machen

Wie wir bereits geschrieben haben , lag ein großer Teil der Arbeit zur Verwaltung komplexer Interaktionen zwischen Diensten vor dem Erscheinen des Servicegitters auf den Schultern der Anwendungsentwickler. Unter diesen Umständen benötigen sie eine ganze Reihe von Tools für die Verwaltung des Anwendungslebenszyklus, angefangen von der Überwachung der Ergebnisse der Codebereitstellung bis hin zur Verwaltung des Anwendungsverkehrs in der Produktion. Damit die Anwendung erfolgreich funktioniert, müssen alle Dienste normal miteinander interagieren. Mithilfe der Ablaufverfolgung kann der Entwickler nachverfolgen, wie die einzelnen Dienste mit anderen Funktionen interagieren, und Engpässe identifizieren, die zu unnötigen Verzögerungen bei der tatsächlichen Arbeit führen.

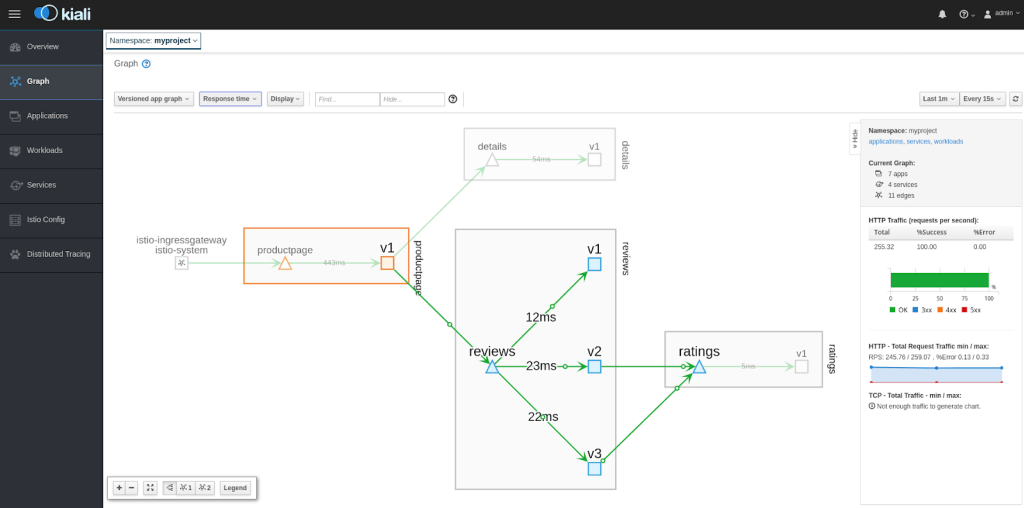

Die Fähigkeit, Verbindungen zwischen allen Diensten zu visualisieren und die Interaktionstopologie zu sehen, hilft auch dabei, das komplexe Bild von Interaktionen zwischen Diensten besser zu verstehen. Red Hat kombiniert diese nützlichen Funktionen mit dem OpenShift Service Mesh und bietet dem Entwickler eine Reihe erweiterter Tools, die für die erfolgreiche Entwicklung und Bereitstellung von Cloud-Mikrodiensten erforderlich sind.

Um die Erstellung eines Servicenetzes zu vereinfachen, können Sie mit unserer Lösung diese Steuerungsebene mithilfe des entsprechenden Kubernetes-Operators auf einfache Weise in eine vorhandene OpenShift-Instanz implementieren. Dieser Operator übernimmt die Aufgaben der Installation, Netzwerkintegration und Betriebsverwaltung aller erforderlichen Komponenten. So können Sie das neu erstellte Service-Mesh sofort für die Bereitstellung realer Anwendungen verwenden.

Wenn Sie die Personalkosten für die Implementierung und Verwaltung des Servicegitters senken, können Sie schnell Anwendungskonzepte erstellen und implementieren, ohne die Kontrolle über die sich entwickelnde Situation zu verlieren. Warum warten, bis sich das Management der dienstübergreifenden Kommunikation zu einem echten Problem entwickelt? Das OpenShift Service Mesh bietet die notwendige Skalierbarkeit, noch bevor Sie es wirklich brauchen.

Die Liste der Vorteile, die das OpenShift Service Mesh OpenShift-Benutzern bietet, umfasst:

- Rückverfolgung und Überwachung (Jaeger). Die Aktivierung des Servicenetzes zur Verbesserung der Verwaltbarkeit kann mit einer gewissen Leistungsverschlechterung einhergehen. Daher kann das OpenShift-Servicenetz das grundlegende Leistungsniveau messen und diese Daten zur weiteren Optimierung verwenden.

- Visualisierung (Kiali). Eine visuelle Darstellung des Service-Netzes hilft dabei, die Topologie des Service-Netzes und das Gesamtbild der Interaktion von Services zu verstehen.

- Kubernetes Betreiber Service Mesh. Minimiert den Verwaltungsaufwand für die Verwaltung von Anwendungen und ermöglicht die Automatisierung von Standardaufgaben wie Installation, Wartung und Lebenszyklusverwaltung des Dienstes. Durch Hinzufügen von Geschäftslogik können Sie die Verwaltung weiter vereinfachen und die Einführung neuer Funktionen in der Produktion beschleunigen. Der OpenShift Service Mesh-Operator stellt die Pakete Istio, Kiali und Jaeger bereit, einschließlich der Konfigurationslogik, die alle erforderlichen Funktionen auf einmal implementiert.

- Unterstützung für mehrere Netzwerkschnittstellen (Multus). Das OpenShift Service Mesh eliminiert manuelle Vorgänge und ermöglicht dem Entwickler, den Code im erweiterten Sicherheitsmodus mit SCC (Security Context Constraint) auszuführen. Insbesondere wird eine zusätzliche Isolierung von Workloads im Cluster bereitgestellt. Beispielsweise können Sie für den Namespace angeben, welche Loads als Root ausgeführt werden können und welche nicht. Infolgedessen ist es möglich, die von Entwicklern geforderten Vorteile von Istio mit den genau definierten Sicherheitsmaßnahmen zu kombinieren, die Clusteradministratoren benötigen.

- Integration mit der Red Hat 3scale API-Verwaltung. Für Entwickler oder IT-Betreiber, die eine erhöhte Sicherheit für den Zugriff auf Service-APIs benötigen, bietet OpenShift Service Mesh eine standardmäßige Red Hat 3scale Istio Mixer Adapter-Komponente, mit der Sie im Gegensatz zum Service-Mesh die dienstübergreifende Kommunikation auf API-Ebene steuern können.

In Bezug auf die Weiterentwicklung der Service-Mesh-Technologien gab Red Hat zu Beginn dieses Jahres die Teilnahme am Branchenprojekt

Service Mesh Interface (SMI) bekannt , mit dem die Interoperabilität dieser Technologien verschiedener Anbieter verbessert werden soll. Die Zusammenarbeit im Rahmen dieses Projekts wird uns dabei helfen, Benutzern von Red Hat OpenShift eine breitere und flexiblere Auswahl zu bieten und die neue Ära näher zu bringen, wenn wir Entwicklern der NoOps-Klassenumgebung anbieten können.

Probieren Sie OpenShift aus

Service-Mesh-Technologien können die Verwendung von Microservice-Stacks in einer Hybrid-Cloud erheblich vereinfachen. Aus diesem

Grund empfehlen wir jedem, der Kubernetes und Container aktiv verwendet

, das Red Hat OpenShift Service Mesh zu testen .