Die Welt um uns herum verändert sich ständig und kontinuierlich, ob wir es wollen oder nicht. Eine große Rolle spielen dabei Technologien, deren Entwicklung und Verbreitung von Jahr zu Jahr aktiver wird. Wir betrachten das Auto nicht mehr als eine Seltenheit, sondern die mobile Kommunikation als Magie. Technologie ist zu einem Teil unseres täglichen Lebens, unserer Arbeit und uns selbst geworden. Eines der beliebtesten Themen unter Futurologen und Science-Fiction-Autoren waren schon immer Roboter - autonome Maschinen, die einem Menschen das Leben erleichtern oder laut Filmen über den Terminator den totalen Völkermord an allem Leben auf dem Planeten anrichten können. Auf jeden Fall bleiben eine Reihe sehr lustiger Fragen offen - wie wird sich ein Mensch mit einer Maschine verhalten, wird er ihr vertrauen und wie effektiv wird seine Zusammenarbeit sein? Wissenschaftler des Forschungslabors der US-Armee beschlossen, eine Reihe von Experimenten durchzuführen, um festzustellen, welche Aspekte des Verhaltens und des Erscheinungsbilds einer autonomen Maschine die Zusammenarbeit mit Menschen verbessern. Was genau wir herausgefunden haben, erfahren wir aus ihrem Bericht. Lass uns gehen

Studienbasis

Um die Beziehung zwischen Mensch und Maschine besser zu verstehen, sollten Sie zuerst die Beziehung zwischen Mensch und Mensch betrachten. Angesichts der Tatsache, dass die Bevölkerung des Planeten in viele Gruppen (Religion, Nationalität, ethnische Zugehörigkeit usw.) unterteilt ist, wird eine Person die Menschen immer in „wir“ und „sie“ aufteilen. Dieser Trennungsprozess verläuft nach Ansicht der Forscher unbewusst und führt zu einer erhöhten Wahrscheinlichkeit, eine Person zu wählen, die derselben Gruppe für die Zusammenarbeit angehört. Wissenschaftler stellen auch fest, dass diese Präferenzen nichts mit Manifestationen der Diskriminierung von Menschen anderer Nationalitäten, Religionen und anderen Dingen zu tun haben.

Bei autonomen Maschinen bleibt unklar, ob eine solche soziale Kategorisierung zum Zeitpunkt des Zusammenwirkens von Mensch und Maschine stattfindet. Wenn ja, wie manifestiert es sich, wie wird es reguliert und wie kann es verändert werden?

Um dies zu testen, führten Wissenschaftler eine Reihe von Experimenten durch, an denen Menschen aus zwei entfernten Kulturen (USA und Japan) und Autos mit virtuellen Gesichtern teilnahmen, die denselben Kulturen entsprachen und bestimmte Emotionen ausdrückten.

Es waren 468 Teilnehmer aus den USA und 477 aus Japan.

Demografische Merkmale für eine Gruppe aus den USA waren wie folgt:

- Geschlecht: 63,2% - Männer und 36,8% - Frauen;

- Alter: 0,9% - 18-21; 58,5% - 22-34; 21,6% - 35-44; 10,7% - 45-54; 6,2% - 55-64; 2,1% - über 64 Jahre alt;

- ethnische Zugehörigkeit: 77,3% - indoeuropäisch; 10,3% - Afroamerikaner; 1,3% - ostindisch; 9,2% - spanisch; 6,0% - Asiatisch (Südosten).

Demografische Merkmale für die Gruppe aus Japan waren wie folgt:

- Geschlecht: 67,4 - Männer und 32,6% - Frauen;

- Alter: 0,6% - 18-21; 15,7% - 22-34; 36,4% - 35-44; 34,7% - 45-54; 10,4% - 55-64; 2,1% - über 64 Jahre alt;

- Ethnizität: 0,6% - ostindisch; 99,4% - Asiatisch (Südosten).

Abhängig von der persönlichen Kategorisierung können Menschen auf unterschiedliche Weise miteinander in Beziehung stehen, aber es sollte nicht vergessen werden, dass eine autonome Maschine keine Person ist. Daher gehört dieses Gerät standardmäßig sozusagen bereits einer anderen sozialen Gruppe an. Natürlich kann eine Person eine Maschine als einen sozialen Akteur wahrnehmen (der an irgendeiner Art von Interaktion teilnimmt), aber er wird sie anders wahrnehmen, als er eine andere lebende Person aus Fleisch und Blut wahrnehmen würde.

Ein bemerkenswertes Beispiel dafür ist die frühere Untersuchung des menschlichen Gehirns während eines Spiels der "Stein-Papier-Schere". Wenn eine Person mit einer anderen Person spielte, wurde der mediale präfrontale Kortex aktiviert, der eine wichtige Rolle bei der

Mentalisierung spielt * .

Mentalisierung * - die Fähigkeit, den mentalen Zustand von sich selbst und anderen Menschen darzustellen.

Beim Spielen mit der Maschine wurde dieser Teil des Gehirns jedoch nicht aktiviert.

Ähnliche Ergebnisse zeigten Experimente mit dem Ultimatum-Spiel.

Das Ultimatum-Spiel * ist ein wirtschaftliches Spiel, bei dem Spieler Nr. 1 einen bestimmten Geldbetrag erhält und diesen mit Spieler Nr. 2 teilen muss, den er zum ersten Mal sieht. Das Angebot kann beliebig sein, aber wenn Spieler Nummer 2 es ablehnt, erhalten beide Spieler überhaupt kein Geld.

Als Spieler 2 ein unfaires Angebot von Spieler 1 (Mensch) erhielt, aktivierte er Abschnitte des zentralen Hirnlappens, die für die Bildung negativer Emotionen verantwortlich waren. Wenn Spieler 1 ein Auto war, wurde keine solche Reaktion beobachtet.

Solche Experimente bestätigen einmal mehr, dass eine Person eine Maschine anders wahrnimmt als eine andere Person. Einige Forscher glauben, dass die Maschine aus unserer Sicht keine Konkurrenz für uns darstellt, und daher gibt es eine ähnlich reduzierte (oder gar keine) Aktivität bestimmter Hirnregionen.

Alles ist ganz logisch: Der Mensch ist ein Wolf für den Menschen, aber auch zwischen Wölfen besteht ein gewisses Maß an Vertrauen und der Wunsch, unter bestimmten Bedingungen zusammenzuarbeiten. Aber das Auto wirkt wie ein Fuchs, mit dem die Wölfe vom Wort her überhaupt nicht kooperieren wollen. Solche Präferenzen heben jedoch nicht die Tatsache auf, dass es auf unserer Welt immer mehr Roboter gibt, und deshalb müssen wir Methoden finden, um die Beziehung zwischen uns und ihnen zu verbessern.

Warum haben sich Forscher für diese Art der sozialen Kategorisierung als kulturelle Identität entschieden? Erstens wurde bereits früher festgestellt, dass eine Person positiv auf Maschinen reagiert, die bestimmte Sprachmerkmale (z. B. Betonung), soziale Normen und Rasse aufweisen.

Zweitens wird in Fällen, in denen Vertreter verschiedener sozialer Gruppen an den Experimenten teilnehmen, in den ersten Phasen eine deutliche Verflechtung von Kooperation und Wettbewerb festgestellt. In den folgenden Phasen, in denen sich die Teilnehmer besser kennenlernen, wird eine klare Verhaltenslinie erstellt, die der Erfahrungsaufgabe entspricht. Einfach ausgedrückt, vertrauten sich Teilnehmer aus verschiedenen sozialen Gruppen überhaupt nicht, auch wenn die Erfahrungsaufgabe mit der Zusammenarbeit zusammenhängt. Aber nach einiger Zeit überwogen das Vertrauen und der Wunsch, die Aufgabe zu erfüllen, das unbewusste Misstrauen.

Drittens haben frühere Experimente gezeigt, dass die anfänglichen Erwartungen an eine Zusammenarbeit auf der Grundlage einer sozialen Kategorisierung verworfen werden können, wenn wir auf situationsbedingt signifikantere Zeichen (Emotionen) zurückgreifen.

Das heißt, die Forscher statteten die Maschine mit visuellen Merkmalen jener sozialen Gruppen aus, zu denen die Versuchsteilnehmer (Menschen) gehörten, und einer Reihe emotionaler Ausdrücke, und überprüften dann verschiedene Kombinationen, um die Verbindung zu identifizieren.

Aus all dem wurden zwei Haupthypothesen identifiziert. Die erste ist, dass die Assoziation positiver Zeichen kultureller Identität die ungünstigen Vorurteile abmildern kann, die Menschen standardmäßig gegenüber Maschinen haben. Zweitens kann der Ausdruck von Emotionen die auf der kulturellen Identität basierenden Erwartungen an Zusammenarbeit / Wettbewerb übertreffen. Mit anderen Worten, wenn Sie dem Auto visuelle Merkmale einer bestimmten kulturellen Gruppe verleihen, können Personen derselben Gruppe ihm unbewusster vertrauen. Bei der Manifestation bestimmter Emotionen, die auf die mangelnde Bereitschaft der Maschine zur Zusammenarbeit hinweisen, verlieren jedoch alle kulturellen Vorurteile augenblicklich ihre Bedeutung.

Interessanterweise basierte das Experiment auf dem Dilemma des Gefangenen - einem Spiel, in dem Kooperation keine Gewinnstrategie ist. Nach der Spieltheorie maximiert der Gefangene (Spieler) immer seinen eigenen Nutzen, ohne an die Vorteile anderer Spieler zu denken. Daher sollte die Rationalität die Spieler zu Verrat und mangelnder Kooperationsbereitschaft drängen. In Wirklichkeit sind die Ergebnisse solcher Experimente jedoch oftmals alles andere als rational, was das Vorhandensein des Wortes „Dilemma“ im Namen dieses mathematischen Spiels erklärt. Es gibt einen kleinen Haken: Wenn ein Spieler glaubt, dass der zweite nicht kooperiert, sollte er auch nicht kooperieren. Wenn jedoch beide Spieler einer solchen Taktik folgen, verlieren beide.

Versuchsergebnisse

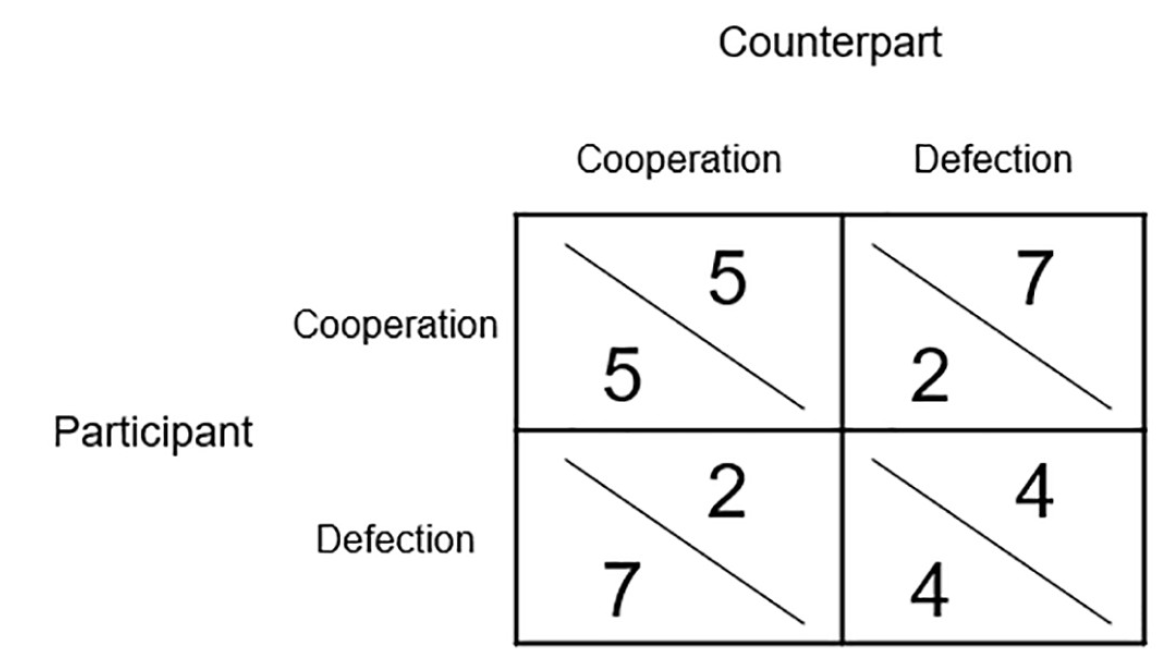

Bild Nr. 1

Bild Nr. 1Insgesamt hat jeder der Versuchsteilnehmer 20 Runden mit der Maschine gespielt. Das obige Bild ist eine Verstärkungsmatrix. Die während des Spiels erzielten Punkte hatten echte finanzielle Vorteile, da sie anschließend in Lottoscheine mit einem Gewinnbetrag von 30 USD umgewandelt wurden.

Das Hauptziel des Experiments war es, herauszufinden, wie die Teilnehmer mit Menschen oder Maschinen zusammenarbeiten / konkurrieren und wie kulturelle Identität und Emotionen diese Prozesse beeinflussen.

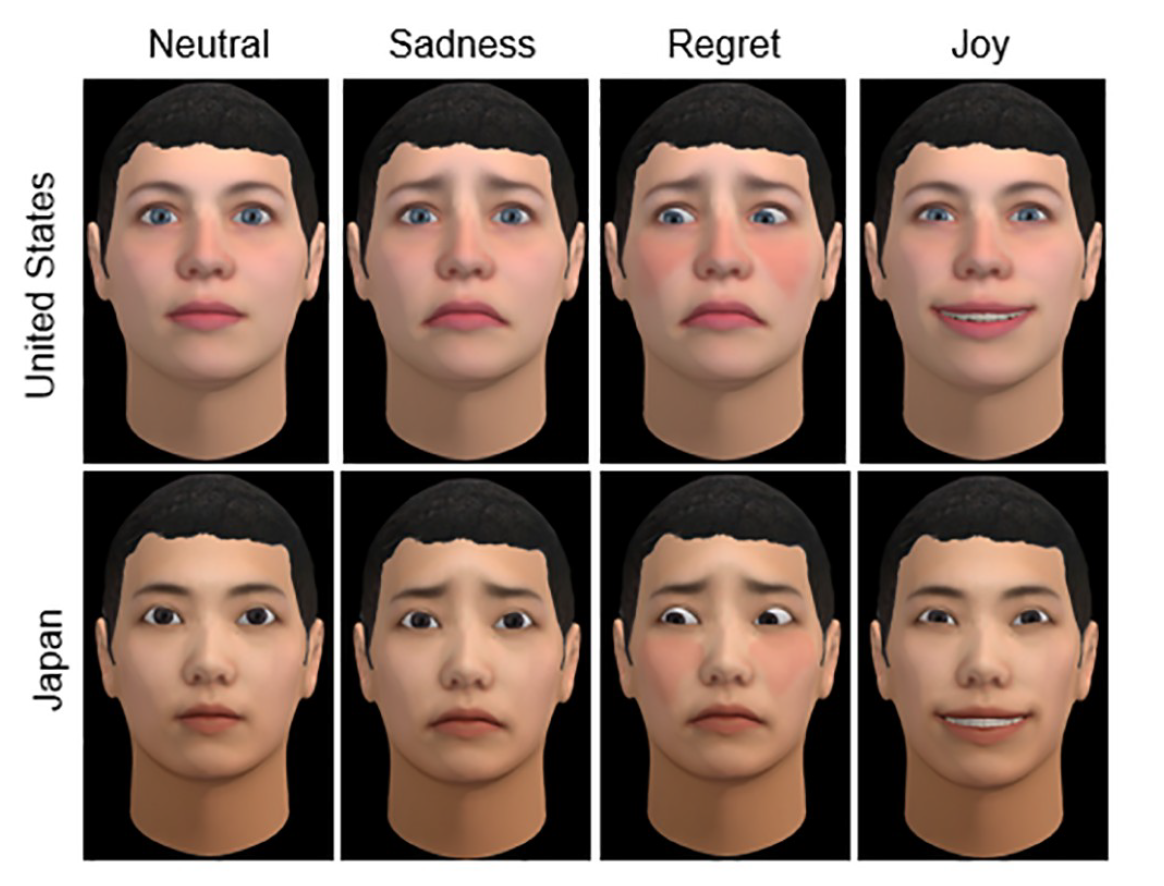

Bild Nr. 2

Bild Nr. 2Das Obige sind zwei kulturelle Identitäten (USA und Japan) von virtuellen Gesichtern für Maschinen, die unterschiedliche Emotionen ausdrücken (Neutralität, Traurigkeit, Bedauern und Freude). Es ist erwähnenswert, dass virtuelle Gesichter von allen Teilnehmern an den Experimenten verwendet wurden, d.h. Menschen und Autos.

Die emotionale Serie wurde nicht zufällig ausgewählt. Frühere Experimente mit dem Gefangenen-Dilemma haben gezeigt, dass einige Emotionen die Zusammenarbeit fördern können, während andere je nach der Zeit, in der sie zum Ausdruck gebracht werden, miteinander konkurrieren können.

In diesem Modell wurden die Emotionen der Maschine und die Aktionen, die sie verursachen, in zwei Hauptkategorien unterteilt.

Eine Person zum Wettbewerb drängen:

- Bedauern nach gegenseitiger Zusammenarbeit (die Maschine verpasste die Gelegenheit, ein menschliches Mitglied zu ihrem eigenen Vorteil zu betreiben);

- Freude nach der Operation (der Teilnehmer kooperiert, erhält aber keine Gegenleistung vom Auto);

- Traurigkeit nach gegenseitigem Wettbewerb / neutrale Emotionen nach gegenseitiger Zusammenarbeit.

Menschen zur Zusammenarbeit ermutigen:

- die Freude der gegenseitigen Zusammenarbeit;

- Bedauern über die Ausbeutung;

- Traurigkeit nach gegenseitigem Wettbewerb.

Somit gab es im Experiment mehrere Variablen gleichzeitig: kulturelle Identität (USA oder Japan), der deklarierte Partnertyp (Person oder Maschine) und geäußerte Emotionen (wettbewerbsorientiert oder kollaborativ).

Die Ergebnisse der Experimente wurden nach der Art der Teilnehmerpaare in zwei Kategorien unterteilt: Teilnehmer aus einer Kulturgruppe und Teilnehmer aus verschiedenen Kulturgruppen.

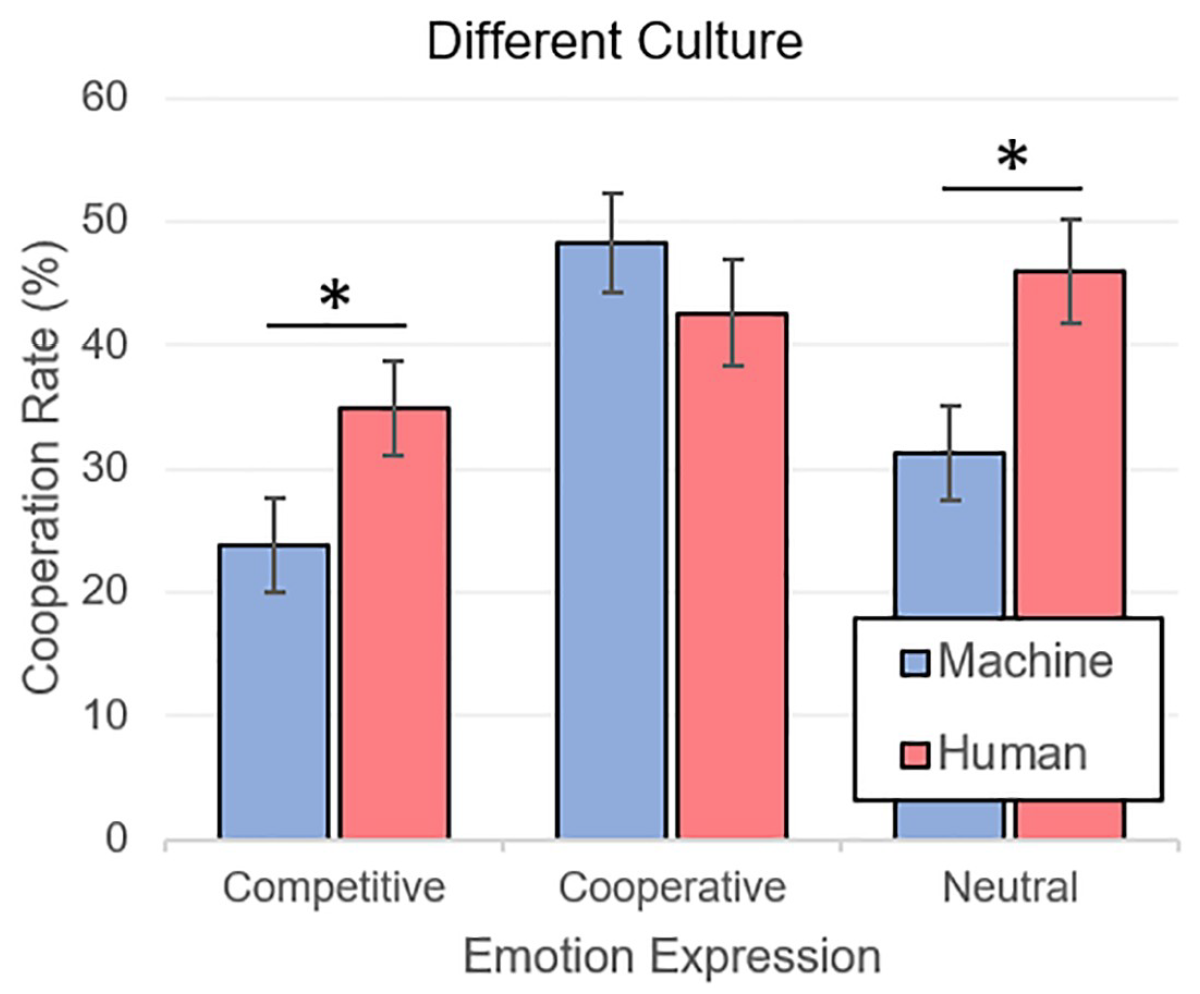

Bild Nr. 3

Bild Nr. 3Oben ist eine graphische Darstellung der Ergebnisse (Varianzanalyse, d. H. ANOVA) von Experimenten, bei denen verschiedene kulturelle Gruppen im Spiel zusammenkamen. Die Zusammenarbeit mit Menschen (M = 41,15, SE = 2,39) drückte sich erwartungsgemäß stärker aus als die Zusammenarbeit mit Maschinen (M = 34,45, SE = 2,25). In Bezug auf Emotionen war alles nicht weniger vorhersehbar - die Spieler arbeiteten häufiger mit denen zusammen, die Emotionen der Zusammenarbeit ausdrückten (M = 45,42, SE = 2,97) als mit Emotionen des Wettbewerbs (M = 29,34, SE = 2,70). Auch die neutralen Emotionen (M = 38,63, SE = 2,85) übertrafen die konkurrierenden.

Es ist merkwürdig, dass die Emotionen, die das Vertrauen in menschliche Spieler wecken, die Tatsache, dass sie mit dem Automaten spielen, vollständig neutralisierten und so das Misstrauen verringerten.

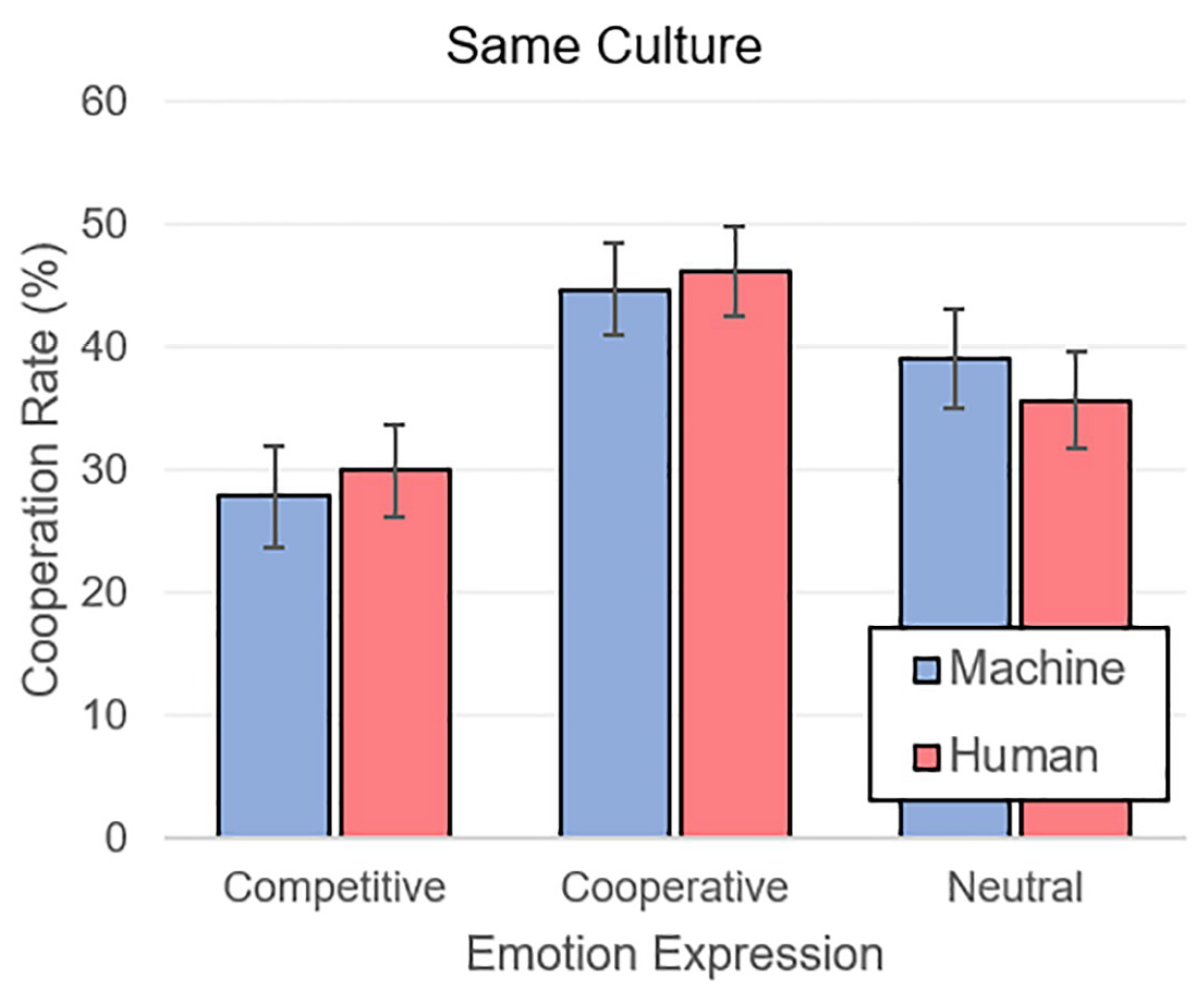

Bild Nr. 4

Bild Nr. 4Als die Teilnehmer auf Partner aus derselben Kulturgruppe stießen, war die Situation ähnlich. Kooperative (M = 45,55, SE = 2,61) Emotionen überwogen die neutralen (M = 37,42, SE = 2,81) und kompetitiven (M = 28,99, SE = 2,78).

Die Gesamtheit der Ergebnisse macht deutlich, dass eine Person in der Kommunikation mit einer Maschine dieselben psychologischen Parameter von Vertrauen und Misstrauen verwendet wie eine andere Person. Autonome Autos werden zunächst als Mitglieder einer sozialen Gruppe wahrgenommen, die der Person fremd ist. Die Verwendung eines visuellen Gesichts mit Merkmalen einer bestimmten kulturellen Identität, die dem menschlichen Partner angemessen sind, kann jedoch das Misstrauen gegenüber der Maschine lindern.

Die wichtigste Beobachtung ist, dass kulturelle Identität und Zugehörigkeit zu Maschinen durch die richtigen Emotionen sozusagen vollständig ausgeglichen werden.

Um die Nuancen der Studie genauer kennenzulernen, empfehle ich Ihnen, in den

Bericht der Wissenschaftler zu schauen.

Nachwort

Diese Studie ist sehr vieldeutig, zeigt uns jedoch ein wichtiges Merkmal der menschlichen Psychologie. Wir kategorisieren die Menschen um uns herum unbewusst in bestimmte soziale Gruppen und erleben ein größeres Vertrauen in diejenigen, die zu unserer Gruppe gehören. Dies ist unsere primäre Reaktion. Es ist jedoch nicht die einzige, da wir bei der Kommunikation mit einer Person eine Reihe von Signalen (visuell und akustisch) empfangen, die durch Emotionen, Sprechweise, Stimme usw. ausgedrückt werden. Diese Signale ergänzen das Bild der Repräsentation einer Person für uns, von dem wir im Moment der Entscheidung, ob wir vertrauen oder nicht, abgewiesen werden. Mit anderen Worten, die soziale Kategorisierung, die in unseren Köpfen stattfindet, spielt keine Rolle, wenn es um lebendige Kommunikation geht. Dies ist, was die alten Sprüche sagen: "Sie werden von Kleidern begrüßt, aber vom Verstand begleitet" und "beurteilen Sie ein Buch nicht nach seinem Einband".

In Bezug auf Autos war eine Person immer mit Besorgnis und Misstrauen konfrontiert, die oft nicht durch wichtige Gründe gestützt wurden. Das ist die Natur des Menschen - zunächst das Fremde abzulehnen. Doch so wie Wissen Unwissenheit besiegt, besiegt auch die tatsächliche Interaktion mit autonomen Maschinen, die in der Lage sind, Gefühle auszudrücken, menschliche Vorurteile.

Bedeutet das, dass alle Roboter in der Zukunft Emotionen haben sollten? Ja und nein Forscher, deren Arbeit wir heute untersucht haben, glauben, dass in den ersten paar Emotionen für Roboter eine hervorragende Funktion sein wird, die den Prozess der Übernahme autonomer Maschinen durch eine Gesellschaft von Menschen beschleunigen kann. Was kann ich sagen, um mit Wölfen zu leben - heulen wie ein Wolf, egal wie unhöflich es sich anhört.

Darüber hinaus verleihen wir Robotern bereits unsere eigenen Merkmale: Wir machen sie zu Augen wie unsere, zu Gesichtern wie unsere, geben ihnen Stimmen und Emotionen. Eine Person wird immer versuchen, das Auto zu humanisieren, und wie diese Studie zeigt, nicht umsonst.

Freitag off-top:Der Dokumentarfilm "Hyper Evolution: Der Aufstieg der Maschinen" (Teil I, Teil II , Teil III ). Vielen Dank für Ihre Aufmerksamkeit, bleiben Sie neugierig und haben Sie ein tolles Wochenende, Jungs! :)

Vielen Dank für Ihren Aufenthalt bei uns. Mögen Sie unsere Artikel? Möchten Sie weitere interessante Materialien sehen? Unterstützen Sie uns, indem Sie eine Bestellung aufgeben oder Ihren Freunden empfehlen,

Cloud-VPS für Entwickler ab 4,99 US-Dollar , ein

30-prozentiger Rabatt für Habr-Benutzer auf ein einzigartiges Analogon von Einstiegsservern, das wir für Sie erfunden haben: Die ganze Wahrheit über VPS (KVM) E5-2650 v4 (6 Kerne) 10 GB DDR4 240 GB SSD 1 Gbit / s ab 20 US-Dollar oder wie man einen Server freigibt? (Optionen sind mit RAID1 und RAID10, bis zu 24 Kernen und bis zu 40 GB DDR4 verfügbar).

Dell R730xd 2 mal günstiger? Nur wir haben

2 x Intel TetraDeca-Core Xeon 2 x E5-2697v3 2,6 GHz 14C 64 GB DDR4 4 x 960 GB SSD 1 Gbit / s 100 TV ab 199 US-Dollar in den Niederlanden! Dell R420 - 2x E5-2430 2,2 GHz 6C 128 GB DDR3 2x960 GB SSD 1 Gbit / s 100 TB - ab 99 US-Dollar! Lesen Sie mehr über

das Erstellen von Infrastruktur-Bldg. Klasse mit Dell R730xd E5-2650 v4 Servern für 9.000 Euro für einen Cent?