Manchmal entstehen Ideen, die im Anfangsstadium nicht richtig studiert wurden, und diese Ideen erscheinen aufgrund der Glaubwürdigkeit ihres Autors allen Teammitgliedern sehr vielversprechend. Vor einiger Zeit kam die Unternehmensgruppe VIT und ComBox Technology auf die Idee, einen Server auf Basis vieler Mikrocomputer zu implementieren. Der Zweck des Servers ist die Ausführung von neuronalen Netzen auf der CPU und der GPU von Mikrocomputern. Der geschätzte Formfaktor des zukünftigen Servers beträgt 1U, Version für die Rackmontage. Und alles wäre in Ordnung, nur die Idee beinhaltete passive Kühlung, da die angekündigte Wärmeabgabe der zur Nutzung vorgeschlagenen Mikrocomputer 25 W betrug. Eigentlich war der vorgeschlagene Mikrocomputer für die Implementierung Intel NUC mit einem Intel Core i5-Prozessor und einer integrierten Iris Plus 655-GPU. 25 W, 1 HE, passive Kühlung, ein Server - all das klingt ermutigend, aber es tauchten allmählich Nuancen auf.

Erstens sollten 8 Computer Mikrocomputer im Server sein. Das heißt, die dem Stromverbrauch proportionale Wärmeabgabe beträgt bereits 25 * 8 = 200 Watt. Und bereits zu diesem Zeitpunkt kann keine passive Kühlung gesagt werden, sondern der Versuch wurde fortgesetzt. Einschließlich aus Gründen der weiteren Anpassung der Technologie für die Ausführung von Außengehäusen. Die Entwicklung der Hardware erfolgte parallel zum OCD unter Einsatz der notwendigen Software. Wir haben einen Komplex für die Erkennung und Erkennung von Kennzeichen und Marken / Modellen von VIT-Fahrzeugen namens EDGE verwendet. Wie sich herausstellte, verbraucht Intel NUC8i5BEK beim Messen des Stromverbrauchs bei 100% Last 46 Watt anstelle der angegebenen 25. Bei diesem Ansatz beträgt der Stromverbrauch und die Wärmeabgabe des Servers bereits 46 * 8 = 368 Watt. Und das ohne Berücksichtigung von Netzteilen und Zusatzkomponenten.

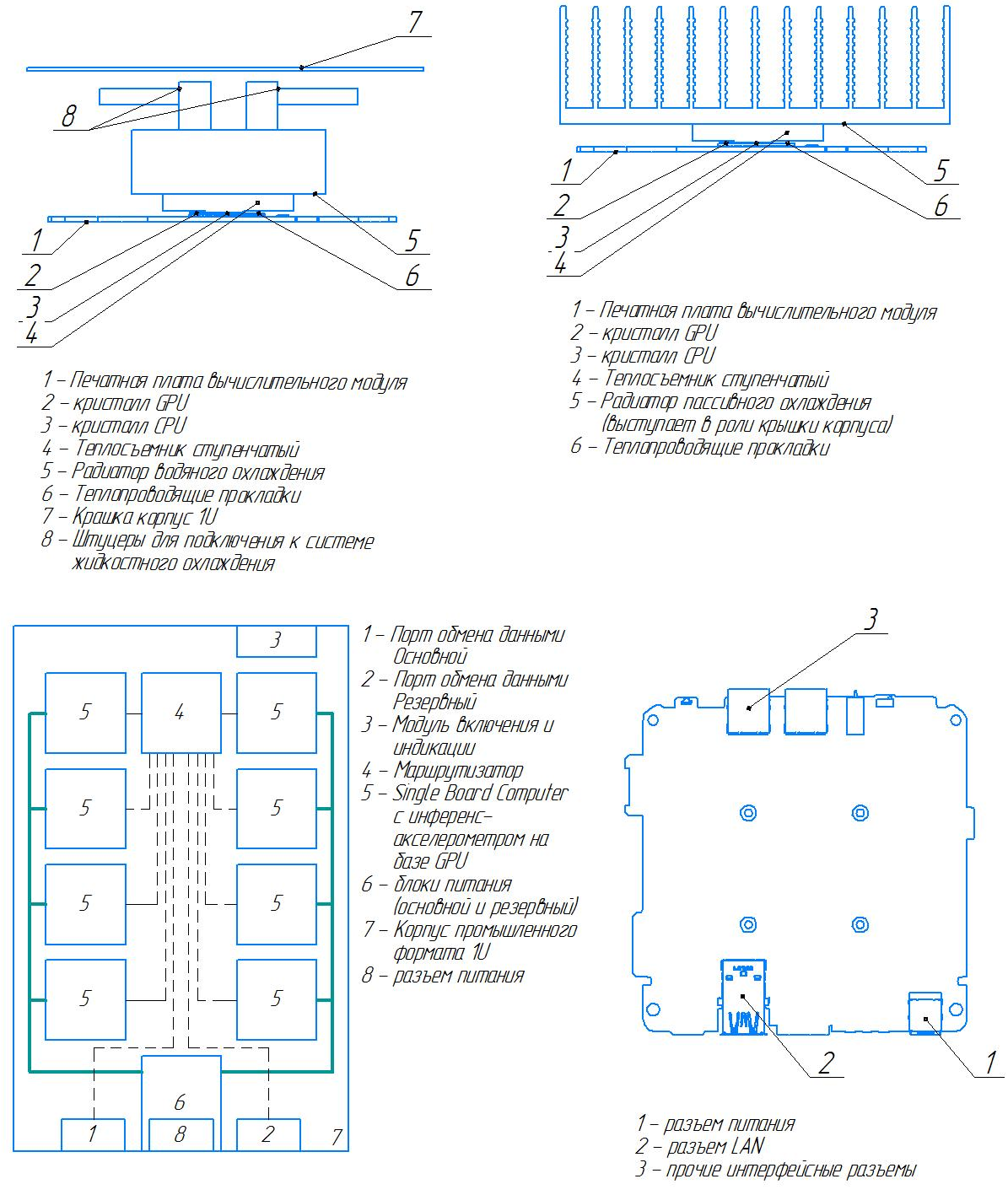

Als Kühlkörper haben wir nach dem Schleifen und Spezialgravieren Kupferplatten verwendet. Ferner gab die Kupferplatte Wärme an den Aluminiumwärmetauscher oben auf dem Server ab. Aufgrund fehlerhafter Berechnungen nahm der Wärmetauscher zwei Drittel der oberen Abdeckung ein und befand sich auf beiden Seiten parallel zu vier Mikrocomputern auf der linken und rechten Seite des Servers. Im zentralen Bereich befanden sich hinten ein 550-W-Netzteil und vorne ein Mikrotik-1-Gbit-Router.

Server Design Phase basierend auf 8 Mikrocomputern

Server Design Phase basierend auf 8 MikrocomputernUnd das Ergebnis stellte sich heraus:

NUC Server mit passiver Kühlung

NUC Server mit passiver KühlungNatürlich funktionierte diese Konstruktion bei mittlerer Last, aber bei 100% erwärmte sie sich weiterhin langsam und gab einen erheblichen Teil der Wärme an die Umgebung ab. Selbst innerhalb eines Serverschranks mit einem heißen und einem kalten Korridor heizte das Design unweigerlich einen höheren „Nachbarn“ auf. Durch die Reduzierung der Anzahl der Mikrocomputer auf 4 Stück konnte die Heiztemperatur stabilisiert und eine Drosselung auch bei 100% Last vermieden werden, das Problem eines höheren „Nachbarn“ blieb jedoch bestehen.

Der technologische Lösungsstapel ist in zwei Richtungen auseinander gegangen:

- Passive Kühlung von Intel NUC8i5BEK bei externer Nutzung

- Aktive Luftkühlung im 1U-Servergehäuse

1U-Server mit 8 Core i5-Prozessoren und 8 installierten GPUs

Ja, ja, es ist viel und ja, es ist möglich. Wie, fragst du? Durch die Kombination mehrerer Mikrocomputer in einem 1U-Gehäuse auf Netzwerkebene über einen Router. Insbesondere für die Implementierung neuronaler Netze und die Verarbeitung eingehender RTSP-Datenströme ist diese Lösung optimal. Darüber hinaus können Sie skalierbare Systeme auf der Basis einer Reihe von Docker, Docker Swarm und Ansible erstellen.

Während des Entwicklungsprozesses mussten wir verschiedene Versionen entwerfen:

Prototyp der zukünftigen Entscheidung

Die ursprüngliche Idee bestand darin, bewährte Kupferkühlkörper und Aluminiumheizkörper zu verwenden, die sich nun jedoch direkt auf jedem Rechenknoten im Gehäuse befinden. Zur Wärmeabfuhr wurden 2 Lüfter verwendet, die vor jedem Computermodul installiert waren und warme Luft von einem kalten Korridor nach heiß (von der Vorderseite des Servers) leiteten. Für die aktive Lüftersteuerung wurden spezielle Boards entwickelt, die ihre Geschwindigkeit basierend auf den Temperatursensoren der einzelnen Mikrocomputer ändern. Aufgrund des fehlenden PoE-Bedarfs wurde der Router nicht aktiv gekühlt, sondern auf passiv mit einer Wärmeabgabe von maximal 10 Watt umgestellt. Das Netzteil in der ersten Version blieb 500 W, wurde jedoch auf speziellen Halterungen mit der Möglichkeit des schnellen Austauschs, jedoch mit einem Stromausfall, installiert. Um den Status der Rechenknoten zu überwachen, wurden auf der Vorderseite 8 Dioden angezeigt.

NUC Server Prototyp von ComBox Technology, 8 CPU Core i5 und 8 GPU Iris Plus 655 im 1U Formfaktor

NUC Server Prototyp von ComBox Technology, 8 CPU Core i5 und 8 GPU Iris Plus 655 im 1U FormfaktorTechnische Merkmale der ersten Version des Servers unter Intel NUC:

- Intel NUC8i5BEK (ohne Gehäuse mit modifiziertem Kühlsystem), 8-tlg.

- AMD Radeon R7 Performance DDR4 SO-DIMM Speichermodule, 8 GB, 8 Stck.

- Zusätzliche Speichermodule DDR4 SO-DIMM Kingston, 4 GB, 8 Stck.

- SSD M.2-Laufwerk WD Green, 240 GB, 8 Stk.

- 1HE Koffer (Eigenproduktion)

- MikroTik RB4011iGS + RM Router (ohne Gehäuse mit modifiziertem Kühlsystem), 1 Stck.

- Verbindungsleitungen (Patchkabel), 11-tlg.

- BP 94Y8187, 550 Watt.

Wie es im Arbeitsprozess aussieht:

Produktionsversion von NUC Server

Die Produktionsversion hat wesentliche Änderungen erfahren. Anstelle eines Netzteils wurden 2 auf dem Server mit der Möglichkeit des Hot-Swappings angezeigt. Wir haben ein kompaktes Server-Netzteil 600 W von Supermicro verwendet. Für Computermodule wurden spezielle Footprints und die Möglichkeit des Hot-Swappings angezeigt, ohne dass der gesamte Server heruntergefahren werden muss. Viele Netzwerkschleifen wurden durch feste Stromschienen ersetzt, die an den Sitzen befestigt waren. Der Nano Pi ARM-Architektur-Mikrocomputer von FriendlyARM wurde hinzugefügt, um den Server zu verwalten. Für diesen wurde Software geschrieben und installiert, um den Status von Rechenknoten zu überprüfen und zu überwachen. Bei Bedarf werden Fehler gemeldet und die Hardware bestimmter Rechenknoten über GPIO zurückgesetzt. In der Serienversion sind die Lüfter hinter der Frontplatte in Richtung vom kalten zum heißen Korridor installiert, und die Lamellen des Aluminium-Wärmetauschers sind jetzt nach unten und nicht nach oben gerichtet, wodurch der Speicher und die Festplatten jedes Rechenknotens zugänglich wurden.

Intel NUC Outdoor-Gehäuse

Da die Mikrocomputer selbst nicht industriell sind, erfordert die Verwendung im Freien nicht nur einen Fall, sondern auch geeignete klimatische Bedingungen. Wir brauchten Schutz vor Staub und Feuchtigkeit IP66 sowie einen Temperaturbereich von -40 bis +50 Grad Celsius.

Wir haben zwei Hypothesen für eine effiziente Wärmeableitung getestet: Wärmerohre und Kupferplatten als Kühlkörper. Letzteres erwies sich als effektiver, wenn auch mit einer großen Fläche und teureren Lösungen. Als Wärmetauscher werden auch allesamt Aluminiumschwellen mit den berechneten Abmessungen der Rippen verwendet.

Um das Gerät bei Minustemperaturen zu starten, haben wir Keramik zum Heizen verwendet. Zur Erleichterung der Bedienung und Implementierung in verschiedenen Bereichen wurden Netzteile mit einem weiten Bereich von 6-36 V installiert.

Der Hauptzweck des resultierenden Geräts: die Ausführung von ressourcenintensiven neuronalen Netzen in unmittelbarer Nähe der Datenquelle. Zu diesen Aufgaben gehören die Berechnung des Personenverkehrs in Fahrzeugen (Pkw, Züge) sowie die zentrale Verarbeitung von Daten zur Gesichtserkennung und -erkennung im Industriebetrieb.

Intel NUC im Außengehäuse, IP66 mit Klimamodul

Intel NUC im Außengehäuse, IP66 mit KlimamodulAllgemeines hybrides Inferenzschema

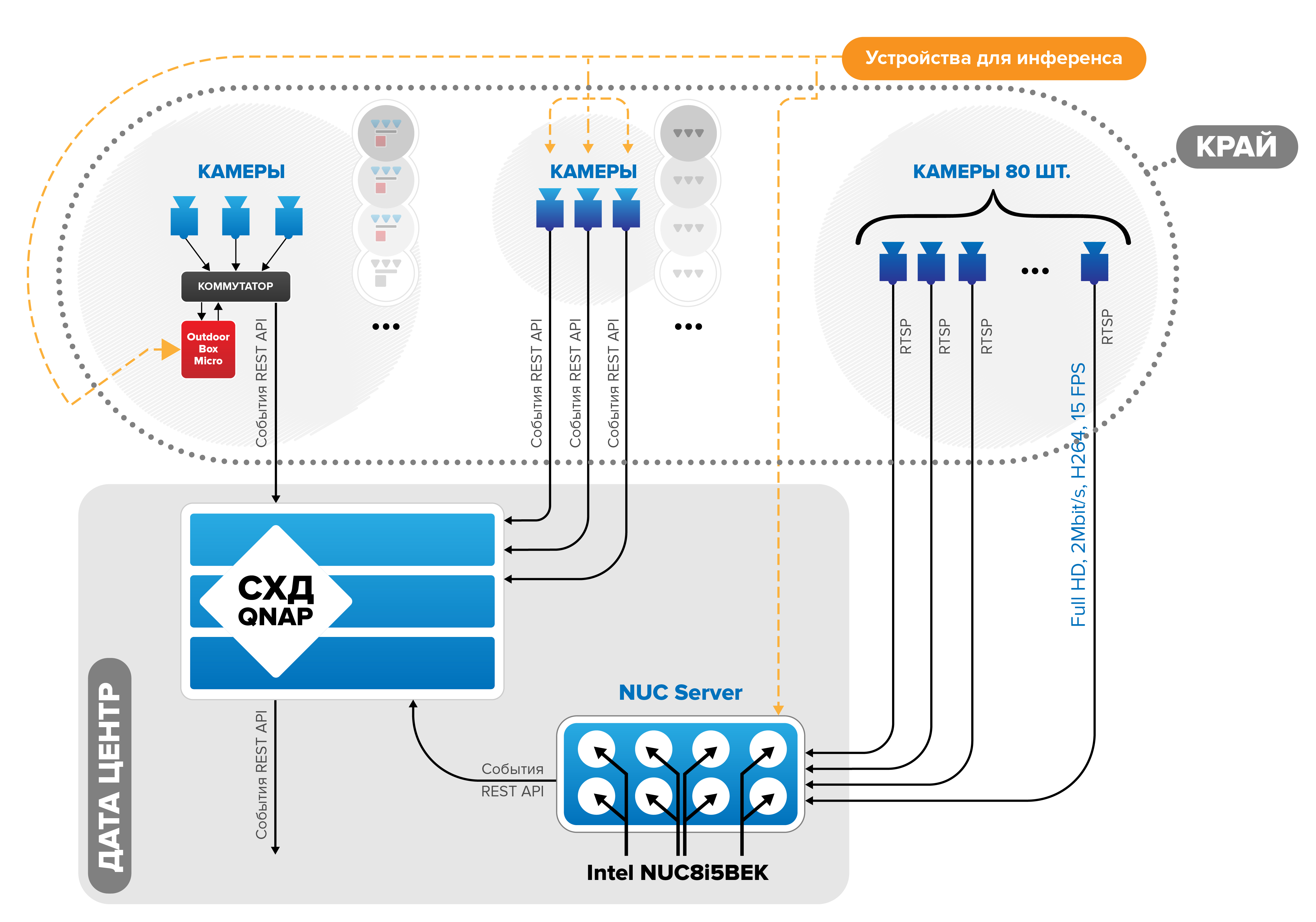

In der Regel werden drei Arten von Geräten verwendet: ein Server in einem Rechenzentrum, Kameras mit installierter Software zum Erkennen und Erkennen von Objekten in ihnen sowie Mikrocomputer einer Außeninstallation (an die Kameras beispielsweise über einen Switch angeschlossen sind). Darüber hinaus ist für mehrere Geräte (z. B. 2 Server, 15 Kameras, 30 Mikrocomputer) die Aggregation und Speicherung von Daten (Ereignissen) erforderlich.

In unseren Lösungen verwenden wir das folgende Schema für die Datenaggregation und -speicherung mithilfe von Speichersystemen:

Das allgemeine Schema der hybriden Inferenz

Das allgemeine Schema der hybriden Inferenz