Die Lösung von Strahlungsproblemen war ein "Wendepunkt in der Geschichte der Weltraumelektronik"

Anfang 2012 stürzte

Phobos-Grunt , eines der ehrgeizigsten Weltraumprojekte des modernen Russland, ins Meer. Dieses Raumschiff sollte auf der Oberfläche des schäbigen Marsmondes Phobos landen, Bodenproben sammeln und zur Erde zurückbringen. Stattdessen driftete er mehrere Wochen lang hilflos in der

niedrigen Erdumlaufbahn (DOE), weil der Bordcomputer ausfiel, bevor er die Motoren startete, die das Schiff in Richtung Mars schicken sollten.

In einem nachfolgenden

Bericht gaben die russischen Behörden den schwer geladenen Teilchen in galaktischen kosmischen Strahlen die Schuld, die mit SRAM-Chips kollidierten und den Chip aufgrund eines übermäßigen Stromflusses zum Versagen brachten. Um dieses Problem zu lösen, haben die beiden Prozessoren, die auf dem Computer ausgeführt werden, einen Neustart gestartet. Danach ging die Sonde für Befehle von der Erde in den sicheren Standby-Modus. Leider wurden keine Anweisungen erhalten.

Kommunikationsantennen sollten nach dem Verlassen des DOE den geplanten Betriebsmodus erreichen. Niemand hat jedoch die Ablehnung vorhergesehen, weshalb die Sonde dieses Stadium nicht erreicht hätte. Nach einer Kollision mit Partikeln war Phobos-Grunt in einer seltsamen Pattsituation. Das Starten von Motoren an Bord sollte den Einsatz von Antennen auslösen. Motoren konnten nur mit einem Befehl von der Erde gestartet werden. Und dieser Befehl konnte nicht kommen, weil die Antennen nicht eingesetzt wurden. Computerfehler führten zum Zusammenbruch der Mission, die sich auf mehrere Jahrzehnte vorbereitete. Insbesondere die Mitglieder des NGO-NGO-Teams sind für die Aufsicht verantwortlich. Lavochkin, der Hersteller des Geräts. Während der Entwicklung war es einfacher aufzulisten, was auf ihrem Computer funktionierte, als was nicht. Jeder kleine Fehler, den sie machten, wurde jedoch zu einer brutalen Erinnerung daran, dass die Entwicklung von Computern der Weltraumklasse furchtbar kompliziert ist. Sobald Sie stolpern und Milliarden von Dollar verbrannt werden.

Die Entwickler haben die Schwierigkeiten von Computern im Weltraum einfach unterschätzt.

Was ist so langsam?

Curiosity, das beliebte Mars-Geländefahrzeug, läuft auf zwei BAE RAD750-Prozessoren mit einer Taktfrequenz von bis zu 200 MHz. Es verfügt über 256 MB RAM und eine 2-GB-SSD. Am Vorabend des Jahres 2020 ist der RAD750 der fortschrittlichste Single-Core-Prozessor der Weltraumklasse. Heute ist es das Beste, was wir in den Weltraum schicken können.

Aber leider kann die Leistung des RAD750 im Vergleich zum Smartphone in unserer Tasche nur Mitleid auslösen. Seine Schaltung basiert auf dem PowerPC 750, einem Prozessor, den IBM und Motorola 1997 als Rivalen des Intel Pentium II eingeführt haben. Dies bedeutet, dass die derzeit technologisch fortschrittlichste Weltraumausrüstung das erste Starcraft (1998) problemlos starten kann. Es wird jedoch Probleme geben, wenn die Rechenleistung höher ist. Vergiss Mars in Crysis.

Gleichzeitig kostet der RAD750 etwa 200.000 US-Dollar. Aber können Sie nicht einfach Ihr iPhone einwerfen und am Ende damit enden? In Bezug auf die Geschwindigkeit haben iPhones für mehrere Generationen den RAD750 verlassen und kosten nur 1.000 USD pro Stück, was deutlich weniger als 200.000 USD ist. Das Phobos-Grunt-Team hat versucht, etwas Ähnliches zu tun. Sie versuchten, die Geschwindigkeit zu erhöhen und zu sparen, aber am Ende gingen sie zu weit.

Der durch stark geladene Partikel beschädigte Phobos Grunt SRAM-Speicherchip wurde mit WS512K32V20G24M gekennzeichnet. Er war in der Raumfahrtindustrie bekannt, weil diese Chips 2005 im Teilchenbeschleuniger des Brookhaven National Laboratory von T. Page und J. Benedetto getestet wurden, um zu testen, wie sie sich verhalten, wenn sie Strahlung ausgesetzt werden. Die Forscher bezeichneten diese Chips als "extrem anfällig", und ihre Ausfälle traten sogar unter der in Brookhaven verfügbaren Mindestenergieexposition auf. Das Ergebnis war nicht überraschend, da der WS512K32V20G24M nicht für den Weltraum konzipiert wurde. Sie wurden für die militärische Luftfahrt entwickelt. Sie waren jedoch leichter zu finden und billiger als Speicherchips der Weltraumklasse, weshalb die Entwickler von Phobos-Grunt beschlossen, sie zu verwenden.

"Die Entdeckung des Vorhandenseins verschiedener Arten von Strahlung im Weltraum ist zu einem der wichtigsten Wendepunkte in der Geschichte der Weltraumelektronik geworden, zusammen mit dem Verständnis der Auswirkungen dieser Strahlung auf die Elektronik und der Entwicklung von Chipverstärkungs- und Schadensminderungstechnologien", sagte Tyler Lovely, ein Forscher am Forschungslabor der US Air Force. Die Hauptquellen dieser Strahlung sind kosmische Strahlen, Sonnenprozesse und die an der Grenze des Erdmagnetfelds gelegenen Protonen- und Elektronengürtel, die sogenannten

Van-Allen-Strahlungsgürtel . Von den Teilchen, die mit der Erdatmosphäre kollidieren, sind 89% Protonen, 9% Alpha-Teilchen, 1% schwerere Kerne und 1% freie Elektronen. Ihre Energie kann 10 bis

19 eV erreichen. Die Verwendung von Chips, die nicht für den Weltraum geeignet sind, in einer Sonde, die mehrere Jahre durch den Weltraum wandern muss, bedeutet, nach Problemen zu fragen. Die Zeitung Krasnaya Zvezda

schrieb, dass 62% der auf Phobos-Grunt verwendeten Chips nicht für den Einsatz im Weltraum bestimmt waren. Das Sondenschema für 62% bestand aus dem Gefühl „Lasst uns dort ein iPhone schrauben“.

Strahlung wird zum Problem

Heutzutage ist die kosmische Strahlung einer der Schlüsselfaktoren, die bei der Erstellung von Computern der Weltraumklasse berücksichtigt werden. Das war aber nicht immer der Fall.

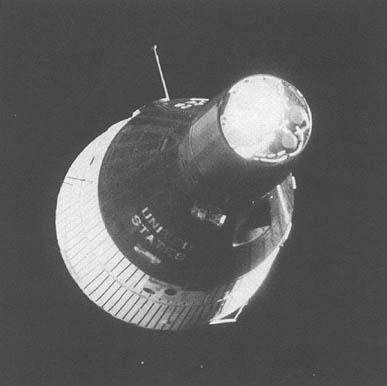

Der erste Computer ging in den 1960er Jahren an Bord eines Gemini-Fahrzeugs ins All. Um die Erlaubnis zum Fliegen zu erhalten, musste ich mehr als hundert verschiedene Tests durchlaufen. Ingenieure testeten, wie es sich bei Vibrationen, Vakuum, extremen Temperaturen usw. verhält. Bei keinem dieser Tests wurden die Auswirkungen der Strahlung berücksichtigt. Dabei funktionierte der Bordcomputer "Gemini" problemlos. Das liegt daran, dass er zu groß war, um sich zu weigern. Wörtlich. In einem Karton mit

11 Litern und einem Gewicht von 12 kg befanden sich bis zu 19,5 KB Speicher. Und der ganze Computer wog 26 kg.

In der Computerindustrie bestand der Prozessorfortschritt typischerweise darin, die Komponentengröße zu verringern und die Taktgeschwindigkeit zu erhöhen. Wir haben Transistoren immer kleiner gemacht, von 240 nm auf 65 nm, dann auf 14 nm und bereits auf 7 nm auf moderne Smartphones. Je kleiner der Transistor ist, desto niedriger ist die Spannung, die zum Ein- und Ausschalten erforderlich ist. Daher wirkte sich die Strahlung auf die alten Prozessoren mit großen Bauteilen praktisch nicht aus - genauer gesagt auf die sogenannten

einsame Störungen . Die durch die Kollision mit dem Partikel erzeugte Spannung war zu gering, um den Betrieb eines ausreichend großen Computers zu beeinträchtigen. Aber als die Leute, die in den Weltraum streben, die Größe von Bauteilen zu verringern begannen, um mehr Transistoren pro Chip zu bewegen, wurden die durch die Spannung erzeugten Partikel genug, um Probleme zu verursachen.

Üblicherweise erhöhen Ingenieure, um die Leistung von Prozessoren zu verbessern, ihre Taktrate. Bei Intel 386SX, unter dessen Kontrolle die Automatisierung in der Space-Shuttle-Steuerkabine arbeitete, arbeitete sie mit einer Frequenz von 20 MHz. Moderne Prozessoren können zu Spitzenzeiten bis zu 5 GHz erreichen. Die Taktfrequenz bestimmt die Anzahl der Verarbeitungszyklen, die der Prozessor pro Zeiteinheit ausführen kann. Das Problem mit der Strahlung ist, dass eine Kollision mit einem Partikel die Daten im Speicher des Prozessors (L1- oder L2-Cache) für kurze Zeit ruinieren kann. Es stellt sich heraus, dass ein geladenes Teilchen in jeder Sekunde nur eine begrenzte Anzahl von Möglichkeiten hat, Probleme zu verursachen. Bei Prozessoren mit geringer Taktrate war diese Anzahl recht gering. Mit zunehmender Frequenz nahm jedoch die Anzahl dieser Zeitpunkte in einer Sekunde zu, wodurch die Prozessoren strahlungsempfindlicher wurden. Prozessoren mit erhöhter Strahlungsbeständigkeit sind daher fast immer langsamer als handelsübliche Gegenstücke. Der Hauptgrund, warum kosmische Prozessoren so langsam arbeiten, ist, dass fast alle Methoden, die sie beschleunigen können, sie anfälliger machen.

Glücklicherweise kann dieses Problem umgangen werden.

Wir beschäftigen uns mit Strahlung

„Bisher wurde die Strahlung durch einen modifizierten Halbleiterprozess minimiert“, sagt Roland Weigand, VISI / ASIC-Ingenieur bei der Europäischen Weltraumorganisation. „Es hat gereicht, den kommerziellen Kern des Prozessors zu übernehmen und einen Prozess anzuwenden, der die Strahlungsbeständigkeit erhöht.“ Bei der Herstellung der Strahlenschutztechnologie wurden Materialien wie Saphir oder Galliumarsenid verwendet, die im Gegensatz zu Silizium nicht so stark auf Strahlung reagierten. Auf diese Weise hergestellte Prozessoren funktionierten gut in Umgebungen mit hoher Strahlung, beispielsweise im Weltraum, aber für ihre Produktion war es notwendig, die gesamte Fabrik neu auszustatten.

„Um die Leistung zu steigern, musste ich immer fortschrittlichere Prozessoren verwenden. Angesichts der Kosten einer modernen Halbleiterfabrik sind spezielle Änderungen im Herstellungsprozess für einen Nischenmarkt wie den Weltraum nicht mehr praktikabel “, sagt Weigand. Dies zwang die Ingenieure, kommerzielle Prozessoren zu verwenden, die einzelnen Störungen ausgesetzt waren. „Um diesen Effekt zu verringern, mussten wir auf andere Technologien umsteigen, um die Strahlenresistenz zu erhöhen - was wir als Design-Strahlenschutz bezeichnen“, fügt Weigand hinzu.

Der Designschutz ermöglichte es den Herstellern, den Standard-CMOS-Herstellungsprozess zu verwenden. Solche Prozessoren der Weltraumklasse könnten in kommerziellen Fabriken hergestellt werden, wodurch ihre Kosten auf ein vernünftiges Maß gesenkt würden und die Entwickler von Weltraummissionen ein wenig mit den kommerziellen Angeboten Schritt halten könnten. Die Strahlung wurde mit Ingenieurgeist behandelt und nicht nur mit den physikalischen Eigenschaften des Materials. "Zum Beispiel ist die dreifache modulare Redundanz (TMI) eine der beliebtesten Möglichkeiten, einen Chip vor Strahlung zu schützen, ansonsten ist sie Standard", erklärte Weigand. "Drei identische Kopien jeder Information werden ständig gespeichert." In der Lesephase werden alle drei gelesen und die richtige Version wird von der Mehrheit gewählt. “

Wenn alle drei Kopien gleich sind, werden die Informationen als korrekt betrachtet. Dasselbe passiert, wenn zwei Exemplare gleich sind und eines davon verschieden ist - das richtige Exemplar wird mit Stimmenmehrheit gewählt. Wenn sich jedoch alle drei Kopien unterscheiden, protokolliert das System einen Fehler. Die Idee ist, die gleichen Informationen an drei verschiedenen Speicheradressen zu speichern, die sich an drei verschiedenen Stellen auf dem Chip befinden. Um die Daten zu verderben, müssen zwei Partikel gleichzeitig mit den Stellen kollidieren, an denen zwei Kopien desselben Informationspartikels gespeichert sind, was äußerst unwahrscheinlich ist. Der Nachteil dieses Ansatzes ist das Vorhandensein übermäßiger Arbeit für den Prozessor. Er muss jede Operation dreimal ausführen, was bedeutet, dass er nur ein Drittel seiner Geschwindigkeit erreicht.

Die neueste Idee bestand darin, die Leistung von Prozessoren der Weltraumklasse noch näher an ihre kommerziellen Pendants heranzuführen. Anstatt das gesamte System auf einem Chip vor Strahlung zu schützen, entscheiden die Ingenieure, wo dieser Schutz am relevantesten ist. Und wo kann man das ablehnen? Dies ändert die Entwurfsprioritäten erheblich. Ältere Weltraumprozessoren waren strahlungsunempfindlich. Neue Prozessoren reagieren empfindlich darauf, sind jedoch so konzipiert, dass sie alle durch Strahlung verursachten Fehler automatisch bewältigen.

Zum Beispiel ist LEON GR740 der neueste europäische Weltraumprozessor. Es wird erwartet, dass er auf der geostationären Erdumlaufbahn 9 einzelne Störungen pro Tag erleidet. Der Trick ist, dass sie alle vom System zurückgehalten werden und nicht zu Betriebsfehlern führen. Der GR740 ist so konzipiert, dass ein Funktionsfehler nicht mehr als einmal alle 300 Jahre auftritt. Und selbst in diesem Fall kann er einfach neu starten.

Europa wählt Offenheit

Die LEON SPARC-Prozessoren der Weltraumklasse sind Europas beliebteste Wahl für Weltraumanwendungen. „In den 90er Jahren, als die SPARC-Spezifikation ausgewählt wurde, war sie sehr tief in der Branche verankert“, sagt Weigand. "Sun Microsystems hat es auf seinen erfolgreichen Workstations eingesetzt." Die Hauptgründe für den Wechsel zu SPARC seien dann die Unterstützung der Software und die Offenheit der Plattform gewesen. „Dank der offenen Architektur konnte jeder ohne Lizenzprobleme damit arbeiten. Dies war wichtig, da in einer so engen Nische wie dem Platz die Lizenzkosten auf eine kleine Anzahl von Geräten verteilt werden, was die Kosten erheblich erhöht “, erklärt er.

Infolgedessen hat die ESA aus bitteren Erfahrungen mit Lizenzierungsproblemen gelernt. Der erste europäische SPARC-Weltraumprozessor - ERC32 - verwendete bis heute kommerzielle Prozessoren. Es basierte auf einer offenen Architektur, aber die Prozessorschaltung war proprietär. „Das hat zu Problemen geführt. Da normalerweise kein Zugriff auf die Quellcodes proprietärer Systeme besteht, ist es schwierig, Änderungen am Projekt vorzunehmen, die zur Verbesserung des Strahlenschutzes erforderlich sind “, sagt Weigand. Daher begann die ESA im nächsten Schritt mit der Arbeit an ihrem eigenen Prozessor LEON. "Sein Projekt stand vollständig unter unserer Kontrolle und wir hatten endlich die Möglichkeit, alle von uns gewünschten Strahlenschutztechnologien einzusetzen."

Die neueste Entwicklung in der LEON-Prozessorlinie ist der Quad-Core-GR740, der mit einer Frequenz von etwa 250 MHz arbeitet. (Weigand geht davon aus, dass die ersten Lieferungen bis Ende 2019 geliefert werden). GR740 wird

mit der 65-nm-Prozesstechnologie hergestellt . Dies ist ein chipbasiertes System, das für allgemeine Hochgeschwindigkeitsberechnungen auf der Basis der SPARC32-Architektur entwickelt wurde. „Das Ziel der Entwicklung des GR740 bestand darin, eine höhere Geschwindigkeit zu erzielen und zusätzliche Geräte zur integrierten Schaltung hinzuzufügen, ohne die Kompatibilität mit früheren europäischen Weltraumprozessoren zu beeinträchtigen“, so Weigand. Ein weiteres Merkmal des GR740 ist sein fortschrittliches Fehlertoleranzsystem. Der Prozessor kann eine erhebliche Anzahl von durch Strahlung verursachten Fehlern bewältigen und dennoch einen unterbrechungsfreien Betrieb der Software sicherstellen. Jede Einheit und GR740-Funktion ist für die höchste Geschwindigkeit optimiert. Dies bedeutet, dass Komponenten, die für einzelne Störungen empfindlich sind, an andere angrenzt, die dies problemlos bewältigen können. Alle empfindlichen Komponenten werden in einer Schaltung verwendet, die die Auswirkung von Fehlern durch Redundanz verringert.

Einige Trigger auf dem GR740 sind beispielsweise reguläre kommerzielle CORELIB-FFs. Sie wurden für die Verwendung auf diesem Chip ausgewählt, da sie weniger Platz beanspruchen und dadurch die Rechendichte erhöhen. Der Nachteil ist, dass sie einzelnen Störungen ausgesetzt sind, aber sie haben dies mit Hilfe von TMI-Blöcken herausgefunden. Jede Information, die aus diesen Triggern gelesen wird, wird durch Abstimmung zwischen allen Modulen bestätigt, die weit genug entfernt sind, so dass ein Ereignis nicht mehrere Bits beeinflusst. Ähnliche Schemata werden für die Prozessor-Caches L1 und L2 implementiert, die aus SRAM-Zellen bestehen, die ebenfalls einzelnen Störungen ausgesetzt sind. Als solche Schemata die Leistung zu stark beeinflussten, stellten die ESA-Ingenieure auf störungsresistente SKYROB-Trigger um. Sie nehmen jedoch doppelt so viel Platz ein wie CORELIB. Wenn Sie versuchen, die Rechenleistung von Computern im Weltraum zu erhöhen, müssen Sie immer einige Kompromisse eingehen.

Bislang hat der GR740 mehrere Strahlungstests sehr gut bestanden. Der Chip wurde mit Schwerionen mit

linearer Energieübertragung (LET) gebrannt, die 125 MeV * cm

2 / mg erreichten, und sie arbeiteten ohne einen einzigen Fehler. Um etwas zu vergleichen, versagten die SRAM-Chips, aufgrund derer der Phobos-Grunt fiel, als nur Partikel mit LET ungefähr 0,375 MeV * cm

2 / mg erreichten. Der GR740 widerstand einer 300-mal stärkeren Strahlung. Neben der nahezu vollständigen Störfestigkeit gegenüber Einzelstörungen kann der GR740 während seiner Lebensdauer bis zu 300 Strahlen absorbieren. Während der Tests hat das Weigand-Team sogar einen der Prozessoren bis zu 293 Grad bestrahlt, der Chip funktionierte jedoch wie gewohnt, ohne Anzeichen von Degradation zu zeigen.

Tests, die die tatsächliche maximale Ionisationsdosis zeigen, die der GR740 absorbieren kann, müssen noch durchgeführt werden. Alle diese Zahlen zusammen deuten darauf hin, dass dieser Prozessor, der im geostationären Orbit der Erde arbeitet, alle 350 Jahre einen Funktionsfehler verursachen sollte. Im niedrigen Orbit erhöht sich dieser Zeitraum auf 1310 Jahre.

Und selbst solche Fehler werden den GR740 nicht töten. Er muss nur neu starten.

Amerika wählt patentierte Lösungen

"Weltraumprozessoren, die in den USA entwickelt werden, basieren traditionell auf proprietären Technologien wie PowerPC, da die Leute mehr Erfahrung mit ihnen hatten und von allen Arten von Software unterstützt wurden", sagte Lovelie von den Forschungslabors der US Air Force. Schließlich begann die Geschichte des Space Computing mit digitalen Prozessoren, die IBM in den 1960er-Jahren für die Gemini-Missionen entwickelte. Und IBM arbeitete mit proprietärer Technologie.Bis heute basieren BAE RAD-Prozessoren auf PowerPC, das dank der Arbeit des Konsortiums aus IBM, Apple und Motorola entstanden ist. Die Prozessoren in den Computern des Cockpits des Space Shuttles und des Hubble-Teleskops basieren auf der x86-Architektur von Intel. Sowohl PowerPC als auch x86 waren proprietäre Technologien. In Fortsetzung dieser Tradition basiert auch das neueste Projekt in diesem Bereich auf geschlossener Technologie. Der High Speed Space Flight Computer ( HPSC ) unterscheidet sich von PowerPC und x86 dadurch, dass letztere besser als Desktop-Prozessoren bekannt waren. Und HPSC basiert auf der ARM-Architektur, die heute auf den meisten Smartphones und Tablets funktioniert.HPSC wurde von der NASA, dem Forschungslabor der US Air Force, und Boeing entwickelt, die für die Produktion verantwortlich sind. HPSC basiert auf vierkernigen ARM Cortex A53-Prozessoren. Er wird zwei solcher Prozessoren über den AMBA-Bus verbinden, was am Ende ein Acht-Kern-System ergeben wird. Seine Geschwindigkeit wird daher 2018 im Bereich der Mittelklasse-Smartphones wie dem Samsung Galaxy J8 oder Entwicklungsboards wie HiKey Lemaker oder Raspberry Pi liegen. Diese Anzeigen werden zwar vor dem Schutz vor Strahlung gegeben - sie verringern die Geschwindigkeit um mehr als das Doppelte. Wir müssen jedoch nicht mehr die langweiligen Schlagzeilen lesen, die 200 Prozessoren des Curiosity Rovers bei einem iPhone nicht einholen werden. Nach dem Start von HPSC sind nur drei oder vier dieser Chips erforderlich, um die Geschwindigkeit mit einem iPhone zu vergleichen."Da wir noch keine echte HPSC für Tests haben, können wir nur vernünftige Annahmen über die Leistung treffen", sagt Lovelie. Der erste sorgfältig untersuchte Parameter war die Taktfrequenz. Kommerzielle Cortex A53-Prozessoren mit acht Kernen arbeiten normalerweise mit Frequenzen von 1,2 GHz (im Fall von HiKey Lemaker) bis 1,8 GHz (wie der Snapdragon 450). Um herauszufinden, wie hoch die HPSC-Taktfrequenz nach dem Strahlenschutz sein würde, verglich Lovelyverschiedene Weltraumprozessoren mit ihren kommerziellen Gegenstücken. "Wir haben entschieden, dass es vernünftig ist, einen ähnlichen Leistungsabfall zu erwarten", sagt er. Lovely bewertete die HPSC-Taktrate mit 500 MHz. Und dennoch wird es eine außergewöhnlich hohe Geschwindigkeit für einen Weltraum-Chip sein. Wenn diese Frequenz wirklich so ist, wird der HPSC der Champion in der Taktfrequenz unter Prozessoren der Weltraumklasse sein. Die Erhöhung der Rechenleistung und der Taktfrequenz im Weltraum führt jedoch normalerweise zu ernsthaften Problemen.Der derzeit leistungsstärkste strahlengeschützte Prozessor ist der BAE RAD5545. Hierbei handelt es sich um eine 64-Bit-Vierkernmaschine, die im 45-nm-Verfahren hergestellt wurde und mit einer Taktfrequenz von 466 MHz und einer Verlustleistung von bis zu 20 W arbeitet. und 20 Watt ist anständig. Der Quad Core i5 des 13 "MacBook Pro 2018 verbraucht 28 Watt. Er kann das Aluminiumgehäuse auf sehr hohe Temperaturen erwärmen, bis zu solchen, die den Benutzern Probleme bereiten. Bei hoher Rechenlast werden die Lüfter sofort eingeschaltet, um das gesamte System zu kühlen Lüfter helfen dem Weltraum überhaupt nicht, da keine Luft auf einen heißen Chip blasen kann. Die einzige Möglichkeit, Wärme aus dem Raumfahrzeug zu entfernen, ist Strahlung, und dies braucht Zeit. Natürlich helfen Heatpipes dabei, die Wärme von diesem zu entfernen Prozessor, aber diese Hitze sollte irgendwann irgendwohin gehen.Einige Missionen haben ein sehr begrenztes Energiebudget und können sich so leistungsstarke Prozessoren wie den RAD5545 einfach nicht leisten. Daher beträgt die europäische Verlustleistung des GR740 nur 1,5 Watt. Es ist nicht das schnellste verfügbare, aber das effektivste. Es gibt Ihnen nur die maximale Menge an Rechenleistung pro Watt. Ein 10 W HPSC ist auf dem zweiten Platz nah dran, aber nicht immer.„Jeder HPSC-Kern hat ein eigenes Modul aus einem einzelnen Befehlsstrom, mehreren Datenströmen und OKMD(Single Instruction Multiple Data, SIMD). Die OKMD-Technologie wird seit den 90er Jahren häufig in kommerziellen Desktop- und Mobilcomputern eingesetzt. Es hilft Prozessoren, die Bild- und Tonverarbeitung in Videospielen besser zu handhaben. Nehmen wir an, wir müssen das Bild aufhellen. Es hat viele Pixel und jedes von ihnen hat eine Helligkeit, die um zwei erhöht werden muss. Ohne OKMD muss der Prozessor alle diese Summierungen nacheinander ausführen, ein Pixel nach dem anderen. Mit OKMD kann dieses Problem parallelisiert werden. Der Prozessor akzeptiert mehrere Datenpunkte - die Helligkeitswerte aller Pixel im Bild - und führt mit ihnen den gleichen Befehl aus, wodurch allen gleichzeitig ein Deuce hinzugefügt wird. Und da der Cortex A53-Prozessor für Smartphones und Tablets entwickelt wurde, die eine große Menge an Medieninhalten verarbeiten, ist auch HPSC dazu in der Lage."Dies ist besonders nützlich bei Aufgaben wie Bildkomprimierung, Verarbeitung oder Stereovision", sagt Lovely. - In Anwendungen, die diese Funktion nicht verwenden, arbeitet HPSC etwas besser als der GR740 und andere schnelle Weltraumprozessoren. Aber wenn es genutzt werden kann, ist der Chip seinen Konkurrenten weit voraus. "Bringen Sie Science Fiction zurück in die Weltraumforschung

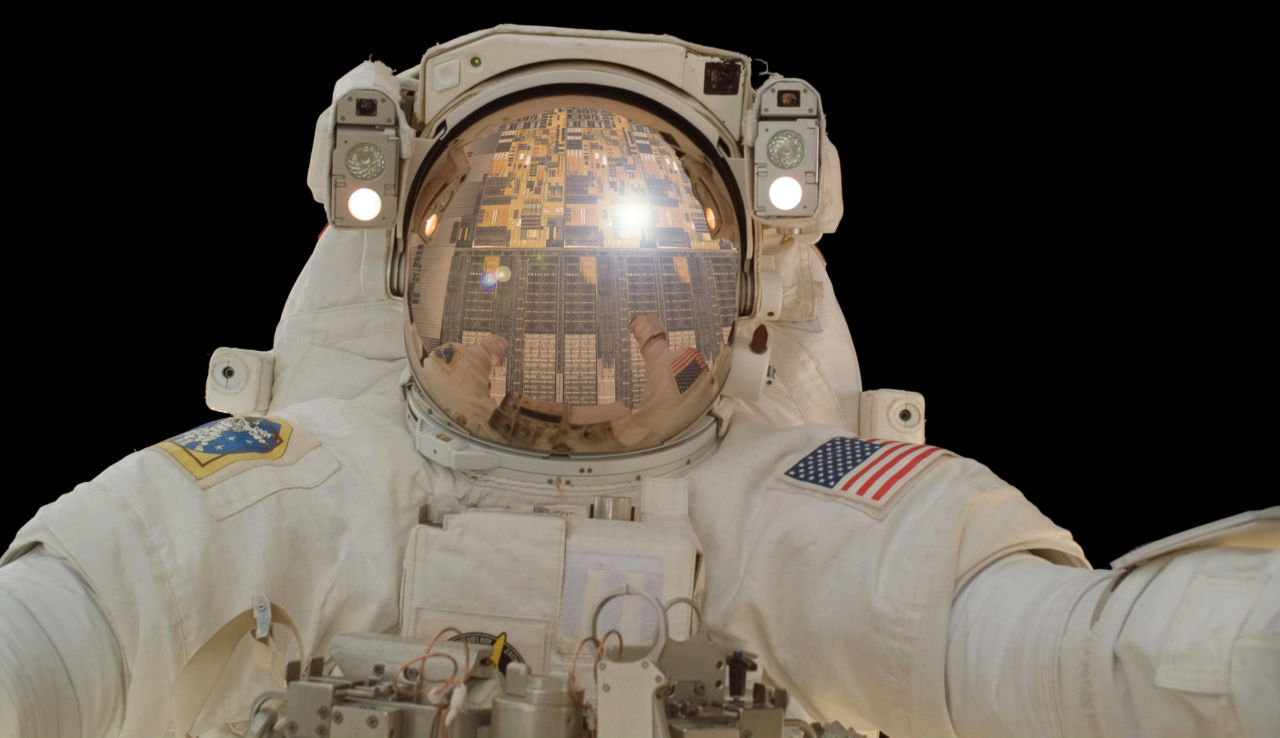

Chipentwickler aus den USA sind in der Regel leistungsstärker, stellen aber auch höhere Anforderungen an Energieprozessoren, da sowohl robotergesteuerte als auch bemannte NASA-Missionen in der Regel einen größeren Umfang haben als ihre europäischen Kollegen. In Europa gibt es auf absehbare Zeit keine Pläne, Menschen oder Geländefahrzeuge in der Größe eines Autos zum Mond oder Mars zu schicken. Heutzutage konzentriert sich die ESA auf Sonden und Satelliten, die in der Regel mit einem begrenzten Energiebudget arbeiten. Daher ist es sinnvoller, sich für etwas Leichteres und Energiesparenderes wie den GR740 zu entscheiden. Das HPSC wurde ursprünglich entwickelt, um die Science-Fiction-Ambitionen der NASA an Orte zu bringen.Zum Beispiel gab das Game Changing Development Program der NASA im Jahr 2011 eine Studie in Auftrag, wie Computeranforderungen im Weltraum in 15 bis 20 Jahren aussehen werden. Ein Expertenteam aus verschiedenen Zentren der Agentur hat eine Liste von Aufgaben zusammengestellt, die fortgeschrittene Prozessoren bei bemannten und Robotermissionen lösen könnten. Eine der ersten identifizierten Aufgaben war die ständige Überwachung des Gerätestatus. Diese Aufgabe läuft darauf hinaus, dass Sensoren vorhanden sind, die den Status kritischer Komponenten ständig überwachen. Das Erfassen von Hochfrequenzdaten von all diesen Sensoren erfordert schnelle Prozessoren. Ein langsamer Computer würde wahrscheinlich die Arbeit erledigen, wenn die Daten alle 10 Minuten irgendwo ankommen, aber wenn Sie alle Geräte mehrmals pro Sekunde überprüfen müssen, um Effizienz zu erzielen,Wie bei der Echtzeitüberwachung sollte Ihr Prozessor sehr schnell laufen. All dies muss entwickelt werden, damit Astronauten vor dem Bedienfeld sitzen können, das den tatsächlichen Zustand des Schiffes anzeigt und Sprachalarme und wunderschöne Grafiken ausgeben kann. Um solche Grafiken zu unterstützen, sind auch schnelle Computer erforderlich.Science-Fiction-Ziele enden jedoch nicht mit Cockpits. Astronauten, die andere Welten erforschen, haben wahrscheinlich ein Augmented-Reality-System in ihre Helme eingebaut. Ihre Umgebung wird durch computergenerierte Videos, Sounds und GPS-Daten ergänzt. Theoretisch wird Augmented Reality die Effektivität von Forschern verbessern, erforschenswerte Gebiete markieren und vor potenziell gefährlichen Situationen warnen. Die Einbettung von Augmented Reality in einen Helm ist natürlich nur eine von mehreren Möglichkeiten. Zu den anderen Optionen, die in der Studie erwähnt wurden, gehören tragbare Geräte wie Smartphones und etwas, das vage als "andere Möglichkeiten zur Anzeige von Informationen" beschrieben wird. Solche Computer-Durchbrüche erfordern schnellere Prozessoren der Weltraumklasse.Solche Prozessoren sollten auch Robotermissionen verbessern. Eines der wichtigsten Beispiele ist die Landung in einem schwierigen Gelände. Die Wahl eines Standorts für die Landung auf der Oberfläche ist immer ein Kompromiss zwischen Sicherheit und wissenschaftlichem Wert. Der sicherste Ort ist ein flaches Flugzeug ohne Steine, Hügel, Täler und Felsvorsprünge. Aus wissenschaftlicher Sicht wird der interessanteste Ort geologisch vielfältig sein, was eine Fülle von Steinen, Hügeln, Tälern und Felsvorsprüngen bedeutet. Eine Möglichkeit, dieses Problem zu lösen, ist das sogenannte. Geländebasierte Navigation (NOM). Mit dem NOM-System ausgestattete Geländefahrzeuge können wichtige Zeichen erkennen, potenzielle Gefahren erkennen und umgehen. Dies kann den Landeradius auf 100 m verringern. Das Problem ist, dass die heute verfügbaren Prozessoren der Weltraumklasse zu langsam sind, um Bilder mit einer solchen Geschwindigkeit zu verarbeiten.Ein NASA-Team startete den NOM-Leistungstest für RAD 750 und stellte fest, dass die Aktualisierung von einer einzelnen Kamera etwa 10 Sekunden dauerte. Leider sind 10 Sekunden viel, wenn Sie auf die Marsoberfläche fallen. Um ein Geländefahrzeug auf einem Gelände mit einem Radius von 100 m zu landen, müssen Aktualisierungen von der Kamera jede Sekunde verarbeitet werden. Für eine exakte Landung auf der Site pro Meter benötigen Sie 10 Updates pro Sekunde.Zu den weiteren Rechenwünschen der NASA zählen Algorithmen, mit denen sich bevorstehende Katastrophen auf der Grundlage von Sensorablesungen, intelligenten Grafiken, erweiterter Autonomie usw. vorhersagen lassen. All dies geht über die Möglichkeiten der aktuellen Prozessoren der Weltraumklasse hinaus. In der Studie geben die NASA-Ingenieure daher ihre Schätzungen der Rechenleistung an, die zur Unterstützung solcher Aufgaben erforderlich ist. Sie stellten fest, dass die Überwachung des Schiffszustands und die Landung unter schwierigen Bedingungen 10 bis 50 GOPS (Gigaoperationen pro Sekunde) erfordern würde. Futuristische Science-Fiction-Flugkonsolen mit modischen Displays und fortschrittlicher Grafik erfordern 50-100 GOPS. Gleiches gilt für Augmented-Reality-Helme oder andere Geräte. Sie verbrauchen auch 50 bis 100 GOPS.Im Idealfall können zukünftige Weltraumprozessoren all diese Projekte problemlos unterstützen. Heutzutage kann der HPSC mit einer Verlustleistung von 7 bis 10 Watt 9-15 GOPS liefern. Dies könnte bereits eine extreme Landung ermöglichen, die HPSC ist jedoch so ausgelegt, dass sich diese Zahl erheblich erhöhen kann. Erstens enthalten diese 15 GOPS nicht die von OKMD erhaltenen Leistungsvorteile. Zweitens kann dieser Prozessor mit anderen HPSC- und externen Geräten, z. B. speziellen FPGA- oder GPU-Prozessoren, zusammenarbeiten. Aus diesem Grund können in der Raumsonde der Zukunft mehrere verteilte Prozessoren parallel arbeiten, und spezialisierte Chips können bestimmte Aufgaben wie Bildverarbeitung oder Signale übernehmen.Unabhängig davon, wohin die Träume der Menschheit vom Weltraum gehen, wissen die Ingenieure bereits, in welchem Entwicklungsstadium sich die aktuelle Rechenleistung befindet. Der LEON GR740 soll der ESA noch in diesem Jahr zur Verfügung gestellt werden. Nach einigen zusätzlichen Tests sollte er 2020 flugbereit sein. Die HPSC-Produktionsphase sollte wiederum im Jahr 2012 beginnen und im Jahr 2022 enden. Die Prüfung im Jahr 2022 sollte mehrere Monate dauern.Die NASA sollte bis Ende 2022 einsatzbereite HPSC-Chips erhalten. Dies bedeutet, dass sich zumindest kosmisches Silizium in einer Geschwindigkeit in die Zukunft bewegt, die es ihm ermöglicht, sich auf die Rückkehr der Menschen zum Mond bis 2024 vorzubereiten, ohne andere Faktoren zu berücksichtigen, die den Fortschritt erschweren.