Jeder kennt den legendären

SSD-Zuverlässigkeitstest von 3dnews (Veröffentlichung von 2018.01), bei dem einige Budget-Laufwerke die vom Hersteller angegebene Ressource um den Faktor zehn übertrafen.

Nach dieser Studie erschien die verschwörungstheologische Theorie, dass Hersteller die Ressourcen von Budget-SSDs unterschätzen, und es wurde die Überzeugung verbreitet, dass fast alle SSDs in der Lage sind, einen Verschleißausgleich qualitativ durchzuführen.

Eine Studie von 3dnews.ru wurde basierend auf

Techreport.com-Tests durchgeführt (veröffentlicht am 20.08.2013).

Die Methode zur Messung der Verschleißfestigkeit wurde ebenfalls verwendet.

Techreport-Technik:

Mit synthetischen Benchmarks können wir die SSD-Belastbarkeitsgrenzen viel schneller erhöhen. Es gibt unzählige Möglichkeiten, aber die beste ist Anvils einfallsreicher Name Storage Utilities.

Diese handliche, kleine App wurde von einem Benutzer der XtremeSystems-Foren entwickelt und enthält einen speziellen Dauertest, bei dem Laufwerke mit Dateien unterschiedlicher Größe gefüllt werden, bevor sie gelöscht und neu gestartet werden. Wir können die Nutzlast jeder Schleife optimieren, um die gleiche Datenmenge auf jedes Laufwerk zu schreiben. Es gibt eine integrierte MD5-Hash-Prüfung, die die Datenintegrität überprüft, und die Schreibgeschwindigkeit ist mehr als eine Größenordnung höher als die effektive Schreibrate von DriveBench 2.0.

Der Ausdauertest von Anvil schreibt Dateien nacheinander, daher ist er keine ideale Simulation für die Praxis. Es ist jedoch das beste Tool, das wir haben, und es ermöglicht uns, Laufwerke mit einem Teil der statischen Daten zu laden, um Abnutzungsroutinen in Frage zu stellen. Wir verwenden 10 GB statische Daten, einschließlich einer Kopie des Windows 7-Installationsordners, einiger Anwendungsdateien und einiger Filme.

3dnews.ru Technik:

Daher verwenden wir in unserem Ausdauertest Laufwerke, die mit dem NTFS-Dateisystem formatiert sind und auf denen fortlaufend und abwechselnd zwei Dateitypen erstellt werden: klein - mit einer zufälligen Größe von 1 bis 128 KB und groß - mit einer zufälligen Größe von 128 KB bis 10 MB. Während des Tests werden diese Dateien mit zufälliger Füllung multipliziert, während das Laufwerk mehr als 12 GB freien Speicherplatz hat. Wenn dieser Schwellenwert erreicht ist, werden alle erstellten Dateien gelöscht, eine kurze Pause gemacht und der Vorgang wird erneut wiederholt. Darüber hinaus ist auf den Testfahrten auch der dritte Dateityp vorhanden - permanent. Solche Dateien mit einem Gesamtvolumen von 16 GB nehmen nicht am Erase-Overwrite-Prozess teil, sondern dienen der Überprüfung der korrekten Funktionsfähigkeit der Laufwerke und der stabilen Lesbarkeit der gespeicherten Informationen: Bei jedem SSD-Füllzyklus überprüfen wir die Prüfsumme dieser Dateien und vergleichen sie mit dem im Voraus berechneten Referenzwert.

In beiden Fällen wurden Anvils Storage Utilities verwendet.

1. Und was ist falsch an der Technik?

Das Problem ist, dass sich die Festplatte nacheinander füllt. Dies entspricht weder den tatsächlichen Anwendungsfällen noch dem von

JEDEC empfohlenen Verschleißschutzverfahren (Semiconductor Engineering Standardization Committee, auch Solid State Technology Association genannt, zu dem alle größten Flash-Speicherhersteller gehören).

Sowohl das Betriebssystem als auch der Controller (wenn er einen kleinen DRAM-Cache hat) gruppieren aufeinanderfolgende Blöcke, die aufgezeichnet werden sollen, und schreiben große systemeigene Blöcke auf, die für ein bestimmtes Gerät charakteristisch sind. Gleichzeitig gibt es praktisch keinen Aufnahmegewinn und es sind praktisch keine Algorithmen zur Verschleißkorrektur erforderlich.

Unter realen Bedingungen wirken sich sowohl der Multiplikator als auch die hochwertige Implementierung des Algorithmus zur Verschleißkorrektur stark auf die Speicherressource aus.

Problem 1. Beim sequentiellen Schreiben von WAF-Dateien ≈ 1

Ein Test, der so konstruiert ist, dass der Datensatzmultiplikationsfaktor (WAF) tendenziell eins wird, führt vorhersehbar zu überschätzten Ergebnissen für die Ressource. Die meisten von 3dnews analysierten Platten (aus denen WAF extrahiert werden konnte) wiesen einen Aufzeichnungsgewinn von of1-1,11 auf. Experten von 3dnews erklärten dies mit effizienten Steuerungsalgorithmen. Nur buchstäblich eine Instanz von WAF 3 musste von einem ineffektiven Controller erklärt werden.

Meiner Meinung nach liegt der springende Punkt jedoch in der Testmethodik, mit der ein sequenzieller Datensatz (bei dem WAF → 1) erstellt wurde, der eine Überschätzung der Ressource von SSD-Laufwerken ergab.

Als nächstes werde ich auswerten, wie oft.

Problem 2. Die Qualität des Abnutzungsnivellierungsalgorithmus wird nicht getestet

Mit dem sukzessiven Befüllen der Scheibe und dem anschließenden Löschen wird der Verschleißausgleichsmechanismus schlecht getestet. Wenn der Hersteller vermutet hat, dass die ersten paar GB der Festplatte (auf der sich das Bitmap der Festplatte, FAT und andere Metadaten befinden) im SLC-Modus funktionieren (oder im RAM-Puffer zwischengespeichert werden), ist der Algorithmus zur Abnutzungskorrektur in der Firmware möglicherweise vollständig nicht vorhanden und wird bei sequenzieller Aufzeichnung dennoch erreicht ausgezeichnete Ressourcenindikatoren.

Problem 3. Die Vorratsdatenspeicherung nach Erschöpfung der Ressourcen wird nicht getestet

Wenn Sie mehrere Monate unterwegs sind, ist nicht klar, ob es möglich ist, einem Datenträger zu vertrauen, der seine Passressource entwickelt hat.

Problem 4. Das sequentielle Füllen einer Festplatte, gefolgt von einem fast vollständigen Löschen, ist kein echtes benutzerdefiniertes Verhaltensmuster

Da SSD immer noch eine ziemlich teure Ressource ist, versuchen die Leute normalerweise, sie so vollständig wie möglich zu nutzen und lassen ein Minimum an freiem Speicherplatz.

Meiner Meinung nach ist der ideale Test, dass die SSD während des Tests zu 80-90% verstopft bleibt, während gleichzeitig alte Dateien gelöscht und neue hinzugefügt werden sollten.

2. Animationsfaktoren aufzeichnen

2.1. Dateisystem-Fragmentierung

Da die Defragmentierung für Windows-SSDs deaktiviert ist und die NTFS-Clustergröße standardmäßig 4 KB beträgt, ist die Festplatte im realen Leben sehr fragmentiert. In diesem Fall wird die Geschwindigkeit selbst bei sequenzieller Aufnahme fast zufällig.

Um einen geänderten Cluster aufzuschreiben, muss der Controller zuerst die gesamte NAND-Hardwareseite (die Hunderte von Kilobyte groß sein kann) lesen, 4 KB ändern und dann alles schreiben. Wenn die Größe der Nutzkapazität der NAND-Seite 64 KB beträgt, haben wir einen 16-fachen Aufnahmegewinn.

Aktuelle Seitengrößen in NANDAus dem Kommentar :

Die tatsächlichen Seitengrößen in NAND-Chips betragen normalerweise nicht Hunderte von Kilobyte, sondern 528, 2112, 4224, 4320, 8576, 8640, 8832, 8896, 9216, 17664, 18048, 18336 usw. Kleine Größen gelten für alte SLC-Chips, größere für TLC- und QLC-Chips. Solche seltsamen Größen, weil zusätzlich zu den Benutzerdaten Hilfsdaten (ECC, Flags, Blocknummern, Satzzähler usw.) gespeichert werden müssen.

2.2. Verschleißausrichtungsalgorithmus

Ein solcher Algorithmus kann als separater Prozess in der Steuerung implementiert werden. Es wird ungefähr so funktionieren:

Um statische Daten in einen Bereich mit höherem Verschleiß zu verschieben, muss die Größe der zu verschiebenden Daten gleich sein, vorausgesetzt, es gibt einen freigegebenen TRIM-Block. Und mit einer kleinen Anzahl von freien Blöcken müssen Sie zwei Einträge vornehmen, um Daten auszutauschen.

RAM = a a = b b = RAM

Bei einem kleinen oder fehlenden DRAM-Puffer sind drei Einträge erforderlich.

temp = a a = b b = temp

Diese Operationen in einem idealen Abnutzungsnivellierungsalgorithmus sind äußerst selten, da es sinnvoll ist, nur statische Daten zu verschieben, um Seiten mit geringer Abnutzung zu verwenden. Daher wird die Auswirkung des Abnutzungsnivellierungsalgorithmus auf die Datensatzanimation vernachlässigt. Obwohl es natürlich keine Garantie gibt, dass echte Algorithmen ideale Algorithmen verwenden.

2.3. Typisches SSD-Schreiben ist zufällig, 4-8 KB Block

Normalerweise handelt es sich bei SSD-Aufzeichnungen um

zufällige 8-KB-Aufzeichnungen . Selbst wenn keine Fragmentierung vorliegt, ist die Größe eines typischen Aufzeichnungsblocks kleiner als die Größe der NAND-Seite und die Aufzeichnung wird multipliziert.

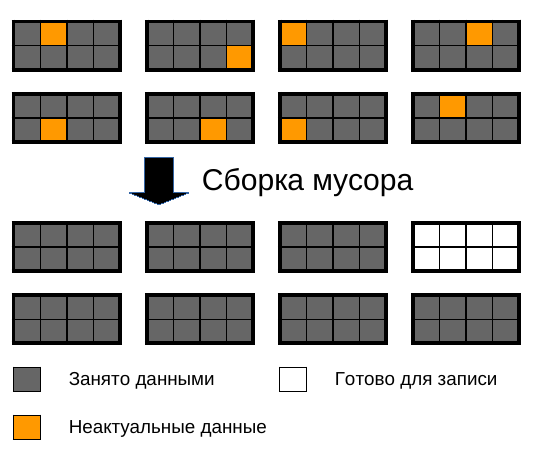

2.4. Garbage Collection-Algorithmus

Hier liegen die größten Tücken. Die Blockgröße im NAND-Speicher erreicht mehrere Megabyte. Ein Block besteht aus mehreren Seiten.

Seiten können separat gelesen und geschrieben werden, und ein Block kann nur vollständig gelöscht werden.

Im Laufe der Zeit werden viele Seiten im Block als ungültig markiert, weil die Daten in ihnen geändert und an eine andere Stelle geschrieben wurden oder weil ein TRIM-Aufruf erfolgt ist. Und früher oder später muss der Müllsammler ein paar teilweise gefüllte Blöcke nehmen und vollständig geschriebene und freie zusammenstellen.

Solange freier Speicherplatz vorhanden ist, wird er höchstwahrscheinlich nicht einmal gestartet, sodass sich mit der Zeit zahlreiche Löcher in den Blöcken bilden.

Je weniger Speicherplatz vorhanden ist, desto schneller steigt der WAF (Write Amplification Factor).

Um die Zunahme des WAF zu veranschaulichen, gebe ich das folgende Bild:

Das Bild zeigt NAND-Speicherblöcke mit 87,5% Datenfüllung, paginiert. Um Speicherplatz für die Aufnahme freizugeben, erfolgt eine Umlagerung, in der 7 Blöcke umgeschrieben und gelöscht werden. 1. Total WAF ergibt =

8 !

Natürlich müssen Sie auch berücksichtigen, dass die meisten SSDs einen Sicherungsbereich haben, in dem auch die Neuverteilung der Aufzeichnung stattfindet. Aber in der Regel ist es klein.

Die typische Größe des verborgenen Bereichs für Consumer-Laufwerke beträgt

7,37% Hersteller geben die Größe in Milliarden von Bytes an, und Mikroschaltungen haben eine Kapazität in Gigabyte. 1 Gigabyte = 1.073.741.824 Byte).

Wenn die Festplatte zu 90% voll ist und ein versteckter Bereich von 7,37% vorhanden ist, beträgt der WAF-

Wert 6,18 !

WAF kann mit dieser Formel bewertet werden:

K Festplattenfülle - von 0 bis 1, wobei 1 - 100% Festplattenfülle.

K Reservebereich - von 1, wobei 1 - 0% der Reservefläche, 1,1 - 10% der Reservefläche usw. sind.

Eine ungefähre Darstellung von WA im Verhältnis zum Prozentsatz des freien Speicherplatzes.

Das Diagramm zeigt, dass WA katastrophal ansteigt, wenn die Festplatte voll wird, und sich 15 nähert, wenn die Festplatte mit einem freien Bereich von

7,37% voll ist (eine typische Zahl für Consumer-Festplatten, da die Hersteller die Größe in Milliarden Bytes angeben und die Mikroschaltungen eine Kapazität in Gigabyte haben. 1 Gigabyte = 1.073.741.824 Byte).

Sie haben wahrscheinlich selbst bemerkt, wie sehr das Telefon langsamer wird, wenn nur wenige Prozent des freien Speicherplatzes vorhanden sind. Immerhin nutzt es auch Flash-Speicher. Das Verstopfen des Speichers bei 100% ist nicht nur furchtbar langsam, sondern verbraucht auch viel Speicherkapazität.

Ein separater Artikel zum Thema .

2.5. Gesamt-WAF aus allen Faktoren

Durch lose gekoppelte Faktoren eingeführte WAFs multiplizieren sich.

3. Methodik zum Messen von Ressourcen aus JEDEC für benutzerdefinierte SSDs

In der JEDEC-Norm „Solid-State Drive (SSD) Endurance Workloads“ vom September 2010 beschreibt die JESD219A-Revision die Methode zum Testen von SSDs.

Kurz und bündig: JEDEC-Ingenieure haben 7 Monate lang Protokolle für Aufzeichnungen, TRIM und Flush (ein Befehl zum Flushen von Puffern auf die Festplatte) eines Laptop-Benutzers aufgezeichnet und hauptsächlich mit Office-Programmen gearbeitet. Vermutlich wurde Windows 7 auf dem Laptop (unterstützt TRIM seit 2009) auf dem NTFS-Dateisystem

mit einer Clustergröße von 4 KB installiert.

Benutzerreferenz Computerdetails und allgemeine StatistikenPlattform und ArbeitslastGesammelt auf Standard-Laptop-PC, 2 GB RAM, 128 GB SATA SSD, Betriebssystem unterstützt Trim

Hauptanwendung: Büro Produktivität

Sekundäre Verwendung: Speicherung von Fotos, Musik und Apps

Merkmale verfolgenSchreibt / schneidet / schneidet in eine Datei mit dem CSV-Format: $ command offset size

49 GB Speicherplatz (gesamte Daten wurden berührt)

128 GB überbrückt (Zugriff auf eine Reihe von LBAs)

Durchschnittliche Größe des zugeschnittenen Speicherplatzes = 13 GB (Durchschnitt über die Dauer der Ablaufverfolgung)

Andere Ablaufverfolgungsmerkmale

Ich habe dieses Protokoll analysiert, um zu verstehen, welche Aktivitäten dort aufgezeichnet wurden.

Während des Tests wird empfohlen, Einträge mit

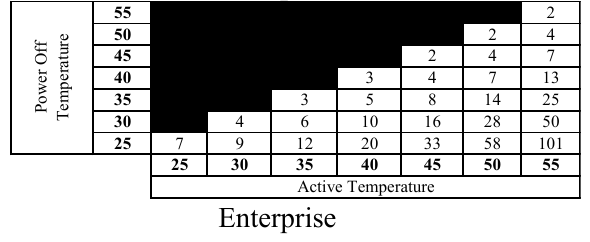

diesem Protokoll (Master-Trace) zu wiederholen, bis die erforderliche Anzahl von aufgezeichneten Terabyte (TBW) gewählt wurde. Anschließend müssen Sie überprüfen, wie lange die Zellen die Ladung speichern (Aufbewahrungszeit). Für eine benutzerdefinierte SSD sollte diese Zeit bei einer Lagertemperatur von 25 ° C etwa 2 Jahre betragen, wenn die Betriebstemperatur 40 ° C betrug. Da niemand 2 Jahre warten wird, erhöhen sie die Speichertemperatur, was zu einem höheren Elektronenverlust führt, und nach speziellen Tabellen (konstruiert nach

der Arrhenius-Gleichung ) wird die Datenspeicherzeit bei Normaltemperatur berechnet.

Interessante Fakten:

Wie Sie wissen, ist der NAND-Speicher in Seiten unterteilt, die zu Blöcken zusammengefasst sind. Das Schreiben und Lesen erfolgt seitenweise und das Löschen nur in Blöcken.

Wenn Sie etwas neu schreiben müssen, funktioniert die ideale Firmware in etwa so: Sie schreibt Seiten mit geänderten Daten in einen Block, in dem noch nicht geschriebene Seiten vorhanden sind, erstellt eine neue Korrespondenz-LBA → -Seite in FTL (Flash Translation Layer) und markiert die alte Seite als ungültig. Wenn es keine solchen Blöcke gibt, startet der Garbage Collector, der die Daten aus den halb gefüllten Blöcken in die gefüllten mit der Freigabe von Blöcken zusammensetzt.

Dies ist eine ideale Option. Nicht alle benutzerdefinierten SSDs verfügen über gute Algorithmen zur Abnutzungskorrektur. Wie aus den dramatisch unterschiedlichen Testergebnissen von 3dnews hervorgeht.

Eine typische Seitengröße beträgt 8 KB und mehr und eine Blockgröße von 2 MB und mehr. Bei JEDEC-Tests war das Laufwerk nie zu mehr als 38% gefüllt, daher gab es, wie ich vermute, immer freie Blöcke und daher keine aktive Arbeit des Garbage Collectors, wodurch auch SSD-Ressourcen verschwendet wurden. Es gab jedoch WAF (Write Multiplication Factor), da Daten manchmal mit unvollständigen Seiten geschrieben wurden und manchmal ein Datensatz an der Grenze von NAND-Seiten vorbeiging.

Beim Testen von JEDEC habe ich ein Skript zur Berechnung des WAF in Abhängigkeit von der Seitengröße geschrieben. Hier ist WAF abhängig von der NAND-Seitengröße:

Beim Testen von 3dnews ist WAF ungefähr 1, da die Dateien sequentiell geschrieben werden und Windows über einen Schreibcache verfügt, in dem die Sektoren ordnungsgemäß geschrieben werden.

In einem typischen Szenario, wenn die Seite 8 KB groß ist (Samsung 840 EVO), beträgt der WAF nur 1,11 (ein Fehler von 11% der Daten von 3dnews), was zu verzeihen scheint. Wenn wir jedoch WAF berücksichtigen, das den Garbage Collection-Algorithmus einführt, können wir nicht vergeben.

4. JEDEC-Methode zum Testen von Unternehmensantrieben auf Verschleißfestigkeit

Es wird viel formalisierter beschrieben und die Bedingungen sind strenger. Ein eindeutiger Prozentsatz von Datensätzen unterschiedlicher Länge wird angegeben. Datensätze mit einer Größe von bis zu 4096 Byte können willkürlich verschoben werden und sollten mit einer Länge von mehr als 4 KB an 4 KB-Offsets ausgerichtet werden.

Berechnung des WAF abhängig von der Seitengröße.5. Berechnung der Änderungen der 3dnews-Testergebnisse

Wir benötigen Korrekturfaktoren, um die Verschleißfestigkeit nach 3dnews in die Verschleißfestigkeit nach der Jedec-Methode umzurechnen.

Zunächst reduzieren wir das erzielte Ergebnis um das 2-fache, da die Haltbarkeit der Lagerung bei den Tests nicht überprüft wurde. Niemand möchte herausfinden, dass nach einem Urlaub die Festplatte in seinem Computer nicht mehr funktionierte oder mit Fehlern übersät war. Nummer 2 wird von der Decke genommen.

Gemäß der JEDEC-Methode ist die Festplatte nur zu 38% voll, was zu einer Erhöhung der WAF aufgrund der 1,55-fachen Speicherbereinigung führt (gemäß der obigen Formel). Dieses Verhältnis wird im Nenner sein.

Als nächstes berücksichtigen wir den Faktor der Datensatzmultiplikation in Abhängigkeit von der NAND-Seitengröße (erhalten durch Analysieren des Tests benutzerdefinierter SSDs mit der JEDEC-Methode) und multiplizieren ihn mit der WAF, die wir vom Garbage Collector erhalten haben.

Korrekturfaktoren für Discs mit einem Flächenüberschuss von 7,37%.Korrekturfaktoren für Discs mit einem Flächenüberschuss von 10%. Korrekturfaktoren für Discs mit einem Flächenüberschuss von 20%. Korrekturfaktoren für Discs mit einem Flächenüberschuss von 30%. 6. Änderungen an 3dnews-Testergebnissen für die Verwendung benutzerdefinierter SSDs in Servern

Ich muss sagen, dass dies eine schlechte Idee ist. Aber viele machen es. Aus diesem Grund werden wir versuchen, Korrekturfaktoren zu berechnen, um die Ressource der Benutzerfestplatten als Serverfestplatten zu bestimmen. Wir nehmen die Verschleißfestigkeit von 3dnews-Tests und dividieren sie durch den erforderlichen Koeffizienten, um die erwartete Ressource (JEDEC-Methode) für den Unternehmensgebrauch zu erhalten.

Die Server benötigen im getrennten Zustand keine solche Langzeitspeicherung wie bei Benutzer-SSDs. Hier ist die entsprechende Tabelle:

Bei einer typischen Betriebstemperatur von 50 ° C unter Last sollte das Laufwerk im ausgeschalteten Zustand bei 25 ° C eine Datenspeicherdauer von 58 Wochen (1 Jahr) bieten.

Für benutzerdefinierte Anwendungen (bei denen im ausgeschalteten Zustand für 2 Jahre Datensicherheit erforderlich ist) haben wir die Ressource um das Zweifache reduziert. Für den Unternehmensgebrauch ist eine so lange Haltbarkeit nicht erforderlich, daher nehmen wir eine kleinere Zahl, zum Beispiel 1.3.

Danach multiplizieren wir mit WAF, was für die Unternehmenslast typisch ist, und berücksichtigen dann die Arbeit des Müllsammlers und erhalten die folgenden Koeffiziententabellen. Das Ergebnis von 3dnews muss durch diese Zahl geteilt werden.

Es gibt ein Problem mit der Tatsache, dass der Standard die Größe des Sicherungsbereichs oder des freien Speicherplatzes für Unternehmenslaufwerke nicht beschreibt. Aus diesem Grund können wir die WAF des

JEDEC-Unternehmenstests nicht genau auswerten. Daher wird diese Zahl (1,55) dem benutzerdefinierten JEDEC-SSD-Test entnommen.

Korrekturfaktoren für Discs mit einem Flächenüberschuss von 7,37%.Korrekturfaktoren für Discs mit einem Flächenüberschuss von 10%. Korrekturfaktoren für Discs mit einem Flächenüberschuss von 20%. Korrekturfaktoren für Discs mit einem Flächenüberschuss von 30%. 8. Schlussfolgerungen

Wenn Sie Ihren Computer mehrere Monate lang nicht ausschalten, die NAND-Seitengröße nicht mehr als 16 KB beträgt und die Festplatte ungefähr halb voll ist, müssen die von 3dnews erreichten Ressourcenindikatoren durch 3 geteilt werden.

Teilen Sie für ein typisches Szenario (Festplattenbelegung 90%, Seitengröße 8 KB) die von 3dnews erhaltene Ressource durch 9, um eine Ressource gemäß den JEDEC-Standards zu erhalten.

Wenn Sie manchmal sehr lange Reisen unternehmen und das Laufwerk zu diesem Zeitpunkt nicht verwendet wird, empfehle ich Ihnen, in der Passressource zu bleiben. Danach sollte das Laufwerk gewechselt werden.

In seltenen Fällen, wenn die NAND-Seitengröße mehr als 16 KB beträgt und der Datenträger ziemlich voll ist, muss er zum Berechnen der tatsächlichen Ressource des Laufwerks um das Zehnfache und manchmal Hundertefache reduziert werden.

Und wenn Sie ein Budget-Laufwerk in den Server einbauen, kümmern Sie sich sowohl um den Raid als auch um das Backup. Sie haben keine stabile Reaktionszeit und -geschwindigkeit, keinen stabilen Stromschutz und andere Vorteile von Unternehmenslaufwerken. Sie können die Ressource jedoch mithilfe von Korrekturteilern aus der entsprechenden Tabelle des Artikels berechnen. Teilen Sie in einem typischen Fall durch 11.

Referenzen

→

Linux mit billigen Flash-Laufwerken optimieren→

So bestimmen Sie die Größe der Seite und des Flash-SpeicherblocksPS Direkte Fehler, die Sie in PM bemerken. Ich erhöhe das Karma dafür.

Danke für das Bild TripletConcept .

Sie können eine virtuelle Maschine mit SSD bei

RUVDS für den unten stehenden Gutschein

bestellen .