Stellen Sie sich vor, Sie gründen ein innovatives Medizingeschäft - eine individuelle Auswahl von Medikamenten, die auf einer Analyse des menschlichen Genoms basiert. Jeder Patient verfügt über 3 Milliarden Genpaare, und die Berechnung eines typischen Servers auf x86-Prozessoren dauert mehrere Tage. Sie wissen, dass Sie den Prozess auf einem Server mit einem FPGA-Prozessor beschleunigen können, der Berechnungen über Tausende von Threads hinweg parallelisiert. Er wird das Genom in ungefähr einer Stunde berechnen. Diese Server können bei Amazon Web Services (AWS) gemietet werden. Aber hier ist das Pech - der Kunde in der Person des Krankenhauses ist kategorisch dagegen, genetische Daten in die Cloud des Anbieters zu stellen. Wie zu sein Kingston und das Cloud-basierte Startup

stellten auf der Supercomputing 2019

die Private MultiCloud Storage (PMCS) -Architektur vor, um dieser Herausforderung zu begegnen.

Drei Voraussetzungen für High Performance Computing

Die Berechnung des menschlichen Genoms ist nicht die einzige Aufgabe im Bereich des High Performance Computing (HPC, High Performance Computing). Wissenschaftler berechnen physikalische Felder, Ingenieure - Details von Flugzeugen, Finanziers - Wirtschaftsmodelle und analysieren zusammen Big Data, bauen neuronale Netze auf und führen viele andere komplexe Berechnungen durch.

Drei Bedingungen für HPC sind enorme Rechenleistung, sehr hohe Kapazität und schnelle Speicherung sowie hohe Netzwerkbandbreite. Daher werden LDC-Berechnungen standardmäßig im unternehmenseigenen Rechenzentrum (vor Ort) oder beim Anbieter in der Cloud durchgeführt.

Aber nicht alle Unternehmen verfügen über eigene Rechenzentren, und diejenigen, bei denen dies der Fall ist, verlieren im Hinblick auf Ressourceneffizienz häufig an kommerzielle Rechenzentren (Investitionen für den Kauf und die Aktualisierung von Hardware und Software, die Bezahlung von hochqualifiziertem Personal usw.). . Im Gegensatz dazu bieten Cloud-Anbieter IT-Ressourcen nach dem Modell der umlagefinanzierten Betriebskosten an, d. H. Miete wird nur für die Zeit der Nutzung berechnet. Nach Abschluss der Berechnungen können die Server aus dem Konto gelöscht und damit IT-Budgets gespart werden. Wenn die Übertragung von Daten an den Anbieter gesetzlich oder unternehmensweit verboten ist, steht HPC Computing in der Cloud nicht zur Verfügung.

Privater MultiCloud-Speicher

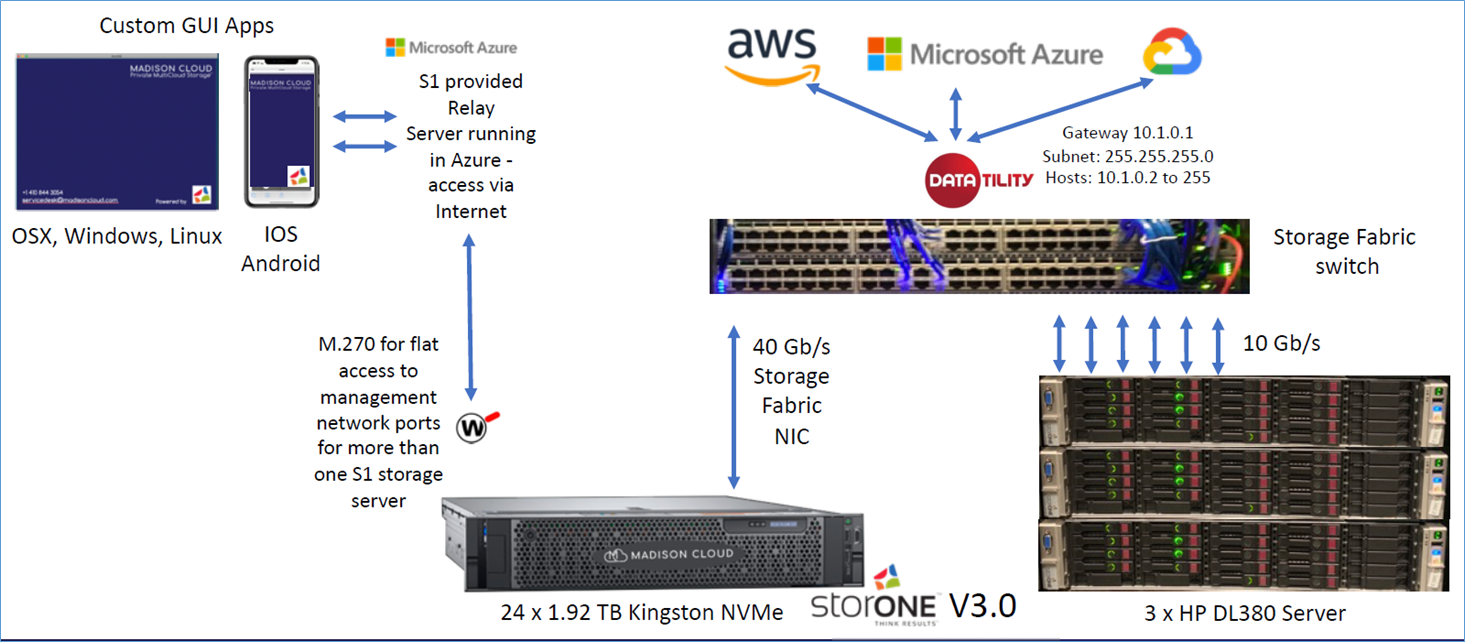

Die Architektur von Private MultiCloud Storage ermöglicht den Zugriff auf Cloud-Dienste, indem die Daten physisch am Standort des Unternehmens oder in einem separaten sicheren Fach des Rechenzentrums mithilfe des Colocation-Dienstes abgelegt werden. Hierbei handelt es sich im Wesentlichen um ein datenzentriertes verteiltes Computermodell, bei dem Cloud-Server mit Remotespeichersystemen aus einer privaten Cloud zusammenarbeiten. Dementsprechend können Sie mit demselben lokalen Data Warehouse mit Cloud-Diensten der größten Anbieter arbeiten: AWS, MS Azure, Google Cloud Platform usw.

Auf der Supercomputing-2019 stellte Kingston ein Beispiel für eine PMCS-Implementierung vor. Es handelt sich um ein Beispiel für ein Hochleistungsdatenspeichersystem (DCS) auf Basis von DC1000M-SSDs. Eines der cloudbasierten Start-ups ist die StorOne S1-Verwaltungssoftware für softwaredefinierten Speicher und dedizierte Kommunikationskanäle mit wichtigen Cloud-Anbietern .

Es ist zu beachten, dass PMCS als Arbeitsmodell für Cloud-Computing mit privatem Speicher für den nordamerikanischen Markt mit der entwickelten Netzwerkkonnektivität zwischen Rechenzentren entwickelt wurde, die auf AT & T- und Equinix-Infrastrukturen unterstützt wird. Daher beträgt der Ping zwischen dem Speichersystem bei der Kollokation in einem Equinix Cloud Exchange-Knoten und der AWS-Cloud weniger als 1 Millisekunde (Quelle: ITProToday ).In der auf der Ausstellung gezeigten Demonstration der PMCS-Architektur wurde das DC1000M NVMe-Speichersystem zusammengestellt und die virtuellen Maschinen in den Clouds von AWS, MS Azure und Google Cloud Platform miteinander gepingt. Die Client-Server-Anwendung arbeitete remote mit dem Kingston-Speichersystem und den HP DL380-Servern im Rechenzentrum zusammen und verschaffte Equinix über die Infrastruktur der Kommunikationskanäle Zugriff auf die Cloud-Plattformen der oben genannten Hauptanbieter.

Folie aus der Präsentation von Private MultiCloud Storage auf der Supercomputing-2019. Quelle: KingstonDie ähnliche Software zur Verwaltung der Architektur eines privaten Multi-Cloud-Speichers wird von verschiedenen Unternehmen angeboten. Die Begriffe für diese Architektur können auch anders klingen - Private MultiCloud Storage oder Private Storage for Cloud.

Folie aus der Präsentation von Private MultiCloud Storage auf der Supercomputing-2019. Quelle: KingstonDie ähnliche Software zur Verwaltung der Architektur eines privaten Multi-Cloud-Speichers wird von verschiedenen Unternehmen angeboten. Die Begriffe für diese Architektur können auch anders klingen - Private MultiCloud Storage oder Private Storage for Cloud."Moderne Supercomputer laufen auf einer Vielzahl von HPC-Anwendungen, die von der Öl- und Gasexploration über Wettervorhersagen und Finanzmärkte bis hin zur Entwicklung neuer Technologien eine Vorreiterrolle spielen", sagte Keat Shimmenti, Corporate Governance Manager für SSDs bei Kingston. "Diese HPC-Anwendungen erfordern eine wesentlich bessere Abstimmung zwischen Prozessorleistung und E / A-Geschwindigkeit." Wir sind stolz darauf, darüber zu sprechen, wie die Lösungen von Kingston zum Durchbruch beim Computing beitragen und die Leistung liefern, die Sie in den extremsten Computerumgebungen und -anwendungen der Welt benötigen. “

Drive DC1000M und ein Beispiel für ein darauf basierendes Speichersystem

Die DC1000M U.2 NVMe-SSD wurde von Kingston für Rechenzentren entwickelt und wurde speziell für die intensive Arbeit mit Daten und HPC entwickelt, z. B. für Anwendungen für künstliche Intelligenz (AI) und maschinelles Lernen (ML).

3,84 TB DC1000M U.2 NVMe-Laufwerk. Quelle: Kingston

3,84 TB DC1000M U.2 NVMe-Laufwerk. Quelle: KingstonDie DC1000M U.2-Laufwerke basieren auf einem Intel 3D-NAND-Speicher mit 96 Schichten, der vom Silicon Motion SM2270-Controller (PCIe 3.0 und NVMe 3.0) gesteuert wird. Silicon Motion SM2270 ist ein 16-Kanal-NVMe-Unternehmenscontroller mit PCIe 3.0 x8-Schnittstelle, doppeltem 32-Bit-DRAM-Datenbus und drei ARM Cortex R5-Doppelprozessoren.

Zur Veröffentlichung werden verschiedene DC1000M-Größen angeboten: von 0,96 bis 7,68 TB (die beliebtesten werden als 3,84 und 7,68 TB angesehen). Die Laufwerksleistung wird auf 800.000 IOPS geschätzt.

Speichersystem mit 10x DC1000M U.2 NVMe 7.68 TB. Quelle: Kingston

Speichersystem mit 10x DC1000M U.2 NVMe 7.68 TB. Quelle: KingstonAls Beispiel für das Speichersystem für HPC-Anwendungen stellte Kingston auf der Supercomputing-2019 eine Rack-Mount-Lösung mit 10 DC1000M U.2 NVMe-Laufwerken mit einer Kapazität von jeweils 7,68 TB vor. Das Speichersystem basiert auf SB122A-PH, der 1U-Formfaktor-Plattform von AIC. Prozessoren: 2x Intel Xeon CPU E5-2660, Kingston DRAM 128 GB (8x16 GB) DDR4-2400 (Teilenummer: KSM24RS4 / 16HAI). Als Betriebssystem wird Ubuntu 18.04.3 LTS, Linux-Kernel Version 5.0.0-31 installiert. Der gfio v3.13-Test (Flexible I / O-Tester) ergab eine Leseleistung von 5,8 Millionen IOPS bei einem Durchsatz von 23,8 Gbit / s.

Das vorgestellte Speichersystem zeigte beeindruckende Eigenschaften beim Parameter des stabilen Lesens von 5,8 Millionen IOPS (Eingabe-Ausgabe-Operationen pro Sekunde). Dies ist zwei Größenordnungen schneller als SSDs für Massenmarktsysteme. Diese Lesegeschwindigkeit wird für HPC-Anwendungen benötigt, die auf spezialisierten Prozessoren ausgeführt werden.Private Cloud Storage HPC in Russland

Die Aufgabe, gemeinsam mit dem Anbieter ein Hochleistungs-Computing durchzuführen, die Daten jedoch vor Ort physisch zu speichern, ist auch für russische Unternehmen von Bedeutung. Ein weiterer häufiger Fall im Inlandsgeschäft ist, dass sich die Daten bei der Nutzung ausländischer Cloud-Dienste auf dem Territorium der Russischen Föderation befinden sollten. Wir wurden gebeten, diese Situationen im Namen des Selectel-Cloud-Anbieters als langjähriger Kingston-Partner zu kommentieren.

„In Russland können Sie eine ähnliche Architektur aufbauen, indem Sie den Service in Russisch und alle Berichtsdokumente für die Kundenbuchhaltung bereitstellen. Wenn ein Unternehmen Hochleistungs-Computing mit lokalem Speicher ausführen muss, vermieten wir bei Selectel Server mit verschiedenen Prozessortypen, einschließlich

FPGAs ,

GPUs oder Multi-Core-CPUs. Darüber hinaus werden wir die Verlegung eines dedizierten optischen Kanals zwischen dem Büro des Kunden und unserem Rechenzentrum über Partner arrangieren “, kommentiert Alexander Tugov, Selectel Services Development Director. - Der Kunde kann seinen Speicher auch auf einer Colocation im Maschinenraum mit einem speziellen Zugriffsmodus platzieren und Anwendungen sowohl auf unseren Servern als auch in den Clouds der globalen Anbieter AWS, MS Azure, Google Cloud ausführen. In letzterem Fall ist die Signalverzögerung natürlich höher als in den USA, aber es wird eine Breitband-Multi-Cloud-Verbindung bereitgestellt. “

Im nächsten Artikel werden wir über eine andere Kingston-Lösung sprechen, die auf der Ausstellung Supercomputing-2019 (Denver, Colorado, USA) vorgestellt wurde und für maschinelles Lernen und Big-Data-Analyse mit Grafikprozessoren gedacht ist. Dies ist die GPUDirect-Speichertechnologie, die eine direkte Datenübertragung zwischen NVMe-Speicher und GPU-Prozessorspeicher ermöglicht. Darüber hinaus werden wir erläutern, wie wir es geschafft haben, eine Datenlesegeschwindigkeit von 5,8 Millionen IOPS im Rack-Mount-Speicher auf NVMe-Festplatten zu erreichen.

Weitere Informationen zu den Produkten von Kingston Technology finden Sie auf

der Website des Unternehmens .