Verwenden Sie jeden Tag Sprachassistenten? Ich nicht . Obwohl ich sie seit mehr als 7 Jahren entwickle!

Mit diesen Worten eröffnete die Entwicklungssitzung

unserer Konferenz zu Gesprächstechnologien in Moskau .

Und was ist eigentlich los mit all diesen "Alice", "Maroussia" und "Google Assistants"? Warum fühlen sich Benutzer mit ihnen nicht wohl, sind aber für das Geschäft unverständlich?

Und was ist die Open Source- Alternative zu all dem?Probleme mobiler Sprachassistenten

Alle mobilen Sprachassistenten arbeiten heute nach dem

„Harvester“ -Prinzip - Hunderte und Tausende von Funktionen sind unter einer Mikrofontaste verborgen. Es scheint - was ist bequemer? Sie müssen nicht Dutzende oder zwei Anwendungssymbole von Drittanbietern bereithalten. Einfach auf das Mikrofon geklickt, sagte - und es funktioniert

nicht .

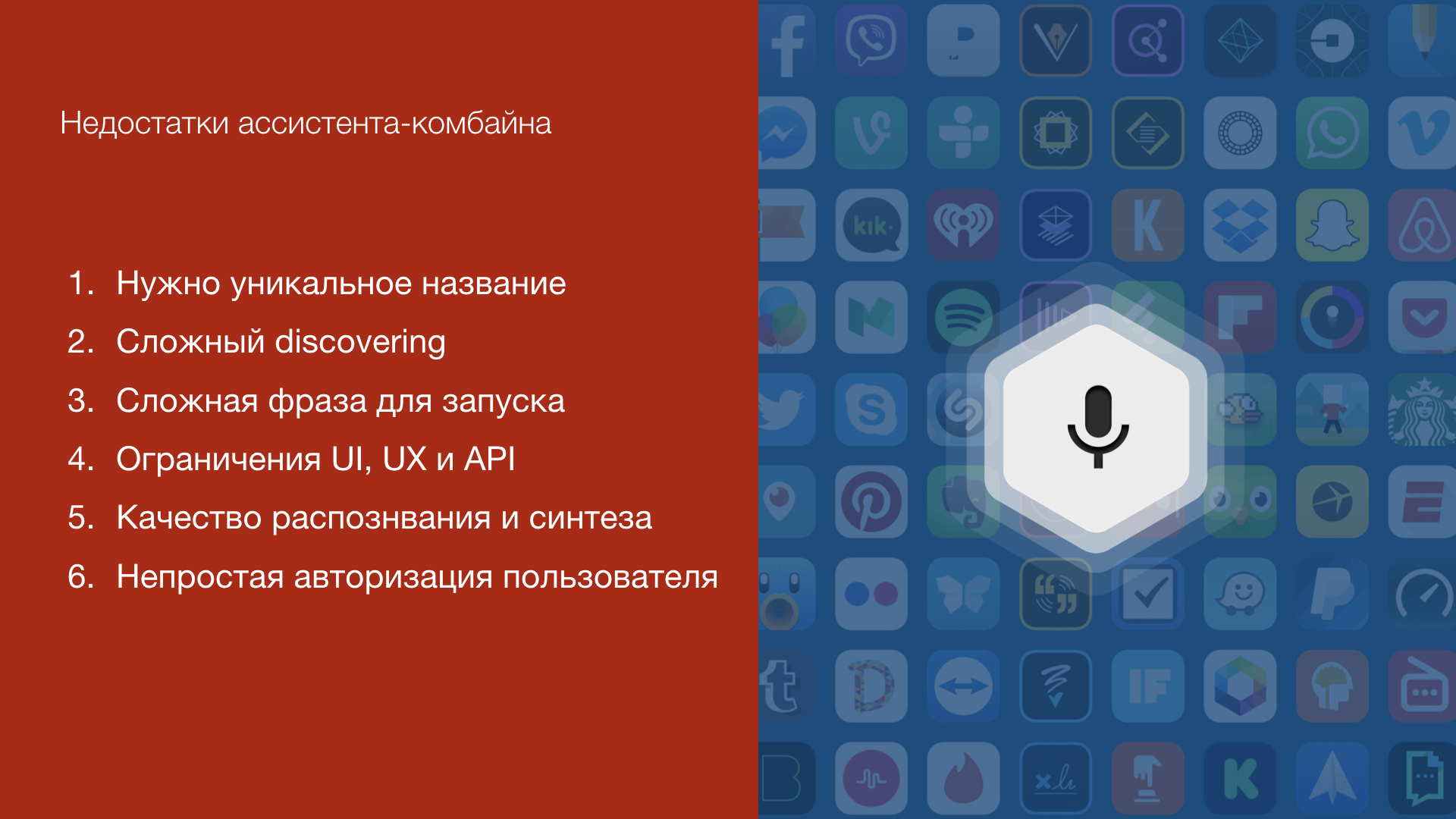

Aber hier sind die Probleme, auf die Sie sowohl als Benutzer als auch als Entwickler einer Sprachfunktion für solche "Assistenten" stoßen.

1. Eindeutiger Name

Jede Stimme "Fähigkeit" (Alice - "Fähigkeit") sollte einen

eindeutigen Namen haben . In der Tat, sonst kann ein Einknopf-Mähdrescher nicht zwischen ihnen unterscheiden! Und je mehr Funktionen der Sprachassistent hat, desto schwieriger ist es, einen solchen Namen zu wählen, damit sich die Benutzer daran erinnern.

2. Anspruchsvolles Entdecken

"Alice, starte die Fertigkeit Mein Lieblingsgeschäft." Oder "Okay Google, sprich mit Pizza Papa Johns." Ist das bekannt Dem Benutzer muss noch beigebracht werden, wie Sie Ihren Sprachdienst starten.

3. Einschränkungen von UI, UX und API

Voice Assistant ist eine Drittanbieteranwendung mit ihren Einschränkungen. Als Entwickler können Sie seiner Benutzeroberfläche nicht die Steuerelemente und Widgets hinzufügen, die Sie benötigen. Infolgedessen müssen Sie einfach mit dem arbeiten, was Sie haben, obwohl Ihre Funktionalität viel breiter sein könnte!

Und vieles mehr

Darüber hinaus gibt es Einschränkungen durch Spracherkennung und Sprachsynthese-Technologien, es ist schwierig, einen Benutzer in Ihrem Dienst zu autorisieren

und vieles mehr .

Infolgedessen kann der Benutzer Ihren Sprachdienst häufig einfach nicht finden, weiß nicht, wie er mit ihm sprechen soll, und ist mit einer eingeschränkten Funktionalität konfrontiert. Und Sie als Entwickler verstehen nicht, wie Sie Ihren Benutzer auf einen neuen Kanal bringen können, der

ein millionstes Publikum verspricht .

Assistent In-App-Konzept

Höchstwahrscheinlich verfügt Ihr Unternehmen bereits über eine mobile Anwendung mit klaren Tools für Funktionalität, Entwicklung, Werbung und Analyse.

Sie verstehen, woher der Benutzer kommt und wer er ist. Welche Funktionen er nutzt, wie man sie verbessert, entwickelt und wie sie sich auf das Geschäft auswirken. Dahinter verbirgt sich Ihr mobiles Entwicklungsteam, Designer, UX-Spezialisten, QS-Abteilung und Produkte.

Und der Benutzer versteht, welche Funktionalität Ihre Anwendung hat.

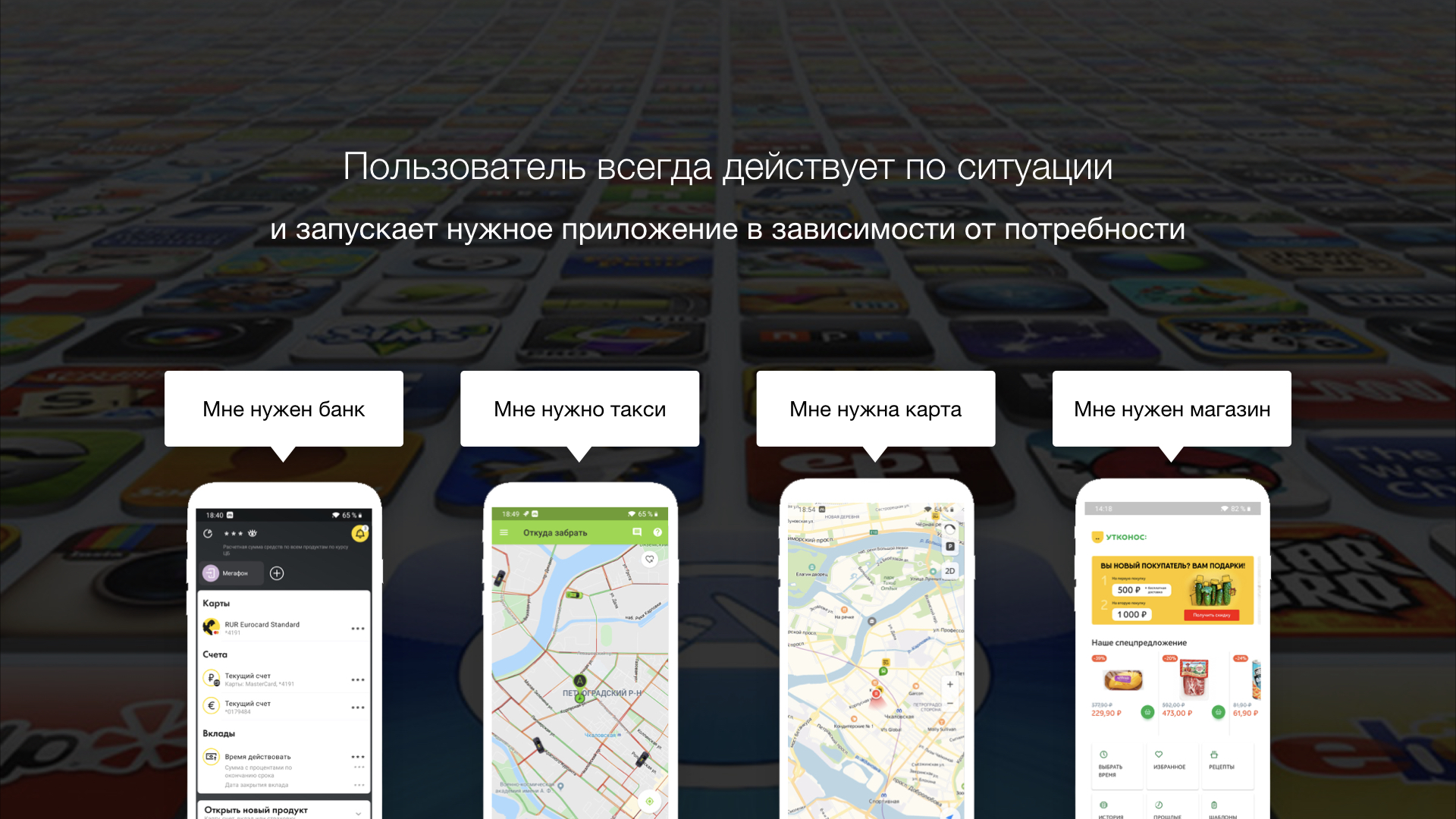

Wenn ich Geld an jemanden überweisen muss, starte ich den Antrag meiner Bank, mit dem meine Konten verknüpft sind. Wenn Sie Produkte bestellen müssen - starte ich die Store-Anwendung, in der ich normalerweise Waren kaufe.

Der Benutzer reagiert immer auf die jeweilige

Situation und startet die mobile Anwendung, die genau sein Bedürfnis hier und jetzt befriedigt. Es gibt keinen Grund zu der Annahme, dass der Benutzer definitiv die Mikrofontaste drücken wird, in der Hoffnung, dass der Sprachassistent die Funktion hat, die er benötigt, und seine Anfrage erfüllen wird!

So entstand das

Konzept eines In-App-Assistenten - das Konzept eines Sprachassistenten, der bereits in Ihrer mobilen Anwendung als

zusätzliche Benutzeroberfläche fungiert . In diesem Fall werden alle Einschränkungen der Assistenten-Harvester ausgeglichen, und der Benutzer versteht die Funktionalität des Assistenten basierend auf dem Kontext der mobilen Anwendung.

Assistent In-App-Fällen

Die Sprachfunktion ist genauso situativ wie der Start einer mobilen Anwendung. Es kann für den Benutzer praktisch sein, eine Funktion per Spracheingabe zu starten, wenn

- Dies ist ein neuer Benutzer, und er hat die Struktur der Benutzeroberfläche Ihrer Anwendung noch nicht herausgefunden.

- Der Benutzer merkt sich nicht, wo das gewünschte Menü oder die Schaltfläche versteckt ist

- Wenn er nur die vorherige Aktion wiederholen muss

- Wenn Sie zwei Wörter anstelle von 5 Bändern und Rollen sagen können

- Wenn es einfacher ist, ein Problem zu erklären, als in der Anwendung nach einer Lösung zu suchen

Schauen Sie sich ein paar einfache Fälle an.

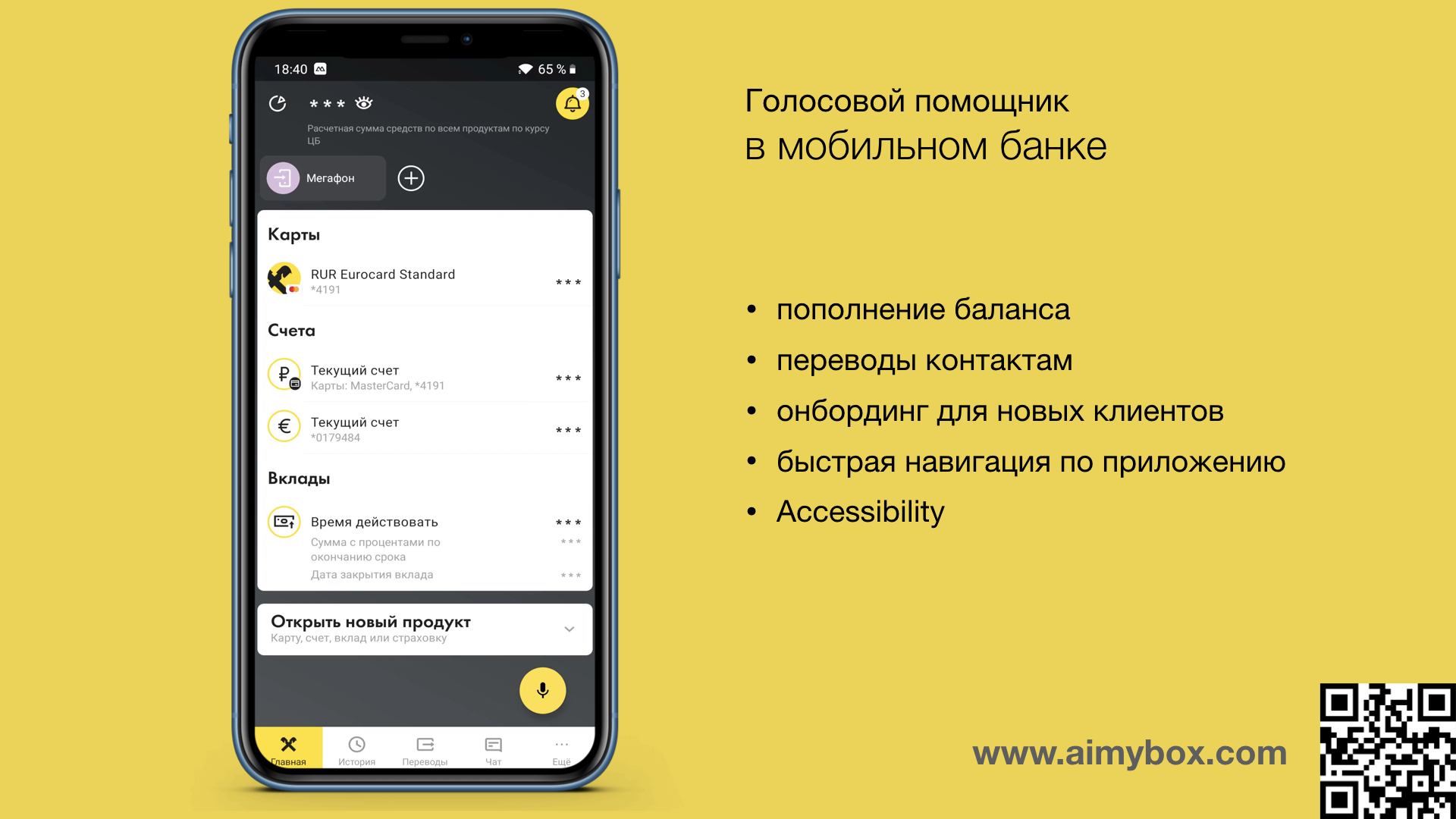

In einer Bankanwendung können Sie beispielsweise Geld an Personen aus Ihrer Kontaktliste überweisen. Der In-App-Assistent kann verstehen, wen der Benutzer meint, wenn er sagt: "500 Rubel an Mutter überweisen". Und der Benutzer muss nicht nach der gewünschten Schaltfläche suchen, nach dem Kontakt suchen und den Betrag eingeben.

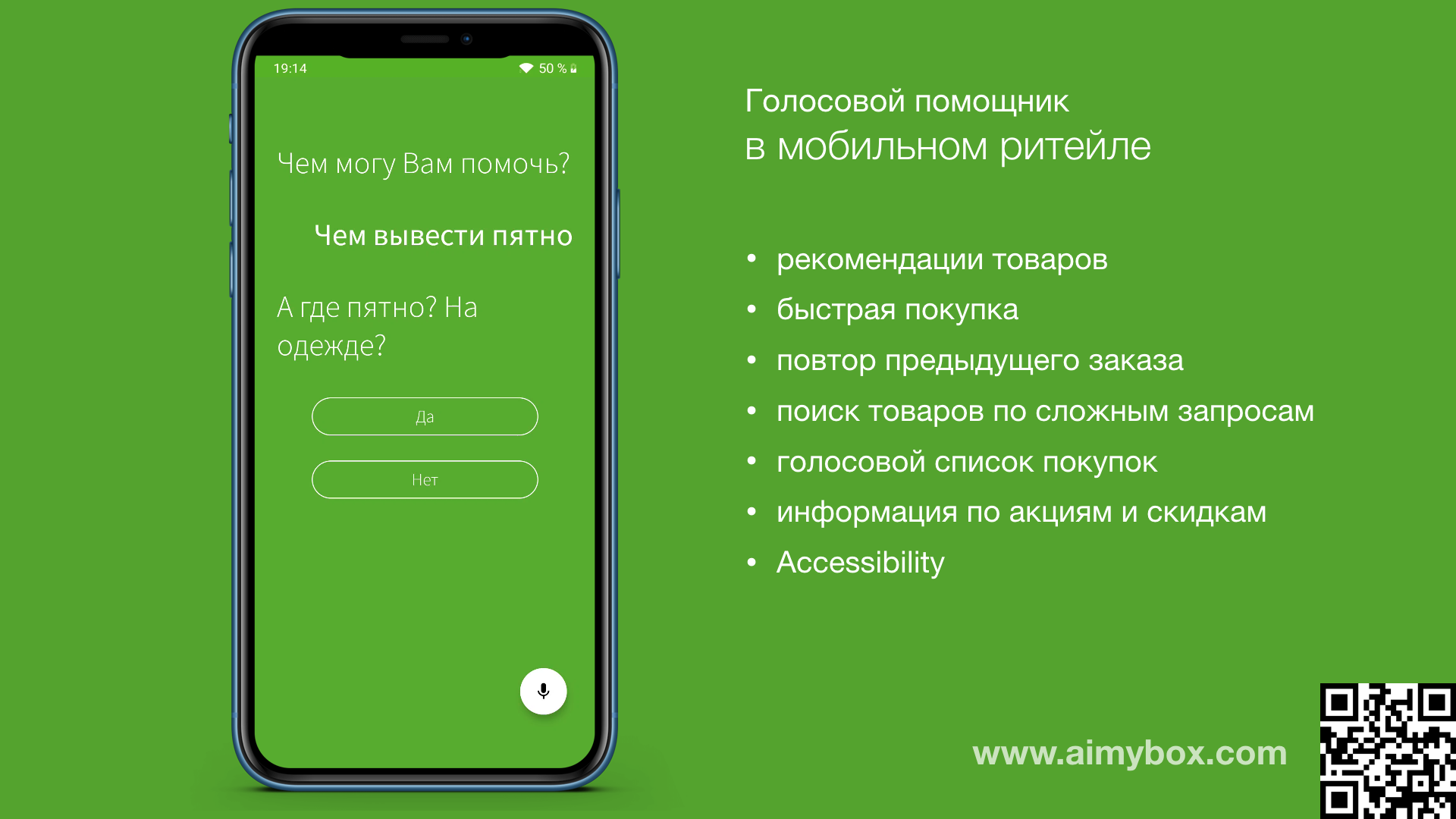

In einer Bankanwendung können Sie beispielsweise Geld an Personen aus Ihrer Kontaktliste überweisen. Der In-App-Assistent kann verstehen, wen der Benutzer meint, wenn er sagt: "500 Rubel an Mutter überweisen". Und der Benutzer muss nicht nach der gewünschten Schaltfläche suchen, nach dem Kontakt suchen und den Betrag eingeben. In der Anwendung des Einzelhändlers kann der Benutzer einen Assistenten anrufen, um das Problem einfach zu beschreiben, und der Assistent bietet das richtige Produkt an.

In der Anwendung des Einzelhändlers kann der Benutzer einen Assistenten anrufen, um das Problem einfach zu beschreiben, und der Assistent bietet das richtige Produkt an.

Es ist wichtig zu verstehen, dass eine solche Sprachschnittstelle nur zu einer vorhandenen Benutzeroberfläche

komplementär ist . Wie oben bereits erwähnt, wird der Wert nur angezeigt, wenn der Assistent als "Navigator" oder Empfehlungssystem fungiert.

Und da dies Ihr eigener Assistent in Ihrer Anwendung ist, ist dies nicht auf alles beschränkt, was wir oben in diesem Artikel aufgeführt haben: Sie müssen keinen eindeutigen Namen angeben, die Benutzeroberfläche kann beliebig sein, der Assistent kann direkt mit den Anwendungsfunktionen interagieren und so weiter.

So fügen Sie Ihrer Anwendung eine Stimme hinzu

Ja, Ihre mobilen Entwickler müssen sich sofort mit einer Vielzahl von Technologien auseinandersetzen, um die Sprachschnittstelle zu integrieren. Und das trotz der Tatsache, dass es eine nette Ergänzung ist und nicht die Hauptfunktionalität ... Nämlich: Verbinden Sie sich mit dem Spracherkennungssystem, der Sprachsynthese, der Sprachverarbeitungs-Engine, archivieren Sie die Benutzeroberfläche Ihres Sprachassistenten, implementieren Sie die Architektur und decken Sie sie mit Tests ab.

Aber es gibt eine Open-Source-Lösung, die all dies viel schneller und effizienter macht!Aimybox

Kürzlich haben wir bereits

ein wenig über den Open-Source-Sprachassistenten

Aimybox geschrieben , der genau darauf ausgelegt ist, die Implementierung von Sprachfunktionen in eine vorhandene mobile Anwendung zu erleichtern. Hier werden wir über ihn in Bezug auf das Konzept der In-App-Assistenten sprechen.

Jetzt werden Sie niemanden mit dem Vorhandensein einer Online-Chat-Schaltfläche auf der Website überraschen, mit der Sie schnell Kontakt mit dem Betreiber aufnehmen und Fragen zu Waren und Dienstleistungen stellen können. Dies ist eine zusätzliche Funktion, die jedoch bei ordnungsgemäßer Verwendung die Conversions erhöht. Um den Online-Chat auf Ihrer Website zu starten, müssen Sie Ihrem HTML-Code in der Regel nur ein Skript-Tag hinzufügen.

Aimybox geht in die gleiche Richtung, aber in Bezug auf den Sprachassistenten. Sie müssen lediglich ein paar Abhängigkeiten zu Ihrem Mobilanwendungsprojekt und ein paar Codezeilen hinzufügen, damit die Mikrofontaste in der rechten unteren Ecke angezeigt wird.

Hier können Sie sehen, wie das gemacht wird.

Aimybox bietet standardmäßig eine übersichtliche und

anpassbare Benutzeroberfläche (die bei Bedarf geändert werden kann) und das Assistenten-

SDK selbst. Darüber hinaus können Sie als

Erkennungs- ,

Synthese- und

NLP- Engines aus vorhandenen Engines auswählen oder ein eigenes Modul erstellen.

Im Wesentlichen implementiert Aimybox die Architektur des Sprachassistenten, standardisiert die Schnittstellen aller dieser Module und organisiert deren Interaktion ordnungsgemäß. Durch die Einführung dieser Lösung können Sie die Zeit für die Entwicklung einer Sprachschnittstelle in Ihrer Anwendung erheblich verkürzen.

Zusammenfassend

Sprachassistenten sind natürlich großartig. Das Gefühl ist jedoch, dass der Weg, den sie jetzt einschlagen, den Benutzer und das Unternehmen nur von der praktischen Technologie wegführt. Und dies liegt häufig auch daran, dass Entwickler noch nicht wissen, wie sie eine qualitativ hochwertige Sprach-UX erstellen können. Wir haben auch

kürzlich darüber geschrieben, wie dies behoben werden kann.

In diesem Artikel haben wir versucht, kurz über das völlig neue Konzept von In-App-Assistenten zu sprechen, dh über Sprachassistenten als interne Funktion einer mobilen Anwendung. In diesem Fall wird der Wert der Stimme als zusätzliche Benutzeroberfläche sowohl für den Benutzer als auch für den Entwickler deutlich.

Nützliche Links