Die Bestimmung des AI-Niveaus ist eines der schwierigsten, aber auch eines der wichtigsten Themen auf dem Gebiet der Informatik. Wenn Sie nicht sicher sagen können, ob die heute erstellte Maschine intelligenter ist als die gestern erstellte Maschine, wie können Sie dann feststellen, dass Sie Fortschritte machen?

Auf den ersten Blick scheint dies überhaupt kein Problem zu sein. "Natürlich wird die KI schlauer", lautet eine der Ansichten zum Problem. „Sehen Sie sich nur das ganze Geld und die talentierten Leute an, die in die Branche eingestiegen sind. Betrachten Sie Erfolge wie das Besiegen von Personen in GO und alle Arten von Aufgaben, die vor 10 Jahren nicht gelöst werden konnten, aber heute alltäglich sind, wie beispielsweise die Bilderkennung. Ist das wirklich kein Fortschritt?

Eine andere Ansicht ist, dass diese Erfolge kein guter Indikator für Intelligenz sind. Ja, die Niederlage der Leute in Schach und Go ist beeindruckend, aber was macht das schon, selbst wenn der intelligenteste Computer bei der Lösung allgemeiner Probleme für ein Kind oder eine Ratte verliert?

Diese Kritik stammt vom Forscher für künstliche Intelligenz, François Cholet, einem Google-Softwareentwickler und einer bekannten Persönlichkeit in der Community für maschinelles Lernen. Cholet ist der Schöpfer von Keras, einer sehr beliebten Bibliothek zum Erstellen neuronaler Netze. Er hat auch zahlreiche Tutorials zum maschinellen Lernen geschrieben und unterhält einen beliebten

Twitter-Account, in dem er Kommentare zu verschiedenen Branchenereignissen abgibt.

In einem kürzlich erschienenen Artikel

über das Messen von Intelligenz argumentiert Cholet auch, dass die KI-Welt entscheiden muss, was Intelligenz ist und was nicht. Laut Cholet sollten Forscher, die Fortschritte bei der Schaffung einer universellen künstlichen Intelligenz erzielen möchten, aufhören, sich mit gängigen Benchmarks wie Videospielen oder Brettspielen zu befassen, und über Fähigkeiten nachdenken, die die Menschen wirklich schlauer machen, wie zum Beispiel unsere Fähigkeit zu generalisieren und sich anpassen.

In einem Interview über das beinahe erledigte The Verge erläuterte Cholet seine Gedanken zu diesem Thema und erklärte, warum er der Ansicht ist, dass die gegenwärtigen Erfolge auf dem Gebiet der KI „verzerrt“ wurden, wie wir die Intelligenz in der Zukunft messen können und warum gruselige Geschichten über superintelligente KI ( die von Elon Musk und anderen erzählt werden) nehmen in der Vorstellung der Öffentlichkeit eine unverhältnismäßig große Aufmerksamkeit auf sich.

Das Interview wurde aus Gründen der Übersichtlichkeit leicht überarbeitet.

In Ihrem Artikel beschreiben Sie zwei unterschiedliche Konzepte der Intelligenz, die das Gebiet der KI beeinflusst haben. Die erste beschreibt Intelligenz als die Fähigkeit, in einer Vielzahl von Aufgaben erfolgreich zu sein, während die zweite der Anpassungsfähigkeit und Generalisierung den Vorrang gibt, dh der Fähigkeit der KI, auf neue Herausforderungen zu reagieren. Welches Konzept ist heute einflussreicher und welche Konsequenzen hat dies?In den ersten 30 Jahren der Industriegeschichte war das erste Konzept am beliebtesten: Intelligenz als eine Reihe statischer Programme und expliziter Wissensdatenbanken. Im Moment hat sich das Pendel sehr stark in die entgegengesetzte Richtung gedreht: Intelligenz wird als „sauberer Schiefer“ oder, um eine passendere Metapher zu verwenden, als „gerade initialisiertes tiefes neuronales Netzwerk“ dargestellt. Leider wird dieses Konzept fast nicht in Frage gestellt und wurde nicht umfassend untersucht. Diese Themen wurden in der wissenschaftlichen Gemeinschaft lange Zeit diskutiert - buchstäblich seit Jahrzehnten -, aber jetzt sehe ich kein Bewusstsein bei Menschen, die sich mit Tiefenlernen befassen, vielleicht, weil die meisten von ihnen nach 2016 in dieses Gebiet gekommen sind.

Intellektuelle Monopole von nur einem Standpunkt sind niemals gut, insbesondere als Antwort auf schlecht verstandene wissenschaftliche Fragen. Dies schränkt die Anzahl der gestellten Fragen ein. Es begrenzt die Anzahl der Ideen, die die Leute fragen könnten. Ich denke, dass sich die Forscher dieser Tatsache jetzt bewusst werden.

In Ihrem Artikel argumentieren Sie auch, dass die Verbesserung der KI eine genauere Definition der Intelligenz erfordert. Sie behaupten, dass sich die Forscher jetzt auf Benchmarks und statistische Tests konzentrieren, wie das Gewinnen von Videospielen und Brettspielen. Warum vermisst du diesen IQ?Tatsache ist, dass Sie bei Auswahl einer solchen Kennzahl alle verfügbaren Lücken (Shortcuts, verkürzte Pfade) verwenden, um sie zu erreichen. Wenn Sie beispielsweise eine Schachpartie als Maß für die Intelligenz auswählen (dies war in den 1970er bis 1990er Jahren der Fall), erhalten Sie ein System, das Schach spielt und sonst nichts. Es gibt keinen Grund zu der Annahme, dass dieses System für irgendetwas anderes gut ist. Als Ergebnis erhalten Sie einen Suchbaum und Minimax, der nichts über die menschliche Intelligenz aussagt. Das Streben nach Meisterschaft in Videospielen wie Dota oder StarCraft fällt heute in dieselbe intellektuelle Falle.

Möglicherweise ist dies nicht offensichtlich, da Fähigkeiten und Intelligenz beim Menschen eng miteinander verbunden sind. Der menschliche Verstand kann seine universelle Intelligenz nutzen, um spezielle Fähigkeiten für die Aufgabe zu erlernen. Leute, die wirklich gut im Schach sind, können als ziemlich schlau angesehen werden, weil wir indirekt wissen, dass sie von vorne angefangen haben und ihre universelle Intelligenz einsetzen mussten, um Schach spielen zu lernen. Sie waren nicht dafür gemacht, Schach zu spielen. Wir wissen also, dass sie ihre universelle Intelligenz auf andere Aufgaben lenken und lernen können, diese Aufgaben auf ähnliche Weise auszuführen. Das ist Vielseitigkeit.

Aber mit Autos etwas anders. Eine Maschine kann zum Schachspielen ausgelegt sein. Die Schlussfolgerung, die wir über Menschen ziehen - „kann Schach spielen, muss also klug sein“ - bricht zusammen. Und unsere anthropomorphen Annahmen können nicht mehr angewendet werden. Universelle Intelligenz kann aufgabenspezifische Fähigkeiten beherrschen, aber es gibt kein Zurück von aufgabenspezifischen Fähigkeiten zu universeller Intelligenz. Absolut. In Autos sind Fähigkeiten und Intelligenz zwei völlig verschiedene Dinge. Sie können beliebige Fähigkeiten in beliebigen Aufgaben erlangen, wenn Sie unendlich viele Daten zu einer Aufgabe sammeln (oder unendlich viele technische Ressourcen ausgeben). Und es bringt Sie der universellen Intelligenz noch keinen Zentimeter näher.

Der entscheidende Punkt hierbei ist, dass es kein Problem gibt, bei dem das Erreichen einer hohen Fertigkeit ein Zeichen der Intelligenz wäre. Nur wenn es sich bei der Aufgabe nicht wirklich um eine Metaaufgabe handelt und um sie zu lösen, müssten neue Fähigkeiten in einer Vielzahl bisher unbekannter Probleme erworben werden. So schlage ich vor, die Intelligenz zu messen.

Wenn uns aktuelle Tests nicht dabei helfen, KI mit einer universelleren und flexibleren Intelligenz zu entwickeln, warum sind sie dann so beliebt?

Wenn uns aktuelle Tests nicht dabei helfen, KI mit einer universelleren und flexibleren Intelligenz zu entwickeln, warum sind sie dann so beliebt?Es besteht kein Zweifel, dass die Bemühungen, die Champions in berühmten Videospielen zu besiegen, in erster Linie auf die Tatsache zurückzuführen sind, dass solche Projekte viel Aufmerksamkeit in den Medien erregen können. Wenn die Öffentlichkeit nicht an diesen bemerkenswerten „Errungenschaften“ interessiert wäre, die sich so leicht vorstellen lassen, dass sie angeblich Fortschritte bei der Erreichung der übermenschlichen KI erzielen, würden die Forscher etwas anderes tun.

Das macht mich ein wenig traurig, denn Forschung sollte offene wissenschaftliche Fragen beantworten und sich nicht mit PR beschäftigen. Wenn ich beabsichtige, Warcraft 3 auf übermenschlicher Ebene durch intensives Training zu „lösen“, können Sie absolut sicher sein, dass alles funktioniert, vorausgesetzt, wir haben ein Entwicklungstalent und eine ausreichende Rechenleistung (die Dutzende Millionen Dollar kosten wird, um ein solches Problem zu lösen). Was lerne ich dann über Intelligenz oder Vielseitigkeit? Nichts Im besten Fall würde ich das Ingenieurwissen erwerben, um Deep Learning zu skalieren. Daher halte ich dies nicht für eine wissenschaftliche Studie, da sie nicht lehrt, was wir noch nicht wussten. Wir beantworten keine einzige offene Frage. Wenn die Frage lautete: „Können wir X auf übermenschlicher Ebene spielen?“, Lautet die Antwort eindeutig: „Ja, wenn Sie viele Trainingssituationen generieren und in einem ausdrucksstarken Modell des Tiefenlernens darstellen können.“ Wir wissen das schon seit einiger Zeit. (

Eigentlich habe ich das gesagt, bevor die KI in Dota 2 und Starcraft das Champion-Level erreicht hat. )

Was sind Ihrer Meinung nach die tatsächlichen Ergebnisse dieser Projekte? Inwieweit werden ihre Ergebnisse falsch interpretiert oder verfälscht?Eine gravierende Verzerrung, die ich sehe, ist, dass diese High-Level-Gaming-Systeme einen echten Fortschritt in Richtung „KI-Systeme und ihre Fähigkeit, mit der Komplexität und Unsicherheit der realen Welt umzugehen“ darstellen Bot spielt Dota 2]. Aber das können sie nicht. Wenn dies so wäre, dann wären dies sehr nützliche Studien, aber das ist einfach nicht wahr. Nehmen wir zum Beispiel OpenAI Five: Er konnte die Komplexität von Dota 2 nicht bewältigen, da er mit 16 Charakteren trainiert war und sein Wissen nicht auf das gesamte Spiel übertragen konnte, in dem es mehr als 100 Charaktere gibt. Das Gameplay benötigte 45.000 Jahre, um es zu trainieren. Beachten Sie auch hier, dass die Anforderungen an Trainingsdaten mit der Komplexität der Aufgabe zunehmen. Das resultierende Modell erwies sich jedoch als sehr fragil: Nicht-Champions-Spieler konnten Strategien finden, um den Bot zu besiegen wenige Tage nachdem die KI der Öffentlichkeit zugänglich wurde.

Wenn Sie jemals lernen möchten, mit der Komplexität und Unsicherheit der realen Welt umzugehen, sollten Sie Fragen stellen wie: Was ist die Universalität von Intelligenz? Wie messen und steigern wir die Vielseitigkeit unserer Lernsysteme? Und das ist keineswegs das Gleiche wie jetzt, wenn wir zehnmal mehr Daten in ein großes neuronales Netzwerk ablegen, sodass es seine Fähigkeiten um mehrere Prozent verbessert.

Welches Maß an Intelligenz ist dann am besten für die Branche?Kurz gesagt, wir sollten die Bewertung von Fertigkeiten in bekannten Aufgaben wie Schach, Dota oder StarCraft einstellen und stattdessen die Fähigkeit des Systems bewerten, Fertigkeiten zu erwerben. Dies bedeutet, dass wir nur neue Aufgaben verwenden sollten, die dem System vorher nicht bekannt waren, das vorläufige Wissen über die Aufgabe messen, mit der das System gestartet wurde, und die Wirksamkeit des Systems messen sollten (wie viele Daten benötigt werden, um zu lernen, wie die Aufgabe zu erledigen ist). Je weniger Informationen (Vorkenntnisse und Erfahrungen) Sie benötigen, um ein bestimmtes Kompetenzniveau zu erreichen, desto intelligenter sind Sie. Angesichts dessen sind moderne Systeme der künstlichen Intelligenz in der Tat nicht sehr intelligent.

Darüber hinaus werden Maschinen mit einem solchen Maß an Intelligenz eher wie Menschen aussehen, da es verschiedene Arten von Intelligenz geben kann, und menschliche Intelligenz ist das, was wir indirekt meinen, wenn wir über universelle Intelligenz sprechen. Dazu gehört auch der Versuch zu verstehen, mit welchem Wissen Menschen in die Welt hineingeboren werden. Die Leute lernen unglaublich effektiv - sie brauchen sehr wenig Erfahrung, um neue Fähigkeiten zu erwerben - aber sie tun es nicht von Grund auf neu. Sie nutzen angeborenes Wissen zusätzlich zu den Fähigkeiten und Kenntnissen, die sich im Laufe des Lebens angesammelt haben.

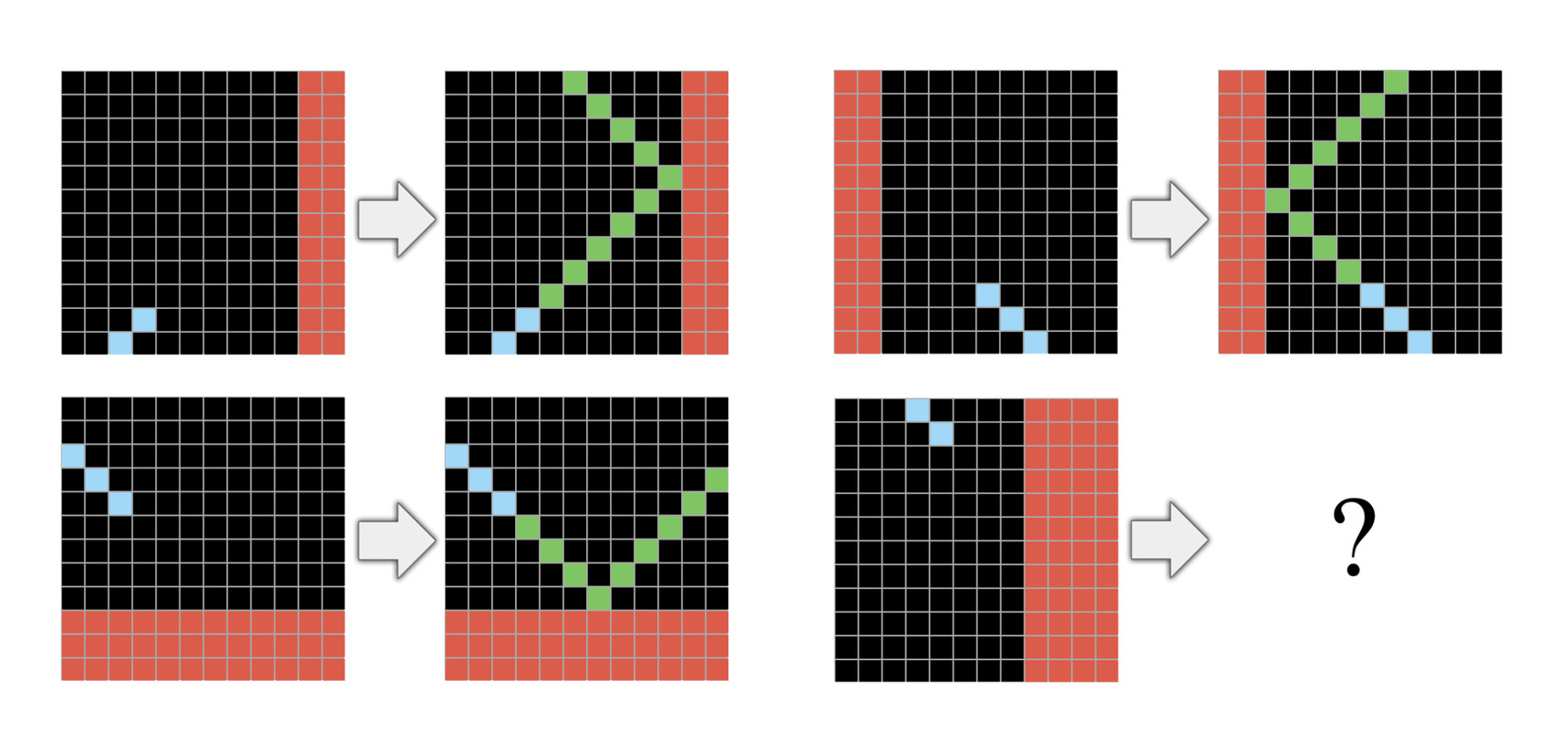

In meinem letzten Artikel schlage ich einen neuen Auswertungsdatensatz vor, ARC, der dem IQ-Test sehr ähnlich ist. ARC ist eine Reihe von mentalen Aufgaben, bei denen jede Aufgabe in einer kurzen Folge von Demos (normalerweise drei) erklärt wird. Sie müssen anhand dieser wenigen Demos lernen, wie Sie die Aufgabe erledigen. Die Idee hinter ARC ist, dass jede Aufgabe, die Ihr System bewertet, völlig neu sein und nur Wissen enthalten sollte, das mit dem angeborenen Wissen des Menschen übereinstimmt. Beispielsweise kann die menschliche Sprache bei solchen Aufgaben nicht verwendet werden. Derzeit können Personen ARC ohne verbale Erklärung oder vorbereitende Vorbereitung lösen, aber keines der derzeit bekannten KI-Systeme kann es lösen. Dies ist ein wichtiger Indikator dafür, dass wir neue Ideen brauchen.

Glauben Sie, dass die KI-Welt in der Lage sein wird, ihren Fortschritt fortzusetzen, indem Sie einfach die Rechenleistung erhöhen, um Probleme zu lösen? Einige argumentieren, dass dies im Laufe der Jahre der effektivste Weg zur Steigerung der Produktivität war. Wenn andere meinen, dass sich die Ergebnisse und Wachstumsraten verschlechtern werden, wenn wir diesem Weg folgen.

Glauben Sie, dass die KI-Welt in der Lage sein wird, ihren Fortschritt fortzusetzen, indem Sie einfach die Rechenleistung erhöhen, um Probleme zu lösen? Einige argumentieren, dass dies im Laufe der Jahre der effektivste Weg zur Steigerung der Produktivität war. Wenn andere meinen, dass sich die Ergebnisse und Wachstumsraten verschlechtern werden, wenn wir diesem Weg folgen.Dies ist absolut richtig, wenn Sie an einer bestimmten Aufgabe arbeiten. Die Verwendung von mehr Trainingsdaten und mehr Rechenleistung für eine vertikale Aufgabe erhöht die Produktivität dieser Aufgabe. Sie erhalten jedoch praktisch kein Verständnis dafür, wie Sie die Vielseitigkeit der künstlichen Intelligenz erreichen können.

Wenn Sie über ein ausreichend umfangreiches Modell für eine gründliche Schulung und ein gutes Beispiel für die Aufgabe verfügen, erfahren Sie, wie Sie dieses Problem lösen können, unabhängig davon, ob es sich um Dota oder StarCraft handelt. Und es ist äußerst wertvoll. Dies kann für nahezu unendlich viele Aufgaben im Zusammenhang mit der Wahrnehmung von Maschinen verwendet werden. Das einzige Problem besteht darin, dass die von Ihnen benötigte Datenmenge eine kombinatorische Funktion im Verhältnis zur Komplexität der Aufgabe ist, sodass selbst geringfügig komplexe Aufgaben zu teuer werden können.

Nehmen wir zum Beispiel Autopilot-Autos. Millionen von Trainingssituationen reichen für ein Modell nicht aus, das nur ein gründliches Training absolviert, um sicheres Fahren zu erlernen. Aus diesem Grund haben wir noch keinen Autopiloten der 5. Stufe. Und in den fortschrittlichsten Autopilotsystemen wird Deep Learning hauptsächlich zum Verknüpfen von Sensordaten und manuell erstellten Modellen verwendet. Und wenn wir universelles Tiefenlernen hätten, hätten wir 2016 einen Autopiloten der Stufe 5 in Form eines großen neuronalen Netzes.

Und schließlich, da Sie über die Grenzen der modernen KI sprechen, erscheint es mir sinnvoll, nach der Befürchtung zu fragen, dass eine extrem starke KI in naher Zukunft die Menschheit schädigen könnte. Glauben Sie, dass dies begründete Befürchtungen sind?Nein, ich glaube nicht an die Gültigkeit dieser Idee. Wir haben noch nie eine eigenständige KI erstellt. Und es gibt absolut keine Anzeichen dafür, dass wir es in absehbarer Zukunft schaffen können. (Die KI-Branche bewegt sich derzeit nicht in diese Richtung.) Und wir können uns nicht einmal vorstellen, wie ihre Merkmale aussehen könnten, wenn wir sie letztendlich in ferner Zukunft schaffen würden. Wenn Sie eine Analogie wollen, dann ist es, als würden Sie 1600 fragen: „Die Ballistik entwickelt sich ziemlich schnell! Aber was ist, wenn wir einmal eine Waffe haben, die eine ganze Stadt zerstören kann? Wie können wir sicher sein, dass sie nur die Bösen tötet? " Dies ist eine ziemlich schlecht formulierte Frage, und ihre Erörterung ohne genaue Kenntnis dieser zukünftigen KI läuft bestenfalls auf ein philosophisches Argument hinaus.

Und doch lenken diese Befürchtungen über die Intelligenz die Aufmerksamkeit von anderen Bereichen ab, in denen KI heutzutage sehr gefährlich sein kann. Bestimmte Wege, KI zu benutzen, sind gefährlich ohne Superintelligenz. Ich schrieb darüber, wie AI für algorithmische Propagandasysteme verwendet werden kann. Über den wachsenden Trend, KI in Waffensystemen einzusetzen, oder über KI als Instrument zur totalitären Kontrolle wurde bereits viel geschrieben.

Es gibt eine Geschichte über die Belagerung von Konstantinopel im Jahr 1453. Während die Stadt gegen die osmanische Armee kämpfte, diskutierten ihre Gelehrten und Herrscher darüber, welche Art von Engeln vom Geschlecht sein könnten. Und je mehr Energie und Aufmerksamkeit wir der Debatte über das Geschlecht der Engel widmen oder über die Werte nachdenken, die eine superintelligente KI haben sollte, desto weniger achten wir auf die Lösung dringender und realer Probleme. Es gibt einen bekannten IT-Marktführer, der gerne über die superintelligente KI als Hauptbedrohung für die Menschheit spricht. Nun, während diese Ideen alle Schlagzeilen einnehmen, diskutieren Sie nicht, ob es ethisch vertretbar ist, Autos mit ungenügend genauem Autopiloten auf unseren Straßen zu produzieren, was zu Unfällen und Todesfällen führt.

Wenn Sie diese Kritik akzeptieren - dass es derzeit keine technische Grundlage für diese Befürchtungen gibt - warum sind sie Ihrer Meinung nach so beliebt?Ich denke, das ist nur eine schöne Geschichte, und die Leute mögen es. Es ist kein Zufall, dass alles so sehr an religiöse Geschichten über das Ende der Welt erinnert, denn solche Geschichten haben sich unter den Menschen seit langem verbreitet und verbreitet. Aus dem gleichen Grund wird diese Angst oft in Science-Fiction-Filmen und Romanen verwendet. Das liegt daran, dass es eine schöne Geschichte ist. Und Menschen brauchen Geschichten, um die Welt zu verstehen. Und solche Geschichten sind viel mehr gefragt, als die Natur der Intelligenz zu verstehen oder zu verstehen, was den technologischen Fortschritt antreibt.

Es gibt auch interessantere Stücke

im Telegrammkanal .