Maschinelles Lernen und tiefe neuronale Netze sind in der Lage, die „Sprache des Verhaltens“ von Tieren auf eine Weise zu erkennen und zu analysieren, die über die menschlichen Fähigkeiten hinausgeht

Um die Bewegungen von Tieren in der natürlichen Umgebung zu verfolgen, wenden sich Wissenschaftler zunehmend der Methode des maschinellen Lernens (MO) zu. In diesem Video verfolgt der DeepPoseKit-Algorithmus die Bewegung und Ausrichtung einer Wüstenheuschrecke auf engstem Raum, um Forschern Daten zum Gelenkverhalten von Insekten bereitzustellen.

Um die Bewegungen von Tieren in der natürlichen Umgebung zu verfolgen, wenden sich Wissenschaftler zunehmend der Methode des maschinellen Lernens (MO) zu. In diesem Video verfolgt der DeepPoseKit-Algorithmus die Bewegung und Ausrichtung einer Wüstenheuschrecke auf engstem Raum, um Forschern Daten zum Gelenkverhalten von Insekten bereitzustellen.Um zu verstehen, was in den Köpfen der Tiere vor sich ging, wurden Neurowissenschaftler auf unerwartete Weise geschickt: vom direkten Einblick in das lebende Gehirn bis zur Steuerung von Neuronen mithilfe von Lichtblitzen, um komplexe Geräte und virtuelle Umgebungen zu schaffen.

2013 führte dies den Neurowissenschaftler

Bob Dattu zusammen mit Kollegen der Harvard Medical School in den Best Buy-Supermarkt, der sich in der gleichen Straße wie das Labor befindet.

Im Unterhaltungselektronikgeschäft fanden sie, wonach sie suchten: die Xbox Kinect, ein Spielgerät, das Spielerbewegungen erfasst. Wissenschaftler mussten die kleinsten Details der Bewegungen der von ihnen untersuchten Mäuse beobachten, aber keine der traditionellen Labortechnologien konnte damit umgehen. Daher wandte sich Dattas Gruppe dem Spielzeug zu, um seine dreidimensionalen Informationen über die Bewegungen der Tierkörper zu nutzen, um ihr Verhalten in der Umwelt zu untersuchen. Das Gerät gab ihnen tatsächlich eine Punktewolke im dreidimensionalen Raum und das Team analysierte dann die rhythmischen Bewegungen dieser Punkte.

Dattas Entscheidung mag für seine Zeit unorthodox gewesen sein, aber sie wurde zum Symbol für die heutige Welle der automatischen Annäherung, die die Wissenschaft des Verhaltens transformiert. Durch eine eingehendere und quantitativere Untersuchung des Verhaltens von Tieren hoffen die Forscher, die dafür verantwortlichen nicht beobachtbaren inneren Zustände besser zu verstehen. "Wir wissen nicht, unter welchen Bedingungen das Tier möglicherweise leidet", schrieb

Adam Calhoun , ein Postdoc, der das Verhalten von Tieren an der Princeton University studierte.

Ein weiteres Hindernis ergibt sich, wenn versucht wird, diese internen Zustände einer bestimmten Aktivität in den komplexen neuronalen Schaltkreisen des Gehirns zu vergleichen. Obwohl hoch entwickelte Instrumente die Arbeit von Tausenden von Neuronen gleichzeitig aufzeichnen können, "verstehen wir die Leistung des Gehirns nicht", sagte Dutta. "Um diese dichte neuronale Kodierung zu verstehen, muss man Zugang zu einem breiteren Verständnis des Verhaltens haben."

Dieses weitreichende Verständnis könnte bald unseren Versuchen zum Opfer fallen, es zu verstehen. Basierend auf dem Erfolg des maschinellen Lernens entwickeln Wissenschaftler Algorithmen, die Tierbewegungen bis zu winzigen Änderungen des Winkels der Flügel einer Fliege oder des Biegens des Mausrückens automatisch verfolgen. Sie erstellen auch Werkzeuge, mit denen Muster gefunden werden können, indem diese Daten automatisch analysiert und klassifiziert werden, um Hinweise auf den inneren Zustand der Tiere zu erhalten.

Der Hauptvorteil dieser Methoden ist, dass sie nach Mustern suchen können, die für Menschen unsichtbar sind. In einem im letzten Monat in der Fachzeitschrift Nature Neuroscience veröffentlichten Artikel erstellte Calhoun zusammen mit den Princeton-Neurowissenschaftlern

Malaya Murty und

Jonathan Pillow ein Modell des maschinellen Lernens, das nur Verhaltensbeobachtungen verwendet, um die drei internen Zustände zu bestimmen, die die Paarungsgewohnheiten von Fruchtfliegen bestimmen. Durch die Manipulation der Gehirnaktivität der Fliegen konnten die Forscher dann die Gruppe von Neuronen bestimmen, die diese Bedingungen kontrollierten.

Die Arbeiten zur Bewegungsverfolgung und Verhaltensanalyse, die diese Entdeckungen ermöglichten, stellen eine technologische Revolution bei der Untersuchung des Verhaltens dar. Daraus folgt auch, dass dies der erste von vielen zukünftigen Erfolgen ist. Wissenschaftler verwenden diese Methoden nun, um Antworten auf Fragen in den Bereichen Neurobiologie, Genetik, Evolution und Medizin zu finden, die bisher unlösbar schienen.

Protokolle und Verzeichnisse

Seit Jahrzehnten quantifizieren Wissenschaftler das Verhalten von Tieren in Laboratorien und in der Natur, indem sie mit Stift, Papier und Stoppuhr bewaffnet werden. Sie sahen zu, wie ihre Versuchspersonen schliefen, spielten, Essen besorgten und sich paarten. Sie werteten die Beobachtungen aus, skizzierten Muster von Mustern und entwickelten organisatorische Plattformen, um diese Trends zu systematisieren und zu erklären. Die Biologen Nikolaas Tinbergen, Konrad Lorenz und Karl von Frisch erhielten 1973 den

Nobelpreis für die unabhängige Durchführung ähnlicher Experimente mit Fischen, Vögeln und Insekten.

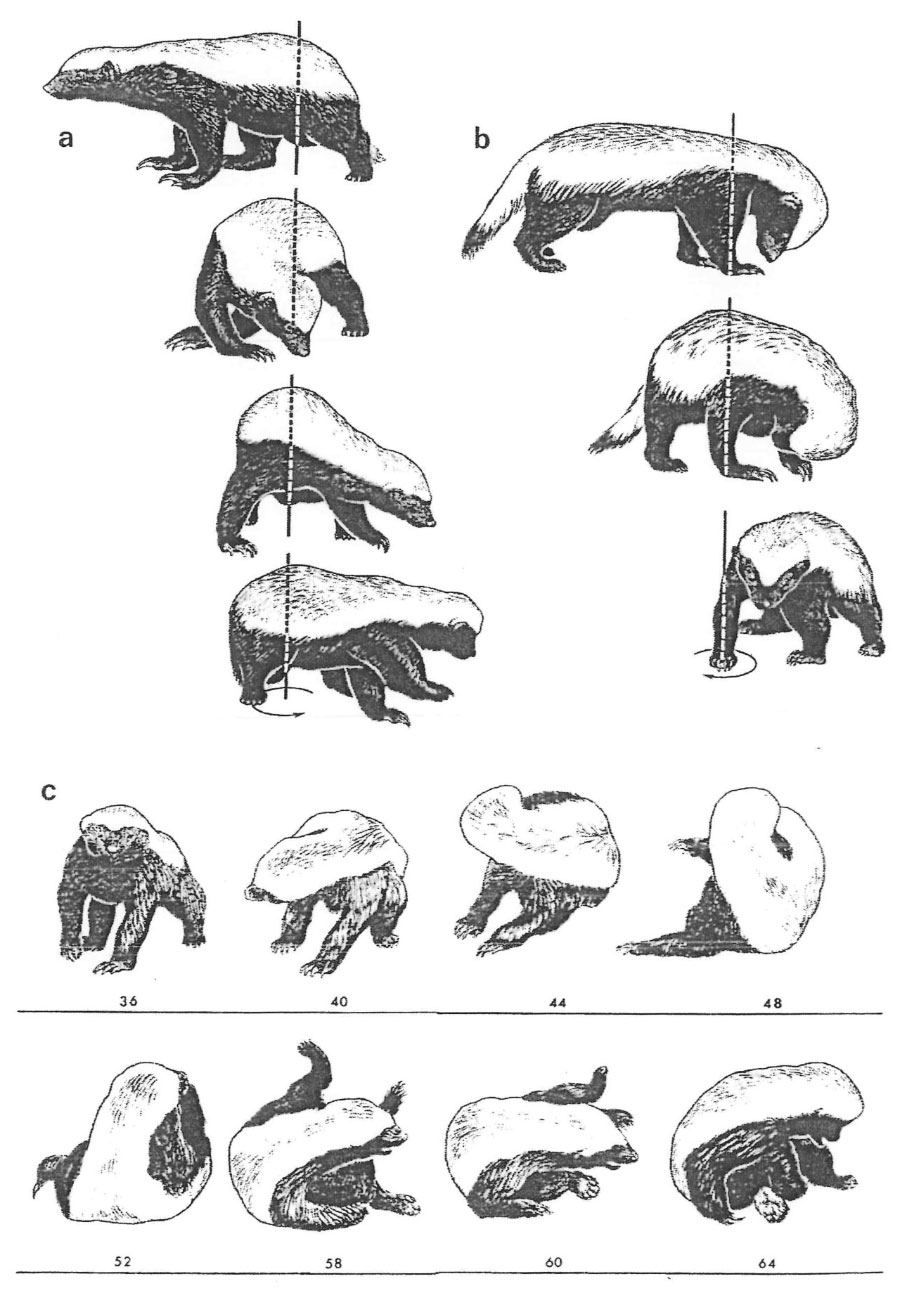

Der Zoologe Ilan Golani skizzierte manuell die Bewegung und das Verhalten verschiedener Arten, um die Regeln, die das Verhalten von Tieren bestimmen, quantitativ zu beschreiben. Diese Figuren zeigen die Rotation des ganzen Körpers durch den Honigdachs.

Der Zoologe Ilan Golani skizzierte manuell die Bewegung und das Verhalten verschiedener Arten, um die Regeln, die das Verhalten von Tieren bestimmen, quantitativ zu beschreiben. Diese Figuren zeigen die Rotation des ganzen Körpers durch den Honigdachs.Solche Verhaltenskataloge können

sehr detailliert sein . In einer Beschreibung des Waschens einer Maus aus dem Jahr 1973 beschrieb Nature die „wählerischen Bewegungen der Vorderbeine unter der Schnauze“ und die „breiten, synchronen, aber asymmetrischen Bewegungen der Vorderbeine über dem Kopf“ und bewertete die Wahrscheinlichkeit solcher Gesten in verschiedenen Situationen. Die Forscher mussten alles so detailliert beschreiben, weil sie nicht wussten, welcher Aspekt des beobachteten Verhaltens wichtig sein könnte.

Einige Wissenschaftler näherten sich dieser Angelegenheit von der entgegengesetzten Seite, indem sie die Vielfalt des Verhaltens der Tiere auf ein Minimum beschränkten, sie unter kontrollierten Laborbedingungen versetzten und ihnen erlaubten, nur die einfachsten Entscheidungen mit zwei Optionen zu treffen, z. Solche Vereinfachungen waren manchmal nützlich und informativ, aber künstliche Einschränkungen beeinträchtigen auch das Verständnis der Wissenschaftler für natürliches Verhalten und können zum Verlust wichtiger Signale führen. "Das Bedürfnis, Verhalten perfekt zu verstehen, schränkt den Umfang dieser Studien ein", sagte

Ann Kennedy , eine Postdoktorandin der theoretischen Neurowissenschaften am California Institute of Technology.

Daher beschlossen die Wissenschaftler, diesen Bereich zu erneuern und "ihr Denken in Richtung eines quantitativen Ansatzes zu

ändern ", sagte

Talmo Pereira , ein Doktorand in den Laboratorien von Murty und

Joshua Shevica in ihrem Princeton. Ein wichtiger Schritt bei dieser Änderung war die Automatisierung der Datenerfassung und -analyse.

Verfolgen Sie Schnauze, Wirbelsäule und Schwanz

Die Bilderfassungstechnologie war schon immer wichtig, um die Haltung sich bewegender Tiere zu verfolgen. Im 19. Jahrhundert verwendete

Edward Maybridge die

Chronofotografie , um die Mechanismen des Pferderennens und des Tanzens zu analysieren. Fotos erleichterten die Analyse der Position beispielsweise der Gliedmaßen oder des Kopfes des Tieres und machten diesen Vorgang genauer. Mit dem Aufkommen der Videoaufzeichnungstechnologie konnten die Forscher genauere Messungen durchführen - sie mussten jedoch immer noch auf groben Schätzungen der Geschwindigkeit oder Position des Tieres basieren. Es war unmöglich, jede Bewegung in drei Dimensionen zu verfolgen. Trotzdem musste noch viel Arbeit geleistet werden, um alle Notizen für das Video manuell zu katalogisieren und in den Computer einzugeben - dieser Prozess hat sich im Vergleich zur älteren Methode des Skizzierens in Notizbüchern nicht wesentlich verbessert.

Edward Maybridge verwendete Zeitrafferfotografie, um die Gangart eines Pferdes und anderer sich bewegender Tiere zu untersuchen. Seine Kamera konnte für das menschliche Auge unzugängliche Details erfassen und erfassen.

Edward Maybridge verwendete Zeitrafferfotografie, um die Gangart eines Pferdes und anderer sich bewegender Tiere zu untersuchen. Seine Kamera konnte für das menschliche Auge unzugängliche Details erfassen und erfassen.In den 1980er Jahren begannen die Forscher, Computer-Vision-Algorithmen für ihre Zwecke anzupassen, die bereits zur Suche nach Gesichtern und Konturen in Bildern verwendet wurden, um Probleme wie die Verfolgung der Konturen von Fliegen auf der Oberfläche zu lösen. In den folgenden Jahrzehnten wurden Systeme entwickelt, die die Position des Tieres in jedem Bild des Videos feststellten, ein bestimmtes Tier in einer Gruppe von mehreren fanden und sogar bestimmte Körperteile und deren Ausrichtung bestimmten.

Die Wirksamkeit dieser Programme ließ jedoch zu wünschen übrig. "Darunter waren Hinweise darauf, was in Zukunft passieren könnte", sagte

Ian Cousin , Direktor des nach ihm benannten Instituts für Tierverhaltensstudien. Max Planck in Deutschland. „Wirklich komplexe Programme konnten jedoch dank der Entwicklung von Deep Learning erst in jüngster Zeit auftauchen.“

Mithilfe von Deep Learning (GO) begannen die Forscher, neuronale Netze zu trainieren, um die Position von Gelenken und großen Körperteilen von fast allen Tieren - Insekten, Mäusen, Fledermäusen, Fischen - in jedem Frame des Videos zu verfolgen. Es müssen nur einige beschriftete Frames erstellt werden (zehn waren für einige Algorithmen ausreichend). Infolgedessen zeichnet das Programm farbige Punkte auf den Körper des Tieres und bestimmt die Position von Nase, Schwanz, Ohren, Beinen, Füßen, Flügeln, Wirbelsäule usw.

In den letzten Jahren hat die Anzahl der Programme, die dies tun können, dramatisch zugenommen, nicht nur dank des Fortschritts beim maschinellen Lernen, sondern auch dank der parallelen Arbeit, menschliche Bewegungen mit Filmemachern, Animatoren und Experten der Spielebranche abzustimmen.

Neue Methoden können die Haltung verschiedener Tiere während ihrer Interaktion verfolgen. Das Video zeigt, wie der SLEAP-Algorithmus während der Balz (links) und bei zwei Mäusen, die die Umgebung untersuchen, automatisch Körperteile eines Fliegenpaares markiert und verfolgt.Wenn die Bewegung für die Bedürfnisse von Hollywood oder Silicon Valley aufgezeichnet wird, ist es natürlich für Menschen einfach, spezielle Anzüge mit Markierungen zu tragen, denen das System problemlos folgen kann. Diese Daten können verwendet werden, um detaillierte Modelle von Körperhaltungen und Bewegungen zu erstellen. Die Kostümoption ist jedoch nicht für das Studium von Tieren geeignet.

Jonathan Whitlock, ein Neurowissenschaftler an der norwegischen Universität für Wissenschaft und Technologie, suchte vor fünf Jahren aktiv nach einer anderen Möglichkeit, die von ihm untersuchten Mäuse zu verfolgen. Er versuchte alles, woran er denken konnte: Er und seine Kollegen rasierten Mäuse und markierten sie mit Tinte, die Infrarotlicht reflektierte. Sie brachten eine Suspension von Glasperlen auf den Rücken von Tieren auf, die häufig für reflektierende Fahrbahnmarkierungen verwendet wird. Sie malten Tiergelenke mit leuchtender Tinte und Lack. Sie haben viele Dinge ausprobiert, aber es hat nicht so funktioniert, wie sie sollten: Manchmal waren die Markierungen nicht hell genug, um sie aufzuspüren, manchmal störten sie die Mäuse und störten ihr Verhalten.

Infolgedessen klebte Whitlocks Team winzige Reflexstreifen an drei Stellen auf den Rücken des Tieres, um die Bewegungen der Wirbelsäule nachzubilden, und setzte einen winzigen Helm mit vier zusätzlichen Streifen auf, um die Kopfbewegungen zu verfolgen. "Selbst das war genug, um uns eine ganz neue Welt zu eröffnen", sagte Whitlock.

www.youtube.com/watch?v=3RaHuybwtFI&feature=youtu.beDurch die Aktivierung bestimmter Neuronen in der Fliege zwangen die Forscher sie, ein kugelförmiges Karussell rückwärts zu durchlaufen. Die Deep-Learning-Methode maß die Änderung der Winkel in den Gelenken der Beine einer Fliege und zeigte die Bewegung der Beine, des Abdomens und der Antennen in den dreidimensionalen Raum.

Aber viele Forscher wollten alle Arten von Markern loswerden und mehr als sieben Punkte auf dem Körper von Tieren verfolgen. Durch die Kombination der Ideen aus früheren Arbeiten mit Tieren und Menschen haben mehrere Laboratorien benutzerfreundliche Systeme geschaffen, die heute weit verbreitet sind.

Das erste dieser Systeme hat letztes Jahr funktioniert.

DeepLabCut wurde von den Harvard-Neurowissenschaftlern

Mackenzie Matis und

Alexander Matis entwickelt , die dafür ein neuronales Netzwerk entwickelt haben, das darauf trainiert ist, Tausende von Objekten zu klassifizieren. Bald erschienen andere Projekte:

LEAP (Leap Estimates Animal Pose), entwickelt von Pereira und anderen in den Labors von Murty und Shevits; SLEAP, die nächste Version desselben Teams, verfolgt die Position von Körperteilen mehrerer interagierender Tiere.

Kozins DeepPoseKit , das vor einigen Monaten veröffentlicht wurde.

„Sie kann sehr schnell lernen“, beschreibt Morty das LEAP-System. "In 10-15 Minuten kannst du sie trainieren, automatisch mit allen Videos zu arbeiten." Andere Gruppen arbeiten an der Modellierung von Posen im dreidimensionalen statt im zweidimensionalen Raum und kalibrieren dieselben Modelle mit mehreren Kameras.

"Im Inneren können diese Technologien unglaublich komplex sein", sagte Kuzin. "Bisher lassen sie sich überraschend einfach auf eine Vielzahl von Aufgaben anwenden, von der Verfolgung der Bewegungen von Maus-Whiskern bis hin zum Verhalten einer Ameise oder zur Bildung von Fischschwärmen."

Whitlock stellte fest, dass bei den von ihm untersuchten Mäusen bestimmte Bewegungen und Positionen in Teilen des Kortex codiert waren, der an koordinierten Bewegungen - und möglicherweise an anderen Aktivitäten - beteiligt ist. "Diese Bereiche des Gehirns sind sehr aktiv darin, wie das Tier seinen Kopf hält", sagte er. „Diesen Aspekt der Informationsverarbeitung haben wir bisher einfach nicht in die Rinde genommen“, weil die Forscher die Bewegungen frei beweglicher Tiere nicht nachvollziehen konnten.

Der Algorithmus beschreibt schematisch die Haltung des Tieres und hilft, sein Verhalten besser zu verstehen. Tatsächlich sind alle messbaren Aspekte des Verhaltens „Veränderungen der Körperhaltung im Laufe der Zeit“, sagte Whitlock. "Und wir haben gelernt, die Pose zu lesen."

Da das Sammeln von Daten durch die Software zur Verfolgung der Körperhaltung vereinfacht wurde, „können wir jetzt zu anderen Aufgaben wechseln“, sagte

Benjamin de Beavort , ein Verhaltensbiologe an der Harvard University. Zum Beispiel: Wie definiere ich Bausteine für Verhalten und wie interpretiere ich sie?

Versteckte Sprache

Die Beantwortung dieser Fragen hing lange Zeit von der Intuition des Betrachters ab - von "einwandfreier Wahrnehmung", wie

Ethologen (Tierverhaltensexperten) scherzen. Die Intuition unterliegt jedoch Vorurteilen, Reproduzierbarkeitsproblemen und Schwierigkeiten bei der Verallgemeinerung.

Der Zoologe

Ilyan Golani von der Universität Tel Aviv hat in den letzten sechs Jahrzehnten die meiste Zeit nach einer weniger zufälligen Methode gesucht, um Verhalten zu beschreiben und zu analysieren. Dabei würden grundlegende Verhaltenseinheiten wie Atome in der Chemie verwendet. Er wollte das Verhalten nicht als "Balz" oder "Fütterung" bezeichnen. Er wollte, dass diese Charakterisierung auf natürliche Weise aus einem allgemeinen Regelwerk hervorgeht, das von der tierischen Anatomie abgeleitet ist. Golani hat sein eigenes Modell, wie diese Einheiten und Regeln aussehen sollten, aber er glaubt, dass dieser Bereich noch weit davon entfernt ist, einen Konsens darüber zu erzielen.

Andere Forscher sind dagegen zuversichtlich, dass MO und GO diesen Bereich eher zu einem Konsens führen werden. DeepLabCut, LEAP und andere fortschrittliche Haltungsverfolgungsalgorithmen basieren jedoch auf der Lehrerausbildung - sie sind darauf geschult, Körperteile anhand von manuell gekennzeichneten Daten zu erkennen. Die Wissenschaftler hoffen, die Grundbausteine des Verhaltens durch Lernen ohne Lehrer zu finden und zu analysieren. Ein solcher Ansatz wird möglicherweise in der Lage sein, die Struktur des für uns unsichtbaren Verhaltens unabhängig voneinander aufzudecken, so dass die Menschen nicht jeden nächsten Schritt in das System einbringen müssen, was zu Fehlern führt, die aus verborgenen Vorurteilen resultieren.

Ein interessantes Beispiel für diesen Ansatz erschien 2008, als die Forscher vier grundlegende Einheiten der Wurmbewegung identifizierten, die miteinander kombiniert werden können und fast alle Bewegungen erhielten, die diesem Tier zur Verfügung standen. Diese kompakte Darstellung, "Eigenwurm" genannt [von "Eigen", d.h. "Eigene" / ca. transl.] bietet eine quantitative Methode zur Bewertung der Verhaltensdynamik.

Der Motion Sequencing-Algorithmus, der im Labor von Bob Dutta an der Harvard Medical School erstellt wurde, definiert kleine Einheiten oder „Silben“ in der Verhaltensdynamik von Mäusen. Wissenschaftler schlagen vor, dass das Verhalten von Mäusen aus solchen Silben besteht, die nach bestimmten "grammatikalischen" Regeln aufeinander folgen.

Das Video zeigt sechs Beispiele für solche Verhaltenseinheiten ("Bücken und Rucken", "Vorwärtslaufen", "Waschen", "Falten im Gesicht", "Aggression", "Fluchtversuch"). Jeder von ihnen basiert auf der Verfolgung verschiedener Mäuse; Erscheinen von Punkten zeigt dasselbe einfache Verhalten an.

Datta hat diesen Ansatz 2013 mit einem Trick der Xbox Kinect auf ein völlig neues Niveau gebracht und damit recht schnell Erfolge erzielt. Als er und seine Kollegen die gesammelten Daten betrachteten, die die Bewegungen der Mäuse beschreiben, waren sie überrascht, wie schnell sie die Struktur in ihnen erkennen konnten. Die Dynamik des dreidimensionalen Verhaltens von Tieren zerfiel auf natürliche Weise in kleine Segmente, die durchschnittlich etwa 300 ms dauerten. „Und es sind nur Daten. Ich zeige Ihnen die Rohdaten ", sagte Datta. "Dies ist nur eine grundlegende Eigenschaft des Mausverhaltens."

Er entschied, dass diese Segmente sehr ähnlich waren wie Verhaltenseinheiten, die wie Silben aussehen sollten, die aus einer Reihe von Regeln oder Grammatik zusammengesetzt wurden. Er und das Team bildeten ein tiefes neuronales Netzwerk, das diese Silben definiert. Sie suchte nach einer Möglichkeit, die Aktivität des Tieres in Segmente zu unterteilen, um das zukünftige Verhalten am besten vorhersagen zu können. Dieser Algorithmus, Motion Sequencing (MoSeq) genannt, erzeugte "Silben", die die Forscher dann mit Namen wie "vorwärts rennen" oder "sich bücken und ruckeln" oder "Fluchtversuch" benannten. In einem typischen Experiment verwendete die Maus 40-50 solcher Silben, und nur einige von ihnen entsprachen dem, wofür die Leute einen Namen hatten.

"Ihr Algorithmus kann Verhalten isolieren, für das wir nicht einmal einen Namen haben", sagte Whitlock.

Die Forscher versuchen nun, die biologische oder ökologische Bedeutung dieser Verhaltensweisen zu bestimmen, die bisher nicht beobachtet wurden. Sie untersuchen, wie sich diese Verhaltenselemente bei verschiedenen Individuen, Geschlechtern oder Arten unterscheiden, wie sie mit zunehmendem Alter oder infolge von Krankheiten zusammenbrechen, wie sie während des Trainings oder während der Evolution entstehen.

Sie verwenden diese automatische Klassifizierung, um zu untersuchen, wie sich verschiedene Mutationen in Genen und Medikamenten auf das Verhalten auswirken, und um soziale Interaktionen zu beschreiben.Und sie beginnen bereits, erste Verbindungen mit dem Gehirn und seinen inneren Zuständen herzustellen.

Vorhersage von Gehirnerkrankungen und Verhaltensweisen

Dutta und Kollegen stellten fest, dass im Striatum , dem Bereich des Gehirns, der für die Planung der motorischen Fähigkeiten und anderer Funktionen zuständig ist, verschiedene Neuronensätze aktiviert werden, um die verschiedenen „Silben“ des Verhaltens zu aktivieren, die das MoSeq-Programm feststellt. Deshalb "wissen wir, dass diese Grammatik direkt vom Gehirn gesteuert wird", sagte Datta. "Dies ist nicht nur ein Epiphänomen , es ist ein echtes Phänomen, das vom Gehirn gesteuert wird."Interessanterweise war die neuronale Darstellung einer bestimmten Silbe nicht immer dieselbe. Es änderte sich und spiegelte die Reihenfolge wider, in der sich diese Silbe befand. Durch die Untersuchung der Aktivität von Neuronen konnte Dutta feststellen, ob eine bestimmte Silbe Teil einer festen oder variablen Sequenz war. "Auf höchster Ebene", sagte er, "deutet dies darauf hin, dass das Striatum nicht nur das gewünschte Verhalten kodiert." Es bietet auch Informationen zu seinem Kontext. “Er unterstützte diese Hypothese weiter, indem er überprüfte, was passieren würde, wenn das Striatum nicht mehr richtig funktionierte. Die Silben blieben gleich, aber die Grammatik wurde gebrochen, die Reihenfolge der Aktionen wurde zufälliger und weniger anpassungsfähig.Andere Forscher untersuchen, was über einen längeren Zeitraum im Gehirn geschieht. Gordon BermanDer Biophysiker der Emory University verwendet Motion Mapper, eine Analyse ohne Lehrer, um das Verhalten zu modellieren. Dieses Modell, das Verhaltenselemente in einer bestimmten Hierarchie aufweist, kann die hierarchische neuronale Aktivität des Gehirns vorhersagen, wie ein von einem Forscherteam der Universität Wien veröffentlichter Aufsatz gezeigt hat. Berman sagt, dass das „inspirierende Ziel“ dieser Studien darin besteht, eines Tages den Motion Mapper zu verwenden, um die soziale Interaktion von Tieren vorherzusagen.Und da ist Murty mit ihrem Team und ihrer Suche nach verborgenen inneren Zuständen. Sie haben bereits ein Modell erstellt, das mithilfe von Flugbewegungsmessungen vorhersagt, wie und wann eine männliche Fliege zu singen beginnt. Sie stellten fest, dass zum Beispiel mit abnehmender Distanz zwischen Mann und Frau die Wahrscheinlichkeit zunimmt, dass der Mann ein Lied einer bestimmten Art herausbringt.In einem kürzlich in Nature Neuroscience veröffentlichten Artikel haben Wissenschaftler dieses Modell um potenzielle versteckte interne Zustände männlicher Fliegen erweitert, die die Qualität der Vorhersagen darüber verbessern könnten, welche Songs das Männchen herausgeben wird. Das Team entdeckte drei Zustände, die es "Intimität", "Verfolgung" und "Gleichgültigkeit" nannte. Indem sie verschiedene Neuronen aktivierten und die Ergebnisse mit Hilfe eines Modells untersuchten, stellten sie fest, dass der Satz von Neuronen, der, wie zuvor angenommen, die Abgabe von Liedern steuert, tatsächlich den Zustand der Fliege steuert. "Dies ist eine andere Interpretation der Aufgaben der Neuronen, die sie als Teil der Steuerung des Verhaltens der Fliegen ausführen", sagte Murty.Jetzt entwickeln sie ihr Wissen mit SLEAP. "Es wird sehr interessant sein zu sehen, welche versteckten Zustände dieses Modell öffnen kann, wenn wir die Verfolgung von Posen mit höherer Auflösung einbeziehen", sagte Pereira.Die Wissenschaftler nehmen mit Vorsicht zur Kenntnis, dass diese Techniken die traditionelle Verhaltensforschung verbessern und ergänzen und nicht vollständig ersetzen sollten. Sie sind sich auch einig, dass eine Menge Arbeit erledigt werden muss, bevor sie anfangen, die wichtigsten universellen Prinzipien des Verhaltens zu entdecken. Beispielsweise werden zusätzliche maschinelle Lernmodelle benötigt, um Verhaltensdaten mit anderen komplexen Arten von Informationen zu verknüpfen."Dies ist im Wesentlichen der erste Schritt bei der Erforschung dieses Problems", sagte Datta. Er hat keinen Zweifel daran, dass "jemand einen viel besseren Weg finden wird, dies zu tun." Und doch: „Das Plus dieses Ansatzes ist, dass wir uns von der Praxis der Ethologen entfernen, wenn sich die Menschen bis zum Schreien zur Heiserkeit streiten, über deren Beschreibung das Verhalten besser ist. Jetzt haben wir ein Maß. “"Wir kommen an einen Punkt, an dem die Methoden mit unseren Fragen Schritt halten können", sagte Murty. "Wir haben gerade diese Straße freigeschaltet." Und alle Einschränkungen beseitigt. Die Leute können machen, was sie wollen. "