Das Kontrollieren von Gedanken mit etwas anderem als Ihren eigenen Gliedern ist ein faszinierender Bereich. Es ist immer wieder interessant, sich eine Zukunft vorzustellen, in der wir nicht nur mit Fingern, Mund, Augen und Ohren mit dem Internet interagieren können.

Wenn Sie darüber nachdenken, sind der Computer und das Telefon schrecklich ineffiziente Schnittstellen, um die erforderlichen Informationen zu erhalten. Sie wissen genau, was Sie wissen möchten: zum Beispiel den aktuellen Wechselkurs des Rubels gegenüber dem Dollar. Klicken Sie mit den Fingern auf bestimmte Bereiche des Telefonbildschirms, und zielen Sie dabei jedes Mal auf die richtigen Punkte. Anschließend wird die Antwort angezeigt.

Es wäre viel schöner, mental „Hallo Igor!“ Zu sagen, eine Frage mental zu formulieren und eine Antwort mit einem Ohr / Auge / auf eine andere Weise zu erhalten. Oder senden Sie auf dieselbe schnelle Weise eine Nachricht an einen Freund. Verbinden Sie im Allgemeinen das Internet mit dem Gehirn.

Da dies jetzt in der Praxis versucht werden kann, lohnt es sich, etwas zu verwalten, zu prüfen, wie bequem es ist, und Schlussfolgerungen zu ziehen. Ein Video mit den Ergebnissen finden Sie am Ende des Artikels.

1. Idee eingeben2. Was wird benötigt?3. Setzen Sie es zusammen4. Wir versuchen es einmal5. Versuchen Sie es mit zwei6. Drei7. Gedanken zum WochenendeIdee

Der Plan war einfach:

Schritt 1. Nehmen Sie ein

EEG-Gerät , das die Gehirnaktivität misst.

Schritt 2. Wir trainieren einen Algorithmus, mit dem wir mentale Befehle mit ausreichender Genauigkeit bestimmen können. Wir probieren verschiedene Arten von mentalen Befehlen aus (dazu später mehr).

Schritt 3. Stellen Sie eine Verbindung zu beweglichen Objekten her.

Schritt 4. Wir versuchen eine einfache Aufgabe auszuführen, zum Beispiel von Punkt A nach Punkt B.

Schritt 5. Aus all dem ziehen wir Schlussfolgerungen, wenn es Zeit ist. Wenn nicht, wiederholen Sie die Schritte 2 und 4.

Ja, ähnliche Experimente wurden zuvor von einer Reihe von Experten durchgeführt: Es gibt viele Tests des

P300-Ansatzes , die es Ihnen ermöglichen, Gedanken einzutippen (es kommt sehr genau heraus,

aber für eine lange Zeit ), verschiedene Prothesen und andere Geräte zu steuern. Aus wissenschaftlicher Sicht passiert im aktuellen Experiment nichts Neues. Ziel ist es, die Gehirnkontrolle persönlich auszuprobieren und aus den Gefühlen und Gedanken über das BCI (Gehirn-Computer-Interface) einige Schlussfolgerungen zu ziehen.

Was wird benötigt?

Wir nehmen

Emotiv Insight als EEG-Gerät. Weit entfernt vom genauesten Gerät mit einer geringen Auflösung einer eingebauten elektromagnetischen Karte, aber ausreichend für unsere Zwecke. Es kostet

$ 299 , es gibt fast immer Rabatte auf dieses Modell, aber das Problem ist bei der Lieferung nach Russland: es ist nicht. Dies erklärt sich weniger aus logistischen als aus rechtlichen Problemen: EEG-Geräte sind aus Sicht der Zollvorschriften der Russischen Föderation Medizinprodukte (mit entsprechenden Konsequenzen).

Es ist auch nicht möglich, irgendwo auf der Welt abzuholen. Daher müssen nur Länder in der Nähe von Russland bestellt werden, die die Lieferoption haben: Polen, Israel oder ähnliches. Es wird gemunkelt, dass es in Moskau unter dem Boden verkauft wird, aber mit angemessenen Gewinnspannen.

Emotive Geräte sind auch aus der Sicht der Software gut: Sie sind proprietär, können aber eine Menge, und, was für die Zwecke unseres Experiments wichtig ist, verfügen sie über integrierte Tools für die Arbeit mit mentalen Befehlen.

Als Roboter nehmen wir die

Hicat.Livera- Plattform. Auf der Basis von Arduino gebaut. Tatsächlich ist dies nur mit einer Kamera, Rädern, einem Laser und geringfügigen Änderungen an der Software möglich. Es kostet ungefähr

$ 100 - $ 150 , es ist wahrscheinlich bequemer, über AliExpress zu bestellen, aber wir bestellten direkt über die Website, obwohl es keine Lieferprobleme gab.

Füge es zusammen

In einigen Punkten sah der Vorgang zum Anschließen aller Komponenten an einen Prüfstand folgendermaßen aus:

1. Installieren Sie von hier aus die erforderliche Software für Emotiv . Vom ganzen Set brauchen wir einen Connector und

Emotiv BCI .

2. Verbinden Sie Insight mit dem Computer und testen Sie die Verbindung.

3. Installieren Sie Node-RED . Dies ist eine wunderbare Sache, mit der Sie Daten und Signale bequem verarbeiten können. Mit Hilfe einer Vielzahl von Modulen können Sie in wenigen Minuten eine Art Hilfsprogramm zusammenstellen: Sie können eine Benachrichtigung über bevorstehenden Regen in Telegrammen an sich selbst senden, eine Reihe von Rohdaten verarbeiten und all das.

4. Fügen Sie der Node-RED Emotiv Toolbox ein Modul hinzu.

Hier wird

beschrieben, was es ist. Machen Sie ein paar Klicks.

5. Wir sammeln Hicat.Livera. Es geht so: Wenn alles gemäß den Anweisungen gemacht wird, fällt der Akku ständig ab, eine der selbstschneidenden Schrauben blockiert Kameradrehungen und so weiter. Hier braucht man ein wenig Kreativität.

6. Schließen Sie den Roboter an den Computer an. Dazu benötigen Sie keine zusätzliche Software, sie wird über WebSocket gesteuert, es reicht aus, sich im selben WLAN-Netzwerk zu befinden. Das ist zwar auch nicht so einfach: Es stellte sich heraus, dass nicht alle Dateien vom Hersteller auf die Speicherkarte geschrieben wurden, so dass ich sie zerlegen, aus dem

Repository herunterladen und überschreiben musste. Im Allgemeinen die klassische Pracht und Armut von

Kickstarter- Projekten.

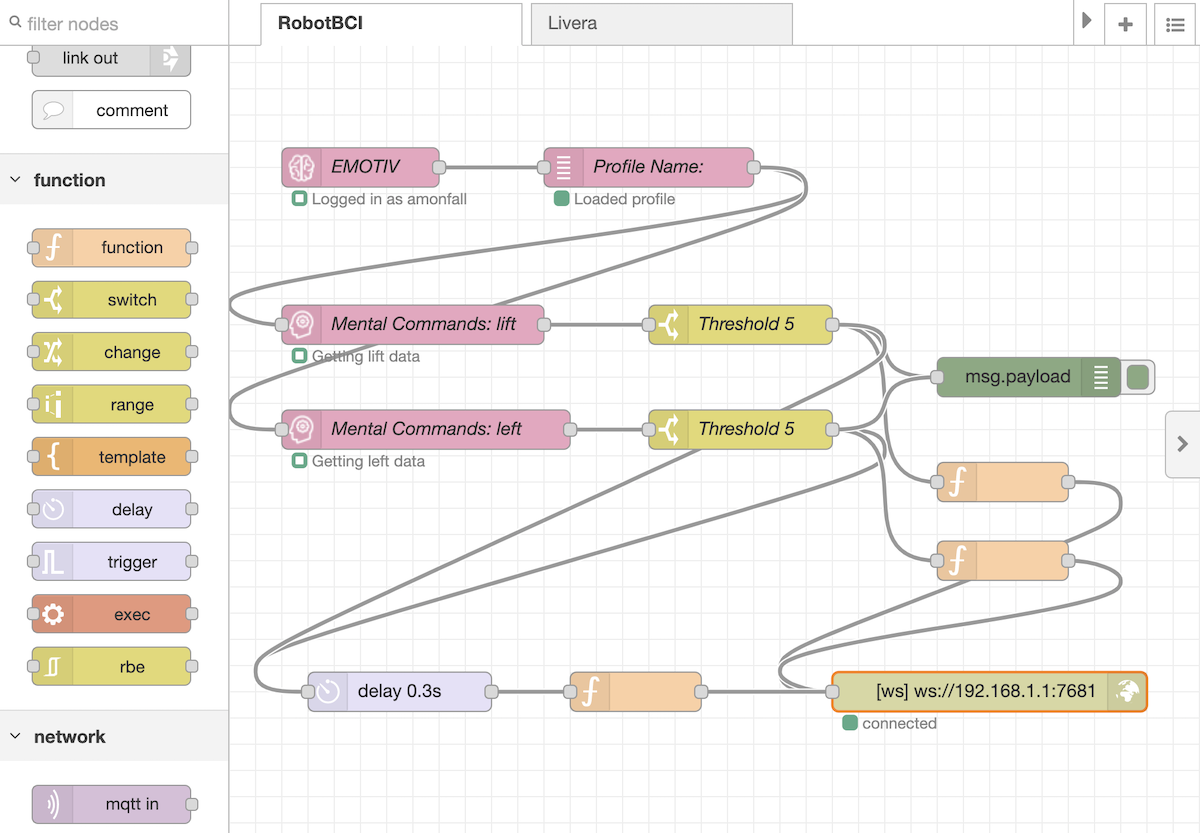

7. Master Flow in Node-RED. Wir nehmen Signale von den in Emotiv BCI geschulten Teams entgegen, beseitigen sie an der Schwelle und senden den empfangenen Leistungswert an den Roboter. Eine Drittelsekunde nach jedem Signal setzen wir die Spannung an den Motoren zurück. Es stellte sich so heraus:

Die Karte selbst für Node-RED kann hier heruntergeladen und in Ihren Flow importiert werden.

Weiter bleibt es nur zu üben und zu versuchen.

Versuchen Sie es einmal

Der Roboter kann vorwärts / rückwärts fahren, jedes Rad separat drehen, die Kamera anheben / absenken und den Laser ein- / ausschalten. Es ist schwierig, für 6-8 Aktionen gleichzeitig zu trainieren, daher umfasste der erste Versuch drei Aktionen: Vorwärts gehen, links und rechts abbiegen.

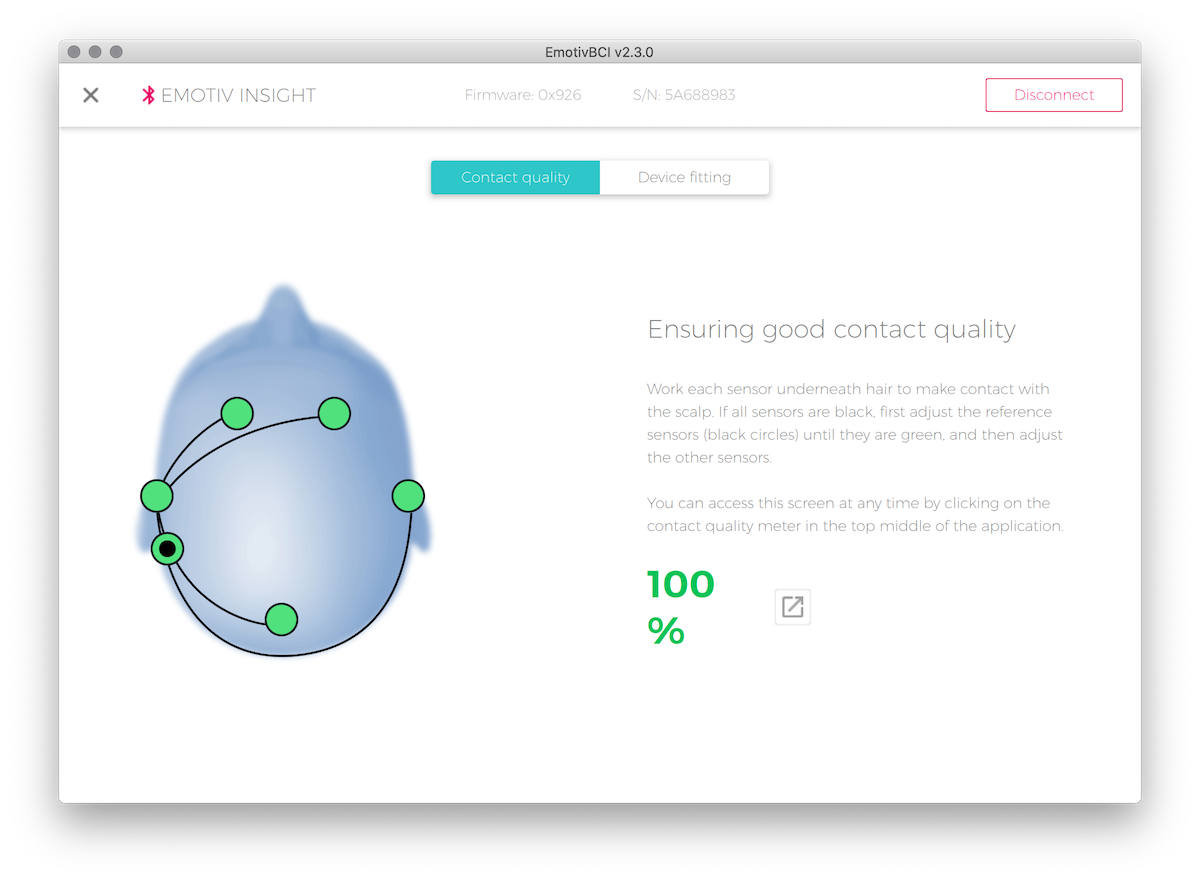

Verbindungsqualität Cerebras können auf einem bequemen Monitor angezeigt werden. Im Falle von Insight ist es wichtig, dass der Haupt-Hinter-dem-Ohr-Sensor sehr dicht an der Kopfhaut anliegt: Wenn Störungen auftreten, werden die anderen sechs Sensoren kein Signal senden.

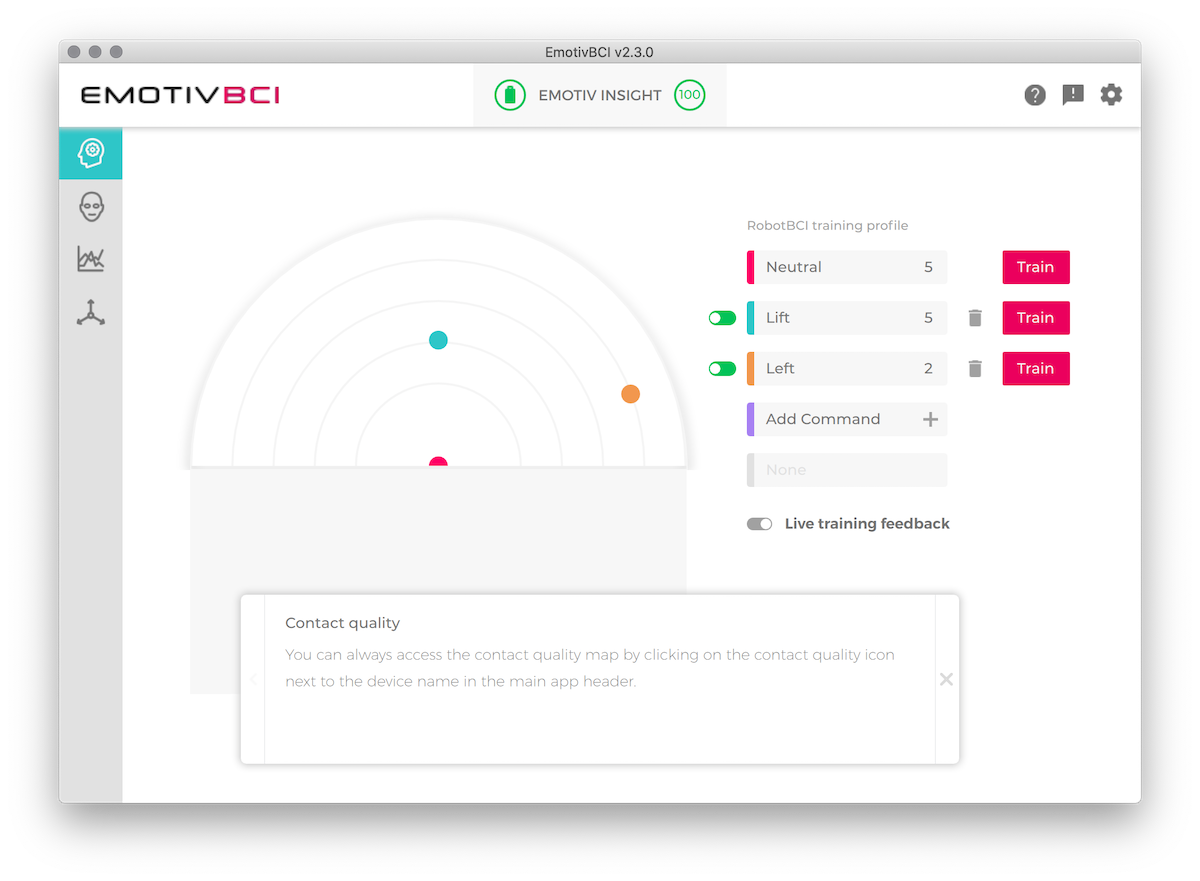

Als nächstes folgt das Training. Erstens ist es am schwierigsten, einen ruhigen und normalen Bewusstseinszustand ohne äußere Reize und Gedanken zu erfassen. Wer die meditativen Praktiken kennt, ist immer noch egal wo, aber einfach so ist es überhaupt nicht einfach, an irgendetwas zu denken. Der Algorithmus nimmt diesen Datensatz als Hintergrund und sucht nach Unterschieden zwischen den Befehlszuständen und den Standardzuständen.

Danach - Training jedes Teams. Die ersten zwei oder drei Einträge werden bedingungslos als Grundlage für das Training angesehen. Als nächstes bestimmt der Algorithmus jedes Mal, wie sehr Ihr Datensatz dem vorherigen ähnlich ist. Wenn der Unterschied zu groß ist, wird empfohlen, diese Sitzung im Training nicht zu berücksichtigen. Bei zu vielseitigen Bewusstseinszuständen ist Training offensichtlich sinnlos.

Jede weitere Trainingseinheit verdeutlicht den Zustand des Modells, des Tracking-Teams. Auf der Karte dieses Modells können Sie sehen, wie sehr sich die Teams voneinander unterscheiden: Wenn die Ähnlichkeiten zu groß sind (die Punkte auf dem Radar sind in der Nähe), wird der Algorithmus kaum verstehen, was Sie im jeweiligen Fall gedacht haben.

Die Hauptfrage während des Trainings ist, was man eigentlich denkt. Mit dem Gehirn können wir zwei Dinge tun: Muskeln kontrollieren und denken. Fakt ist, dass der motorische Kortex, der für Muskelbewegungen verantwortlich ist, aus Sicht des EEG sehr stark stört. Das heißt, wenn Sie als Team versuchen, Ihre Gliedmaßen zu bewegen, sie zu überanstrengen oder sich vorzustellen, dass sie funktionieren, wird dies ein ununterbrochenes, nicht unterscheidbares Geräusch mit einer allgemeinen Genauigkeit wie das Insight-Modell erzeugen.

Es bleibt zu denken. Es gibt eine große Weite: Im Kopf Worte sprechen, über eine Art Gefühl nachdenken, sich irgendwo vorstellen, sich vorstellen, wie sich der Roboter in die richtige Richtung bewegt usw.

Zunächst wurde eine verbale Anweisung gewählt: für jedes Team eine bestimmte Phrase mit einer internen Stimme auszusprechen.

Die Ergebnisse dieses Ansatzes erwiesen sich als unbefriedigend: Ja, die Befehle wurden definitiv mit unterschiedlichen Empfindlichkeitseinstellungen ausgeführt, aber es stellte sich heraus, dass es völlig unmöglich war, sie zu kontrollieren. Es gibt eine klare Unterscheidung zwischen dem Versuch, Befehle auszuführen, und ihrer Abwesenheit: Im ersten Fall macht der Roboter etwas, im zweiten ist praktisch nichts, aber es war nicht möglich, ihn zu zwingen, zumindest in die ungefähre Richtung zu gehen.

Versuchen Sie es mit zwei

Des Weiteren entstand die Idee, folgende Bereiche auszuprobieren:

- Wenn Sie zum Beispiel an einen hellen Moment denken, liegen Sie am Strand und die Sonne wärmt sich warm.

- Hören Sie verschiedene Tonsignale / Musikausschnitte.

- Stellen Sie Kälte / Hitze in bestimmten Teilen bestimmter Gliedmaßen dar.

- Versuchen Sie, gute Laune und schlechte Laune zu imitieren.

- Hören Sie sich die Sprachbefehle verschiedener Personen aus verschiedenen Blickwinkeln an (um die Differenzierung der Signale durch räumliche Wahrnehmung zu erhöhen).

Die Ergebnisse waren interessant: Zum Beispiel führte die Stimme einer Person neben dem Thema des Experiments dazu, dass sich der Roboter in die eine und die andere Person in die andere Richtung bewegte. Es war egal, was diese Leute sagten.

Aber im Allgemeinen stellte sich die Genauigkeit als genauso traurig heraus: Mit einer Qualität auszukommen, die es Ihnen ermöglicht, eine strenge Folge von Befehlen auszuführen, hat nicht funktioniert.

Drei

Um die Kontrollgenauigkeit zu erhöhen, wurde beschlossen, die Anzahl der Teams von drei auf zwei zu reduzieren: vorwärts gehen und in eine Richtung drehen. Dies reicht aus, um sich im Flugzeug zu bewegen, und die Erkennung von nur zwei Teams sollte einfacher sein.

Das Ergebnis ist wie folgt:

Es ist so einfach, von Punkt A nach Punkt B zu gelangen, aber nach einer Reihe von Trainings gibt es ein ungefähres Ergebnis.

Wochenendgedanken

BCI in Form von abstrakten mentalen Befehlen ist aus praktischer Sicht eher eine unmögliche Sache. Ja, Sie können Elektroden in einen bestimmten Teil des Gehirns implantieren, lange trainieren und dadurch lernen, den Cursor oder einen Roboterarm wie Ihren eigenen zu steuern. Dies ist gut zur Lösung von Behinderungsproblemen und anderen Problemen geeignet, aber in jedem Fall ist diese Lösung für eine bestimmte Person individuell, weil Das Gehirn benötigt eine relativ lange Zeit, um neue neuronale Verbindungen aufzubauen.

Als Masseninterface: Ich habe es gekauft, am Kopf gezogen und benutze es - es funktioniert nicht. Einige von uns haben es sofort geschafft, die Befehle klar umzusetzen, andere haben es auch nach langen Schulungen nicht geschafft, überhaupt etwas zu tun. Der Prozess ist zu individuell und zu kompliziert, um in der Gebrauchsanweisung erklärt zu werden. Darüber hinaus ist es schwierig, am nächsten Tag nach erfolgreichem Management dasselbe zu wiederholen: Der Bewusstseinszustand ist bereits etwas anders.

Meiner Meinung nach ist es viel effektiver, Geräte zu verwenden, die die innere Stimme durch Änderungen der Potentiale der Muskeln von Unterkiefer und Nacken für die „mentale“ Kontrolle lesen. Wenn wir mit uns selbst sprechen, werden den Muskeln des Stimmapparates Nervensignale gegeben,

sie bewegen sich sehr leicht . Wenn sie von empfindlichen Sensoren überwacht werden, können Sie den Text fast ohne Training mit Ihrer inneren Stimme diktieren.

Es gibt viele ähnliche Geräte, eines der letzten ist das

AlterEgo- Projekt von MIT-Forschern. Während in der Entwicklung, aber in den Video-Demonstrationen, kann man sehen, dass es immer noch relativ gut funktioniert.

Im Wesentlichen ist es jedoch die gleiche Sprachsteuerung, aber lautlos. Das Problem bei allen Sprachschnittstellen ist das mangelnde Verständnis der Befehlspalette. Wenn wir uns eine Website oder Anwendung ansehen, sehen wir Schaltflächen, Signaturen und wissen, wo wir stöbern müssen. Im Falle eines Sprachassistenten ist es nicht wichtig zu verstehen, was genau gefragt werden kann. Mögliche Befehle müssen auswendig gelernt werden oder jedes Mal, wenn lange Listen möglicher Themen für den Dialog angehört werden. All dies, zusammen mit der nicht idealen Spracherkennung, führt dazu, dass wir nur noch den Standardsatz von Sprachassistentenbefehlen verwenden: Rufen Sie Sophocles an, stellen Sie einen Timer für fünfhundert Jahre ein und erinnern Sie daran, zur Arbeit vorbeizuschauen.

Im Moment haben wir also Folgendes: a) Wenn Sie etwas so verwalten, dass es cool aussieht, aber gleichzeitig funktioniert, dann liest es nur die interne Stimme (es wird auch hier ein Experiment erforderlich sein) und b) den Wettbewerb um die grafische Oberfläche nicht einmal in der Nähe.

In Bezug auf den zweiten Punkt gibt es Technologien auf dem Gebiet der

transkraniellen Magnetstimulation . Kurz gesagt: Wenn Sie so etwas wie eine Mikrowelle auf den visuellen Kortex fokussieren, sehen wir Phosphene - leuchtende Punkte und Effekte, die das Auge nicht sieht. Solche Geräte können ziemlich genaue Zeichen zeichnen, beispielsweise Buchstaben im Leerzeichen. Diese Eingriffe verursachen in der Regel starke Kopfschmerzen und Übelkeit und werden für Experimente nicht sehr empfohlen. Theoretisch ist es jedoch möglich, eine Grenzfläche gegenüber einem Iron Man ohne Linsen und Brille zu zeichnen. Sie können zwar Linsen und Brillen verwenden, aber mehr dazu, vielleicht ein anderes Mal.

Auf dem Cover ist ein Foto von Road to VR zu sehen, das einen Artikel über die BCI-Experimente von Valve enthält.