Die Firma SPC "Geostra", die den

MCS- Dienst nutzte, führte eine kamerale Verarbeitung von seismischen Informationen durch - eine 40-TB-High-Density-Untersuchung MOGT-3D. Die Umsetzung, Nuancen und Ergebnisse des Projekts werden in diesem Artikel diskutiert.

Die industrielle Ölförderung in der Wolga begann in den 1930er Jahren. Da die geologischen und geophysikalischen Kenntnisse der Region zunahmen, war es mit den Standardmethoden der Feld- und Kameralseismik nicht mehr möglich, neue Ölvorkommen in den erforderlichen Mengen zu finden. Ölfirmen standen daher vor der Frage einer genaueren Untersuchung des geologischen Umfelds.

Für Studien mit dem erforderlichen Detaillierungsgrad müssen Benutzer von Untergründen sowohl Feld- als auch Offsite-Erdbebenerhebungen mit ausgeklügelten Techniken durchführen. Gleichzeitig nimmt die Menge der erhaltenen Daten erheblich zu, und für deren Verarbeitung und Interpretation sind erhebliche Verarbeitungsressourcen erforderlich.

Geophysikalische Dienstleistungsunternehmen wiederum suchen ständig nach Wegen, um Ressourcen zu optimieren und die Rechenleistung zu steigern. Eines der vielversprechenden Gebiete ist heute die Cloud-Technologie.

Projektparameter und Format

Die im Rahmen des Pilotprojekts untersuchte Fläche des Standorts betrug 47 km

2 . Als Methode für Feldbeobachtungen wurde eine Technologie ausgewählt, die die Registrierung von hochdichten seismischen Beobachtungen MOGT-3D in kurzer Zeit ermöglicht. Hierzu wurden die methodischen und technologischen Grundlagen sowohl der Abteilung für Explorationsgeophysik der Bashneftegeofizika JSC, deren Spezialisten für die Umsetzung der Feldphase des Projekts verantwortlich waren, als auch der Firma LLC SPC Geostra, deren Expertengruppen Schreibtischarbeit leisteten, verbessert.

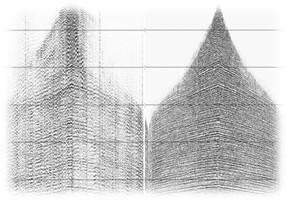

Stufen der seismischen Datenverarbeitung.

Stufen der seismischen Datenverarbeitung.Dieser Artikel konzentriert sich auf den Kameralteil des Projekts. Nämlich auf die Besonderheiten der Implementierung des technischen Teils der seismischen Datenverarbeitungseinheit, die neben Standardwerken auch eine spezielle Technologie beinhaltete - die Voll-Azimut-Migration.

Das Quelldatenvolumen für die zyklische Ausführung von Berechnungen betrug 40 Tb. Angesichts der räumlichen Dichte von seismischen Vermessungen entspricht dieses Datenvolumen bei Umstellung auf ein Standard-Feldbeobachtungssystem für die Arbeitsregion einer Vermessung von etwa 2500 km

2 (mit Standard-Versorgungsgebieten von 200-400 km

2 ). Das Rechenzentrum der SPC "Geostra" ist darauf ausgelegt, Probleme mit ähnlichen Volumina zu lösen. Die Reservierung des Clustersystems zur Lösung des Problems des High-Density-Shootings war jedoch für den Projektzeitraum nicht geplant. Berechnungen zufolge mussten mindestens 2.000 zusätzliche physische Kerne verwendet werden, von denen jeder 16 GB RAM benötigte.

Mit Cloud-Diensten können Sie die Menge der verwendeten Computerressourcen in Abhängigkeit von der jeweiligen Aufgabe schnell ändern. Dementsprechend können Sie die Datenverarbeitung beschleunigen, indem Sie die Ressourcenmenge schnell erhöhen und gleichzeitig die Kosten optimieren, indem Sie bei der Lösung von Problemen, bei denen nicht die volle Kapazität erreicht werden muss, einige Server aufgeben.

Es ist zu beachten, dass bei der Durchführung des Projekts bestimmte Einschränkungen auferlegt wurden, die dazu beigetragen haben, ein Porträt des Unternehmens zu zeichnen, das Dienstleistungen im Cloud-Service erbringt:

- Die Server befinden sich auf dem Territorium der Russischen Föderation . Arbeiten Sie mit strategisch wichtigen Informationen - geophysikalischen Daten, deren Weitergabe ins Ausland gesetzlich verboten ist.

- Exklusiver Zugriff auf Ressourcen . Workloads sollten die höchste Priorität erhalten und den Cloud-Ressourcenpool nicht mit den Clients anderer Anbieter gemeinsam nutzen.

- Software- und Hardwarekompatibilität . Geophysikalische Software sollte in einer Virtualisierungsumgebung stabil funktionieren. Diesbezüglich bestanden Zweifel, da die Software ursprünglich für den Stack bestimmter Prozessoren geschrieben wurde. Informationen darüber, wie er sich im Emulator verhält, sind äußerst gering.

Allein die erste Anforderung, die Datenspeicherung in der Russischen Föderation, hat die Suche nach einem geeigneten Dienstleister stark eingeschränkt. Als Ergebnis der Auswahl der Kandidaten wurde MCS als einer der führenden Anbieter von Cloud-Diensten in Russland Partner von SPC „Geostra“ bei der Umsetzung eines Testprojekts. MCS stellte umgehend die erforderliche Stromversorgung, die Testumgebung und den exklusiven Zugriff auf Computerressourcen bereit. Die Einhaltung der Kompatibilitätsanforderungen - wie sich spezialisierte Software in einer Virtualisierungsumgebung verhält, konnte nur in der Praxis überprüft werden.

Portierung von geophysikalischer Software auf die Cloud-Plattform

Fachleute der SPC "Geostra" haben zuvor festgestellt, dass für die termingerechte Durchführung des Testprojekts 2000 Kerne benötigt werden. In der Praxis hat sich herausgestellt, dass aufgrund der Eigenschaften der Software kein linearer Zusammenhang zwischen der Verarbeitungsgeschwindigkeit und der Gesamtleistung besteht. Wenn ein Server das Problem in einer Stunde löst, reichen zehn Server möglicherweise nicht für die zehnfache Beschleunigung aus. In Zusammenarbeit mit Spezialisten von MCS wurde eine Infrastruktur von 2072 Kernen erstellt. Für komplexe Berechnungen wurde GPU-basiertes Cloud-Computing mit NVIDIA Tesla V100-GPUs verwendet. Es wurde auch das MCS-Speichersystem verwendet, das von fünfzig Terabyte-SSD-Laufwerken bedient wurde. Außerdem wurde eine virtuelle Netzwerkinfrastruktur mit einer Bandbreite von mindestens 1 Gbit / s zwischen zwei beliebigen Servern bereitgestellt.

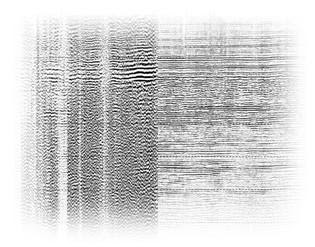

Deep-Speed-Modell der Umwelt.Bei der Migration von geophysikalischer Software in die Cloud gab es keine großen Probleme. Beim Testen trat jedoch ein Engpass auf - die Leistung des Festplattensubsystems. Spezialisten von MCS und SPC "Geostra" gelang es, die Zugriffsgeschwindigkeit auf Daten auf Cloud-Laufwerken fast zu verdoppeln. Geophysikalische Software arbeitete auch mit einer seltenen Version des Betriebssystems, die keine 100% ige Nutzung des virtuellen Netzwerks ermöglichte. Die gemeinsame Arbeit der Spezialisten beider Unternehmen bei der Feinabstimmung des Betriebssystems hat zur Lösung dieses Problems geführt.

So arbeitete spezialisierte Software, die ursprünglich für physische Geräte entwickelt wurde, an virtuellen Kapazitäten. Der Erfolg des 1,5 Monate dauernden Pilotprojekts war auch darauf zurückzuführen, dass Problemsituationen in der Testphase gelöst wurden.

Zusammenfassung

Das Pilotprojekt war erfolgreich. Die Cloud-Computing-Leistung handhabte die Verarbeitung von seismischen Daten mit hoher Dichte. Das Unternehmen SPC "Geostra" verfügt über umfangreiche Erfahrungen in der Arbeit mit geophysikalischer Software für Cloud-Ressourcen, die es ermöglichen wird, diese in zukünftigen Großprojekten einzusetzen.

Über die Perspektiven von Cloud-Diensten bei der Erdölexploration

Ölfirmen haben es fast geschafft, mit moderner Technologie neue Felder zu erschließen. Es wurde deutlich, dass im Zeitalter von Big Data die Anforderungen an die Rechenleistung sowohl der Ölfirmen selbst als auch der Ölfelddienstleistungsunternehmen erheblich gestiegen sind.

Die Ölindustrie stand somit vor der Wahl, ihre Rechenleistung weiter zu steigern (kontinuierlich an Modernisierung, Entwicklung und Wartung zu arbeiten) oder Rechenleistung nach Bedarf in Form eines Dienstes, beispielsweise in Form von Cloud-Diensten, zu leasen. Die Produktionserfahrung dieses Projekts hat gezeigt, dass die Clouds die hohen Anforderungen an Spezialsoftware erfolgreich umsetzen können.