Intel IoT Roadshow o realidad virtual en el mundo real

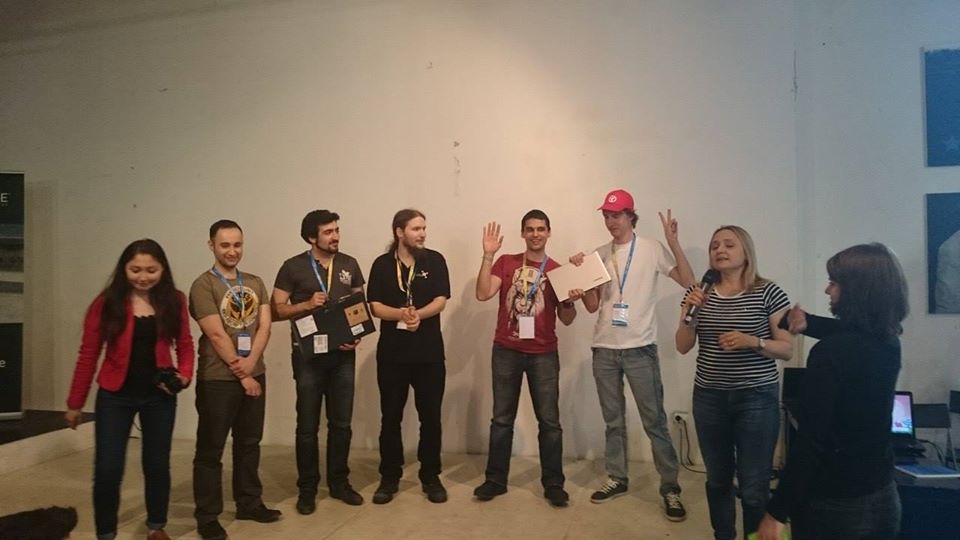

Del 27 al 28 de junio de 2015, Intel organizó un hackathon , donde el proyecto SenseDrive obtuvo el segundo lugar. Durante la presentación, nuestro equipo miró un poco hacia el futuro y demostró cómo expandir las capacidades humanas sumergiéndose en un espacio virtual conectado a Internet de las cosas.

Un poco de historia

Todo comenzó con la conferencia DevCon 2015 , donde conocí por primera vez las capacidades de la tecnología RealSense , y en el hackathon nocturno tuve la suerte de evaluar las capacidades de la cámara y RealSense SDK. Mi primer deseo fue conectar la cámara a las gafas de realidad virtual para ver mis manos "virtuales". Sin embargo, no pude encontrar programadores y diseñadores 3D gratuitos de Unity en ese hackathon. Por lo tanto, después de unirnos con un chico de Vietnam, logramos estudiar el SDK y las características de trabajar con la cámara lo suficientemente bien como para demostrar un programa simple que ayuda a los programadores a cargar los ojos y se asegura de que el programador no "engañe" al respecto. También aprendí que en una semana en San Petersburgo habrá otro hackathon usando esta tecnología.Entonces, ahora ya tenía una semana para prepararme. Me interesó mi idea el colega Dmitry Postilgu, quien bosquejó una interfaz tridimensional de manos libres para Windows Phone en Unity. Y en este momento estaba desarrollando la capacidad de transferir datos sobre la posición de las manos en un teléfono inteligente.Esta tarea no fue trivial, ya que RealSense requiere un procesador muy potente y USB 3.0, que por razones obvias estaban ausentes en nuestro teléfono inteligente. Tuve que escribir un complemento para Unity, que despliega un servidor en el teléfono y una aplicación cliente para PC que transfiere paquetes de datos procesados al teléfono, lo que nos permitió "conectar" varias cámaras a futuras gafas virtuales a la vez para determinar con mayor precisión la posición de las manos.El resultado fue una arquitectura bastante flexible en la que no hubo una diferencia notable para Unity: si los datos de la cámara van directamente (para el caso cuando la aplicación se implementa en una PC) o por WiFi (para el caso cuando la aplicación se implementa en un teléfono inteligente). Mirando hacia el futuro, fue esta arquitectura la que nos salvó durante la presentación en el último hackathon.La semana resultó ser muy poco tiempo para tener tiempo para crear un prototipo de manos virtuales, ya que estábamos involucrados en el proyecto en nuestro tiempo libre desde el trabajo principal. Escribieron el proyecto incluso de noche, mientras viajaban en tren desde Minsk a San Petersburgo. Como resultado, tomamos el primer lugar .

También en el segundo hackathon, descubrí el próximo Intel IoT Roadshow en un mes y conocí a Maxim Massalsky de Robot Kitchen- Laboratorio de robótica de Minsk. Con él, decidimos finalmente unir el mundo virtual y el real.Para demostrar estas capacidades, Maxim ensambló un robot con una cámara en movimiento, que conectamos a la placa Intel Edison en el hackoton. Maxim lanzó WiFi y transmitió una transmisión de video desde la cámara del robot a la red. Desarrollamos un sistema de comandos de control y resultó ser un robot en el que puedes "moverte" desde la realidad virtual.El robot transmite lo que ve a través de la cámara de video: la transmisión desde la cámara lanzada en Intel Edison directamente a gafas virtuales, y la realidad virtual transfiere la posición de la cabeza y el comando desde las "palancas de control" virtuales al robot. Logramos crear un "efecto de presencia" en las gafas del usuario en la cabina de control del avatar del robot. Al mismo tiempo, el usuario no solo podía usar sus manos (sin un mouse, teclado o ningún cable) para indicar dónde debía ir el robot, sino también girar la cabeza hacia los lados, mientras el robot realizaba obedientemente lo mismo al girar su cámara.Un avatar robot es, por supuesto, genial, pero no está del todo claro de qué sirve. Por lo tanto, un robot no fue suficiente para nosotros. Incluso antes del hackathon, tuvimos una pequeña sesión de lluvia de ideas para pensar cómo transmitir mejor y más claramente la utilidad de la tecnología al jurado. No hubo necesidad de buscar ejemplos durante mucho tiempo, hubo muchos de ellos (algunos de ellos se pueden encontrar en la descripción del proyecto), pero no se puede hacer mucho en 24 horas, por lo que se decidió elegir dos tipos:

También en el segundo hackathon, descubrí el próximo Intel IoT Roadshow en un mes y conocí a Maxim Massalsky de Robot Kitchen- Laboratorio de robótica de Minsk. Con él, decidimos finalmente unir el mundo virtual y el real.Para demostrar estas capacidades, Maxim ensambló un robot con una cámara en movimiento, que conectamos a la placa Intel Edison en el hackoton. Maxim lanzó WiFi y transmitió una transmisión de video desde la cámara del robot a la red. Desarrollamos un sistema de comandos de control y resultó ser un robot en el que puedes "moverte" desde la realidad virtual.El robot transmite lo que ve a través de la cámara de video: la transmisión desde la cámara lanzada en Intel Edison directamente a gafas virtuales, y la realidad virtual transfiere la posición de la cabeza y el comando desde las "palancas de control" virtuales al robot. Logramos crear un "efecto de presencia" en las gafas del usuario en la cabina de control del avatar del robot. Al mismo tiempo, el usuario no solo podía usar sus manos (sin un mouse, teclado o ningún cable) para indicar dónde debía ir el robot, sino también girar la cabeza hacia los lados, mientras el robot realizaba obedientemente lo mismo al girar su cámara.Un avatar robot es, por supuesto, genial, pero no está del todo claro de qué sirve. Por lo tanto, un robot no fue suficiente para nosotros. Incluso antes del hackathon, tuvimos una pequeña sesión de lluvia de ideas para pensar cómo transmitir mejor y más claramente la utilidad de la tecnología al jurado. No hubo necesidad de buscar ejemplos durante mucho tiempo, hubo muchos de ellos (algunos de ellos se pueden encontrar en la descripción del proyecto), pero no se puede hacer mucho en 24 horas, por lo que se decidió elegir dos tipos:- Apagar un aparato eléctrico (después de todo, nadie quiere que su casa se queme porque la plancha o la estufa se detuvieron rápidamente cuando se encendió);

- . , , , :) , , … , - .

El ahorrativo Maxim trajo consigo varios servos y relés, el resto se decidió mirar en el acto.Como un electrodoméstico que puede quemar un apartamento, utilizamos un hervidor eléctrico. Con esto nos ayudó Evgeny Tkachevsky, un tipo de Video Wings que estaba interesado en nuestro proyecto y trajo un hervidor de casa la mañana del segundo día.El alimentador de gatos fue diseñado en papel en un tren camino a San Petersburgo, un modelo de computadora fue dibujado e impreso en una impresora 3D tan pronto como llegó. Pero con la búsqueda del gato, todo fue más complicado. No había gatos cerca del lugar, por lo que tomamos prestado un osito de peluche de uno de los expertos de Intel. Debo decir que el proyecto despertó gran interés incluso en la etapa de prueba. Aún así, no todos los días se ve a un programador con los ojos cerrados en una caja blanca, agitando las manos frente a una computadora portátil y de pie junto a un robot en un soporte, girando las ruedas de un lado a otro y agitando la cabeza ... Algunos espectadores incluso tuvieron la suerte de probarse a sí mismos como conductores de robots.

Debo decir que el proyecto despertó gran interés incluso en la etapa de prueba. Aún así, no todos los días se ve a un programador con los ojos cerrados en una caja blanca, agitando las manos frente a una computadora portátil y de pie junto a un robot en un soporte, girando las ruedas de un lado a otro y agitando la cabeza ... Algunos espectadores incluso tuvieron la suerte de probarse a sí mismos como conductores de robots.

Presentación

Desafortunadamente, en el momento de la presentación, Internet se apagó por completo, ya no era posible hablar sobre ninguna transferencia de datos sobre la posición de las manos, y aún más sobre la transmisión de video en streaming desde la cámara del robot. En los últimos segundos antes del lanzamiento, se decidió descargar el flujo de datos tanto como sea posible, dejando solo los comandos de control del robot y desatando por completo las gafas virtuales. Tuvimos que demostrar la versión para PC del proyecto, en la que era imposible volver la cabeza y ver a través de los ojos de un robot. Solo podíamos controlar el robot, la tetera y el alimentador con la ayuda de manos virtuales, observando por encima del hombro los movimientos del robot, el hervidor se apagaba y la comida se estaba derramando. Y finalmente, para aquellos que lo deseen, ofrecimos medir anteojos y sentirnos, al menos por un momento, en el mundo virtual.

¿Por qué la realidad virtual?

Desafortunadamente, debido a dificultades técnicas, no pudimos transmitir la idea principal del proyecto: ¿en qué se diferencia el control del mundo virtual de simplemente hacer clic en los botones de la pantalla con el mouse ? Y todo es realmente simple, es más conveniente que alguien haga clic con el mouse, alguien que toque con el dedo en la pantalla, alguien que escriba en la consola, la realidad virtual hace posible interactuar con el mundo real mediante acciones y gestos familiares para el cuerpo humano, lo que le permite realizar varias acciones a la vez familiares para una persona. Por ejemplo, en la implementación actual, puede hacer que el robot vaya recto con una mano, girarlo ligeramente hacia la derecha con la otra, y girar la cabeza y ver qué sucede a la izquierda. Seguramente, muchos automovilistas tuvieron que sostener el volante con una mano, hablar por teléfono con la otra y periódicamente mirar hacia un lado para ver si había algún peatón en la curva. Es lo mismo aqui. Bueno, como un bono en el mundo virtual, una persona puede tener "más allá de la capacidad" como superhéroes. Por ejemplo, para cambiar de un robot a un hervidor o un alimentador, hice pases con las manos, lo que condujo al movimiento de objetos tridimensionales en este mundo, como el Jedi ... Hubo una idea de liberar la bola de fuego de mi mano y así apagar el robot, pero decidí que era demasiado.¿No es esto libertad? Libertad de movimiento, libertad de pensamiento, libertad de acción, libertad de fantasía ...Pero eso no es todo. No siempre es conveniente que una persona controle algún objeto complejo solo. La implementación actual del proyecto permite a varias personas administrar simultáneamente varias partes del mismo dispositivo. No tienes que ir muy lejos por ejemplos. Dos usuarios pueden conectarse al tanque del robot, uno controlará el movimiento del tanque en la superficie y el segundo en este momento rotará la torreta del tanque y tendrá acceso para controlar el hocico. ¡Imagínense cómo sería un juego de batalla de tanques con su implementación?Desde el punto de vista de la producción, ahora no hay necesidad de gastar mucho dinero en la fabricación de teclados, ratones, joysticks o cualquier otro manipulador adecuado. Simplemente dibuje un panel de control y cárguelo en el mundo virtual. Y cómo se verá depende solo de la imaginación y las necesidades específicas.

Por ejemplo, en la implementación actual, puede hacer que el robot vaya recto con una mano, girarlo ligeramente hacia la derecha con la otra, y girar la cabeza y ver qué sucede a la izquierda. Seguramente, muchos automovilistas tuvieron que sostener el volante con una mano, hablar por teléfono con la otra y periódicamente mirar hacia un lado para ver si había algún peatón en la curva. Es lo mismo aqui. Bueno, como un bono en el mundo virtual, una persona puede tener "más allá de la capacidad" como superhéroes. Por ejemplo, para cambiar de un robot a un hervidor o un alimentador, hice pases con las manos, lo que condujo al movimiento de objetos tridimensionales en este mundo, como el Jedi ... Hubo una idea de liberar la bola de fuego de mi mano y así apagar el robot, pero decidí que era demasiado.¿No es esto libertad? Libertad de movimiento, libertad de pensamiento, libertad de acción, libertad de fantasía ...Pero eso no es todo. No siempre es conveniente que una persona controle algún objeto complejo solo. La implementación actual del proyecto permite a varias personas administrar simultáneamente varias partes del mismo dispositivo. No tienes que ir muy lejos por ejemplos. Dos usuarios pueden conectarse al tanque del robot, uno controlará el movimiento del tanque en la superficie y el segundo en este momento rotará la torreta del tanque y tendrá acceso para controlar el hocico. ¡Imagínense cómo sería un juego de batalla de tanques con su implementación?Desde el punto de vista de la producción, ahora no hay necesidad de gastar mucho dinero en la fabricación de teclados, ratones, joysticks o cualquier otro manipulador adecuado. Simplemente dibuje un panel de control y cárguelo en el mundo virtual. Y cómo se verá depende solo de la imaginación y las necesidades específicas.¿Que sigue?

En el hackathon, nuestro objetivo era demostrar las posibilidades que ofrece la simbiosis de Internet de las cosas, los robots y la realidad virtual. Ahora estamos en la etapa de orientación del proyecto y mientras se vislumbran las siguientes áreas:- Desarrollo de un robot controlado simultáneamente por varias personas, prototipo de un robot tanque;

- Agregar soporte para plataformas Android e IOS en el proyecto actual;

- Desarrollo de un avatar robot completo, capaz de tomar artículos y transmitir una imagen estéreo desde dos ojos;

- Desarrollando un protocolo completo y SDK para conectarse a Internet de las cosas y la realidad virtual. Esto permitirá a cualquiera que quiera conectar fácilmente sus dispositivos electrónicos a la realidad virtual y, como resultado, ampliará la gama de gafas;

- Desarrollo de tus propias gafas virtuales;

- Agregar una interfaz neuronal, que permitirá a las personas no solo controlar las cosas con la ayuda de los movimientos del cuerpo, sino también con el poder del pensamiento. En el último hackathon hubo varios proyectos utilizando una interfaz similar y quizás podamos combinar nuestros esfuerzos en beneficio de la humanidad.

Source: https://habr.com/ru/post/es382109/

All Articles