¿Máxima computación antes del pico del petróleo?

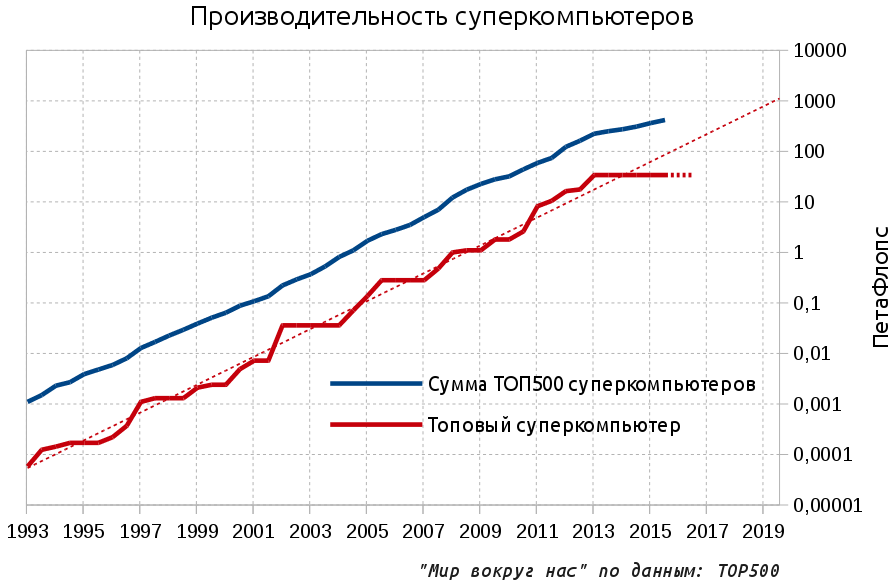

Hoy probaremos el género de Cassandra popular en la blogósfera: profecías negativas. Por lo tanto, es "bien sabido" que el invierno está cerca, la humanidad ha alcanzado los límites de crecimiento en todo, y vivimos los últimos días tranquilos antes de que el inevitable avance hacia nuevos siglos oscuros. La última fuente de optimismo tecnológico y el símbolo más sorprendente del progreso, que se ha opuesto en los últimos 20 años a muchos procesos estancados en el planeta, ha sido el rápido desarrollo de la microelectrónica. Ha llegado el momento de arrancar las cubiertas de esta área.Parece que el progreso ahora es más rápido que nunca y cualquier usuario de un teléfono inteligente le informará sobre procesadores cada vez más rápidos que aparecen en los nuevos modelos. Pero en el extremo norte, ya se estaba enfriando contra la pared que nos protegía del recurso. Donde realmente se necesita el máximo rendimiento de la microelectrónica, en el área de las supercomputadoras en las fronteras más avanzadas, el progreso se ha detenido.Como puede ver en el gráfico, durante tres años el rendimiento de la supercomputadora superior (expresado en operaciones de punto flotante por segundo - FLOPS) no ha estado creciendo. Además, si observa los planes anunciados, puede decir con confianza que la situación no cambiará al menos en el próximo año. Por lo tanto, el estancamiento del rendimiento de la supercomputadora superior se extenderá hasta 2016: Las líneas punteadas indican la tendencia de desarrollo exponencial y el pronóstico para la supercomputadora de gama alta para 2016 (estancamiento). Brevemente sobre el material: en el artículo, se usan los prefijos Pet y Axe. PetaFlops - 10 ^ 15 operaciones por segundo, y el futuro necesario y discutido mil veces - ExaFlops, 10 ^ 18.Para continuar con la tendencia exponencial, las supercomputadoras deberían alcanzar la escala ExFlops en 2019, y ahora Aurora planea solo alrededor de 100 PetFlops para 2018. Pero, ¿cuál es exactamente el problema?En mi experiencia, incluso muchos desarrolladores profesionales de software y hardware no podrán decirte cuál es la importancia de las supercomputadoras. En el mundo moderno, en el siglo de Internet generalizado, grandes salas llenas de estanterías de hierro y dedicadas al procesamiento de una compleja tarea computacional parecen ser el destino del pasado romántico del comienzo de la era de las computadoras de los años sesenta y setenta. De hecho, hoy los recursos de incluso una computadora personal son suficientes para resolver muchos problemas complejos, y los servidores disponibles comercialmente le permiten satisfacer las necesidades de las grandes empresas. Pero también hay servicios populares de computación en la nube que le prometen recursos informáticos infinitos para una recompensa modesta.Pero, de hecho, las supercomputadoras son lo único que le da a la humanidad 7000 millones de la actualidad la oportunidad de continuar desarrollándose y viviendo sin temor a la maldición maltusiana.Todas las tareas avanzadas se pueden resolver solo con la ayuda de una potencia informática muy grande y una supercomputadora donde todos los componentes de la tecnología informática se optimizan tanto como sea posible, esta es la herramienta más adecuada para resolver estos problemas. Además, la simulación directa por computadora puede interpretarse como el tercer método científico de cognición además de la investigación teórica y experimental. Para no ser infundado, damos algunos ejemplos.Sobre el aceite madre, que durante mucho tiempo fue casi imposible de encontrar sin computadoras potentes, ya escribimosy la conclusión fue categórica: en la mañana una supercomputadora en el aceite de la tarde, en la noche una supercomputadora en el aceite de la mañana. Veamos otros temas.AviaciónEn el diseño de nuevos aviones, la simulación por computadora ha reducido el número de pruebas físicas en un túnel de viento de 77 unidades en 1979 a 11 en 1995 y desde entonces el valor se ha mantenido en el mismo nivel. Algo debido a esto, nuestros aviones permanecieron casi igual donde estaban. La transición a una simulación física fundamentalmente más precisa basada en la aplicación directa de las ecuaciones de Navier-Stokes requiere capacidades computacionales del orden de 50 exaflops, es decir, 1000 veces más que el líder actual: el Tianhe-2 chino de 33 PetaFlops. Al mismo tiempo, el cálculo de la aerodinámica externa sigue siendo relativamente simple, pero, por ejemplo, un motor típico consta de miles de partes móviles y el modelado de flujos internos requerirá una potencia informática aún mayor.

Las líneas punteadas indican la tendencia de desarrollo exponencial y el pronóstico para la supercomputadora de gama alta para 2016 (estancamiento). Brevemente sobre el material: en el artículo, se usan los prefijos Pet y Axe. PetaFlops - 10 ^ 15 operaciones por segundo, y el futuro necesario y discutido mil veces - ExaFlops, 10 ^ 18.Para continuar con la tendencia exponencial, las supercomputadoras deberían alcanzar la escala ExFlops en 2019, y ahora Aurora planea solo alrededor de 100 PetFlops para 2018. Pero, ¿cuál es exactamente el problema?En mi experiencia, incluso muchos desarrolladores profesionales de software y hardware no podrán decirte cuál es la importancia de las supercomputadoras. En el mundo moderno, en el siglo de Internet generalizado, grandes salas llenas de estanterías de hierro y dedicadas al procesamiento de una compleja tarea computacional parecen ser el destino del pasado romántico del comienzo de la era de las computadoras de los años sesenta y setenta. De hecho, hoy los recursos de incluso una computadora personal son suficientes para resolver muchos problemas complejos, y los servidores disponibles comercialmente le permiten satisfacer las necesidades de las grandes empresas. Pero también hay servicios populares de computación en la nube que le prometen recursos informáticos infinitos para una recompensa modesta.Pero, de hecho, las supercomputadoras son lo único que le da a la humanidad 7000 millones de la actualidad la oportunidad de continuar desarrollándose y viviendo sin temor a la maldición maltusiana.Todas las tareas avanzadas se pueden resolver solo con la ayuda de una potencia informática muy grande y una supercomputadora donde todos los componentes de la tecnología informática se optimizan tanto como sea posible, esta es la herramienta más adecuada para resolver estos problemas. Además, la simulación directa por computadora puede interpretarse como el tercer método científico de cognición además de la investigación teórica y experimental. Para no ser infundado, damos algunos ejemplos.Sobre el aceite madre, que durante mucho tiempo fue casi imposible de encontrar sin computadoras potentes, ya escribimosy la conclusión fue categórica: en la mañana una supercomputadora en el aceite de la tarde, en la noche una supercomputadora en el aceite de la mañana. Veamos otros temas.AviaciónEn el diseño de nuevos aviones, la simulación por computadora ha reducido el número de pruebas físicas en un túnel de viento de 77 unidades en 1979 a 11 en 1995 y desde entonces el valor se ha mantenido en el mismo nivel. Algo debido a esto, nuestros aviones permanecieron casi igual donde estaban. La transición a una simulación física fundamentalmente más precisa basada en la aplicación directa de las ecuaciones de Navier-Stokes requiere capacidades computacionales del orden de 50 exaflops, es decir, 1000 veces más que el líder actual: el Tianhe-2 chino de 33 PetaFlops. Al mismo tiempo, el cálculo de la aerodinámica externa sigue siendo relativamente simple, pero, por ejemplo, un motor típico consta de miles de partes móviles y el modelado de flujos internos requerirá una potencia informática aún mayor. Hidrodinámica computacional aplicada a los álabes de la turbina (izquierda) y al avión X-43 con un número Mach = 7Energía termonuclearEn el campo de la física termonuclear, que es interesantemente escrito por un colega de energía., el diseño de la próxima generación de tokamaks es imposible sin el progreso en el modelado de plasma a alta temperatura en una trampa magnética. Ya están participando en los modelos varios miles de millones de partículas en el espacio con una resolución de 131 millones de puntos. Para tales escalas, se utilizan los sistemas de pedidos de Petaflops más potentes y se obtienen buenos resultados, pero está claro que la precisión suficiente de la simulación completa sobre los principios básicos deberá ampliarse a unos modestos 13 millones de veces.

Hidrodinámica computacional aplicada a los álabes de la turbina (izquierda) y al avión X-43 con un número Mach = 7Energía termonuclearEn el campo de la física termonuclear, que es interesantemente escrito por un colega de energía., el diseño de la próxima generación de tokamaks es imposible sin el progreso en el modelado de plasma a alta temperatura en una trampa magnética. Ya están participando en los modelos varios miles de millones de partículas en el espacio con una resolución de 131 millones de puntos. Para tales escalas, se utilizan los sistemas de pedidos de Petaflops más potentes y se obtienen buenos resultados, pero está claro que la precisión suficiente de la simulación completa sobre los principios básicos deberá ampliarse a unos modestos 13 millones de veces. Modelado del comportamiento del plasma en un tokamakClima y climaEl modelado del clima y los pronósticos meteorológicos precisos nos permiten planificar de manera óptima nuestras acciones: la precisión de los pronósticos aumenta con el crecimiento del rendimiento de la supercomputadora. En el futuro, será posible predecir las lluvias y, en consecuencia, las inundaciones y los flujos de lodo. Sequía y pérdida de cultivos.

Modelado del comportamiento del plasma en un tokamakClima y climaEl modelado del clima y los pronósticos meteorológicos precisos nos permiten planificar de manera óptima nuestras acciones: la precisión de los pronósticos aumenta con el crecimiento del rendimiento de la supercomputadora. En el futuro, será posible predecir las lluvias y, en consecuencia, las inundaciones y los flujos de lodo. Sequía y pérdida de cultivos. Hoy, un pronóstico del tiempo de 4 días es tan preciso como un pronóstico del tiempo de un día en 1980Las predicciones cada vez más precisas requieren un modelo de escala planetaria más detallado, y es necesaria una disminución constante en la celda de simulación. Actualmente, las celdas modelo para pronósticos regionales a corto plazo tienen dimensiones de 10x10 km, y los modelos climáticos a largo plazo usan una cuadrícula con celdas de cientos de km, mientras que se requiere una escala de 1x1 km en la superficie (10,000 veces más grande que ahora) y 100 metros verticalmente. Sí, con una periodización de 1 segundo, que durante dos meses significa 5 millones de segundos.Un ejemplo de un modelo moderno con una celda de 300x300 km.

Hoy, un pronóstico del tiempo de 4 días es tan preciso como un pronóstico del tiempo de un día en 1980Las predicciones cada vez más precisas requieren un modelo de escala planetaria más detallado, y es necesaria una disminución constante en la celda de simulación. Actualmente, las celdas modelo para pronósticos regionales a corto plazo tienen dimensiones de 10x10 km, y los modelos climáticos a largo plazo usan una cuadrícula con celdas de cientos de km, mientras que se requiere una escala de 1x1 km en la superficie (10,000 veces más grande que ahora) y 100 metros verticalmente. Sí, con una periodización de 1 segundo, que durante dos meses significa 5 millones de segundos.Un ejemplo de un modelo moderno con una celda de 300x300 km. Medicina y biología.La medicina no es la excepción. Hoy en día, las supercomputadoras de gama alta pueden simular solo partes individuales de células ultrapequeñas:

Medicina y biología.La medicina no es la excepción. Hoy en día, las supercomputadoras de gama alta pueden simular solo partes individuales de células ultrapequeñas: En la figura, el resultado de modelar el funcionamiento de los canales iónicos en la membrana celular en las supercomputadoras de extremo superior, y solo participan unas 100 mil moléculas. Además, el número total de moléculas en una célula humana es de miles de millones, y las células mismas son casi cuatro mil millones (10 ^ 14). El proceso de obtener nuevos medicamentos y llevarlos al mercado lleva de 5 a 15 años y ahora se habla de nuevos conceptos en el diseño de arrastre. Solo imagine cuánto puede acelerar el proceso y aumentar la efectividad de los medicamentos si modela la situación de manera integral, comenzando por el ADN del patógeno, que, de hecho, contiene toda la información al respecto y terminando con el modelo del cuerpo humano, teniendo en cuenta las características genéticas individuales.La lista real es mucho, mucho más grande: la búsqueda de materiales fundamentalmente nuevos con las propiedades deseadas, astrofísica, energía nuclear y mucho más. Contabilidad deexpositoresLa pregunta que surge es: si los beneficios son tan grandes, ¿por qué no invertimos mucho dinero en supercomputadoras poderosas? El hecho es que hasta ahora ha habido un exponente de nuestro lado, a saber, el exponente de Moore: la densidad de los transistores se duplica cada 18-24 meses, y hasta hace muy poco, esto significaba que la productividad también se duplicaba.Por lo tanto, los estudiantes de los jugadores estaban atormentados por la pregunta constante: "¿Necesito comprar una computadora hoy por $ 2000 dólares o tomar algo más simple por $ 1000?" De hecho, por los $ 1000 restantes en 3-4 años, será posible comprar una computadora un par de veces más potente. Esto no es sorprendente, porque una función lineal siempre pierde exponencialmente y la multiplicación de costos produce, en el mejor de los casos, la misma multiplicación lineal de rendimiento en lugar de una dependencia de la ley de potencia en el caso de un exponente. Como regla general, el presupuesto de los estudiantes no era elástico y la elección recayó en la segunda opción, pero a veces querían involucrarse, tomaron la opción de propagación y, después de un par de años, miraron mal a esta vieja basura.Un proceso similar, pero en un entorno mucho más serio, tuvo lugar durante las discusiones de las nuevas supercomputadoras. En la mayoría de los casos, se eligió un camino más moderado pero productivo. Es significativo que en los últimos 20 años, solo tres computadoras hayan costado más de $ 300 millones y las tres se construyeron fuera de los Estados Unidos: dos en Japón y un líder actual en China, en países con un reclamo de liderazgo mundial. De hecho, además de los beneficios reales, tener su propia supercomputadora en la primera línea de la clasificación se ha convertido en un orgullo nacional para demostrar la existencia de la ciencia avanzada nacional.El final del expositorDe año en año, se escuchan exclamaciones de que la ley de Moore está cerca del final y, hasta ahora, parece que son todas historias de terror. Pero si lo desea, ya puede discernir los jinetes individuales del apocalipsis:

En la figura, el resultado de modelar el funcionamiento de los canales iónicos en la membrana celular en las supercomputadoras de extremo superior, y solo participan unas 100 mil moléculas. Además, el número total de moléculas en una célula humana es de miles de millones, y las células mismas son casi cuatro mil millones (10 ^ 14). El proceso de obtener nuevos medicamentos y llevarlos al mercado lleva de 5 a 15 años y ahora se habla de nuevos conceptos en el diseño de arrastre. Solo imagine cuánto puede acelerar el proceso y aumentar la efectividad de los medicamentos si modela la situación de manera integral, comenzando por el ADN del patógeno, que, de hecho, contiene toda la información al respecto y terminando con el modelo del cuerpo humano, teniendo en cuenta las características genéticas individuales.La lista real es mucho, mucho más grande: la búsqueda de materiales fundamentalmente nuevos con las propiedades deseadas, astrofísica, energía nuclear y mucho más. Contabilidad deexpositoresLa pregunta que surge es: si los beneficios son tan grandes, ¿por qué no invertimos mucho dinero en supercomputadoras poderosas? El hecho es que hasta ahora ha habido un exponente de nuestro lado, a saber, el exponente de Moore: la densidad de los transistores se duplica cada 18-24 meses, y hasta hace muy poco, esto significaba que la productividad también se duplicaba.Por lo tanto, los estudiantes de los jugadores estaban atormentados por la pregunta constante: "¿Necesito comprar una computadora hoy por $ 2000 dólares o tomar algo más simple por $ 1000?" De hecho, por los $ 1000 restantes en 3-4 años, será posible comprar una computadora un par de veces más potente. Esto no es sorprendente, porque una función lineal siempre pierde exponencialmente y la multiplicación de costos produce, en el mejor de los casos, la misma multiplicación lineal de rendimiento en lugar de una dependencia de la ley de potencia en el caso de un exponente. Como regla general, el presupuesto de los estudiantes no era elástico y la elección recayó en la segunda opción, pero a veces querían involucrarse, tomaron la opción de propagación y, después de un par de años, miraron mal a esta vieja basura.Un proceso similar, pero en un entorno mucho más serio, tuvo lugar durante las discusiones de las nuevas supercomputadoras. En la mayoría de los casos, se eligió un camino más moderado pero productivo. Es significativo que en los últimos 20 años, solo tres computadoras hayan costado más de $ 300 millones y las tres se construyeron fuera de los Estados Unidos: dos en Japón y un líder actual en China, en países con un reclamo de liderazgo mundial. De hecho, además de los beneficios reales, tener su propia supercomputadora en la primera línea de la clasificación se ha convertido en un orgullo nacional para demostrar la existencia de la ciencia avanzada nacional.El final del expositorDe año en año, se escuchan exclamaciones de que la ley de Moore está cerca del final y, hasta ahora, parece que son todas historias de terror. Pero si lo desea, ya puede discernir los jinetes individuales del apocalipsis: Arriba hay cinco tendencias para varias especificaciones de microprocesador. La ley de Moore parece continuar: el naranja indica el número de transistores por unidad de área con una duplicación cada 18-24 meses. Desde 2005, el parámetro ha crecido 100 veces, pero no hay tanta alegría: el rendimiento de un núcleo está marcado en azul y el crecimiento durante el mismo período ya es inferior a 10 veces. El resto de los transistores fueron a aumentar el número de núcleos que permiten procesar tareas en paralelo (negro).En 2005, fue posible comprar un procesador con una velocidad de reloj de 3.8 GHz, pero ahora el procesador Intel con una frecuencia de reloj superior a 4 GHz no se compra. Esto se refiere directamente al gráfico: la frecuencia del procesador, que anteriormente era responsable de la mitad del crecimiento de la productividad, no ha cambiado mucho desde 2004 (verde), así como el consumo de energía (rojo), que se basaba en la posibilidad de disipación de calor.Estas tendencias son absolutamente simétricas en la arquitectura de las supercomputadoras. Si tomamos el campeón chino de hoy, entonces vemos uno de los indicadores de consumo de energía más altos (18 MW), una gran cantidad de núcleos informáticos e incluso una regresión al precio de PetaFlops. Todo esto permitió construir una supercomputadora solo dos veces más productiva que el competidor anterior.¡Rechace al exponente burgués por el bien de la línea comunista!

Arriba hay cinco tendencias para varias especificaciones de microprocesador. La ley de Moore parece continuar: el naranja indica el número de transistores por unidad de área con una duplicación cada 18-24 meses. Desde 2005, el parámetro ha crecido 100 veces, pero no hay tanta alegría: el rendimiento de un núcleo está marcado en azul y el crecimiento durante el mismo período ya es inferior a 10 veces. El resto de los transistores fueron a aumentar el número de núcleos que permiten procesar tareas en paralelo (negro).En 2005, fue posible comprar un procesador con una velocidad de reloj de 3.8 GHz, pero ahora el procesador Intel con una frecuencia de reloj superior a 4 GHz no se compra. Esto se refiere directamente al gráfico: la frecuencia del procesador, que anteriormente era responsable de la mitad del crecimiento de la productividad, no ha cambiado mucho desde 2004 (verde), así como el consumo de energía (rojo), que se basaba en la posibilidad de disipación de calor.Estas tendencias son absolutamente simétricas en la arquitectura de las supercomputadoras. Si tomamos el campeón chino de hoy, entonces vemos uno de los indicadores de consumo de energía más altos (18 MW), una gran cantidad de núcleos informáticos e incluso una regresión al precio de PetaFlops. Todo esto permitió construir una supercomputadora solo dos veces más productiva que el competidor anterior.¡Rechace al exponente burgués por el bien de la línea comunista! Las tropas cibernéticas chinas eliminan los marcadores de los procesadores Intel Xeon.Si las computadoras son tan importantes, ¿por qué no simplemente continuar el camino chino y hacer que la supercomputadora sea más grande y luego aún más grande? Debe comprender que cualquier aumento en la productividad debido a un aumento lineal en la escala no es solo un aumento en el precio del dólar, sino también el mismo aumento lineal en el consumo de energía. Si toma un monstruo chino con tres millones de núcleos e intenta escalarlo desde el nivel 33 de PetaFlops hasta el nivel 30 ExaFlops, deberá reservar para uso exclusivo dos docenas de reactores nucleares nuevos, y esto corresponde a todos los reactores que ahora se están construyendo en China. Si aún es posible apretar de alguna manera el cinturón para tirar, entonces el nivel de 30 ZettaFlops con sus 20,000 reactores está cerrado para siempre.Hay una salida¿Es posible continuar con el expositor? Para los próximos años, sí, aún es posible. En 2-3 años, las supercomputadoras serán tres veces más potentes que las chinas de gama alta y con los mejores parámetros de consumo de energía y costo de PetAflops. ¿Y qué pasará después?Personalmente, no estoy seguro, pero los expertos no son muy optimistas. Por ejemplo, un director de Microsoft visitó un foro oficial a fines de octubre sobre el desarrollo del futuro sistema ExFlops en los Estados Unidos. Al foro asistieron todos los principales fabricantes de hierro, así como representantes de varias agencias estatales que desarrollan y usan supercomputadoras.Para citar :es obvio para todos los participantes del foro:

Las tropas cibernéticas chinas eliminan los marcadores de los procesadores Intel Xeon.Si las computadoras son tan importantes, ¿por qué no simplemente continuar el camino chino y hacer que la supercomputadora sea más grande y luego aún más grande? Debe comprender que cualquier aumento en la productividad debido a un aumento lineal en la escala no es solo un aumento en el precio del dólar, sino también el mismo aumento lineal en el consumo de energía. Si toma un monstruo chino con tres millones de núcleos e intenta escalarlo desde el nivel 33 de PetaFlops hasta el nivel 30 ExaFlops, deberá reservar para uso exclusivo dos docenas de reactores nucleares nuevos, y esto corresponde a todos los reactores que ahora se están construyendo en China. Si aún es posible apretar de alguna manera el cinturón para tirar, entonces el nivel de 30 ZettaFlops con sus 20,000 reactores está cerrado para siempre.Hay una salida¿Es posible continuar con el expositor? Para los próximos años, sí, aún es posible. En 2-3 años, las supercomputadoras serán tres veces más potentes que las chinas de gama alta y con los mejores parámetros de consumo de energía y costo de PetAflops. ¿Y qué pasará después?Personalmente, no estoy seguro, pero los expertos no son muy optimistas. Por ejemplo, un director de Microsoft visitó un foro oficial a fines de octubre sobre el desarrollo del futuro sistema ExFlops en los Estados Unidos. Al foro asistieron todos los principales fabricantes de hierro, así como representantes de varias agencias estatales que desarrollan y usan supercomputadoras.Para citar :es obvio para todos los participantes del foro:

la microelectrónica moderna basada en la tecnología CMOS está llegando al final de sus capacidades.

No existe una tecnología alternativa que estará disponible en los próximos diez años.En pocas palabras, en los próximos 10 años el paradigma existente terminará, y no tenemos otro paradigma para usted . Source: https://habr.com/ru/post/es387109/

All Articles