Un recorrido por el centro de datos sueco de Facebook cerca del Círculo Polar Ártico

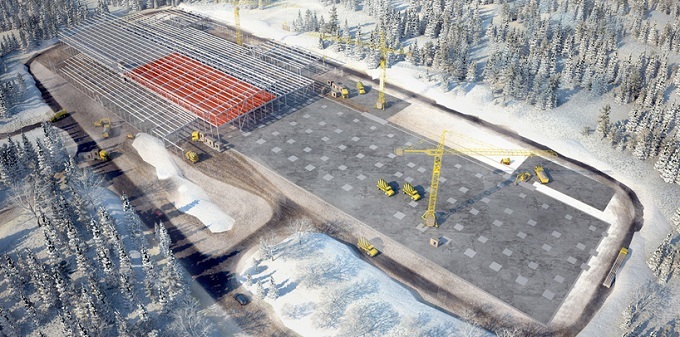

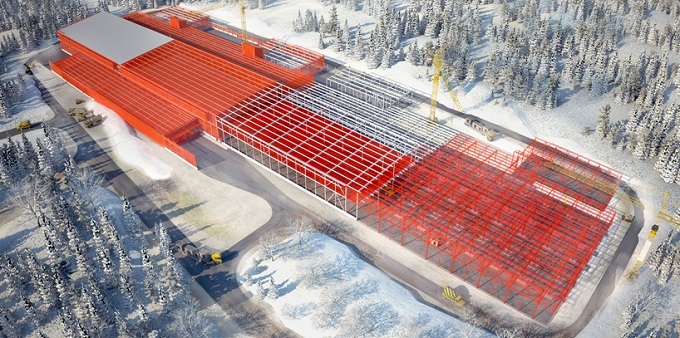

Un poco al sur del Círculo Polar Ártico, en medio de un bosque en las afueras de la ciudad sueca de Luleå, hay una granja de servidores, un centro de datos hipermount de Facebook. La fachada del gigantesco edificio está enmarcada por miles de paneles metálicos rectangulares, mientras que en sí misma parece una nave espacial real. La granja de servidores de la compañía en Lulea es enorme. Tiene 300 metros de ancho y 100 metros de largo, lo que corresponde aproximadamente al tamaño de cuatro campos de fútbol. Curiosamente, el proyecto del centro de datos de Facebook en Suecia en un momento resultó estar muy cerca del fracaso.Un ecólogo local dijo que el nuevo centro de datos podría dañar a las aves, incluido el raro pájaro carpintero sueco de tres dedos que anida cerca del campus. Pero funcionarios del municipio de Lulea rechazaron la objeción. El proyecto de Facebook parecía demasiado atractivo, involucrando la inversión de cientos de millones de dólares en construcción y la creación de muchos empleos.

Curiosamente, el proyecto del centro de datos de Facebook en Suecia en un momento resultó estar muy cerca del fracaso.Un ecólogo local dijo que el nuevo centro de datos podría dañar a las aves, incluido el raro pájaro carpintero sueco de tres dedos que anida cerca del campus. Pero funcionarios del municipio de Lulea rechazaron la objeción. El proyecto de Facebook parecía demasiado atractivo, involucrando la inversión de cientos de millones de dólares en construcción y la creación de muchos empleos. La granja de servidores de Facebook es una de las instalaciones informáticas con mayor eficiencia energética en la historia humana. Hace aproximadamente un siglo, Suecia comenzó la construcción de numerosas centrales hidroeléctricas para organizar el suministro de energía de su industria del acero, la pulpa y el papel. Tales centrales hidroeléctricas aparecieron en Lulea. Ahora se utilizan para alimentar el centro de datos de Facebook, que, por cierto, consume aproximadamente la misma cantidad de electricidad que una fábrica de acero. Según los ingenieros de Facebook, el objetivo de la compañía es proporcionar el 50% de la energía a sus centros de datos a través de fuentes de energía renovables y respetuosas con el medio ambiente para 2018. Y el campus sueco ha llevado significativamente a Facebook a ese nivel. El campus también alberga tres potentes generadores diesel de forma cuadrada,que será necesario en caso de interrupciones poco probables en la operación de la red eléctrica central."Tantas plantas hidroeléctricas están conectadas a la red regional que simplemente no se necesitan generadores", dijo Jay Park, director de desarrollo de infraestructura de Facebook. Según Park, al conectar las subestaciones al nuevo centro de datos, los ingenieros de Facebook utilizaron el esquema de redundancia 2N, es decir, la electricidad proviene de redes independientes que utilizan varias rutas. En el primer caso, se utilizan cables subterráneos, mientras que en el segundo - líneas eléctricas aéreas.

La granja de servidores de Facebook es una de las instalaciones informáticas con mayor eficiencia energética en la historia humana. Hace aproximadamente un siglo, Suecia comenzó la construcción de numerosas centrales hidroeléctricas para organizar el suministro de energía de su industria del acero, la pulpa y el papel. Tales centrales hidroeléctricas aparecieron en Lulea. Ahora se utilizan para alimentar el centro de datos de Facebook, que, por cierto, consume aproximadamente la misma cantidad de electricidad que una fábrica de acero. Según los ingenieros de Facebook, el objetivo de la compañía es proporcionar el 50% de la energía a sus centros de datos a través de fuentes de energía renovables y respetuosas con el medio ambiente para 2018. Y el campus sueco ha llevado significativamente a Facebook a ese nivel. El campus también alberga tres potentes generadores diesel de forma cuadrada,que será necesario en caso de interrupciones poco probables en la operación de la red eléctrica central."Tantas plantas hidroeléctricas están conectadas a la red regional que simplemente no se necesitan generadores", dijo Jay Park, director de desarrollo de infraestructura de Facebook. Según Park, al conectar las subestaciones al nuevo centro de datos, los ingenieros de Facebook utilizaron el esquema de redundancia 2N, es decir, la electricidad proviene de redes independientes que utilizan varias rutas. En el primer caso, se utilizan cables subterráneos, mientras que en el segundo - líneas eléctricas aéreas.

La granja de servidores ayuda a Facebook a procesar alrededor de 350 millones de fotos, 4.5 mil millones de me gusta y 10 mil millones de mensajes por día. La compañía comenzó la construcción del centro de datos sueco para mejorar la calidad del servicio para los usuarios europeos que generan cada vez más datos electrónicos. Al mismo tiempo, existe una alta probabilidad de que si sube una selfie en Londres o publica una actualización de estado en París, sus datos se almacenarán en Lulea. En un centro de datos típico, uno y medio a dos vatios de equipos electromecánicos y sistemas de enfriamiento caen en cada vatio de carga de TI, el centro de datos de Luleå funciona muchas veces de manera más eficiente: su coeficiente PUE es 1.04.

La granja de servidores ayuda a Facebook a procesar alrededor de 350 millones de fotos, 4.5 mil millones de me gusta y 10 mil millones de mensajes por día. La compañía comenzó la construcción del centro de datos sueco para mejorar la calidad del servicio para los usuarios europeos que generan cada vez más datos electrónicos. Al mismo tiempo, existe una alta probabilidad de que si sube una selfie en Londres o publica una actualización de estado en París, sus datos se almacenarán en Lulea. En un centro de datos típico, uno y medio a dos vatios de equipos electromecánicos y sistemas de enfriamiento caen en cada vatio de carga de TI, el centro de datos de Luleå funciona muchas veces de manera más eficiente: su coeficiente PUE es 1.04.Concepto de chasis

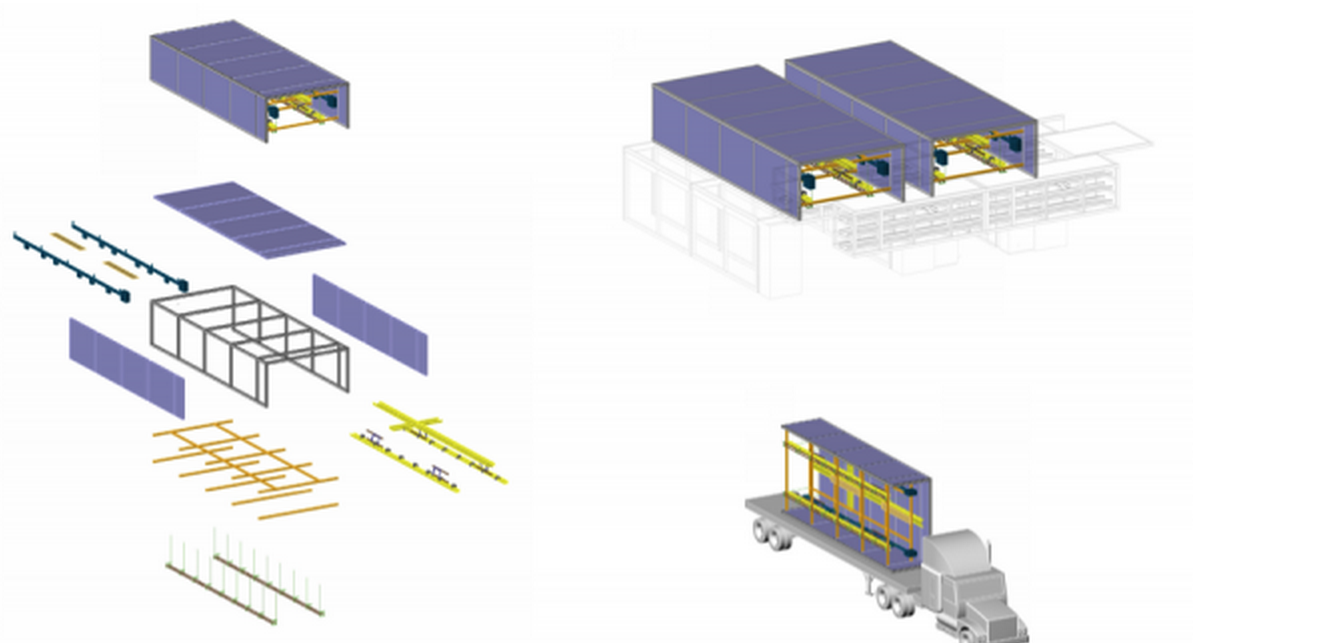

Facebook construyó una granja de servidores, repitiendo el concepto de "chasis". Utilizando consejos de diversas industrias donde la automatización y la estandarización de la producción son ampliamente utilizadas, logramos formar una visión de la idea e implementar el "chasis" - la base (en este caso, un marco de acero con un tamaño aproximado de 3.6 m por 12.2 m) y usar la línea de ensamblaje para aquellos entregados en el lugar de implementación artículos de trabajo Marco Magarelli, ingeniero de diseño para la construcción del centro de datos de Facebook:

Marco Magarelli, ingeniero de diseño para la construcción del centro de datos de Facebook:, : , , - . «» , . «», . , .

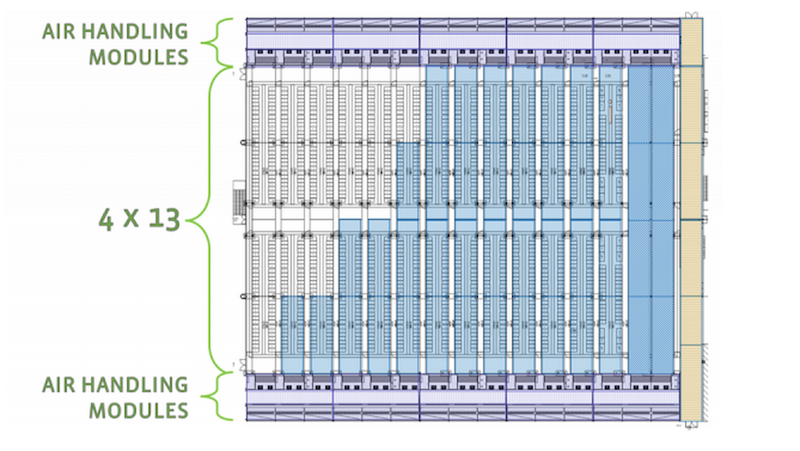

Después del ensamblaje, el chasis se carga en el cuerpo y se transporta directamente a la granja de servidores. En el mismo edificio, el conjunto entregado se monta en postes de hormigón preparados. Dos chasis conectados forman un pasaje de 18 metros. La sala de máquinas habitual del centro de datos acomodará 52 chasis, formando así 13 corredores, incluidos los destinados a refrigerar los conjuntos de servidores.

Dos chasis conectados forman un pasaje de 18 metros. La sala de máquinas habitual del centro de datos acomodará 52 chasis, formando así 13 corredores, incluidos los destinados a refrigerar los conjuntos de servidores. Alta eficiencia y respeto al medio ambiente del centro de datos debido a su ubicación. Los operadores suecos tienen a su disposición electricidad barata generada por centrales hidroeléctricas confiables, así como un clima frío, que los especialistas de TI pueden envolver a su favor. Esto se debe, entre otras cosas, a las bajas temperaturas en la región (en invierno, el termómetro mantiene un promedio de alrededor de -20 C). En lugar de gastar dinero en enormes aires acondicionados que consumen energía para enfriar decenas de miles de servidores en Lulea, los ingenieros de Facebook usan el aire exterior para ejecutarlo en las horas posteriores al centro de datos después de que el aire se haya filtrado y optimizado para la temperatura y la humedad, lo que enfría los sistemas del servidor. El nuevo centro de datos funciona como un gran mecanismo.Dentro hay pasillos largos, numerosos servidores con luces intermitentes y el zumbido de los fanáticos gigantes.

Alta eficiencia y respeto al medio ambiente del centro de datos debido a su ubicación. Los operadores suecos tienen a su disposición electricidad barata generada por centrales hidroeléctricas confiables, así como un clima frío, que los especialistas de TI pueden envolver a su favor. Esto se debe, entre otras cosas, a las bajas temperaturas en la región (en invierno, el termómetro mantiene un promedio de alrededor de -20 C). En lugar de gastar dinero en enormes aires acondicionados que consumen energía para enfriar decenas de miles de servidores en Lulea, los ingenieros de Facebook usan el aire exterior para ejecutarlo en las horas posteriores al centro de datos después de que el aire se haya filtrado y optimizado para la temperatura y la humedad, lo que enfría los sistemas del servidor. El nuevo centro de datos funciona como un gran mecanismo.Dentro hay pasillos largos, numerosos servidores con luces intermitentes y el zumbido de los fanáticos gigantes.

Una buena ubicación geográfica permitirá que ocho meses del año enfríen este centro de datos del norte únicamente debido al aire exterior, lo que hace que sea más barato mantenerlo en un promedio del 40% en comparación con un centro de datos similar en los Estados Unidos. Un factor importante para las inversiones de Facebook fue el hecho de que para la construcción de su centro de datos, la compañía estadounidense recibió subsidios de la Unión Europea por un monto de 10 millones de libras, además, fue aquí donde se ofrecieron los precios de electricidad más bajos de toda Europa.

Los ingenieros de Facebook simplificaron el diseño de los servidores al eliminar el uso de una serie de componentes estándar, como ranuras de memoria adicionales, cables y fundas protectoras de plástico. Estos servidores, con placas base desprotegidas, se encuentran dentro de un rack estándar del tamaño de un refrigerador.

Los ingenieros de Facebook simplificaron el diseño de los servidores al eliminar el uso de una serie de componentes estándar, como ranuras de memoria adicionales, cables y fundas protectoras de plástico. Estos servidores, con placas base desprotegidas, se encuentran dentro de un rack estándar del tamaño de un refrigerador.

Los expertos confían en que este diseño le permite intensificar el flujo de aire que pasa por cada servidor. La operación efectiva de tales sistemas de cómputo requiere menos capacidad de enfriamiento, porque debido al número reducido de componentes emiten menos energía térmica que los análogos estándar. Y además, las máquinas de Facebook pueden funcionar a temperaturas elevadas.

Los expertos confían en que este diseño le permite intensificar el flujo de aire que pasa por cada servidor. La operación efectiva de tales sistemas de cómputo requiere menos capacidad de enfriamiento, porque debido al número reducido de componentes emiten menos energía térmica que los análogos estándar. Y además, las máquinas de Facebook pueden funcionar a temperaturas elevadas.

Cuando los ingenieros de Facebook comenzaron a presentar sus ideas al "público", la mayoría de los expertos en el campo de los centros de datos aún se mostraron escépticos, especialmente con respecto al funcionamiento de los sistemas de servidores a temperaturas elevadas. Pero, como dicen, el tiempo ha puesto todo en su lugar. Al mismo tiempo, la mejora adicional de los sistemas de infraestructura por parte de los participantes de la iniciativa Open Compute Project (además del proyecto de Facebook es desarrollado por muchos fabricantes de hardware y microchips, proveedores de alojamiento y colocación, así como por organizaciones bancarias lejos del segmento de TI) hizo posible usarlos lejos del Ártico. El siguiente gran centro de datos de Facebook, se decidió construir en Iowa (EE. UU.), Donde el clima es templado. Como en Suecia, hay más que suficiente electricidad barata de fuentes renovables (en Iowa, los parques eólicos desempeñan el papel de las centrales hidroeléctricas).La compañía también comenzó a desarrollar sus propios sistemas de almacenamiento y equipos de red.

Cuando los ingenieros de Facebook comenzaron a presentar sus ideas al "público", la mayoría de los expertos en el campo de los centros de datos aún se mostraron escépticos, especialmente con respecto al funcionamiento de los sistemas de servidores a temperaturas elevadas. Pero, como dicen, el tiempo ha puesto todo en su lugar. Al mismo tiempo, la mejora adicional de los sistemas de infraestructura por parte de los participantes de la iniciativa Open Compute Project (además del proyecto de Facebook es desarrollado por muchos fabricantes de hardware y microchips, proveedores de alojamiento y colocación, así como por organizaciones bancarias lejos del segmento de TI) hizo posible usarlos lejos del Ártico. El siguiente gran centro de datos de Facebook, se decidió construir en Iowa (EE. UU.), Donde el clima es templado. Como en Suecia, hay más que suficiente electricidad barata de fuentes renovables (en Iowa, los parques eólicos desempeñan el papel de las centrales hidroeléctricas).La compañía también comenzó a desarrollar sus propios sistemas de almacenamiento y equipos de red.

HP respondió rápidamente a la iniciativa de la red social lanzando las ventas de un microservidor llamado Moonshot , que carece de todo el exceso, está equipado con chips de baja potencia y se caracteriza por una alta eficiencia energética. El lanzamiento de Moonshot fue el cambio más radical en la línea de productos de granja de servidores realizada por la compañía estadounidense en los últimos años. HP también está trabajando en mecanismos para mejorar la eficiencia energética del servidor a través del enfriamiento por agua.Según el liderazgo del gigante de la red, solo unas pocas compañías querrán lidiar con sistemas tan especializados que fueron diseñados principalmente para satisfacer las necesidades de las grandes compañías de Internet que poseen centros de datos hipergrandes. Según el portavoz de Cisco, David McCulloch, el gigante de la red no ve la nueva tendencia como una amenaza para su negocio. Hace seis años, otro importante proveedor de EE. UU., Dell, creó un equipo especial de ingenieros para diseñar sistemas informáticos sin los "adornos" adquiridos por las empresas de Internet. Desde entonces, los ingresos de Dell han crecido significativamente. Esto sugiere que el vendedor ha elegido la dirección correcta para el desarrollo de su negocio.Si bien el hardware especializado desarrollado dentro de los muros de los gigantes web Google y Amazon es accesible solo para los operadores de centros de datos de estas empresas, la apertura de Facebook y el deseo de la red social de compartir sus mejores prácticas se han convertido en las razones del creciente interés en sus centros de datos no solo por parte de otras compañías de Internet: Incluso las pequeñas y medianas empresas están activamente interesadas en los desarrollos de la red social en el campo de mejorar la eficiencia del centro de datos. Facebook ha creado instrucciones paso a paso para crear una granja de servidores a gran escala, que puede ser utilizada por cualquier empresa con suficientes horas de trabajo y dinero.

HP respondió rápidamente a la iniciativa de la red social lanzando las ventas de un microservidor llamado Moonshot , que carece de todo el exceso, está equipado con chips de baja potencia y se caracteriza por una alta eficiencia energética. El lanzamiento de Moonshot fue el cambio más radical en la línea de productos de granja de servidores realizada por la compañía estadounidense en los últimos años. HP también está trabajando en mecanismos para mejorar la eficiencia energética del servidor a través del enfriamiento por agua.Según el liderazgo del gigante de la red, solo unas pocas compañías querrán lidiar con sistemas tan especializados que fueron diseñados principalmente para satisfacer las necesidades de las grandes compañías de Internet que poseen centros de datos hipergrandes. Según el portavoz de Cisco, David McCulloch, el gigante de la red no ve la nueva tendencia como una amenaza para su negocio. Hace seis años, otro importante proveedor de EE. UU., Dell, creó un equipo especial de ingenieros para diseñar sistemas informáticos sin los "adornos" adquiridos por las empresas de Internet. Desde entonces, los ingresos de Dell han crecido significativamente. Esto sugiere que el vendedor ha elegido la dirección correcta para el desarrollo de su negocio.Si bien el hardware especializado desarrollado dentro de los muros de los gigantes web Google y Amazon es accesible solo para los operadores de centros de datos de estas empresas, la apertura de Facebook y el deseo de la red social de compartir sus mejores prácticas se han convertido en las razones del creciente interés en sus centros de datos no solo por parte de otras compañías de Internet: Incluso las pequeñas y medianas empresas están activamente interesadas en los desarrollos de la red social en el campo de mejorar la eficiencia del centro de datos. Facebook ha creado instrucciones paso a paso para crear una granja de servidores a gran escala, que puede ser utilizada por cualquier empresa con suficientes horas de trabajo y dinero.

El máximo directivo de Facebook Frank FrankovskyLa junta directiva de la organización sin fines de lucro Open Compute Project Foundation, dirigida por el máximo gerente de Facebook Frank Frankovsky, incluye a los jefes de gigantes del mundo de la alta tecnología y las finanzas como Intel y Goldman Sachs, respectivamente. Al mismo tiempo, muchos grandes fabricantes de hardware asiáticos como Quanta Computer y Tyan Computer ya han comenzado a vender sistemas de servidor basados en especificaciones creadas por miembros del Open Compute Project. La iniciativa de las redes sociales resultó ser muy popular.

El máximo directivo de Facebook Frank FrankovskyLa junta directiva de la organización sin fines de lucro Open Compute Project Foundation, dirigida por el máximo gerente de Facebook Frank Frankovsky, incluye a los jefes de gigantes del mundo de la alta tecnología y las finanzas como Intel y Goldman Sachs, respectivamente. Al mismo tiempo, muchos grandes fabricantes de hardware asiáticos como Quanta Computer y Tyan Computer ya han comenzado a vender sistemas de servidor basados en especificaciones creadas por miembros del Open Compute Project. La iniciativa de las redes sociales resultó ser muy popular.Campus de granja de servidores

Se colocó una valla larga alrededor del perímetro del campus del centro de datos, que en realidad se levantó para evitar que los alces locales ingresen al campus.Dentro del edificio, la cultura de Suecia se mezcla con la estadounidense. En la entrada, puede ver imágenes coloridas de ciervos junto al logotipo y los relojes de Facebook, que muestran la hora en otros campus de la compañía en los estados de Carolina del Norte, Iowa y Oregon. La mayoría de los mil quinientos empleados del campus sueco son locales. Los empleados se ponen a trabajar en motos de nieve y bicicletas decoradas con el logotipo de Facebook. También suelen pasar tiempo juntos, por ejemplo, organizando la pesca en hielo.

La mayoría de los mil quinientos empleados del campus sueco son locales. Los empleados se ponen a trabajar en motos de nieve y bicicletas decoradas con el logotipo de Facebook. También suelen pasar tiempo juntos, por ejemplo, organizando la pesca en hielo.

Source: https://habr.com/ru/post/es387823/

All Articles