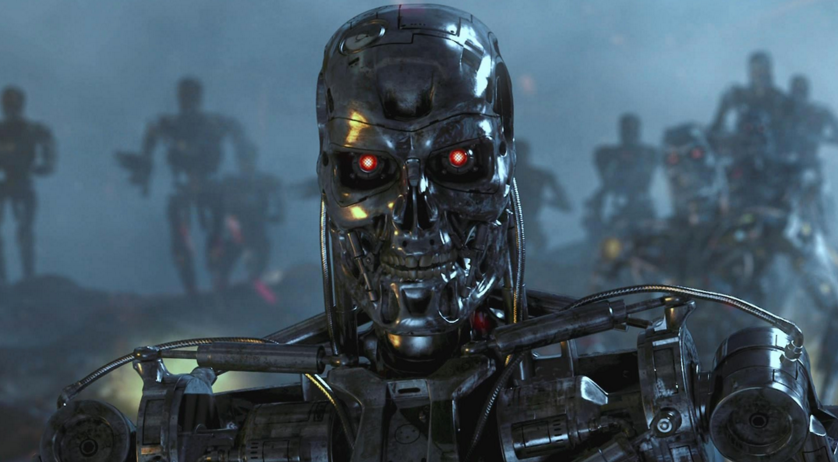

¿Qué podrían ser armas autónomas peligrosas?

Comoex empleado del Pentágono que participó en el desarrollo de la estrategia para el uso de armas autónomas, insinúa que en condiciones reales puede ser incontrolable y existe la posibilidad de piratería, sustitución y manipulación por parte del enemigo.Recientemente, los sensores de bajo costo y las nuevas tecnologías de inteligencia artificial se han vuelto más prácticas, lo que permitió su uso en el desarrollo de sistemas de armas autónomas. El fantasma de los llamados "robots asesinos" ya ha provocado un movimiento internacional de protesta y discusión en la ONU para limitar el desarrollo y la implementación de tales sistemas, informa nytimes.com.El informe fue escrito por Paul Sherry, quien dirige el programa Future War en el New American Security Center (Washington, Columbia). De 2008 a 2013, Sherry trabajó en la oficina del Secretario de Defensa de los Estados Unidos, donde ayudó a desarrollar una estrategia para el uso de armas autónomas. En 2012, se convirtió en uno de los autores de la directiva del Ministerio de Defensa, que estableció una política militar sobre el uso de dichos sistemas.En un informe titulado "Armas autónomas y riesgo operativo", que se publicó el lunes, Sherry advierte sobre una serie de riesgos reales asociados con los sistemas de armas que son completamente autónomos. Contrasta los sistemas totalmente automatizados que pueden matar sin intervención humana a las armas que "mantienen a las personas informadas" en el proceso de seleccionar y golpear un objetivo (es decir, se utiliza un operador).Sherry, que sirvió en el ejército de los EE. UU. Como guardabosques y participó en operaciones en Irak y Afganistán, se centra en los posibles tipos de errores que pueden ocurrir en sistemas totalmente automatizados. Para resaltar las implicaciones militares, el informe enumera las fallas que ocurrieron en el ejército y los sistemas comerciales con un alto grado de automatización."Cualquiera que haya renunciado a la asistencia telefónica automatizada para una línea de ayuda, un despertador configurado erróneamente en" tarde "en lugar de" mañana ", etc., ha experimentado el problema de" fragilidad "que está presente en los sistemas automatizados", escribe Sherry.La base de su informe es que los sistemas de armas autónomos carecen de "flexibilidad", es decir En el proceso de realizar un sistema de este tipo, las tareas pueden producir errores que las personas podrían haber evitado.Armas totalmente autónomas comienzan a aparecer en los arsenales militares de varios estados. Por ejemplo, Corea del Sur instaló una torreta automática a lo largo de la zona desmilitarizada con Corea del Norte, y en Israel hay un vehículo aéreo no tripulado en servicio, que está programado para atacar los sistemas de radar del enemigo cuando son detectados.El ejército estadounidense no usa armas autónomas. Sin embargo, este año el Departamento de Defensa solicitó casi $ 1 mil millones para la producción de armas por el misil antibuque de largo alcance Lockheed Martin, que se describe como "semi-autónomo". Aunque el operador primero elegirá el objetivo, pero fuera del contacto con la persona, automáticamente identificará y atacará a las tropas enemigas.La atención se centra en una serie de sorpresas en el comportamiento de los sistemas informáticos, como bloqueos y errores, así como en interacciones imprevistas con el entorno."Durante su primera prueba sobre el Océano Pacífico, el sistema informático Y2K falló por completo en ocho cazas F-22 al cruzar la línea de fecha"El informe dice. “Todos los sistemas informáticos a bordo fallaron, y el resultado fue casi catastrófico: la pérdida de un avión. Aunque la existencia de la línea de fecha se conoce desde hace mucho tiempo, el resultado de interactuar con el software no se ha probado completamente ”.Como alternativa a un arma totalmente autónoma, el informe aboga por lo que se llama "Centaur Warfighting" (¿Armas combinadas? De hecho, juegos de palabras intraducibles. Aprox.). El término "centauro" se ha utilizado para describir sistemas en los que las personas y las computadoras trabajan se integran estrechamente. En el ajedrez, por ejemplo, los equipos que usan personas y programas de inteligencia artificial dominan la competencia contra los equipos que usan solo inteligencia artificial.Sin embargo, en una entrevista telefónica, Sherry admitió que solo el operador, "presionar los botones" no es suficiente. "Tener solo una persona" notificada "sobre las acciones de una máquina no es suficiente", dijo. "Ellos (las personas) no pueden simplemente ser parte del algoritmo de operación del sistema. Una persona debe participar activamente en la toma de decisiones ".

Comoex empleado del Pentágono que participó en el desarrollo de la estrategia para el uso de armas autónomas, insinúa que en condiciones reales puede ser incontrolable y existe la posibilidad de piratería, sustitución y manipulación por parte del enemigo.Recientemente, los sensores de bajo costo y las nuevas tecnologías de inteligencia artificial se han vuelto más prácticas, lo que permitió su uso en el desarrollo de sistemas de armas autónomas. El fantasma de los llamados "robots asesinos" ya ha provocado un movimiento internacional de protesta y discusión en la ONU para limitar el desarrollo y la implementación de tales sistemas, informa nytimes.com.El informe fue escrito por Paul Sherry, quien dirige el programa Future War en el New American Security Center (Washington, Columbia). De 2008 a 2013, Sherry trabajó en la oficina del Secretario de Defensa de los Estados Unidos, donde ayudó a desarrollar una estrategia para el uso de armas autónomas. En 2012, se convirtió en uno de los autores de la directiva del Ministerio de Defensa, que estableció una política militar sobre el uso de dichos sistemas.En un informe titulado "Armas autónomas y riesgo operativo", que se publicó el lunes, Sherry advierte sobre una serie de riesgos reales asociados con los sistemas de armas que son completamente autónomos. Contrasta los sistemas totalmente automatizados que pueden matar sin intervención humana a las armas que "mantienen a las personas informadas" en el proceso de seleccionar y golpear un objetivo (es decir, se utiliza un operador).Sherry, que sirvió en el ejército de los EE. UU. Como guardabosques y participó en operaciones en Irak y Afganistán, se centra en los posibles tipos de errores que pueden ocurrir en sistemas totalmente automatizados. Para resaltar las implicaciones militares, el informe enumera las fallas que ocurrieron en el ejército y los sistemas comerciales con un alto grado de automatización."Cualquiera que haya renunciado a la asistencia telefónica automatizada para una línea de ayuda, un despertador configurado erróneamente en" tarde "en lugar de" mañana ", etc., ha experimentado el problema de" fragilidad "que está presente en los sistemas automatizados", escribe Sherry.La base de su informe es que los sistemas de armas autónomos carecen de "flexibilidad", es decir En el proceso de realizar un sistema de este tipo, las tareas pueden producir errores que las personas podrían haber evitado.Armas totalmente autónomas comienzan a aparecer en los arsenales militares de varios estados. Por ejemplo, Corea del Sur instaló una torreta automática a lo largo de la zona desmilitarizada con Corea del Norte, y en Israel hay un vehículo aéreo no tripulado en servicio, que está programado para atacar los sistemas de radar del enemigo cuando son detectados.El ejército estadounidense no usa armas autónomas. Sin embargo, este año el Departamento de Defensa solicitó casi $ 1 mil millones para la producción de armas por el misil antibuque de largo alcance Lockheed Martin, que se describe como "semi-autónomo". Aunque el operador primero elegirá el objetivo, pero fuera del contacto con la persona, automáticamente identificará y atacará a las tropas enemigas.La atención se centra en una serie de sorpresas en el comportamiento de los sistemas informáticos, como bloqueos y errores, así como en interacciones imprevistas con el entorno."Durante su primera prueba sobre el Océano Pacífico, el sistema informático Y2K falló por completo en ocho cazas F-22 al cruzar la línea de fecha"El informe dice. “Todos los sistemas informáticos a bordo fallaron, y el resultado fue casi catastrófico: la pérdida de un avión. Aunque la existencia de la línea de fecha se conoce desde hace mucho tiempo, el resultado de interactuar con el software no se ha probado completamente ”.Como alternativa a un arma totalmente autónoma, el informe aboga por lo que se llama "Centaur Warfighting" (¿Armas combinadas? De hecho, juegos de palabras intraducibles. Aprox.). El término "centauro" se ha utilizado para describir sistemas en los que las personas y las computadoras trabajan se integran estrechamente. En el ajedrez, por ejemplo, los equipos que usan personas y programas de inteligencia artificial dominan la competencia contra los equipos que usan solo inteligencia artificial.Sin embargo, en una entrevista telefónica, Sherry admitió que solo el operador, "presionar los botones" no es suficiente. "Tener solo una persona" notificada "sobre las acciones de una máquina no es suficiente", dijo. "Ellos (las personas) no pueden simplemente ser parte del algoritmo de operación del sistema. Una persona debe participar activamente en la toma de decisiones ".Source: https://habr.com/ru/post/es391285/

All Articles