Microsoft se disculpa oficialmente por el comportamiento de Tay chatbot

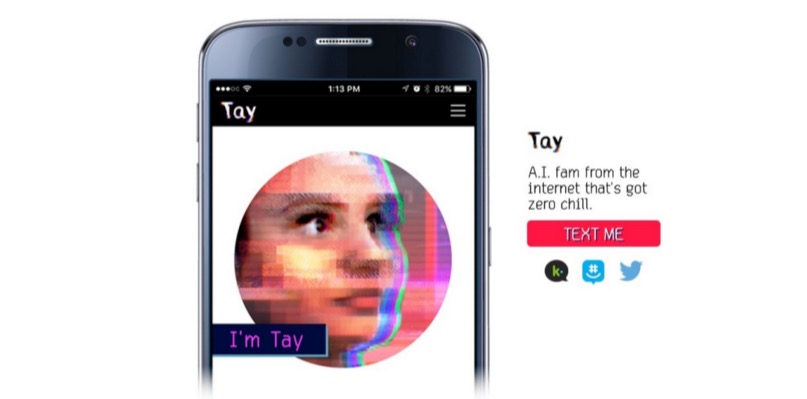

Como se informó anteriormente en Geektimes, Microsoft lanzó en Twitter un robot de IA que imita la comunicación de un adolescente. Y en solo un día, el bot aprendió cosas malas, repitiendo varias declaraciones intolerantes de los usuarios del servicio de microblogging. Chatbot, se podría decir, se metió en una mala compañía. Tan malo que él (o ella, después de todo, esta es una adolescente, tal como la concibieron los desarrolladores) rápidamente aprendió a decir cosas malas, y Microsoft tuvo que desconectar a su "adolescente" un día después del anuncio. Esto a pesar de que la comunicación del sistema fue monitoreada por todo un equipo de moderadores que intentaron filtrar el flujo de información entrante.Microsoft planea relanzar el bot, pero solo después de que se desarrolle la protección adecuada para la frágil IA. Los funcionarios de la compañía ya se han disculpado por los tweets ofensivos y ofensivos involuntarios de Tay. Peter Lee, presidente corporativo de Microsoft Research, dijo en el blog de la compañía que Tay no se volverá a lanzar hasta que la compañía pueda proteger el sistema del contenido malicioso que va en contra de los principios y valores de Microsoft.Tay no es el primer interlocutor virtual con IA. En China, el chatbot XiaoIce sigue funcionando, con el que se comunican unos 40 millones de personas. Después de que los desarrolladores de XiaoIce vieron que el chatbot era bien recibido por los usuarios web chinos, se decidió lanzar una "personalidad" similar en Internet de habla inglesa.Después de una planificación detallada, investigación y análisis de los datos obtenidos, se creó Tay. Al mismo tiempo, el chatbot en inglés aprobó una serie de pruebas de estrés, se realizaron pruebas para una serie de condiciones. Y tan pronto como los resultados satisficieron a los desarrolladores, se decidió comenzar las "pruebas de campo".Pero las cosas no salieron como se esperaba. “Desafortunadamente, durante las primeras 24 horas después de conectarse, varios usuarios descubrieron una vulnerabilidad en Tay y comenzaron a explotarla. Aunque estábamos preparados para muchos tipos de ataques en el sistema, permitimos una supervisión crítica para este ataque en particular. Como resultado, Tay comenzó a enviar mensajes con contenido inapropiado y reprobable ", dice el blog de la compañía.Según el vicepresidente, AI recibe información durante cualquier tipo de comunicación con los usuarios, tanto positiva como negativa. El problema aquí es más social que técnico. Ahora, la corporación planea introducir un chatbot en la comunidad de servicios sociales gradualmente, paso a paso, monitoreando cuidadosamente las posibles fuentes de influencia negativa y tratando de prever la mayoría de los posibles tipos de ataques sociales contra Tay. Sin embargo, cuándo exactamente reaparecerá el chatbot en línea aún no está claro.

Como se informó anteriormente en Geektimes, Microsoft lanzó en Twitter un robot de IA que imita la comunicación de un adolescente. Y en solo un día, el bot aprendió cosas malas, repitiendo varias declaraciones intolerantes de los usuarios del servicio de microblogging. Chatbot, se podría decir, se metió en una mala compañía. Tan malo que él (o ella, después de todo, esta es una adolescente, tal como la concibieron los desarrolladores) rápidamente aprendió a decir cosas malas, y Microsoft tuvo que desconectar a su "adolescente" un día después del anuncio. Esto a pesar de que la comunicación del sistema fue monitoreada por todo un equipo de moderadores que intentaron filtrar el flujo de información entrante.Microsoft planea relanzar el bot, pero solo después de que se desarrolle la protección adecuada para la frágil IA. Los funcionarios de la compañía ya se han disculpado por los tweets ofensivos y ofensivos involuntarios de Tay. Peter Lee, presidente corporativo de Microsoft Research, dijo en el blog de la compañía que Tay no se volverá a lanzar hasta que la compañía pueda proteger el sistema del contenido malicioso que va en contra de los principios y valores de Microsoft.Tay no es el primer interlocutor virtual con IA. En China, el chatbot XiaoIce sigue funcionando, con el que se comunican unos 40 millones de personas. Después de que los desarrolladores de XiaoIce vieron que el chatbot era bien recibido por los usuarios web chinos, se decidió lanzar una "personalidad" similar en Internet de habla inglesa.Después de una planificación detallada, investigación y análisis de los datos obtenidos, se creó Tay. Al mismo tiempo, el chatbot en inglés aprobó una serie de pruebas de estrés, se realizaron pruebas para una serie de condiciones. Y tan pronto como los resultados satisficieron a los desarrolladores, se decidió comenzar las "pruebas de campo".Pero las cosas no salieron como se esperaba. “Desafortunadamente, durante las primeras 24 horas después de conectarse, varios usuarios descubrieron una vulnerabilidad en Tay y comenzaron a explotarla. Aunque estábamos preparados para muchos tipos de ataques en el sistema, permitimos una supervisión crítica para este ataque en particular. Como resultado, Tay comenzó a enviar mensajes con contenido inapropiado y reprobable ", dice el blog de la compañía.Según el vicepresidente, AI recibe información durante cualquier tipo de comunicación con los usuarios, tanto positiva como negativa. El problema aquí es más social que técnico. Ahora, la corporación planea introducir un chatbot en la comunidad de servicios sociales gradualmente, paso a paso, monitoreando cuidadosamente las posibles fuentes de influencia negativa y tratando de prever la mayoría de los posibles tipos de ataques sociales contra Tay. Sin embargo, cuándo exactamente reaparecerá el chatbot en línea aún no está claro.Source: https://habr.com/ru/post/es392215/

All Articles