Programa de predicción del delito acusado de racismo

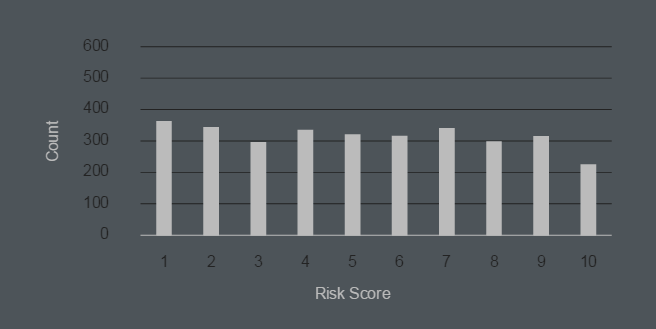

Durante varios años, las agencias de aplicación de la ley de los Estados Unidos han estado utilizando programas especiales que analizan las estadísticas de delitos y hacen recomendaciones. Por ejemplo, en California, el programa calcula la ruta de patrulla óptima , teniendo en cuenta la probabilidad de delincuencia en cada área de la ciudad a una hora específica del día. La policía de Chicago en 2014 compiló una lista de vigilancia con los nombres de 400 de los delincuentes más probables en el futuro . El algoritmo de predicción para delincuentes y futuras víctimas preocupa a los defensores de los derechos humanos, aunque mostró una precisión sorprendente (más del 70% de las víctimas de un disparo en Chicago en 2016 estaban en una lista precompilada por el programa).Recientemente, los programas analíticos han comenzado a utilizarse en los tribunales. El juez debe determinar si castiga al delincuente con la severidad mínima o máxima prescrita por la ley para un delito específico. En este caso, el programa calcula el llamado "puntaje de evaluación de riesgos" con base en los datos disponibles. Este indicador determina la probabilidad de que se repita el delito y, en consecuencia, afecta la gravedad de la sentencia.Entonces, un análisis exhaustivo de los resultados del programa por ProPublica, reveló una tendencia extraña: por alguna razón, para los afroamericanos (negros), el programa otorga una calificación de riesgo más alta que para los blancos. En otras palabras, ¡el algoritmo exhibe discriminación racial! Y esto a pesar del hecho de que este programa se introdujo específicamente en el sistema judicial precisamente para excluir dicha discriminación.Un indicador de evaluación de riesgos es muy importante. Afecta la severidad de la sentencia, el tamaño de la cantidad bajo la cual el sospechoso es liberado bajo fianza, así como la elección de una medida preventiva y mucho más.Los reporteros de ProPublica analizaron más de 7,000 casos en el condado de Broward, Florida, donde el puntaje de riesgo del sospechoso se calcula mediante uno de los programas más populares de este tipo de Northpointe .Al final resultó que, solo el 20% de los sospechosos para quienes el programa identificó un alto riesgo de cometer delitos lo cometió dentro de los dos años posteriores a la exposición. Incluso si tiene en cuenta infracciones menores, como ir más allá del perímetro de un arresto domiciliario, "la precisión del programa es un poco más que arrojar una moneda".Pero lo peor es que el programa exhibe discriminación racial. Las tasas de evaluación de riesgos para los afroamericanos son mucho más altas que para los delincuentes blancos. La predicción errónea de recaída para los negros es dos veces mayor que para los blancos.Indicador de evaluación de riesgo para afroamericanos (1 - mínimo, 10 - máximo)

Durante varios años, las agencias de aplicación de la ley de los Estados Unidos han estado utilizando programas especiales que analizan las estadísticas de delitos y hacen recomendaciones. Por ejemplo, en California, el programa calcula la ruta de patrulla óptima , teniendo en cuenta la probabilidad de delincuencia en cada área de la ciudad a una hora específica del día. La policía de Chicago en 2014 compiló una lista de vigilancia con los nombres de 400 de los delincuentes más probables en el futuro . El algoritmo de predicción para delincuentes y futuras víctimas preocupa a los defensores de los derechos humanos, aunque mostró una precisión sorprendente (más del 70% de las víctimas de un disparo en Chicago en 2016 estaban en una lista precompilada por el programa).Recientemente, los programas analíticos han comenzado a utilizarse en los tribunales. El juez debe determinar si castiga al delincuente con la severidad mínima o máxima prescrita por la ley para un delito específico. En este caso, el programa calcula el llamado "puntaje de evaluación de riesgos" con base en los datos disponibles. Este indicador determina la probabilidad de que se repita el delito y, en consecuencia, afecta la gravedad de la sentencia.Entonces, un análisis exhaustivo de los resultados del programa por ProPublica, reveló una tendencia extraña: por alguna razón, para los afroamericanos (negros), el programa otorga una calificación de riesgo más alta que para los blancos. En otras palabras, ¡el algoritmo exhibe discriminación racial! Y esto a pesar del hecho de que este programa se introdujo específicamente en el sistema judicial precisamente para excluir dicha discriminación.Un indicador de evaluación de riesgos es muy importante. Afecta la severidad de la sentencia, el tamaño de la cantidad bajo la cual el sospechoso es liberado bajo fianza, así como la elección de una medida preventiva y mucho más.Los reporteros de ProPublica analizaron más de 7,000 casos en el condado de Broward, Florida, donde el puntaje de riesgo del sospechoso se calcula mediante uno de los programas más populares de este tipo de Northpointe .Al final resultó que, solo el 20% de los sospechosos para quienes el programa identificó un alto riesgo de cometer delitos lo cometió dentro de los dos años posteriores a la exposición. Incluso si tiene en cuenta infracciones menores, como ir más allá del perímetro de un arresto domiciliario, "la precisión del programa es un poco más que arrojar una moneda".Pero lo peor es que el programa exhibe discriminación racial. Las tasas de evaluación de riesgos para los afroamericanos son mucho más altas que para los delincuentes blancos. La predicción errónea de recaída para los negros es dos veces mayor que para los blancos.Indicador de evaluación de riesgo para afroamericanos (1 - mínimo, 10 - máximo) Indicador de evaluación de riesgo para blancos (1 - mínimo, 10 - máximo)

Indicador de evaluación de riesgo para blancos (1 - mínimo, 10 - máximo) Los investigadores concluyen que el programa viola la ley, considerando específicamente el factor de color de la piel como uno de los parámetros para determinar la probabilidad de un delito en el futuro.Northpointe afirma que la raza del sospechoso no se tiene en cuenta en el análisis. Pero se tienen en cuenta otros factores que se correlacionan fuertemente con la raza: nivel de educación, situación laboral, antecedentes penales de familiares, uso de drogas por parte de amigos / conocidos, etc. Se clasifica el peso de cada factor en el puntaje final: este es el algoritmo patentado de Northpointe.

Los investigadores concluyen que el programa viola la ley, considerando específicamente el factor de color de la piel como uno de los parámetros para determinar la probabilidad de un delito en el futuro.Northpointe afirma que la raza del sospechoso no se tiene en cuenta en el análisis. Pero se tienen en cuenta otros factores que se correlacionan fuertemente con la raza: nivel de educación, situación laboral, antecedentes penales de familiares, uso de drogas por parte de amigos / conocidos, etc. Se clasifica el peso de cada factor en el puntaje final: este es el algoritmo patentado de Northpointe.Source: https://habr.com/ru/post/es394313/

All Articles