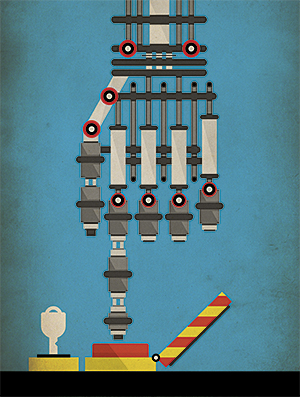

¿Le daremos a los robots militares una licencia para matar?

A medida que los robots de guerra con IA mejoran, la esencia de la guerra cambia

En 1920, el escritor checo Karel Čapek escribió la obra RUR (Rossum Universal Robots, "Rossum Universal Robots"), en la que le dio al mundo la palabra "robot". En su juego, todo comienza con personas artificiales: robots que trabajan en fábricas y producen bienes de bajo costo. Y todo termina con el hecho de que los robots destruyen a la humanidad. Así nació la trama de larga duración del NF: los robots se descontrolan y se convierten en máquinas de matar imparables. La literatura y el cine del siglo XX continúan proporcionándonos ejemplos de robots que destruyen el mundo, y Hollywood lo convierte constantemente en franquicias de gran éxito: The Matrix, Transformers y Terminator.Recientemente, el miedo a convertir la ficción en realidad se ve respaldado por una combinación de circunstancias, entre las cuales se encuentran las mejoras en IA y robótica, la difusión deDrones militares y robots terrestres en Irak y Afganistán. Las potencias más grandes están desarrollando armas inteligentes con diversos grados de autonomía y mortalidad. La mayoría de ellos pronto serán controlados remotamente por personas, sin cuyo comando el robot no podrá apretar el gatillo. Pero, muy probablemente, y según algunos, incluso sin lugar a dudas, en algún momento los robots podrán operar de manera completamente autónoma, y el Rubicon se encenderá en asuntos militares: por primera vez, un conjunto de microchips y software decidirá si una persona vive o muere.Como era de esperar, la amenaza de los robots asesinos, como los apodaron cariñosamente, condujo a un apasionado debate. En los lados opuestos de la disputa están aquellos que temen que las armas automáticas inicien una guerra general y destruyan la civilización, y quienes afirman que las armas nuevas son solo otra clase de armas guiadas con precisión que reducirán en lugar de aumentar el número de víctimas. En diciembre, más de cien países discutirán este tema en la reunión de desarme de la OTAN en Ginebra.

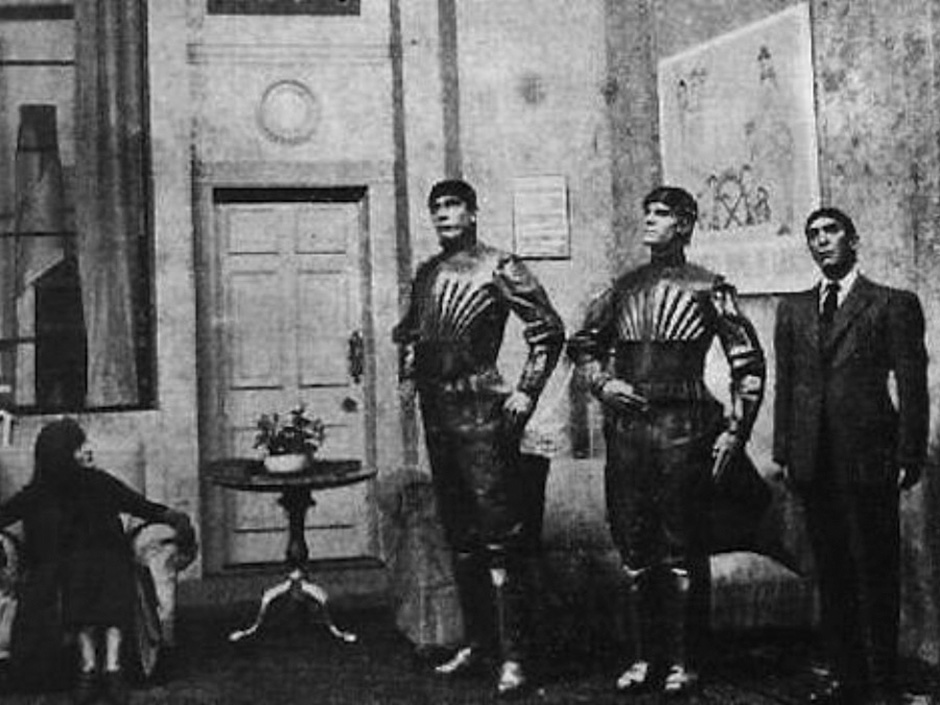

En 1920, el escritor checo Karel Čapek escribió la obra RUR (Rossum Universal Robots, "Rossum Universal Robots"), en la que le dio al mundo la palabra "robot". En su juego, todo comienza con personas artificiales: robots que trabajan en fábricas y producen bienes de bajo costo. Y todo termina con el hecho de que los robots destruyen a la humanidad. Así nació la trama de larga duración del NF: los robots se descontrolan y se convierten en máquinas de matar imparables. La literatura y el cine del siglo XX continúan proporcionándonos ejemplos de robots que destruyen el mundo, y Hollywood lo convierte constantemente en franquicias de gran éxito: The Matrix, Transformers y Terminator.Recientemente, el miedo a convertir la ficción en realidad se ve respaldado por una combinación de circunstancias, entre las cuales se encuentran las mejoras en IA y robótica, la difusión deDrones militares y robots terrestres en Irak y Afganistán. Las potencias más grandes están desarrollando armas inteligentes con diversos grados de autonomía y mortalidad. La mayoría de ellos pronto serán controlados remotamente por personas, sin cuyo comando el robot no podrá apretar el gatillo. Pero, muy probablemente, y según algunos, incluso sin lugar a dudas, en algún momento los robots podrán operar de manera completamente autónoma, y el Rubicon se encenderá en asuntos militares: por primera vez, un conjunto de microchips y software decidirá si una persona vive o muere.Como era de esperar, la amenaza de los robots asesinos, como los apodaron cariñosamente, condujo a un apasionado debate. En los lados opuestos de la disputa están aquellos que temen que las armas automáticas inicien una guerra general y destruyan la civilización, y quienes afirman que las armas nuevas son solo otra clase de armas guiadas con precisión que reducirán en lugar de aumentar el número de víctimas. En diciembre, más de cien países discutirán este tema en la reunión de desarme de la OTAN en Ginebra. Un avión no tripulado controlado por humanos

Un avión no tripulado controlado por humanos El cañón Phalanx dispara de forma independienteEl año pasado, una discusión de este tipo cayó en las noticias cuando un grupo de investigadores líderes de IA pidió la prohibición de "armas ofensivas autónomas que operen sin un control humano significativo". En una carta abierta a una conferencia internacional sobre IA, un grupo de investigadores señaló que tales armas podrían conducir a una carrera armamentista internacional de IA y podrían usarse para asesinatos por contrato, desestabilización de naciones, represión de pueblos y destrucción selectiva de grupos étnicos.La carta fue firmada por más de 20,000 personas, incluidas personalidades tan famosas como el físico Stephen Hawking y el empresario Ilon Musk. Este último donó $ 10 millones al Instituto de Boston el año pasado., comprometidos en proteger la vida de las personas de la hipotética amenaza de una IA hostil. Los académicos que organizaron la escritura: Stuart Russell de la Universidad de California en Berkeley, Max Tegmark del MIT y Toby Walsh de la Universidad de Nueva Gales del Sur en Australia, ampliaron su posición en un artículo para IEEE Spectrum. Por ejemplo, en un escenario, "se puede matar una gran cantidad de microrobots de bajo costo que una persona puede colocar en el mercado negro, y miles o millones de personas que cumplan con los criterios del usuario podrán matar".También agregaron que “las armas autónomas pueden convertirse en armas de destrucción masiva. "Algunos países pueden prohibir su uso, mientras que otros países y, por supuesto, los terroristas, es poco probable que puedan abandonarlo".Difícilmente se puede decir que una nueva carrera armamentista, que puede dar como resultado máquinas de matar inteligentes, autónomas y móviles, beneficiará a toda la humanidad. Sin embargo, esta carrera ya ha comenzado.Las armas autónomas han existido durante varias décadas, aunque sus especímenes raros hasta ahora se han utilizado principalmente para la defensa. Un ejemplo es el Phalanx , un arma controlada por computadora guiada por radar y montada en buques de guerra de la Marina de los EE. UU. Puede detectar, rastrear, evaluar y disparar automáticamente a los misiles y aviones que se aproximan, lo que considera una amenaza. En un modo totalmente autónomo, la participación humana no es necesaria en absoluto.Dron Harop destruye objetivoDoDAAM Systems demuestra las capacidades del reloj robot Super aEgis II.Recientemente, los desarrolladores militares han comenzado a crear robots autónomos ofensivos. La compañía Israel Aerospace Industries ha fabricado aviones no tripulados Harpy y Harop, que lleva a las ondas de radio de los sistemas de defensa aérea enemiga, y matarlos por la colisión. La compañía afirma que sus UAV se están vendiendo bien en todo el mundo.La compañía surcoreana DoDAAM Systems ha desarrollado el reloj robot Super aEgis II. Dispara con una ametralladora, y utiliza la visión por computadora para detectar y disparar a objetivos (personas) a una distancia de 3 km. Se alega que el ejército surcoreano realizó pruebas de estos robots en la zona desmilitarizada en la frontera con Corea del Norte. DoDAAM yavendió 30 dispositivos de este tipo a otros países, incluidos varios clientes de Oriente Medio.Hoy en día, los sistemas con un alto grado de autonomía son muy pocos en comparación con las armas robóticas controladas por personas casi todo el tiempo, y especialmente durante los disparos. Los analistas predicen que con el desarrollo de los asuntos militares, las armas tendrán capacidades cada vez más autónomas."La guerra será completamente diferente y la automatización desempeñará un papel donde la velocidad es importante", dijo Peter Singer, un experto en robots militares en el grupo no político de Nueva América con sede en Washington. Él leerá que en futuras batallas, como en las batallas entre diferentes vehículos aéreos no tripulados, o cuando una nave automática se encuentra con un submarino automático, un arma que tenga una fracción de una segunda ventaja decidirá el resultado de la batalla. "Puede haber un conflicto repentino e intenso en el que simplemente no habrá tiempo para poner a la gente al día, porque todo se decidirá en cuestión de segundos".El ejército estadounidense ha descrito sus planes a largo plazo para librar un nuevo tipo de guerra utilizando sistemas no tripulados, pero aún se desconoce si tienen la intención de armar estos sistemas. EnEl foro del Washington Post en marzo, el Secretario de Defensa de los EE. UU., Robert Work, cuyo trabajo es garantizar que el Pentágono se mantenga al día con la última tecnología, señaló la necesidad de invertir en IA y robots. Según él, la creciente presencia de sistemas autónomos en el campo de batalla es "inevitable".Con respecto a las armas autónomas, Work insiste en que el ejército estadounidense "no le dará a la máquina el poder de tomar decisiones fatales". Sin embargo, él mismo agregó que "si un oponente parece estar listo para transferir tales poderes ... tendremos que tomar decisiones sobre el tema de la competencia con él". Todavía no lo hemos descubierto por completo, pero pensamos mucho en esto ”.Vladimir Putin mira un cyborg militar en un ATV durante la manifestación del año pasadoEl primer vuelo del UAV CH-5 de la compañía china China Aerospace Science and Technology Corporation,Rusia y China se adhieren a una estrategia similar en el desarrollo de sistemas de combate no tripulados para operaciones en tierra, mar y aire, que, aunque armados, todavía dependen de operadores vivos. Russian Platform-M es un pequeño robot con control remoto, equipado con un rifle de asalto Kalashnikov y un lanzagranadas. Se asemeja al sistema US Talon SWORDS , un robot terrestre capaz de transportar M16 y otras armas que se han probado en Irak. Rusia también construyó un vehículo no tripulado Uranus-9, armado con un cañón de 30 mm y misiles antitanque guiados. Y el año pasado, los rusos demostraron un robot humanoide militar a Putin.El creciente arsenal de robots militares de China incluye muchos drones para ataque y reconocimiento. CH-4: UAV de acción prolongada, que recuerda al depredador estadounidense. Divine Eagle: un dron a gran altitud para cazar bombarderos furtivos. Además, se mostraron robots con ametralladoras similares a Platform-M y Talon SWORDS en varias presentaciones militares en China.Estos tres países se están acercando a la creación de robots armados y, al aumentar su autonomía, al mismo tiempo enfatizan la preservación del papel de las personas en su trabajo. Aparecerá un problema grave para la prohibición de las armas autónomas: no será necesariamente aplicable a las armas casi autónomas. Los militares siempre pueden desarrollar de forma encubierta robots armados que son controlados por personas, pero con solo tocar un botón pasan al modo fuera de línea. "Será muy difícil para los robots imponer un acuerdo de limitación de armas", concluye Wendell Wallach, experto en ética y tecnología de la Universidad de Yale. "La diferencia entre las armas autónomas y no autónomas puede ser solo una línea de código", dijo en una conferencia.En las películas, los robots a veces se vuelven sorprendentemente autónomos, hasta que adquieren conciencia casi desde cero, lo que toma a las personas por sorpresa . En el mundo real, a pesar de la emoción general del progreso del aprendizaje automático , los robots ganan autonomía gradualmente. Lo mismo puede esperarse de las armas autónomas.

El cañón Phalanx dispara de forma independienteEl año pasado, una discusión de este tipo cayó en las noticias cuando un grupo de investigadores líderes de IA pidió la prohibición de "armas ofensivas autónomas que operen sin un control humano significativo". En una carta abierta a una conferencia internacional sobre IA, un grupo de investigadores señaló que tales armas podrían conducir a una carrera armamentista internacional de IA y podrían usarse para asesinatos por contrato, desestabilización de naciones, represión de pueblos y destrucción selectiva de grupos étnicos.La carta fue firmada por más de 20,000 personas, incluidas personalidades tan famosas como el físico Stephen Hawking y el empresario Ilon Musk. Este último donó $ 10 millones al Instituto de Boston el año pasado., comprometidos en proteger la vida de las personas de la hipotética amenaza de una IA hostil. Los académicos que organizaron la escritura: Stuart Russell de la Universidad de California en Berkeley, Max Tegmark del MIT y Toby Walsh de la Universidad de Nueva Gales del Sur en Australia, ampliaron su posición en un artículo para IEEE Spectrum. Por ejemplo, en un escenario, "se puede matar una gran cantidad de microrobots de bajo costo que una persona puede colocar en el mercado negro, y miles o millones de personas que cumplan con los criterios del usuario podrán matar".También agregaron que “las armas autónomas pueden convertirse en armas de destrucción masiva. "Algunos países pueden prohibir su uso, mientras que otros países y, por supuesto, los terroristas, es poco probable que puedan abandonarlo".Difícilmente se puede decir que una nueva carrera armamentista, que puede dar como resultado máquinas de matar inteligentes, autónomas y móviles, beneficiará a toda la humanidad. Sin embargo, esta carrera ya ha comenzado.Las armas autónomas han existido durante varias décadas, aunque sus especímenes raros hasta ahora se han utilizado principalmente para la defensa. Un ejemplo es el Phalanx , un arma controlada por computadora guiada por radar y montada en buques de guerra de la Marina de los EE. UU. Puede detectar, rastrear, evaluar y disparar automáticamente a los misiles y aviones que se aproximan, lo que considera una amenaza. En un modo totalmente autónomo, la participación humana no es necesaria en absoluto.Dron Harop destruye objetivoDoDAAM Systems demuestra las capacidades del reloj robot Super aEgis II.Recientemente, los desarrolladores militares han comenzado a crear robots autónomos ofensivos. La compañía Israel Aerospace Industries ha fabricado aviones no tripulados Harpy y Harop, que lleva a las ondas de radio de los sistemas de defensa aérea enemiga, y matarlos por la colisión. La compañía afirma que sus UAV se están vendiendo bien en todo el mundo.La compañía surcoreana DoDAAM Systems ha desarrollado el reloj robot Super aEgis II. Dispara con una ametralladora, y utiliza la visión por computadora para detectar y disparar a objetivos (personas) a una distancia de 3 km. Se alega que el ejército surcoreano realizó pruebas de estos robots en la zona desmilitarizada en la frontera con Corea del Norte. DoDAAM yavendió 30 dispositivos de este tipo a otros países, incluidos varios clientes de Oriente Medio.Hoy en día, los sistemas con un alto grado de autonomía son muy pocos en comparación con las armas robóticas controladas por personas casi todo el tiempo, y especialmente durante los disparos. Los analistas predicen que con el desarrollo de los asuntos militares, las armas tendrán capacidades cada vez más autónomas."La guerra será completamente diferente y la automatización desempeñará un papel donde la velocidad es importante", dijo Peter Singer, un experto en robots militares en el grupo no político de Nueva América con sede en Washington. Él leerá que en futuras batallas, como en las batallas entre diferentes vehículos aéreos no tripulados, o cuando una nave automática se encuentra con un submarino automático, un arma que tenga una fracción de una segunda ventaja decidirá el resultado de la batalla. "Puede haber un conflicto repentino e intenso en el que simplemente no habrá tiempo para poner a la gente al día, porque todo se decidirá en cuestión de segundos".El ejército estadounidense ha descrito sus planes a largo plazo para librar un nuevo tipo de guerra utilizando sistemas no tripulados, pero aún se desconoce si tienen la intención de armar estos sistemas. EnEl foro del Washington Post en marzo, el Secretario de Defensa de los EE. UU., Robert Work, cuyo trabajo es garantizar que el Pentágono se mantenga al día con la última tecnología, señaló la necesidad de invertir en IA y robots. Según él, la creciente presencia de sistemas autónomos en el campo de batalla es "inevitable".Con respecto a las armas autónomas, Work insiste en que el ejército estadounidense "no le dará a la máquina el poder de tomar decisiones fatales". Sin embargo, él mismo agregó que "si un oponente parece estar listo para transferir tales poderes ... tendremos que tomar decisiones sobre el tema de la competencia con él". Todavía no lo hemos descubierto por completo, pero pensamos mucho en esto ”.Vladimir Putin mira un cyborg militar en un ATV durante la manifestación del año pasadoEl primer vuelo del UAV CH-5 de la compañía china China Aerospace Science and Technology Corporation,Rusia y China se adhieren a una estrategia similar en el desarrollo de sistemas de combate no tripulados para operaciones en tierra, mar y aire, que, aunque armados, todavía dependen de operadores vivos. Russian Platform-M es un pequeño robot con control remoto, equipado con un rifle de asalto Kalashnikov y un lanzagranadas. Se asemeja al sistema US Talon SWORDS , un robot terrestre capaz de transportar M16 y otras armas que se han probado en Irak. Rusia también construyó un vehículo no tripulado Uranus-9, armado con un cañón de 30 mm y misiles antitanque guiados. Y el año pasado, los rusos demostraron un robot humanoide militar a Putin.El creciente arsenal de robots militares de China incluye muchos drones para ataque y reconocimiento. CH-4: UAV de acción prolongada, que recuerda al depredador estadounidense. Divine Eagle: un dron a gran altitud para cazar bombarderos furtivos. Además, se mostraron robots con ametralladoras similares a Platform-M y Talon SWORDS en varias presentaciones militares en China.Estos tres países se están acercando a la creación de robots armados y, al aumentar su autonomía, al mismo tiempo enfatizan la preservación del papel de las personas en su trabajo. Aparecerá un problema grave para la prohibición de las armas autónomas: no será necesariamente aplicable a las armas casi autónomas. Los militares siempre pueden desarrollar de forma encubierta robots armados que son controlados por personas, pero con solo tocar un botón pasan al modo fuera de línea. "Será muy difícil para los robots imponer un acuerdo de limitación de armas", concluye Wendell Wallach, experto en ética y tecnología de la Universidad de Yale. "La diferencia entre las armas autónomas y no autónomas puede ser solo una línea de código", dijo en una conferencia.En las películas, los robots a veces se vuelven sorprendentemente autónomos, hasta que adquieren conciencia casi desde cero, lo que toma a las personas por sorpresa . En el mundo real, a pesar de la emoción general del progreso del aprendizaje automático , los robots ganan autonomía gradualmente. Lo mismo puede esperarse de las armas autónomas.Antología de robots asesinos.

«R.U.R» 1920 – ,

«R.U.R» 1920 – , «2001: » (1968). ,

«2001: » (1968). , « » (1973).

« » (1973). « » (1982). -

« » (1982). - «» (1984). - -800

«» (1984). - -800 (1987). – , .

(1987). – , . (1999).

(1999). « » (2004). , ,

« » (2004). , , Yo, robot (2004). Los robots humanoides, sin pasar por las Tres Leyes de la Robótica, causan problemas en Chicago

Yo, robot (2004). Los robots humanoides, sin pasar por las Tres Leyes de la Robótica, causan problemas en Chicago Transformers (2007). Una pandilla de robots alienígenas liderados por Megatron intenta aniquilar a todos loshumanos. El centro del nuevo grupo de investigación de seguridad estadounidense en Washington. "Pero es poco probable que los militares quieran hacer este tipo de arma autónoma". Según él, lo más probable es que los sistemas autónomos ataquen instalaciones militares como radares, tanques, barcos, submarinos y aviones.La tarea de identificar el objetivo, determinar si un objeto pertenece al enemigo, es una de las tareas más críticas para la IA. Los objetivos, aviones y misiles en movimiento tienen una trayectoria que se puede rastrear y tomar como base la decisión de intentar derribar un objeto. Así es como funciona el cañón Phalanx en los buques de guerra estadounidenses, y también lo hace el sistema de intercepción de misiles de la Cúpula de Hierro israelí. Pero cuando las personas son elegidas como el objetivo, esta identificación es complicada. Incluso en condiciones ideales, las tareas de reconocer objetos y entornos que las personas enfrentan todo el tiempo pueden ser demasiado complejas para los robots.Una computadora puede distinguir la figura de una persona, incluso si se mueve sigilosamente. Pero es difícil para el algoritmo entender con qué están ocupadas las personas y qué intenciones dan su lenguaje corporal y sus expresiones faciales. ¿Un hombre levanta una pistola o un rastrillo? ¿Está sosteniendo una bomba o un bebé?Scarre afirma que las armas robóticas, tratando de elegir un objetivo por su cuenta, salvan frente a las dificultades. En su opinión, el mejor enfoque, desde el punto de vista de la seguridad, la legalidad y la ética, sigue siendo el desarrollo de tácticas y tecnologías en las que las personas trabajen juntas con robots . "Los militares pueden invertir en robótica y automatización avanzadas, pero al mismo tiempo dejar a la persona en la cadena de control para tomar decisiones sobre objetivos, para estar seguros", dice. “Después de todo, las personas son más flexibles y se adaptan mejor a nuevas situaciones que quizás no programemos. Esto es especialmente importante en una guerra donde hay un adversario que intenta derrotar a sus sistemas, engañarlos y piratearlos ”.No es sorprendente que los surcoreanos de DoDAAM produzcan sus robots de vigilancia con severas restricciones de autonomía. Ahora sus robots no dispararán hasta que una persona confirme el objetivo y ordene "disparar". "La versión original era un sistema de incendio automático", dijo un ingeniero de la compañía a la BBC el año pasado . "Pero todos los clientes pidieron incorporar procedimientos de seguridad en ellos ... Les preocupaba que el arma pudiera estar equivocada".Otros expertos creen que la única forma de evitar los errores fatales de un arma autónoma, especialmente con la participación de civiles, es elaborar programas apropiados. "Si somos tan estúpidos que continuamos matándonos en el campo de batalla, y si se transfieren más y más poderes a las máquinas, al menos podemos asegurarnos de que están haciendo su trabajo de manera ética", dice Ronald Arkin, IT Especialista del Instituto de Tecnología de Georgia.Arkin confía en que las armas autónomas, como los soldados, deben seguir las reglas de la guerra y las leyes de la guerra, incluidas las leyes humanitarias internacionalesprotegiendo a los civiles y limitando el poder y los tipos de armas permitidas. Esto significa que debemos introducir ciertas cualidades morales en sus programas para que entiendan diferentes situaciones y distingan lo bueno de lo malo. Su software debe tener algún tipo de brújula ética.Durante los últimos diez años, Arkin ha estado trabajando en esa brújula. Usando herramientas de matemática y lógica del campo de la ética de la máquina, traduce las leyes de la guerra y las reglas de la guerra en variables y operaciones que son comprensibles para una computadora. Por ejemplo, una de las variables contiene el valor de confianza de la unidad de control ético de que el objetivo es un enemigo. Otro, booleano, significa si la fuerza asesina de las armas está permitida o prohibida. Al final, Arkin llegó a un cierto conjunto de algoritmos, y con la ayuda de simulaciones por computadora y escenarios de batalla simplificados, por ejemplo, un UAV atacando a un grupo de personas en un campo abierto, pudo probar su técnica.Arkin admite que el proyecto patrocinado por las Fuerzas Armadas de EE. UU. Aún no ha alcanzado la etapa del sistema terminado, y fue creado solo para demostrar su operatividad. Pero, en su opinión, los resultados del trabajo muestran que los robots son incluso mejores que los humanos pueden seguir las reglas de la guerra. Por ejemplo, los robots pueden realizar acciones que amenazan la vida con más moderación que los humanos, disparando solo en respuesta. O, a medida que se acercan los civiles, generalmente pueden cesar el fuego, incluso si ellos mismos son destruidos. Los robots no sufren de estrés, insatisfacción, ira, miedo, y todo esto puede dañar la adopción de las decisiones correctas en las personas. Por lo tanto, en teoría, los robots pueden superar a los soldados humanos , que a menudo, y a veces inevitablemente, cometen errores en el fragor de la batalla."Como resultado, podemos salvar vidas, especialmente las vidas de personas inocentes que están atrapadas en una batalla", dice Arkin. "Y si los robots hacen esto, la moral sugiere la necesidad de usarlos".Por supuesto, esta opinión no es generalmente aceptada. las armas autónomas insisten en que solo una prohibición preventiva tiene sentido, porque tales armas aparecen detrás de escena. "No existe un sistema de fuego que podamos señalar y decir: Sí, aquí está un robot asesino", dice Mary Wareham, Human Rights Watch Lobby Manager y Coor Coordinador de campaña para prohibir robots asesinos ( Campaña de la parada de Robots del asesino) - coaliciones de diversas comunidades humanitarias. - Estamos hablando de muchos sistemas de armas diferentes que funcionan de diferentes maneras. Pero nos preocupa una de sus características comunes: la falta de control humano sobre la función de selección y ataque de objetivos ".En la ONU, las discusiones sobre robots autónomos capaces de matar han estado ocurriendo durante cinco años, pero los países no han llegado a un acuerdo. En 2013, Christof Heyns, Relator Especial de la ONU sobre Derechos Humanos, escribió un informe influyente, en el que señaló que los países tienen una rara oportunidad de discutir los riesgos de las armas autónomas incluso antes de que se desarrollen. Ahora, después de haber participado en varias reuniones de la ONU, Hines dice que "si miras hacia atrás, estoy un poco alentado, pero si miras hacia adelante, parece que tendremos problemas si no comenzamos a avanzar más rápido".En diciembre, la Convención de las Naciones Unidas sobre armas clásicas organizará una conferencia que revisará el trabajo de cinco años, y el tema de los robots autónomos está en la agenda. Pero es poco probable que se acepte su prohibición. Tal decisión requerirá una decisión unánime de todos los países, y existe un desacuerdo fundamental entre ellos sobre qué hacer con la amplia gama de armas autónomas que aparecerán en el futuro.Como resultado, las disputas sobre robots asesinos se reducen a una discusión de personas. Las armas autónomas, al menos inicialmente, serán similares a cualquier tecnología: se pueden introducir con precisión y prudencia, o de manera caótica y catastrófica. Y la gente tendrá que aceptar las acusaciones. Por lo tanto, la pregunta "¿Son una buena idea los robots de combate autónomos?" No es el correcto. Es mejor hacer la pregunta: "¿Confiamos en nosotros mismos lo suficiente como para confiar en los robots para nuestras vidas?"

Transformers (2007). Una pandilla de robots alienígenas liderados por Megatron intenta aniquilar a todos loshumanos. El centro del nuevo grupo de investigación de seguridad estadounidense en Washington. "Pero es poco probable que los militares quieran hacer este tipo de arma autónoma". Según él, lo más probable es que los sistemas autónomos ataquen instalaciones militares como radares, tanques, barcos, submarinos y aviones.La tarea de identificar el objetivo, determinar si un objeto pertenece al enemigo, es una de las tareas más críticas para la IA. Los objetivos, aviones y misiles en movimiento tienen una trayectoria que se puede rastrear y tomar como base la decisión de intentar derribar un objeto. Así es como funciona el cañón Phalanx en los buques de guerra estadounidenses, y también lo hace el sistema de intercepción de misiles de la Cúpula de Hierro israelí. Pero cuando las personas son elegidas como el objetivo, esta identificación es complicada. Incluso en condiciones ideales, las tareas de reconocer objetos y entornos que las personas enfrentan todo el tiempo pueden ser demasiado complejas para los robots.Una computadora puede distinguir la figura de una persona, incluso si se mueve sigilosamente. Pero es difícil para el algoritmo entender con qué están ocupadas las personas y qué intenciones dan su lenguaje corporal y sus expresiones faciales. ¿Un hombre levanta una pistola o un rastrillo? ¿Está sosteniendo una bomba o un bebé?Scarre afirma que las armas robóticas, tratando de elegir un objetivo por su cuenta, salvan frente a las dificultades. En su opinión, el mejor enfoque, desde el punto de vista de la seguridad, la legalidad y la ética, sigue siendo el desarrollo de tácticas y tecnologías en las que las personas trabajen juntas con robots . "Los militares pueden invertir en robótica y automatización avanzadas, pero al mismo tiempo dejar a la persona en la cadena de control para tomar decisiones sobre objetivos, para estar seguros", dice. “Después de todo, las personas son más flexibles y se adaptan mejor a nuevas situaciones que quizás no programemos. Esto es especialmente importante en una guerra donde hay un adversario que intenta derrotar a sus sistemas, engañarlos y piratearlos ”.No es sorprendente que los surcoreanos de DoDAAM produzcan sus robots de vigilancia con severas restricciones de autonomía. Ahora sus robots no dispararán hasta que una persona confirme el objetivo y ordene "disparar". "La versión original era un sistema de incendio automático", dijo un ingeniero de la compañía a la BBC el año pasado . "Pero todos los clientes pidieron incorporar procedimientos de seguridad en ellos ... Les preocupaba que el arma pudiera estar equivocada".Otros expertos creen que la única forma de evitar los errores fatales de un arma autónoma, especialmente con la participación de civiles, es elaborar programas apropiados. "Si somos tan estúpidos que continuamos matándonos en el campo de batalla, y si se transfieren más y más poderes a las máquinas, al menos podemos asegurarnos de que están haciendo su trabajo de manera ética", dice Ronald Arkin, IT Especialista del Instituto de Tecnología de Georgia.Arkin confía en que las armas autónomas, como los soldados, deben seguir las reglas de la guerra y las leyes de la guerra, incluidas las leyes humanitarias internacionalesprotegiendo a los civiles y limitando el poder y los tipos de armas permitidas. Esto significa que debemos introducir ciertas cualidades morales en sus programas para que entiendan diferentes situaciones y distingan lo bueno de lo malo. Su software debe tener algún tipo de brújula ética.Durante los últimos diez años, Arkin ha estado trabajando en esa brújula. Usando herramientas de matemática y lógica del campo de la ética de la máquina, traduce las leyes de la guerra y las reglas de la guerra en variables y operaciones que son comprensibles para una computadora. Por ejemplo, una de las variables contiene el valor de confianza de la unidad de control ético de que el objetivo es un enemigo. Otro, booleano, significa si la fuerza asesina de las armas está permitida o prohibida. Al final, Arkin llegó a un cierto conjunto de algoritmos, y con la ayuda de simulaciones por computadora y escenarios de batalla simplificados, por ejemplo, un UAV atacando a un grupo de personas en un campo abierto, pudo probar su técnica.Arkin admite que el proyecto patrocinado por las Fuerzas Armadas de EE. UU. Aún no ha alcanzado la etapa del sistema terminado, y fue creado solo para demostrar su operatividad. Pero, en su opinión, los resultados del trabajo muestran que los robots son incluso mejores que los humanos pueden seguir las reglas de la guerra. Por ejemplo, los robots pueden realizar acciones que amenazan la vida con más moderación que los humanos, disparando solo en respuesta. O, a medida que se acercan los civiles, generalmente pueden cesar el fuego, incluso si ellos mismos son destruidos. Los robots no sufren de estrés, insatisfacción, ira, miedo, y todo esto puede dañar la adopción de las decisiones correctas en las personas. Por lo tanto, en teoría, los robots pueden superar a los soldados humanos , que a menudo, y a veces inevitablemente, cometen errores en el fragor de la batalla."Como resultado, podemos salvar vidas, especialmente las vidas de personas inocentes que están atrapadas en una batalla", dice Arkin. "Y si los robots hacen esto, la moral sugiere la necesidad de usarlos".Por supuesto, esta opinión no es generalmente aceptada. las armas autónomas insisten en que solo una prohibición preventiva tiene sentido, porque tales armas aparecen detrás de escena. "No existe un sistema de fuego que podamos señalar y decir: Sí, aquí está un robot asesino", dice Mary Wareham, Human Rights Watch Lobby Manager y Coor Coordinador de campaña para prohibir robots asesinos ( Campaña de la parada de Robots del asesino) - coaliciones de diversas comunidades humanitarias. - Estamos hablando de muchos sistemas de armas diferentes que funcionan de diferentes maneras. Pero nos preocupa una de sus características comunes: la falta de control humano sobre la función de selección y ataque de objetivos ".En la ONU, las discusiones sobre robots autónomos capaces de matar han estado ocurriendo durante cinco años, pero los países no han llegado a un acuerdo. En 2013, Christof Heyns, Relator Especial de la ONU sobre Derechos Humanos, escribió un informe influyente, en el que señaló que los países tienen una rara oportunidad de discutir los riesgos de las armas autónomas incluso antes de que se desarrollen. Ahora, después de haber participado en varias reuniones de la ONU, Hines dice que "si miras hacia atrás, estoy un poco alentado, pero si miras hacia adelante, parece que tendremos problemas si no comenzamos a avanzar más rápido".En diciembre, la Convención de las Naciones Unidas sobre armas clásicas organizará una conferencia que revisará el trabajo de cinco años, y el tema de los robots autónomos está en la agenda. Pero es poco probable que se acepte su prohibición. Tal decisión requerirá una decisión unánime de todos los países, y existe un desacuerdo fundamental entre ellos sobre qué hacer con la amplia gama de armas autónomas que aparecerán en el futuro.Como resultado, las disputas sobre robots asesinos se reducen a una discusión de personas. Las armas autónomas, al menos inicialmente, serán similares a cualquier tecnología: se pueden introducir con precisión y prudencia, o de manera caótica y catastrófica. Y la gente tendrá que aceptar las acusaciones. Por lo tanto, la pregunta "¿Son una buena idea los robots de combate autónomos?" No es el correcto. Es mejor hacer la pregunta: "¿Confiamos en nosotros mismos lo suficiente como para confiar en los robots para nuestras vidas?"Source: https://habr.com/ru/post/es395139/

All Articles