La IA genera sonidos realistas en el metraje

Los empleados del Laboratorio del Instituto de Ciencias de la Computación e Inteligencia Artificial de Massachusetts (CSAIL) y Google Research han diseñado una red neuronal que ha aprendido a sonar secuencias de video arbitrarias , generando sonidos realistas y prediciendo las propiedades de los objetos. El programa analiza el video, reconoce objetos, su movimiento y tipo de contacto: golpes, deslizamiento, fricción, etc. En base a esta información, genera un sonido que una persona en el 40% de los casos considera más realista que el real.Los científicos sugieren que este desarrollo será ampliamente utilizado en el cine y la televisión para generar efectos de sonido a partir de una secuencia de video sin sonido. Además, puede ser útil para entrenar robots para comprender mejor las propiedades del mundo.Los sonidos ambientales dicen mucho sobre las propiedades de los objetos circundantes, por lo que en el proceso de autoaprendizaje, los futuros robots pueden actuar como niños: tocar objetos, probarlos con el tacto, meter un palo en ellos, intentar moverse, elevar. En este caso, el robot recibe retroalimentación, reconociendo las propiedades del objeto: su peso, elasticidad, etc.El sonido hecho por un objeto en contacto también lleva información importante sobre las propiedades del objeto. "Cuando deslizas tu dedo por una copa de vino, el sonido que haces corresponde a la cantidad de líquido vertido en la copa", explica el estudiante graduado Andrew Owens , autor principal de un artículo científico publicado, que aún no está listo para una revista científica, pero solo publicadodisponible públicamente en arXiv.org. La presentación del trabajo científico tendrá lugar en la conferencia anual sobre visión artificial y reconocimiento de patrones (CVPR) en Las Vegas este mes.Los científicos han seleccionado 977 videos en los que las personas realizan acciones con objetos circundantes, que consisten en varios materiales: rascar, golpearlos con un palo, etc. En total, los videos contenían 46.577 acciones. Los estudiantes de CSAIL marcaron manualmente todas las acciones, indicando el tipo de material, el lugar de contacto, el tipo de acción (choque / rascado / otro) y el tipo de reacción del material u objeto (deformación, forma estática, movimiento duro, etc.). Los videos con sonido se usaron para entrenar la red neuronal, y las etiquetas colocadas manualmente se usaron solo para analizar el resultado del entrenamiento de la red neuronal, pero no para entrenarla..

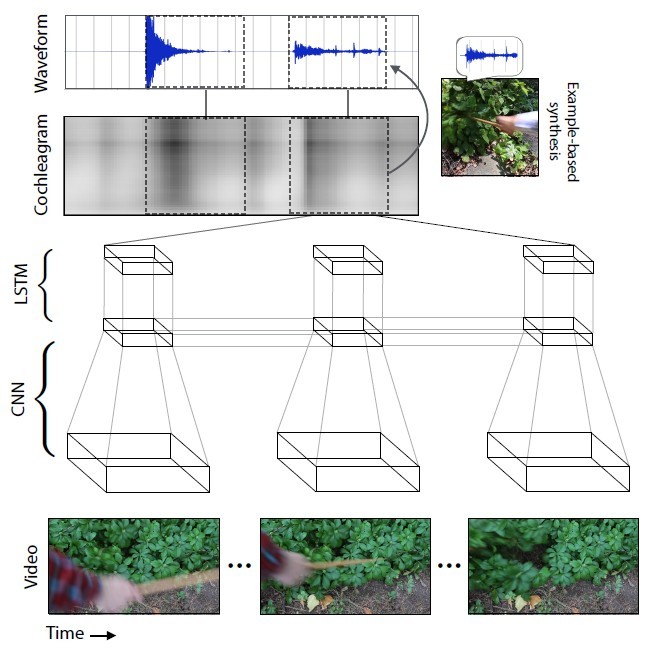

Los empleados del Laboratorio del Instituto de Ciencias de la Computación e Inteligencia Artificial de Massachusetts (CSAIL) y Google Research han diseñado una red neuronal que ha aprendido a sonar secuencias de video arbitrarias , generando sonidos realistas y prediciendo las propiedades de los objetos. El programa analiza el video, reconoce objetos, su movimiento y tipo de contacto: golpes, deslizamiento, fricción, etc. En base a esta información, genera un sonido que una persona en el 40% de los casos considera más realista que el real.Los científicos sugieren que este desarrollo será ampliamente utilizado en el cine y la televisión para generar efectos de sonido a partir de una secuencia de video sin sonido. Además, puede ser útil para entrenar robots para comprender mejor las propiedades del mundo.Los sonidos ambientales dicen mucho sobre las propiedades de los objetos circundantes, por lo que en el proceso de autoaprendizaje, los futuros robots pueden actuar como niños: tocar objetos, probarlos con el tacto, meter un palo en ellos, intentar moverse, elevar. En este caso, el robot recibe retroalimentación, reconociendo las propiedades del objeto: su peso, elasticidad, etc.El sonido hecho por un objeto en contacto también lleva información importante sobre las propiedades del objeto. "Cuando deslizas tu dedo por una copa de vino, el sonido que haces corresponde a la cantidad de líquido vertido en la copa", explica el estudiante graduado Andrew Owens , autor principal de un artículo científico publicado, que aún no está listo para una revista científica, pero solo publicadodisponible públicamente en arXiv.org. La presentación del trabajo científico tendrá lugar en la conferencia anual sobre visión artificial y reconocimiento de patrones (CVPR) en Las Vegas este mes.Los científicos han seleccionado 977 videos en los que las personas realizan acciones con objetos circundantes, que consisten en varios materiales: rascar, golpearlos con un palo, etc. En total, los videos contenían 46.577 acciones. Los estudiantes de CSAIL marcaron manualmente todas las acciones, indicando el tipo de material, el lugar de contacto, el tipo de acción (choque / rascado / otro) y el tipo de reacción del material u objeto (deformación, forma estática, movimiento duro, etc.). Los videos con sonido se usaron para entrenar la red neuronal, y las etiquetas colocadas manualmente se usaron solo para analizar el resultado del entrenamiento de la red neuronal, pero no para entrenarla.. La red neuronal analizó las características del sonido que corresponden a cada tipo de interacción con los objetos: volumen, tono y otras características. Durante el entrenamiento, el sistema estudió el video cuadro por cuadro, analizó el sonido en este cuadro y encontró una coincidencia con el sonido más similar en la base de datos ya acumulada. Lo más importante era enseñar a la red neuronal a estirar el sonido en cuadros.

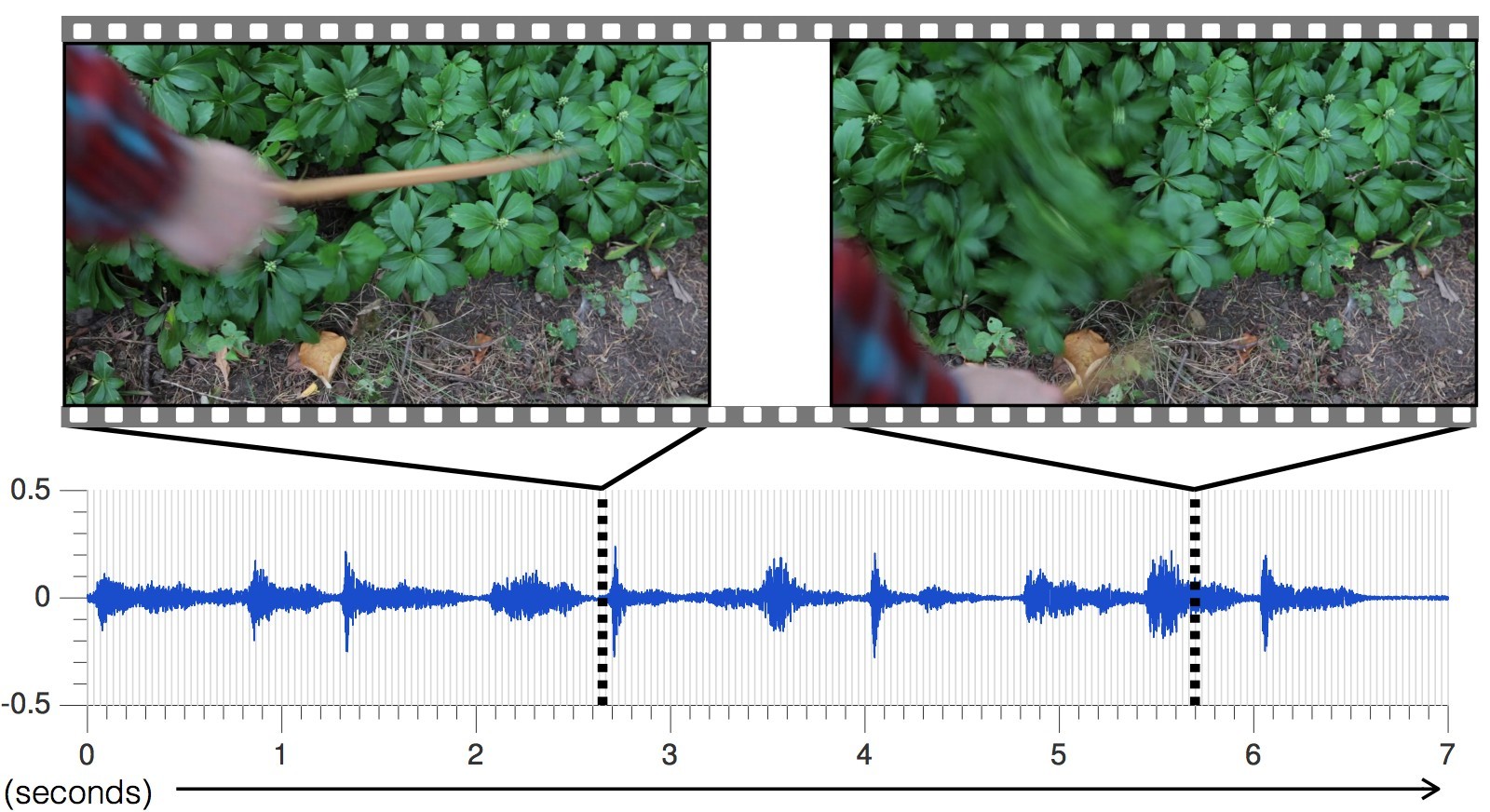

La red neuronal analizó las características del sonido que corresponden a cada tipo de interacción con los objetos: volumen, tono y otras características. Durante el entrenamiento, el sistema estudió el video cuadro por cuadro, analizó el sonido en este cuadro y encontró una coincidencia con el sonido más similar en la base de datos ya acumulada. Lo más importante era enseñar a la red neuronal a estirar el sonido en cuadros. Con cada video nuevo, la precisión de la predicción de los sonidos aumentaba.El sonido generado por la red neuronal para diferentes escenas, en comparación con el real.

Con cada video nuevo, la precisión de la predicción de los sonidos aumentaba.El sonido generado por la red neuronal para diferentes escenas, en comparación con el real. Como resultado, la red neuronal aprendió a predecir con precisión los sonidos más diversos con todos los matices: desde golpes de piedras hasta el roce de la hiedra."Los enfoques actuales de los investigadores en el campo de la inteligencia artificial se centran en solo uno de los cinco sentidos: los especialistas en visión artificial estudian imágenes visuales, los especialistas en reconocimiento de voz estudian el sonido, etc.", dice Abhinav Gupta, profesor asistente de robótica en la Universidad Carnegie. Mellon "Este estudio es un paso en la dirección correcta que imita el proceso de aprendizaje de la misma manera que lo hace la gente, es decir, integrando el sonido y la visión".Para probar la efectividad de la IA, los científicos realizaron un estudio en línea sobre Amazon Mechanical Turk, a los participantes se les pidió que compararan dos opciones para el sonido de un video en particular y determinaran qué sonido es real y cuál no.Como resultado del experimento, AI logró engañar a las personas en el 40% de los casos . Sin embargo, según algunos comentaristas en los foros , no es tan difícil engañar a una persona, porque la gente moderna obtiene una parte importante del conocimiento sobre la imagen sonora del mundo a partir de películas y juegos de computadora. El rango de sonido para películas y juegos está compuesto por especialistas que utilizan colecciones de muestras estándar. Es decir, constantemente escuchamos sobre lo mismo.En un experimento en línea, en dos de cada cinco casos, la gente pensó que el sonido generado por el programa era más realista que el sonido real del video. Este es un mejor resultado que otros métodos para sintetizar sonidos realistas.

Como resultado, la red neuronal aprendió a predecir con precisión los sonidos más diversos con todos los matices: desde golpes de piedras hasta el roce de la hiedra."Los enfoques actuales de los investigadores en el campo de la inteligencia artificial se centran en solo uno de los cinco sentidos: los especialistas en visión artificial estudian imágenes visuales, los especialistas en reconocimiento de voz estudian el sonido, etc.", dice Abhinav Gupta, profesor asistente de robótica en la Universidad Carnegie. Mellon "Este estudio es un paso en la dirección correcta que imita el proceso de aprendizaje de la misma manera que lo hace la gente, es decir, integrando el sonido y la visión".Para probar la efectividad de la IA, los científicos realizaron un estudio en línea sobre Amazon Mechanical Turk, a los participantes se les pidió que compararan dos opciones para el sonido de un video en particular y determinaran qué sonido es real y cuál no.Como resultado del experimento, AI logró engañar a las personas en el 40% de los casos . Sin embargo, según algunos comentaristas en los foros , no es tan difícil engañar a una persona, porque la gente moderna obtiene una parte importante del conocimiento sobre la imagen sonora del mundo a partir de películas y juegos de computadora. El rango de sonido para películas y juegos está compuesto por especialistas que utilizan colecciones de muestras estándar. Es decir, constantemente escuchamos sobre lo mismo.En un experimento en línea, en dos de cada cinco casos, la gente pensó que el sonido generado por el programa era más realista que el sonido real del video. Este es un mejor resultado que otros métodos para sintetizar sonidos realistas. En la mayoría de los casos, AI engañó a los participantes en el experimento con los sonidos de materiales como hojas y tierra, porque estos sonidos son más complejos y no tan "limpios" como los hechos, por ejemplo, con madera o metal.Volviendo al entrenamiento de la red neuronal, como subproducto del estudio, se descubrió que el algoritmo puede distinguir entre materiales blandos y duros con una precisión del 67%, simplemente prediciendo su sonido. En otras palabras, el robot puede mirar el camino de asfalto y la hierba frente a él, y concluir que el asfalto es duro y el césped es blando. El robot sabrá esto por el sonido predicho, sin siquiera pisar el asfalto y la hierba. Luego puede avanzar donde quiera, y probar sus sentimientos al verificar con la base de datos y, si es necesario, hacer correcciones en la biblioteca de muestras de sonido. De esta manera, en el futuro, los robots estudiarán y dominarán el mundo que los rodea.Sin embargo, los investigadores aún tienen mucho trabajo por hacer para mejorar la tecnología. La red neuronal ahora se confunde a menudo con el movimiento rápido de objetos, sin caer en el momento exacto de contacto. Además, la IA solo puede generar sonido basado en el contacto directo que se graba en video, y hay tantos sonidos a nuestro alrededor que no se basan en el contacto visual: el ruido de los árboles, el zumbido de un ventilador en una computadora. "Lo que sería realmente genial es simular de alguna manera un sonido que no esté tan relacionado con el metraje", dice Andrew Owens.

En la mayoría de los casos, AI engañó a los participantes en el experimento con los sonidos de materiales como hojas y tierra, porque estos sonidos son más complejos y no tan "limpios" como los hechos, por ejemplo, con madera o metal.Volviendo al entrenamiento de la red neuronal, como subproducto del estudio, se descubrió que el algoritmo puede distinguir entre materiales blandos y duros con una precisión del 67%, simplemente prediciendo su sonido. En otras palabras, el robot puede mirar el camino de asfalto y la hierba frente a él, y concluir que el asfalto es duro y el césped es blando. El robot sabrá esto por el sonido predicho, sin siquiera pisar el asfalto y la hierba. Luego puede avanzar donde quiera, y probar sus sentimientos al verificar con la base de datos y, si es necesario, hacer correcciones en la biblioteca de muestras de sonido. De esta manera, en el futuro, los robots estudiarán y dominarán el mundo que los rodea.Sin embargo, los investigadores aún tienen mucho trabajo por hacer para mejorar la tecnología. La red neuronal ahora se confunde a menudo con el movimiento rápido de objetos, sin caer en el momento exacto de contacto. Además, la IA solo puede generar sonido basado en el contacto directo que se graba en video, y hay tantos sonidos a nuestro alrededor que no se basan en el contacto visual: el ruido de los árboles, el zumbido de un ventilador en una computadora. "Lo que sería realmente genial es simular de alguna manera un sonido que no esté tan relacionado con el metraje", dice Andrew Owens.Source: https://habr.com/ru/post/es395243/

All Articles