Expertos de China y EE. UU. Aprendieron a manipular el piloto automático de Tesla

El funcionamiento del piloto automático y los sensores se puede interrumpir intencionalmente con la ayuda de equipos especiales.

En los Estados Unidos, el accidente fatal del Tesla Model S todavía se está investigando en mayo de este año. Entonces el auto eléctrico que iba con exceso de velocidad se estrelló contra un camión. Ni el conductor ni el piloto automático vieron un obstáculo contra un cielo brillante. Los expertos en seguridad de la información tienen una pregunta: ¿qué sucede si intentamos reproducir condiciones similares artificialmente? ¿Será posible engañar a los sensores de la máquina y al sistema informático mismo?El equipo combinado de investigadores de la Universidad de Carolina del Sur (EE. UU.), La Universidad de Zhejiang (China) y la empresa china Qihoo 360, que trabajan en el campo de la seguridad informática, pudieron aprender a manipular el piloto automático Tesla Model S. Para esto, los investigadores trabajaron con equipos de varios tipos: emitiendo ondas de radio, señales de sonido y la luz En algunos casos, el piloto automático Tesla comenzó a "creer" que no había obstáculos por delante, aunque sí, y viceversa, que había un objeto por delante que podía encontrarse, aunque no había nada delante del automóvil.Al final resultó que, para engañar al sistema de control de computadora Tesla Model S, debe hacer un esfuerzo significativo. El objetivo del equipo de científicos era demostrar que las condiciones que llevaron al accidente en mayo pueden reproducirse intencionalmente. “El peor de los casos para un automóvil que conduce un piloto automático es un radar que no funciona. En este caso, la máquina no podrá determinar la presencia de obstáculos por delante ", dice uno de los representantes del equipo de científicos que realizó la investigación.El piloto automático, impulsado por vehículos eléctricos Tesla, detecta obstáculos utilizando tres métodos principales: radar, sensores ultrasónicos y cámaras. Los investigadores atacaron los tres tipos de sistemas. Como resultado, fue posible determinar qué radar exactamente se adapta mejor al "engaño". Para distorsionar su testimonio, los investigadores utilizaron dos sistemas. El primero es un generador de señal de Keysight Technologies de $ 90,000. El segundo es un multiplicador de frecuencia VDI, cuyo precio es aún más alto. Ambos sistemas se utilizaron para bloquear la señal emitida por el sistema de radar del vehículo eléctrico. Cuando los expertos bloquearon la señal, el auto frente al Tesla Model S desapareció para el piloto automático y ya no se mostró.Tan pronto como se activó el "antirradar", el obstáculo delantero desapareció. Según los autores de este trabajo, este método puede ser utilizado en la carretera por intrusos que, por una razón u otra, deseen organizar un accidente que involucre un automóvil eléctrico Tesla. Los científicos dicen que para un ataque exitoso al sistema de radar Tesla, es necesario instalar correctamente un silenciador, lo que no es tan fácil de hacer en la carretera.Un ataque más simple y económico es el sistema de ultrasonido, con la ayuda de los cuales los especialistas decidieron actuar sobre los sensores ultrasónicos de la máquina. Por lo general, se usan para estacionar automáticamente y "llamar" al conductor al automóvil. En este modo, ella puede salir del estacionamiento independientemente y acercarse al dueño. Para engañar a los sensores ultrasónicos, los investigadores utilizaron un transductor ultrasónico basado en Arduino y un generador de señales para crear señales eléctricas con características específicas. Tal sistema cuesta significativamente menos, solo $ 40. En este caso, fue posible engañar al sistema de estacionamiento automático, y el automóvil no quería estacionar, considerando que había un obstáculo en el frente. Usando el mismo sistema, fue posible "convencer" al sistema de estacionamiento de que no había ningún obstáculo al frente, aunque lo era.

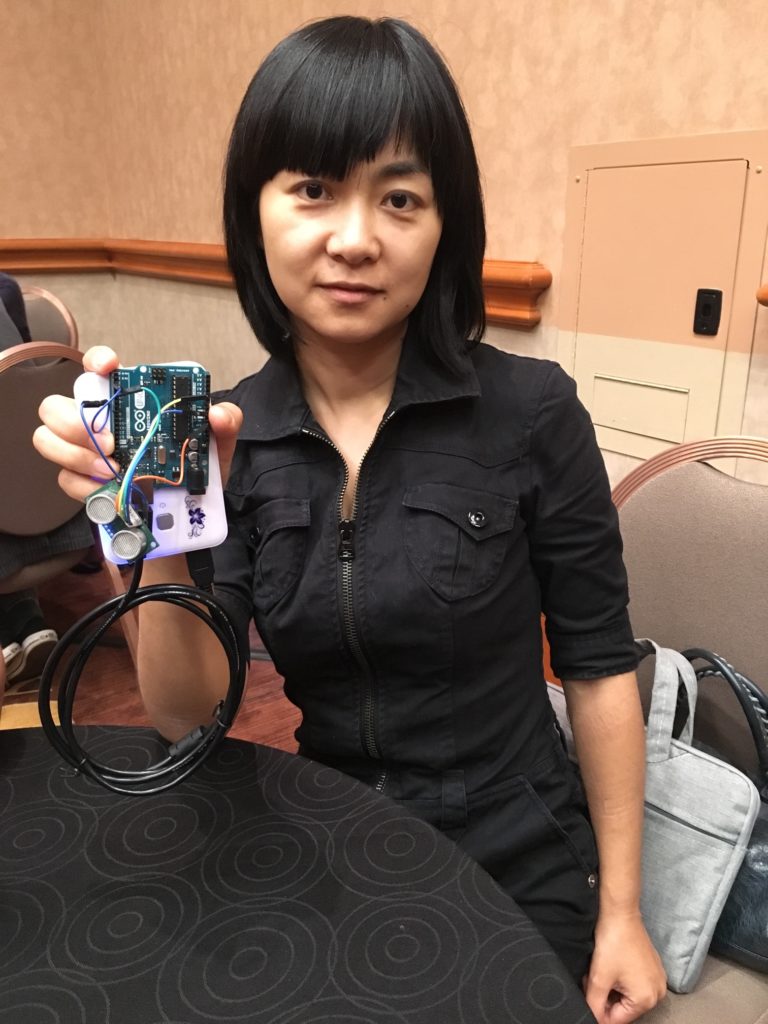

En los Estados Unidos, el accidente fatal del Tesla Model S todavía se está investigando en mayo de este año. Entonces el auto eléctrico que iba con exceso de velocidad se estrelló contra un camión. Ni el conductor ni el piloto automático vieron un obstáculo contra un cielo brillante. Los expertos en seguridad de la información tienen una pregunta: ¿qué sucede si intentamos reproducir condiciones similares artificialmente? ¿Será posible engañar a los sensores de la máquina y al sistema informático mismo?El equipo combinado de investigadores de la Universidad de Carolina del Sur (EE. UU.), La Universidad de Zhejiang (China) y la empresa china Qihoo 360, que trabajan en el campo de la seguridad informática, pudieron aprender a manipular el piloto automático Tesla Model S. Para esto, los investigadores trabajaron con equipos de varios tipos: emitiendo ondas de radio, señales de sonido y la luz En algunos casos, el piloto automático Tesla comenzó a "creer" que no había obstáculos por delante, aunque sí, y viceversa, que había un objeto por delante que podía encontrarse, aunque no había nada delante del automóvil.Al final resultó que, para engañar al sistema de control de computadora Tesla Model S, debe hacer un esfuerzo significativo. El objetivo del equipo de científicos era demostrar que las condiciones que llevaron al accidente en mayo pueden reproducirse intencionalmente. “El peor de los casos para un automóvil que conduce un piloto automático es un radar que no funciona. En este caso, la máquina no podrá determinar la presencia de obstáculos por delante ", dice uno de los representantes del equipo de científicos que realizó la investigación.El piloto automático, impulsado por vehículos eléctricos Tesla, detecta obstáculos utilizando tres métodos principales: radar, sensores ultrasónicos y cámaras. Los investigadores atacaron los tres tipos de sistemas. Como resultado, fue posible determinar qué radar exactamente se adapta mejor al "engaño". Para distorsionar su testimonio, los investigadores utilizaron dos sistemas. El primero es un generador de señal de Keysight Technologies de $ 90,000. El segundo es un multiplicador de frecuencia VDI, cuyo precio es aún más alto. Ambos sistemas se utilizaron para bloquear la señal emitida por el sistema de radar del vehículo eléctrico. Cuando los expertos bloquearon la señal, el auto frente al Tesla Model S desapareció para el piloto automático y ya no se mostró.Tan pronto como se activó el "antirradar", el obstáculo delantero desapareció. Según los autores de este trabajo, este método puede ser utilizado en la carretera por intrusos que, por una razón u otra, deseen organizar un accidente que involucre un automóvil eléctrico Tesla. Los científicos dicen que para un ataque exitoso al sistema de radar Tesla, es necesario instalar correctamente un silenciador, lo que no es tan fácil de hacer en la carretera.Un ataque más simple y económico es el sistema de ultrasonido, con la ayuda de los cuales los especialistas decidieron actuar sobre los sensores ultrasónicos de la máquina. Por lo general, se usan para estacionar automáticamente y "llamar" al conductor al automóvil. En este modo, ella puede salir del estacionamiento independientemente y acercarse al dueño. Para engañar a los sensores ultrasónicos, los investigadores utilizaron un transductor ultrasónico basado en Arduino y un generador de señales para crear señales eléctricas con características específicas. Tal sistema cuesta significativamente menos, solo $ 40. En este caso, fue posible engañar al sistema de estacionamiento automático, y el automóvil no quería estacionar, considerando que había un obstáculo en el frente. Usando el mismo sistema, fue posible "convencer" al sistema de estacionamiento de que no había ningún obstáculo al frente, aunque lo era. El profesor de ciencias de la computación Wenyuan Xu demuestra un dispositivo ultrasónico basado en Arduino Uno (Fuente: Andy Greenberg).La forma más fácil de influir en el sistema de control de la computadora de Tesla es aplicar una espuma especial que absorbe el sonido a los sensores.Los científicos también trataron de influir en las cámaras, pero este sistema fue el más confiable. Lo único que fue posible hacer fue cegar el sistema con un haz de LED dirigido o un rayo láser. Pero los desarrolladores de Tesla proporcionaron esa opción, y el piloto automático simplemente se apagó, pasando el control al controlador. Como descubrieron los expertos, un piloto automático puede ser cegado por la luz solar brillante bajo ciertas circunstancias. Quizás esta es precisamente la situación que surgió en mayo.El manual del automóvil eléctrico dice que el piloto automático puede no detectar ciertos objetos. También se dice que la tecnología "fue creada para la conveniencia al conducir, pero no es un sistema para evitar obstáculos o prevenir colisiones".Según algunos especialistas externos que estudiaron los resultados del trabajo descrito anteriormente, la siguiente etapa del estudio debería ser la situación en el camino, y no en condiciones estacionarias. Para confirmar la efectividad de los métodos para influir en el piloto automático y los sensores de un vehículo eléctrico, es necesario intentar hacer lo mismo en el campo. “Necesitan hacer un poco más para descubrir si el piloto automático realmente permite que el automóvil choque con un obstáculo. Puedes decirme hasta este punto si el piloto automático funciona o no ", dice Jonathan Petit, portavoz de la Universidad Jonathan Petit.Los autores del estudio creen que el piloto automático y los sensores son susceptibles a las influencias externas y son vulnerables, aunque el uso de esta vulnerabilidad no es tan simple. Según los científicos, Tesla debería proteger sus vehículos eléctricos de intrusos que podrían intentar interferir con el funcionamiento normal del sistema informático de la máquina. "Si el nivel de ruido es muy alto, o se detectan algunas desviaciones, el radar debe notificar al sistema de control de una posible falla", dice uno de los investigadores.Hasta ahora, los científicos reconocen que los métodos utilizados por ellos no son muy prácticos: son difíciles y costosos de usar. Pero con el tiempo, el equipo se vuelve más barato y los métodos de trabajo de los intrusos son complicados y mejorados. Y después de un tiempo puede resultar que alguien aprendió a engañar a un sistema informático de Tesla sin usar sistemas que cuestan $ 100,000.

El profesor de ciencias de la computación Wenyuan Xu demuestra un dispositivo ultrasónico basado en Arduino Uno (Fuente: Andy Greenberg).La forma más fácil de influir en el sistema de control de la computadora de Tesla es aplicar una espuma especial que absorbe el sonido a los sensores.Los científicos también trataron de influir en las cámaras, pero este sistema fue el más confiable. Lo único que fue posible hacer fue cegar el sistema con un haz de LED dirigido o un rayo láser. Pero los desarrolladores de Tesla proporcionaron esa opción, y el piloto automático simplemente se apagó, pasando el control al controlador. Como descubrieron los expertos, un piloto automático puede ser cegado por la luz solar brillante bajo ciertas circunstancias. Quizás esta es precisamente la situación que surgió en mayo.El manual del automóvil eléctrico dice que el piloto automático puede no detectar ciertos objetos. También se dice que la tecnología "fue creada para la conveniencia al conducir, pero no es un sistema para evitar obstáculos o prevenir colisiones".Según algunos especialistas externos que estudiaron los resultados del trabajo descrito anteriormente, la siguiente etapa del estudio debería ser la situación en el camino, y no en condiciones estacionarias. Para confirmar la efectividad de los métodos para influir en el piloto automático y los sensores de un vehículo eléctrico, es necesario intentar hacer lo mismo en el campo. “Necesitan hacer un poco más para descubrir si el piloto automático realmente permite que el automóvil choque con un obstáculo. Puedes decirme hasta este punto si el piloto automático funciona o no ", dice Jonathan Petit, portavoz de la Universidad Jonathan Petit.Los autores del estudio creen que el piloto automático y los sensores son susceptibles a las influencias externas y son vulnerables, aunque el uso de esta vulnerabilidad no es tan simple. Según los científicos, Tesla debería proteger sus vehículos eléctricos de intrusos que podrían intentar interferir con el funcionamiento normal del sistema informático de la máquina. "Si el nivel de ruido es muy alto, o se detectan algunas desviaciones, el radar debe notificar al sistema de control de una posible falla", dice uno de los investigadores.Hasta ahora, los científicos reconocen que los métodos utilizados por ellos no son muy prácticos: son difíciles y costosos de usar. Pero con el tiempo, el equipo se vuelve más barato y los métodos de trabajo de los intrusos son complicados y mejorados. Y después de un tiempo puede resultar que alguien aprendió a engañar a un sistema informático de Tesla sin usar sistemas que cuestan $ 100,000.Source: https://habr.com/ru/post/es396721/

All Articles