La inteligencia artificial tiene problemas de lenguaje.

Las máquinas conscientes del lenguaje serían muy útiles. Pero no sabemos cómo construirlos.

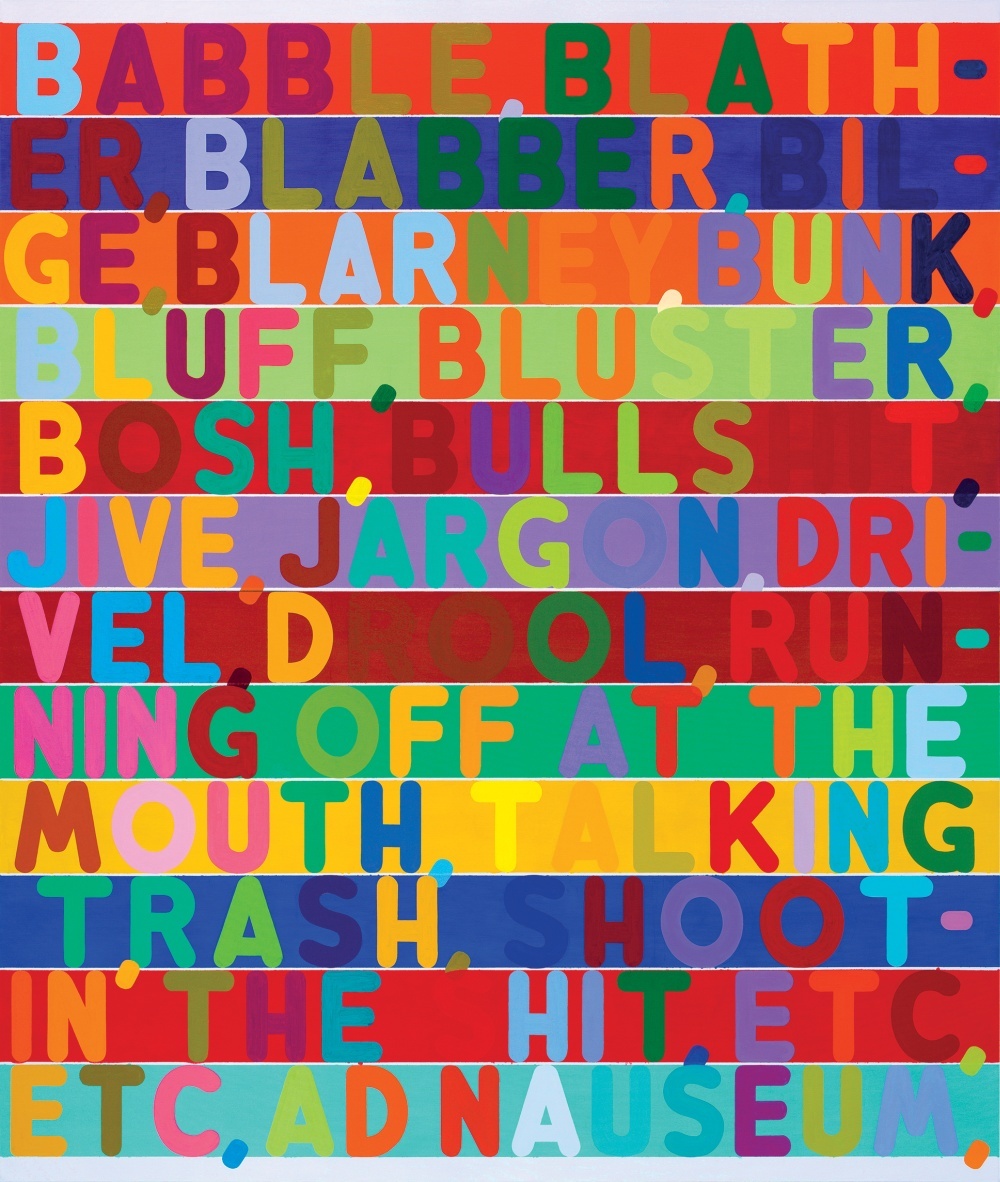

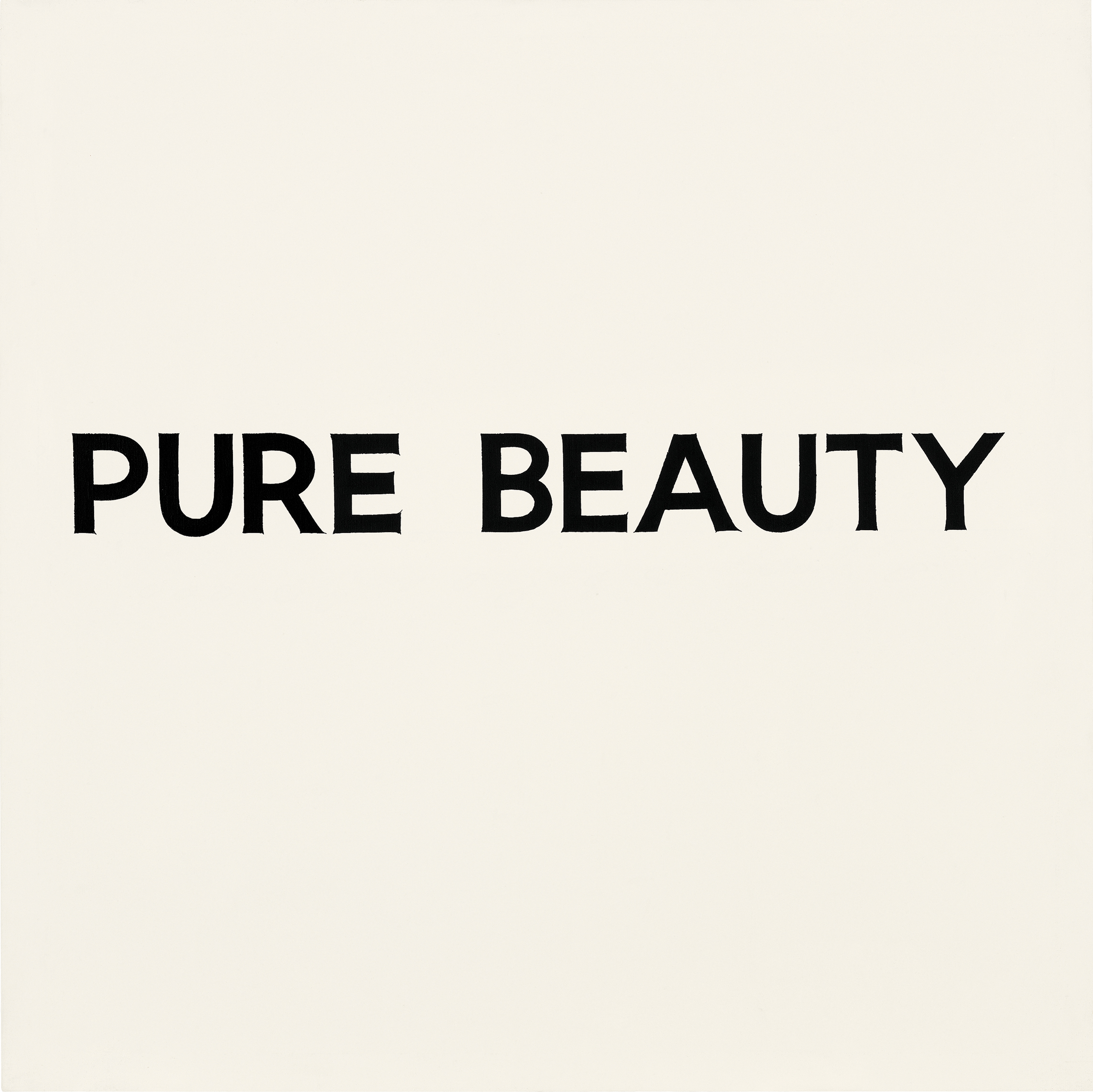

Acerca de las ilustraciones para el artículo: una de las dificultades para entender un idioma por computadora es el hecho de que a menudo el significado de las palabras depende del contexto e incluso de la aparición de letras y palabras. En las imágenes presentadas en el artículo, varios artistas demuestran el uso de varias pistas visuales que transmiten una carga semántica que va más allá de los bordes de las letras.En medio de un tenso juego de go, que se desarrollaba en Seúl, Corea del Sur, entre Lee Sedol, uno de los mejores jugadores de todos los tiempos, y AlphaGo, una IA creada por Google, el programa hizo un movimiento misterioso, demostrando su extraña superioridad sobre un rival humano.En la jugada 37, AlphaGo decidió poner la piedra negra en una posición extraña a primera vista. Todo fue hasta el punto de que tuvo que perder una parte importante del territorio: un error de principiante en un juego basado en el control del espacio en el tablero. Dos comentaristas de televisión estaban discutiendo si entendieron correctamente el curso de la computadora y si se rompió. Resultó que, a pesar de la contradicción del sentido común, el movimiento número 37 permitió a AlphaGo construir una estructura insuperable en el centro del tablero. El programa de Google esencialmente ganó el juego con un movimiento en el que nadie hubiera pensado.Victoria de AlphaGoTambién es impresionante porque el antiguo juego de go a menudo se veía como una prueba de inteligencia intuitiva. Sus reglas son simples. Dos jugadores se turnan para colocar piedras negras o blancas en la intersección de las líneas horizontales y verticales del tablero, tratando de rodear las piedras del oponente y eliminarlas del tablero. Pero jugarlo bien es increíblemente difícil.Si los jugadores de ajedrez pueden calcular el juego varios pasos por delante, rápidamente se convierte en una tarea inimaginablemente difícil, además, no hay juegos clásicos en el juego. Tampoco hay una manera fácil de medir los beneficios, e incluso para un jugador experimentado puede ser difícil explicar por qué hizo tal movimiento. Debido a esto, es imposible escribir un conjunto simple de reglas que sería seguido por un programa que se reproduce a nivel experto.AlphaGo no fue enseñado a jugar go. El programa analizó cientos de miles de juegos y jugó millones de partidos consigo mismo. Entre las diversas técnicas de inteligencia artificial, utilizó el método cada vez más popular conocido como aprendizaje profundo. Se basa en cálculos matemáticos, cuyo método se inspira en cómo se activan las capas interconectadas de neuronas en el cerebro al procesar nueva información. El programa se enseñó durante muchas horas de práctica, gradualmente perfeccionando un sentido intuitivo de estrategia. Y el hecho de que ella fue capaz de vencer a uno de los mejores jugadores del mundo es un nuevo hito en inteligencia artificial e inteligencia artificial.

Acerca de las ilustraciones para el artículo: una de las dificultades para entender un idioma por computadora es el hecho de que a menudo el significado de las palabras depende del contexto e incluso de la aparición de letras y palabras. En las imágenes presentadas en el artículo, varios artistas demuestran el uso de varias pistas visuales que transmiten una carga semántica que va más allá de los bordes de las letras.En medio de un tenso juego de go, que se desarrollaba en Seúl, Corea del Sur, entre Lee Sedol, uno de los mejores jugadores de todos los tiempos, y AlphaGo, una IA creada por Google, el programa hizo un movimiento misterioso, demostrando su extraña superioridad sobre un rival humano.En la jugada 37, AlphaGo decidió poner la piedra negra en una posición extraña a primera vista. Todo fue hasta el punto de que tuvo que perder una parte importante del territorio: un error de principiante en un juego basado en el control del espacio en el tablero. Dos comentaristas de televisión estaban discutiendo si entendieron correctamente el curso de la computadora y si se rompió. Resultó que, a pesar de la contradicción del sentido común, el movimiento número 37 permitió a AlphaGo construir una estructura insuperable en el centro del tablero. El programa de Google esencialmente ganó el juego con un movimiento en el que nadie hubiera pensado.Victoria de AlphaGoTambién es impresionante porque el antiguo juego de go a menudo se veía como una prueba de inteligencia intuitiva. Sus reglas son simples. Dos jugadores se turnan para colocar piedras negras o blancas en la intersección de las líneas horizontales y verticales del tablero, tratando de rodear las piedras del oponente y eliminarlas del tablero. Pero jugarlo bien es increíblemente difícil.Si los jugadores de ajedrez pueden calcular el juego varios pasos por delante, rápidamente se convierte en una tarea inimaginablemente difícil, además, no hay juegos clásicos en el juego. Tampoco hay una manera fácil de medir los beneficios, e incluso para un jugador experimentado puede ser difícil explicar por qué hizo tal movimiento. Debido a esto, es imposible escribir un conjunto simple de reglas que sería seguido por un programa que se reproduce a nivel experto.AlphaGo no fue enseñado a jugar go. El programa analizó cientos de miles de juegos y jugó millones de partidos consigo mismo. Entre las diversas técnicas de inteligencia artificial, utilizó el método cada vez más popular conocido como aprendizaje profundo. Se basa en cálculos matemáticos, cuyo método se inspira en cómo se activan las capas interconectadas de neuronas en el cerebro al procesar nueva información. El programa se enseñó durante muchas horas de práctica, gradualmente perfeccionando un sentido intuitivo de estrategia. Y el hecho de que ella fue capaz de vencer a uno de los mejores jugadores del mundo es un nuevo hito en inteligencia artificial e inteligencia artificial. Unas pocas horas después de la jugada 37, AlphaGo ganó el juego y comenzó a liderar 2-0 en un partido de cinco juegos. Después de eso, Sedol se paró frente a una multitud de periodistas y fotógrafos y se disculpó cortésmente por decepcionar a la humanidad. "Estaba sin palabras", dijo, parpadeando bajo las ráfagas de destello.El sorprendente éxito de AlphaGo muestra cuánto progreso se ha logrado en IA en los últimos años, después de décadas de desesperación y desafíos descritos como "el invierno de la IA". El aprendizaje profundo permite a las máquinas aprender por sí mismas cómo realizar tareas complejas, cuya solución hace unos años no se podía imaginar sin la participación de la inteligencia humana. Robomobiles ya se avecinan en el horizonte. En un futuro cercano, los sistemas de aprendizaje profundo ayudarán a diagnosticar enfermedades y proporcionarán recomendaciones de tratamiento.Pero a pesar de estos impresionantes avances, una de las principales posibilidades no está dada por AI: el lenguaje. Los sistemas como Siri e IBM Watson pueden reconocer comandos verbales y escritos simples y responder preguntas simples, pero no pueden mantener una conversación o realmente entender las palabras utilizadas. Para que la IA cambie nuestro mundo, esto debe cambiar.Aunque AlphaGo no habla, tiene tecnología que puede proporcionar una mejor comprensión del idioma. En Google, Facebook, Amazon y los laboratorios de ciencias, los investigadores están tratando de resolver este obstinado problema utilizando las mismas herramientas de IA, incluido el aprendizaje profundo, que son responsables del éxito de AlphaGo y del resurgimiento de la IA. Su éxito determinará el alcance y las propiedades de lo que ya está comenzando a convertirse en una revolución de IA. Esto determinará nuestro futuro: tendremos máquinas con las que sea fácil comunicarse y los sistemas con IA seguirán siendo misteriosas cajas negras, aunque más autónomas. "No hay forma de crear un sistema humanoide con IA a menos que esté basado en el lenguaje", dijo Josh Tenenbaum, profesor de ciencias cognitivas y computación en el MIT. "Esta es una de las cosas más obvias que definen la inteligencia humana".Tal vez las mismas tecnologías que permitieron a AlphaGo conquistar ir permitieran a las computadoras dominar el idioma, o de lo contrario se necesitará algo más. Pero sin comprender el lenguaje, el impacto de la IA será diferente. Por supuesto, todavía tendremos programas poco realistas e inteligentes como AlphaGo. Pero nuestra relación con la IA no será tan cercana, y probablemente no tan amigable. "La pregunta más importante desde el comienzo de la investigación fue" ¿Qué pasa si tienes dispositivos que son inteligentes en términos de eficiencia, pero no como nosotros en términos de falta de empatía por lo que somos? ", Dice Terry Winograd, honrado Profesor de la Universidad de Stanford. "Puede imaginar máquinas que no se basan en la inteligencia humana, funcionan con grandes datos y controlan el mundo".

Unas pocas horas después de la jugada 37, AlphaGo ganó el juego y comenzó a liderar 2-0 en un partido de cinco juegos. Después de eso, Sedol se paró frente a una multitud de periodistas y fotógrafos y se disculpó cortésmente por decepcionar a la humanidad. "Estaba sin palabras", dijo, parpadeando bajo las ráfagas de destello.El sorprendente éxito de AlphaGo muestra cuánto progreso se ha logrado en IA en los últimos años, después de décadas de desesperación y desafíos descritos como "el invierno de la IA". El aprendizaje profundo permite a las máquinas aprender por sí mismas cómo realizar tareas complejas, cuya solución hace unos años no se podía imaginar sin la participación de la inteligencia humana. Robomobiles ya se avecinan en el horizonte. En un futuro cercano, los sistemas de aprendizaje profundo ayudarán a diagnosticar enfermedades y proporcionarán recomendaciones de tratamiento.Pero a pesar de estos impresionantes avances, una de las principales posibilidades no está dada por AI: el lenguaje. Los sistemas como Siri e IBM Watson pueden reconocer comandos verbales y escritos simples y responder preguntas simples, pero no pueden mantener una conversación o realmente entender las palabras utilizadas. Para que la IA cambie nuestro mundo, esto debe cambiar.Aunque AlphaGo no habla, tiene tecnología que puede proporcionar una mejor comprensión del idioma. En Google, Facebook, Amazon y los laboratorios de ciencias, los investigadores están tratando de resolver este obstinado problema utilizando las mismas herramientas de IA, incluido el aprendizaje profundo, que son responsables del éxito de AlphaGo y del resurgimiento de la IA. Su éxito determinará el alcance y las propiedades de lo que ya está comenzando a convertirse en una revolución de IA. Esto determinará nuestro futuro: tendremos máquinas con las que sea fácil comunicarse y los sistemas con IA seguirán siendo misteriosas cajas negras, aunque más autónomas. "No hay forma de crear un sistema humanoide con IA a menos que esté basado en el lenguaje", dijo Josh Tenenbaum, profesor de ciencias cognitivas y computación en el MIT. "Esta es una de las cosas más obvias que definen la inteligencia humana".Tal vez las mismas tecnologías que permitieron a AlphaGo conquistar ir permitieran a las computadoras dominar el idioma, o de lo contrario se necesitará algo más. Pero sin comprender el lenguaje, el impacto de la IA será diferente. Por supuesto, todavía tendremos programas poco realistas e inteligentes como AlphaGo. Pero nuestra relación con la IA no será tan cercana, y probablemente no tan amigable. "La pregunta más importante desde el comienzo de la investigación fue" ¿Qué pasa si tienes dispositivos que son inteligentes en términos de eficiencia, pero no como nosotros en términos de falta de empatía por lo que somos? ", Dice Terry Winograd, honrado Profesor de la Universidad de Stanford. "Puede imaginar máquinas que no se basan en la inteligencia humana, funcionan con grandes datos y controlan el mundo".Hablar con autos

Un par de meses después del triunfo de AlphaGo, fui a Silicon Valley, el corazón del boom de la IA. Quería reunirme con investigadores que han logrado un progreso significativo en las aplicaciones prácticas de IA y están tratando de darles a las máquinas una comprensión del lenguaje.Comencé con Vinohrad, que vive en un suburbio en el extremo sur del campus de Stanford en Palo Alto, no lejos de la sede de Google, Facebook y Apple. Su cabello gris y rizado y su bigote espeso le dan la apariencia de un científico respetable, e infecta con su entusiasmo.En 1968, Grapes hizo uno de los primeros intentos de enseñar a las máquinas a hablar. Como un prodigio matemático con pasión por el lenguaje, vino al nuevo laboratorio de IA del MIT para obtener su título. Decidió crear un programa que se comunica con las personas a través del ingreso de texto en el lenguaje cotidiano. En ese momento, no parecía un objetivo tan atrevido. Se dieron pasos muy importantes en el desarrollo de IA, y otros equipos del MIT construyeron sofisticados sistemas de visión por computadora y manipuladores robóticos. "Había una sensación de posibilidades desconocidas e ilimitadas", recuerda. Pero no todos creían que el lenguaje fuera tan fácil de conquistar. Algunos críticos, incluido el influyente lingüista y profesor del MIT Noam Chomsky, pensaron que sería muy difícil para los investigadores de IA enseñar a las máquinas a entender, ya que la mecánica del lenguaje en los humanos era muy poco conocida. Grapes recuerda una fiesta en la que un estudiante Chomsky se alejó de él después de escuchar que estaba trabajando en un laboratorio de IA.Pero hay razones para el optimismo. Joseph Weizenbaum, profesor en el MIT de ascendencia alemana, hizo el primer programa de chatbot hace un par de años. Se llamaba ELIZA y estaba programada para responder como una psicóloga de dibujos animados, repitiendo partes clave de las declaraciones o haciendo preguntas inspiradoras para continuar la conversación. Si le dijiste que estabas enojado con tu madre, el programa podría decir: "¿Qué más te viene a la mente cuando piensas en tu madre?". Un truco barato que funcionó sorprendentemente bien. Weisenbaum se sorprendió cuando algunos sujetos comenzaron a verificar sus oscuros secretos con su automóvil.Las uvas querían hacer algo que pudiera fingir convincentemente que entendía el idioma. Comenzó reduciendo el alcance del problema. Creó un entorno virtual simple, el "mundo de bloques", que consiste en un conjunto de objetos ficticios sobre una mesa ficticia. Luego creó un programa, nombrándolo SHRDLU, que puede analizar todos los sustantivos, verbos y reglas gramaticales simples necesarias para comunicarse en este mundo virtual simplificado. SHRDLU (una palabra sin sentido formada por una línea de letras del teclado linotipo) podría describir objetos, responder preguntas sobre sus relaciones y cambiar el mundo de bloques en respuesta a los comandos de entrada. Incluso tenía un cierto recuerdo y si le pedías que moviera el "cono rojo", y luego escribías sobre cierto cono, suponía que tenías en mente este cono rojo, y no otro.

Pero no todos creían que el lenguaje fuera tan fácil de conquistar. Algunos críticos, incluido el influyente lingüista y profesor del MIT Noam Chomsky, pensaron que sería muy difícil para los investigadores de IA enseñar a las máquinas a entender, ya que la mecánica del lenguaje en los humanos era muy poco conocida. Grapes recuerda una fiesta en la que un estudiante Chomsky se alejó de él después de escuchar que estaba trabajando en un laboratorio de IA.Pero hay razones para el optimismo. Joseph Weizenbaum, profesor en el MIT de ascendencia alemana, hizo el primer programa de chatbot hace un par de años. Se llamaba ELIZA y estaba programada para responder como una psicóloga de dibujos animados, repitiendo partes clave de las declaraciones o haciendo preguntas inspiradoras para continuar la conversación. Si le dijiste que estabas enojado con tu madre, el programa podría decir: "¿Qué más te viene a la mente cuando piensas en tu madre?". Un truco barato que funcionó sorprendentemente bien. Weisenbaum se sorprendió cuando algunos sujetos comenzaron a verificar sus oscuros secretos con su automóvil.Las uvas querían hacer algo que pudiera fingir convincentemente que entendía el idioma. Comenzó reduciendo el alcance del problema. Creó un entorno virtual simple, el "mundo de bloques", que consiste en un conjunto de objetos ficticios sobre una mesa ficticia. Luego creó un programa, nombrándolo SHRDLU, que puede analizar todos los sustantivos, verbos y reglas gramaticales simples necesarias para comunicarse en este mundo virtual simplificado. SHRDLU (una palabra sin sentido formada por una línea de letras del teclado linotipo) podría describir objetos, responder preguntas sobre sus relaciones y cambiar el mundo de bloques en respuesta a los comandos de entrada. Incluso tenía un cierto recuerdo y si le pedías que moviera el "cono rojo", y luego escribías sobre cierto cono, suponía que tenías en mente este cono rojo, y no otro. SHRDLU se ha convertido en el estandarte del tremendo progreso en IA. Pero fue solo una ilusión. Cuando Vinograd intentó expandir el mundo de bloques del programa, las reglas necesarias para explicar las palabras adicionales y las dificultades gramaticales se volvieron incontrolables. Solo unos años más tarde, se rindió y dejó el campo de la IA, concentrándose en otros estudios. "Las restricciones eran mucho más fuertes de lo que parecían entonces", dice.Grapes decidió que con las herramientas disponibles en ese momento era imposible enseñarle a la máquina a entender realmente el idioma. El problema, según Hubert Dreyfus, profesor de filosofía en la Universidad de California en Berkeley, como lo expresó en 1972, What Computers Can't Do, es que muchas acciones humanas requieren comprensión instintiva. que no se puede establecer mediante un conjunto de reglas simples. Es por eso que, antes del inicio del partido entre Sedol y AlphaGo, muchos expertos dudaban de que las máquinas pudieran dominar el juego de go.

SHRDLU se ha convertido en el estandarte del tremendo progreso en IA. Pero fue solo una ilusión. Cuando Vinograd intentó expandir el mundo de bloques del programa, las reglas necesarias para explicar las palabras adicionales y las dificultades gramaticales se volvieron incontrolables. Solo unos años más tarde, se rindió y dejó el campo de la IA, concentrándose en otros estudios. "Las restricciones eran mucho más fuertes de lo que parecían entonces", dice.Grapes decidió que con las herramientas disponibles en ese momento era imposible enseñarle a la máquina a entender realmente el idioma. El problema, según Hubert Dreyfus, profesor de filosofía en la Universidad de California en Berkeley, como lo expresó en 1972, What Computers Can't Do, es que muchas acciones humanas requieren comprensión instintiva. que no se puede establecer mediante un conjunto de reglas simples. Es por eso que, antes del inicio del partido entre Sedol y AlphaGo, muchos expertos dudaban de que las máquinas pudieran dominar el juego de go. Pero mientras Dreyfus demostraba su punto, varios investigadores desarrollaron un enfoque que, al final, les daría a las máquinas el tipo de inteligencia que necesitaban. Inspirados por la neurociencia, experimentaron con redes neuronales artificiales: capas de simulaciones matemáticas de neuronas que pueden entrenarse para activarse en respuesta a ciertos datos de entrada. Al principio, estos sistemas funcionaban increíblemente lento y el enfoque fue rechazado por ser poco práctico para la lógica y el razonamiento. Sin embargo, una característica clave de las redes neuronales era la capacidad de aprender lo que no se había programado manualmente, y luego resultó ser útil para tareas simples como el reconocimiento de escritura a mano. Esta habilidad encontró uso comercial en la década de 1990 para leer números de cheques. Los defensores del método confiaban en que con el tiempo, las redes neuronales permitirían a las máquinas hacer mucho más.Afirmaron que algún día esta tecnología ayudará y reconocerá el idioma.En los últimos años, las redes neuronales se han vuelto más complejas y poderosas. El enfoque floreció gracias a mejoras matemáticas clave y, lo que es más importante, un hardware informático más rápido y la llegada de grandes cantidades de datos. Para 2009, los investigadores de la Universidad de Toronto demostraron que las redes de aprendizaje profundo de múltiples capas pueden reconocer el habla con una precisión récord. Y en 2012, el mismo grupo ganó la competencia de visión artificial utilizando un algoritmo de aprendizaje profundo que mostró una precisión sorprendente.Una red neuronal de aprendizaje profundo reconoce objetos en imágenes con un simple truco. La capa de neuronas simuladas recibe información como una imagen y algunas de las neuronas se activan en respuesta a la intensidad de los píxeles individuales. La señal resultante pasa a través de muchas capas de neuronas interconectadas antes de llegar a la capa de salida, que señala la observación de un objeto. Se utiliza una técnica matemática llamada "retropropagación" para ajustar la sensibilidad de las neuronas de la red para crear la respuesta correcta. Es este paso el que le da al sistema la oportunidad de aprender. Las diferentes capas de la red responden a propiedades como bordes, colores o textura. Tales sistemas hoy son capaces de reconocer objetos, animales o caras con una precisión que rivaliza con la de los humanos.Hay un problema obvio con la aplicación de tecnología de aprendizaje profundo al idioma. Las palabras son caracteres arbitrarios, y así es como difieren esencialmente de las imágenes. Dos palabras pueden tener un significado similar y contener letras completamente diferentes. Y la misma palabra puede significar cosas diferentes según el contexto.En la década de 1980, a los investigadores se les ocurrió la difícil idea de convertir un lenguaje en un tipo de problema que una red neuronal puede manejar. Mostraron que las palabras pueden representarse como vectores matemáticos, lo que nos permite calcular la similitud de las palabras relacionadas. Por ejemplo, "barco" y "agua" están cerca en el espacio vectorial, aunque se ven diferentes. Investigadores de la Universidad de Montreal liderados por Yoshua Bengio y otro equipo de Google usaron esta idea para construir redes en las que cada palabra en una oración se usa para construir una representación más compleja. Geoffrey Hinton, profesor de la Universidad de Toronto y destacado investigador de aprendizaje profundo que también trabaja para Google, llama a esto un "vector mental".Usando dos de estas redes, puede traducir de un idioma a otro con excelente precisión. Y combinando este tipo de redes con la que reconoce objetos en las imágenes, puede obtener subtítulos sorprendentemente precisos.

Pero mientras Dreyfus demostraba su punto, varios investigadores desarrollaron un enfoque que, al final, les daría a las máquinas el tipo de inteligencia que necesitaban. Inspirados por la neurociencia, experimentaron con redes neuronales artificiales: capas de simulaciones matemáticas de neuronas que pueden entrenarse para activarse en respuesta a ciertos datos de entrada. Al principio, estos sistemas funcionaban increíblemente lento y el enfoque fue rechazado por ser poco práctico para la lógica y el razonamiento. Sin embargo, una característica clave de las redes neuronales era la capacidad de aprender lo que no se había programado manualmente, y luego resultó ser útil para tareas simples como el reconocimiento de escritura a mano. Esta habilidad encontró uso comercial en la década de 1990 para leer números de cheques. Los defensores del método confiaban en que con el tiempo, las redes neuronales permitirían a las máquinas hacer mucho más.Afirmaron que algún día esta tecnología ayudará y reconocerá el idioma.En los últimos años, las redes neuronales se han vuelto más complejas y poderosas. El enfoque floreció gracias a mejoras matemáticas clave y, lo que es más importante, un hardware informático más rápido y la llegada de grandes cantidades de datos. Para 2009, los investigadores de la Universidad de Toronto demostraron que las redes de aprendizaje profundo de múltiples capas pueden reconocer el habla con una precisión récord. Y en 2012, el mismo grupo ganó la competencia de visión artificial utilizando un algoritmo de aprendizaje profundo que mostró una precisión sorprendente.Una red neuronal de aprendizaje profundo reconoce objetos en imágenes con un simple truco. La capa de neuronas simuladas recibe información como una imagen y algunas de las neuronas se activan en respuesta a la intensidad de los píxeles individuales. La señal resultante pasa a través de muchas capas de neuronas interconectadas antes de llegar a la capa de salida, que señala la observación de un objeto. Se utiliza una técnica matemática llamada "retropropagación" para ajustar la sensibilidad de las neuronas de la red para crear la respuesta correcta. Es este paso el que le da al sistema la oportunidad de aprender. Las diferentes capas de la red responden a propiedades como bordes, colores o textura. Tales sistemas hoy son capaces de reconocer objetos, animales o caras con una precisión que rivaliza con la de los humanos.Hay un problema obvio con la aplicación de tecnología de aprendizaje profundo al idioma. Las palabras son caracteres arbitrarios, y así es como difieren esencialmente de las imágenes. Dos palabras pueden tener un significado similar y contener letras completamente diferentes. Y la misma palabra puede significar cosas diferentes según el contexto.En la década de 1980, a los investigadores se les ocurrió la difícil idea de convertir un lenguaje en un tipo de problema que una red neuronal puede manejar. Mostraron que las palabras pueden representarse como vectores matemáticos, lo que nos permite calcular la similitud de las palabras relacionadas. Por ejemplo, "barco" y "agua" están cerca en el espacio vectorial, aunque se ven diferentes. Investigadores de la Universidad de Montreal liderados por Yoshua Bengio y otro equipo de Google usaron esta idea para construir redes en las que cada palabra en una oración se usa para construir una representación más compleja. Geoffrey Hinton, profesor de la Universidad de Toronto y destacado investigador de aprendizaje profundo que también trabaja para Google, llama a esto un "vector mental".Usando dos de estas redes, puede traducir de un idioma a otro con excelente precisión. Y combinando este tipo de redes con la que reconoce objetos en las imágenes, puede obtener subtítulos sorprendentemente precisos.Sentido de la vida

Sentado en una sala de conferencias en el corazón de la bulliciosa sede de Google en Mountain View, California, uno de los investigadores de la compañía que desarrolló este enfoque, Quoc Le, analiza la idea de una máquina capaz de soportar una conversación real. Las ambiciones de Lee explican cómo las máquinas parlantes pueden ser útiles. "Necesito una forma de simular pensamientos en un automóvil", dice. "Y si quieres fingir ser pensamientos, puedes preguntarle al auto qué está pensando". Google ya está enseñando a sus computadoras los conceptos básicos del lenguaje. En mayo, la compañía presentó el sistema Parsey McParseface, que puede reconocer sintaxis, sustantivos, verbos y otros elementos de texto. Es fácil ver cómo comprender un idioma puede ayudar a una empresa. El algoritmo de búsqueda de Google alguna vez simplemente rastreaba palabras clave y enlaces entre páginas web. Ahora el sistema RankBrain lee el texto de las páginas para comprender su significado y mejorar los resultados de búsqueda. Lee quiere impulsar esta idea aún más. Adaptando el sistema, que resultó ser útil para traducciones y firmas de imágenes, él y sus colegas crearon Smart Reply, que lee el contenido de las cartas en Gmail y ofrece posibles respuestas. También crearon un programa que aprendió a través del chat de soporte de Google para responder preguntas técnicas simples.Lee recientemente creó un programa que puede generar respuestas decentes a preguntas difíciles. Se formó en diálogos de 18.900 películas. Algunas respuestas dan un puntazo aterrador. Por ejemplo, Lee preguntó "¿Cuál es el propósito de la vida?" Y el programa respondió "Al servicio del bien superior". "Esa es una buena respuesta", recuerda con una sonrisa. "Quizás mejor de lo que me respondería a mí mismo".Solo hay un problema que se hace evidente cuando se observan más respuestas del sistema. Cuando Lee preguntó: "¿Cuántas patas tiene un gato?", El sistema respondió: "Creo que cuatro". Luego preguntó: "¿Cuántas patas tiene un ciempiés?" Y recibió la extraña respuesta "Ocho". De hecho, el programa de Lee no entiende de qué está hablando. Ella entiende que algunas combinaciones de símbolos se combinan juntas, pero no entiende el mundo real. Ella no sabe cómo se ve un ciempiés ni cómo se mueve. Esto sigue siendo una ilusión de inteligencia, sin sentido común, que la gente da por sentado. Los sistemas de aprendizaje profundo son bastante inestables en este sentido. Un sistema de Google que crea subtítulos para imágenes a veces comete errores extraños, por ejemplo, describe una señal de tráfico como un refrigerador con comida.Por una extraña coincidencia, el vecino de Terry Vinohrad en Palo Alto resultó ser un hombre que puede ayudar a las computadoras a comprender mejor el verdadero significado de las palabras. Fei-Fei Li, directora del Laboratorio de Inteligencia Artificial de Stanford, estaba de baja por maternidad durante mi visita, pero me invitó a casa y me presentó con orgullo a su bebé de tres meses, Phoenix. "Fíjate que te mira más de lo que me mira a mí", dijo Lee cuando el Fénix me miró. - Esto es porque eres nuevo; es un reconocimiento facial temprano ".Durante la mayor parte de su carrera, Lee estudió aprendizaje automático y visión artificial. Hace varios años, bajo su liderazgo, se intentó crear una base de datos de millones de imágenes de objetos, cada uno de los cuales se firmó con las palabras clave correspondientes. Pero Lee cree que las máquinas necesitan una comprensión más complicada de lo que está sucediendo en el mundo, y este año su equipo lanzó otra base de datos con imágenes, cuyas anotaciones eran mucho más ricas. Para cada imagen, la gente hizo docenas de firmas: "Perro en una patineta", "El perro tiene un pelaje ondulado", "Carretera con grietas", etc. Esperan que los sistemas de aprendizaje automático aprendan a comprender el mundo físico. "La parte lingüística del cerebro recibe mucha información, incluso del sistema visual", dice Lee. "Una parte importante de la IA será la integración de estos sistemas".Este proceso está más cerca de enseñar a los niños a conectar palabras con objetos, relaciones y acciones. Pero la analogía con enseñar a la gente no va demasiado lejos. Los niños no necesitan ver a un perro en una patineta para imaginarlo o describirlo con palabras. Lee cree que las herramientas actuales para la IA y el aprendizaje automático no serán suficientes para crear una IA real. "No se trata solo de un aprendizaje profundo con un gran conjunto de datos", dice ella. "A los humanos nos va muy mal con los cálculos de big data, pero muy bien con las abstracciones y la creatividad".Nadie sabe cómo dotar a las máquinas de estas cualidades humanas y si esto es posible. ¿Hay algo exclusivamente humano en tales cualidades que no permita que la IA los posea?Los expertos en ciencias cognitivas, como Tenenbaum del MIT, creen que las redes neuronales de hoy carecen de componentes críticos de la mente, independientemente del tamaño de estas redes. Las personas pueden aprender relativamente rápido sobre cantidades relativamente pequeñas de datos, y tienen la capacidad incorporada de simular efectivamente un mundo tridimensional. "El lenguaje se basa en otras posibilidades, probablemente más profundo y presente en los bebés incluso antes de que comiencen a dominar el lenguaje: la percepción visual del mundo, el trabajo con nuestro aparato motor, la comprensión de la física del mundo y las intenciones de otras criaturas", dice Tenenbaum.Si tiene razón, entonces, sin tratar de simular el proceso de aprendizaje humano, crear modelos mentales y psicología, será muy difícil recrear la comprensión del lenguaje en IA.

Google ya está enseñando a sus computadoras los conceptos básicos del lenguaje. En mayo, la compañía presentó el sistema Parsey McParseface, que puede reconocer sintaxis, sustantivos, verbos y otros elementos de texto. Es fácil ver cómo comprender un idioma puede ayudar a una empresa. El algoritmo de búsqueda de Google alguna vez simplemente rastreaba palabras clave y enlaces entre páginas web. Ahora el sistema RankBrain lee el texto de las páginas para comprender su significado y mejorar los resultados de búsqueda. Lee quiere impulsar esta idea aún más. Adaptando el sistema, que resultó ser útil para traducciones y firmas de imágenes, él y sus colegas crearon Smart Reply, que lee el contenido de las cartas en Gmail y ofrece posibles respuestas. También crearon un programa que aprendió a través del chat de soporte de Google para responder preguntas técnicas simples.Lee recientemente creó un programa que puede generar respuestas decentes a preguntas difíciles. Se formó en diálogos de 18.900 películas. Algunas respuestas dan un puntazo aterrador. Por ejemplo, Lee preguntó "¿Cuál es el propósito de la vida?" Y el programa respondió "Al servicio del bien superior". "Esa es una buena respuesta", recuerda con una sonrisa. "Quizás mejor de lo que me respondería a mí mismo".Solo hay un problema que se hace evidente cuando se observan más respuestas del sistema. Cuando Lee preguntó: "¿Cuántas patas tiene un gato?", El sistema respondió: "Creo que cuatro". Luego preguntó: "¿Cuántas patas tiene un ciempiés?" Y recibió la extraña respuesta "Ocho". De hecho, el programa de Lee no entiende de qué está hablando. Ella entiende que algunas combinaciones de símbolos se combinan juntas, pero no entiende el mundo real. Ella no sabe cómo se ve un ciempiés ni cómo se mueve. Esto sigue siendo una ilusión de inteligencia, sin sentido común, que la gente da por sentado. Los sistemas de aprendizaje profundo son bastante inestables en este sentido. Un sistema de Google que crea subtítulos para imágenes a veces comete errores extraños, por ejemplo, describe una señal de tráfico como un refrigerador con comida.Por una extraña coincidencia, el vecino de Terry Vinohrad en Palo Alto resultó ser un hombre que puede ayudar a las computadoras a comprender mejor el verdadero significado de las palabras. Fei-Fei Li, directora del Laboratorio de Inteligencia Artificial de Stanford, estaba de baja por maternidad durante mi visita, pero me invitó a casa y me presentó con orgullo a su bebé de tres meses, Phoenix. "Fíjate que te mira más de lo que me mira a mí", dijo Lee cuando el Fénix me miró. - Esto es porque eres nuevo; es un reconocimiento facial temprano ".Durante la mayor parte de su carrera, Lee estudió aprendizaje automático y visión artificial. Hace varios años, bajo su liderazgo, se intentó crear una base de datos de millones de imágenes de objetos, cada uno de los cuales se firmó con las palabras clave correspondientes. Pero Lee cree que las máquinas necesitan una comprensión más complicada de lo que está sucediendo en el mundo, y este año su equipo lanzó otra base de datos con imágenes, cuyas anotaciones eran mucho más ricas. Para cada imagen, la gente hizo docenas de firmas: "Perro en una patineta", "El perro tiene un pelaje ondulado", "Carretera con grietas", etc. Esperan que los sistemas de aprendizaje automático aprendan a comprender el mundo físico. "La parte lingüística del cerebro recibe mucha información, incluso del sistema visual", dice Lee. "Una parte importante de la IA será la integración de estos sistemas".Este proceso está más cerca de enseñar a los niños a conectar palabras con objetos, relaciones y acciones. Pero la analogía con enseñar a la gente no va demasiado lejos. Los niños no necesitan ver a un perro en una patineta para imaginarlo o describirlo con palabras. Lee cree que las herramientas actuales para la IA y el aprendizaje automático no serán suficientes para crear una IA real. "No se trata solo de un aprendizaje profundo con un gran conjunto de datos", dice ella. "A los humanos nos va muy mal con los cálculos de big data, pero muy bien con las abstracciones y la creatividad".Nadie sabe cómo dotar a las máquinas de estas cualidades humanas y si esto es posible. ¿Hay algo exclusivamente humano en tales cualidades que no permita que la IA los posea?Los expertos en ciencias cognitivas, como Tenenbaum del MIT, creen que las redes neuronales de hoy carecen de componentes críticos de la mente, independientemente del tamaño de estas redes. Las personas pueden aprender relativamente rápido sobre cantidades relativamente pequeñas de datos, y tienen la capacidad incorporada de simular efectivamente un mundo tridimensional. "El lenguaje se basa en otras posibilidades, probablemente más profundo y presente en los bebés incluso antes de que comiencen a dominar el lenguaje: la percepción visual del mundo, el trabajo con nuestro aparato motor, la comprensión de la física del mundo y las intenciones de otras criaturas", dice Tenenbaum.Si tiene razón, entonces, sin tratar de simular el proceso de aprendizaje humano, crear modelos mentales y psicología, será muy difícil recrear la comprensión del lenguaje en IA.Explicar

La oficina de Noah Goodman en el Departamento de Psicología de Stanford está casi vacía, con la excepción de un par de pinturas asrácticas en una de las paredes y varias plantas con maleza. Goodman garabateó algo en su computadora portátil en el momento de mi llegada, poniendo los pies descalzos sobre la mesa. Caminamos por el campus iluminado por el sol para comprar café helado. "La peculiaridad del lenguaje es que se basa no solo en una gran cantidad de información sobre el idioma, sino también en la comprensión universal del mundo que nos rodea y estas dos áreas de conocimiento están implícitamente relacionadas entre sí", explica.Goodman y sus estudiantes desarrollaron el lenguaje de programación Webppl, que puede usarse para dotar a las computadoras de sentido común probabilístico, que es bastante importante en las conversaciones. Una versión experimental es capaz de reconocer juegos de palabras, y la otra es una hipérbole. Si ella dice que algunas personas tienen que pasar "la eternidad" esperando una mesa en un restaurante, automáticamente decidirá que usar el significado literal de esta palabra en este caso es poco probable y que las personas probablemente esperarán mucho tiempo y se molestarán. El sistema aún no puede llamarse verdadera inteligencia, pero muestra cómo los nuevos enfoques pueden ayudar a los programas de IA a hablar un poco más vívidamente.El ejemplo de Goodman también muestra lo difícil que será enseñar a las máquinas un idioma. Comprender el significado del término "eternidad" en un determinado contexto es un ejemplo de lo que los sistemas de inteligencia artificial deberían aprender, y esto es realmente algo bastante simple y rudimentario.Sin embargo, a pesar de la complejidad y la complejidad de la tarea, los éxitos iniciales de los investigadores que utilizan el aprendizaje profundo para reconocer imágenes o jugar el juego dan la esperanza de que estamos al borde de un avance en el campo del lenguaje. En este caso, este avance llegó justo a tiempo. Si la IA se convierte en una herramienta universal, ayuda a las personas a complementar y fortalecer su propia inteligencia y realizar tareas en un modo de simbiosis sin problemas, entonces el lenguaje es la clave para lograr este estado. Especialmente si los sistemas de inteligencia artificial utilizarán cada vez más el aprendizaje profundo y otras tecnologías para la autoprogramación."En general, los sistemas de aprendizaje profundo están asombrados", dijo John Leonard, profesor de vehículos robóticos en el MIT. "Por otro lado, su trabajo es bastante difícil de entender".Toyota, que está estudiando diversas tecnologías de conducción autónoma, ha lanzado un proyecto de investigación en el MIT dirigido por Gerald Sussman, experto en IA y lenguajes de programación, con el objetivo de desarrollar un sistema de conducción autónomo que pueda explicar por qué en algún momento Otra acción. La forma obvia de dar tal explicación sería verbal. "Crear sistemas que tengan conocimiento es un gran desafío", dice Leonard, quien dirige otro proyecto de Toyota en el MIT. "Pero sí, idealmente deberían dar no solo una respuesta, sino una explicación".Unas semanas después de regresar de California, me reuní con David Silver, un investigador de Google DeepMind y desarrollador de AlphaGo. Habló sobre el partido contra Sedol en una conferencia científica en Nueva York. Silver explicó que cuando el programa en el segundo juego hizo su movimiento decisivo, su equipo se sorprendió no menos que los demás. Solo podían ver que AlphaGo predijo las posibilidades de ganar, y esta predicción no cambió mucho después de la jugada 37. Solo unos días después, después de analizar cuidadosamente el juego, el equipo hizo un descubrimiento: al digerir los juegos anteriores, el programa calculó que un jugador humano podría hacer ese movimiento con una probabilidad de 1 en 10 000. Y sus juegos de entrenamiento mostraron que tal maniobra proporciona una ventaja posicional inusualmente fuerte .Entonces, en cierto sentido, el automóvil sabía que este movimiento golpearía el punto débil de Sedol.Silver dijo que Google está considerando varias formas de comercializar esta tecnología, incluidos asistentes inteligentes y herramientas de atención médica. Después de la conferencia, le pregunté sobre la importancia de poder comunicarse con la IA que controla dichos sistemas. "Una pregunta interesante", dijo después de una pausa. - Para algunas aplicaciones, esto puede ser útil. Por ejemplo, en atención médica puede ser importante saber por qué se tomó una decisión en particular ".De hecho, la IA se está volviendo cada vez más compleja y confusa, y es muy difícil imaginar cómo trabajaremos con ellos sin lenguaje, sin la capacidad de preguntarles "¿Por qué?". Además, la capacidad de comunicarse fácilmente con las computadoras las haría más útiles y parecería mágicas. Después de todo, el lenguaje es la mejor de nuestras formas de entender el mundo e interactuar con él. Es hora de que los autos nos alcancen.Source: https://habr.com/ru/post/es396977/

All Articles