iBrain ya está aquí, y ya en tu teléfono

Vista exclusiva de Apple de inteligencia artificial y aprendizaje automático

30 de julio de 2014 Siria [Siri] trasplantó el cerebro.Tres años antes, Apple fue la primera de las compañías de tecnología más grandes en implementar un asistente de inteligencia artificial en el sistema operativo. Siri se ha convertido en una adaptación de una aplicación de terceros adquirida por la empresa. Al mismo tiempo con la aplicación en 2010, se adquirió la empresa desarrolladora. Las primeras revisiones de la tecnología fueron entusiastas, pero en los siguientes meses y años, los usuarios comenzaron a molestar sus fallas. Con demasiada frecuencia, ella reconoció incorrectamente los comandos.Por lo tanto, Apple transfirió el sistema de reconocimiento de voz de Siri para trabajar utilizando una red neuronal para usuarios de los Estados Unidos el día de julio mencionado anteriormente (en el resto del mundo esto sucedió el 15 de agosto de 2014). Algunas de las técnicas anteriores se mantuvieron operativas, incluidos los "modelos ocultos de Markov", pero ahora el sistema se basa en técnicas de aprendizaje automático como redes neuronales profundas (DNN), redes neuronales convolucionales, memoria a corto plazo a largo plazo, redes recurrentes con puertas de enlace y n-gramos. Después de la actualización, Siri se veía igual, pero el aprendizaje profundo la rescató.Y como suele ser el caso con las actualizaciones ocultas, Apple no lo anunció. Si los usuarios lo han notado, esta es una reducción en el número de errores. Apple afirma que los resultados para mejorar la precisión han sido asombrosos.

30 de julio de 2014 Siria [Siri] trasplantó el cerebro.Tres años antes, Apple fue la primera de las compañías de tecnología más grandes en implementar un asistente de inteligencia artificial en el sistema operativo. Siri se ha convertido en una adaptación de una aplicación de terceros adquirida por la empresa. Al mismo tiempo con la aplicación en 2010, se adquirió la empresa desarrolladora. Las primeras revisiones de la tecnología fueron entusiastas, pero en los siguientes meses y años, los usuarios comenzaron a molestar sus fallas. Con demasiada frecuencia, ella reconoció incorrectamente los comandos.Por lo tanto, Apple transfirió el sistema de reconocimiento de voz de Siri para trabajar utilizando una red neuronal para usuarios de los Estados Unidos el día de julio mencionado anteriormente (en el resto del mundo esto sucedió el 15 de agosto de 2014). Algunas de las técnicas anteriores se mantuvieron operativas, incluidos los "modelos ocultos de Markov", pero ahora el sistema se basa en técnicas de aprendizaje automático como redes neuronales profundas (DNN), redes neuronales convolucionales, memoria a corto plazo a largo plazo, redes recurrentes con puertas de enlace y n-gramos. Después de la actualización, Siri se veía igual, pero el aprendizaje profundo la rescató.Y como suele ser el caso con las actualizaciones ocultas, Apple no lo anunció. Si los usuarios lo han notado, esta es una reducción en el número de errores. Apple afirma que los resultados para mejorar la precisión han sido asombrosos. Vicepresidente senior de software y servicios de Internet, Eddie Kew"Esta fue una de esas veces en que la mejora fue tan significativa que tuvimos que verificar los resultados para asegurarnos de que nadie pusiera el separador decimal en otro lugar", dice Eddie Kew. Vicepresidente Senior de Programas y Servicios de Internet.La historia de la transformación de Siri, descrita por primera vez en este artículo, puede sorprender a los expertos en inteligencia artificial. No porque las redes neuronales mejoraron el sistema, sino porque Apple hizo todo en silencio. Hasta hace poco, cuando la compañía aumentó su reclutamiento de expertos en inteligencia artificial y adquirió un par de firmas especializadas, los observadores consideraron que Apple estaba detrás en la competencia más emocionante de nuestro tiempo: la carrera para explotar las ricas capacidades de la inteligencia artificial. Como Apple siempre se mostró reacio a compartir información sobre lo que estaba sucediendo a puerta cerrada, los conocedores de la inteligencia artificial no sospechaban que la compañía se dedicaba al aprendizaje automático. "Apple no es parte de la comunidad", dijo Jerry Kaplan, el curso de historia de IA de Stanford. "Apple es la NSA en el mundo de la IA". Pero los expertos en IA pensaron que si Apple hubiera estado haciendo IA tan en serio como Google o Facebook, entonces eso se habría sabido."Las mejores personas en Google, Facebook y Microsoft son el aprendizaje automático", dice Oren Etzioni, del Instituto Allen de IA. - Sí, Apple contrató a alguien. ¿Pero me llamas los cinco mejores expertos en inteligencia artificial de Apple? Tienen reconocimiento de voz, pero no está claro dónde más les ayuda el aprendizaje automático. ¡Muéstrame dónde se usa MO en tu producto! ”"Yo mismo estoy con Missouri", dice Etzioni, quien en realidad nació en Israel. "Muéstrame".Recientemente, Apple mostró dónde se usa el aprendizaje automático en sus productos, pero no para Etzoni, sino para mí. Pasé la mayor parte del día en la sala de reuniones One Infinite Loop en Cupertino, recibiendo información básica sobre el trabajo de la compañía con AI y MO de parte de los ejecutivos de Apple (Kew, Phil Schiller, vicepresidente senior de marketing internacional, y Craig Federigi, vicepresidente senior de desarrollo de software) y dos científicos cuyo trabajo fue clave para el desarrollo de Siria. Nos sentamos y me dieron contenido de dos páginas que enumera los productos y servicios de Apple utilizando tecnología de máquina, aquellos que ya se estaban preparando para el lanzamiento, o ya se iban, como tema de discusión.Mensaje: ya estamos aquí. No somos inferiores a nadie. Pero lo hacemos a nuestra manera.Si usa un iPhone, se ha encontrado con AI de Apple, y no solo en la versión mejorada de Siri. Lo encuentra cuando el teléfono identifica a una persona que llama que no está en su lista de contactos (pero que le escribió un correo electrónico recientemente). O cuando desliza el dedo por la pantalla para que aparezca una lista de aplicaciones, entre las cuales hay una alta probabilidad de que desee abrir después de eso. O cuando recibe un recordatorio de reunión que no agregó al calendario. O cuando aparece un punto en el mapa con el hotel que ha reservado y aún no ha ingresado su dirección. O cuando el teléfono te señala el lugar donde estacionaste, pero no le preguntaste. Todas estas características aparecieron o se mejoraron en gran medida mediante el uso de aprendizaje profundo y redes neuronales.

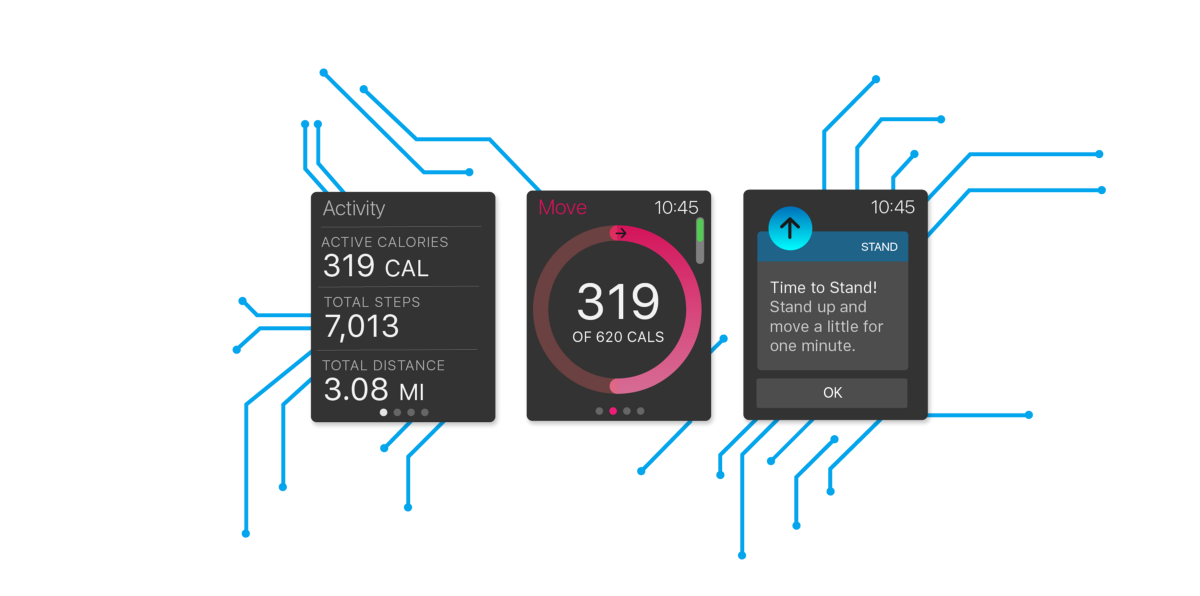

Vicepresidente senior de software y servicios de Internet, Eddie Kew"Esta fue una de esas veces en que la mejora fue tan significativa que tuvimos que verificar los resultados para asegurarnos de que nadie pusiera el separador decimal en otro lugar", dice Eddie Kew. Vicepresidente Senior de Programas y Servicios de Internet.La historia de la transformación de Siri, descrita por primera vez en este artículo, puede sorprender a los expertos en inteligencia artificial. No porque las redes neuronales mejoraron el sistema, sino porque Apple hizo todo en silencio. Hasta hace poco, cuando la compañía aumentó su reclutamiento de expertos en inteligencia artificial y adquirió un par de firmas especializadas, los observadores consideraron que Apple estaba detrás en la competencia más emocionante de nuestro tiempo: la carrera para explotar las ricas capacidades de la inteligencia artificial. Como Apple siempre se mostró reacio a compartir información sobre lo que estaba sucediendo a puerta cerrada, los conocedores de la inteligencia artificial no sospechaban que la compañía se dedicaba al aprendizaje automático. "Apple no es parte de la comunidad", dijo Jerry Kaplan, el curso de historia de IA de Stanford. "Apple es la NSA en el mundo de la IA". Pero los expertos en IA pensaron que si Apple hubiera estado haciendo IA tan en serio como Google o Facebook, entonces eso se habría sabido."Las mejores personas en Google, Facebook y Microsoft son el aprendizaje automático", dice Oren Etzioni, del Instituto Allen de IA. - Sí, Apple contrató a alguien. ¿Pero me llamas los cinco mejores expertos en inteligencia artificial de Apple? Tienen reconocimiento de voz, pero no está claro dónde más les ayuda el aprendizaje automático. ¡Muéstrame dónde se usa MO en tu producto! ”"Yo mismo estoy con Missouri", dice Etzioni, quien en realidad nació en Israel. "Muéstrame".Recientemente, Apple mostró dónde se usa el aprendizaje automático en sus productos, pero no para Etzoni, sino para mí. Pasé la mayor parte del día en la sala de reuniones One Infinite Loop en Cupertino, recibiendo información básica sobre el trabajo de la compañía con AI y MO de parte de los ejecutivos de Apple (Kew, Phil Schiller, vicepresidente senior de marketing internacional, y Craig Federigi, vicepresidente senior de desarrollo de software) y dos científicos cuyo trabajo fue clave para el desarrollo de Siria. Nos sentamos y me dieron contenido de dos páginas que enumera los productos y servicios de Apple utilizando tecnología de máquina, aquellos que ya se estaban preparando para el lanzamiento, o ya se iban, como tema de discusión.Mensaje: ya estamos aquí. No somos inferiores a nadie. Pero lo hacemos a nuestra manera.Si usa un iPhone, se ha encontrado con AI de Apple, y no solo en la versión mejorada de Siri. Lo encuentra cuando el teléfono identifica a una persona que llama que no está en su lista de contactos (pero que le escribió un correo electrónico recientemente). O cuando desliza el dedo por la pantalla para que aparezca una lista de aplicaciones, entre las cuales hay una alta probabilidad de que desee abrir después de eso. O cuando recibe un recordatorio de reunión que no agregó al calendario. O cuando aparece un punto en el mapa con el hotel que ha reservado y aún no ha ingresado su dirección. O cuando el teléfono te señala el lugar donde estacionaste, pero no le preguntaste. Todas estas características aparecieron o se mejoraron en gran medida mediante el uso de aprendizaje profundo y redes neuronales. El reconocimiento facial funciona con redes neuronales.Como dicen mis oradores, MO ya se utiliza en todos los productos y servicios de la empresa. Apple utiliza una capacitación en profundidad para identificar a los estafadores en la tienda de Apple, para aumentar la duración de la batería, para descartar los comentarios más útiles de los beta testers. MO ayuda a Apple a elegir las noticias para ti. Determina si los usuarios de Apple Watch practican deportes o simplemente van y vienen. Reconoce rostros y lugares a partir de fotografías. Determina si es mejor romper una conexión Wi-Fi débil y cambiar a comunicaciones móviles. Incluso sabe cómo hacer una película, combinando fotos y videos en una pequeña película con solo tocar un botón. Los competidores de la compañía están haciendo lo mismo, pero según sus directores, estas capacidades de IA no pueden funcionar igual de bien, al tiempo que protegen la privacidad de los usuarios tanto como lo hacen en Apple.Y, por supuesto, ninguno de ellos fabrica productos como el de Apple.La IA no es nueva para la empresa. Ya en la década de 1990, usaron algunas técnicas de MO en programas que reconocían la escritura a mano (¿recuerdan a Newton?). Los restos de estos intentos se pueden encontrar en los programas actuales que convierten caracteres chinos escritos a mano en texto o reconocen la entrada letra por texto en el Apple Watch. Ambas oportunidades fueron desarrolladas por el mismo equipo de especialistas en el Ministerio de Defensa. Por supuesto, antes, el aprendizaje automático funcionaba de manera más primitiva, y pocas personas conocían el aprendizaje profundo. Hoy, estas tecnologías están en su apogeo, y Apple se eriza en respuesta a las acusaciones de que su MO no es demasiado grave. Y aquí los líderes de la compañía hablan de esto con más detalle.

El reconocimiento facial funciona con redes neuronales.Como dicen mis oradores, MO ya se utiliza en todos los productos y servicios de la empresa. Apple utiliza una capacitación en profundidad para identificar a los estafadores en la tienda de Apple, para aumentar la duración de la batería, para descartar los comentarios más útiles de los beta testers. MO ayuda a Apple a elegir las noticias para ti. Determina si los usuarios de Apple Watch practican deportes o simplemente van y vienen. Reconoce rostros y lugares a partir de fotografías. Determina si es mejor romper una conexión Wi-Fi débil y cambiar a comunicaciones móviles. Incluso sabe cómo hacer una película, combinando fotos y videos en una pequeña película con solo tocar un botón. Los competidores de la compañía están haciendo lo mismo, pero según sus directores, estas capacidades de IA no pueden funcionar igual de bien, al tiempo que protegen la privacidad de los usuarios tanto como lo hacen en Apple.Y, por supuesto, ninguno de ellos fabrica productos como el de Apple.La IA no es nueva para la empresa. Ya en la década de 1990, usaron algunas técnicas de MO en programas que reconocían la escritura a mano (¿recuerdan a Newton?). Los restos de estos intentos se pueden encontrar en los programas actuales que convierten caracteres chinos escritos a mano en texto o reconocen la entrada letra por texto en el Apple Watch. Ambas oportunidades fueron desarrolladas por el mismo equipo de especialistas en el Ministerio de Defensa. Por supuesto, antes, el aprendizaje automático funcionaba de manera más primitiva, y pocas personas conocían el aprendizaje profundo. Hoy, estas tecnologías están en su apogeo, y Apple se eriza en respuesta a las acusaciones de que su MO no es demasiado grave. Y aquí los líderes de la compañía hablan de esto con más detalle. "En los últimos cinco años, hemos estado observando el crecimiento de esta área en la empresa", dice Phil Schiller. "Nuestros dispositivos se están volviendo más inteligentes, y está sucediendo más rápido, especialmente con el uso de los chips de la serie A que desarrollamos. El backend se está volviendo más inteligente, más rápido, y todo lo que hacemos está conectado entre sí". Esto nos permite usar más y más técnicas de MO, porque hay mucho que aprender, pero ya está disponible para nosotros ".Y aunque Apple está luchando por usar el MO al máximo, los directores enfatizan que este proceso no es nada especial. Los jefes de Cupertin ven en el aprendizaje profundo y el MO solo otra tecnología de un flujo de tecnologías sucesivas e innovadoras. Sí, sí, está cambiando el mundo, pero no más que otros avances, como pantallas táctiles, pantallas planas u OOP. Desde el punto de vista de Apple, MO no es la última frontera, a pesar de la opinión de otras compañías. "Después de todo, no se puede decir que en los últimos años no haya habido otras tecnologías críticas para cambiar los principios de nuestra interacción con los dispositivos", dice Kew. Y nadie en la compañía quiere acercarse a discutir temas aterradores que siempre aparecen cuando se menciona la IA. Y, como era de esperar, Apple no confirma si está trabajando en vehículos robóticos o su versión de Netflix.Pero el equipo indicó claramente que Apple no está trabajando en Skynet."Utilizamos estas tecnologías para lo que siempre hemos querido hacer, y con una mejor calidad de la que era posible antes", dice Schiller. - Y por cosas nuevas que no podríamos hacer. Esta tecnología se convertirá en un método de Apple para lograr objetivos a medida que evoluciona dentro de la empresa y por la forma en que fabricamos nuestros productos ".Pero durante la sesión informativa, queda claro cómo la IA ha cambiado enormemente los métodos para usar el ecosistema de Apple. Los expertos en IA creen que Apple tiene limitaciones porque no tiene su propio motor de búsqueda (que podría proporcionar datos para entrenar redes neuronales) y su convicción inflexible de la necesidad de proteger la información del usuario (datos que de otro modo podrían usarse). Pero resulta que Apple ya ha descubierto cómo superar estos dos obstáculos.¿Y de qué tamaño es este cerebro, un caché dinámico que proporciona MO en iPhone? Me sorprendió que me respondieran esta pregunta. Su tamaño es de aproximadamente 200 MB, dependiendo de la cantidad de información personal almacenada (los datos antiguos siempre se eliminan). Esto incluye información sobre el uso de aplicaciones, la interacción con personas, el procesamiento de redes neuronales, la generación de voz y el "modelado de eventos de lenguaje natural". También contiene datos utilizados para redes neuronales que funcionan con reconocimiento de patrones, caras y clasificación de escenas.Y, según Apple, todo esto se hace de tal manera que su configuración, preferencias y movimientos permanecen privados.Y aunque no me explicaron todo sobre el uso de IA en la empresa, pude descubrir cómo la empresa difunde la experiencia en el MO entre los empleados de la organización. El talento de la Región de Moscú se comparte en toda la empresa, está disponible para todos los desarrolladores que se animen a usar este conocimiento para resolver problemas e inventar nuevas oportunidades para productos específicos. "No tenemos una organización dedicada, el Templo MO, en Apple", dice Craig Federigi. "Estamos tratando de mantener la información más cerca de los equipos que la utilizan para crear la experiencia de usuario correcta".¿Cuántas personas en la empresa están trabajando en MO? "Mucho", dice Federigi después de pensarlo un poco. (Si pensabas que me diría la cantidad exacta, no conoces a Apple). Es interesante que aquellas personas que no eran expertas en este tema antes de unirse a la compañía también se estén desarrollando en Apple. "Contratamos a personas que conocen bien las matemáticas, las estadísticas, la programación y la criptografía", dice Federigi. - Resulta que muchos de estos talentos se transforman perfectamente en MO. Aunque hoy, por supuesto, contratamos especialistas en la Región de Moscú, también llevamos a personas con las inclinaciones y talentos necesarios ".

"En los últimos cinco años, hemos estado observando el crecimiento de esta área en la empresa", dice Phil Schiller. "Nuestros dispositivos se están volviendo más inteligentes, y está sucediendo más rápido, especialmente con el uso de los chips de la serie A que desarrollamos. El backend se está volviendo más inteligente, más rápido, y todo lo que hacemos está conectado entre sí". Esto nos permite usar más y más técnicas de MO, porque hay mucho que aprender, pero ya está disponible para nosotros ".Y aunque Apple está luchando por usar el MO al máximo, los directores enfatizan que este proceso no es nada especial. Los jefes de Cupertin ven en el aprendizaje profundo y el MO solo otra tecnología de un flujo de tecnologías sucesivas e innovadoras. Sí, sí, está cambiando el mundo, pero no más que otros avances, como pantallas táctiles, pantallas planas u OOP. Desde el punto de vista de Apple, MO no es la última frontera, a pesar de la opinión de otras compañías. "Después de todo, no se puede decir que en los últimos años no haya habido otras tecnologías críticas para cambiar los principios de nuestra interacción con los dispositivos", dice Kew. Y nadie en la compañía quiere acercarse a discutir temas aterradores que siempre aparecen cuando se menciona la IA. Y, como era de esperar, Apple no confirma si está trabajando en vehículos robóticos o su versión de Netflix.Pero el equipo indicó claramente que Apple no está trabajando en Skynet."Utilizamos estas tecnologías para lo que siempre hemos querido hacer, y con una mejor calidad de la que era posible antes", dice Schiller. - Y por cosas nuevas que no podríamos hacer. Esta tecnología se convertirá en un método de Apple para lograr objetivos a medida que evoluciona dentro de la empresa y por la forma en que fabricamos nuestros productos ".Pero durante la sesión informativa, queda claro cómo la IA ha cambiado enormemente los métodos para usar el ecosistema de Apple. Los expertos en IA creen que Apple tiene limitaciones porque no tiene su propio motor de búsqueda (que podría proporcionar datos para entrenar redes neuronales) y su convicción inflexible de la necesidad de proteger la información del usuario (datos que de otro modo podrían usarse). Pero resulta que Apple ya ha descubierto cómo superar estos dos obstáculos.¿Y de qué tamaño es este cerebro, un caché dinámico que proporciona MO en iPhone? Me sorprendió que me respondieran esta pregunta. Su tamaño es de aproximadamente 200 MB, dependiendo de la cantidad de información personal almacenada (los datos antiguos siempre se eliminan). Esto incluye información sobre el uso de aplicaciones, la interacción con personas, el procesamiento de redes neuronales, la generación de voz y el "modelado de eventos de lenguaje natural". También contiene datos utilizados para redes neuronales que funcionan con reconocimiento de patrones, caras y clasificación de escenas.Y, según Apple, todo esto se hace de tal manera que su configuración, preferencias y movimientos permanecen privados.Y aunque no me explicaron todo sobre el uso de IA en la empresa, pude descubrir cómo la empresa difunde la experiencia en el MO entre los empleados de la organización. El talento de la Región de Moscú se comparte en toda la empresa, está disponible para todos los desarrolladores que se animen a usar este conocimiento para resolver problemas e inventar nuevas oportunidades para productos específicos. "No tenemos una organización dedicada, el Templo MO, en Apple", dice Craig Federigi. "Estamos tratando de mantener la información más cerca de los equipos que la utilizan para crear la experiencia de usuario correcta".¿Cuántas personas en la empresa están trabajando en MO? "Mucho", dice Federigi después de pensarlo un poco. (Si pensabas que me diría la cantidad exacta, no conoces a Apple). Es interesante que aquellas personas que no eran expertas en este tema antes de unirse a la compañía también se estén desarrollando en Apple. "Contratamos a personas que conocen bien las matemáticas, las estadísticas, la programación y la criptografía", dice Federigi. - Resulta que muchos de estos talentos se transforman perfectamente en MO. Aunque hoy, por supuesto, contratamos especialistas en la Región de Moscú, también llevamos a personas con las inclinaciones y talentos necesarios ". Craig Federigi, vicepresidente sénior de desarrollo de software, escucha a Alex Acero, director sénior de SiriY aunque Federigi no dice esto, este enfoque puede ser necesario: la propensión al secreto de la compañía puede ponerlo en desventaja en comparación con los competidores que alientan a sus mejores programadores a difundir los resultados de la investigación. "Nuestros métodos aumentan la dispersión de la selección natural: aquellos que necesitan trabajo en equipo y el lanzamiento de excelentes productos, sobre todo en contra de aquellos que más necesitan publicar", dice Federigi. Si los investigadores logran un gran avance en el campo mientras mejoran los productos de Apple, eso es bueno. "Pero para nosotros, el resultado final será lo principal", dice Kew.Algunas personas talentosas ingresan a la empresa después de la adquisición. "Recientemente, hemos estado comprando 20-30 pequeñas empresas al año, estamos comprometidos en la contratación de mano de obra", dice Kew. Cuando Apple compra una compañía que trabaja en IA, no lo hace porque "hay una multitud de investigadores de MO aquí, vamos a sacar un establo de ellos", dice Federigi. "Estamos buscando personas con talento pero enfocadas en crear una gran experiencia de usuario".La adquisición más reciente es Turi, una compañía con sede en Seattle que Apple compró por $ 200 millones. Crearon un juego de herramientas para MOs comparable al TensorFlow de Google, y esta adquisición generó rumores de que Apple usaría esta tecnología para propósitos similares, tanto para sí misma como para los desarrolladores. Los directores no confirman ni niegan esta información. "Algunos de sus resultados se combinaron muy bien con Apple, tanto en términos de tecnología como de personas", dice Kew. En un par de años, probablemente descubriremos qué sucedió, como sucedió cuando Siri comenzó a demostrar las capacidades predictivas de Cue (no relacionado con Eddie), el producto de la startup del mismo nombre que Apple compró en 2013.No importa de dónde provenga el talento, la infraestructura de inteligencia artificial de Apple le permite desarrollar productos y capacidades que de otro modo no serían posibles. Ella está cambiando el programa de desarrollo de productos de la compañía. "La lista de ideas geniales de Apple no tiene fin", dice Schiller. - MO nos permite recurrir a cosas que en el pasado no tocaríamos. Se fusiona con el proceso de toma de decisiones sobre productos que trataremos en el futuro ".Un ejemplo es el Apple Pencil, que funciona con el Apple Pencil. Para que este lápiz óptico de alta tecnología funcionara, la compañía tuvo que resolver el problema: cuando las personas escriben en la pantalla, la parte inferior de la palma se ejecuta en la pantalla táctil, lo que da lugar a la aparición de clics falsos. Utilizando el modelo MO para eliminar estos toques, la compañía pudo enseñar a la pantalla a distinguir el desplazamiento, el tacto y la entrada del lápiz. "Si esto no funciona al 100%, este papel de registro no es adecuado para mí, y Pencil es un mal producto", dice Federigi. Si te gusta Pencil, agradece a MO por ello.Quizás la mejor medida del progreso de MO en una empresa sería su compra más importante, Siri. Se origina en el ambicioso programa DARPA para el desarrollo de asistentes inteligentes, después del cual varios científicos fundaron la compañía para crear una aplicación utilizando esta tecnología. Steve Jobs convenció personalmente a los fundadores de la compañía de vender Apple en 2010, e insistió en que Siri se integrara en el sistema operativo. Su lanzamiento fue uno de los aspectos más destacados de la presentación del iPhone 4S en octubre de 2011. Ahora funciona no solo cuando el usuario mantiene presionado el botón de inicio o murmura "Hola Siri" (el propio MO también usa esta función, lo que permite que el iPhone escuche éter, sin poner mucha batería). La inteligencia de Siri está integrada en Apple Brain y funciona incluso cuando no dice nada.Kew describe los cuatro componentes de un producto central: reconocimiento de voz, comprensión del lenguaje natural, ejecución de comandos y recuperación. "El Ministerio de Educación ha afectado a todas estas áreas con mucha fuerza", dice.

Craig Federigi, vicepresidente sénior de desarrollo de software, escucha a Alex Acero, director sénior de SiriY aunque Federigi no dice esto, este enfoque puede ser necesario: la propensión al secreto de la compañía puede ponerlo en desventaja en comparación con los competidores que alientan a sus mejores programadores a difundir los resultados de la investigación. "Nuestros métodos aumentan la dispersión de la selección natural: aquellos que necesitan trabajo en equipo y el lanzamiento de excelentes productos, sobre todo en contra de aquellos que más necesitan publicar", dice Federigi. Si los investigadores logran un gran avance en el campo mientras mejoran los productos de Apple, eso es bueno. "Pero para nosotros, el resultado final será lo principal", dice Kew.Algunas personas talentosas ingresan a la empresa después de la adquisición. "Recientemente, hemos estado comprando 20-30 pequeñas empresas al año, estamos comprometidos en la contratación de mano de obra", dice Kew. Cuando Apple compra una compañía que trabaja en IA, no lo hace porque "hay una multitud de investigadores de MO aquí, vamos a sacar un establo de ellos", dice Federigi. "Estamos buscando personas con talento pero enfocadas en crear una gran experiencia de usuario".La adquisición más reciente es Turi, una compañía con sede en Seattle que Apple compró por $ 200 millones. Crearon un juego de herramientas para MOs comparable al TensorFlow de Google, y esta adquisición generó rumores de que Apple usaría esta tecnología para propósitos similares, tanto para sí misma como para los desarrolladores. Los directores no confirman ni niegan esta información. "Algunos de sus resultados se combinaron muy bien con Apple, tanto en términos de tecnología como de personas", dice Kew. En un par de años, probablemente descubriremos qué sucedió, como sucedió cuando Siri comenzó a demostrar las capacidades predictivas de Cue (no relacionado con Eddie), el producto de la startup del mismo nombre que Apple compró en 2013.No importa de dónde provenga el talento, la infraestructura de inteligencia artificial de Apple le permite desarrollar productos y capacidades que de otro modo no serían posibles. Ella está cambiando el programa de desarrollo de productos de la compañía. "La lista de ideas geniales de Apple no tiene fin", dice Schiller. - MO nos permite recurrir a cosas que en el pasado no tocaríamos. Se fusiona con el proceso de toma de decisiones sobre productos que trataremos en el futuro ".Un ejemplo es el Apple Pencil, que funciona con el Apple Pencil. Para que este lápiz óptico de alta tecnología funcionara, la compañía tuvo que resolver el problema: cuando las personas escriben en la pantalla, la parte inferior de la palma se ejecuta en la pantalla táctil, lo que da lugar a la aparición de clics falsos. Utilizando el modelo MO para eliminar estos toques, la compañía pudo enseñar a la pantalla a distinguir el desplazamiento, el tacto y la entrada del lápiz. "Si esto no funciona al 100%, este papel de registro no es adecuado para mí, y Pencil es un mal producto", dice Federigi. Si te gusta Pencil, agradece a MO por ello.Quizás la mejor medida del progreso de MO en una empresa sería su compra más importante, Siri. Se origina en el ambicioso programa DARPA para el desarrollo de asistentes inteligentes, después del cual varios científicos fundaron la compañía para crear una aplicación utilizando esta tecnología. Steve Jobs convenció personalmente a los fundadores de la compañía de vender Apple en 2010, e insistió en que Siri se integrara en el sistema operativo. Su lanzamiento fue uno de los aspectos más destacados de la presentación del iPhone 4S en octubre de 2011. Ahora funciona no solo cuando el usuario mantiene presionado el botón de inicio o murmura "Hola Siri" (el propio MO también usa esta función, lo que permite que el iPhone escuche éter, sin poner mucha batería). La inteligencia de Siri está integrada en Apple Brain y funciona incluso cuando no dice nada.Kew describe los cuatro componentes de un producto central: reconocimiento de voz, comprensión del lenguaje natural, ejecución de comandos y recuperación. "El Ministerio de Educación ha afectado a todas estas áreas con mucha fuerza", dice. Jefe de Ingeniería Avanzada Tom Gruber y Siri Guru, Alex AceroSiri participa en el jefe del departamento de desarrollo avanzado Tom Grubber, quien llegó a Apple junto con la adquisición principal (los cofundadores de la compañía dejaron Apple en 2011). Él dice que incluso antes de que las redes neuronales se aplicaran a Siri, recibían una gran cantidad de datos provenientes de la base de usuarios. En el futuro, estos datos sirvieron como la clave para entrenar redes neuronales. "Steve dijo que pasaremos de una aplicación piloto a cientos de millones de personas en una noche, sin pruebas beta", dice. - De repente tendremos usuarios. Nos dijeron cómo la gente llamaría a cosas relacionadas con nuestra aplicación. Esta fue la primera revolución. Y luego aparecieron las redes neuronales.La transición de Siri a redes neuronales que procesan el reconocimiento de voz coincidió con la llegada de varios expertos en inteligencia artificial, incluido Alex Acero, ahora el jefe del equipo de tecnología del habla. Acero comenzó su carrera en reconocimiento de voz en Apple a principios de los 90 y luego pasó muchos años en Microsoft Research. "Realmente me gustó trabajar allí, publiqué mucho trabajo", dice. "Pero cuando Siri salió, dije: 'Esta es una oportunidad para hacer realidad las redes neuronales profundas, para llevarlos de un estado donde cientos de personas leen sobre ellos, a uno en el que millones los usan". En otras palabras, pertenecía exactamente al tipo de científicos que Apple estaba buscando: poner el producto por encima de las publicaciones.Cuando Acero se unió a la compañía hace tres años, Apple todavía estaba en el proceso de obtener licencias para la mayoría de las tecnologías de voz de Siri de terceros, y esta situación pronto debería cambiar. Federigi señala que Apple está trabajando constantemente en este patrón. “Cuando queda claro que el campo tecnológico es necesario para nuestra capacidad de lanzar un nuevo producto con el tiempo, aumentamos nuestra capacidad interna para producir lo que queremos. Para que un producto sea excelente, necesitamos ser completamente competentes en tecnología e innovar internamente. El discurso es un gran ejemplo de cómo usamos las oportunidades disponibles desde el exterior para dar inicio al proyecto ”.El equipo comenzó a entrenar la red neuronal para reemplazar el Siri original. "Teníamos la mejor granja de GPU, trabajando todo el día", dice Acero. "Y pusimos un montón de datos en él". La versión de julio de 2014 demostró que no se desperdició todo este tiempo de procesador."El número de errores se ha reducido a la mitad en todos los idiomas, y en algunos casos, incluso más", dice Acero. "Principalmente gracias al aprendizaje profundo y nuestra optimización, no solo el algoritmo en sí, sino de acuerdo con el contexto de su trabajo en el producto final".La mención del producto final no es accidental. Apple no es el primero en utilizar el entrenamiento de redes neuronales profundas en el reconocimiento de voz. Pero Apple afirma tener la ventaja de controlar todo el desarrollo del producto y el sistema de entrega. Como Apple hace los chips ella misma, Acero tuvo la oportunidad de trabajar con su equipo de desarrollo e ingenieros que escribieron firmware para dispositivos para maximizar el rendimiento de las redes neuronales. Las necesidades del equipo de desarrollo de Siri incluso influyeron en el diseño del iPhone."No es solo silicio", agrega Federigi. - El número de micrófonos en el dispositivo, donde se encuentran. ¿Cómo configuramos hardware y micrófonos, y un conjunto de software que procesa el sonido? La interacción de las partes es importante. Esta es una gran ventaja sobre aquellos que simplemente escribieron software y vieron lo que hace ".Otra ventaja: cuando una red neuronal funciona en un producto, se puede adaptar como base de la tecnología para otros fines. MO, ayudando a Siri a entenderte, se convierte en un motor de grabación de dictado. Como resultado del trabajo de Siri, las personas descubren que sus correos electrónicos y mensajes serán más significativos si rechazan el teclado en pantalla, hacen clic en el icono del micrófono y hablan en voz alta.El segundo componente de Siri, mencionado por Kew, es la comprensión del lenguaje natural. Siri comenzó a usar MO para comprender las intenciones del usuario en noviembre de 2014, y lanzó una versión de aprendizaje profundo un año después. Y, al igual que con el reconocimiento de voz, MO ha mejorado la experiencia del usuario, especialmente en términos de una interpretación más flexible de los comandos. Por ejemplo, Kew saca un iPhone y llama a Siri. "Envíale a Jane veinte dólares a través de Square Cash", dice. Aparece un mensaje en la pantalla con una descripción de su solicitud. Luego trata de establecer la tarea de una manera diferente: "tirar veinte de mi esposa". El resultado es el mismo.Apple afirma que sin estas mejoras en Siri, sería poco probable que la versión actual de Apple TV, con control de voz sofisticado, fuera posible. Las versiones anteriores de Siri te hacían hablar clara y separadamente, la versión MO cargada no solo ofrece opciones específicas de un gran catálogo de películas y canciones, sino que también comprende los conceptos. "Muéstrame un buen thriller con Tom Hanks". (Si Siri fuera realmente inteligente, habría excluido el Código Da Vinci). "Tal oportunidad antes del advenimiento de esta tecnología no podría haber sido brindada", dice Federigi.IOS 10 está programado para lanzarse este otoño, y la voz de Siri será el último de los cuatro componentes transformados por MO. Las redes neuronales profundas han reemplazado las implementaciones anteriores realizadas bajo licencia. De hecho, las réplicas de Siri se seleccionan de la base de datos de registros recopilados en el centro de voz y cada oración se recopila en partes. Según Grubber, el aprendizaje automático suaviza las esquinas y hace que Siri se parezca más a una persona real.Acero realiza una demostración: primero la voz familiar de Siri, con notas de robot a las que estamos acostumbrados. Luego, uno nuevo, que dice "Hola, ¿cómo puedo ayudarlo?", Con fluidez cautivadora. Cual es la diferencia "Aprendizaje profundo, bebé", dice.Parece un detalle fino, pero una voz más natural puede conducir a grandes cambios. "La gente confía mejor en una mejor voz", dice Grubber. - La mejor voz atrae al usuario y lo alienta a usarlo con más frecuencia. El efecto de retorno está aumentando ".El deseo de usar Siri, y todas las mejoras realizadas gracias a MO, se están volviendo aún más importantes, porque Apple finalmente abre Siri a desarrolladores externos, y los críticos de la compañía creen que era hora de hacerlo hace mucho tiempo. Muchos notaron que Apple, cuyas docenas de socios Siri, está a la zaga de sistemas como Alexa de Amazon, que cuenta con miles de características proporcionadas por desarrolladores externos. Apple dice que compararlos es incorrecto porque los usuarios de Amazon tienen que expresar sus deseos en un idioma especial. Siri incluirá más naturalmente cosas como SquareCash o Uber. (Otro competidor, Viv, creado por otros cofundadores de Siri, también promete integración con servicios de terceros cuando la fecha de lanzamiento aún no se ha anunciado).Quizás el mayor desafío para el desarrollo de MO será tener éxito, si es necesario, para cumplir con los principios de privacidad del usuario. La compañía cifra sus datos, por lo que nadie, ni siquiera los abogados de Apple, pueden leerlos (ni siquiera el FBI, incluso con una orden judicial). Y la empresa se enorgullece de no recopilar datos de usuario con fines publicitarios.Aunque tal austeridad es encomiable desde el punto de vista de los usuarios, no ayuda a atraer a los mejores talentos de IA a la empresa. "Los expertos en MO necesitan datos", dijo un ex empleado de Apple que trabajaba para una empresa especializada en inteligencia artificial. "Pero en una posición de privacidad, Apple te obliga a trabajar con una mano atada". Puede discutir si esto es correcto o incorrecto, pero como resultado, Apple no tiene una reputación de expertos en inteligencia artificial realmente geniales ".Hay dos problemas El primero es el procesamiento de información personal en sistemas basados en MO. Cuando los datos personales de un usuario pasan a través de una piedra de molino de procesamiento de redes neuronales, ¿qué sucede con esta información? El segundo problema consiste en reunir la información necesaria para entrenar redes neuronales para reconocer el comportamiento. ¿Cómo se puede hacer esto sin recopilar información personal del usuario?Apple cree que tiene soluciones. "Algunas personas piensan que no podemos hacer esto con IA porque no tenemos datos", dice Kew. "Pero encontramos formas de obtener los datos que necesitamos, manteniendo la privacidad". Así ".Apple resuelve el primer problema aprovechando la capacidad de controlar tanto el software como el hardware. La información más personal permanece dentro de Apple Brain. "Almacenamos las cosas más sensibles donde el MO ocurre localmente con respecto al dispositivo", dice Federigi. Como ejemplo, da predicciones de las aplicaciones que se ejecutarán, iconos que aparecen al deslizar la pantalla hacia la derecha. Estas predicciones se basan en muchos factores, algunos de los cuales dependen solo de su comportamiento. Y funcionan: Federigi dice que el 90% de las veces las personas encuentran lo que necesitan en estas predicciones. Todos los cálculos que Apple realiza directamente en el teléfono.Además, el dispositivo almacena, posiblemente, la información más personal recibida por la empresa: palabras utilizadas por personas en el teclado QuickType de iPhone. Utilizando un sistema de entrenamiento de red neuronal que monitorea su entrada, Apple puede reconocer eventos y momentos clave, como información sobre viajes aéreos, contactos, reuniones, pero la información en sí misma permanece en su teléfono. Incluso en las copias de seguridad almacenadas en la nube, se diluye de tal manera que no se puede obtener de una sola copia de seguridad. "No queremos que esta información se almacene en nuestros servidores", dice Federigi. "Apple no necesita conocer tus hábitos, ni dónde y cuándo vas".Apple está tratando de minimizar la información almacenada. Federigi dio un ejemplo en el que puede tener una conversación, y alguien en ella mencionará un término adecuado para la búsqueda. Otras compañías podrían analizar toda la conversación en la nube para encontrar estos términos, pero el dispositivo Apple puede reconocerlos para que los datos no abandonen al usuario, porque el sistema busca constantemente coincidencias en la base de conocimiento almacenada en el teléfono (es parte de 200 MB "Cerebro").“La base es compacta, pero integral, con cientos de miles de ubicaciones y objetos. Lo localizamos porque sabemos dónde estás ”, dice Federigi. Todas las aplicaciones de Apple acceden a la base de datos, incluidos los motores de búsqueda Spotlight, Maps y Safari. Ayuda a corregir errores automáticamente. "Y funciona constantemente en segundo plano", dice.A partir de iOS 10, Apple utilizará la nueva tecnología de privacidad diferenciada, que permite la información de crowdsourcing para que no pueda identificar a las personas. Estas pueden ser palabras que han ganado popularidad que no están en la base de datos, enlaces que ofrecen respuestas más relevantes a las consultas o una forma de usar ciertos emojis. "Por lo general, en la industria se acostumbra enviar todas las palabras y símbolos que ingresa a los servidores de la compañía para que luego los profundicen y noten algo interesante", dice Federigi. "Ciframos información desde y hacia, por lo que no lo hacemos". Aunque la privacidad diferenciada se originó en la comunidad de investigación, Apple está tratando de presentarla a las masas. "La estamos transfiriendo del departamento de investigación a mil millones de usuarios", dice Kew.Y aunque está claro que MO ha cambiado los productos de Apple, aún no está claro si ha cambiado la compañía misma. En cierto sentido, el enfoque que usa MO está en conflicto con el espíritu de la empresa. Apple monitorea cuidadosamente la experiencia del usuario, hasta sensores que miden la conductividad en pantalla. Todo está planeado de antemano y codificado con precisión. Pero cuando usan MO, los ingenieros tienen que dar un paso atrás y darle al software la oportunidad de buscar soluciones por su cuenta. ¿Puede Apple adaptarse a la realidad moderna, en la que los sistemas con MO pueden participar en el diseño del producto?"Esta es la causa de mucha controversia en la empresa", dice Federigi. - Estamos acostumbrados a ofrecer una experiencia muy reflexiva y controlada en la que controlamos todas las dimensiones de cómo se comunica el sistema con el usuario. Cuando comienza a entrenar un sistema basado en un gran conjunto de datos sobre el comportamiento humano, los resultados obtenidos pueden no coincidir con la idea del diseñador. Aparecen según los datos ".Pero Apple no va a dar marcha atrás, dice Schiller. "Aunque tales tecnologías, por supuesto, influyen en el desarrollo de productos, al final las usamos para producir mejores productos".Como resultado, es posible que Apple no haga anuncios de encabezado sobre la inmersión en MO, pero utilizará tantos MO como sea posible para mejorar los productos. El cerebro en tu teléfono lo prueba."Un usuario típico experimentará un aprendizaje profundo a diario, y esto ilustra lo que le gusta de los productos de Apple", dice Schiller. "Los momentos más geniales son tan sutiles que solo piensas en ellos después de una tercera reunión con ellos, y luego te detienes y exclamas: '¿Cómo es esto posible?"Skynet esperará.

Jefe de Ingeniería Avanzada Tom Gruber y Siri Guru, Alex AceroSiri participa en el jefe del departamento de desarrollo avanzado Tom Grubber, quien llegó a Apple junto con la adquisición principal (los cofundadores de la compañía dejaron Apple en 2011). Él dice que incluso antes de que las redes neuronales se aplicaran a Siri, recibían una gran cantidad de datos provenientes de la base de usuarios. En el futuro, estos datos sirvieron como la clave para entrenar redes neuronales. "Steve dijo que pasaremos de una aplicación piloto a cientos de millones de personas en una noche, sin pruebas beta", dice. - De repente tendremos usuarios. Nos dijeron cómo la gente llamaría a cosas relacionadas con nuestra aplicación. Esta fue la primera revolución. Y luego aparecieron las redes neuronales.La transición de Siri a redes neuronales que procesan el reconocimiento de voz coincidió con la llegada de varios expertos en inteligencia artificial, incluido Alex Acero, ahora el jefe del equipo de tecnología del habla. Acero comenzó su carrera en reconocimiento de voz en Apple a principios de los 90 y luego pasó muchos años en Microsoft Research. "Realmente me gustó trabajar allí, publiqué mucho trabajo", dice. "Pero cuando Siri salió, dije: 'Esta es una oportunidad para hacer realidad las redes neuronales profundas, para llevarlos de un estado donde cientos de personas leen sobre ellos, a uno en el que millones los usan". En otras palabras, pertenecía exactamente al tipo de científicos que Apple estaba buscando: poner el producto por encima de las publicaciones.Cuando Acero se unió a la compañía hace tres años, Apple todavía estaba en el proceso de obtener licencias para la mayoría de las tecnologías de voz de Siri de terceros, y esta situación pronto debería cambiar. Federigi señala que Apple está trabajando constantemente en este patrón. “Cuando queda claro que el campo tecnológico es necesario para nuestra capacidad de lanzar un nuevo producto con el tiempo, aumentamos nuestra capacidad interna para producir lo que queremos. Para que un producto sea excelente, necesitamos ser completamente competentes en tecnología e innovar internamente. El discurso es un gran ejemplo de cómo usamos las oportunidades disponibles desde el exterior para dar inicio al proyecto ”.El equipo comenzó a entrenar la red neuronal para reemplazar el Siri original. "Teníamos la mejor granja de GPU, trabajando todo el día", dice Acero. "Y pusimos un montón de datos en él". La versión de julio de 2014 demostró que no se desperdició todo este tiempo de procesador."El número de errores se ha reducido a la mitad en todos los idiomas, y en algunos casos, incluso más", dice Acero. "Principalmente gracias al aprendizaje profundo y nuestra optimización, no solo el algoritmo en sí, sino de acuerdo con el contexto de su trabajo en el producto final".La mención del producto final no es accidental. Apple no es el primero en utilizar el entrenamiento de redes neuronales profundas en el reconocimiento de voz. Pero Apple afirma tener la ventaja de controlar todo el desarrollo del producto y el sistema de entrega. Como Apple hace los chips ella misma, Acero tuvo la oportunidad de trabajar con su equipo de desarrollo e ingenieros que escribieron firmware para dispositivos para maximizar el rendimiento de las redes neuronales. Las necesidades del equipo de desarrollo de Siri incluso influyeron en el diseño del iPhone."No es solo silicio", agrega Federigi. - El número de micrófonos en el dispositivo, donde se encuentran. ¿Cómo configuramos hardware y micrófonos, y un conjunto de software que procesa el sonido? La interacción de las partes es importante. Esta es una gran ventaja sobre aquellos que simplemente escribieron software y vieron lo que hace ".Otra ventaja: cuando una red neuronal funciona en un producto, se puede adaptar como base de la tecnología para otros fines. MO, ayudando a Siri a entenderte, se convierte en un motor de grabación de dictado. Como resultado del trabajo de Siri, las personas descubren que sus correos electrónicos y mensajes serán más significativos si rechazan el teclado en pantalla, hacen clic en el icono del micrófono y hablan en voz alta.El segundo componente de Siri, mencionado por Kew, es la comprensión del lenguaje natural. Siri comenzó a usar MO para comprender las intenciones del usuario en noviembre de 2014, y lanzó una versión de aprendizaje profundo un año después. Y, al igual que con el reconocimiento de voz, MO ha mejorado la experiencia del usuario, especialmente en términos de una interpretación más flexible de los comandos. Por ejemplo, Kew saca un iPhone y llama a Siri. "Envíale a Jane veinte dólares a través de Square Cash", dice. Aparece un mensaje en la pantalla con una descripción de su solicitud. Luego trata de establecer la tarea de una manera diferente: "tirar veinte de mi esposa". El resultado es el mismo.Apple afirma que sin estas mejoras en Siri, sería poco probable que la versión actual de Apple TV, con control de voz sofisticado, fuera posible. Las versiones anteriores de Siri te hacían hablar clara y separadamente, la versión MO cargada no solo ofrece opciones específicas de un gran catálogo de películas y canciones, sino que también comprende los conceptos. "Muéstrame un buen thriller con Tom Hanks". (Si Siri fuera realmente inteligente, habría excluido el Código Da Vinci). "Tal oportunidad antes del advenimiento de esta tecnología no podría haber sido brindada", dice Federigi.IOS 10 está programado para lanzarse este otoño, y la voz de Siri será el último de los cuatro componentes transformados por MO. Las redes neuronales profundas han reemplazado las implementaciones anteriores realizadas bajo licencia. De hecho, las réplicas de Siri se seleccionan de la base de datos de registros recopilados en el centro de voz y cada oración se recopila en partes. Según Grubber, el aprendizaje automático suaviza las esquinas y hace que Siri se parezca más a una persona real.Acero realiza una demostración: primero la voz familiar de Siri, con notas de robot a las que estamos acostumbrados. Luego, uno nuevo, que dice "Hola, ¿cómo puedo ayudarlo?", Con fluidez cautivadora. Cual es la diferencia "Aprendizaje profundo, bebé", dice.Parece un detalle fino, pero una voz más natural puede conducir a grandes cambios. "La gente confía mejor en una mejor voz", dice Grubber. - La mejor voz atrae al usuario y lo alienta a usarlo con más frecuencia. El efecto de retorno está aumentando ".El deseo de usar Siri, y todas las mejoras realizadas gracias a MO, se están volviendo aún más importantes, porque Apple finalmente abre Siri a desarrolladores externos, y los críticos de la compañía creen que era hora de hacerlo hace mucho tiempo. Muchos notaron que Apple, cuyas docenas de socios Siri, está a la zaga de sistemas como Alexa de Amazon, que cuenta con miles de características proporcionadas por desarrolladores externos. Apple dice que compararlos es incorrecto porque los usuarios de Amazon tienen que expresar sus deseos en un idioma especial. Siri incluirá más naturalmente cosas como SquareCash o Uber. (Otro competidor, Viv, creado por otros cofundadores de Siri, también promete integración con servicios de terceros cuando la fecha de lanzamiento aún no se ha anunciado).Quizás el mayor desafío para el desarrollo de MO será tener éxito, si es necesario, para cumplir con los principios de privacidad del usuario. La compañía cifra sus datos, por lo que nadie, ni siquiera los abogados de Apple, pueden leerlos (ni siquiera el FBI, incluso con una orden judicial). Y la empresa se enorgullece de no recopilar datos de usuario con fines publicitarios.Aunque tal austeridad es encomiable desde el punto de vista de los usuarios, no ayuda a atraer a los mejores talentos de IA a la empresa. "Los expertos en MO necesitan datos", dijo un ex empleado de Apple que trabajaba para una empresa especializada en inteligencia artificial. "Pero en una posición de privacidad, Apple te obliga a trabajar con una mano atada". Puede discutir si esto es correcto o incorrecto, pero como resultado, Apple no tiene una reputación de expertos en inteligencia artificial realmente geniales ".Hay dos problemas El primero es el procesamiento de información personal en sistemas basados en MO. Cuando los datos personales de un usuario pasan a través de una piedra de molino de procesamiento de redes neuronales, ¿qué sucede con esta información? El segundo problema consiste en reunir la información necesaria para entrenar redes neuronales para reconocer el comportamiento. ¿Cómo se puede hacer esto sin recopilar información personal del usuario?Apple cree que tiene soluciones. "Algunas personas piensan que no podemos hacer esto con IA porque no tenemos datos", dice Kew. "Pero encontramos formas de obtener los datos que necesitamos, manteniendo la privacidad". Así ".Apple resuelve el primer problema aprovechando la capacidad de controlar tanto el software como el hardware. La información más personal permanece dentro de Apple Brain. "Almacenamos las cosas más sensibles donde el MO ocurre localmente con respecto al dispositivo", dice Federigi. Como ejemplo, da predicciones de las aplicaciones que se ejecutarán, iconos que aparecen al deslizar la pantalla hacia la derecha. Estas predicciones se basan en muchos factores, algunos de los cuales dependen solo de su comportamiento. Y funcionan: Federigi dice que el 90% de las veces las personas encuentran lo que necesitan en estas predicciones. Todos los cálculos que Apple realiza directamente en el teléfono.Además, el dispositivo almacena, posiblemente, la información más personal recibida por la empresa: palabras utilizadas por personas en el teclado QuickType de iPhone. Utilizando un sistema de entrenamiento de red neuronal que monitorea su entrada, Apple puede reconocer eventos y momentos clave, como información sobre viajes aéreos, contactos, reuniones, pero la información en sí misma permanece en su teléfono. Incluso en las copias de seguridad almacenadas en la nube, se diluye de tal manera que no se puede obtener de una sola copia de seguridad. "No queremos que esta información se almacene en nuestros servidores", dice Federigi. "Apple no necesita conocer tus hábitos, ni dónde y cuándo vas".Apple está tratando de minimizar la información almacenada. Federigi dio un ejemplo en el que puede tener una conversación, y alguien en ella mencionará un término adecuado para la búsqueda. Otras compañías podrían analizar toda la conversación en la nube para encontrar estos términos, pero el dispositivo Apple puede reconocerlos para que los datos no abandonen al usuario, porque el sistema busca constantemente coincidencias en la base de conocimiento almacenada en el teléfono (es parte de 200 MB "Cerebro").“La base es compacta, pero integral, con cientos de miles de ubicaciones y objetos. Lo localizamos porque sabemos dónde estás ”, dice Federigi. Todas las aplicaciones de Apple acceden a la base de datos, incluidos los motores de búsqueda Spotlight, Maps y Safari. Ayuda a corregir errores automáticamente. "Y funciona constantemente en segundo plano", dice.A partir de iOS 10, Apple utilizará la nueva tecnología de privacidad diferenciada, que permite la información de crowdsourcing para que no pueda identificar a las personas. Estas pueden ser palabras que han ganado popularidad que no están en la base de datos, enlaces que ofrecen respuestas más relevantes a las consultas o una forma de usar ciertos emojis. "Por lo general, en la industria se acostumbra enviar todas las palabras y símbolos que ingresa a los servidores de la compañía para que luego los profundicen y noten algo interesante", dice Federigi. "Ciframos información desde y hacia, por lo que no lo hacemos". Aunque la privacidad diferenciada se originó en la comunidad de investigación, Apple está tratando de presentarla a las masas. "La estamos transfiriendo del departamento de investigación a mil millones de usuarios", dice Kew.Y aunque está claro que MO ha cambiado los productos de Apple, aún no está claro si ha cambiado la compañía misma. En cierto sentido, el enfoque que usa MO está en conflicto con el espíritu de la empresa. Apple monitorea cuidadosamente la experiencia del usuario, hasta sensores que miden la conductividad en pantalla. Todo está planeado de antemano y codificado con precisión. Pero cuando usan MO, los ingenieros tienen que dar un paso atrás y darle al software la oportunidad de buscar soluciones por su cuenta. ¿Puede Apple adaptarse a la realidad moderna, en la que los sistemas con MO pueden participar en el diseño del producto?"Esta es la causa de mucha controversia en la empresa", dice Federigi. - Estamos acostumbrados a ofrecer una experiencia muy reflexiva y controlada en la que controlamos todas las dimensiones de cómo se comunica el sistema con el usuario. Cuando comienza a entrenar un sistema basado en un gran conjunto de datos sobre el comportamiento humano, los resultados obtenidos pueden no coincidir con la idea del diseñador. Aparecen según los datos ".Pero Apple no va a dar marcha atrás, dice Schiller. "Aunque tales tecnologías, por supuesto, influyen en el desarrollo de productos, al final las usamos para producir mejores productos".Como resultado, es posible que Apple no haga anuncios de encabezado sobre la inmersión en MO, pero utilizará tantos MO como sea posible para mejorar los productos. El cerebro en tu teléfono lo prueba."Un usuario típico experimentará un aprendizaje profundo a diario, y esto ilustra lo que le gusta de los productos de Apple", dice Schiller. "Los momentos más geniales son tan sutiles que solo piensas en ellos después de una tercera reunión con ellos, y luego te detienes y exclamas: '¿Cómo es esto posible?"Skynet esperará.Source: https://habr.com/ru/post/es397331/

All Articles