Gracias por la memoria: cómo la memoria barata cambia la informática

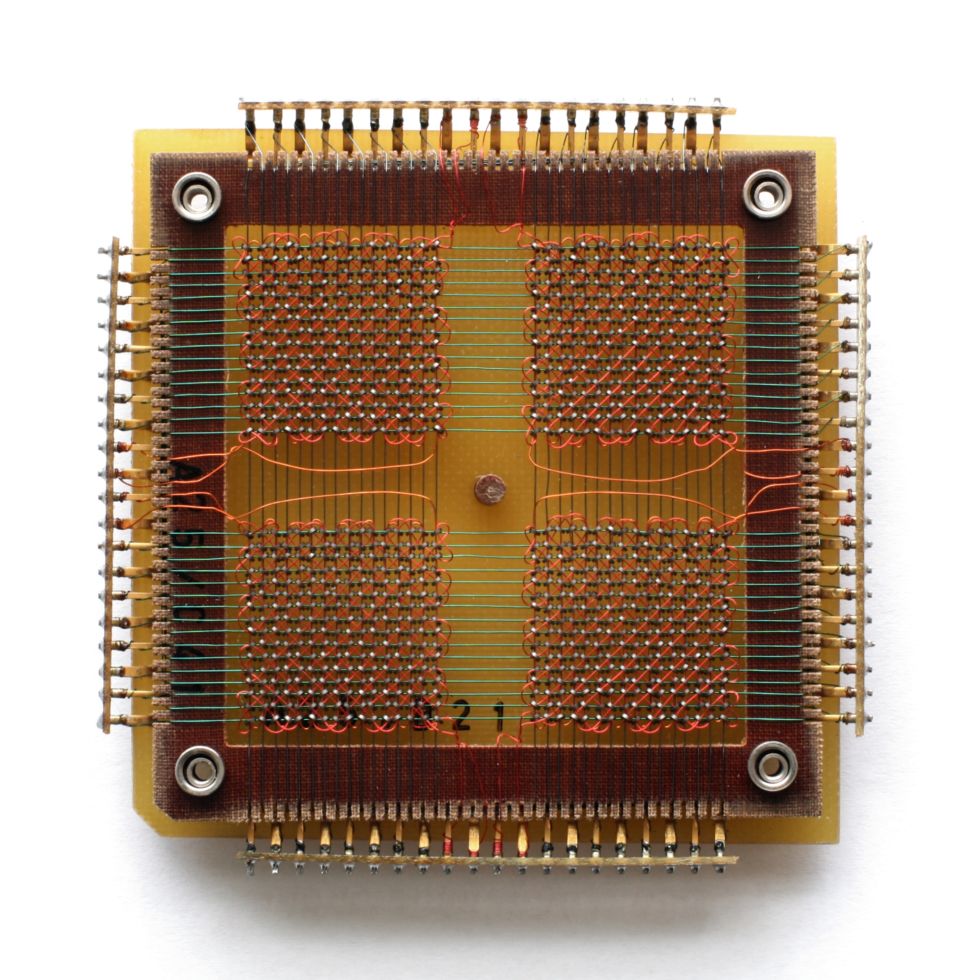

La DRAM Micron temprana con una capacidad de 1 MbitRAM (memoria de acceso aleatorio, memoria de acceso aleatorio) está presente en cualquier sistema informático, desde pequeños controladores integrados hasta servidores industriales. Los datos se almacenan en SRAM (RAM estática) o DRAM (RAM dinámica) mientras el procesador trabaja con ellos. Con la caída en los precios de RAM, el modelo para mover datos entre RAM y una ubicación de almacenamiento permanente puede desaparecer.La RAM está fuertemente influenciada por las fluctuaciones del mercado, pero a la larga su valor baja. En 2000, un gigabyte de memoria costaba más de $ 1000, y ahora solo cuesta $ 5. Esto nos permite imaginar una arquitectura de sistema completamente diferente.Las bases de datos generalmente se almacenan en discos, desde donde la información necesaria se lee en la memoria, si es necesario, y luego se procesa. En general, se cree que la cantidad de memoria en un sistema es varios órdenes de magnitud menor que el volumen de los discos, por ejemplo, gigabytes versus terabytes. Pero con el aumento de la memoria se vuelve más eficiente cargar más datos en la memoria, reduciendo el número de lecturas y escrituras. Con una disminución en el costo de la RAM, es posible cargar toda la base de datos en la memoria, realizar operaciones en ellos y volver a escribirlos. Ahora hemos llegado al punto en que algunas bases de datos no se vuelven a escribir en el disco, y permanentemente se quedan en la memoria.

La DRAM Micron temprana con una capacidad de 1 MbitRAM (memoria de acceso aleatorio, memoria de acceso aleatorio) está presente en cualquier sistema informático, desde pequeños controladores integrados hasta servidores industriales. Los datos se almacenan en SRAM (RAM estática) o DRAM (RAM dinámica) mientras el procesador trabaja con ellos. Con la caída en los precios de RAM, el modelo para mover datos entre RAM y una ubicación de almacenamiento permanente puede desaparecer.La RAM está fuertemente influenciada por las fluctuaciones del mercado, pero a la larga su valor baja. En 2000, un gigabyte de memoria costaba más de $ 1000, y ahora solo cuesta $ 5. Esto nos permite imaginar una arquitectura de sistema completamente diferente.Las bases de datos generalmente se almacenan en discos, desde donde la información necesaria se lee en la memoria, si es necesario, y luego se procesa. En general, se cree que la cantidad de memoria en un sistema es varios órdenes de magnitud menor que el volumen de los discos, por ejemplo, gigabytes versus terabytes. Pero con el aumento de la memoria se vuelve más eficiente cargar más datos en la memoria, reduciendo el número de lecturas y escrituras. Con una disminución en el costo de la RAM, es posible cargar toda la base de datos en la memoria, realizar operaciones en ellos y volver a escribirlos. Ahora hemos llegado al punto en que algunas bases de datos no se vuelven a escribir en el disco, y permanentemente se quedan en la memoria. Chip de megabits de Carl Zeiss

Chip de megabits de Carl Zeiss Hasta 1975, la RAM era un

Hasta 1975, la RAM era un chip EPROM de 4 megabytes de memoria de núcleo magnético borrado mediante radiación ultravioleta enviada a través de una ventana.

chip EPROM de 4 megabytes de memoria de núcleo magnético borrado mediante radiación ultravioleta enviada a través de una ventana. Un montón develocidades de acceso de memoria DRAM modernas se miden en nanosegundos, y los tiempos de acceso al disco se miden en milisegundos, es decir. , la memoria es un millón de veces más rápida. La velocidad de transferencia de datos en la memoria, por supuesto, no es un millón de veces más rápida: estos son gigabytes por segundo frente a varios cientos de megabytes por segundo para disco duro rápido, pero al menos la velocidad de RAM excede la velocidad de las unidades en un orden de magnitud.En el mundo real, las diferencias no son tan serias, pero leer datos de un disco en la RAM y volver a escribirlos es un serio cuello de botella, así como un campo para que aparezcan errores. La desaparición de este paso conduce a una simplificación de las instrucciones, un aumento en la simplicidad y la eficiencia.Con la caída en los precios de RAM en grandes empresas y centros de datos, se ha vuelto popular proporcionar servidores con terabytes de memoria. Pero, aparte del tamaño, la base de datos en la memoria generalmente no desea mantenerse por razones de confiabilidad. RAM pierde contenido cuando se interrumpe un corte de energía o un sistema. Estos problemas se encuentran cuando se intenta cumplir con el estándar de confiabilidad de la base de datos ACID (atomicidad, consistencia, aislamiento, durabilidad: atomicidad, coherencia, aislamiento, durabilidad).Los problemas se pueden evitar con moldes y troncos. Del mismo modo que puede hacer copias de seguridad de bases de datos desde discos, las bases de datos en memoria se pueden copiar en el almacenamiento. La creación de conversiones evita que otros procesos lean datos, por lo que la frecuencia de los puntos de interrupción es un compromiso entre la velocidad y la confiabilidad. Y esto, a su vez, se puede suavizar registrando transacciones o registrando, registrando cambios en los datos para que se pueda recrear un estado posterior a partir de una copia anterior. Pero aún así, cuando la base de datos está completamente en la memoria, se pierde un cierto porcentaje de redundancia.Los programas para administrar bases de datos en memoria (IMDBS) le permiten crear sistemas híbridos en los que algunas tablas de bases de datos están en memoria y otras viven en disco. Esto es mejor que el almacenamiento en caché, y es conveniente en casos en los que no tiene sentido mantener toda la base de datos en la memoria.Las bases de datos se pueden comprimir, especialmente en sistemas con columnas que almacenan tablas como conjuntos de columnas en lugar de filas. La mayoría de las tecnologías de compresión prefieren que los datos vecinos sean del mismo tipo, y las columnas en las tablas casi siempre contienen datos del mismo tipo. Y aunque la compresión implica aumentar la carga en la informática, el almacenamiento de columnas es muy adecuado para consultas complejas en conjuntos de datos muy grandes; es por eso que los usuarios de grandes datos y los científicos están interesados en ellos .A gran escala, empresas como Google han cambiado a RAM para que una gran cantidad de consultas de búsqueda se procesen a una velocidad aceptable. También hay problemas para proporcionar acceso a grandes cantidades de memoria, ya que la cantidad de RAM conectada a una placa base es limitada, y la organización del acceso compartido genera demoras adicionales.

Un montón develocidades de acceso de memoria DRAM modernas se miden en nanosegundos, y los tiempos de acceso al disco se miden en milisegundos, es decir. , la memoria es un millón de veces más rápida. La velocidad de transferencia de datos en la memoria, por supuesto, no es un millón de veces más rápida: estos son gigabytes por segundo frente a varios cientos de megabytes por segundo para disco duro rápido, pero al menos la velocidad de RAM excede la velocidad de las unidades en un orden de magnitud.En el mundo real, las diferencias no son tan serias, pero leer datos de un disco en la RAM y volver a escribirlos es un serio cuello de botella, así como un campo para que aparezcan errores. La desaparición de este paso conduce a una simplificación de las instrucciones, un aumento en la simplicidad y la eficiencia.Con la caída en los precios de RAM en grandes empresas y centros de datos, se ha vuelto popular proporcionar servidores con terabytes de memoria. Pero, aparte del tamaño, la base de datos en la memoria generalmente no desea mantenerse por razones de confiabilidad. RAM pierde contenido cuando se interrumpe un corte de energía o un sistema. Estos problemas se encuentran cuando se intenta cumplir con el estándar de confiabilidad de la base de datos ACID (atomicidad, consistencia, aislamiento, durabilidad: atomicidad, coherencia, aislamiento, durabilidad).Los problemas se pueden evitar con moldes y troncos. Del mismo modo que puede hacer copias de seguridad de bases de datos desde discos, las bases de datos en memoria se pueden copiar en el almacenamiento. La creación de conversiones evita que otros procesos lean datos, por lo que la frecuencia de los puntos de interrupción es un compromiso entre la velocidad y la confiabilidad. Y esto, a su vez, se puede suavizar registrando transacciones o registrando, registrando cambios en los datos para que se pueda recrear un estado posterior a partir de una copia anterior. Pero aún así, cuando la base de datos está completamente en la memoria, se pierde un cierto porcentaje de redundancia.Los programas para administrar bases de datos en memoria (IMDBS) le permiten crear sistemas híbridos en los que algunas tablas de bases de datos están en memoria y otras viven en disco. Esto es mejor que el almacenamiento en caché, y es conveniente en casos en los que no tiene sentido mantener toda la base de datos en la memoria.Las bases de datos se pueden comprimir, especialmente en sistemas con columnas que almacenan tablas como conjuntos de columnas en lugar de filas. La mayoría de las tecnologías de compresión prefieren que los datos vecinos sean del mismo tipo, y las columnas en las tablas casi siempre contienen datos del mismo tipo. Y aunque la compresión implica aumentar la carga en la informática, el almacenamiento de columnas es muy adecuado para consultas complejas en conjuntos de datos muy grandes; es por eso que los usuarios de grandes datos y los científicos están interesados en ellos .A gran escala, empresas como Google han cambiado a RAM para que una gran cantidad de consultas de búsqueda se procesen a una velocidad aceptable. También hay problemas para proporcionar acceso a grandes cantidades de memoria, ya que la cantidad de RAM conectada a una placa base es limitada, y la organización del acceso compartido genera demoras adicionales.La vida después de la RAM

Pero no puede garantizar que trabajar con datos en la memoria sea el futuro del procesamiento de datos. Un método alternativo es el uso de RAM no volátil (RAM no volátil, NVRAM), familiar para los usuarios en forma de SSD , que ofrece una arquitectura compatible con los sistemas de disco. Ahora funcionan con memoria flash NAND, que ofrece altas velocidades de lectura y escritura en comparación con los discos duros mecánicos. Pero ella tiene sus propios problemas. La memoria flash requiere voltajes relativamente altos para registrar datos, y se degenera gradualmente, contra los cuales se llama a los algoritmos especiales para luchar, lo que conduce a una desaceleración gradual de la operación. El costo de la memoria y el almacenamiento a lo largo del tiempo (dólares por megabyte)Como puede ver en el gráfico, con el tiempo, el costo de las unidades disminuye aproximadamente lo mismo que el costo de la RAM. El costo decreciente de los SSD ha llevado a su distribución en centros de datos y lugares de trabajo, pero hasta ahora no está claro cuál es el futuro de esta tecnología. Un estudio de Google publicado en febrero de 2016, basado en seis años de uso, concluyó que la memoria flash es mucho menos confiable que los discos duros, por ejemplo, produce errores fatales, aunque requiere reemplazos más raros. Y los SSD para uso corporativo no difieren en calidad de las opciones del consumidor.Pero ya están apareciendo nuevos tipos de NVRAM. La RAM ferroeléctrica (FRAM) alguna vez se suponía que era un reemplazo de RAM y unidades flash en dispositivos móviles, pero ahora la atención se ha desplazado a la RAM magnetoresistiva (MRAM). En términos de velocidad, se acerca a la RAM, y el retraso de acceso es de 50 nanosegundos: es más lento que 10 ns en DRAM, pero 1000 veces más rápido que microsegundos en NAND.

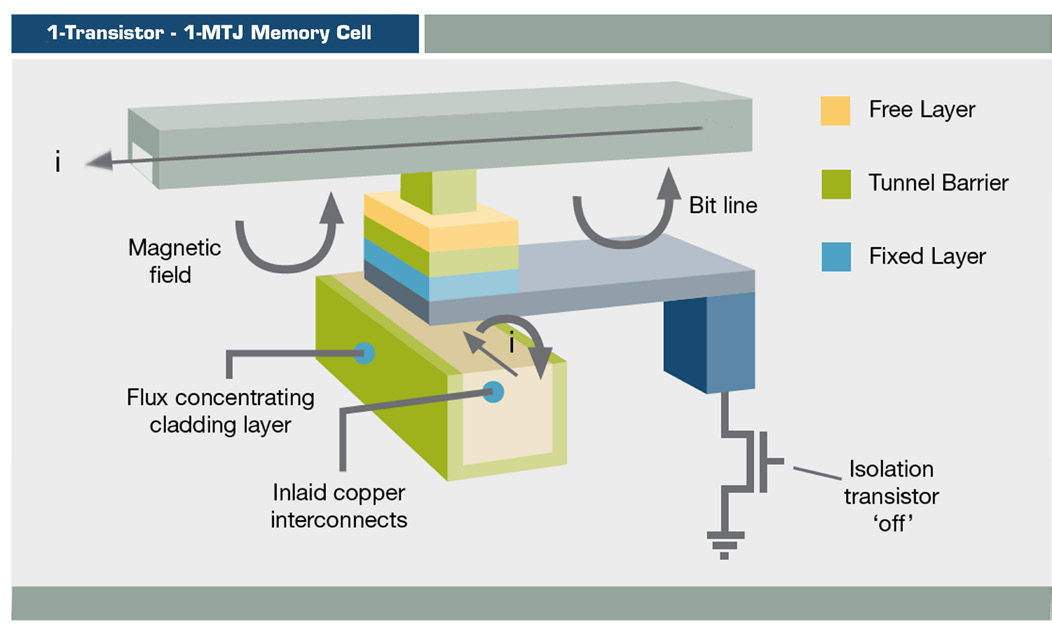

El costo de la memoria y el almacenamiento a lo largo del tiempo (dólares por megabyte)Como puede ver en el gráfico, con el tiempo, el costo de las unidades disminuye aproximadamente lo mismo que el costo de la RAM. El costo decreciente de los SSD ha llevado a su distribución en centros de datos y lugares de trabajo, pero hasta ahora no está claro cuál es el futuro de esta tecnología. Un estudio de Google publicado en febrero de 2016, basado en seis años de uso, concluyó que la memoria flash es mucho menos confiable que los discos duros, por ejemplo, produce errores fatales, aunque requiere reemplazos más raros. Y los SSD para uso corporativo no difieren en calidad de las opciones del consumidor.Pero ya están apareciendo nuevos tipos de NVRAM. La RAM ferroeléctrica (FRAM) alguna vez se suponía que era un reemplazo de RAM y unidades flash en dispositivos móviles, pero ahora la atención se ha desplazado a la RAM magnetoresistiva (MRAM). En términos de velocidad, se acerca a la RAM, y el retraso de acceso es de 50 nanosegundos: es más lento que 10 ns en DRAM, pero 1000 veces más rápido que microsegundos en NAND. Esquema MRAM MRAMalmacena información utilizando orientación magnética en lugar de carga eléctrica, utilizando una estructura de película delgada y una unión de túnel magnético. La conmutación MRAM ya se usa en productos como los arreglos de almacenamiento EqualLogic de Dell, pero hasta ahora solo para el registro en diario.Spin Transfer MRAM (ST-MRAM) utiliza una estructura más compleja que potencialmente permite un aumento de la densidad. Ahora Everspin lo lanza al mercado, recientemente lanzado en NASDAQ bajo el código MRAM. Otras empresas que exploran esta oportunidad son Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) y Toshiba.

Esquema MRAM MRAMalmacena información utilizando orientación magnética en lugar de carga eléctrica, utilizando una estructura de película delgada y una unión de túnel magnético. La conmutación MRAM ya se usa en productos como los arreglos de almacenamiento EqualLogic de Dell, pero hasta ahora solo para el registro en diario.Spin Transfer MRAM (ST-MRAM) utiliza una estructura más compleja que potencialmente permite un aumento de la densidad. Ahora Everspin lo lanza al mercado, recientemente lanzado en NASDAQ bajo el código MRAM. Otras empresas que exploran esta oportunidad son Crocus, Micron, Qualcomm, Samsung, Spin Transfer Technologies (STT) y Toshiba. Memoria 3D XPoint

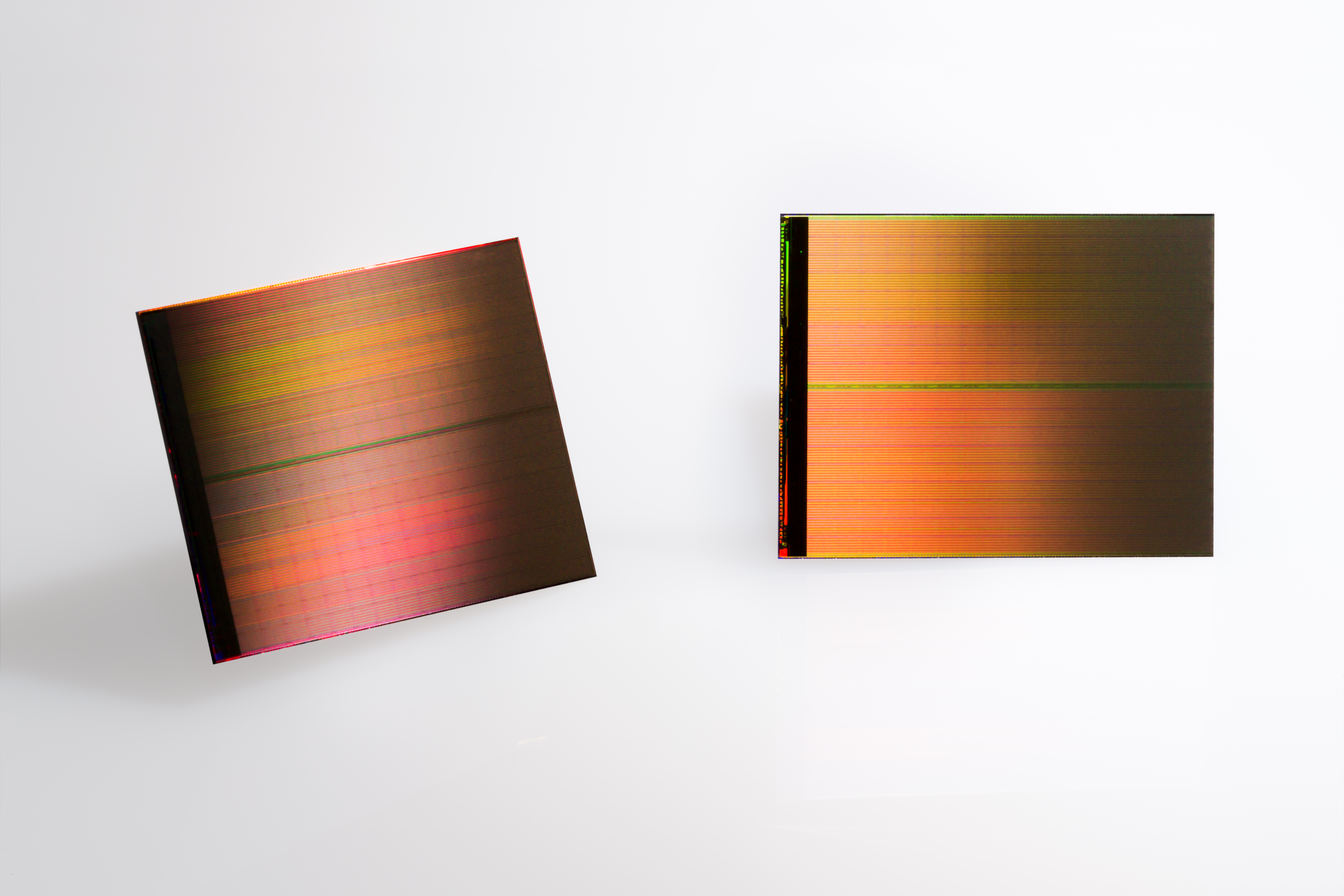

Memoria 3D XPoint Dos chips 3D XPoint de 128 GB

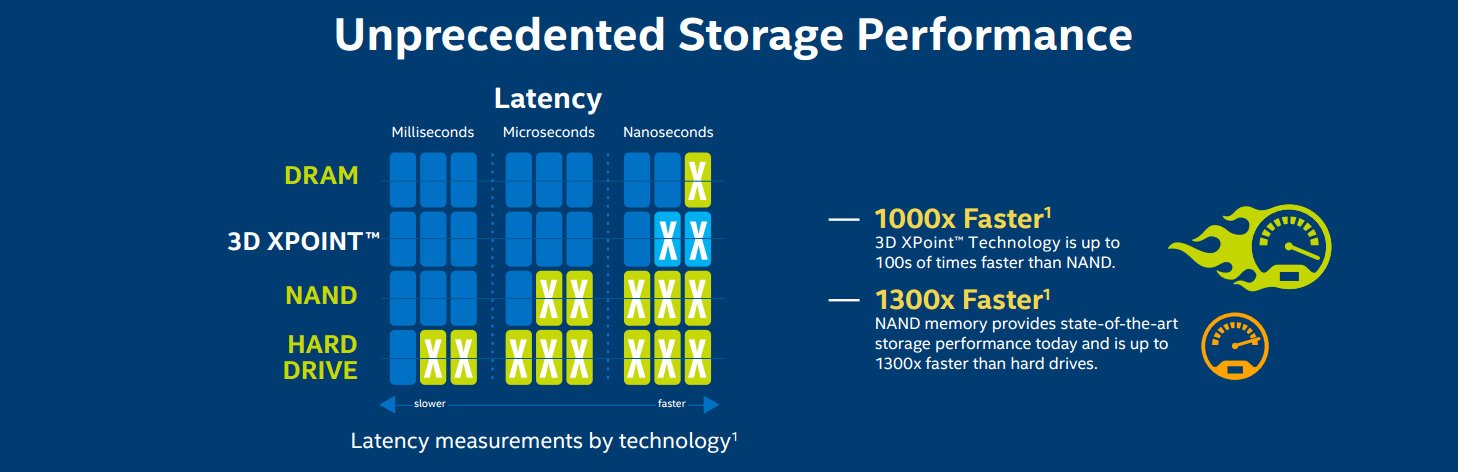

Dos chips 3D XPoint de 128 GB Diagrama para Intel / Micron Comparación de velocidad 3D XPoint

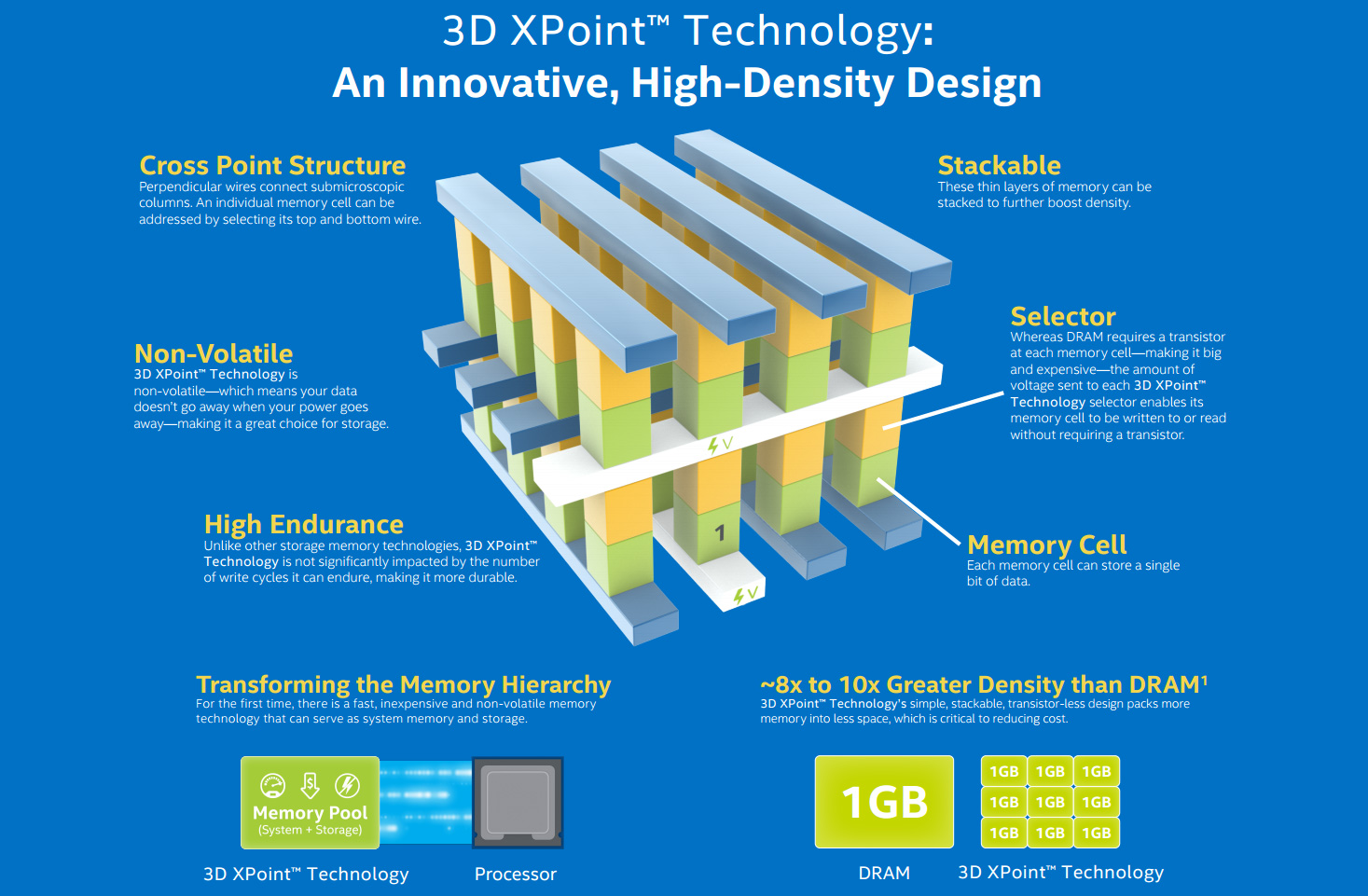

Diagrama para Intel / Micron Comparación de velocidad 3D XPoint Mientras tanto, Intel está trabajando con Micron en un tipo de NVRAM llamado 3D XPoint (pronunciado "punto de cruce"). Esta forma de memoria de cambio de fase (PCM), conocida como RAM resistiva (ReRAM), se hizo pública por primera vez en 2015. "3D" significa la posibilidad de construcción de memoria de múltiples capas. Intel cree que XPoint puede ejecutarse 1,000 veces más rápido que NAND y ser 10 veces más capaz, aunque recientemente estas afirmaciones han disminuido ligeramente. Se espera que el precio sea entre flash y DRAM. Debido a esto, es poco probable que arraigue en los hogares, pero a gran escala puede reemplazar la RAM y la SSD.IBM también trabaja en memoria de cambio de fase. Al igual que Intel, su tecnología se basa en el vidrio de calcogenuro utilizado en medios ópticos regrabables. Usando electricidad para transformar material de un estado amorfo en uno de los tres cristalinos, la compañía cuenta con un avance en capacidades que hará que el costo de la memoria sea más bajo que DRAM.La carrera RAM afectará a todos los niveles de desarrollo informático. El aumento de la memoria de 8 a 16 GB en las computadoras de escritorio del usuario final acelerará la multitarea y aumentará la eficiencia de los programas que requieren mucha memoria.En los ultrabooks, los SSD ya son la norma, y las capacidades crecientes ya los están haciendo candidatos para reemplazar los discos duros. La próxima generación de NAND tridimensional(V-NAND, vertical) promete mayor eficiencia y densidad de grabación. Samsung predice que para 2020 habrá 512 GB de SSD para usuarios finales al precio del tornillo de terabyte de hoy.Para las empresas medianas y las instituciones académicas, una RAM más barata significa mejores análisis con los datos en la memoria, si el software sigue el ritmo. SAP HANA es una base de datos en memoria, una plataforma para el uso generalizado de soluciones en la nube y locales, que permite a las empresas más pequeñas trabajar con grandes datos. IBM y Oracle tienen bases de datos similares.RAM democratiza la tecnología: la tecnología se vuelve más barata y se borra la diferencia entre organizaciones grandes y pequeñas.

Mientras tanto, Intel está trabajando con Micron en un tipo de NVRAM llamado 3D XPoint (pronunciado "punto de cruce"). Esta forma de memoria de cambio de fase (PCM), conocida como RAM resistiva (ReRAM), se hizo pública por primera vez en 2015. "3D" significa la posibilidad de construcción de memoria de múltiples capas. Intel cree que XPoint puede ejecutarse 1,000 veces más rápido que NAND y ser 10 veces más capaz, aunque recientemente estas afirmaciones han disminuido ligeramente. Se espera que el precio sea entre flash y DRAM. Debido a esto, es poco probable que arraigue en los hogares, pero a gran escala puede reemplazar la RAM y la SSD.IBM también trabaja en memoria de cambio de fase. Al igual que Intel, su tecnología se basa en el vidrio de calcogenuro utilizado en medios ópticos regrabables. Usando electricidad para transformar material de un estado amorfo en uno de los tres cristalinos, la compañía cuenta con un avance en capacidades que hará que el costo de la memoria sea más bajo que DRAM.La carrera RAM afectará a todos los niveles de desarrollo informático. El aumento de la memoria de 8 a 16 GB en las computadoras de escritorio del usuario final acelerará la multitarea y aumentará la eficiencia de los programas que requieren mucha memoria.En los ultrabooks, los SSD ya son la norma, y las capacidades crecientes ya los están haciendo candidatos para reemplazar los discos duros. La próxima generación de NAND tridimensional(V-NAND, vertical) promete mayor eficiencia y densidad de grabación. Samsung predice que para 2020 habrá 512 GB de SSD para usuarios finales al precio del tornillo de terabyte de hoy.Para las empresas medianas y las instituciones académicas, una RAM más barata significa mejores análisis con los datos en la memoria, si el software sigue el ritmo. SAP HANA es una base de datos en memoria, una plataforma para el uso generalizado de soluciones en la nube y locales, que permite a las empresas más pequeñas trabajar con grandes datos. IBM y Oracle tienen bases de datos similares.RAM democratiza la tecnología: la tecnología se vuelve más barata y se borra la diferencia entre organizaciones grandes y pequeñas. Centro de datos de Google con servidores personalizados

Centro de datos de Google con servidores personalizados Sequoia Supercomputer

Sequoia Supercomputer

Supercomputadora Sunway TaihuLight, la computadora más rápida del mundo, 93 petaflops

Supercomputadora Sunway TaihuLight, la computadora más rápida del mundo, 93 petaflops Titan, la supercomputadora más rápida de EE. UU.

Titan, la supercomputadora más rápida de EE. UU. EcoPod HP data center Porúltimo, pero no menos importante , el punto es la necesidad de memoria de supercomputadora. Sunway TaihuLight, el SC chino más rápido en la actualidad, contiene 1.300 TB de DRAM DDR3, que es relativamente pequeño por su velocidad de 93 petaflops (miles de millones de operaciones de punto flotante por segundo). En particular, debido a esto, su consumo de energía es de solo 15.3 MW, pero esto puede convertirse en un factor limitante.Ahora todos luchan por el prefijo exaflops, o 1000 petaflops. La computadora japonesa post-K, desarrollada por Riken y Fujitsu, estará lista para 2020 e incluirá el Cubo de memoria híbrido de Micron, una implementación de múltiples capas de DRAM, y posiblemente también use 3D XPoint NVRAM. El proyecto europeo NEXTGenIO en el Centro de Supercomputadoras de Edimburgo pretende alcanzar exaflops para 2022, también utilizando 3D XPoint.En los EE. UU., El Proyecto de Computación Exascale, desarrollado como parte de la iniciativa NSCI, presentará dos supercomputadoras de velocidad similar para 2023. Su arquitectura aún se está desarrollando, pero dado que la velocidad y la eficiencia energética son una prioridad, la RAM desempeñará un papel central en ella.

EcoPod HP data center Porúltimo, pero no menos importante , el punto es la necesidad de memoria de supercomputadora. Sunway TaihuLight, el SC chino más rápido en la actualidad, contiene 1.300 TB de DRAM DDR3, que es relativamente pequeño por su velocidad de 93 petaflops (miles de millones de operaciones de punto flotante por segundo). En particular, debido a esto, su consumo de energía es de solo 15.3 MW, pero esto puede convertirse en un factor limitante.Ahora todos luchan por el prefijo exaflops, o 1000 petaflops. La computadora japonesa post-K, desarrollada por Riken y Fujitsu, estará lista para 2020 e incluirá el Cubo de memoria híbrido de Micron, una implementación de múltiples capas de DRAM, y posiblemente también use 3D XPoint NVRAM. El proyecto europeo NEXTGenIO en el Centro de Supercomputadoras de Edimburgo pretende alcanzar exaflops para 2022, también utilizando 3D XPoint.En los EE. UU., El Proyecto de Computación Exascale, desarrollado como parte de la iniciativa NSCI, presentará dos supercomputadoras de velocidad similar para 2023. Su arquitectura aún se está desarrollando, pero dado que la velocidad y la eficiencia energética son una prioridad, la RAM desempeñará un papel central en ella.Source: https://habr.com/ru/post/es398373/

All Articles