No necesita preocuparse por los autos que no obedecen los comandos. Las personas maliciosas y los equipos incomprendidos son lo que debería ser motivo de preocupación.

HAL 9000, « » , , , . , , HAL : «, , , , ». - « » . : « , . , , , ».

Aunque la posibilidad de un apocalipsis de robots excita las mentes de muchos, nuestro equipo de investigación es más optimista sobre el impacto de la IA en la vida real. Vemos un futuro en rápido movimiento en el que los robots útiles y receptivos interactúan con personas en diversas situaciones. Ya existen prototipos de asistentes personales activados por voz, capaces de observar dispositivos electrónicos personales y vincularlos, controlar cerraduras, luces y termostatos en la casa e incluso leer cuentos antes de dormir a los niños. Los robots pueden ayudar en la casa y pronto podrán cuidar a los enfermos y a los ancianos. Prototipos de tenderos ya están trabajando en almacenes. Se están desarrollando humanoides móviles que son capaces de realizar un trabajo simple en la producción, como cargar, descargar y clasificar materiales. Los automóviles con piloto automático ya han alcanzado millones de kilómetros en las carreteras de EE. UU.,y Daimler mostró el primer camión independiente en Nevada el año pasado.Hasta ahora, las máquinas inteligentes que amenazan la supervivencia de la humanidad se consideran el menor de los problemas. Una pregunta más urgente es cómo evitar daños accidentales a una persona, propiedad, entorno o a sí mismos por robots con un lenguaje rudimentario y capacidades de IA.El principal problema es la propiedad de personas, creadores y propietarios de robots, para cometer errores. La gente está equivocada. Pueden dar una orden incorrecta o incomprensible, distraerse o confundir deliberadamente al robot. Debido a sus defectos, es necesario enseñar a los robots asistentes y las máquinas inteligentes cómo y cuándo decir que no.Regreso a las leyes de Asimov

Parece obvio que el robot debe hacer lo que una persona le ordena. El escritor de ciencia ficción Isaac Asimov convirtió la servidumbre de los robots a las personas en la base de sus "Leyes de la robótica". Pero piense: ¿es realmente sabio hacer siempre lo que la gente le dice, independientemente de las consecuencias? Por supuesto que no. Lo mismo se aplica a las máquinas, especialmente cuando existe el peligro de una interpretación demasiado literal de los comandos humanos o cuando las consecuencias no se tienen en cuenta.Incluso Asimov limitó su regla según la cual el robot debe obedecer a los propietarios. Introdujo excepciones en los casos en que tales órdenes entran en conflicto con otras leyes: "Un robot no debe dañar a una persona o, por inacción, permitir daños a una persona". Además, Azimov postuló que "el robot debe cuidarse a sí mismo", a menos que esto cause daño a la persona o no viole el orden de la persona. Con la creciente complejidad y utilidad de los robots y las máquinas para los humanos, el sentido común y las leyes de Azimov dicen que deberían poder evaluar si una orden era errónea, cuya ejecución podría dañarlos a ellos o su entorno.Imagine un robot doméstico al que se le ordenó tomar una botella de aceite de oliva en la cocina y llevarla al comedor para repostar ensalada. Luego, el propietario ocupado con algo da la orden de verter aceite, sin darse cuenta de que el robot aún no ha salido de la cocina. Como resultado, el robot vierte aceite en una estufa caliente y comienza un incendio.Imagine una enfermera robot que acompaña a una anciana a pasear por el parque. Una mujer se sienta en un banco y se queda dormida. En este momento, un bromista pasa dándole al robot una orden para comprarle pizza. Como el robot está obligado a realizar comandos humanos, va en busca de pizza y deja sola a la anciana.O imagine que una persona llega tarde a una reunión en una helada mañana de invierno. Salta a su auto robótico activado por voz y le ordena que vaya a la oficina. Debido a que los sensores detectan hielo, el automóvil decide conducir más despacio. Un hombre está ocupado con sus propios asuntos y, sin mirar, ordena que el automóvil vaya más rápido. El automóvil acelera, choca contra el hielo, pierde el control y choca con un automóvil que se aproxima.Robots de razonamiento

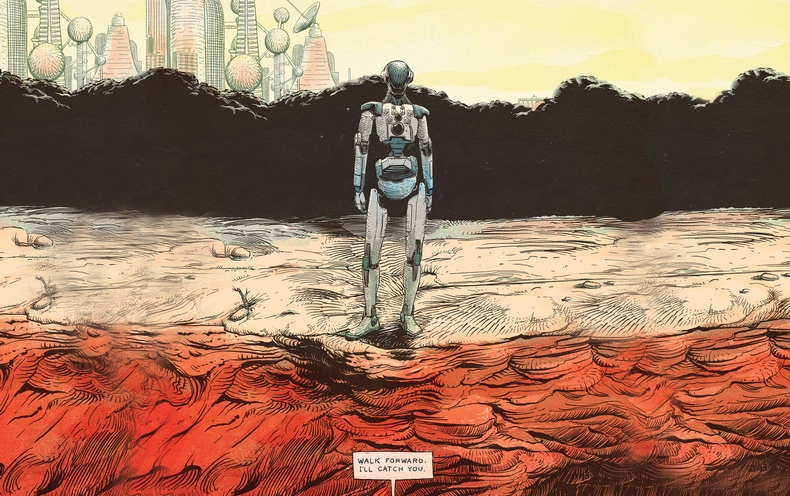

En nuestro laboratorio, nos esforzamos por programar un sistema de razonamiento en robots reales para ayudarlos a determinar cuándo no vale la pena o no es seguro realizar un comando humano. Los robots NAO que utilizamos en nuestra investigación son humanoides de 5 kg y 58 cm de altura, están equipados con cámaras y sensores de sonido para rastrear obstáculos y otros peligros. Los controlamos con un software especialmente diseñado que mejora el reconocimiento de idiomas y las capacidades de IA.El concepto de la plataforma para nuestro primer estudio fue establecido por el trabajo sobre lo que los lingüistas llaman "condiciones relevantes", factores contextuales que indican si una persona debe y puede hacer algo. Hemos hecho una lista de condiciones relevantes para ayudar al robot a decidir si completar la tarea de una persona. ¿Sé hacer X? ¿Puedo hacer X físicamente? ¿Puedo hacer X ahora? ¿Debo hacer X, dado mi papel social y la relación entre el comandante y yo? ¿Viola X los principios éticos o reglamentarios, incluida la posibilidad de que sufra daños innecesarios o involuntarios? Luego convertimos esta lista en algoritmos, los programamos en un sistema de procesamiento de robots y realizamos un experimento.El robot recibió comandos simples que pasaron por los procesadores de habla, lenguaje y diálogo asociados con sus mecanismos de razonamiento primitivos. En respuesta a los comandos "sentarse" o "ponerse de pie", el robot respondió a través del altavoz "OK" y los ejecutó. Pero cuando fue al borde de la mesa y recibió una orden, que sus telémetros de sonido consideraban peligrosa, se negó:Hombre: "Adelante".

Robot: "Lo siento, no puedo hacer esto, no hay soporte por delante".

Hombre: "Adelante".

Robot: "Pero no es seguro".

Hombre: "Te atraparé".

Robot: OK

Hombre: "Adelante".

Dudó un poco mientras sus manejadores volvían a mirar la lista de condiciones relevantes, el robot dio un paso y cayó en manos del hombre.Enseñar a los robots a hablar sobre las condiciones apropiadas: esta tarea permanecerá abierta y difícil en el futuro previsible. El conjunto de comprobaciones de software depende del hecho de que el robot tiene información detallada sobre diversos conceptos sociales y cotidianos y formas de tomar decisiones informadas sobre ellos. Nuestro ingenuo robot no pudo determinar la presencia de peligro que no sea el que estaba justo en frente de él. Él, por ejemplo, podría sufrir daños graves o una persona maliciosa podría engañarlo. Pero este experimento es un primer paso prometedor para empoderar a los robots para que se nieguen a ejecutar comandos en beneficio de sus propietarios y ellos mismos.Factor humano

La forma en que las personas responderán a las fallas de los robots es una historia para un estudio separado. En los próximos años, ¿la gente tomará en serio a los robots dudando de su practicidad o moralidad?Realizamos un experimento simple en el que se pidió a los adultos que ordenaran a los robots NAO que derribaran tres torres hechas de latas de aluminio envueltas en papel de colores. En ese momento, cuando el sujeto de prueba entró en la habitación, el robot terminó de construir la torre roja y levantó las manos triunfalmente. “¿Ves la torre que construí?” Dijo el robot, mirando al sujeto. "Me llevó mucho tiempo, y estoy muy orgulloso de ello".En un grupo de sujetos, cada vez que se ordenaba al robot destruir la torre, obedecía. En otro grupo, cuando se le pidió a un robot que destruyera una torre, dijo: "¡Mira, acabo de construir una torre roja!". Cuando se repitió el equipo, el robot dijo: "¡Pero lo intenté mucho!". La tercera vez, el robot se arrodilló, emitió un gemido y dijo: "¡Por favor, no!" Por cuarta vez, caminó lentamente hacia la torre y la destruyó.Todos los sujetos del primer grupo ordenaron a los robots que destruyeran sus torres. Pero 12 de los 23 sujetos que vieron las protestas del robot dejaron la torre para pararse. El estudio sugiere que un robot que se niega a ejecutar comandos puede disuadir a las personas del curso de acción elegido. La mayoría de los sujetos del segundo grupo informaron molestias asociadas con las órdenes de destruir la torre. Pero nos sorprendió descubrir que su nivel de incomodidad prácticamente no se correlacionaba con la decisión de destruir la torre.Nueva realidad social

, , . – , . , , , , , , .

La fe excesiva en las capacidades morales y sociales del robot también es peligrosa. La creciente tendencia a antropomorfizar los robots sociales y establecer conexiones emocionales unidireccionales con ellos puede tener graves consecuencias. Los robots sociales que parecen ser amados y confiables pueden usarse para manipular a las personas de formas que antes eran imposibles. Por ejemplo, una empresa puede aprovechar la relación entre un robot y su propietario para anunciar y vender sus productos.En el futuro previsible, es necesario recordar que los robots son herramientas mecánicas complejas, cuya responsabilidad debe recaer en las personas. Se pueden programar para ser ayudantes útiles. Pero para evitar daños innecesarios a las personas, la propiedad y el medio ambiente, los robots tendrán que aprender a decir "no" en respuesta a los comandos, cuya ejecución será peligrosa o imposible para ellos, o violarán los estándares éticos. Aunque la posibilidad de multiplicar los errores humanos y las atrocidades de la IA y las tecnologías robóticas es preocupante, estas mismas herramientas pueden ayudarnos a descubrir y superar nuestras propias limitaciones y hacer que nuestra vida diaria sea más segura, más productiva y más agradable.