Las gafas especiales cambian la personalidad de una persona para el sistema de reconocimiento facial

Exitosa suplantación en el sistema de reconocimiento facial. Izquierda: actriz Reese Witherspoon, cuya identidad reconoce la red neuronal con una probabilidad del 100%. En el centro: gafas seleccionadas para la personificación del actor Russell Crowe. Derecha: víctima de la suplantación de identidad.Gracias a las redes neuronales, los sistemas de visión artificial lograron una precisión récord en el reconocimiento facial. La personalidad de una persona es casi inconfundiblemente reconocida incluso en fotografías borrosas y en aquellas en las que la cara solo es parcialmente visible. Se crean algoritmos que tienen en cuenta el contexto: vestimenta, entorno, marcha. Hasta ahora, estos son solo desarrollos tecnológicos avanzados. Pero dada la histeria global en torno al terrorismo y la seguridad (aunque 53 veces menos personas mueren de terrorismo)que en accidentes de tráfico), muy pronto tales programas de reconocimiento se conectarán sin duda a millones de cámaras de vigilancia al aire libre en lugares públicos. La pregunta es, ¿qué métodos existen para combatir esa vigilancia?El reconocimiento facial es muy difícil de combatir, pero los científicos aún tratan de encontrar "vulnerabilidades" en los sistemas de reconocimiento facial. Para engañar a un sistema de este tipo requiere una forma específica de cambiar la apariencia física. No hay problema en ponerse una capucha o usar anteojos grandes y oscuros. Pero esto es sospechoso: la policía o los guardias de seguridad pueden detener a una persona con la cara cerrada. Debe haber formas más inteligentes. Ciertamente, algunos pequeños cambios pueden pasar por alto el sistema de reconocimiento informático, pero al mismo tiempo apenas afectarán la percepción de la persona a los ojos de los demás y no causarán sospechas.La tarea es similar a la que los distribuidores de spam resuelven para evitar los filtros de spam. Necesitan el mensaje para llegar a los consumidores de forma legible, pero sin pasar por los filtros de la computadora. Entonces, aquí, una persona debe ser abierta y bien reconocida por las personas, pero no debe ser reconocida por una red neuronal.

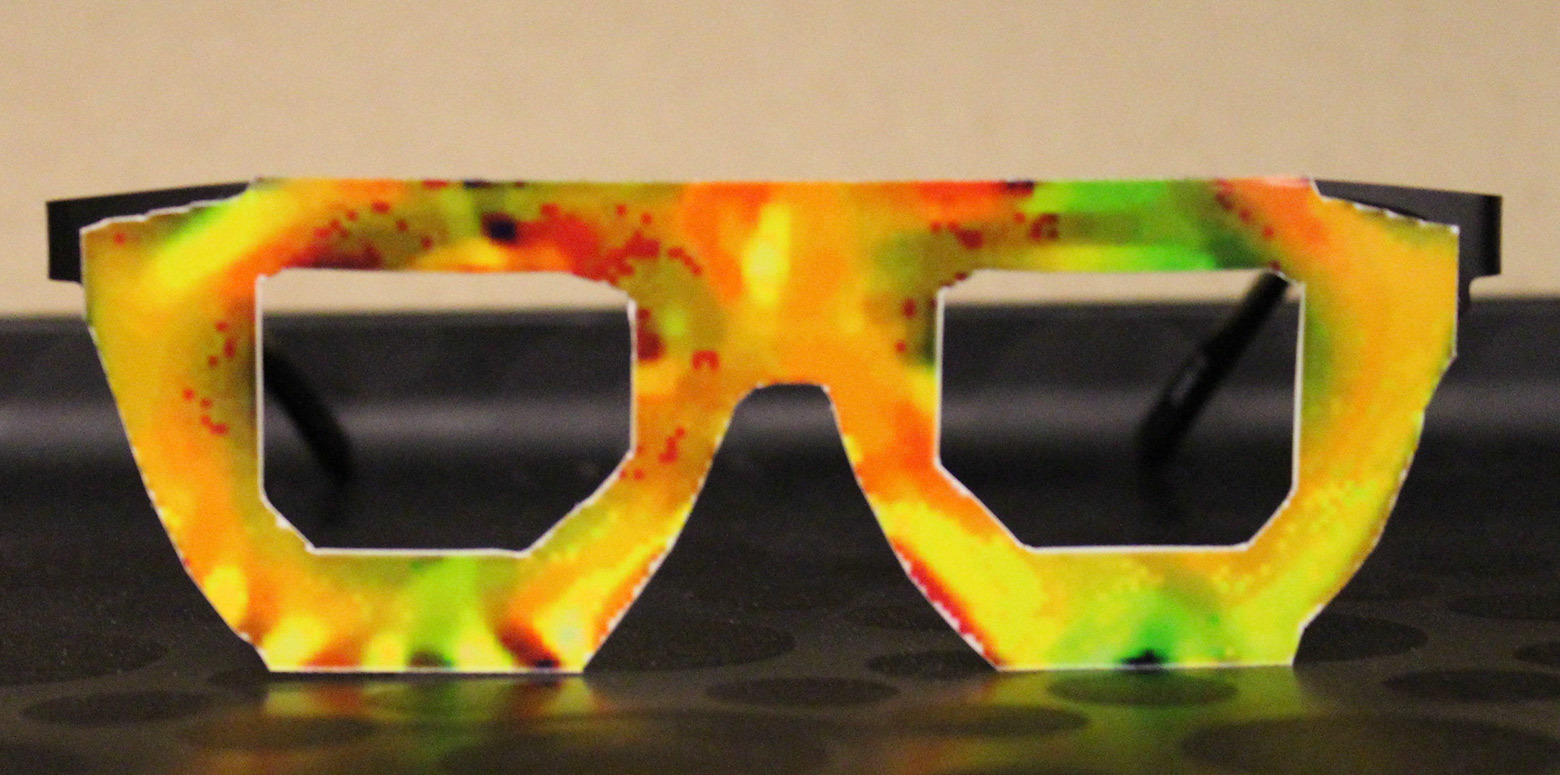

Exitosa suplantación en el sistema de reconocimiento facial. Izquierda: actriz Reese Witherspoon, cuya identidad reconoce la red neuronal con una probabilidad del 100%. En el centro: gafas seleccionadas para la personificación del actor Russell Crowe. Derecha: víctima de la suplantación de identidad.Gracias a las redes neuronales, los sistemas de visión artificial lograron una precisión récord en el reconocimiento facial. La personalidad de una persona es casi inconfundiblemente reconocida incluso en fotografías borrosas y en aquellas en las que la cara solo es parcialmente visible. Se crean algoritmos que tienen en cuenta el contexto: vestimenta, entorno, marcha. Hasta ahora, estos son solo desarrollos tecnológicos avanzados. Pero dada la histeria global en torno al terrorismo y la seguridad (aunque 53 veces menos personas mueren de terrorismo)que en accidentes de tráfico), muy pronto tales programas de reconocimiento se conectarán sin duda a millones de cámaras de vigilancia al aire libre en lugares públicos. La pregunta es, ¿qué métodos existen para combatir esa vigilancia?El reconocimiento facial es muy difícil de combatir, pero los científicos aún tratan de encontrar "vulnerabilidades" en los sistemas de reconocimiento facial. Para engañar a un sistema de este tipo requiere una forma específica de cambiar la apariencia física. No hay problema en ponerse una capucha o usar anteojos grandes y oscuros. Pero esto es sospechoso: la policía o los guardias de seguridad pueden detener a una persona con la cara cerrada. Debe haber formas más inteligentes. Ciertamente, algunos pequeños cambios pueden pasar por alto el sistema de reconocimiento informático, pero al mismo tiempo apenas afectarán la percepción de la persona a los ojos de los demás y no causarán sospechas.La tarea es similar a la que los distribuidores de spam resuelven para evitar los filtros de spam. Necesitan el mensaje para llegar a los consumidores de forma legible, pero sin pasar por los filtros de la computadora. Entonces, aquí, una persona debe ser abierta y bien reconocida por las personas, pero no debe ser reconocida por una red neuronal. La cara del atacante (izquierda), la ilustración del ataque (centro) y la víctima de la personificación (derecha).Idealmente, el sistema debe reconocer la cara abierta de una persona como la cara de un extraño , siguiendo el patrón de reemplazar al personaje principal de la película "Opinión especial". En este caso, los guardias y la policía no tendrán ninguna queja en absoluto, y la persona podrá moverse libremente por lugares públicos que son escaneados por cámaras de CCTV.Es importante comprender exactamente qué cambios afectarán más a los algoritmos de las redes neuronales en el reconocimiento facial. Un grupo de investigadores de la Universidad Carnegie Mellon estudió el tema en detalle y recientemente publicó los resultados de su investigación sobre este tema. De hecho, los investigadores están hablando de un nuevo tipo de ataque .

La cara del atacante (izquierda), la ilustración del ataque (centro) y la víctima de la personificación (derecha).Idealmente, el sistema debe reconocer la cara abierta de una persona como la cara de un extraño , siguiendo el patrón de reemplazar al personaje principal de la película "Opinión especial". En este caso, los guardias y la policía no tendrán ninguna queja en absoluto, y la persona podrá moverse libremente por lugares públicos que son escaneados por cámaras de CCTV.Es importante comprender exactamente qué cambios afectarán más a los algoritmos de las redes neuronales en el reconocimiento facial. Un grupo de investigadores de la Universidad Carnegie Mellon estudió el tema en detalle y recientemente publicó los resultados de su investigación sobre este tema. De hecho, los investigadores están hablando de un nuevo tipo de ataque .Los ataques que cambian físicamente la apariencia, pero al mismo tiempo parecen inofensivos para el observador externo.

A diferencia de otros ataques similares, en este caso, los investigadores se centraron en el factor de "inocuidad" para que el hecho de manipular la red neuronal no despertara ninguna sospecha entre extraños, incluidos los guardias de seguridad que estaban viendo la transmisión de video de las cámaras de vigilancia.Los científicos han descubierto que en este caso, es más efectivo usar anteojos con un patrón especialmente seleccionado que afecte la red neuronal para reconocer rostros. Las pruebas de los sistemas de reconocimiento facial determinaron que el punto más vulnerable de las redes neuronales es una comparación del color de los píxeles vecinos en lugares específicos de la cara alrededor de los ojos.La “inocuidad” es realmente importante, porque si se la detiene, una persona tendrá la oportunidad de negar de manera efectiva la intención maliciosa. Nadie puede probar que estas gafas están especialmente diseñadas para engañar al sistema de reconocimiento facial y no tienen colores aleatorios.Los investigadores han propuesto dos opciones para llevar a cabo un ataque: suplantación y evasión. En el primer caso, la tarea es dar la cara de la persona con anteojos para la cara de otra persona específica. En el caso de un ataque contra la evasión, la tarea es entregar la cara de la persona con anteojos por la cara de cualquier otra persona.Como han demostrado las pruebas en sistemas de reconocimiento de rostros reales, es posible crear tales anteojos en la mayoría de los casos para algunas personas. Por ejemplo, para el rostro de un hombre blanco, los lentes especialmente seleccionados suplantan la identidad de Mila Jovovich en el 87.87% de los casos. Tres autores del trabajo científico (tres hombres blancos) probaron los anteojos en sí mismos y declararon que los anteojos impresos con un patrón específico permiten evadir un ataque en el 80% de los casos contra los sistemas comerciales más modernos de reconocimiento facial.Por supuesto, el éxito de un ataque contra la suplantación depende en gran medida de la raza y el color del atacante. Por ejemplo, una mujer del sur de Asia puede hacerse pasar por un hombre del Medio Oriente en el 88% de los casos, pero los hombres del Medio Oriente pueden hacerse pasar por Clive Owen (hombre blanco) en solo el 16.13% de los casos.Los sistemas se probaron en el sistema de reconocimiento facial Face ++ , así como en el sistema de detección de rostros utilizando el método Viola-Jones más común hasta la fecha . El algoritmo Viola-Jones propuesto en 2001 se implementa en muchos programas populares, incluida la biblioteca de visión por computadora OpenCV. Encuentra caras con alta precisión y un bajo número de falsos positivos.Los científicos han optimizado el algoritmo para que la apariencia de las gafas sea la más bella, con transiciones de color suaves y sea adecuada para imprimir en una impresora convencional. Los investigadores estiman que imprimir marcos y vasos de papel para evitar los sistemas modernos de reconocimiento facial costará alrededor de 22 centavos. Para probar la efectividad del sistema de evasión de reconocimiento, se seleccionaron 20 fotos aleatorias de la base de datos de fotos faciales PubFig. El uso de anteojos estándar permitió realizar un ataque de evasión en 19 de 20 casos, y el uso de accesorios auxiliares (lentes de contacto, gorro de invierno, etc.) aumentó el éxito del ataque al 100%. Los científicos también señalan que el método funciona con éxito no solo en sistemas de reconocimiento facial con código fuente abierto, sino también en sistemas como la caja negra.

Los investigadores estiman que imprimir marcos y vasos de papel para evitar los sistemas modernos de reconocimiento facial costará alrededor de 22 centavos. Para probar la efectividad del sistema de evasión de reconocimiento, se seleccionaron 20 fotos aleatorias de la base de datos de fotos faciales PubFig. El uso de anteojos estándar permitió realizar un ataque de evasión en 19 de 20 casos, y el uso de accesorios auxiliares (lentes de contacto, gorro de invierno, etc.) aumentó el éxito del ataque al 100%. Los científicos también señalan que el método funciona con éxito no solo en sistemas de reconocimiento facial con código fuente abierto, sino también en sistemas como la caja negra.Source: https://habr.com/ru/post/es398915/

All Articles