Cada vez más inteligentes, los autos comienzan a aprender casi tanto como nosotros

Los estudios muestran que los modelos informáticos, conocidos como redes neuronales utilizadas en un número creciente de aplicaciones, pueden aprender a reconocer secuencias en los datos utilizando los mismos algoritmos que el cerebro humano.

El cerebro resuelve su problema canónico, el entrenamiento, ajustando muchos de sus compuestos de acuerdo con un conjunto desconocido de reglas. Para revelar estas reglas, los científicos comenzaron a desarrollar modelos de computadora hace 30 años tratando de reproducir el proceso de aprendizaje. Hoy, en un número creciente de experimentos, queda claro que estos modelos se comportan de manera muy similar al cerebro real en ciertas tareas. Los investigadores dicen que esta similitud sugiere un ajuste básico entre los algoritmos de aprendizaje de la computadora y el cerebro.El algoritmo utilizado por el modelo de computadora se llama máquina de Boltzmann . Fue inventado por Jeffrey Hinton y Terry Seinowski en 1983 [de hecho, en 1985- aprox. transl.]. Parece muy prometedor como una explicación teórica simple de varios procesos que ocurren en el cerebro: desarrollo, formación de memoria, reconocimiento de objetos y sonidos, ciclos de sueño y vigilia."Esta es la mejor oportunidad que tenemos hoy para comprender el cerebro", dice Sue Becker, profesora de psicología, neurobiología y comportamiento en la Universidad. McMaster en Hamilton, Ontario. "No conozco un modelo que describa una gama más amplia de fenómenos relacionados con el aprendizaje y la estructura del cerebro".Hinton, pionero en el campo de la IA, siempre quiso entender las reglas por las cuales el cerebro mejora la comunicación o la debilita, es decir, el algoritmo de aprendizaje. "Decidí que para entender algo, es necesario construirlo", dice. Siguiendo el enfoque reduccionista de los físicos, planea crear modelos informáticos simples del cerebro utilizando diferentes algoritmos de aprendizaje y ver "cuáles funcionarán", dice Hinton, en parte profesor de informática en la Universidad de Toronto y en parte en Google.

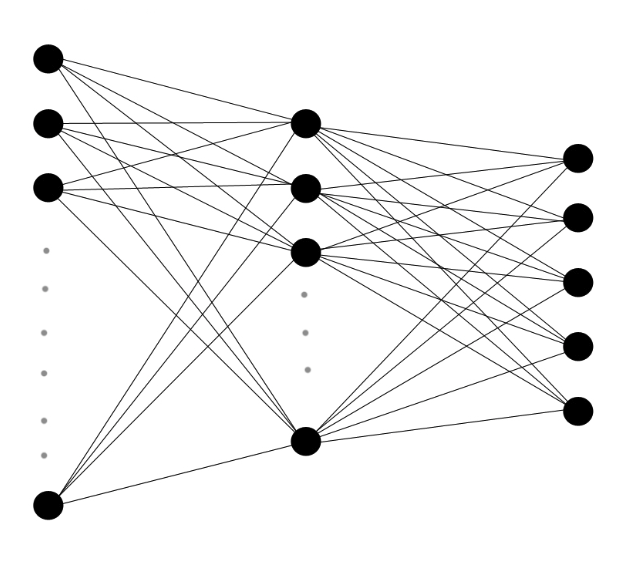

El cerebro resuelve su problema canónico, el entrenamiento, ajustando muchos de sus compuestos de acuerdo con un conjunto desconocido de reglas. Para revelar estas reglas, los científicos comenzaron a desarrollar modelos de computadora hace 30 años tratando de reproducir el proceso de aprendizaje. Hoy, en un número creciente de experimentos, queda claro que estos modelos se comportan de manera muy similar al cerebro real en ciertas tareas. Los investigadores dicen que esta similitud sugiere un ajuste básico entre los algoritmos de aprendizaje de la computadora y el cerebro.El algoritmo utilizado por el modelo de computadora se llama máquina de Boltzmann . Fue inventado por Jeffrey Hinton y Terry Seinowski en 1983 [de hecho, en 1985- aprox. transl.]. Parece muy prometedor como una explicación teórica simple de varios procesos que ocurren en el cerebro: desarrollo, formación de memoria, reconocimiento de objetos y sonidos, ciclos de sueño y vigilia."Esta es la mejor oportunidad que tenemos hoy para comprender el cerebro", dice Sue Becker, profesora de psicología, neurobiología y comportamiento en la Universidad. McMaster en Hamilton, Ontario. "No conozco un modelo que describa una gama más amplia de fenómenos relacionados con el aprendizaje y la estructura del cerebro".Hinton, pionero en el campo de la IA, siempre quiso entender las reglas por las cuales el cerebro mejora la comunicación o la debilita, es decir, el algoritmo de aprendizaje. "Decidí que para entender algo, es necesario construirlo", dice. Siguiendo el enfoque reduccionista de los físicos, planea crear modelos informáticos simples del cerebro utilizando diferentes algoritmos de aprendizaje y ver "cuáles funcionarán", dice Hinton, en parte profesor de informática en la Universidad de Toronto y en parte en Google. Las redes neuronales multicapa consisten en capas de neuronas artificiales con conexiones ponderadas entre ellas. Envío los datos entrantes en cascada de señales en capas, y el algoritmo determina el cambio en los pesos de cada conexión.En las décadas de 1980 y 1990, Hinton, el tataranieto de la lógica del siglo XIX, George Boole, cuyo trabajo formó la base de la informática moderna, inventó varios algoritmos de aprendizaje automático. Los algoritmos que controlan cómo una computadora aprende de los datos se utilizan en modelos informáticos llamados "redes neuronales artificiales": redes de neuronas virtuales interconectadas que transmiten señales a sus vecinos, encendiéndose o apagándose, o "disparándose". Cuando los datos se envían a la red, esto lleva a una cascada de respuestas, y el algoritmo, basado en la imagen de estas respuestas, selecciona aumentar o disminuir los pesos de las conexiones o sinapsis, entre cada par de neuronas.Durante décadas, muchos modelos de computadora Hinton han estado vegetando. Pero gracias a los avances en la potencia del procesador, el progreso en la comprensión del cerebro y los algoritmos, las redes neuronales están desempeñando un papel cada vez mayor en la neurobiología. Sejnowski [Sejnowski], jefe del Laboratorio de Computación de Neurobiología del Instituto de Investigación Biológica. Salka en La Jolla, California, dice: “Hace treinta años, teníamos ideas muy aproximadas; ahora estamos comenzando a probar algunos de ellos ".

Las redes neuronales multicapa consisten en capas de neuronas artificiales con conexiones ponderadas entre ellas. Envío los datos entrantes en cascada de señales en capas, y el algoritmo determina el cambio en los pesos de cada conexión.En las décadas de 1980 y 1990, Hinton, el tataranieto de la lógica del siglo XIX, George Boole, cuyo trabajo formó la base de la informática moderna, inventó varios algoritmos de aprendizaje automático. Los algoritmos que controlan cómo una computadora aprende de los datos se utilizan en modelos informáticos llamados "redes neuronales artificiales": redes de neuronas virtuales interconectadas que transmiten señales a sus vecinos, encendiéndose o apagándose, o "disparándose". Cuando los datos se envían a la red, esto lleva a una cascada de respuestas, y el algoritmo, basado en la imagen de estas respuestas, selecciona aumentar o disminuir los pesos de las conexiones o sinapsis, entre cada par de neuronas.Durante décadas, muchos modelos de computadora Hinton han estado vegetando. Pero gracias a los avances en la potencia del procesador, el progreso en la comprensión del cerebro y los algoritmos, las redes neuronales están desempeñando un papel cada vez mayor en la neurobiología. Sejnowski [Sejnowski], jefe del Laboratorio de Computación de Neurobiología del Instituto de Investigación Biológica. Salka en La Jolla, California, dice: “Hace treinta años, teníamos ideas muy aproximadas; ahora estamos comenzando a probar algunos de ellos ".Máquinas cerebrales

Los primeros intentos de Hinton de reproducir el cerebro fueron limitados. Las computadoras podían ejecutar sus algoritmos de aprendizaje en pequeñas redes neuronales, pero los modelos de escala sobrecargaban muy rápidamente los procesadores. En 2005, Hinton descubrió que si divide las redes neuronales en capas y ejecuta los algoritmos por separado en cada capa, repitiendo aproximadamente la estructura y el desarrollo del cerebro, el proceso se vuelve más eficiente.Aunque Hinton publicó su descubrimiento en dos revistas conocidas, las redes neuronales estaban fuera de moda para entonces, y "luchó para que la gente se interesara", dijo Lee Deng, investigador principal de Microsoft Research. Sin embargo, Deng conocía a Hinton y decidió probar su método de "aprendizaje profundo" en 2009, reconociendo rápidamente su potencial. En los años siguientes, los algoritmos de aprendizaje se utilizan en la práctica en un número creciente de aplicaciones, como el asistente personal de Google Now o la función de búsqueda por voz en los teléfonos Microsoft Windows.Uno de los algoritmos más prometedores, la máquina de Boltzmann, lleva el nombre del físico austríaco del siglo XIX Ludwig Boltzmann, quien desarrolló una rama de la física que se ocupa de una gran cantidad de partículas, conocida como mecánica estadística. Boltzmann descubrió una ecuación que da la probabilidad de que un gas molecular tenga una cierta energía cuando alcanza el equilibrio. Si reemplaza las moléculas con neuronas, entonces el resultado tenderá a la misma ecuación.Las sinapsis de la red comienzan con una distribución aleatoria de pesos, y los pesos se ajustan gradualmente de acuerdo con un procedimiento bastante simple: el circuito de respuesta generado en el proceso de recepción de datos por la máquina (como imágenes o sonidos) se compara con el circuito de respuesta aleatorio de la máquina que ocurre cuando no se ingresan datos. Joffrey Hinton cree que el mejor enfoque para comprender los procesos de aprendizaje en el cerebro es construir computadoras que aprendan de la misma manera.Cada sinapsis virtual rastrea ambos conjuntos estadísticos. Si las neuronas conectadas a él se activan con mayor frecuencia en una secuencia cerrada al recibir datos que durante la operación aleatoria, entonces el peso de la sinapsis aumenta en un valor proporcional a la diferencia. Pero si dos neuronas se activan juntas con mayor frecuencia durante una operación aleatoria, entonces la sinapsis que las conecta se considera demasiado fuerte y debilitada.La versión más utilizada de la máquina Boltzmann funciona mejor después del "entrenamiento", ya que ha procesado miles de datos de muestra secuencialmente en cada capa. Primero, la capa inferior de la red recibe datos sin procesar en forma de imágenes o sonidos y, a la manera de las células de la retina, las neuronas se activan si detectan contrastes en su área de datos, como cambiar de claro a oscuro. Su activación puede desencadenar la activación de las neuronas asociadas con ellas, dependiendo del peso de la sinapsis que las conecta. A medida que la activación de pares de neuronas virtuales se compara constantemente con las estadísticas de fondo, gradualmente aparecen e intensifican conexiones significativas entre las neuronas. Se especifican los pesos de las sinapsis y se incorporan categorías de sonidos e imágenes en las conexiones. Cada capa posterior se entrena de manera similar, utilizando datos de la capa debajo de ella.Si alimenta una imagen de un automóvil a una red neuronal que está entrenada para detectar ciertos objetos en imágenes, la capa inferior funcionará si detecta un contraste que indica una cara o un punto final. Estas señales irán a neuronas de nivel superior que determinan ángulos, partes de las ruedas, etc. En el nivel superior, las neuronas se activan solo al reaccionar a la imagen del automóvil."La magia de lo que está sucediendo en la web es que puede resumir", dice Yann LeCun, director del Centro de Ciencia de Datos de la Universidad de Nueva York. "Si le muestra un automóvil que no ha visto antes, y si el automóvil tendrá algunas formas y características comunes con las máquinas que se le muestran durante el entrenamiento, puede determinar que se trata de un automóvil".Las redes neuronales han acelerado recientemente su desarrollo gracias al modo multicapa de Hinton, el uso de chips de computadora de alta velocidad para procesar gráficos y el crecimiento explosivo en la cantidad de imágenes y grabaciones de voz disponibles para capacitación. Las redes pueden reconocer correctamente el 88% de las palabras en inglés, mientras que la persona promedio reconoce el 96%. Pueden detectar automóviles y miles de otros objetos en imágenes con una precisión similar, y en los últimos años han tomado una posición dominante en las competencias de aprendizaje automático.

Joffrey Hinton cree que el mejor enfoque para comprender los procesos de aprendizaje en el cerebro es construir computadoras que aprendan de la misma manera.Cada sinapsis virtual rastrea ambos conjuntos estadísticos. Si las neuronas conectadas a él se activan con mayor frecuencia en una secuencia cerrada al recibir datos que durante la operación aleatoria, entonces el peso de la sinapsis aumenta en un valor proporcional a la diferencia. Pero si dos neuronas se activan juntas con mayor frecuencia durante una operación aleatoria, entonces la sinapsis que las conecta se considera demasiado fuerte y debilitada.La versión más utilizada de la máquina Boltzmann funciona mejor después del "entrenamiento", ya que ha procesado miles de datos de muestra secuencialmente en cada capa. Primero, la capa inferior de la red recibe datos sin procesar en forma de imágenes o sonidos y, a la manera de las células de la retina, las neuronas se activan si detectan contrastes en su área de datos, como cambiar de claro a oscuro. Su activación puede desencadenar la activación de las neuronas asociadas con ellas, dependiendo del peso de la sinapsis que las conecta. A medida que la activación de pares de neuronas virtuales se compara constantemente con las estadísticas de fondo, gradualmente aparecen e intensifican conexiones significativas entre las neuronas. Se especifican los pesos de las sinapsis y se incorporan categorías de sonidos e imágenes en las conexiones. Cada capa posterior se entrena de manera similar, utilizando datos de la capa debajo de ella.Si alimenta una imagen de un automóvil a una red neuronal que está entrenada para detectar ciertos objetos en imágenes, la capa inferior funcionará si detecta un contraste que indica una cara o un punto final. Estas señales irán a neuronas de nivel superior que determinan ángulos, partes de las ruedas, etc. En el nivel superior, las neuronas se activan solo al reaccionar a la imagen del automóvil."La magia de lo que está sucediendo en la web es que puede resumir", dice Yann LeCun, director del Centro de Ciencia de Datos de la Universidad de Nueva York. "Si le muestra un automóvil que no ha visto antes, y si el automóvil tendrá algunas formas y características comunes con las máquinas que se le muestran durante el entrenamiento, puede determinar que se trata de un automóvil".Las redes neuronales han acelerado recientemente su desarrollo gracias al modo multicapa de Hinton, el uso de chips de computadora de alta velocidad para procesar gráficos y el crecimiento explosivo en la cantidad de imágenes y grabaciones de voz disponibles para capacitación. Las redes pueden reconocer correctamente el 88% de las palabras en inglés, mientras que la persona promedio reconoce el 96%. Pueden detectar automóviles y miles de otros objetos en imágenes con una precisión similar, y en los últimos años han tomado una posición dominante en las competencias de aprendizaje automático.Construyendo un cerebro

Nadie sabe cómo entender directamente las reglas por las cuales se entrena el cerebro, pero existen muchas coincidencias indirectas entre el comportamiento del cerebro y la máquina de Boltzmann.Ambos se entrenan sin supervisión, utilizando solo patrones existentes en los datos. "Tu madre no te cuenta un millón de veces sobre lo que se muestra en la imagen", dice Hinton. - Tienes que aprender a reconocer las cosas sin el consejo de los demás. Después de estudiar las categorías, le dicen los nombres de estas categorías. Entonces los niños aprenden sobre perros y gatos, y luego aprenden que los perros se llaman "perros", y los gatos se llaman "gatos".El cerebro adulto no es tan flexible como el joven, al igual que la máquina Boltzmann, que se entrenó para 100.000 imágenes de automóviles, no cambiará mucho después de ver otra. Sus sinapsis ya tienen los pesos correctos para clasificar los autos. Pero el entrenamiento no termina. Se puede integrar nueva información en la estructura del cerebro y de las máquinas de Boltzmann.En las últimas dos décadas, un estudio de la actividad cerebral en un sueño ha proporcionado la primera evidencia de que el cerebro utiliza un algoritmo similar al algoritmo de Boltzmann para incorporar nueva información y recuerdos en su estructura. Los neurocientíficos saben desde hace tiempo que el sueño juega un papel importante en la consolidación de la memoria y ayuda a integrar nueva información. En 1995, Hinton y sus colegas sugirieronese sueño desempeña el papel de un nivel básico en el algoritmo, que denota la actividad de las neuronas en ausencia de datos de entrada."Durante el sueño, solo se calcula la frecuencia base de las neuronas", dice Hinton. - Averigua la correlación de su trabajo en el caso en que el sistema funciona por sí solo. Y luego, si las neuronas se correlacionan más, solo aumente el peso entre ellas. Y si es menos, reduzca el peso ".A nivel de sinapsis," este algoritmo se puede proporcionar de varias maneras ", dice Sezhnowski, asesor de la administración presidencial como parte de la iniciativa BRAIN , un estudio con una subvención de $ 100 millones diseñado para desarrollar nuevas técnicas para estudiar el cerebro.Él dice, que es más fácil para el cerebro trabajar con el algoritmo de Boltzmann, pasar de crear sinapsis durante el día a disminuirlas por la noche.Giulio Tononi , jefe del Centro de Estudios del Sueño y la Conciencia de la Universidad de Wisconsin-Madison, descubrió que la expresión génica en las sinapsis los cambia según esta hipótesis: los genes involucrados en el crecimiento de las sinapsis son más activos durante el día y los genes involucrados en la contracción sinapsis: de noche.En otra opción, "la línea de base se puede calcular en un sueño, y luego se pueden hacer cambios en relación con ella durante el día", dice Sezhnowski. En su laboratorio, los modelos informáticos detallados de las sinapsis y las redes que soportan se crean para determinar cómo recopilan estadísticas sobre la vigilia y los patrones de sueño, y cuándo cambia la intensidad de las sinapsis para mostrar esta diferencia.Dificultades con el cerebro.

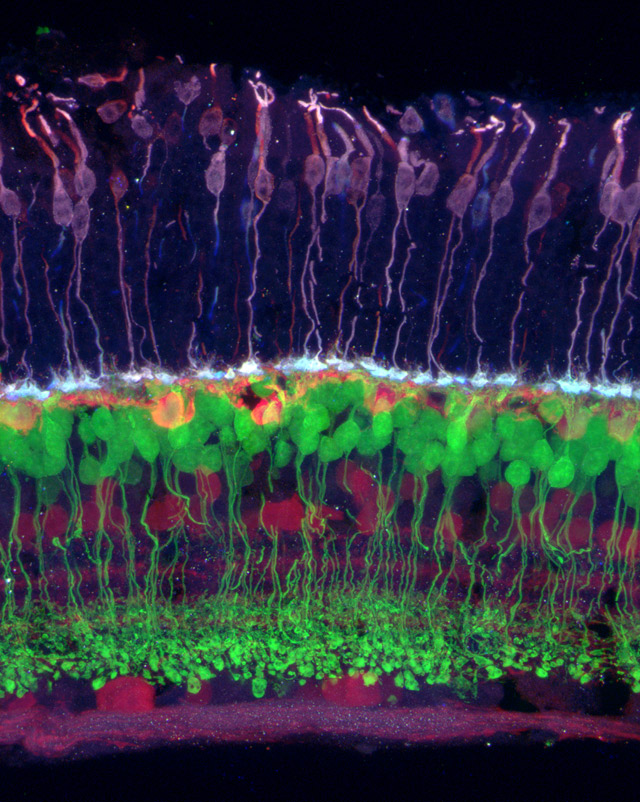

Imagen de la retina en la que los diferentes tipos de células están indicados por diferentes colores. Sensible al color (violeta) se conecta a la horizontal (naranja), que se conecta a bipolar (verde), y a las células de la retina y el ganglio (púrpura).El algoritmo de Boltzmann puede ser uno de los muchos utilizados por el cerebro para ajustar las sinapsis. En la década de 1990, varios grupos independientes desarrollaron un modelo teórico de cómo el sistema visual codifica eficientemente el flujo de información que va a la retina. La teoría postulaba que en las capas inferiores de la corteza visual hay un proceso de "codificación dispersa", similar a la compresión de imágenes, como resultado de lo cual las últimas etapas del sistema visual funcionan de manera más eficiente.Las predicciones del modelo pasan gradualmente pruebas cada vez más rigurosas. En el trabajopublicado en PLOS Computational Biology, los neurocientíficos computacionales de Gran Bretaña y Australia descubrieron que cuando las redes neuronales que utilizan el algoritmo de codificación dispersa de Products of Experts inventado por Hinton en 2002 procesan los mismos datos visuales inusuales que reciben los gatos vivos (para Por ejemplo, los gatos y las redes neuronales estudian imágenes rayadas), sus neuronas producen conexiones inusuales casi idénticas."Cuando la información llega a la corteza visual, el cerebro, creemos, la presenta como un código disperso", dijo Bruno Olshausen, neurocientífico computacional y director del Centro Redwood para Neurobiología Teórica en la Universidad de California-Berkeley, quien ayudó a desarrollar Teoría de la codificación dispersa. "Como si una máquina de Boltzmann estuviera sentada en tu cabeza y tratara de entender las conexiones que existen entre los elementos del código disperso".Olshausen y el equipo utilizaron modelos de redes neuronales de las capas superiores de la corteza visual para mostrar cómo el cerebro es capaz de mantener una percepción estable de la información visual a pesar del movimiento de las imágenes. En otro estudiodescubrieron que la actividad de las neuronas en la corteza visual de los gatos que miran una película en blanco y negro está muy bien descrita por la máquina Boltzmann.Una de las posibles aplicaciones de este trabajo es la creación de neuroprótesis, por ejemplo, una retina artificial. Si observa cómo "la información está formateada en el cerebro, puede comprender cómo estimular al cerebro para que piense que está viendo una imagen", dice Olshausen.Sezhnowski dice que comprender los algoritmos de crecimiento y reducción de las sinapsis permitirá a los investigadores cambiarlas y aprender cómo se interrumpe el funcionamiento de la red neuronal. "Entonces se pueden comparar con los problemas conocidos de las personas", dice. - Casi todos los trastornos mentales pueden explicarse por problemas con las sinapsis. Si podemos entender mejor las sinapsis, podemos entender cómo funciona normalmente el cerebro, cómo procesa la información, cómo aprende y qué sale mal si, por ejemplo, desarrolla esquizofrenia ".El enfoque para estudiar el cerebro usando redes neuronales contrasta fuertemente con el enfoque del Proyecto Cerebro Humano [ Proyecto Cerebro Humano] Este es el plan publicitado del neurocientífico suizo Henry Marcram para crear una simulación precisa del cerebro humano utilizando una supercomputadora. A diferencia del enfoque de Hinton, que comienza con un modelo muy simplificado y sigue el camino de la complicación gradual, Markram quiere incluir de inmediato la mayor cantidad posible de datos, hasta moléculas individuales, y espera que, como resultado, tenga plena funcionalidad y conciencia.El proyecto recibió fondos de $ 1.3 mil millones de la Comisión Europea, pero Hinton cree que esta mega-simulación fallará, quedando atascada en demasiadas partes móviles que nadie entiende todavía.Además, Hinton no cree que el cerebro pueda ser entendido solo por sus imágenes. Dichos datos deben usarse para crear y refinar algoritmos. "El pensamiento teórico y la investigación en el espacio de los algoritmos de aprendizaje son necesarios para crear una teoría como", dice la máquina de Boltzmann. El siguiente paso para Hinton es el desarrollo de algoritmos para entrenar aún más redes neuronales similares a las del cerebro, en las cuales las sinapsis conectan las neuronas dentro de una capa, y no solo entre diferentes capas. "El objetivo principal es comprender los beneficios que se pueden obtener al complicar los cálculos en cada etapa", dice.La hipótesis es que más conexiones conducirán a bucles posteriores más fuertes, lo que, según Olshausen, probablemente ayudará al cerebro a "completar los detalles faltantes". Las capas superiores interfieren con el trabajo de las neuronas de las capas inferiores que tratan con información parcial. "Todo esto está estrechamente relacionado con la conciencia", dice.El cerebro humano es aún mucho más complejo que cualquier modelo. Es más grande, más denso, más eficiente, tiene más interconexiones y neuronas complejas, y funciona simultáneamente con varios algoritmos. Olshausen sugiere que comprendamos aproximadamente el 15% de la actividad de la corteza visual. Aunque los modelos están avanzando, la neurociencia sigue siendo "similar a la física antes de Newton", dice. Sin embargo, confía en que el proceso de trabajar sobre la base de estos algoritmos algún día podrá explicar el enigma principal del cerebro: cómo los datos de los órganos sensoriales se transforman en un sentido subjetivo de la realidad. La conciencia, dice Olshausen, "es algo que emerge de la realidad, una máquina de Boltzmann muy compleja".

Imagen de la retina en la que los diferentes tipos de células están indicados por diferentes colores. Sensible al color (violeta) se conecta a la horizontal (naranja), que se conecta a bipolar (verde), y a las células de la retina y el ganglio (púrpura).El algoritmo de Boltzmann puede ser uno de los muchos utilizados por el cerebro para ajustar las sinapsis. En la década de 1990, varios grupos independientes desarrollaron un modelo teórico de cómo el sistema visual codifica eficientemente el flujo de información que va a la retina. La teoría postulaba que en las capas inferiores de la corteza visual hay un proceso de "codificación dispersa", similar a la compresión de imágenes, como resultado de lo cual las últimas etapas del sistema visual funcionan de manera más eficiente.Las predicciones del modelo pasan gradualmente pruebas cada vez más rigurosas. En el trabajopublicado en PLOS Computational Biology, los neurocientíficos computacionales de Gran Bretaña y Australia descubrieron que cuando las redes neuronales que utilizan el algoritmo de codificación dispersa de Products of Experts inventado por Hinton en 2002 procesan los mismos datos visuales inusuales que reciben los gatos vivos (para Por ejemplo, los gatos y las redes neuronales estudian imágenes rayadas), sus neuronas producen conexiones inusuales casi idénticas."Cuando la información llega a la corteza visual, el cerebro, creemos, la presenta como un código disperso", dijo Bruno Olshausen, neurocientífico computacional y director del Centro Redwood para Neurobiología Teórica en la Universidad de California-Berkeley, quien ayudó a desarrollar Teoría de la codificación dispersa. "Como si una máquina de Boltzmann estuviera sentada en tu cabeza y tratara de entender las conexiones que existen entre los elementos del código disperso".Olshausen y el equipo utilizaron modelos de redes neuronales de las capas superiores de la corteza visual para mostrar cómo el cerebro es capaz de mantener una percepción estable de la información visual a pesar del movimiento de las imágenes. En otro estudiodescubrieron que la actividad de las neuronas en la corteza visual de los gatos que miran una película en blanco y negro está muy bien descrita por la máquina Boltzmann.Una de las posibles aplicaciones de este trabajo es la creación de neuroprótesis, por ejemplo, una retina artificial. Si observa cómo "la información está formateada en el cerebro, puede comprender cómo estimular al cerebro para que piense que está viendo una imagen", dice Olshausen.Sezhnowski dice que comprender los algoritmos de crecimiento y reducción de las sinapsis permitirá a los investigadores cambiarlas y aprender cómo se interrumpe el funcionamiento de la red neuronal. "Entonces se pueden comparar con los problemas conocidos de las personas", dice. - Casi todos los trastornos mentales pueden explicarse por problemas con las sinapsis. Si podemos entender mejor las sinapsis, podemos entender cómo funciona normalmente el cerebro, cómo procesa la información, cómo aprende y qué sale mal si, por ejemplo, desarrolla esquizofrenia ".El enfoque para estudiar el cerebro usando redes neuronales contrasta fuertemente con el enfoque del Proyecto Cerebro Humano [ Proyecto Cerebro Humano] Este es el plan publicitado del neurocientífico suizo Henry Marcram para crear una simulación precisa del cerebro humano utilizando una supercomputadora. A diferencia del enfoque de Hinton, que comienza con un modelo muy simplificado y sigue el camino de la complicación gradual, Markram quiere incluir de inmediato la mayor cantidad posible de datos, hasta moléculas individuales, y espera que, como resultado, tenga plena funcionalidad y conciencia.El proyecto recibió fondos de $ 1.3 mil millones de la Comisión Europea, pero Hinton cree que esta mega-simulación fallará, quedando atascada en demasiadas partes móviles que nadie entiende todavía.Además, Hinton no cree que el cerebro pueda ser entendido solo por sus imágenes. Dichos datos deben usarse para crear y refinar algoritmos. "El pensamiento teórico y la investigación en el espacio de los algoritmos de aprendizaje son necesarios para crear una teoría como", dice la máquina de Boltzmann. El siguiente paso para Hinton es el desarrollo de algoritmos para entrenar aún más redes neuronales similares a las del cerebro, en las cuales las sinapsis conectan las neuronas dentro de una capa, y no solo entre diferentes capas. "El objetivo principal es comprender los beneficios que se pueden obtener al complicar los cálculos en cada etapa", dice.La hipótesis es que más conexiones conducirán a bucles posteriores más fuertes, lo que, según Olshausen, probablemente ayudará al cerebro a "completar los detalles faltantes". Las capas superiores interfieren con el trabajo de las neuronas de las capas inferiores que tratan con información parcial. "Todo esto está estrechamente relacionado con la conciencia", dice.El cerebro humano es aún mucho más complejo que cualquier modelo. Es más grande, más denso, más eficiente, tiene más interconexiones y neuronas complejas, y funciona simultáneamente con varios algoritmos. Olshausen sugiere que comprendamos aproximadamente el 15% de la actividad de la corteza visual. Aunque los modelos están avanzando, la neurociencia sigue siendo "similar a la física antes de Newton", dice. Sin embargo, confía en que el proceso de trabajar sobre la base de estos algoritmos algún día podrá explicar el enigma principal del cerebro: cómo los datos de los órganos sensoriales se transforman en un sentido subjetivo de la realidad. La conciencia, dice Olshausen, "es algo que emerge de la realidad, una máquina de Boltzmann muy compleja".Source: https://habr.com/ru/post/es401931/

All Articles