Lawrence Kraus es físico teórico, cosmólogo, director del proyecto Origins, fundador de la Escuela de Investigación de la Tierra y el Espacio de la Universidad Estatal de Arizona. Es autor de los libros más vendidos, como The Universe from Nothing y The Physics of Star Trek. Traducción de un extracto de su futuro libro, "La historia más grande contada hasta ahora: ¿Por qué estamos aquí?" [La historia más grande jamás contada - Hasta ahora: ¿Por qué estamos aquí?].

Antes del descubrimiento de la partícula de Higgs en 2012, los expertos en física de partículas soñaban con dos tipos de pesadillas. La primera es que no encontrarán nada en el Gran Colisionador de Hadrones (LHC). En este caso, sería el último acelerador importante construido para sondear la estructura fundamental del universo. El segundo es que encontrarán la partícula de Higgs predicha por el físico teórico Peter Higgs en 1964 en el LHC ... y nada más.

Cada descubrimiento de un nivel de realidad nos muestra los siguientes niveles. Por lo tanto, cada descubrimiento importante en la ciencia generalmente nos deja con más preguntas que respuestas. Pero, por lo general, nos da al menos un diagrama del camino a seguir, ayudándonos a buscar respuestas a nuevas preguntas. El descubrimiento exitoso de la partícula de Higgs y la confirmación de la existencia en el espacio de un fondo invisible del campo de Higgs (en el mundo cuántico, cada partícula, como una partícula de Higgs, está asociada con un campo), se ha convertido en una confirmación contundente de los audaces descubrimientos científicos del siglo XX.

Pero

las palabras de

Sheldon Lee Glashow no han perdido su relevancia: la partícula de Higgs es similar a una alcantarilla. Ella esconde todos los detalles desordenados de los que no queremos hablar. El campo de Higgs interactúa con la mayoría de las partículas elementales cuando se mueven en el espacio, y crea una fuerza de resistencia que ralentiza su movimiento y les da la apariencia de masa. Por lo tanto, las masas de partículas elementales medidas por nosotros y haciendo posible nuestro mundo familiar son una especie de ilusión, un accidente de nuestra percepción.

Esta idea puede parecer elegante, pero de hecho es una adición especial al Modelo Estándar de Física, que explica tres de las cuatro fuerzas conocidas y cómo interactúan con la materia. Se agregó a la teoría para satisfacer los requisitos necesarios para una descripción precisa de nuestro mundo. Pero la teoría en sí misma no lo requiere. El Universo podría existir fácilmente con partículas sin masa y una interacción débil de largo alcance (una de las cuatro interacciones; el resto será una fuerza fuerte, electromagnética y gravitacional). Simplemente no seríamos nosotros y nuestras preguntas. Además, la física exacta del modelo de Higgs no se define solo dentro del modelo estándar. La partícula podría ser 20 veces más pesada o 100 veces más ligera.

Entonces, ¿por qué existe? ¿Y por qué ella tiene tanta masa? (Considerando que cuando un científico hace la pregunta "¿Por qué?", En realidad quiere decir "¿Cómo?"). Si no hubiera partículas de Higgs, no habría un mundo como el que observamos, pero esto claramente no se puede llamar Una explicación. ¿O es posible? Comprender las bases de la física de Higgs significa comprender cómo aparecimos nosotros mismos. Cuando preguntamos: "¿Por qué estamos aquí?", En efecto, preguntamos: "¿Por qué está aquí el Higgs?" Y el modelo estándar no puede responder esta pregunta.

Hay algunas pistas que provienen de una combinación de teoría y experimento. Poco después de establecer la estructura clara del Modelo Estándar, en 1974, y mucho antes de la confirmación experimental de sus detalles en la próxima década, dos grupos diferentes de físicos de Harvard, en los que trabajaron Sheldon Lee Glashow y

Stephen Weinberg , notaron algo interesante. Glashow, junto con

Howard Georgie , hizo lo que mejor sabía: buscar patrones en partículas e interacciones existentes, y nuevas posibilidades utilizando la teoría matemática de grupos.

En el modelo estándar, las interacciones débiles y electromagnéticas se combinan a altas energías en una sola fuerza, que los físicos llaman "electroataque". Esto significa que las mismas matemáticas controlan la interacción débil y electromagnética, ambas obedecen a las mismas simetrías y estas dos fuerzas son reflejos diferentes de la misma teoría unificada. Pero la simetría se "rompe espontáneamente" por el campo de Higgs que interactúa con partículas que transfieren interacción débil, pero no con partículas que transportan electromagnética. Esta propiedad de la naturaleza lleva al hecho de que estas dos interacciones se ven separadas y diferentes en las escalas disponibles para nuestras mediciones, mientras que la interacción débil funciona a distancias cortas y la interacción electromagnética a largas distancias.

Georges y Glashow intentaron expandir esta idea y conectar una interacción fuerte con ellos, y descubrieron que todas las partículas conocidas y tres interacciones sin gravedad encajan naturalmente en una estructura fundamentalmente simétrica. Razonaron que esta simetría puede romperse espontáneamente en una escala de energía ultraalta (y a una corta distancia), que está más allá de las capacidades de los experimentos modernos, y da lugar a dos simetrías separadas: interacción fuerte y electrodébil. Como resultado, a energías más bajas y a grandes distancias, se destruye la simetría de electroválvula, dividiendo la interacción de electroválvula en débil, actuando a distancias cortas y electromagnética, actuando a la larga.

Llamaron modestamente a tal teoría la Gran Teoría de la Unificación (TVO).

Al mismo tiempo, Weinberg y Georgie, junto con

Helen Quinn, notaron algo interesante, desarrollando el trabajo de Frank Wilchek, David Gross y David Politzer. Si a distancias pequeñas la interacción fuerte se vuelve más débil, entonces lo electromagnético y lo débil se vuelven más fuertes.

No era necesario tener siete tramos en la frente para estar interesados en si la fuerza de tres interacciones diferentes a pequeña escala coincide. Después de calcular, encontraron (con la precisión con la que se midieron las interacciones) que tal unión es posible, pero solo a distancias de 15 órdenes de magnitud más pequeñas que el tamaño del protón.

Si TVO fue la propuesta por Howard Georgie y Glashow, entonces esta fue una buena noticia, porque si todas las partículas que observamos en la naturaleza se combinan de esta manera, entonces debe haber nuevas partículas (

bosones de calibración ) que proporcionen una conexión entre los quarks (de los cuales protones y neutrones) y electrones con neutrinos. Y esto significaría que los protones pueden descomponerse en partículas más ligeras, lo que podemos observar en principio. Como escribió Glashow, "los diamantes no son para siempre".

E incluso entonces se sabía que la vida útil del protón es extremadamente larga. No solo porque todavía existimos 14 mil millones de años después del Big Bang, sino también porque no morimos de cáncer en la infancia. Si la vida útil promedio de los protones fuera inferior a mil millones de millones de años, en la infancia, suficientes protones se pudrirían en nuestros cuerpos para que su radiación nos matara. En mecánica cuántica, todos los procesos son probabilísticos. Si el protón promedio vive mil millones de billones de años, y si tiene mil millones de billones de protones, uno de ellos decaerá en promedio cada año. Y en

nuestro cuerpo mucho más de mil millones de billones de protones.

Sin embargo, con una escala de distancias tan increíblemente pequeña y, en consecuencia, con una escala de masa tan grande, asociada con la ruptura de simetría espontánea en el TVO, los nuevos bosones de calibración reciben grandes masas. Y esto llevaría al hecho de que las interacciones controladas por ellos ocurrirían a distancias tan pequeñas que serían increíblemente débiles desde el punto de vista de protones y neutrones. Como resultado, aunque los protones pueden descomponerse, en nuestro caso, antes de eso, pueden sobrevivir, tal vez un millón de billones de billones de años.

Gracias a los resultados obtenidos por Glashow con Georgie, así como Georges con Quinn y Weinberg, las expectativas de una gran síntesis estaban en el aire. Después del éxito de la teoría del electrodébil, los físicos de partículas eran ambiciosos y creían en una posterior unificación.

¿Cómo sabes si estas ideas son ciertas? Era imposible construir un acelerador capaz de trabajar a energías mil millones de veces más grandes que la masa de protones en reposo. La circunferencia de tal máquina tendría que compararse con la órbita de la luna. E incluso si fuera posible, como resultado del fracaso del superconductor superconductor, ningún gobierno aprobaría dicha estimación [Este colisionador, también llamado Desertron, se iba a construir en Texas en los años 90, pero debido a problemas de presupuesto, el proyecto ha sido cancelado Se planeó que su circunferencia fuera de 87.1 km. Se gastaron $ 2 mil millones en construcción, y el costo final se estimó en $ 12 mil millones - aprox. transl.].

Afortunadamente, había otra forma: usar la probabilidad descrita por mí, limitando la vida útil del protón. Si TVO predice una vida útil de protones de mil billones de billones de billones de años, entonces necesita meter mil billones de billones de protones en un detector y, en promedio, uno de ellos decaerá cada año.

¿Y dónde obtener tantos protones? Es simple: en 3000 toneladas de agua.

Todo lo que se requería para esto era colocar un tanque de agua en la oscuridad, asegurarse de que no hubiera fondo radiactivo en este lugar, rodearlo con fotocélulas sensibles capaces de detectar destellos de luz en el detector, y luego esperar un año para que parpadee un destello cuando el protón se descomponga. Suena aterrador, pero sin embargo, de acuerdo con un esquema de este tipo, se pagaron y construyeron al menos dos grandes plantas experimentales: una en el

fondo de una mina de sal cerca del lago Erie (IMB), y la otra

en una mina de zinc de Kamioka en Japón (Kamiokande). Las minas se utilizaron para cortar los rayos cósmicos, en cuyo contexto sería imposible notar la descomposición del protón.

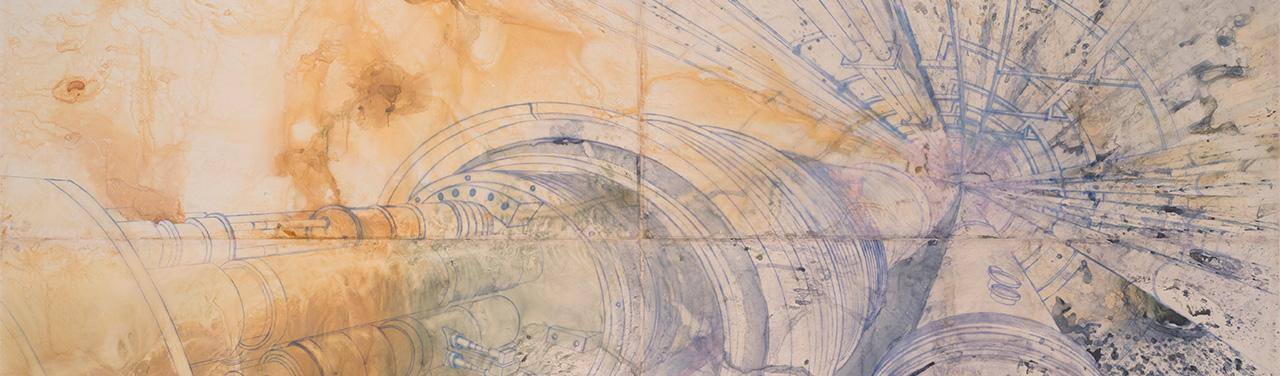

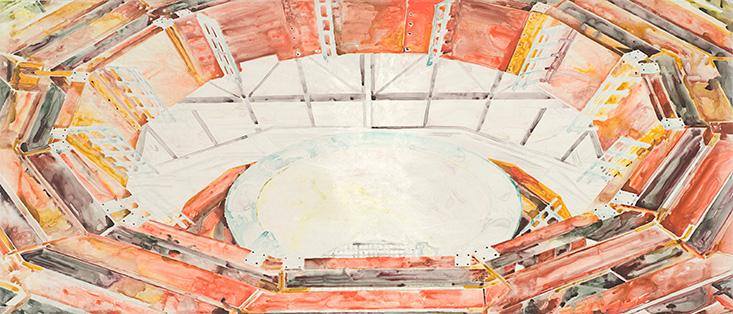

Gran Colisionador de Hadrones

Gran Colisionador de HadronesAmbos experimentos comenzaron a funcionar en 1982-1983. Los científicos se dejaron llevar tanto por TVO que esperaban con confianza que la señal apareciera pronto. En este caso, TVO sería la culminación de una década de tremendo desarrollo y descubrimientos en física de partículas, sin mencionar el próximo

Nobel para Glashow , y posiblemente algo más.

Desafortunadamente, en este caso, la naturaleza no fue tan amable. Ni una sola señal apareció en el primer año, ni en el segundo, ni en el tercero. El modelo simple y elegante de Glashow y Georgie pronto tuvo que ser rechazado. Pero la fiebre TBO ya había capturado a los científicos, y era difícil deshacerse de ella. Se hicieron otras sugerencias con respecto a las teorías de la unificación, debido a que la descomposición de los protones iría más allá del alcance de los experimentos actuales.

El 23 de febrero de 1987, ocurrió otro evento, demostrando nuevamente un aforismo casi universal: cada nueva ventana al Universo nos toma por sorpresa. Ese día, un grupo de astrónomos en placas fotográficas acumuladas durante la noche descubrió la estrella explosiva (supernova) más cercana de todas las que hemos visto en los últimos 400 años. Esta estrella, ubicada a 160,000 años luz de nosotros, estaba en la

Gran Nube de Magallanes , una pequeña galaxia, un satélite de la Vía Láctea, que se puede ver en el hemisferio sur.

Si nuestras teorías sobre la explosión de estrellas son ciertas, la mayor parte de la energía que emiten debería tomar la forma de un neutrino, a pesar de que la luz de su explosión es el más brillante de los fuegos artificiales cósmicos (y explotan aproximadamente una estrella en una galaxia en 100 años). Cálculos aproximados mostraron que los detectores de agua IMB y Kamiokande tuvieron que detectar alrededor de 20 colisiones con neutrinos. Y cuando los experimentadores de estos detectores estudiaron los datos de ese día, IBM encontró 8 candidatos en un intervalo de 10 segundos y en Kamiokand - 11. Para la física de neutrinos, era solo un mar de datos. La astrofísica de neutrinos ha madurado repentinamente. Probablemente, 1900 trabajos científicos de varios físicos (incluido yo mismo) se basaron en estos 19 eventos, quienes se dieron cuenta de que este evento nos abrió una ventana sin precedentes hacia los núcleos de las estrellas en explosión, y hacia el laboratorio no solo para la astrofísica, sino también para la física de los neutrinos.

Impulsados por la idea de que los grandes detectores de descomposición de protones pueden convertirse simultáneamente en detectores astrofísicos de neutrinos, varios grupos de científicos comenzaron a construir una nueva generación de detectores de doble propósito. El más grande fue reconstruido en la mina Kamioka y apodado Super Kamiokande, y por una buena razón. Este gigantesco reservorio de agua con un peso de 50,000 toneladas, rodeado de 11,800 fotocélulas, trabajó en una mina existente, y el experimento se llevó a cabo con limpieza de laboratorio. Esto era necesario, ya que con un detector tan grande era necesario cuidar no solo los rayos cósmicos externos, sino también los contaminantes radiactivos internos que eclipsarían todas las señales útiles.

Mientras tanto, el interés por los neutrinos astrofísicos también estaba en su apogeo. El sol emite neutrinos como resultado de las reacciones nucleares que tienen lugar en su núcleo, y durante 20 años el físico Ray Davis descubrió los neutrinos solares, pero los eventos ocurrieron tres veces menos de lo que predijeron los mejores modelos del Sol. Se construyó un nuevo tipo de detector solar de neutrinos llamado Sudbury Neutrino Observatory (SNO) en la mina de Sudbury en Canadá.

Hasta la fecha, Super Kamiokande ha trabajado casi continuamente, a veces experimentando varias mejoras, durante 20 años. Desde entonces no se han observado señales de desintegración de protones ni nuevas supernovas. Sin embargo, la observación precisa de los neutrinos, junto con observaciones adicionales sobre SNO, confirmó inequívocamente la realidad de la deficiencia de neutrinos solares descubierta por Ray Davis. Se descubrió que el déficit no existe debido a los fenómenos astrofísicos que ocurren en el Sol, sino a las propiedades de los neutrinos. Quedó claro que al menos uno de los tres tipos de neutrinos no tiene masa. Dado que los neutrinos no están incluidos en el Modelo Estándar, esta fue la primera observación confirmada de que algunas nuevas físicas funcionan fuera del Modelo Estándar y de Higgs.

Los neutrinos de alta energía bombardean regularmente la Tierra después de que los protones de los rayos cósmicos de alta energía colisionan con la atmósfera y producen una

amplia lluvia de partículas subatómicas secundarias, donde también se encuentran estos neutrinos. Las observaciones de ellos mostraron que el segundo tipo de neutrino también tiene masa. Es ligeramente más grande que el primero, pero mucho menos que la masa del electrón. Para esta observación, los equipos de SNO y Kamiokande recibieron un Premio Nobel en 2015, una semana antes de que comenzara a escribir este libro. Hasta el día de hoy, estas alusiones seductoras a la nueva física no se han explicado utilizando nuestras teorías.

La ausencia de descomposición de protones fue una decepción, pero no una sorpresa completa. Desde el momento en que TVO se propuso por primera vez, el panorama de la física ha sufrido cambios. Las mediciones más precisas de los valores de las tres interacciones no gravitacionales, junto con cálculos más complejos de los cambios en su magnitud con la distancia, mostraron que si solo existen partículas del Modelo estándar en la naturaleza, entonces las fuerzas de estas tres interacciones no se combinarán en una escala. Para que suceda la Gran Unificación, tendrá que existir una nueva física, ubicada en una escala de energía que supere todo lo que hemos observado hasta ahora. Y la presencia de nuevas partículas no solo cambiaría la escala de energía para combinar las tres interacciones, sino que también aumentaría la escala de TBO, reduciendo así la tasa de descomposición del protón y aumentando su vida útil más allá de millones de miles de millones de millones de años.

Gran Colisionador de Hadrones

Gran Colisionador de HadronesParalelamente a estos eventos, los teóricos utilizaron activamente nuevas herramientas matemáticas para estudiar un nuevo tipo probable de simetría, que comenzaron a llamar supersimetría. Esta simetría fundamental difiere de otras conocidas en que une dos tipos diferentes de partículas: fermiones (partículas con un giro de medio entero) y bosones (partículas con un giro completo). Y la conclusión es que si tal simetría se observa en la naturaleza, entonces para cada partícula conocida en el Modelo Estándar debe haber al menos una partícula nueva. Para cada nuevo bosón, debe existir un fermión. Por cada fermión, un bosón.

Como no observamos estas partículas, esta simetría no puede manifestarse en el nivel del universo que sea accesible para nosotros y, por lo tanto, debe romperse, lo que significa que las nuevas partículas deben tener masas lo suficientemente grandes como para no encontrarse todavía en los aceleradores existentes.

¿Qué es tan atractivo en simetría que de repente duplica el número de partículas en la naturaleza cuando no hay evidencia de su existencia? En su mayor parte, ella es seducida por la Gran Unificación. Dado que si TVO existe en una escala de masa de 15-16 órdenes de magnitud de masas de reposo de protones más grandes, entonces es 13 órdenes de magnitud más grande que las escalas en las que se rompe la simetría de electroválvula. La pregunta es cómo y por qué en las leyes fundamentales de la naturaleza hay una brecha de escala tan grande. En particular, si Higgs es realmente la última partícula del Modelo Estándar, entonces surge la pregunta: ¿por qué la escala de ruptura de simetría de Higgs es 13 órdenes de magnitud más pequeña que la escala de ruptura de simetría de un nuevo campo que divide la DOS simetría en interacciones separadas?

Y el problema es aún peor de lo que parece.

Si consideramos los efectos de las partículas virtuales (que surgen y desaparecen tan rápidamente que su existencia puede confirmarse solo indirectamente), incluidas las partículas de una masa arbitrariamente grande (como las partículas de calibre del supuesto TBT), queda claro que la masa y la escala de la ruptura de la simetría de Higgs aumentan tanto que acercándose a la gran escala de TVO. De ahí el llamado El problema de la naturalidad . Técnicamente hablando, la existencia de una gran jerarquía de escalas no es natural , desde aquellas en las que la partícula de Higgs rompe la simetría de electroválvula, hasta aquellas en las que la simetría de TVO se rompe por un nuevo campo escalar, sea lo que sea.El físico matemático Edwart Whitten escribió en su histórico trabajo de 1981 que la supersimetría tiene una propiedad especial. Puede reducir el efecto de partículas virtuales de masa y energía arbitrariamente grandes sobre las propiedades del mundo en las escalas que están disponibles para nuestras observaciones. Dado que los fermiones virtuales y los bosones virtuales de la misma masa conducen a correcciones cuánticas idénticas, aparte del signo, entonces, si cada bosón corresponde a un fermión de la misma masa, los efectos cuánticos de las partículas virtuales se aniquilan mutuamente. Y esto significa que el efecto de las partículas virtuales de una masa y energía arbitrariamente grandes sobre las propiedades del mundo en las escalas que están disponibles para nuestras observaciones desaparece por completo.Si la supersimetría en sí misma se rompe (como debería ser, de lo contrario todos los socios supersimétricos de la materia ordinaria tendrían la misma masa que las partículas ordinarias, y las habríamos descubierto hace mucho tiempo), entonces las correcciones cuánticas no se destruyen. Conducen a adiciones a las masas a escalas comparables a aquellas en que se rompe la supersimetría. Si fueran comparables a la escala de la violación de la simetría de electroválvula, esto explicaría la escala de la masa de Higgs.También significa que uno puede esperar la observación de un montón de partículas nuevas, socios supersimétricos de la materia ordinaria, en las escalas que el LHC está investigando ahora.Esto resolvería el problema de la naturalidad, ya que protegería a las masas del bosón de Higgs de las correcciones cuánticas, lo que las empujaría a la escala de energía del TVO. La supersimetría puede permitir la existencia de una gran jerarquía "natural" de energía y masa, dividiendo la escala de electroválvulas y la escala de la TVO.El hecho de que la supersimetría en principio pueda resolver el problema de la jerarquía ha aumentado su atractivo para los físicos. Los teóricos comenzaron a explorar modelos realistas, incluida la ruptura de la supersimetría y otras consecuencias de esta idea. Después de eso, el "valor de cambio" de la supersimetría rompió todos los récords. Dado que, si incluimos la posibilidad de ruptura espontánea de la supersimetría en los cálculos de cambios en tres interacciones no gravitacionales dependiendo de la distancia, resulta que la fuerza de estas tres interacciones naturalmente converge repentinamente en una escala de pequeñas distancias. ¡TVO vuelve a funcionar!Los modelos con supersimetría rota tienen una característica más atractiva. Mucho antes del descubrimiento del quark superior, se demostró que si el quark superior es pesado, a través de la interacción con otros socios supersimétricos, puede contribuir a las correcciones cuánticas a las propiedades de la partícula de Higgs, lo que conducirá a un cambio en el campo de Higgs. Si la Gran Unificación ocurre en una escala de energías mucho mayor, entonces el campo de Higgs debería formar un fondo coherente en todo el espacio al nivel de energía en el que tienen lugar las mediciones actuales. En resumen, la escala de energía de la ruptura de la simetría de electrodébil puede ocurrir naturalmente en una teoría en la que el VO ocurre a una escala mucho mayor. Y cuando se descubrió el quark superior y se estableció que era realmente pesado,Esto se sumó al atractivo de la posibilidad de que la ruptura de la supersimetría sea responsable de las escalas de energía observadas de la interacción débil.Pero todo esto tiene un precio. Para que una teoría funcione, debe haber dos bosones de Higgs, no uno. Además, en un acelerador como el LHC, sería necesario encontrar nuevas partículas supersimétricas: es capaz de explorar una nueva física en la región de escalas de electrodébil. Y finalmente, lo que parecía una restricción demasiado estricta durante algún tiempo: el más ligero de los Higgs no podía ser demasiado pesado, o este mecanismo no funcionaría en absoluto.Mientras la búsqueda de Higgs continuaba sin mucho éxito, los aceleradores se acercaban constantemente al límite superior teórico de la masa ligera de Higgs en las teorías supersimétricas. Este valor era de aproximadamente 135 masas de protones, y los detalles ya dependían del modelo específico. Si no se encontrara a Higgs en esta escala, esto significaría que todo el bombo en torno a la supersimetría seguiría siendo bombo.Pero resultó diferente. Higgs encontrado en el LHC tiene una masa de 125 veces el protón. Es posible que alcancemos una gran síntesis.Hasta la fecha, la respuesta no está clara. Los signos de la presencia de nuevas partículas supersimétricas, si existieran, deberían haber sido tan claramente visibles en el LHC que algunos físicos pensaron que las posibilidades de descubrir la supersimetría tenían muchas más probabilidades de encontrar Higgs. Pero todo salió mal. Después de tres años de operación, no hay signos de supersimetría visibles. La situación se está volviendo incómoda. Las restricciones más bajas impuestas a las masas de los socios supersimétricos de la materia ordinaria aumentan todo el tiempo. Si suben demasiado, la escala de ruptura de la supersimetría ya no estará cerca de la escala de electroválvula, y muchas propiedades atractivas de ruptura de la supersimetría que permiten resolver el problema de la jerarquía simplemente se evaporarán.Pero la esperanza permanece, y el LHC se vuelve a encender, ya con una energía más alta. Es posible que pronto se detecten partículas supersimétricas. Su detección conducirá a otro resultado importante. Uno de los mayores misterios de la cosmología es la naturaleza de la materia oscura, que parece dominar todas las galaxias que vemos. Existe tanto que no puede consistir en las mismas partículas que la materia normal. Si consistiera en partículas normales, entonces, por ejemplo, las predicciones sobre la abundancia de elementos ligeros como el helio obtenido durante el Big Bang no serían consistentes con las observaciones. Por lo tanto, los físicos están bastante seguros de que la materia oscura consiste en un nuevo tipo de partículas elementales. Pero cual?El socio supersimétrico más ligero de la materia ordinaria en la mayoría de los modelos es completamente estable y sus propiedades son muy parecidas a las de los neutrinos. Interactuaría débilmente y sería eléctricamente neutro, por lo que no absorbería ni emitiría luz. Además, los cálculos de hace 30 años, en los que también participé, mostraron que la abundancia residual de la partícula supersimétrica más ligera que quedaba después del Big Bang, naturalmente, sería tal que correspondería al dominio de la masa de materia oscura en las galaxias.En este caso, nuestra galaxia tendría un halo de partículas de materia oscura silbando a través de sus partes, incluida la habitación en la que la lees. Como muchos de nosotros hemos entendido por mucho tiempo, esto significa que puede desarrollar detectores subterráneos sensibles, similares, aunque solo en esencia, a los detectores de neutrinos existentes, y detectar partículas de materia oscura directamente. Una docena de excelentes experimentos en todo el mundo están tratando de hacer precisamente eso. Pero hasta ahora nadie ha encontrado nada.Por lo tanto, ahora vivimos en tiempos mejores o peores. Hay una carrera entre el LHC y los detectores subterráneos de materia oscura por el derecho de ser el primero en descubrir su naturaleza. Si un grupo anuncia su descubrimiento, dará paso al descubrimiento de un mundo completamente nuevo de descubrimientos, lo que podría conducir a una comprensión de la propia TVO. Y si no hay descubrimientos en los próximos años, será posible excluir la opción del origen supersimétrico de la materia oscura y, en general, la idea de la supersimetría como una solución al problema de la jerarquía. En este caso, tendrá que volver al tablero, sin embargo, en ausencia de cualquier señal del LHC, no tendremos una comprensión de qué dirección debemos mover para desarrollar un nuevo modelo de la naturaleza.Todo se volvió mucho más interesante cuando el LHC descubrió una posible señal que nos prometía una nueva partícula seis veces más pesada que el Higgs. Las características de esta partícula no coincidían con las características esperadas de ninguno de los socios supersimétricos de la materia ordinaria. Por lo general, cuando se procesa una gran matriz de datos, desaparecen los indicios más seductores de las señales, y seis meses después de la aparición de esta señal y el procesamiento de datos, desaparece. De lo contrario, podría cambiar toda nuestra idea de TVO y simetría de electroválvula, insinuar la existencia de una nueva interacción fundamental y un nuevo conjunto de partículas asociadas a ella. Pero, aunque condujo a la aparición de un trabajo científico teórico esperanzador, la naturaleza decidió a su manera.Pero un equipo de físicos no está preocupado por la ausencia de una detección experimental clara o confirmación de supersimetría durante mucho tiempo y aún. La belleza matemática de la supersimetría en 1984 inspiró a los científicos a resucitar una idea que ha estado dormitando desde la década de 1960. Luego, Yoichiro Nambu y sus colegas trataron de descubrir una interacción fuerte, presentándola como señales de cadena que conectan los quarks. Y cuando se incluyó la supersimetría en la teoría de cuerdas cuánticas para obtener lo que se conoció como teoría de supercuerdas, comenzaron a aparecer resultados matemáticos sorprendentemente hermosos. Entre ellos está la posibilidad de combinar no solo tres interacciones no gravitacionales, sino en general las cuatro fuerzas conocidas en la naturaleza en una teoría de campo cuántico consistente.Sin embargo, esta teoría requiere la existencia de un montón de dimensiones adicionales del espacio-tiempo, que nadie ha observado todavía. Además, la teoría no hace predicciones que puedan verificarse en el nivel experimental actual. Además, se ha vuelto tan complicado recientemente que ahora parece que las cadenas mismas ya no son las variables dinámicas centrales de esta teoría.Pero esto no disminuyó el entusiasmo de los seguidores más entusiastas, devotos y extremadamente talentosos de la teoría de las supercuerdas, ahora conocidas como teorías M, que durante 30 años han seguido trabajando en ella. Periódicamente, aparecen afirmaciones de gran éxito, pero hasta ahora la teoría M carece de un elemento clave que asegure el triunfo de una empresa científica como el Modelo Estándar: la capacidad de ponerse en contacto con el mundo que podemos medir, resolver misterios inexplicables por otros métodos y proporcionar elementos fundamentales. explicaciones de por qué nuestro mundo es lo que es. Esto no significa que la teoría M sea errónea, pero hasta ahora solo representa un razonamiento, aunque tiene un buen motivo.Si sigues las lecciones de la historia, queda claro que las teorías físicas más avanzadas resultaron ser falsas. De lo contrario, cualquiera podría dedicarse a la física teórica. Tomó varios siglos, y si tomamos en cuenta la ciencia de los antiguos griegos, entonces varios milenios, el método de prueba y error, que condujo a la aparición del Modelo Estándar.Y aqui estamos. ¿Nos aguardarán pronto nuevas revelaciones experimentales, que serán capaces de confirmar o refutar los mejores argumentos de la física teórica? ¿O estamos al borde del desierto y la naturaleza no nos dará pistas sobre la dirección de la búsqueda de respuestas a los secretos del espacio? Lo descubriremos y, en cualquier caso, tendremos que vivir con una nueva realidad.

Su detección conducirá a otro resultado importante. Uno de los mayores misterios de la cosmología es la naturaleza de la materia oscura, que parece dominar todas las galaxias que vemos. Existe tanto que no puede consistir en las mismas partículas que la materia normal. Si consistiera en partículas normales, entonces, por ejemplo, las predicciones sobre la abundancia de elementos ligeros como el helio obtenido durante el Big Bang no serían consistentes con las observaciones. Por lo tanto, los físicos están bastante seguros de que la materia oscura consiste en un nuevo tipo de partículas elementales. Pero cual?El socio supersimétrico más ligero de la materia ordinaria en la mayoría de los modelos es completamente estable y sus propiedades son muy parecidas a las de los neutrinos. Interactuaría débilmente y sería eléctricamente neutro, por lo que no absorbería ni emitiría luz. Además, los cálculos de hace 30 años, en los que también participé, mostraron que la abundancia residual de la partícula supersimétrica más ligera que quedaba después del Big Bang, naturalmente, sería tal que correspondería al dominio de la masa de materia oscura en las galaxias.En este caso, nuestra galaxia tendría un halo de partículas de materia oscura silbando a través de sus partes, incluida la habitación en la que la lees. Como muchos de nosotros hemos entendido por mucho tiempo, esto significa que puede desarrollar detectores subterráneos sensibles, similares, aunque solo en esencia, a los detectores de neutrinos existentes, y detectar partículas de materia oscura directamente. Una docena de excelentes experimentos en todo el mundo están tratando de hacer precisamente eso. Pero hasta ahora nadie ha encontrado nada.Por lo tanto, ahora vivimos en tiempos mejores o peores. Hay una carrera entre el LHC y los detectores subterráneos de materia oscura por el derecho de ser el primero en descubrir su naturaleza. Si un grupo anuncia su descubrimiento, dará paso al descubrimiento de un mundo completamente nuevo de descubrimientos, lo que podría conducir a una comprensión de la propia TVO. Y si no hay descubrimientos en los próximos años, será posible excluir la opción del origen supersimétrico de la materia oscura y, en general, la idea de la supersimetría como una solución al problema de la jerarquía. En este caso, tendrá que volver al tablero, sin embargo, en ausencia de cualquier señal del LHC, no tendremos una comprensión de qué dirección debemos mover para desarrollar un nuevo modelo de la naturaleza.Todo se volvió mucho más interesante cuando el LHC descubrió una posible señal que nos prometía una nueva partícula seis veces más pesada que el Higgs. Las características de esta partícula no coincidían con las características esperadas de ninguno de los socios supersimétricos de la materia ordinaria. Por lo general, cuando se procesa una gran matriz de datos, desaparecen los indicios más seductores de las señales, y seis meses después de la aparición de esta señal y el procesamiento de datos, desaparece. De lo contrario, podría cambiar toda nuestra idea de TVO y simetría de electroválvula, insinuar la existencia de una nueva interacción fundamental y un nuevo conjunto de partículas asociadas a ella. Pero, aunque condujo a la aparición de un trabajo científico teórico esperanzador, la naturaleza decidió a su manera.Pero un equipo de físicos no está preocupado por la ausencia de una detección experimental clara o confirmación de supersimetría durante mucho tiempo y aún. La belleza matemática de la supersimetría en 1984 inspiró a los científicos a resucitar una idea que ha estado dormitando desde la década de 1960. Luego, Yoichiro Nambu y sus colegas trataron de descubrir una interacción fuerte, presentándola como señales de cadena que conectan los quarks. Y cuando se incluyó la supersimetría en la teoría de cuerdas cuánticas para obtener lo que se conoció como teoría de supercuerdas, comenzaron a aparecer resultados matemáticos sorprendentemente hermosos. Entre ellos está la posibilidad de combinar no solo tres interacciones no gravitacionales, sino en general las cuatro fuerzas conocidas en la naturaleza en una teoría de campo cuántico consistente.Sin embargo, esta teoría requiere la existencia de un montón de dimensiones adicionales del espacio-tiempo, que nadie ha observado todavía. Además, la teoría no hace predicciones que puedan verificarse en el nivel experimental actual. Además, se ha vuelto tan complicado recientemente que ahora parece que las cadenas mismas ya no son las variables dinámicas centrales de esta teoría.Pero esto no disminuyó el entusiasmo de los seguidores más entusiastas, devotos y extremadamente talentosos de la teoría de las supercuerdas, ahora conocidas como teorías M, que durante 30 años han seguido trabajando en ella. Periódicamente, aparecen afirmaciones de gran éxito, pero hasta ahora la teoría M carece de un elemento clave que asegure el triunfo de una empresa científica como el Modelo Estándar: la capacidad de ponerse en contacto con el mundo que podemos medir, resolver misterios inexplicables por otros métodos y proporcionar elementos fundamentales. explicaciones de por qué nuestro mundo es lo que es. Esto no significa que la teoría M sea errónea, pero hasta ahora solo representa un razonamiento, aunque tiene un buen motivo.Si sigues las lecciones de la historia, queda claro que las teorías físicas más avanzadas resultaron ser falsas. De lo contrario, cualquiera podría dedicarse a la física teórica. Tomó varios siglos, y si tomamos en cuenta la ciencia de los antiguos griegos, entonces varios milenios, el método de prueba y error, que condujo a la aparición del Modelo Estándar.Y aqui estamos. ¿Nos aguardarán pronto nuevas revelaciones experimentales, que serán capaces de confirmar o refutar los mejores argumentos de la física teórica? ¿O estamos al borde del desierto y la naturaleza no nos dará pistas sobre la dirección de la búsqueda de respuestas a los secretos del espacio? Lo descubriremos y, en cualquier caso, tendremos que vivir con una nueva realidad.