La ciencia escolar a menudo se enseña de forma seca y sin interés. Los niños aprenden a memorizar mecánicamente para aprobar el examen, y no ven la conexión de la ciencia con el mundo exterior.

Estas palabras pertenecen al gran físico, que nunca se rinde y cree en los milagros, Stephen Hawking. Pero lo que importa no son las palabras sobre educación, sino la segunda parte de la cita sobre la conexión entre la ciencia y el mundo exterior. La ciencia nos sigue todos los días. Está en todas partes, lo veamos o no. Sentimos su influencia independientemente de nuestra religión, lugar de residencia u ocupación. Maldita sea, la ciencia era incluso antes de que se acuñara el término. Nuestro universo entero está lleno de procesos que son descritos por varias ciencias. En su mayor parte, todavía se da preferencia a la física. Una ciencia capaz de llamar al orden del caos y al orden del caos. Y explique por qué es así, y no de otra manera. Sin embargo, me gustaría referirme a la ciencia, que, como la física, está presente en nuestra vida y tiene una influencia increíble en su curso. No veo el punto de mantener la intriga por mucho tiempo, porque todos, ya desde el título de este ensayo, entendieron que se trataría de química. Pero no solo sobre la química, sino también sobre la ciencia, sino sobre cómo manifiesta su fuerza y belleza en el mundo de la informática.

Por supuesto, para la mayoría de nosotros, los recuerdos de las lecciones de química en la escuela no son nostalgia, sino más bien un alivio de la constatación de que esta pesadilla finalmente ha terminado. Sin embargo, no se puede minimizar el significado de esta ciencia. Fue la química la que nos permitió crear computadoras más rápidas y potentes, aumentar el volumen de los discos duros e incluso hacer que la calidad de la imagen en nuestros monitores fuera poco realista.

Con el tiempo, el mundo de las computadoras está mejorando rápidamente. Uno de los aspectos más visibles de este proceso es el aumento de la potencia y la reducción del tamaño de los dispositivos que utilizamos. Por ejemplo, microchips y, por lo tanto, transistores de silicio. Y todo este proceso de evolución informática se enfrenta constantemente a las leyes inexorables de la física. El aumento constante en el número de transistores en microchips da más potencia y más dolor de cabeza a sus creadores. Aquí es donde la química viene al rescate.

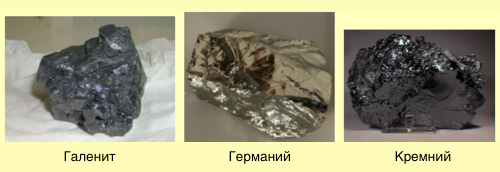

Química de transistoresLos transistores funcionan debido al hecho de que los semiconductores de los que están hechos (silicio, germanio) tienen una propiedad muy inusual y muy útil: conducen la corriente eléctrica mejor que los aislantes (vidrio, por ejemplo), pero no tan buenos como los conductores (aluminio, por ejemplo). )

Los científicos pueden manipular la conductividad de los semiconductores, aumentando o disminuyendo agregando una pequeña cantidad de impurezas (a menudo se utiliza boro o arsénico). Al "diluir" el silicio con otras sustancias, los científicos cambian sus propiedades. En última instancia, puede actuar como un aislante o como un metal. Lo que afecta directamente la capacidad de los transistores para realizar sus funciones.

El silicio

El silicio , el semiconductor utilizado para fabricar transistores, es el material más común en el mundo en este momento. Representa el 27.7% de la masa de la corteza terrestre y es el componente principal de la arena.

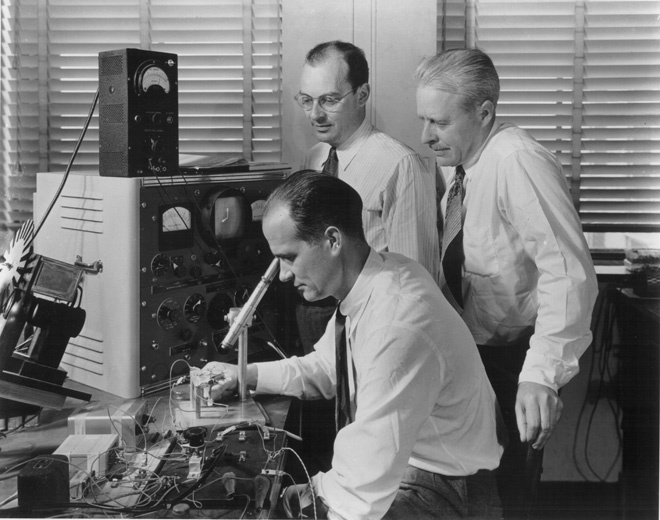

Aunque el primer transistor, creado en los Laboratorios Bell en 1947, se fabricó sobre la base de Alemania, hay varias razones por las que Silicon Valley no se llama Germanieva.

Laboratorios Bell

Laboratorios BellLa razón más común es la inaccesibilidad y el alto costo de Alemania. Un problema mucho más grave fueron las propiedades químicas de la forma aislante de esta sustancia llamada óxido de germanio. Se disuelve en agua, por lo tanto, en el proceso de molienda necesario para crear varios transistores en un microchip, simplemente "desaparecería". Por lo tanto, después de haber derramado un vaso de agua en su computadora portátil "alemana", simplemente la habría tirado.

Esto es lo que llevó a los científicos a usar silicio, que, a su vez, también tiene algunas desventajas. Sobre ellos un poco más tarde.

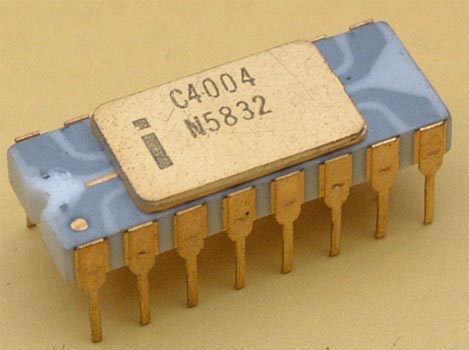

Intel 4004

Intel 4004Una pequeña digresión en la historia. En 1971, Intel lanzó el primer microprocesador Intel 4004, que contenía 2.300 transistores. Ahora un microprocesador contiene varios cientos de millones de transistores y su número crece cada año.

Esta es una confirmación directa de la ley de Moore (cofundador de Intel Gordon Moore), que establece que el número de transistores en un solo chip se duplicará dos veces cada 2 años. Una predicción muy audaz pero increíblemente precisa. Sin embargo, ahora los microchips son cada vez más pequeños. Su potencia en este caso aumenta precisamente debido a un aumento en el número de transistores. Y mientras la química está haciendo frente a este proceso, "talla menos / potencia más". Desafortunadamente, hay un "Pero": cuando los componentes del microchip disminuyen, el espacio donde los cables de conexión de los transistores están conectados a la oblea de silicio también disminuye. En términos generales, al reducir los transistores y los microchips, los componentes que conectan todos en uno deberían disminuir. Y al final, sin pensar en cómo reducir estos componentes, la potencia y el tamaño de los microchips se mantendrán en el nivel actual.

La solución a este problema para Intel fue el cambio de metal (los microchips se vuelven más pequeños y la resistencia es mayor). Cuando un conductor deja de ser efectivo, comience a usar otro. En la lejana década de 1980, se usaba tungsteno, luego titanio a principios de los 90, luego cobalto y níquel, que ahora se usa. Cada uno de los nuevos metales mejoró los microchips, ya que disminuyó el nivel de resistencia en los puntos de conexión.

Sin embargo, la transición constante de un metal a otro conlleva mucho dolor de cabeza para los fabricantes de microchips. Cada vez surgen nuevas dificultades. Después del uso a largo plazo de tungsteno (aproximadamente 5 años, según Intel), fue necesario cambiar el equipo para la deposición (almacenamiento) de materiales. También tuvimos que pasar de calentar obleas semiconductoras en hornos especiales a usar lámparas de descarga de gas, ya que esto acompaña una conexión más duradera del nuevo material con silicio. La tarea principal ahora es desarrollar una metodología que le permita cambiar los materiales necesarios sin costos especiales para el fabricante, tanto financieros como de tiempo.

Otro gran problema fue la conexión de los transistores y la placa en sí. O más bien, el deseo de pasar del aluminio al cobre. La conclusión es que el cobre es un mejor conductor que el aluminio, pero su uso es imposible debido a su susceptibilidad a la corrosión. Sin embargo, descartar este material es estúpido, es mejor ayudar a resolver el problema de la corrosión.

Titanio

TitanioY así, a principios de los años 90, los científicos llegaron a la conclusión de que una capa delgada de titanio sobre cobre puede prevenir la corrosión. Este problema se resolvió, pero había uno más. Los compuestos de aluminio podrían aplicarse al microprocesador utilizando métodos litográficos estándar. Lo que no se puede decir sobre el cobre. Además, el cobre no debe entrar en contacto con el silicio en vista de la presencia de ciertas interacciones entre materiales que pueden dañar los transistores.

Un aspecto importante de la reducción continua de microprocesadores no es solo la combinación de materiales. El rendimiento de las puertas del transistor depende directamente de la delgada capa aislante de dióxido de silicio. Una disminución en los transistores también ha llevado a una disminución en esta capa, cuyo grosor ahora oscila entre 3 y 4 átomos.

La desventaja de este grosor es la fuga de corriente. Es decir, en lugar de posiciones tales como activar o desactivar, activamos y desactivamos las posiciones con una fuga. Cuanto más pequeños se vuelven los microprocesadores, más potencia requieren para el funcionamiento normal.

Por lo tanto, al apagar el transistor, no se puede evitar la pérdida de corriente. El microchip Pentium consume alrededor de 30-40 vatios con una pérdida de 1 vatio. Ahora se necesitan aproximadamente 100 vatios para el funcionamiento normal de los microprocesadores modernos y, como resultado, se pierde aproximadamente la mitad de la corriente. Y este proceso también acompaña a una fuerte generación de calor. Es decir, en las computadoras portátiles no puede usar chips de 100 vatios, el límite máximo para estos dispositivos es de 30-40 vatios.

Por lo tanto, si no se resuelven todos los problemas anteriores, la ley de Moore se convertirá en historia y el proceso posterior de evolución de los microchips tendrá que esperar mucho tiempo.

ADN en lugar de silicioAlgunos de los investigadores están pensando en reemplazar completamente el silicio con algo más avanzado. Ya se usa arseniuro de galio, que tiene algunas ventajas sobre el silicio. En primer lugar, la velocidad de tales microprocesadores es mucho mayor. En segundo lugar, son extremadamente sensibles a varias ondas de radio, lo que los hace ideales para teléfonos móviles y tarjetas de conexión inalámbrica a Internet. Sin embargo, los requisitos de alta potencia han limitado el uso de transistores de arseniuro de galio exclusivamente en chips de comunicación.

Además, no se olvide de la investigación de los nanotubos de carbono. El uso de cilindros huecos requerirá significativamente menos energía que el hecho de silicio.

Sin embargo, si cambia levemente su pensamiento de la ciencia a la ciencia ficción, ¿por qué no usar el ADN? Esta opción parece casi poco realista. Sin embargo, vale la pena echar un vistazo a los posibles beneficios, ya que esta empresa parece un pastel, que todavía vale la pena. O más bien:

- Las cadenas de ADN ya codifican información, y los científicos ya pueden cambiarla copiando, eliminando o moviendo ciertos segmentos de la cadena;

- almacenar datos sobre el ADN aumentará significativamente la velocidad de su procesamiento y reducirá el consumo de energía (en teoría);

- También el material en sí (ADN) es muy asequible, barato, como los nanotubos, increíblemente pequeño en tamaño.

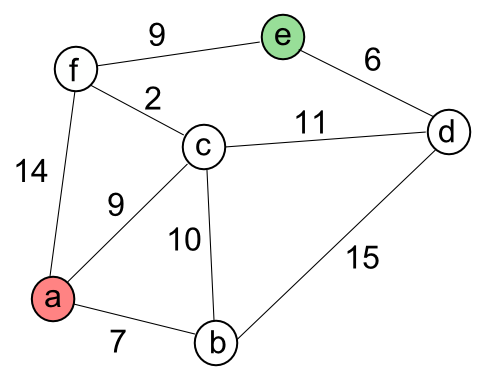

Ejemplo esquemático del problema del vendedor ambulante

Ejemplo esquemático del problema del vendedor ambulanteLa idea de usar ADN en tecnología informática no es nueva. En 1994, Leonard Max Adleman, un teórico de la informática en la Universidad del Sur de California, utilizó el ADN para resolver el problema del vendedor ambulante (encontrar el camino óptimo entre varias ciudades con la condición de visitarlas una sola vez). Tomó varios días, por lo que no hay necesidad de esperar computadoras súper rápidas de ADN en el futuro cercano.

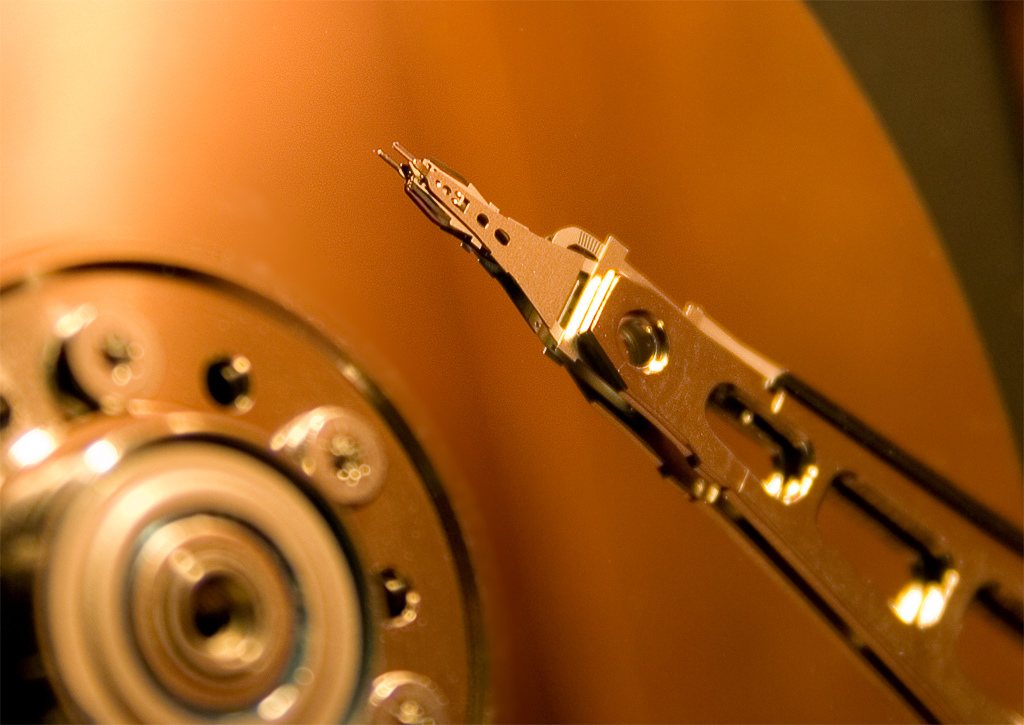

HDD de químicaLos discos duros o HDD son uno de los medios más comunes para almacenar y procesar datos, especialmente en computadoras portátiles y personales. En el HDD, la información se registra en placas rígidas hechas de aluminio o vidrio recubierto con una capa de material ferromagnético.

El proceso de escribir datos en el HDD ocurre magnetizando un sector particular del HDD. Más precisamente, la placa rígida gira a alta velocidad, y el cabezal de escritura, ubicado a una distancia de 10 nm, transmite un campo magnético alterno que cambia el vector de magnetización del dominio, que se encuentra inmediatamente debajo del cabezal. En términos generales, un sector vacío (dominio) no tiene carga, y el relleno de información tiene un determinado vector magnético (norte-sur), cuya combinación crea una secuencia lógica 0 y 1, debido a la cual se forma la información en sí.

Como resultado, tenemos varios elementos que pueden mejorarse mediante el uso de nuevos elementos químicos: placas rígidas, cabeza de lectura-escritura. Los intentos de reducir el tamaño físico de las placas al tiempo que aumenta el volumen de información almacenada y procesada se enfrentan a nuevos problemas que la química puede resolver.

Actualmente, las placas HDD están hechas de una aleación de cobalto, cromo y platino. Los primeros dos materiales son necesarios para crear magnetismo y ocupan aproximadamente el 50-60% de la "mezcla" total. El platino evita un cambio incontrolado del vector magnético del dominio de la placa.

A medida que disminuye el espesor de la placa, surge un nuevo problema. Ahora las partículas magnéticas se miden en 10 nanómetros. Al ser tan pequeños, comienzan a vibrar durante el calentamiento. El platino todavía puede compensar este efecto, pero sus posibilidades no son ilimitadas.

Por lo tanto, con una disminución en el tamaño de la placa, el platino no podrá evitar un cambio incontrolado del vector magnético del dominio. Hasta ahora, este límite de tamaño no se ha alcanzado, pero los investigadores ya se han propuesto la tarea muy ambiciosa de reducirlo de 10 nanómetros a 5. Es posible lograr esto cambiando la temperatura a la que se forman las capas, o usar cierto material debajo de una capa magnética. Por ejemplo, el uso de níquel le permite dividir la placa en un mayor número de dominios.

Un problema aún más grave es que en los discos típicos, las partículas magnéticas no se dividen en regiones idénticas, una región puede ser más grande que la otra. En pocas palabras, cambiar la polaridad de la región magnética se complica por el hecho de que no conocemos la posición exacta de la región debido a la distribución desigual.

La química de las cabezas de los discos magnéticos también ha evolucionado.Los cabezales de lectura de los discos duros no tocan la superficie de las placas durante la operación debido a la capa intermedia del flujo de aire entrante que se forma cerca de la superficie durante la rotación rápida (generalmente 5400 o 7200 rpm). La distancia entre la cabeza y el disco en los discos modernos es de aproximadamente 10 nm. Una distancia tan pequeña se debe a la necesidad de transferir un campo magnético alterno desde la cabeza a la placa.

Inicialmente, los cabezales de lectura estaban hechos de níquel (80%) y hierro (20%). Más tarde, la relación se cambió a 45% / 55%. Sin embargo, esto no fue suficiente para resolver la tarea, ya que comenzaron a usar una aleación de cobalto y hierro.

Otro problema es el daño físico a la placa por el cabezal de lectura-escritura. Como ya dijimos, la placa gira muy rápidamente, creando una vibración, y la cabeza se encuentra en una insistencia críticamente pequeña. Y a veces la cabeza puede golpear la superficie de la placa, dañándola, lo que lleva al problema de leer datos.

La solución a este problema fue el uso de un revestimiento de carbono delgado, pero duro, similar al diamante, tanto un disco como un cabezal de lectura. También entre ellos había una capa de lubricante con un espesor de 1 molécula. Por lo tanto, si la cabeza golpea el disco, sus superficies se deslizarán sobre el lubricante y no habrá daños.

Sin embargo, a menudo ocurren colisiones, y no hay forma de aumentar el grosor de la capa de lubricante. ¿Cómo hacerlo más duradero? La respuesta a esta pregunta fue éter perfluorado. Esta sustancia tiene una propiedad única: la autocuración. Debido a la consistencia, cualquier daño a la capa lubricante se retrasa, como si se llevara a cabo con un cuchillo en la superficie de la miel.

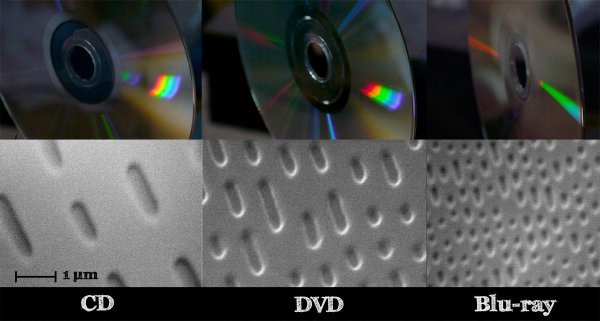

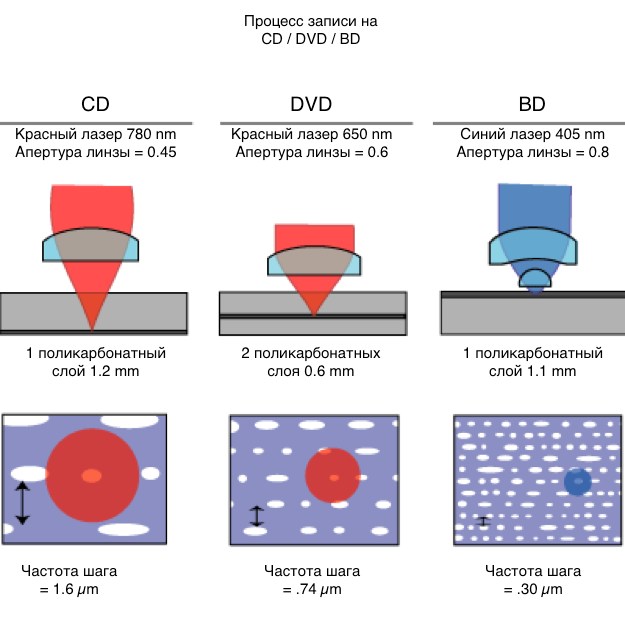

CD / DVDSe utilizan métodos muy diferentes de química y física en el funcionamiento de los discos ópticos, cuya similitud con los discos duros está limitada por la rotación y la presencia de un cabezal de lectura. Sin embargo, su producción no utiliza elementos magnéticos en absoluto.

Entre los diversos CD y DVD, los más químicamente interesantes son los propietarios de la función de doblaje. Estos discos usan un revestimiento de transición de fase especial. Los materiales más antiguos y más comunes para crear esta aleación son germanio, antimonio y telurio.

Un recubrimiento con una transición de fase tiene una propiedad sorprendente: sus átomos pueden formar aleatoriamente un estado caótico o uno ordenado (caótico - cubo de Rubik desmontado, ordenado - cubo de Rubik plegado). Los átomos caóticos se ven aburridos, y los ordenados son brillantes, lo que lleva a una analogía con ceros y unos.

La unidad utiliza un láser con tres niveles de potencia para leer y escribir datos. Durante la lectura, el láser funciona a la potencia más baja. Se centra en una capa de transición de fase que se puede ubicar a gran profundidad desde la superficie del disco. El sensor óptico reconoce desde qué átomos rebota el rayo, desde tenue o radiante.

El proceso de grabación es un poco más complicado. A alta potencia, el láser genera un aumento de la temperatura, ciertas secciones de la capa se derriten, los átomos se transfieren a su posición caótica (tenue). A una potencia láser promedio, las secciones de la capa se calientan, en lugar de fundirse, y los átomos se alinean en una posición ideal (radiante). Una vez que el láser termina de grabar, vuelve a la potencia mínima y lee los datos en el disco.

Monitores de químicaLas pantallas LCD modernas nos dan la oportunidad de usar monitores más delgados y menos intensivos en energía con menos daño a la visión.

El primer monitor CRT, introducido en 1927 por Philo Farnsworth, fue un descubrimiento revolucionario. Pero dicho monitor consumía mucha energía y tenía otras desventajas.

Philo Farnsworth

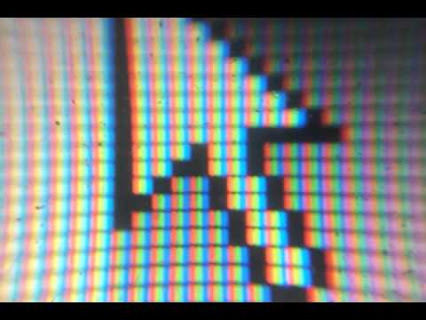

Philo FarnsworthEl principio de funcionamiento de la CRT era el siguiente: los puntos de fósforo que cubrían toda la superficie del vidrio brillaban debido a la constante lectura de los mismos por un haz de electrones. Por lo tanto, se resaltaron ciertos puntos y se formó una imagen. Sin embargo, si la matriz de puntos completa se actualiza varias veces por segundo, entonces se desarrolla la ilusión de movimiento. Cuando aparecieron los monitores en color, estaban equipados con puntos de fósforo en tres colores: rojo, verde, azul. Los químicos han encontrado muchas aleaciones que le permiten producir un brillo de cierto color. Mezclado adecuadamente, el sulfuro de zinc con cobre y aluminio da un color verde y plata con un color azul. Para el rojo, se necesitan europio, oxígeno e itrio (que se encuentran en las piedras lunares).

Sin embargo, muchas de estas aleaciones son extremadamente peligrosas para el medio ambiente. El sulfuro de zinc, por ejemplo, es muy tóxico. Y los viejos monitores desechados liberan todas estas sustancias terribles en el agua subterránea.

Entre otras cosas, el haz de electrones requiere más potencia para funcionar. , , (, , ). , , - .

— . 1889 , « » . .

1971 , . LCD-.

, 90 .

, . , . , .

.

. . . , - . , , .

.

. ,

NL/US 4- : E5-2650v4/10GB DDR4/240GB SSD/1 Gbps — $29. Geektimes .?

DELL R730XD c

9000 , 10 / :

2 Intel Dodeca-Core Xeon E5-2650 v4 128GB DDR4 6 x 480GB SSD 1Gbps 100 — $249 / .