Probablemente no valga la pena hablar en detalle sobre la llamada

Ley de Moore en Geektimes: todos lo sabemos, al menos aproximadamente. En resumen, esta ley es una observación empírica hecha por Gordon Moore. Hubo varias redacciones de la ley en sí, pero la moderna dice que el número de transistores colocados en un chip de circuito integrado se duplica cada 24 meses. Un poco más tarde, apareció una especie de ley, donde aparece no dos años, sino 18 meses. Esto no se debe a Moore, sino a David House de Intel. En su opinión, el rendimiento de los procesadores debería duplicarse cada 18 meses debido al crecimiento simultáneo tanto del número de transistores como de la velocidad de cada uno de ellos.

Desde la redacción de la ley, los desarrolladores de elementos electrónicos intentan seguir el ritmo de los plazos establecidos. En términos generales, para 1965 la ley era algo inusual, incluso puede llamarse radical. Entonces las "mini computadoras" todavía no eran muy pequeñas, ocupaban el volumen de un escritorio normal en la sala, o incluso más. En ese momento, era difícil imaginar que las computadoras pudieran llegar a formar parte de un refrigerador, lavadora u otros electrodomésticos con el tiempo. La mayoría de las personas nunca vieron una computadora, y quienes la vieron casi nunca trabajaron con ellas. Bueno, aquellos que trabajaron usaron tarjetas perforadas y otras herramientas no muy convenientes para interactuar con las computadoras, que, a su vez, trabajaron para resolver un rango bastante limitado de tareas.

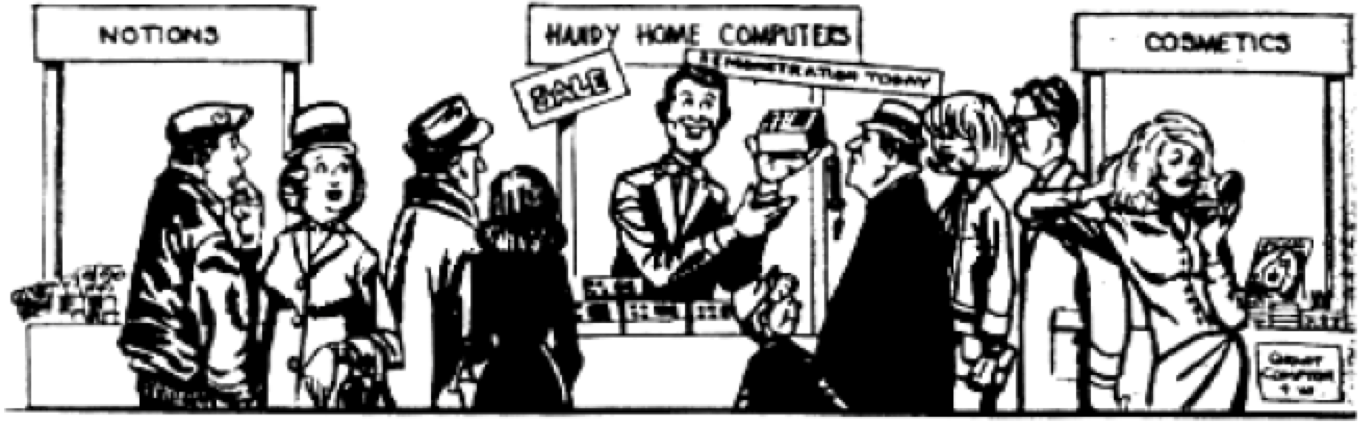

Después de que se conoció la idea de Moore, incluso comenzaron a bromear en revistas. Por ejemplo, en uno de ellos publicaron aquí tal caricatura:

Entonces fue difícil imaginar que pronto incluso tales computadoras no serían consideradas pequeñas en absoluto. Moore, por cierto, vio la ilustración, y estaba muy sorprendida por su originalidad. Hasta donde se puede juzgar, el artista intentó transmitir una actitud algo escéptica con respecto a la idea de reducir constantemente el tamaño de las PC. Pero después de 25 años, esta ilustración se convirtió en una realidad cotidiana.

Influencia de la ley de Moore

Como se mencionó anteriormente, hay varias variaciones de la Ley de Moore, no estamos hablando solo de un aumento constante en el número de transistores en el chip. Una de las consecuencias de la idea de Moore es un intento de averiguar qué tan rápido funcionarán todos los transistores de contracción. Además, los científicos y especialistas en tecnología de la información, utilizando la idea de Moore, intentaron predecir la rapidez de la cantidad de RAM, la memoria principal, la productividad de los chips, etc.

Pero lo principal no es qué versión de la Ley de Moore es más curiosa / útil, sino qué impacto ha tenido la idea principal en nuestro mundo. Aquí se pueden distinguir tres formas principales de influencia. Esta es una rivalidad de los desarrolladores, pronostica y cambia la arquitectura de los sistemas informáticos.

RivalidadLa Ley de Moore se puede utilizar para averiguar cuánta información se puede almacenar en el volumen de un chip. Esta ley, por cierto, se puede atribuir a la RAM en el campo. En los albores de la tecnología informática, o mejor dicho, PC, un chip de computadora podría almacenar

. Los chips comenzaron a llamarse RAM (memoria de acceso aleatorio). Los chips con 16K comenzaron a producir muchos. Luego, de acuerdo con la ley de Moore, o incluso más rápido, aparecieron chips con 64 K. Los ingenieros que desarrollaron estos chips conocían la Ley y trataron de cumplirla. Por lo tanto, desde el principio, se estableció un ciclo de producción especial e ininterrumpido, cuando los ingenieros, lanzando un chip, ya estaban terminando el trabajo en su próxima generación. Esta situación se observa ahora. Todos conocen las reglas y el juego, y todos participan en él.

PrevisiónConociendo la tendencia a un aumento en el número de transistores en el volumen del chip (y la fórmula fue inicialmente lo suficientemente clara), los ingenieros de cualquiera de las compañías que fabrican componentes electrónicos podrían imaginar aproximadamente cuándo se liberaría qué generación de chips. Y fue un pronóstico bastante preciso. También se podría imaginar en qué año y con qué rendimiento funcionará el procesador.

Los ingenieros de las empresas comenzaron a elaborar planes de producción, centrándose principalmente en la Ley de Moore. Los vendedores de computadoras tenían una buena idea de cuándo la generación de máquinas debería abandonar el mercado y cuándo debería aparecer.

Se puede decir que la ley de Moore ha establecido el proceso de producción para la producción de componentes y sistemas electrónicos. No hubo sorpresas a este respecto, y no pudo haber ninguna, porque todos trabajaron aproximadamente a la misma velocidad, sin tratar de adelantar o retrasar el marco de tiempo establecido por Moore. Todo era perfectamente predecible.

Arquitectura y elementos de PC

Arquitectura y elementos de PCDe todos modos, la Ley de Moore permitió a los ingenieros desarrollar un diseño de chip que se ha convertido en un punto de referencia durante mucho tiempo. Este es un Intel 4004 y sus encarnaciones posteriores. Se desarrolló una arquitectura especializada, que se llamó

arquitectura von Neumann .

En marzo de 1945, los principios de la arquitectura lógica se formalizaron en un documento llamado "El primer borrador del Informe EDVAC", un informe para el Laboratorio de Balística del Ejército de EE. UU., Sobre cuyo dinero se construyó ENIAC y se desarrolló EDVAC. El informe, dado que era solo un borrador, no estaba destinado a su publicación, sino solo a su distribución dentro del grupo, pero German Goldstein, el curador del proyecto del Ejército de EE. UU., Multiplicó este trabajo científico y lo envió a un amplio círculo de científicos para su revisión. Como solo el nombre von Neumann [1] estaba en la primera página del documento, los lectores del documento tenían la falsa impresión de que él era el autor de todas las ideas presentadas en el trabajo. El documento proporcionaba suficiente información para que quienes lo leyeran pudieran construir sus computadoras, similares a EDVAC, sobre los mismos principios y con la misma arquitectura, que como resultado se conoció como "arquitectura von Neumann".

Después del final de la Segunda Guerra Mundial y el final del trabajo en ENIAK en febrero de 1946, el equipo de ingenieros y científicos se separó, John Mokley, John Eckert decidió dedicarse a los negocios y crear computadoras a nivel comercial. Von Neumann, Goldstein y Burks se mudaron al Instituto de Investigación Avanzada, donde decidieron crear su propia máquina IAS, similar a EDVAC, y usarla para trabajos de investigación. En junio de 1946, [2] [3] establecieron sus principios para la construcción de computadoras en el artículo clásico, "Una revisión preliminar del diseño lógico de un dispositivo de computación electrónica". Más de medio siglo ha pasado desde entonces, pero las disposiciones presentadas en él siguen siendo relevantes hoy. El artículo confirma convincentemente el uso de un sistema binario para representar números, ya que antes todas las máquinas informáticas almacenaban números procesados en forma decimal. Los autores demostraron las ventajas del sistema binario para la implementación técnica, la conveniencia y la simplicidad de realizar operaciones aritméticas y lógicas en él. Posteriormente, las computadoras comenzaron a procesar tipos de información no numéricos: texto, gráficos, sonido y otros, pero la codificación de datos binarios todavía forma la base de información de cualquier computadora moderna.

Todas las bases que se establecieron hace varias décadas y se convirtieron en la base. En el futuro, casi todo permaneció sin cambios, los desarrolladores solo intentaron hacer que las computadoras fueran cada vez más productivas.

Vale la pena recordar que la Ley de Moore es la base de todo. Todas sus encarnaciones sirvieron de apoyo para el modelo básico del desarrollo de la tecnología informática, y ya poco podría llevar a una ruptura en este ciclo. Y cuanto más activamente se desarrollaba la tecnología informática, más profundo, podemos decir, que los desarrolladores de estos sistemas estaban atados a la ley. De hecho, la creación de una arquitectura informática diferente lleva años y años, y pocas empresas pueden permitirse este lujo: la búsqueda de formas alternativas de desarrollar tecnología informática. Organizaciones de investigación como MIT han llevado a cabo valientes experimentos como la máquina Lisp y la máquina de conexión, aquí puede mencionar uno de los proyectos japoneses. Pero todo esto terminó en nada, la arquitectura von Neumann se mantuvo en uso.

El trabajo de los ingenieros y programadores ahora consistía en optimizar el trabajo de sus programas y hardware para que cada milímetro cuadrado de chips funcionara más y más eficientemente. Los desarrolladores compitieron en el almacenamiento en caché de cantidades cada vez mayores de datos. Además, varios fabricantes de componentes electrónicos han intentado (y todavía lo están intentando) colocar la mayor cantidad posible de núcleos dentro de un procesador. Sea como fuere, todo el trabajo se ha centrado en un número limitado de arquitecturas de procesador. Estos son X86, ARM y PowerPC. Hace treinta años había muchos más.

X86 se utiliza principalmente en computadoras de escritorio, computadoras portátiles y servidores en la nube. Los procesadores ARM se ejecutan en teléfonos y tabletas. Bueno, PowerPC en la mayoría de los casos se usa en la industria automotriz.

Una excepción interesante a las estrictas reglas del juego establecidas por la Ley de Moore es la GPU. Fueron desarrollados para procesar información gráfica con un alto grado de eficiencia, por lo que su arquitectura es diferente del procesador (aún). Pero para hacer frente a su tarea, la GPU tuvo que desarrollarse independientemente de la evolución de los procesadores. La arquitectura de las tarjetas de video fue optimizada para manejar la gran cantidad de datos necesarios para representar la imagen en la pantalla. Por lo tanto, aquí los ingenieros desarrollaron un tipo diferente de chip, que no reemplazó a los procesadores existentes, sino que complementó sus capacidades.

¿Cuándo dejará de funcionar la ley de Moore?

En el sentido habitual, ya ha dejado de funcionar, en esa comprensión clásica, que se discutió anteriormente. Esto se evidencia por varias fuentes, incluida, por ejemplo,

esta . Ahora la carrera aún está en curso. Por ejemplo, en el mismo primer procesador comercial Intel 4004 de 5 bits lanzado en 1971, había 2.300 transistores. Después de 45 años, en 2016, Intel presentó el procesador Xeon Broadwell-WS de 24 núcleos con 5,7 mil millones de transistores. Este procesador está disponible en tecnología de 14 nm. IBM anunció recientemente un procesador de 7 nm con 20 mil millones de transistores, y luego un procesador de 5 nm con 30 mil millones de transistores.

Pero 5 nm es una capa con un espesor de solo 20 átomos. Aquí, la ingeniería ya se está acercando al límite técnico de una mejora adicional del proceso. Además, la densidad de los transistores en los procesadores modernos es muy alta. 5 o incluso 10 mil millones de transistores por milímetro cuadrado. La velocidad de transmisión de la señal en el transistor es muy alta y es de gran importancia. La frecuencia central de los procesadores más rápidos modernos es de 8,76 GHz. Una mayor aceleración, aunque posible, también es un problema técnico, y es muy, muy grande. Es por eso que los ingenieros optaron por crear procesadores de múltiples núcleos, en lugar de continuar aumentando la frecuencia de un solo núcleo.

Esto permitió mantener el ritmo de aumento en el número de operaciones por segundo previsto por la ley de Moore. Sin embargo, el multinuclearismo en sí mismo es una cierta desviación de la ley. Sin embargo, varios expertos creen que no importa cómo intentemos "ponernos al día", lo principal es que el ritmo de desarrollo de las tecnologías, en particular la tecnología informática, corresponde más o menos a la ley de Moore.

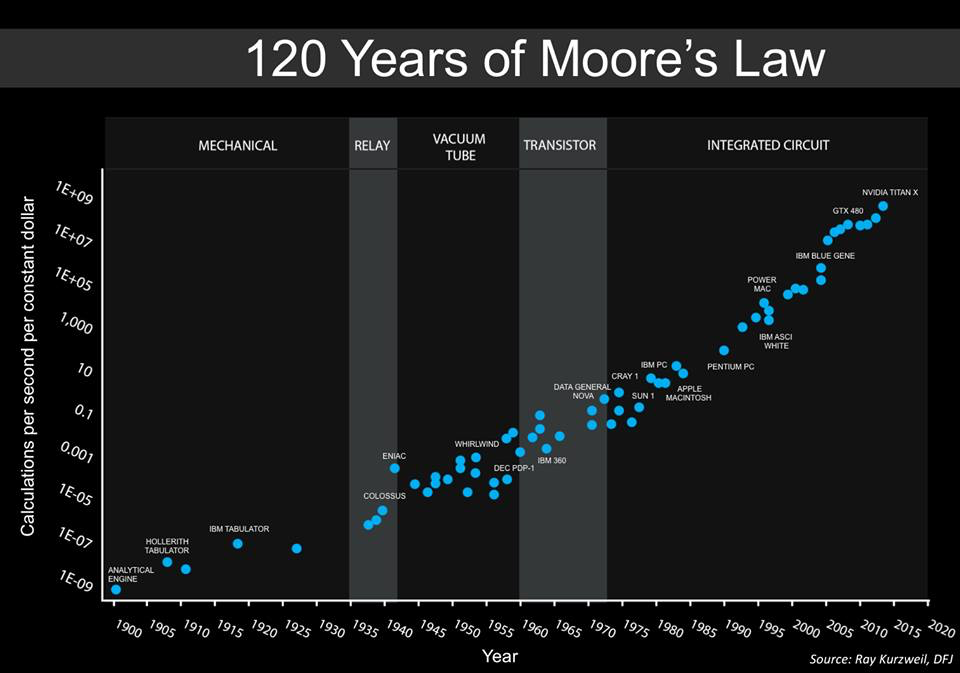

A continuación se muestra un gráfico creado por Steve Jurvetson, cofundador de Draper Fisher Jurvetson. Afirma que este es un horario aumentado presentado previamente por

Ray Kurzweil .

Este gráfico muestra el costo relativo de la cantidad de operaciones por unidad de tiempo (1 segundo). Es decir, podemos ver claramente cuánto más barata es la informática en el tiempo. Además, los cálculos se hicieron cada vez más universales, por así decirlo. En los años 40 había máquinas especializadas diseñadas para descifrar códigos militares. En la década de 1950, las computadoras comenzaron a usarse para trabajar con tareas comunes, y esta tendencia continúa hasta nuestros días.

Curiosamente, las dos últimas posiciones en el gráfico son la GPU, GTX 450 y NVIDIA Titan X. Curiosamente, en 2010 no había GPU en el gráfico, solo procesadores multi-core.

En general, la GPU ya está aquí, y muchos están contentos con ella. Además, ahora una dirección como el aprendizaje profundo, una de las manifestaciones de las redes neuronales, se está volviendo cada vez más popular. Muchas empresas, grandes y pequeñas, se dedican a su desarrollo. Y las GPU son ideales para redes neuronales.

¿Por qué todo esto? El hecho es que el aumento general en el número de cálculos aún se conserva, sí, pero los métodos y el equipo están cambiando.

¿Qué significa todo esto?

Ahora la forma misma de la computación está cambiando. Los arquitectos pronto no necesitarán pensar qué más hacer para mantenerse al día con la ley de Moore. Ahora se están introduciendo nuevas ideas que alcanzarán alturas inaccesibles para los sistemas informáticos convencionales con arquitectura tradicional. Quizás, en el futuro cercano, la velocidad de la informática no será tan importante, será posible mejorar el rendimiento del sistema de manera diferente.

Sistemas de autoaprendizaje

Sistemas de autoaprendizajeAhora muchas redes neuronales dependen de la GPU. Se están creando sistemas con arquitectura especializada para ellos. Por ejemplo, Google ha desarrollado sus propios chips, que se denominan Unidades TensorFlow (o TPU). Le permiten ahorrar potencia informática debido a la eficiencia de los cálculos. Google usa estos chips en sus centros de datos, y muchos de los servicios en la nube de la compañía funcionan de acuerdo con ellos. Como resultado, el rendimiento del sistema es mayor y el consumo de energía es menor.

Chips especializadosEn los dispositivos móviles convencionales, los procesadores ARM ahora funcionan, que son especializados. Estos procesadores procesan la información de las cámaras, optimizan el procesamiento del habla y en tiempo real trabajan con reconocimiento facial. La especialización en todo es lo que la electrónica espera.

Arquitectura especializadaSí, la cuña no convergió en la arquitectura von Neumann, ahora se están desarrollando sistemas con diferentes arquitecturas diseñadas para realizar diferentes tareas. Esta tendencia no solo se mantiene, sino que incluso se acelera.

Seguridad informáticaLos cibercriminales se están volviendo cada vez más hábiles, con la piratería de algunos sistemas ahora puede obtener millones, decenas de millones de dólares. Pero en la mayoría de los casos, es posible piratear el sistema debido a errores de software o hardware. La gran mayoría de los trucos utilizados por los crackers funcionan en sistemas con arquitectura von Neumann, pero no funcionarán con otros sistemas.

Sistemas cuánticosLas llamadas computadoras cuánticas son tecnología experimental, que, entre otras cosas, también es muy costosa. Aquí se utilizan elementos criogénicos, además de muchas otras cosas que no se encuentran en los sistemas convencionales. Las computadoras cuánticas son completamente diferentes de las computadoras habituales, y la ley de Moore no se aplica a ellas. Sin embargo, con su ayuda, según los expertos, es posible aumentar radicalmente el rendimiento de algunos tipos de cálculos. Quizás fue la ley de Moore la que llevó a los científicos e ingenieros a buscar nuevas formas de aumentar la eficiencia de la informática y encontrarlas.

Como epílogo

Lo más probable es que en 5-10 años veamos sistemas informáticos completamente nuevos, ahora estamos hablando de tecnología de semiconductores. Estos sistemas estarán por delante de nuestros planes más salvajes y se desarrollarán a un ritmo muy rápido. Lo más probable es que los especialistas, tratando de eludir la ley de Moore, creen nuevas tecnologías de desarrollo de chips que, si nos hubieran contado sobre ellas ahora, nos hubieran parecido mágicas. ¿Qué dirían las personas que vivieron hace 50 años si se les diera un teléfono inteligente moderno? Pocos entenderían cómo funciona todo. Así es en nuestro caso.