Ha llegado el momento de la informática inspirada en la estructura del cerebro. Los algoritmos que utilizan redes neuronales y aprendizaje profundo que imitan algunos aspectos del cerebro humano permiten que las computadoras digitales alcancen alturas increíbles en la traducción de idiomas, busquen patrones evasivos en grandes cantidades de datos y golpeen a las personas en Go.

Pero mientras los ingenieros continúan desarrollando activamente esta estrategia computacional, capaz de mucho, la eficiencia energética de la computación digital se acerca a su límite. Nuestros centros de datos y supercomputadoras ya consumen megavatios: el 2% de toda la electricidad consumida en los EE. UU. Se destina a centros de datos. Y el cerebro humano vale 20 vatios, y esta es una pequeña fracción de la energía contenida en la comida diaria consumida. Si queremos mejorar los sistemas informáticos, debemos hacer que las computadoras se vean como cerebros.

A esta idea se asocia un aumento de interés en las tecnologías neuromórficas, que promete llevar las computadoras más allá de las redes neuronales simples, hacia circuitos que funcionan como neuronas y sinapsis. El desarrollo de circuitos físicos similares al cerebro ya está bastante bien desarrollado. El trabajo realizado en mi laboratorio y otras instituciones en todo el mundo durante los últimos 35 años ha llevado a la creación de componentes nerviosos artificiales, similares a las sinapsis y las dendritas, que reaccionan y generan señales eléctricas de la misma manera que las reales.

Entonces, ¿qué se requiere para integrar estos bloques de construcción en un cerebro informático completo? En 2013, Bo Marr, mi antiguo estudiante de posgrado en el Instituto de Tecnología de Georgia, me ayudó a

evaluar lo mejor de los avances modernos en ingeniería y neurobiología . Llegamos a la conclusión de que es posible crear una versión de silicio de la corteza del cerebro humano utilizando transistores. Además, la máquina final ocuparía menos de un metro cúbico en el espacio y consumiría menos de 100 vatios, lo que no es tan diferente del cerebro humano.

No quiero decir que crear una computadora así sea fácil. El sistema que inventamos requerirá varios miles de millones de dólares para el desarrollo y la construcción, y para darle compacidad, incluirá varias innovaciones innovadoras. También surge la pregunta de cómo programaremos y entrenaremos tal computadora. Los investigadores del neuromorfismo todavía están luchando por comprender cómo hacer que miles de neuronas artificiales trabajen juntas y cómo encontrar aplicaciones útiles para la actividad pseudocerebral.

Sin embargo, el hecho de que podamos llegar a tal sistema sugiere que no teníamos mucho tiempo antes de la aparición de chips de menor escala adecuados para su uso en dispositivos electrónicos portátiles y portátiles. Dichos dispositivos consumirán poca energía, por lo que un chip neuromórfico con alta eficiencia energética, incluso si solo realiza parte de los cálculos, digamos, el procesamiento de señales, puede convertirse en revolucionario. Las funciones existentes, como el reconocimiento de voz, pueden funcionar en entornos ruidosos. Incluso puede imaginar los teléfonos inteligentes del futuro llevando a cabo la traducción de voz en tiempo real en una conversación entre dos personas. Piense en esto: durante los 40 años transcurridos desde la llegada de los circuitos integrados para el procesamiento de señales, la ley de Moore ha mejorado su eficiencia energética en aproximadamente 1,000 veces. Los chips neuromórficos muy similares al cerebro pueden superar fácilmente estas mejoras, reduciendo el consumo de energía en otros 100 millones de veces. Como resultado, los cálculos que anteriormente necesitaban un centro de datos cabían en la palma de su mano.

En una máquina ideal que se acerque al cerebro, será necesario recrear análogos de todos los componentes funcionales principales del cerebro: sinapsis que conectan las neuronas y les permiten recibir y responder a las señales; dendritas que combinan y realizan cálculos locales basados en señales entrantes; El núcleo, o soma, es la región de cada neutrón, combina la entrada de las dendritas y transmite la salida al axón.

Las versiones más simples de estos componentes básicos ya están implementadas en silicio. El comienzo de este trabajo fue dado por el mismo semiconductor de óxido de metal, o MOSFET, de los cuales miles de millones de copias se utilizan para construir circuitos lógicos en procesadores digitales modernos.

Estos dispositivos tienen mucho en común con las neuronas. Las neuronas funcionan mediante barreras controladas por voltaje, y su actividad eléctrica y química depende principalmente de los canales en los que los iones se mueven entre los espacios interno y externo de la célula. Este es un proceso suave y analógico en el que hay una acumulación o reducción constante de la señal, en lugar de simples operaciones de encendido / apagado.

Los MOSFET también están controlados por voltaje y funcionan mediante los movimientos de unidades de carga individuales. Y cuando los MOSFET funcionan en el modo "subliminal", sin alcanzar el umbral de voltaje, cambiando los modos de encendido y apagado, la cantidad de corriente que fluye a través del dispositivo es muy pequeña: menos de una milésima parte de la corriente que se puede encontrar en interruptores típicos o puertas digitales.

Carver Mead de Caltech, quien contribuyó a la revolución en el campo de los circuitos integrados supergrandes en la década de 1970, expresó la idea de que la física de los transistores subliminales se puede utilizar para crear circuitos similares al cerebro. Mil señaló que los diseñadores de chips no utilizaron muchos aspectos interesantes de su comportamiento, utilizando transistores exclusivamente para la lógica digital. Este proceso, como

escribió en 1990 , es similar al hecho de que "toda la bella física que existe en los transistores se convierte en ceros y unos, y luego las compuertas AND y OR se construyen dolorosamente sobre esta base para reinventar la multiplicación". Una computadora más "física" o física podría hacer más cálculos por unidad de energía que una computadora digital convencional. Mead predijo que una computadora así ocuparía menos espacio.

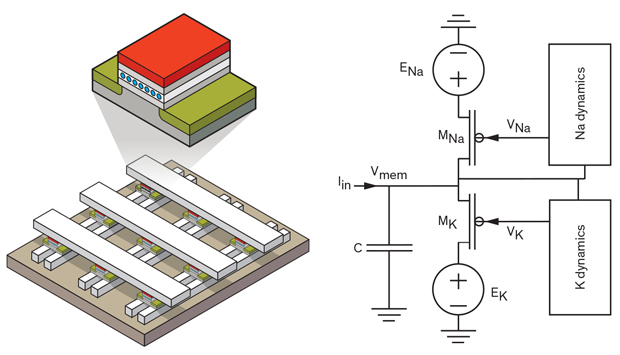

En años posteriores, los ingenieros de sistemas neuromórficos crearon todos los bloques básicos del cerebro a partir de silicio con alta precisión biológica. Las dendritas, el axón y el neuroma soma pueden estar hechos de transistores estándar y otros elementos. Por ejemplo, en 2005, Ethan Farquhar y yo

creamos un circuito neuronal a partir de un conjunto de seis MOSFET y un grupo de condensadores. Nuestro modelo emitió impulsos eléctricos, muy similares a los que emiten calamar neurona de bagre, un objeto de experimentos de larga data. Además, nuestro esquema logró tales indicadores con niveles actuales y de consumo de energía cercanos a los existentes en el cerebro del calamar. Si quisiéramos usar circuitos analógicos para modelar las ecuaciones derivadas por los neurocientíficos para describir este comportamiento, tendríamos que usar 10 veces más transistores. Realizar tales cálculos en una computadora digital requeriría aún más espacio.

Sinapsis y bagre: se puede utilizar un transistor de puerta flotante (arriba a la izquierda), capaz de almacenar una cantidad diferente de carga, para crear una matriz coordinada de sinapsis artificiales (abajo a la izquierda). Las versiones electrónicas de otros componentes de la neurona, como el bagre (derecha), se pueden hacer a partir de transistores estándar y otros componentes.

Las sinapsis son un poco más difíciles de emular. Un dispositivo que se comporta como una sinapsis debe poder recordar en qué estado se encuentra, responder de cierta manera a la señal entrante y adaptar sus respuestas con el tiempo.

Existen varios enfoques potenciales para crear sinapsis. La más desarrollada es una

sinapsis de aprendizaje de transistores simples (STLS), en la que mis colegas de Kaltech y yo trabajamos en la década de 1990, cuando era un estudiante graduado en Mead.

Presentamos STLS por primera vez en 1994, y se ha convertido en una herramienta importante para los ingenieros que crean circuitos analógicos modernos, por ejemplo, redes neuronales físicas. En las redes neuronales, cada nodo de la red tiene un peso asociado, y estos pesos determinan cómo se combinan los datos de diferentes nodos. STLS fue el primer dispositivo capaz de contener un conjunto de diferentes pesos y reprogramaciones sobre la marcha. Además, el dispositivo no es volátil, es decir, recuerda su estado, incluso cuando no está en uso; esta circunstancia reduce significativamente la necesidad de energía.

STLS es un tipo de transistor de puerta flotante, un dispositivo utilizado para crear celdas en la memoria flash. En un MOSFET convencional, la puerta controla la corriente que pasa a través del canal. El transistor de puerta flotante tiene una segunda puerta, entre la puerta eléctrica y el canal. Este obturador no está conectado directamente a tierra ni a ningún otro componente. Gracias a este aislamiento eléctrico, reforzado con aisladores de silicio de alta calidad, la carga se almacena en una puerta flotante durante mucho tiempo. Este obturador puede tomar una cantidad diferente de carga y, por lo tanto, puede dar una respuesta eléctrica en muchos niveles, y esto es necesario para crear una sinapsis artificial que puede variar su respuesta al estímulo.

Mis colegas y yo usamos STLS para demostrar la primera red de coordenadas, un modelo computacional que es popular entre los investigadores de nanodispositivos. En una matriz bidimensional, los dispositivos se encuentran en la intersección de las líneas de entrada que van de arriba a abajo y las líneas de salida que van de izquierda a derecha. Dicha configuración es útil porque le permite programar la fuerza de conexión de cada "sinapsis" por separado, sin interferir con otros elementos de la matriz.

Gracias en particular al reciente programa DARPA llamado

SyNAPSE , la ingeniería neuromorfológica ha estimulado la investigación sobre sinapsis artificiales hechas de nanodispositivos como memristors, memoria resistiva y memoria de estado de fase, así como dispositivos de puerta flotante. Pero estas nuevas sinapsis artificiales serán difíciles de mejorar sobre la base de matrices con un obturador flotante hace veinte años. Los recuerdos y otros tipos de memoria nueva son difíciles de programar. La arquitectura de algunos de ellos es tal que es bastante difícil acceder a un dispositivo específico en una matriz de coordenadas. Otros requieren un transistor dedicado para la programación, lo que aumenta significativamente su tamaño. Dado que la memoria con un obturador flotante se puede programar para una amplia gama de valores, es más fácil de ajustar para compensar las desviaciones de producción de un dispositivo a otro en comparación con otros nanodispositivos. Varios grupos de investigación que estudiaron dispositivos neuromórficos intentaron incorporar nanodispositivos en sus diseños y, como resultado, comenzaron a utilizar dispositivos de persiana flotante.

¿Y cómo combinamos todos estos componentes similares al cerebro? En el cerebro humano, las neuronas y las sinapsis están entrelazadas. Los desarrolladores de chips neuromórficos también deben elegir un enfoque integrado con la colocación de todos los componentes en un chip. Pero en muchos laboratorios no encontrará esto: para facilitar el trabajo con proyectos de investigación, las unidades de base individuales se encuentran en diferentes lugares. Las sinapsis se pueden colocar en una matriz fuera del chip. Las conexiones pueden pasar por otro chip, una matriz de compuerta programable por el usuario (FPGA).

Pero al escalar sistemas neuromórficos, debe asegurarse de que no estamos copiando la estructura de las computadoras modernas que pierden una cantidad significativa de energía al transferir bits de un lado a otro entre la lógica, la memoria y el almacenamiento. Hoy, una computadora puede consumir fácilmente 10 veces más energía para mover datos que para computar.

El cerebro, por el contrario, minimiza el consumo de energía de las comunicaciones debido a la alta localización de las operaciones. Los elementos de la memoria cerebral, como el poder de sinapsis, se mezclan con componentes de transmisión de señales. Y los "cables" del cerebro - dendritas y axones que transmiten señales entrantes e impulsos salientes - generalmente son cortos en comparación con el tamaño del cerebro, y no necesitan mucha energía para mantener la señal. Por anatomía, sabemos que más del 90% de las neuronas se conectan a solo 1,000 vecinas.

Otra gran pregunta para los creadores de chips y computadoras similares al cerebro son los algoritmos que tendrán que funcionar en ellos. Incluso un sistema ligeramente similar al cerebro puede dar una gran ventaja sobre uno digital convencional. Por ejemplo, en 2004, mi grupo usó dispositivos de puerta flotante para realizar la multiplicación en el procesamiento de la señal, y tomó 1,000 veces menos energía y 100 veces menos espacio que un sistema digital. Con los años, los investigadores han demostrado con éxito enfoques neuromórficos a otros tipos de computación para el procesamiento de señales.

Pero el cerebro sigue siendo 100,000 veces más eficiente que estos sistemas. Esto se debe a que, aunque nuestras tecnologías neuromórficas actuales aprovechan la física similar a las neuronas de los transistores, no usan algoritmos como los que usa el cerebro para hacer su trabajo.

Hoy estamos empezando a descubrir estos algoritmos físicos, procesos que pueden permitir que los chips similares al cerebro trabajen con eficiencia cercana al cerebro. Hace cuatro años, mi grupo usó siluro de silicio, sinapsis y dendritas para ejecutar un algoritmo de búsqueda de palabras que reconoce palabras en grabaciones de audio. Este algoritmo mostró una mejora de mil veces en la eficiencia energética en comparación con el procesamiento de señales analógicas. Como resultado, al reducir el voltaje aplicado a los chips y usar transistores más pequeños, los investigadores deben crear chips comparables en rendimiento al cerebro en muchos tipos de computación.

Cuando comencé a investigar sobre el neuromorfismo hace 30 años, todos creían que el desarrollo de sistemas similares al cerebro nos proporcionaría oportunidades increíbles. De hecho, ahora se construyen industrias enteras en torno a la inteligencia artificial y el aprendizaje en profundidad, y estas aplicaciones prometen transformar por completo nuestros dispositivos móviles, instituciones financieras y la interacción de las personas en lugares públicos.

Y, sin embargo, estas aplicaciones dependen muy poco de nuestro conocimiento de la función cerebral. Durante los próximos 30 años, sin duda podremos ver cómo se utiliza cada vez más este conocimiento. Ya tenemos muchos bloques de hardware básicos necesarios para convertir la neurobiología en una computadora. Pero necesitamos comprender aún mejor cómo debería funcionar este equipo, y qué esquemas computacionales darán los mejores resultados.

Considere esto un llamado a la acción. Hemos logrado mucho utilizando un modelo muy aproximado del cerebro. Pero la neurociencia puede llevarnos a crear computadoras más complejas parecidas al cerebro. ¿Y qué podría ser mejor que usar nuestro cerebro para entender cómo hacer estas nuevas computadoras?