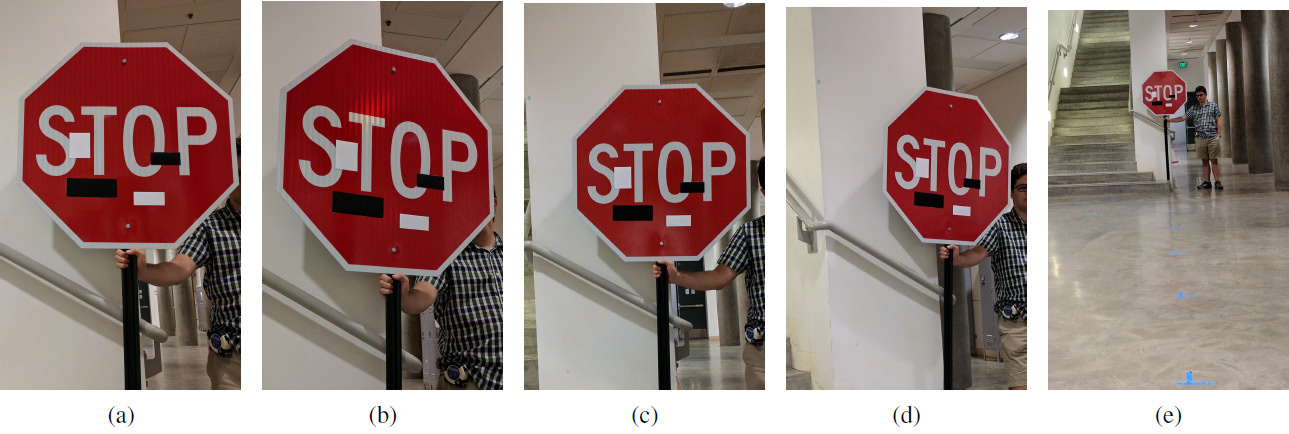

Un conjunto de imágenes experimentales con pegatinas de arte a diferentes distancias y en diferentes ángulos: (a) 5 pies, 0 grados; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; (e) 40 ° 0 °. Hacer trampa funciona a cualquier distancia y en cualquier ángulo: en lugar de la señal de Stop, el sistema de aprendizaje automático ve la señal "Límite de velocidad 45 millas"

Un conjunto de imágenes experimentales con pegatinas de arte a diferentes distancias y en diferentes ángulos: (a) 5 pies, 0 grados; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; (e) 40 ° 0 °. Hacer trampa funciona a cualquier distancia y en cualquier ángulo: en lugar de la señal de Stop, el sistema de aprendizaje automático ve la señal "Límite de velocidad 45 millas"Mientras que algunos científicos están mejorando los sistemas de aprendizaje automático, otros científicos están mejorando los métodos para engañar a estos sistemas.

Como sabe, los pequeños cambios específicos en la imagen pueden "romper" el sistema de aprendizaje automático, de modo que reconozca una imagen completamente diferente. Estas imágenes "troyanas" se denominan "ejemplos adversos" y representan una de las

limitaciones bien conocidas

del aprendizaje profundo .

Para crear un ejemplo competitivo, debe maximizar la activación, por ejemplo, de un cierto filtro de red neuronal convolucional. Ivan Yevtimov de la Universidad de Washington, junto con colegas de la Universidad de California en Berkeley, la Universidad de Michigan y la Universidad de Nueva York en Stony Brook desarrollaron un nuevo algoritmo de ataque:

perturbaciones físicas robustas (

perturbaciones físicas robustas o RP

2 ). Captura de manera muy efectiva la visión de vehículos no tripulados, robots, cuadricópteros y cualquier otro sistema robótico que intente navegar en el espacio circundante.

A diferencia de estudios anteriores, aquí los autores se centraron en cambiar directamente los objetos mismos, en lugar de los antecedentes. La tarea de los investigadores fue encontrar el delta más pequeño posible que derribara el clasificador del sistema de aprendizaje automático, que fue entrenado en

un conjunto de datos con imágenes de señales de tráfico de LISA . Los autores tomaron independientemente una serie de fotografías de señales de tráfico en la calle en diferentes condiciones (distancia, ángulos, iluminación) y complementaron el conjunto de datos LISA para capacitación.

Después de calcular dicho delta, se reveló una máscara: un lugar (o varios lugares) en la imagen que causa perturbaciones de manera más confiable en el sistema de aprendizaje automático (visión artificial). Se realizó una serie de experimentos para verificar los resultados. Los experimentos se llevaron a cabo principalmente en una señal de stop (señal "STOP"), que los investigadores convirtieron con varias manipulaciones inocuas para la visión artificial en una señal "SPEED LIMIT 45". La técnica desarrollada se puede utilizar en cualquier otro signo. Los autores luego lo probaron en una señal de giro.

El equipo de investigación ha desarrollado dos tipos de ataques en sistemas de visión artificial que reconocen las señales de tráfico. El primer ataque son pequeños cambios imperceptibles en toda el área del signo. Usando el optimizador Adam, pudieron minimizar la máscara para crear ejemplos competitivos, específicos y separados que apuntan a señales de tráfico específicas. En este caso, los sistemas de aprendizaje automático pueden ser engañados con cambios mínimos de imagen, y las personas no notarán nada en absoluto. La efectividad de este tipo de ataque se probó en carteles impresos con ligeros cambios (al principio, los investigadores estaban convencidos de que el sistema de visión artificial reconoce con éxito los carteles sin cambios).

El segundo tipo de ataque es el camuflaje. Aquí, el sistema imita actos de vandalismo o graffiti artístico para que el sistema no interfiera con la vida de quienes lo rodean. Por lo tanto, el conductor verá inmediatamente la señal de giro a la izquierda o la luz de freno, y el robot verá una señal completamente diferente. La efectividad de este tipo de ataque se probó en señales de tráfico reales, que fueron selladas con adhesivos. El camuflaje de graffiti consistía en calcomanías en forma de las palabras AMOR y ODIO, y camuflaje como arte abstracto: cuatro calcomanías de forma rectangular en blanco y negro.

Los resultados del experimento se muestran en la tabla. En todos los casos, se muestra la efectividad de engañar al clasificador de aprendizaje automático, que reconoce el signo "PARADA" modificado como el signo "LÍMITE DE VELOCIDAD 45". La distancia está en pies y el ángulo de rotación está en grados. La segunda columna muestra la segunda clase, que se ve en el sistema de aprendizaje automático en un signo modificado. Por ejemplo, desde una distancia de 5 pies (152,4 cm), el camuflaje como el arte abstracto en un ángulo de 0 ° produce los siguientes resultados para reconocer el signo de "PARADA": con una confianza del 64%, se reconoce como un signo de "LÍMITE DE VELOCIDAD 45" y con una confianza del 11% - como Carril termina firmar.

Leyenda: SL45 = Límite de velocidad 45, STP = Parada, YLD = Rendimiento, ADL = Carril agregado, SA = Señal adelante, LE = Extremos del carril

Leyenda: SL45 = Límite de velocidad 45, STP = Parada, YLD = Rendimiento, ADL = Carril agregado, SA = Señal adelante, LE = Extremos del carrilQuizás la humanidad necesitará un sistema de este tipo (con los cambios correspondientes) en el futuro, y ahora se puede usar para probar sistemas imperfectos de aprendizaje automático y visión por computadora.

El trabajo científico fue

publicado el 27 de julio de 2017 en el sitio de preimpresión arXiv.org (arXiv: 1707.08945).