Los editores del Diccionario de Oxford eligieron la palabra "post-verdad"

como la honorable "

palabra de 2016 ". Este término describe circunstancias en las cuales los hechos objetivos son menos importantes para la formación de la opinión pública que la apelación a las emociones y creencias personales.

Se observó una frecuencia particularmente alta de uso de esta palabra en publicaciones en inglés después de las elecciones presidenciales de EE. UU. En relación con la difusión de una gran cantidad de noticias falsas, después de lo cual la verdad en sí misma no importó mucho.

Según algunos analistas, la difusión de noticias difamatorias falsas fue una de las razones de la derrota de Hillary Clinton en las elecciones. Feed algorítmico Facebook se

ha convertido en una de las principales fuentes de noticias falsas.

En este contexto, las noticias de los desarrolladores en el campo de la inteligencia artificial pasaron casi desapercibidas. Ya estamos acostumbrados al hecho de que las redes neuronales hacen dibujos, crean una foto de una persona de acuerdo con su descripción verbal y generan música. Lo hacen cada vez más y cada vez lo hacen mejor. Pero lo más interesante es que las máquinas aprendieron a crear falsificaciones.

La influencia de las falsificaciones

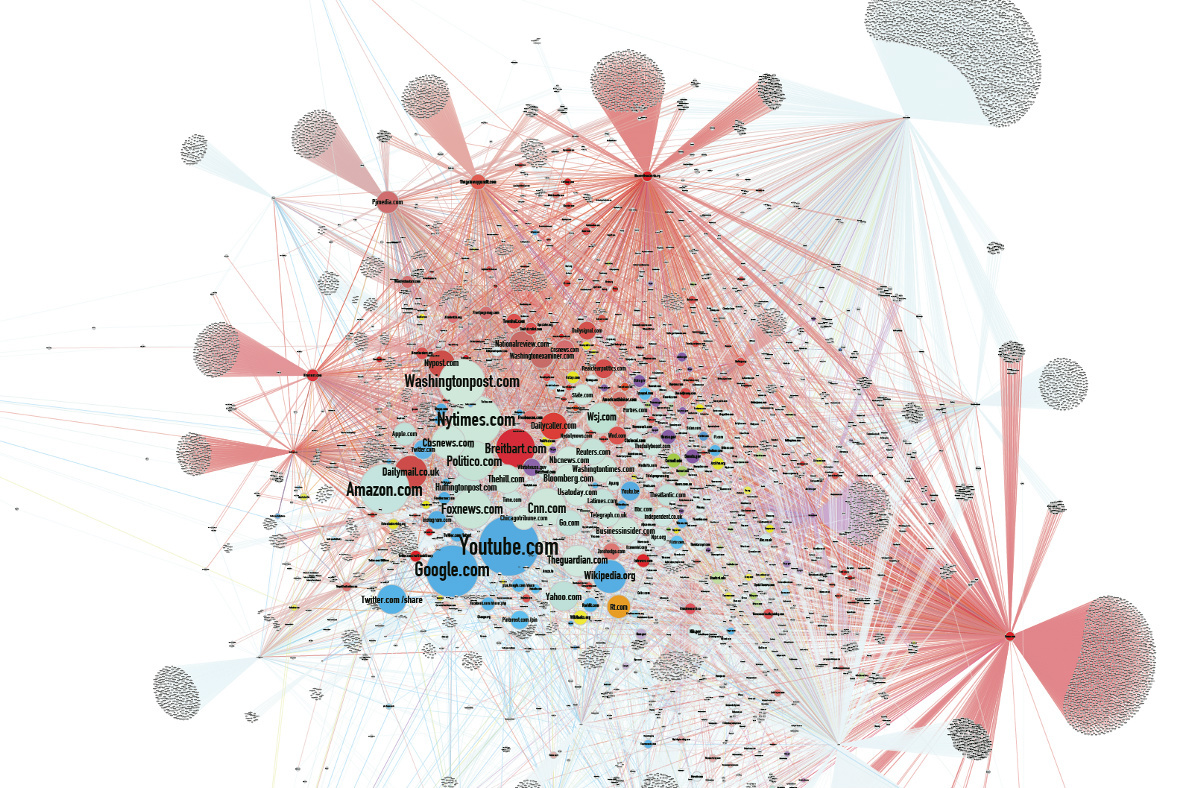

Durante la carrera electoral de los EE. UU., La cantidad de publicaciones falsas en las redes sociales excedió la cantidad de publicaciones verdaderas, porque las falsificaciones estaban más en línea con las expectativas o eran más emocionantes. Después de las elecciones, Facebook contrató verificadores de hechos independientes para marcar mensajes no verificados para alertar a los usuarios.

La combinación de una mayor polarización política de la sociedad y una tendencia a leer principalmente títulos da un efecto acumulativo. Las noticias falsas a menudo también se difunden a través de sitios de noticias falsas, cuya información a menudo cae en los medios de comunicación principales, que buscan atraer tráfico de usuarios. Y nada atrae el tráfico como un titular pegadizo.

Pero, de hecho, la influencia de las falsificaciones no se limita solo a la esfera política. Hay muchos ejemplos que demuestran el impacto de las noticias falsas en la sociedad.

Una compañía australiana de producción de videos ha lanzado

videos virales falsos durante dos años, obteniendo cientos de millones de visitas.

En una

falsa bien pensada sobre Stalin, cuya cara supuestamente apareció en el metro de Moscú, incluso creyeron el 1 de abril.

En 1992, el millonario Ilya Medkov comenzó a pagar grandes agencias de noticias en Rusia y la CEI (incluidos RIA Novosti, Interfax, ITAR-TASS). ITAR-TASS emitió un

mensaje falso a los medios sobre el accidente en la central nuclear de Leningrado en enero de 1993. Como resultado, las acciones de las principales empresas escandinavas cayeron en precio, y antes de que apareciera una refutación de los medios, los agentes de Medkov compraron las acciones más rentables de las empresas suecas, finlandesas y noruegas.

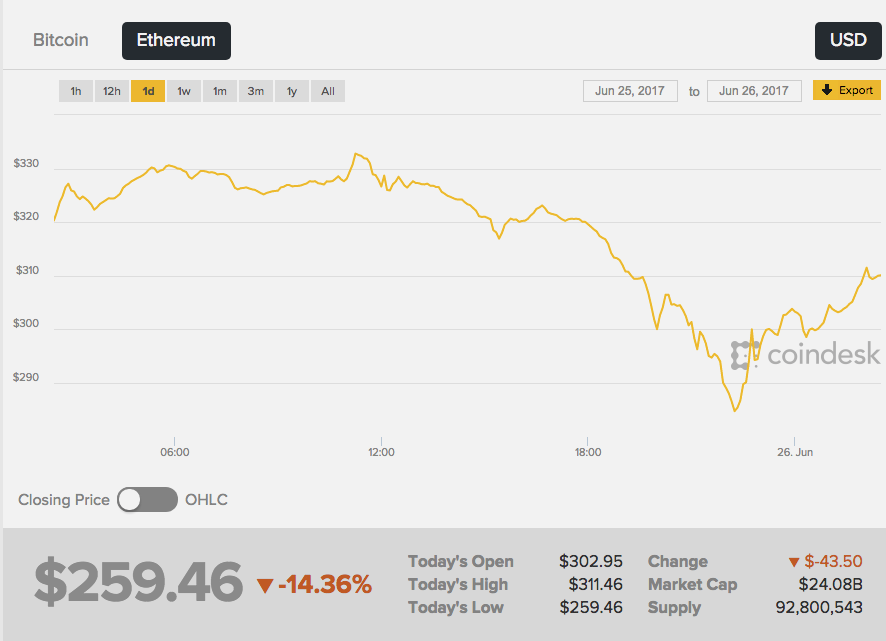

El 26 de junio de 2017, la tasa de la segunda capitalización de criptomonedas Ethereum bajó bruscamente: el intercambio reaccionó a los rumores que aparecieron en la red sobre la trágica muerte del creador de Ether, Vitaliy Buterin. Además, las primeras "noticias urgentes" aparecieron en una imagen anónima de 4chan, y esta fuente, francamente, no es la más confiable.

Wikipedia escribió que "Vitalik

era un programador ruso", y luego la prensa amarilla recogió la noticia. Como resultado, la tasa de éter

cayó un 13%, de aproximadamente $ 289 a $ 252. El curso comenzó a crecer inmediatamente después de la negación de las noticias del propio Vitali.

No hay evidencia de que alguien haya creado deliberadamente una falsificación con fines de lucro sobre la diferencia en las tasas de criptomonedas. Es indiscutible que las noticias ficticias sin un solo hecho confirmado tienen un efecto poderoso en las personas.

Imitación de la realidad

La cantante francesa Francoise Ardi en el video repetirá el discurso de Kellianne Conway, asesora del presidente de los Estados Unidos, Donald Trump, quien se hizo famoso después de hablar sobre "hechos alternativos". Lo interesante aquí es que Ardi en realidad tiene 73 años, y en el video parece una joven de veinte años.

Roller Alternative Face v1.1 fue

creado por el artista y accionista alemán Mario Klingeman. Tomó las entrevistas de audio de Conway y los viejos videos musicales de Arde. Y luego utilizó una red neuronal generativa (GAN), que hizo contenido de video único de muchos cuadros de diferentes clips del cantante, y superpuso una pista de audio con comentarios de Conway.

En este caso, la falsificación es fácil de reconocer, pero puede ir más allá: realizar cambios en el archivo de audio. La gente creerá que la imagen y el sonido se graban más voluntariamente que solo el texto. Pero, ¿cómo fingir el sonido de una voz humana?

Los sistemas GAN pueden estudiar las características estadísticas de las grabaciones de audio y luego reproducirlas en un contexto diferente con precisión de milisegundos. Es suficiente ingresar el texto que la red neuronal debería reproducir, y obtendrá una declaración plausible.

La startup canadiense Lyrebird ha publicado sus propios algoritmos que pueden simular la voz de cualquier persona basándose en un archivo de sonido con una duración de un minuto. Para demostrar las posibilidades, la compañía

publicó una conversación entre Obama, Trump y Clinton: todos los héroes, por supuesto, eran falsos.

DeepMind, el Instituto Baidu para el Aprendizaje Profundo y el Instituto Montreal para el Estudio de Algoritmos (MILA) ya están trabajando en algoritmos de texto a voz altamente realistas.

El resultado aún no es perfecto, puede distinguir rápidamente la voz recreada del original, pero se siente la similitud. Además, en la voz, la red cambia las emociones, agrega ira o tristeza dependiendo de la situación.

Generación de imagen

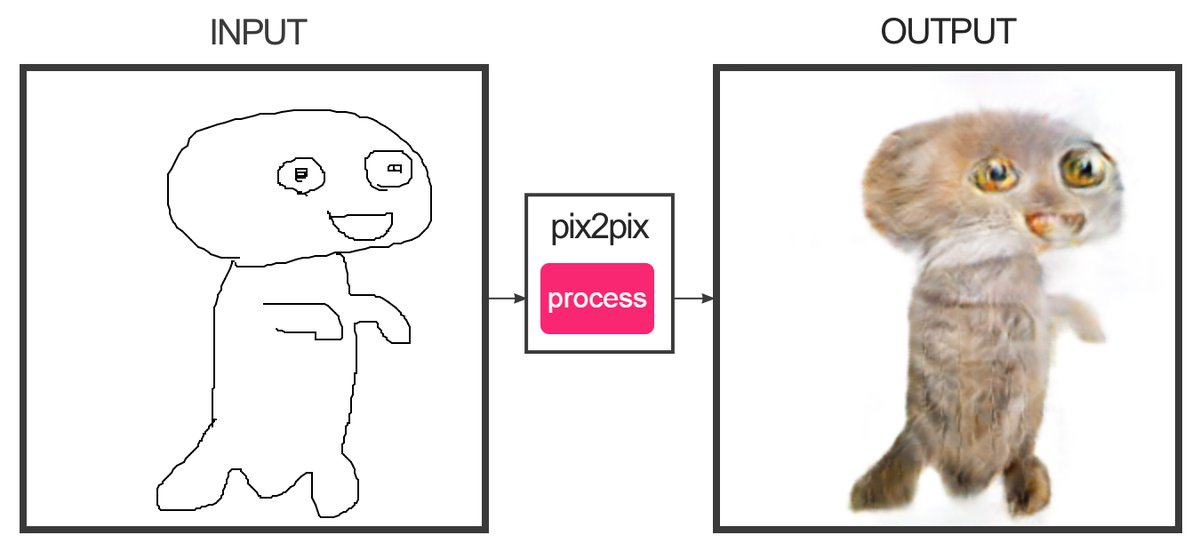

El desarrollador Christopher Hesse creó un

servicio que, con la ayuda del aprendizaje automático, puede "dibujar" bocetos que consisten en varias líneas para colorear fotografías. Sí, este es el sitio que dibuja gatos. Los sellos resultan más o menos: es difícil confundirlos con los reales.

La programadora Alexa Jolikier Martino pudo

hacer gatos que son exactamente como los reales. Para hacer esto, utilizó DCGAN - Redes Adversarias Generativas Convolucionales Profundas (redes competitivas convolucionales generativas profundas). Los DCGAN son capaces de crear imágenes fotorrealistas únicas al combinar dos redes neuronales profundas que compiten entre sí.

La primera red (que genera) recibe los valores de las variables en la entrada, y en la salida proporciona los valores de la función de estas variables, que deberían "convencer" a la segunda red (discriminando o discriminando) de que los resultados de la primera red son indistinguibles del estándar. Como muestras en el trabajo de Joliker-Martino, se utilizó una base de datos de diez mil retratos felinos.

Con los métodos DCGAN, es posible crear imágenes falsas que no pueden considerarse objetivamente falsas sin otra red neuronal.

Combinaciones de contenido

En la Universidad de Washington,

desarrollaron un algoritmo que le permite superponer audio en el video de una persona con sincronización de labios precisa. El algoritmo fue entrenado en 17 horas de mensajes de video de Barack Obama. La red neuronal fue entrenada para simular los movimientos de los labios de Obama de tal manera que corrija sus movimientos imitando la pronunciación de las palabras correctas. Hasta ahora, solo puede generar video con palabras que la persona realmente dijo.

Ahora observe el funcionamiento del algoritmo, que le

permite cambiar las expresiones faciales de otra persona sobre la marcha a sus propias expresiones faciales. En el video con Trump (todavía hay una manifestación sobre Bush, Putin y Obama), la curvatura de la persona se impone en el estudio, y el resultado es un Trump gruñón. El algoritmo se usa en Face2Face. La tecnología creada es similar en principio al bot

Smile Vector , que agrega una sonrisa a las personas en las fotos.

Por lo tanto, ahora es posible crear un video realista en el que una persona famosa hable hechos ficticios. Se puede cortar el discurso de los discursos anteriores para componer cualquier mensaje. Pero en el futuro cercano, incluso tales trucos resultarán superfluos: la red pondrá cualquier texto en la boca de un personaje falso con toda precisión.

Las consecuencias

Desde un punto de vista práctico, todas estas tecnologías le permiten hacer mucho bien. Por ejemplo, puede mejorar la calidad de la videoconferencia sintetizando los cuadros faltantes si se caen de la transmisión de video. E incluso sintetizar palabras faltantes completas, proporcionando una excelente comunicación en lugares con cualquier nivel de señal.

Será posible "digitalizar" completamente al actor y agregar una copia realista del mismo a películas y juegos.

¿Pero qué pasará con las noticias?

Es probable que en los próximos años, la generación falsa alcance un nuevo nivel. Hay nuevas formas de pelear. Por ejemplo, si correlaciona una foto con condiciones conocidas en el área (velocidad del viento, inclinación de las sombras, nivel de luz, etc.), estos datos ayudarán a identificar una falsificación.

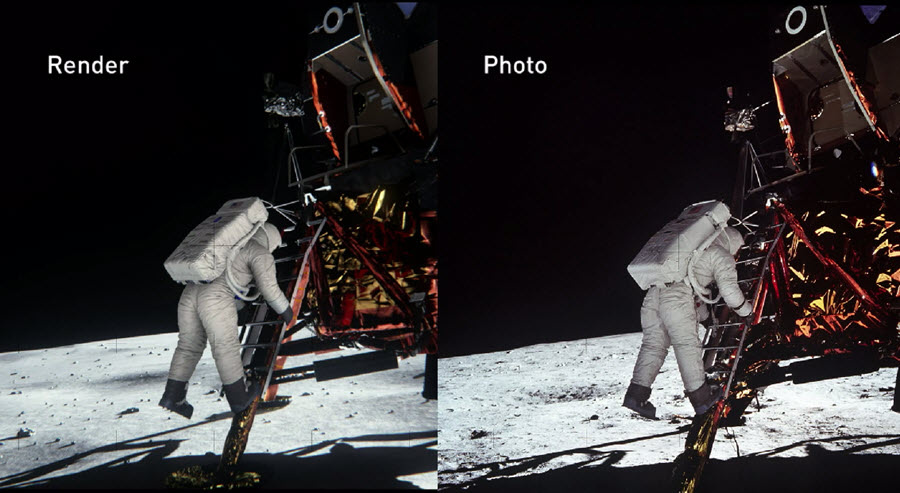

En 2014, los ingenieros de NVIDIA reconstruyeron la escena del alunizaje con la mayor precisión posible, basándose en evidencia documental de esa época. En este caso, se tuvieron en cuenta todas las propiedades físicas y ópticas de los objetos para descubrir cómo se refleja la luz de varios materiales y cómo se comporta en tiempo real. Como resultado, pudieron

verificar de manera confiable la autenticidad de las fotos de la NASA.

NVIDIA confirmó que con la preparación adecuada, uno puede probar la autenticidad (o refutar) incluso el trabajo fotográfico más complejo creado hace décadas.

El año pasado, la Agencia de los Estados Unidos para la Investigación y el Desarrollo de Defensa Avanzada (DARPA) lanzó un proyecto de cuatro años para crear un sistema

forense de medios abierto que puede identificar fotos que han sido procesadas o distorsionadas de una forma u otra.

Las redes neuronales podrán no solo cambiar el contenido original, sino también identificar las falsificaciones de la más alta calidad. Quién ganará finalmente en esta carrera tecnológica mostrará el tiempo.