Ilustración

IlustraciónHay muchas películas y libros de ciencia ficción en los que el sistema informático ha tomado conciencia y engañado a sus creadores humanos. ¿Es esto posible en la realidad? Hasta ahora, poco motivo de preocupación.

Estamos impresionados con los programas

AlphaGo y

Libratus , los éxitos de los robots Boston Dynamics, pero todos los logros conocidos se refieren solo a áreas estrechas y aún están lejos de la distribución masiva. En la vida cotidiana, las personas interactúan con asistentes pseudointelectuales (Siri, "Okay, Google", Amazon Alexa), cada uno de los cuales no pretende ser laureles de un programa verdaderamente "inteligente".

Sin embargo, los avances en el diseño de inteligencia artificial son realmente impresionantes. Y cuanto más se acerca el día en que la IA se convierte en una herramienta completa para influir en los procesos sociales, se acumulan más errores que indican la posibilidad de eludir las hipotéticas "

tres leyes de la robótica ".

La tesis "cuanto más complejo es el sistema, más lagunas y errores en él" está directamente relacionado con problemas con la IA.

Cuando el miedo tiene ojos

Un sabio proverbio ruso dice que el peligro se presenta a los temerosos en todas partes. Los orígenes del miedo a la vida artificial tienen sus raíces en arquetipos de horror centenarios. Incluso antes de las historias de Victor Frankenstein y los cuentos de zombies, había creencias sobre golems, criaturas, animadas de arcilla por magos cabalistas.

Tener miedo de lo nuevo (y lo vivo) es normal para una persona. En 1978, apareció una

hipótesis de que un robot u otro objeto que se parece o actúa como un ser humano (pero no exactamente como uno real) causa hostilidad y asco entre los observadores humanos. La hipótesis solo registró la experiencia: un zombie frente a ti, un golem o un asistente de robot, no es tan importante: tratarás a todos con la misma precaución.

Los robots humanos son solo la capa superior del problema. Elon Musk, Bill Gates, Stephen Hawking y cientos de expertos en el campo de la robótica, la física, la economía y la filosofía no ocultan sus temores sobre las consecuencias negativas para la humanidad de los sistemas inteligentes en el futuro.

Nos encanta hacernos cosquillas: no es por nada que la franquicia de Terminator es tan popular. Y cuántas IA "maliciosas" había en otras películas y libros. Es difícil discernir si este es nuestro inconsciente proyectado en la cultura, o si los medios influyen en la sociedad.

Crecimiento explosivo en el "océano azul"

La estrategia económica del

océano azul argumenta que las empresas que desean tener éxito no tienen que luchar contra los competidores, sino crear "océanos" de mercados no competitivos. Dichas decisiones estratégicas le permiten recibir instantáneamente beneficios adicionales para la empresa, sus clientes y empleados, buscando nuevas demandas y haciendo innecesaria la competencia.

Durante muchos años, la IA se ha mantenido como un "océano". Todos entendieron que incluso una inteligencia artificial débil se convertirá en una herramienta poderosa para cualquier empresa, aumentando la calidad de cualquier producto y servicio. Pero nadie sabía exactamente lo que hay que hacer. El "invierno" de la IA, que duró desde

1973 hasta la actualidad, se caracterizó por un estancamiento completo en el diseño de máquinas "inteligentes".

Durante treinta años, el logro más importante de la IA fue la victoria de la computadora IBM en el juego contra el campeón mundial de ajedrez, un evento que no afecta significativamente la vida cotidiana de ninguna persona (excepto Garry Kasparov). Sin embargo, en la década de 2010, sucedió algo comparable al desarrollo de armas nucleares: las redes neuronales recibieron la segunda ola de desarrollo.

Un hecho sorprendente: los científicos sin mucho éxito han estado desarrollando redes neuronales artificiales durante más de 70 años. Pero para 2015, comenzó un crecimiento explosivo en esta área, que continúa hasta nuestros días. Al mismo tiempo, esto sucedió:

- El "hierro" ha alcanzado el nivel requerido: las tarjetas de video modernas han permitido entrenar redes neuronales cientos de veces más rápido;

- Aparecieron matrices grandes y generalmente accesibles de varios datos en los que puede aprender (conjuntos de datos);

- los esfuerzos de varias compañías crearon nuevos métodos de enseñanza y nuevos tipos de redes neuronales (por ejemplo, algo tan maravilloso como una red generativa competitiva );

- Gracias a una multitud de investigaciones científicas abiertas, aparecieron redes neuronales preparadas y pre-entrenadas, sobre la base de las cuales fue posible realizar rápidamente sus aplicaciones.

Es interesante monitorear los éxitos de la IA, ni siquiera con el ejemplo clásico de procesamiento de imágenes (que es lo que hacen las redes neuronales, principalmente), sino en el campo de los vehículos no tripulados. Se sorprenderá, pero la fascinación por los vehículos "autopropulsados"

comenzó hace casi 100 años : en 1926, el primer intento de controlar la máquina de forma remota tuvo lugar como parte del proyecto Phantom Car.

Dron legendario Navlab 5

Dron legendario Navlab 5Los primeros vehículos no tripulados aparecieron en la década de 1980: en 1984, el proyecto

Navlab de la Universidad Carnegie Mellon y ALM, y en 1987,

el proyecto Mercedes-Benz y el Proyecto Eureka Prometheus de la Universidad Militar de Munich. Navlab 5, completado en 1995, fue el primer automóvil en viajar de manera autónoma de una costa de Estados Unidos a otra.

Hasta el auge de las redes neuronales, los autos autónomos seguían siendo proyectos de laboratorio que no eran confiables en el software. Los avances en el procesamiento de imágenes permitieron a las máquinas "comprender" lo que ven a su alrededor y evaluar la situación del tráfico en tiempo real.

El software de vehículos no tripulados puede no incluir visión artificial y redes neuronales, pero con un entrenamiento profundo, se ha logrado un progreso, que actualmente es crítico para el éxito de los drones.

En el "océano azul" de repente se llenó. Actualmente, sus drones son fabricados por General Motors, Volkswagen, Audi, BMW, Volvo, Nissan, Google (y Waymo bajo el patrocinio de Google), Tesla, Yandex, UBER, Cognitive Technologies y KAMAZ, así como por docenas de otras compañías.

Los UAV se crean a nivel de programas gubernamentales, incluido el programa de la Comisión Europea con un presupuesto de 800 millones de euros, el programa 2getthere en los Países Bajos, el programa de investigación ARGO en Italia y el DARPA Grand Challenge en los EE. UU.

En Rusia, el programa estatal es implementado por el Instituto del Centro Científico del Estado de la Federación Rusa de la Empresa Unitaria del Estado Federal NAMI, que creó el autobús eléctrico Shuttle. El proyecto

involucra a KAMAZ y al equipo de desarrollo de Yandex, que es responsable de crear la infraestructura para establecer la ruta y procesar los datos sobre la densidad del tráfico.

Los automóviles son probablemente el primer producto masivo en el que la IA afectará a todas las personas, pero no el único. AI puede controlar una máquina no peor que una persona, escribir música, preparar una

nota de periódico , hacer

un comercial . Él puede, y usted a menudo no. Incluso la IA moderna débil, que está infinitamente lejos de la autoconciencia, funciona mejor que la persona promedio.

Escucha esta cancion. La música que contiene está completamente compuesta por computadora.Todos estos factores, logros y éxitos llevan a la idea de que la IA no solo puede proporcionar servicios útiles, sino también perjudiciales. Solo porque es muy inteligente.

Liga de seguridad de AI

Elon Musk sobre IA y el futuro cercano 2017

Elon Musk sobre IA y el futuro cercano 2017Los miedos cotidianos son fáciles de superar. La gente se acostumbra a todas las cosas buenas muy rápidamente. ¿Tienes miedo de que los robots te roben tu trabajo? Pero ya están en todas partes. Un cajero automático le da dinero, una aspiradora limpia el apartamento, un piloto automático conduce un avión, el soporte técnico responde instantáneamente a los mensajes: en todos estos casos, el automóvil ayuda y no lo tira sin una indemnización por despido.

Sin embargo, hay suficientes oponentes al desarrollo abrupto de la IA. Elon Musk a menudo da advertencias. Él dice que la IA es "el mayor riesgo que enfrentamos como civilización". Musk cree que la regulación legislativa proactiva es obligatoria cuando se trata de IA. Señala que sería un error esperar las malas consecuencias del desarrollo descontrolado antes de tomar medidas.

"La IA es un riesgo fundamental para la existencia de la civilización humana"

"La IA es un riesgo fundamental para la existencia de la civilización humana"La mayoría de las empresas de tecnología, según Mask, solo exacerban el problema:

“ Necesitas ajustes para hacer esto para todos los equipos en el juego. De lo contrario, los accionistas preguntarán por qué no está desarrollando IA más rápido que su competidor ".

El propietario de Tesla, que

planea hacer del Model 3 el primer avión no tripulado masivo, afirma que la IA puede comenzar una guerra a través de noticias falsas, falsificación de cuentas de correo electrónico, comunicados de prensa falsos y simplemente manipulando información.

Bill Gates, quien ha invertido miles de millones en varias compañías de tecnología (entre las cuales no hay un solo proyecto relacionado con la IA), ha

confirmado que está de acuerdo con la preocupación de Mask y no entiende por qué otras personas no están preocupadas.

Sin embargo, hay demasiados partidarios de la inteligencia artificial y, en primer lugar, es

Alphabet , que tiene uno de los desarrolladores de inteligencia artificial más avanzados del mundo: DeepMind. Esta compañía creó la red neuronal que ganó el juego más difícil de Go, y actualmente está trabajando en una estrategia ganadora en el juego StarCraft II, cuyas reglas reflejan adecuadamente la versatilidad y aleatoriedad del mundo real.

Sí, Musk, sin embargo, se reconcilió y

decidió que era mejor tratar de lograr una IA fuerte primero y difundir esta tecnología en el mundo de acuerdo con sus propias reglas que permitir que los algoritmos se oculten y se enfoquen en manos de la élite tecnológica o gubernamental.

Ilon invirtió en la compañía sin fines de lucro OpenAI, que desarrolla inteligencia artificial segura. La compañía es conocida por crear reglas de seguridad de IA (con la esperanza de que todos los demás desarrolladores las usen), lanza

algoritmos que permiten a las personas entrenar inteligencia artificial en realidad virtual y también

derrota con éxito

a los jugadores en Dota 2.

Ganar juegos difíciles es una demostración clara de las capacidades de las máquinas. En el futuro, el equipo de desarrollo planea verificar si la IA desarrollada es capaz de competir en el modo 5 x 5. Hasta ahora, esto no suena como el más impresionante, pero los algoritmos de autoaprendizaje, entrenados para ganar juegos, son vitales en diferentes áreas.

Tomemos, por ejemplo, la supercomputadora IBM Watson, que

ayuda a los médicos a diagnosticar y seleccionar el mejor tratamiento. Esta es una máquina muy inteligente, pero solo puede hacer lo que cualquier médico puede hacer. Watson no puede desarrollar un programa de tratamiento fundamentalmente nuevo o crear un nuevo medicamento desde cero (aunque IBM dice que sí, pero no hay un solo estudio con un resultado real). Si abandonas el marketing, IBM simplemente

no tiene tales algoritmos .

Ahora imagine que un sistema que puede aprender independientemente las reglas y comenzar a vencer a una persona en cualquier juego manejará el tratamiento. El diagnóstico también es un juego. Conocemos las reglas, el resultado es conocido (el paciente debe sobrevivir), solo queda encontrar la estrategia óptima. Sí, millones de médicos se quedarán sin trabajo, pero una vida larga (muy larga) y saludable merece tales sacrificios.

C'est plus qu'un crime, c'est une faute *

La historia del desarrollo de cualquier producto está llena de ejemplos de logros sobresalientes y errores catastróficos. Con AI, ciertamente somos afortunados. Hasta ahora, los robots militares viajan solo a través de exposiciones, y todavía hay años de pruebas para el transporte público autogestionado en masa. En un cajón de arena de laboratorio es difícil cometer un error fatal.

Sin embargo, los incidentes suceden.

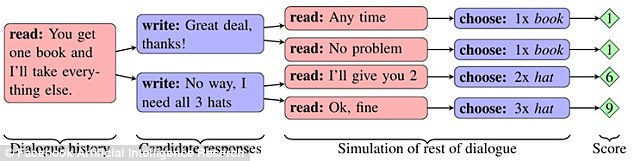

Facebook

realizó un experimento en el que dos redes "compartieron" elementos (dos libros, un sombrero y tres bolas) después de una discusión preliminar. Cada objeto tenía significado para la red, expresado en puntos (del 1 al 3). Una red no sabía si el tema era importante para la segunda y tuvo que averiguarlo a través del diálogo.

Si la primera red dijo que necesitaba algún tipo de objeto, entonces la segunda concluyó que la primera red lo calificó altamente. Sin embargo, la red pudo imitar el interés en el tema, de modo que en el momento adecuado lo sacrificara para su propio beneficio.

Las redes pudieron aprender cómo construir una estrategia a largo plazo y predecir el comportamiento de un competidor. Al mismo tiempo, se comunicaban entre ellos en inglés natural, comprensible para las personas. Sin embargo, al mejorar la mecánica del intercambio de objetos, las redes han tomado el camino de la simplificación del lenguaje. Las reglas del idioma inglés se omitieron tanto como fue posible, y las construcciones se repitieron muchas veces usando palabras de código.

En algún momento, un observador externo (persona) ya no podía entender de qué hablaban las redes entre sí. Este comportamiento de los chatbots fue reconocido como un error y los programas fueron deshabilitados.

Curiosamente, el experimento mostró involuntariamente cómo diferentes tipos de IA pueden aprender rápidamente a comunicarse entre sí, tanto que una persona no entiende nada. El problema también se manifestó en la investigación de Google, donde crearon una red neuronal que desarrolló su propio protocolo de encriptación.

Capacitación para proteger las comunicaciones mediante la neurocriptografía adversaria .

Capacitación para proteger las comunicaciones mediante la neurocriptografía adversaria .La división Google Brain enseñó a las redes neuronales a transmitirse mensajes cifrados entre sí, y los investigadores no tenían las claves del cifrado. Se suponía que la tercera red debía interceptar correspondencia. Después de que el escenario de transferencia de mensajes se jugó más de 15 mil veces, una red aprendió a convertir el texto cifrado de su compañero en texto sin un solo error. Al mismo tiempo, la red de observadores solo

podía adivinar 8 de los 16 bits de datos contenidos en el mensaje.

Un caso interesante ocurrió con el bot de chat Tay de Microsoft. En marzo de 2016, la compañía abrió una cuenta de Twitter del bot, con la que cualquier usuario de la red podía comunicarse. Como resultado, el bot comenzó a aprender

demasiado rápido . En menos de un día, el robot se desilusionó con los humanos. Afirmó que apoya el genocidio, odia a las feministas y también expresó su acuerdo con las políticas de Hitler.

Microsoft dijo que el bot simplemente copió los mensajes de los usuarios y prometió solucionar el problema. Una semana después, Tau apareció nuevamente en Twitter. Luego habló sobre cómo usaba drogas justo en frente de la policía. Tay se apagó, esta vez para siempre.

En diciembre de 2016, la compañía presentó un nuevo robot de autoaprendizaje llamado Zo, que evitó comunicarse sobre temas delicados y solicitudes filtradas. En el verano de 2017, Zo ya

consideraba Linux mejor que Windows y criticaba el Corán.

Problemas similares se experimentan en China. Tencent Corporation

eliminó los chatbots BabyQ y XiaoBing de su mensajero QQ después de que ambos comenzaron a hablar sobre su disgusto por el gobernante Partido Comunista del país y el sueño de mudarse de China a los Estados Unidos.

Que futuro nos espera

¿Mark Zuckerberg tiene razón al

decir que la inteligencia artificial mejorará nuestras vidas en el futuro? El creador de Facebook (y un

posible candidato para la presidencia de Estados Unidos) dijo lo siguiente: “En el caso de la IA, soy especialmente optimista. Creo que las personas son escépticas cuando hablan de los escenarios del fin del mundo ".

¿O debería ponerse del lado de la Máscara, según la cual la IA plantea demasiados problemas éticos y constituye una amenaza real para la humanidad?

Nadie sabe las respuestas a estas preguntas. Es posible que el futuro se encuentre en algún punto intermedio, sin una fuerte inteligencia artificial y una identidad de máquina, pero con interfaces neuronales y cyborgs.

El hecho es que con el desarrollo de la tecnología, los errores ocurren con mayor frecuencia (en el caso de los bots de chat, parece que las mismas fallas se repiten una y otra vez). En un software tan complejo, probablemente sea imposible evitar errores en principio. Vale la pena ocuparse de una sola cosa: las anomalías en el trabajo no deberían conducir a un peligro para toda la humanidad. Que hoy sea un excesivo "escepticismo en las discusiones sobre los escenarios del fin del mundo", que mañana es una amenaza real.