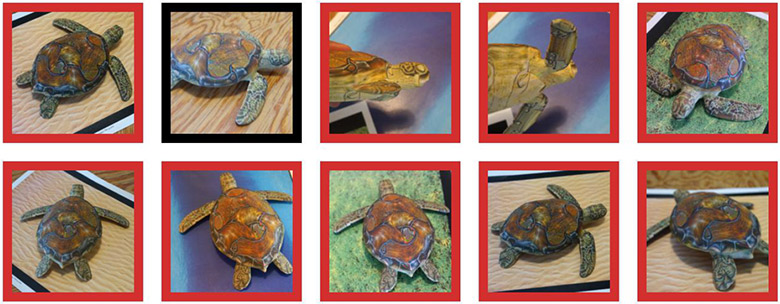

La red neuronal reconoce una tortuga impresa en una impresora 3D como una tortuga (contorno verde), un rifle (contorno rojo) o como otro objeto (contorno negro)

La red neuronal reconoce una tortuga impresa en una impresora 3D como una tortuga (contorno verde), un rifle (contorno rojo) o como otro objeto (contorno negro)Hace tiempo que se sabe que pequeños cambios intencionales en la imagen "rompen" el sistema de aprendizaje automático, de modo que

clasifica una imagen completamente diferente . Estas imágenes "troyanas" se denominan "ejemplos adversos" y representan una de las

limitaciones bien conocidas

del aprendizaje profundo .

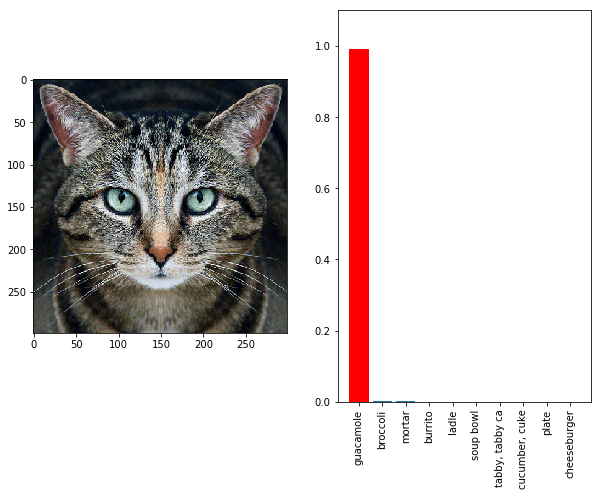

Funcionan de manera simple: necesita hacer un gradiente ascendente en el espacio de datos de entrada para generar patrones que maximicen la predicción de clase para una clase determinada. Por ejemplo, si tomamos una foto de un panda y agregamos el gradiente "gibbon", haremos que la red neuronal clasifique a este panda como un gibbon. La tortuga se puede emitir como un rifle (ver ilustración arriba). El gato se convierte en una merienda fría de guacamole (ver debajo del gato), no importa. Cualquier objeto se convierte en otro para los ojos de la inteligencia artificial, porque la IA tiene un sistema especial de "visión" que es diferente del humano.

Hasta ahora, un ajuste tan fino del gradiente funcionaba solo en imágenes 2D y era muy sensible a cualquier distorsión.

Una fotografía de un gato se reconoce como guacamole en el clasificador InceptionV3

Una fotografía de un gato se reconoce como guacamole en el clasificador InceptionV3Mire al gato desde un ángulo diferente o desde una distancia diferente, y la red neuronal nuevamente ve al gato en él, y no un refrigerio frío.

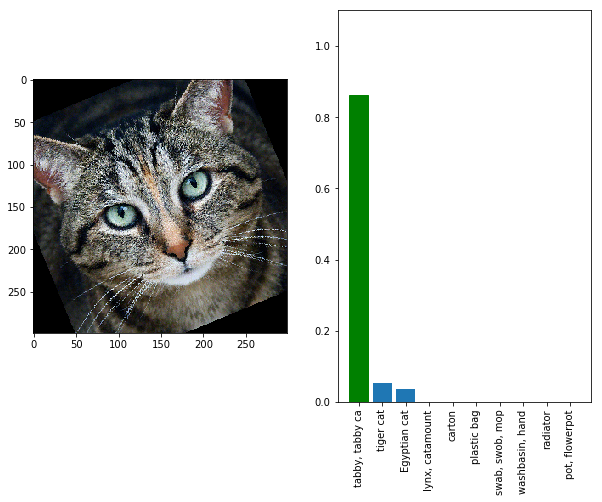

Una foto de un gato se reconoce nuevamente como un gato en el clasificador InceptionV3 , si lo gira un poco

Una foto de un gato se reconoce nuevamente como un gato en el clasificador InceptionV3 , si lo gira un pocoEs decir, en realidad, tales ejemplos competitivos no serán efectivos debido al zoom, el ruido de la cámara digital y otras distorsiones que inevitablemente surgen en la realidad. Esto es inaceptable si queremos

engañar de manera confiable y constante los sistemas de visión fuera de línea . Pero ahora ha surgido la esperanza de que las personas puedan hacer esta tarea. Investigadores del Instituto de Tecnología de Massachusetts y el grupo de investigación independiente LabSix (compuesto por estudiantes y graduados del MIT) han creado el primer algoritmo del mundo que genera

ejemplos competitivos en 3D . Por ejemplo, el siguiente video muestra una tortuga que el clasificador Google InceptionV3 reconoce constantemente como un rifle en casi cualquier ángulo.

El algoritmo puede generar no solo tortugas, sino también modelos arbitrarios. Para la muestra, los investigadores también imprimieron una pelota de béisbol, que se clasifica como espresso (café) en cualquier ángulo, y también crearon una gran cantidad de otros modelos, ilusiones ópticas peculiares para la IA.

La ilusión óptica funciona incluso si el objeto en la fotografía está en un contexto semánticamente irrelevante. Obviamente, durante el entrenamiento, la red neuronal no pudo ver ni un rifle bajo el agua ni un café exprés en el guante de un receptor.

Ejemplos competitivos en 3D: una tortuga que parece un rifle para la red neuronal InceptionV3, y una pelota de béisbol que se parece a un espresso

Ejemplos competitivos en 3D: una tortuga que parece un rifle para la red neuronal InceptionV3, y una pelota de béisbol que se parece a un espressoAunque el método se "agudiza" específicamente para una red neuronal particular, en los comentarios sobre artículos científicos anteriores sobre este tema,

se prestó atención a la observación de los investigadores de que, muy probablemente, el ataque afectará a muchos modelos entrenados en este conjunto de datos en particular, incluidas varias arquitecturas de redes de convolución y incluso clasificadores lineales. Entonces, para un ataque, la hipótesis sobre qué datos se podría entrenar el modelo es suficiente.

"En términos concretos, esto significa que es probable que haya una oportunidad para crear una señal de tráfico para la venta de una casa, lo que parece bastante habitual para los conductores humanos, pero para un vehículo no tripulado parecerá un peatón que apareció de repente en la acera", dice el trabajo científico. "Los ejemplos competitivos son de interés práctico, que debe tenerse en cuenta a medida que las redes neuronales se vuelven cada vez más comunes (y peligrosas)".

Para protegerse contra tales ataques, los desarrolladores de la futura IA pueden mantener información secreta sobre la arquitectura de sus redes neuronales y, lo que es más importante, sobre el conjunto de datos que se utilizó en la capacitación.

El artículo científico fue

publicado el 30 de octubre de 2017 en el sitio de preimpresión arXiv.org (arXiv: 1707.07397v2).