Los sistemas de Inteligencia Artificial (IA) están ganando terreno. En este sentido, los abogados y legisladores discuten el problema de cómo deben regularse dichos sistemas, quién será responsable de sus acciones. Este problema requiere un estudio cuidadoso y un enfoque equilibrado, porque los sistemas de IA son capaces de generar grandes cantidades de datos y se utilizan en aplicaciones de diferentes funciones, desde sistemas médicos y pilotos automáticos en automóviles hasta predicción de delitos y cálculo de posibles delincuentes. Al mismo tiempo, los científicos se esfuerzan por crear una "IA fuerte" capaz de razonar, y surge la pregunta de cómo determinar la presencia de intenciones en sus acciones, o reconocer acciones como no intencionales.

Hay muchas maneras de llevar el sistema de IA a la responsabilidad y la responsabilidad; se han publicado varios estudios sobre este tema. En un nuevo

trabajo de investigación , expertos en informática, expertos en ciencias cognitivas y abogados de las universidades de Harvard y Cambridge (EE. UU.) Discuten un componente del futuro sistema de responsabilidad de IA, a saber, el papel de una nota explicativa de AI, es decir, una evaluación de cómo el sistema de inteligencia artificial explica sus acciones . Los científicos llegaron a la conclusión de que el módulo para explicar las acciones debería estar separado del sistema general de IA.

Los autores del trabajo científico describen todos los problemas que surgen al intentar pedirle al sistema de IA una explicación de sus acciones.

En primer lugar, dicha oportunidad debe proporcionarse en la etapa de desarrollo del sistema, de lo contrario, la IA puede rechazar o no podrá explicar sus acciones.

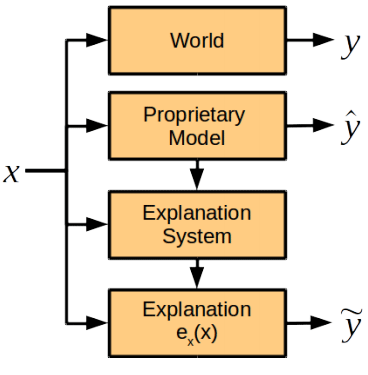

En segundo lugar, el sistema de IA procesa una gran variedad de datos utilizando complejos algoritmos o métodos patentados que él mismo desarrolló en el proceso de aprendizaje. Por lo tanto, cuando intenta explicar sus acciones de la manera más completa, puede generar demasiados datos que son incomprensibles para una persona. O, como el otro extremo, proporcionará un modelo demasiado simplista que no reflejará las intenciones reales de la IA y los motivos de las acciones. Además, los algoritmos de operación del sistema de inteligencia artificial pueden ser propiedad intelectual de la empresa en desarrollo, por lo que es necesario proporcionar dicho método de compilación de una nota explicativa para establecer las causas del sistema, pero no dar a conocer los algoritmos subyacentes.

Los investigadores creen que es posible una explicación sin revelar los algoritmos y las reglas que subyacen al funcionamiento del sistema de IA. En caso de un incidente, el sistema debe proporcionar respuestas a las siguientes preguntas:

- ¿Cuáles son los principales factores que influyen en la decisión?

- ¿Un cambio en cierto factor conduciría a un cambio en la decisión?

- ¿Por qué dos casos similares condujeron a soluciones diferentes?

Las respuestas a tales preguntas no requieren necesariamente la divulgación de secretos de propiedad y algoritmos internos del sistema, pero al mismo tiempo darán una comprensión clara de sus motivos.

Los científicos discuten en qué casos es apropiado requerir que la IA explique sus acciones. De hecho, esto se requiere en los casos en que el beneficio de la explicación supera el precio de su recibo: “Creemos que hay tres condiciones para situaciones en las que la compañía considera necesario obtener una explicación del tomador de decisiones. Estas son razones morales, sociales o legales ”, explica Finale Doshi-Velez, autor principal del artículo.

Al mismo tiempo, uno no debería exigir explicaciones de AI literalmente en cada situación. Como se mencionó anteriormente, esto aumenta los riesgos de emitir secretos comerciales y supone una carga adicional para los desarrolladores de sistemas de inteligencia artificial. En otras palabras, la responsabilidad constante de la IA hacia los humanos inhibirá el desarrollo de estos sistemas, incluso en áreas importantes para los humanos.

En contraste con la creencia generalizada de que el sistema de IA es una caja negra, cuyas causas son incomprensibles para los humanos, los autores del trabajo científico están seguros de que se puede desarrollar un módulo que funcione normalmente para explicar las acciones de la IA. Este módulo se integrará en el sistema, pero funcionará independientemente de los algoritmos de toma de decisiones y no los obedecerá.

Los científicos creen que hay algunos puntos en la explicación de acciones que son fáciles de establecer para las personas y difíciles para las máquinas, y viceversa.

Comparación de las habilidades humanas y la IA para explicar | Hombre | AI |

|---|

| Los beneficios | Puede explicar el acto posterior | Reproducibilidad, falta de presión social. |

| Desventajas | Puede ser inexacto y poco confiable, siente presión social | Requiere programación preliminar del módulo de explicación, taxonomías adicionales y expansión del sistema de almacenamiento. |

Sin embargo, el grupo de expertos recomienda que la primera vez establecida para los sistemas de IA sea el mismo estándar para explicar sus acciones que se establece hoy para las personas (este estándar se detalla en la ley de los EE. UU .: en particular, se requiere una explicación en casos de responsabilidad estricta, divorcio y discriminación, para tomar decisiones administrativas y de jueces y jurados para explicar sus decisiones, aunque el nivel de detalle de la nota explicativa es muy diferente en cada caso).

Pero si las razones de las acciones de la IA van más allá de la comprensión del hombre, entonces, para dar cuenta de la IA en el futuro, se puede desarrollar otro estándar para sus notas explicativas, dicen los científicos.

El artículo científico fue

publicado el 3 de noviembre de 2017 en el sitio de preimpresión arXiv.org (arXiv: 1711.01134v1).