En mayo de 2017, los investigadores de Google Brain presentaron el proyecto

AutoML , que automatiza el diseño de modelos de aprendizaje automático. Los experimentos de AutoML han demostrado que este sistema puede generar redes neuronales pequeñas con un rendimiento muy bueno, bastante comparable a las redes neuronales diseñadas y entrenadas por expertos humanos. Sin embargo, al principio, AutoML se limitó a pequeños conjuntos de datos científicos como CIFAR-10 y Penn Treebank.

Los ingenieros de Google se preguntaron: ¿qué pasa si ponemos tareas más serias para el generador de IA? ¿Es este sistema de IA capaz de generar otra IA que será mejor que la IA artificial en alguna tarea importante como clasificar objetos de

ImageNet , el más famoso de los conjuntos de datos a gran escala en visión artificial? Así que había una red neuronal

NASNet , creada casi sin intervención humana.

Al final resultó que, AI hace frente al diseño y entrenamiento de redes neuronales no peor que los humanos. La tarea de clasificar objetos del conjunto de datos de ImageNet y definir objetos del conjunto de datos de

COCO fue parte del proyecto

Aprendizaje de arquitecturas transferibles para reconocimiento de imagen escalable .

Los desarrolladores del proyecto AutoML

dicen que la tarea resultó no ser trivial, porque los nuevos conjuntos de datos son varios órdenes de magnitud más grandes que los anteriores con los que el sistema está acostumbrado a trabajar. Tuve que cambiar algunos algoritmos de operación de AutoML, incluido el rediseño del espacio de búsqueda para que AutoML pudiera encontrar la mejor capa y duplicarla muchas veces antes de crear la versión final de la red neuronal. Además, los desarrolladores exploraron opciones para la arquitectura de redes neuronales para CIFAR-10 y transfirieron manualmente la arquitectura más exitosa a las tareas de ImageNet y COCO.

Gracias a estas manipulaciones, el sistema AutoML pudo detectar las capas más eficientes de la red neuronal que funcionaban bien para CIFAR-10 y al mismo tiempo funcionaban bien en tareas de ImageNet y COCO. Estas dos capas descubiertas se combinaron para formar una arquitectura innovadora llamada NASNet.

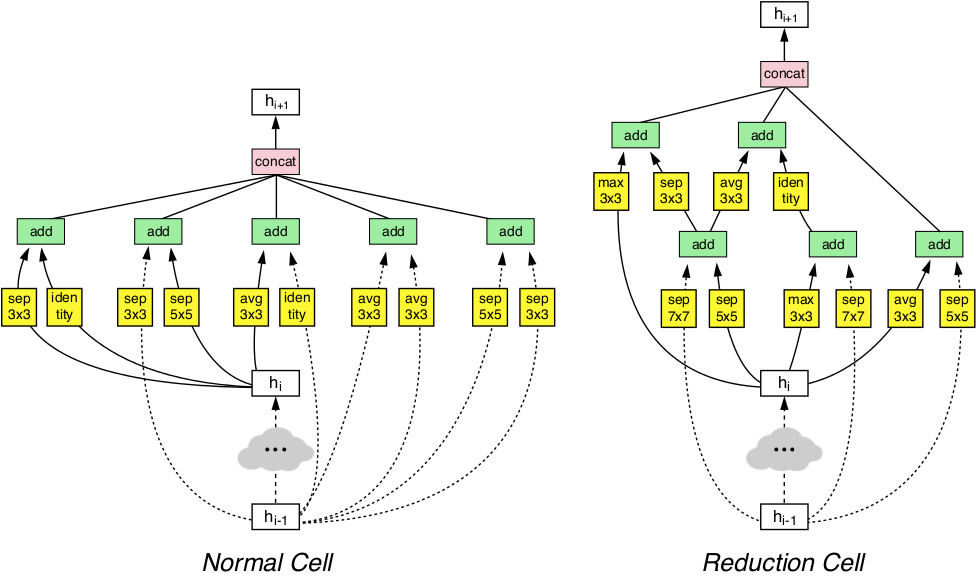

La arquitectura NASNet consta de dos tipos de capas: una capa normal (izquierda) y una capa de reducción (derecha). Estas dos capas están diseñadas por un generador AutoML.

La arquitectura NASNet consta de dos tipos de capas: una capa normal (izquierda) y una capa de reducción (derecha). Estas dos capas están diseñadas por un generador AutoML.Los puntos de referencia mostraron que la IA generada automáticamente supera todos los demás sistemas de visión artificial creados y entrenados por expertos humanos en la clasificación y definición de objetos.

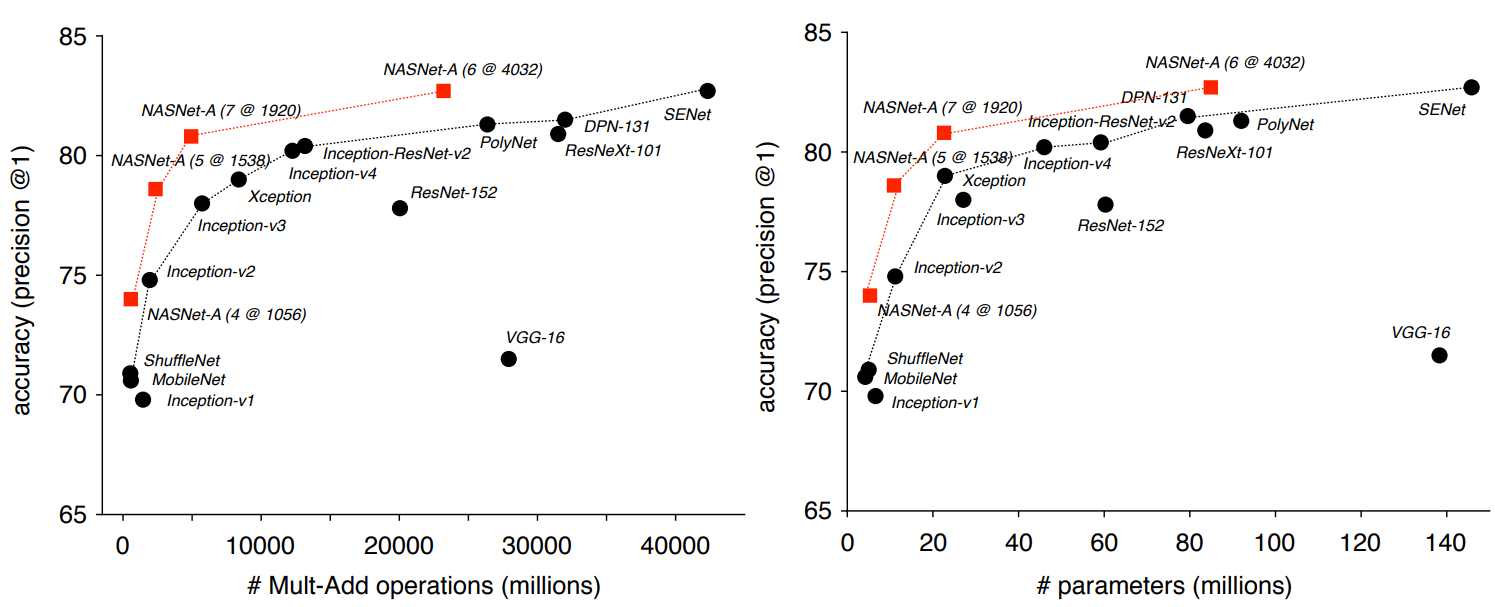

Entonces, en la tarea de clasificación basada en ImageNet, la red neuronal NASNet demostró una precisión de predicción del 82.7% en el conjunto de prueba. Este resultado es más alto que todos los modelos de visión artificial diseñados previamente de la familia Inception. El sistema NASNet mostró un resultado de al menos 1,2 puntos porcentuales más alto que todas las redes neuronales de visión artificial conocidas, incluidos los últimos resultados de trabajos aún no publicados en la prensa científica, pero ya publicados en el sitio de preimpresión arXiv.org.

Los investigadores enfatizan que NASNet se puede escalar y, por lo tanto, adaptarse para trabajar en sistemas con recursos informáticos débiles sin mucha pérdida de precisión. La red neuronal puede funcionar incluso en un teléfono móvil con una CPU débil con un recurso de memoria limitado. Los autores dicen que la versión en miniatura de NASNet muestra una precisión del 74%, que es 3.1 puntos porcentuales mejor que las redes neuronales conocidas de más alta calidad para plataformas móviles.

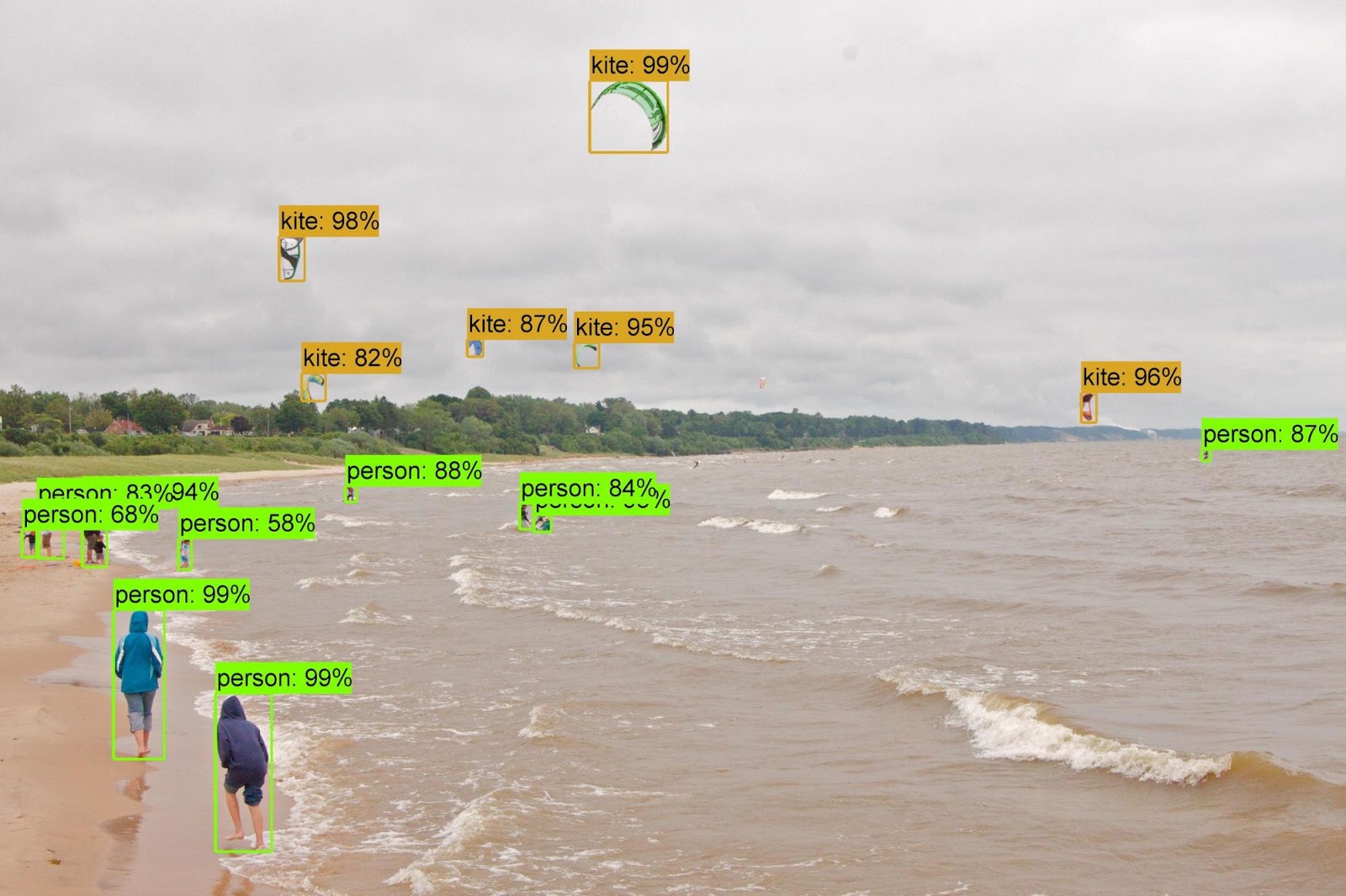

Cuando los atributos adquiridos del clasificador ImageNet se transfirieron al reconocimiento de objetos y se combinaron con el

marco Faster-RCNN , el sistema mostró los mejores resultados en el problema de reconocimiento de objetos COCO tanto en el modelo grande como en la versión reducida para plataformas móviles. El modelo grande mostró un resultado de 43.1% mAP, que es 4 puntos porcentuales mejor que el competidor más cercano.

Los autores abrieron el código fuente de NASNet en los repositorios

Slim y

Object Detection para TensorFlow, para que todos puedan experimentar una nueva red neuronal en su propio trabajo.

El artículo científico fue

publicado el 1 de diciembre de 2017 en el sitio de preimpresión arXiv.org (arXiv: 1707.07012v3, tercera versión).